Perplexity AI a gagné en popularité significative pour ses capacités d'IA conversationnelle, en particulier sa force à fournir des réponses à jour et citées, en intégrant la recherche web en temps réel dans ses réponses. Pour les développeurs et les entreprises qui cherchent à exploiter ces modèles puissants au sein de leurs propres applications, Perplexity propose une Interface de Programmation d'Application (API).

L'API Perplexity AI permet un accès programmatique aux grands modèles de langage (LLMs) de Perplexity, y compris leurs modèles en ligne (comme sonar-small-online et sonar-medium-online) qui peuvent naviguer sur le web pour répondre aux requêtes, et leurs modèles de chat hors ligne (comme sonar-small-chat et sonar-medium-chat).

Ce tutoriel explore deux voies principales pour interagir avec l'écosystème de l'API Perplexity AI :

- Accès direct en utilisant une clé API officielle Perplexity : Il s'agit de la méthode standard fournie par Perplexity. Bien qu'il puisse y avoir un essai gratuit ou des crédits d'introduction très limités, une utilisation soutenue ou à volume élevé nécessite généralement un abonnement Perplexity Pro ou des accords d'entreprise spécifiques pour obtenir et utiliser une clé API avec suffisamment de crédits.

- Accès indirect via des services tiers (OpenRouter) : Des plateformes comme OpenRouter agissent comme des agrégateurs, fournissant un accès à divers LLMs, y compris les modèles de Perplexity, via leur propre infrastructure API. Cela peut être un autre moyen d'utiliser les modèles Perplexity, potentiellement sans avoir besoin d'un abonnement Perplexity Pro direct, bien que vous encourriez toujours des coûts via le fournisseur tiers.

Nous allons également clarifier la situation concernant Groq, une autre plateforme d'inférence populaire, et sa relation (ou son absence) avec les modèles propriétaires de Perplexity.

Accéder à l'API officielle Perplexity AI avec un compte Pro

Cette section détaille comment utiliser l'API officielle fournie directement par Perplexity. Cette méthode offre généralement l'accès le plus direct et potentiellement les dernières fonctionnalités ou modèles, mais nécessite généralement un abonnement Perplexity payant (Pro) pour une utilisation significative au-delà de l'exploration initiale.

Prérequis :

- Un compte Perplexity.

- Un abonnement Perplexity Pro (généralement requis pour un accès API substantiel et la génération de clés).

- Compréhension de base des API REST et de la manière d'effectuer des requêtes HTTP (en utilisant des outils comme

curlou des langages de programmation comme Python).

Étape 1 : Obtenir votre clé API officielle Perplexity AI

- Connectez-vous à Perplexity : Accédez au site Web de Perplexity (

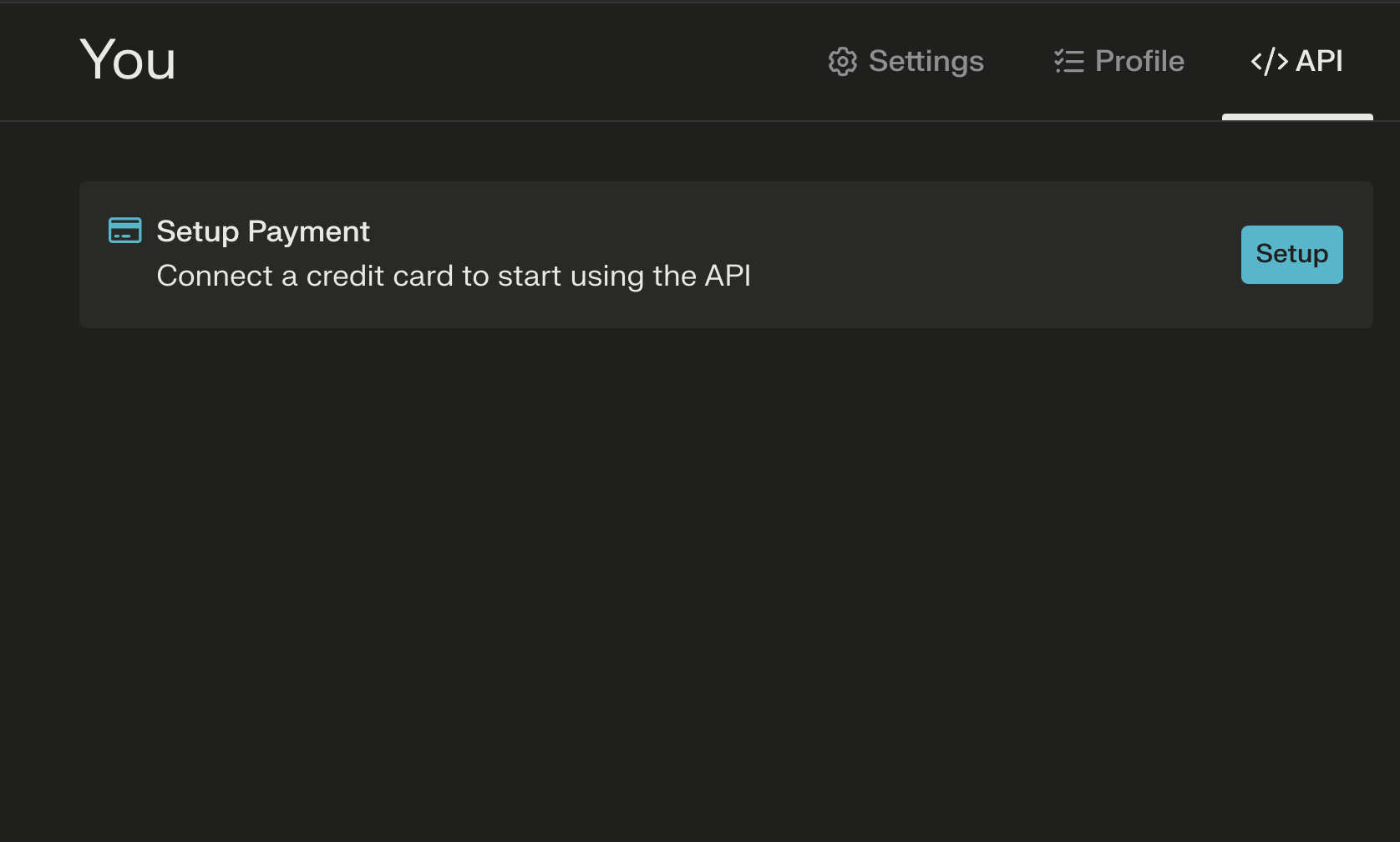

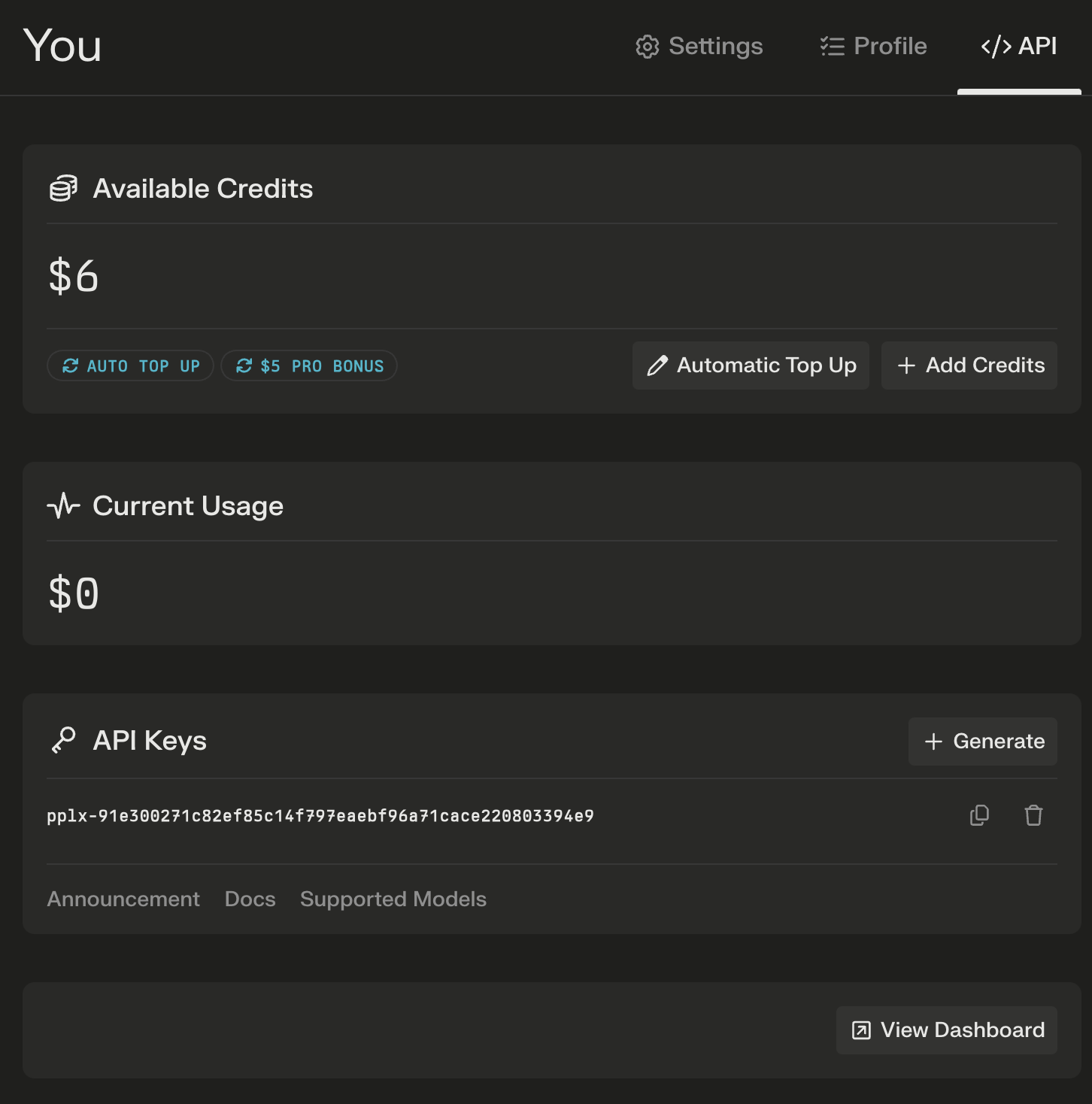

perplexity.ai) et connectez-vous à votre compte. Assurez-vous qu'il est mis à niveau vers Pro si cela est requis pour la génération/l'utilisation de la clé API. - Configurer un mode de paiement : Recherchez les paramètres du compte, les options de profil ou une section « API » dédiée dans votre tableau de bord Perplexity. L'emplacement exact peut changer, mais il se trouve généralement dans votre zone de gestion de compte.

3. Générer une clé API : Dans les paramètres de l'API, vous devriez trouver une option pour générer une nouvelle clé API. Cliquez sur ce bouton.

4. Copiez et sécurisez votre clé : Perplexity générera une chaîne alphanumérique unique. C'est votre clé API. Traitez cette clé comme un mot de passe. Ne la partagez pas publiquement et ne l'engagez pas directement dans vos référentiels de code. Stockez-la en toute sécurité, par exemple en utilisant des variables d'environnement ou un système de gestion des secrets.

Étape 2 : Comprendre le point de terminaison de l'API Perplexity AI

Le point de terminaison principal pour interagir avec les modèles de chat de Perplexity via l'API est :

https://api.perplexity.ai/chat/completions

Ce point de terminaison suit une structure similaire à l'API d'OpenAI, ce qui le rend relativement familier pour les développeurs qui ont travaillé avec d'autres API LLM.

Étape 3 : Choisir un modèle d'API Perplexity AI

Perplexity propose plusieurs modèles via son API. Vous devez spécifier quel modèle vous souhaitez utiliser dans votre requête API. Les modèles courants incluent :

Modèles en ligne (avec recherche web) :

sonar-small-onlinesonar-medium-online- (Précédemment

pplx-7b-online,pplx-70b-online- consultez la documentation actuelle pour les modèles disponibles)

Modèles de chat (sans recherche web) :

sonar-small-chatsonar-medium-chat- (Précédemment

pplx-7b-chat,pplx-70b-chat- consultez la documentation actuelle) - D'autres modèles spécialisés ou plus anciens peuvent également être disponibles. Reportez-vous toujours à la documentation officielle de l'API Perplexity pour obtenir la liste la plus à jour des modèles et de leurs capacités.

Étape 4 : Effectuer votre première requête d'API Perplexity AI

Vous pouvez interagir avec l'API en utilisant divers outils ou langages de programmation. Voici des exemples utilisant curl (outil en ligne de commande) et Python (bibliothèque requests).

Utilisation de curl :

curl -X POST <https://api.perplexity.ai/chat/completions> \\\\

-H "Authorization: Bearer YOUR_PERPLEXITY_API_KEY" \\\\

-H "Content-Type: application/json" \\\\

-d '{

"model": "sonar-medium-online",

"messages": [

{

"role": "system",

"content": "Be precise and concise."

},

{

"role": "user",

"content": "What are the main benefits of using the Perplexity AI API?"

}

],

"max_tokens": 500,

"temperature": 0.7

}'

Explication :

curl -X POST ...: Effectue une requête HTTP POST vers le point de terminaison spécifié.H "Authorization: Bearer YOUR_PERPLEXITY_API_KEY": Cet en-tête fournit vos informations d'identification d'authentification. RemplacezYOUR_PERPLEXITY_API_KEYpar la clé que vous avez générée.H "Content-Type: application/json": Informe le serveur que le corps de la requête est au format JSON.d '{...}': Spécifie la charge utile JSON (données) envoyée."model": Le modèle Perplexity spécifique à utiliser (par exemple,sonar-medium-online)."messages": Une liste d'objets de message définissant l'historique de la conversation."role": Peut être"system"(définit le comportement de l'IA),"user"(votre entrée) ou"assistant"(réponses précédentes de l'IA)."content": Le texte du message."max_tokens"(facultatif) : Nombre maximal de jetons à générer dans la réponse."temperature"(facultatif) : Contrôle le caractère aléatoire (0 = déterministe, plus élevé = plus créatif/aléatoire).

Utilisation de Python (bibliothèque requests) :

Tout d'abord, assurez-vous que la bibliothèque requests est installée : pip install requests

import requests

import json

import os

# Securely load your API key (e.g., from an environment variable)

api_key = os.environ.get("PERPLEXITY_API_KEY")

# Or uncomment and replace directly (less secure for production):

# api_key = "YOUR_PERPLEXITY_API_KEY"

if not api_key:

print("Error: PERPLEXITY_API_KEY environment variable not set.")

else:

url = "<https://api.perplexity.ai/chat/completions>"

payload = {

"model": "sonar-medium-online",

"messages": [

{

"role": "system",

"content": "Provide detailed explanations and cite sources."

},

{

"role": "user",

"content": "Explain the concept of Retrieval-Augmented Generation (RAG)."

}

],

"max_tokens": 800,

"temperature": 0.5,

# Add other parameters like 'frequency_penalty', 'presence_penalty' if needed

}

headers = {

"Authorization": f"Bearer {api_key}",

"Content-Type": "application/json"

}

try:

response = requests.post(url, headers=headers, json=payload)

response.raise_for_status() # Raise an exception for bad status codes (4xx or 5xx)

response_data = response.json()

print(json.dumps(response_data, indent=2))

# Extract the assistant's reply

if response_data.get("choices"):

assistant_message = response_data["choices"][0]["message"]["content"]

print("\\\\nAssistant's Response:\\\\n", assistant_message)

except requests.exceptions.RequestException as e:

print(f"An error occurred: {e}")

if e.response is not None:

print("Error details:", e.response.text)

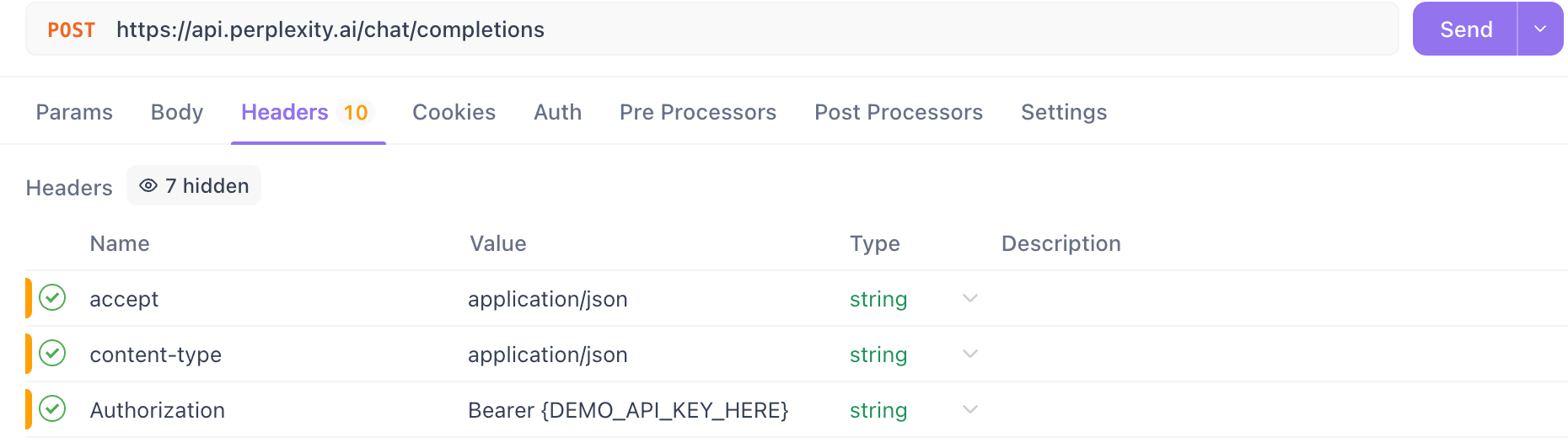

Étape 5 : Tester votre clé API Perplexity AI avec APIdog

Avant d'intégrer la clé API dans votre application, il est judicieux de la tester pour vous assurer qu'elle fonctionne correctement. APIdog est un outil convivial pour tester les API. Voici comment l'utiliser pour tester votre clé Perplexity :

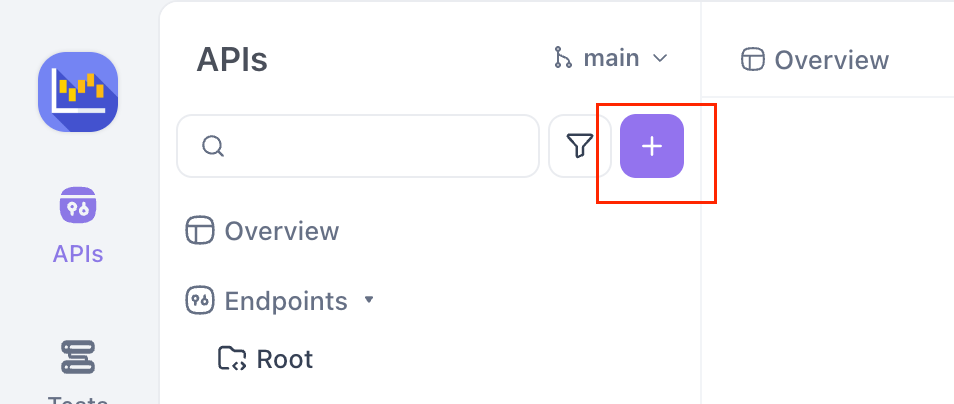

Téléchargez et ouvrez APIdog : Lancez l'application APIdog ou utilisez la version web.

Créez une nouvelle requête : Cliquez sur le bouton « + » ou une option similaire pour créer une nouvelle requête API.

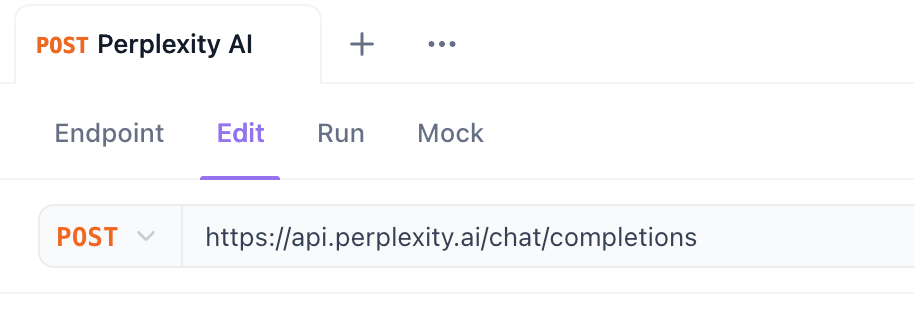

Définir la méthode sur POST : Remplacez le menu déroulant de la méthode HTTP par POST.

Entrez l'URL du point de terminaison : Dans le champ de saisie de l'URL, collez le point de terminaison des complétions de chat Perplexity : https://api.perplexity.ai/chat/completions

Configurer l'autorisation :

- Accédez à l'onglet « Autorisation » sous la barre d'URL.

- Sélectionnez « Jeton porteur » dans le menu déroulant de type.

- Dans le champ « Jeton », collez votre clé API Perplexity AI obtenue à l'étape 1.

Définir l'en-tête Content-Type :

- Accédez à l'onglet « En-têtes ».

- Ajoutez un nouvel en-tête. Définissez la clé sur

Content-Typeet la valeur surapplication/json.

Construire le corps de la requête :

- Accédez à l'onglet « Corps ».

- Sélectionnez l'option « brut » et choisissez « JSON » dans le menu déroulant à côté.

- Collez la structure JSON suivante dans la zone de texte, en remplaçant

"sonar-medium-online"par le modèle que vous souhaitez tester et en ajustant le"content"si vous le souhaitez :

{

"model": "sonar-medium-online",

"messages": [

{

"role": "system",

"content": "Be precise and factual."

},

{

"role": "user",

"content": "How many moons does Mars have?"

}

]

}

Envoyer la requête : Cliquez sur le bouton « Envoyer ».

Vérifiez la réponse : APIdog affichera la réponse de l'API Perplexity. Recherchez un code d'état 200 OK et une réponse JSON contenant la réponse de l'IA dans le champ choices[0].message.content. Si vous obtenez une erreur (comme un 401 Unauthorized ou 403 Forbidden), vérifiez que votre clé API a été collée correctement dans l'onglet Autorisation et que votre compte/clé Perplexity dispose des autorisations et des crédits nécessaires.

Vous voulez une plateforme intégrée, tout-en-un, pour que votre équipe de développeurs travaille ensemble avec une productivité maximale ?

Apidog répond à toutes vos demandes et remplace Postman à un prix beaucoup plus abordable !

Utilisation des modèles d'API Perplexity AI sans compte Pro direct (avec Openrouter)

Si vous n'avez pas d'abonnement Perplexity Pro ou si vous préférez un autre modèle de facturation/accès, vous pouvez souvent utiliser les modèles de Perplexity via des fournisseurs d'API tiers. OpenRouter en est un exemple populaire.

OpenRouter fournit un point de terminaison d'API unifié pour accéder à une grande variété de LLM de différents fournisseurs, y compris Perplexity. Vous payez OpenRouter en fonction de votre utilisation, et ils gèrent les appels backend vers les fournisseurs de modèles respectifs.

Vous pouvez consulter l'API Perplexity AI disponible ici :

Prérequis :

- Un compte OpenRouter (

openrouter.ai). - Financement ajouté à votre compte OpenRouter ou configuration de la facturation.

- Compréhension de base des API REST.

Étape 1 : Obtenez votre clé API OpenRouter

- Inscrivez-vous/Connectez-vous : Accédez à

openrouter.aiet créez un compte ou connectez-vous. - Accédez aux clés : Trouvez la section « Clés » ou « Clés API » dans les paramètres de votre compte.

- Créer une clé : Générez une nouvelle clé API.

- Copier et sécuriser : Copiez la clé générée et stockez-la en toute sécurité, comme la clé officielle Perplexity.

Étape 2 : Identifier les modèles d'API Perplexity AI sur OpenRouter

OpenRouter utilise sa propre convention de dénomination, préfixant souvent le nom du fournisseur. Les modèles Perplexity sur OpenRouter peuvent ressembler à :

perplexity/sonar-small-chatperplexity/sonar-small-onlineperplexity/sonar-medium-chatperplexity/sonar-medium-online- (Consultez la page /models d'OpenRouter pour la liste actuelle et les noms exacts)

Étape 3 : Effectuer une requête API via le point de terminaison OpenRouter pour les modèles d'API Perplexity AI

OpenRouter utilise un point de terminaison d'API compatible avec OpenAI :

https://openrouter.ai/api/v1/chat/completions

Vous structurez votre requête de la même manière que l'API officielle Perplexity ou l'API OpenAI, mais utilisez votre clé OpenRouter et le nom du modèle OpenRouter.

Utilisation de curl :

curl -X POST <https://openrouter.ai/api/v1/chat/completions> \\\\

-H "Authorization: Bearer YOUR_OPENROUTER_API_KEY" \\\\

-H "Content-Type: application/json" \\\\

-H "HTTP-Referer: YOUR_SITE_URL" \\\\ # Optional, but recommended by OpenRouter

-H "X-Title: YOUR_APP_NAME" \\\\ # Optional, but recommended by OpenRouter

-d '{

"model": "perplexity/sonar-medium-online",

"messages": [

{"role": "user", "content": "How does OpenRouter provide access to the Perplexity AI API models?"}

]

}'

Remarque : OpenRouter recommande d'ajouter les en-têtes HTTP-Referer et X-Title pour identifier votre application. Remplacez YOUR_OPENROUTER_API_KEY, YOUR_SITE_URL et YOUR_APP_NAME en conséquence.

Étape 4 : Gérer la réponse OpenRouter pour les modèles d'API Perplexity AI

La structure de la réponse d'OpenRouter est généralement identique à la norme OpenAI/Perplexity, y compris les champs choices, message, content et usage. La principale différence est que les coûts sont calculés en fonction des prix d'OpenRouter pour le modèle Perplexity spécifique que vous avez utilisé.

Avantages de l'utilisation d'OpenRouter :

- Accédez aux modèles Perplexity sans avoir besoin d'un abonnement Perplexity Pro direct.

- Facturation consolidée pour plusieurs LLM de différents fournisseurs.

- Clé et point de terminaison d'API uniques pour divers modèles.

Considérations :

- Les prix peuvent différer des coûts directs de l'API de Perplexity.

- Potentiel de latence légèrement plus élevée en raison du saut supplémentaire.

- Dépend de la disponibilité de la plateforme OpenRouter et de son intégration avec Perplexity.

Conclusion

Ce tutoriel fournit un guide détaillé pour accéder aux modèles puissants derrière Perplexity AI via diverses méthodes d'API. N'oubliez pas de toujours consulter la documentation officielle de Perplexity, OpenRouter pour les noms de modèles, les points de terminaison, les prix et les fonctionnalités les plus récents. Sécurisez vos clés API et choisissez la méthode d'accès qui convient le mieux aux exigences et au budget de votre projet.