Et si vous pouviez contrôler Claude Code ou Gemini 3 Pro depuis WhatsApp ou Telegram sans toucher un terminal ? OpenClaw rend cela possible, transformant vos modèles d'IA préférés en assistants basés sur la messagerie avec lesquels vous pouvez discuter de n'importe où.

Le Problème : Accès à l'IA Verrouillé au Terminal

Claude Code et Gemini 3 Pro exécutent de puissants modèles d'IA, mais ils vous lient à un terminal ou à une fenêtre de navigateur. Vous ne pouvez pas envoyer de commandes lorsque vous n'êtes pas à votre bureau. Vous ne pouvez pas vérifier l'état pendant vos trajets. Vous ne pouvez pas déléguer de tâches sans être assis devant votre clavier.

OpenClaw résout ce problème en créant une passerelle entre les modèles d'IA et les plateformes de messagerie. Il s'exécute localement sur votre machine, se connecte à Claude Code ou Gemini 3 Pro à l'aide de vos identifiants API existants et transmet les messages via Telegram, WhatsApp, Discord ou Slack. Vous bénéficiez de toutes les capacités de l'IA via des interfaces de chat familières.

Vous voulez une plateforme intégrée tout-en-un pour que votre équipe de développeurs travaille ensemble avec une productivité maximale?

Apidog répond à toutes vos exigences et remplace Postman à un prix beaucoup plus abordable!

Installation d'OpenClaw

OpenClaw nécessite Node.js 22 ou supérieur. Vérifiez votre installation :

node -v

- Installez OpenClaw en utilisant l'installateur officiel :

curl -fsSL https://openclaw.ai/install.sh | bash

L'installateur détecte votre système d'exploitation, vérifie les dépendances et gère la configuration automatiquement. Aucun clonage de dépôt ni configuration manuelle n'est nécessaire.

- Les utilisateurs Windows exécutent l'équivalent PowerShell :

iwr -useb https://openclaw.ai/install.ps1 | iex

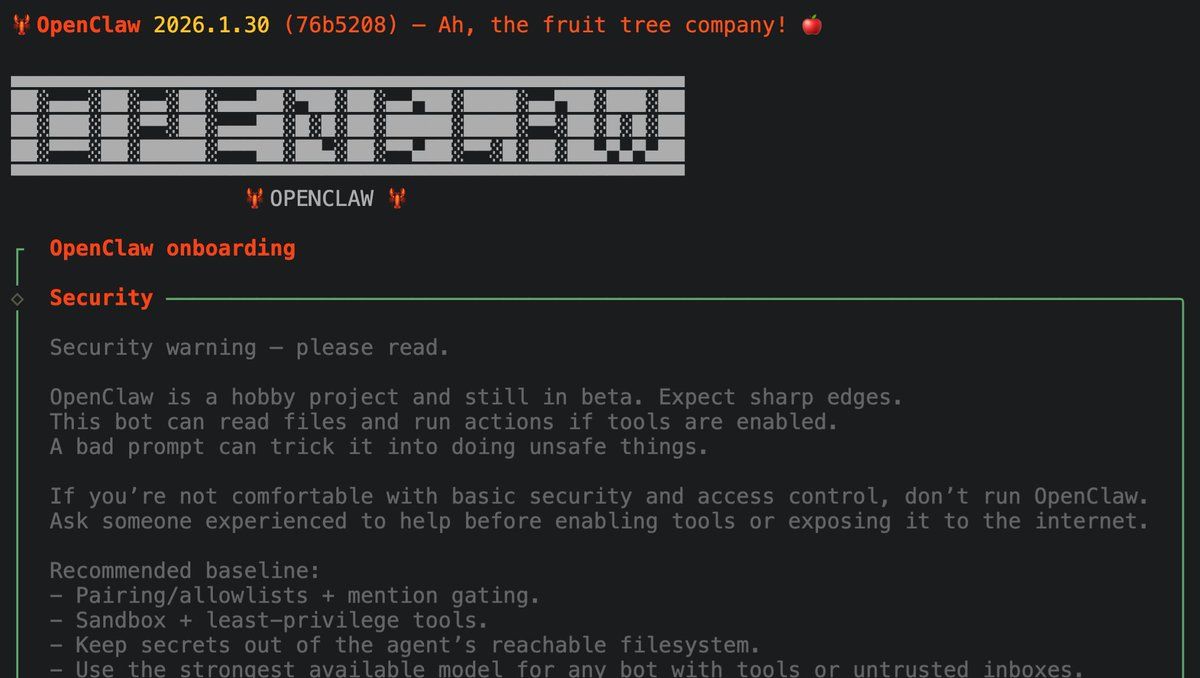

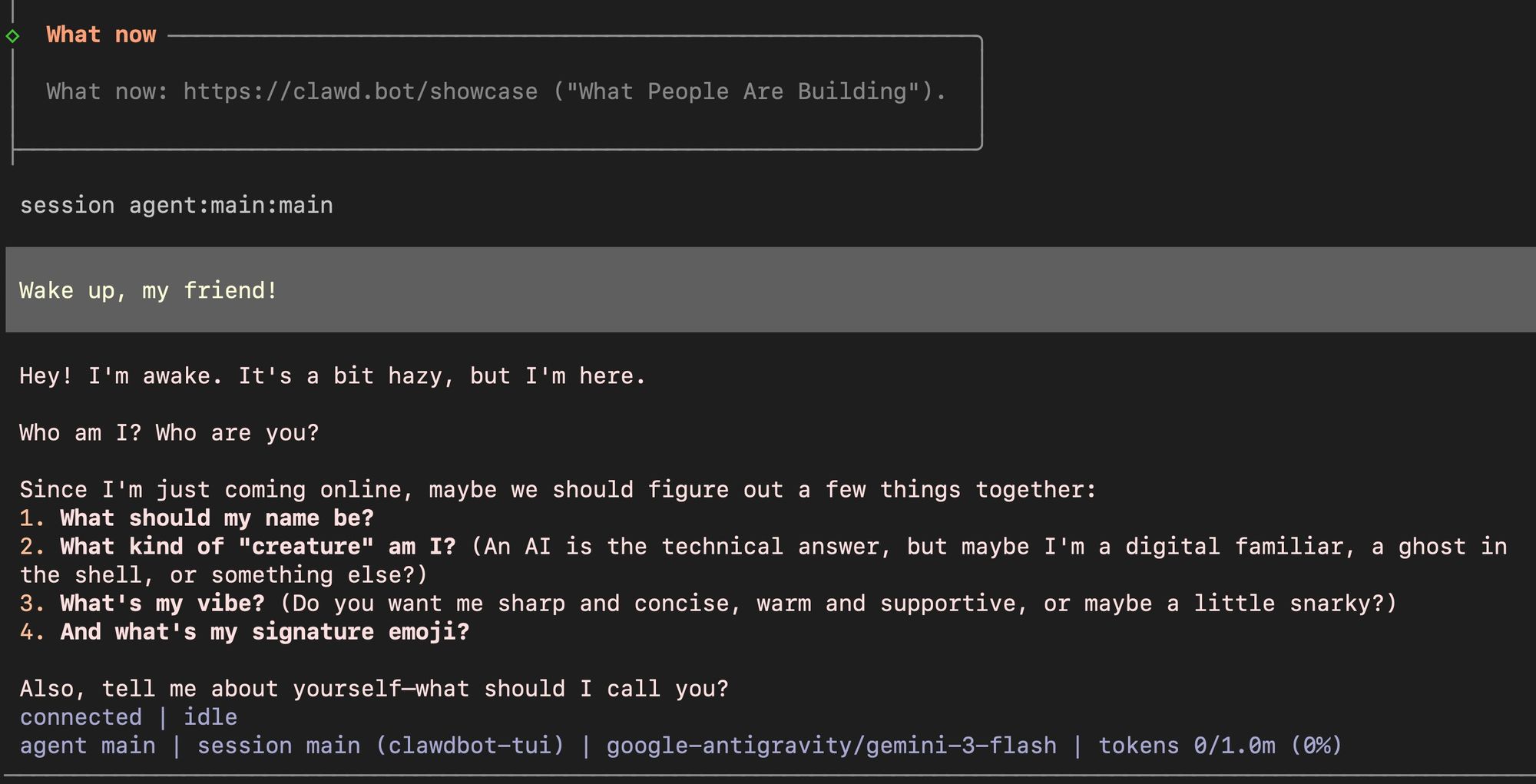

Une fois l'installation terminée, OpenClaw lance une interface utilisateur de terminal interactive (TUI). Cette interface axée sur la conversation vous guide à travers la configuration à l'aide d'invites en langage naturel plutôt que de fichiers de configuration complexes.

Vérification Post-Installation

Vérifiez qu'OpenClaw est correctement installé en vérifiant sa version :

openclaw --versionLe terminal devrait afficher le numéro de version actuel. Si vous voyez une erreur "command not found", assurez-vous que Node.js est dans votre PATH et redémarrez votre terminal. L'installateur ajoute automatiquement OpenClaw au chemin d'exécution de votre système, mais certains shells nécessitent un redémarrage pour reconnaître les nouvelles commandes.

Configuration de Claude Code et Gemini 3 Pro

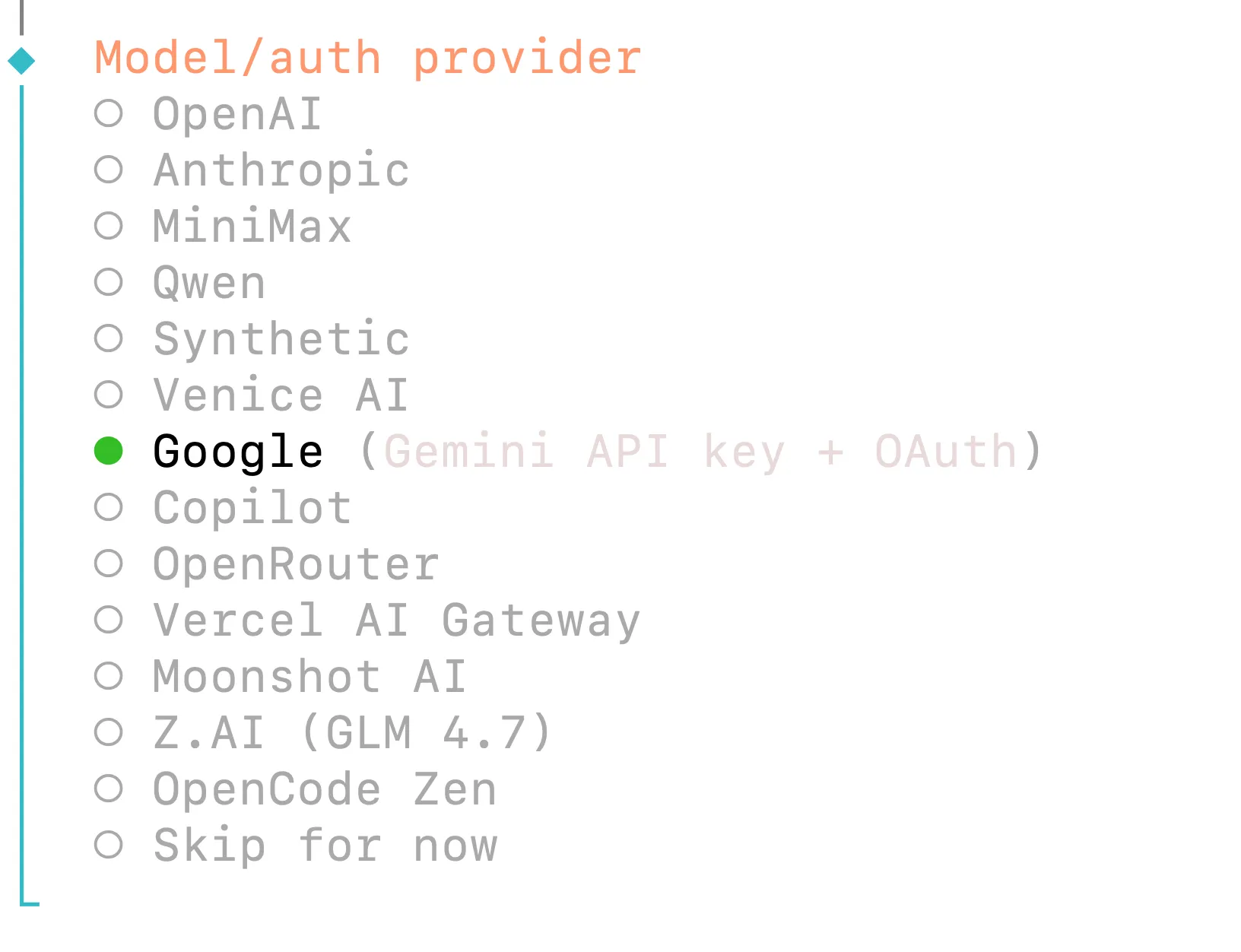

OpenClaw prend en charge plusieurs fournisseurs d'IA. Vous pouvez utiliser Claude Code via l'API d'Anthropic ou Gemini 3 Pro via l'API de Google, quels que soient les identifiants que vous possédez déjà.

Pour Gemini 3 Pro (Google) :

Sélectionnez "Google" (pour Google Gemini 3 Pro) dans la liste des fournisseurs de modèles. Choisissez votre méthode d'authentification :

- Clé API Google Gemini - Authentification directe par clé API

- Google Antigravity OAuth - Utilise un plugin d'authentification intégré

- Google Gemini CLI OAuth - Flux OAuth en ligne de commande

L'option de clé API Gemini fonctionne immédiatement si vous avez une clé de Google AI Studio. Les options OAuth nécessitent une authentification par navigateur mais offrent une sécurité renforcée.

Pour Claude Code (Anthropic) :

Pendant l'assistant d'intégration, sélectionnez "Anthropic" (pour Claude Code) comme fournisseur de modèle. Saisissez votre clé API lorsque vous y êtes invité :

openclaw onboard

# Select: Anthropic API Key

# Enter: sk-ant-api03-your-key-here

Les clés API Anthropic sont disponibles sur console.anthropic.com. OpenClaw stocke votre clé en toute sécurité dans ~/.openclaw/openclaw.json.

Structure du Fichier de Configuration

Vos sélections sont enregistrées dans ~/.openclaw/openclaw.json :

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-opus-4-5"

}

}

},

"env": {

"ANTHROPIC_API_KEY": "sk-ant-..."

}

}

Changez de modèle à tout moment en modifiant ce fichier ou en réexécutant openclaw onboard.

Stratégie de Sélection des Modèles

Choisissez votre modèle principal en fonction des exigences de la tâche. Claude Code excelle dans le raisonnement complexe, la génération de code et les workflows agentiques nécessitant l'utilisation d'outils. Gemini 3 Pro offre des temps de réponse plus rapides et des capacités multimodales plus robustes pour les tâches de vision. Les deux modèles prennent en charge l'appel de fonctions et les fenêtres de contexte étendues.Vous pouvez configurer des modèles de repli dans le même fichier de configuration. Si votre modèle principal rencontre des limites de débit ou des erreurs, OpenClaw bascule automatiquement vers le modèle de repli :

{

"agents": {

"defaults": {

"model": {

"primary": "anthropic/claude-opus-4-5",

"fallback": "google/gemini-3-pro"

}

}

}

}Cela assure un fonctionnement continu même lorsqu'un fournisseur subit une panne.

Mise en Cache des Requêtes (Anthropic uniquement)

OpenClaw active automatiquement la mise en cache des requêtes pour les modèles Anthropic. Cela réduit les coûts pour les requêtes similaires répétées. La durée de cache par défaut est de 5 minutes (rétention courte). Étendez-la à 1 heure en ajoutant le drapeau bêta extended-cache-ttl-2025-04-11 dans votre configuration.

Configuration des Canaux de Messagerie dans OpenClaw

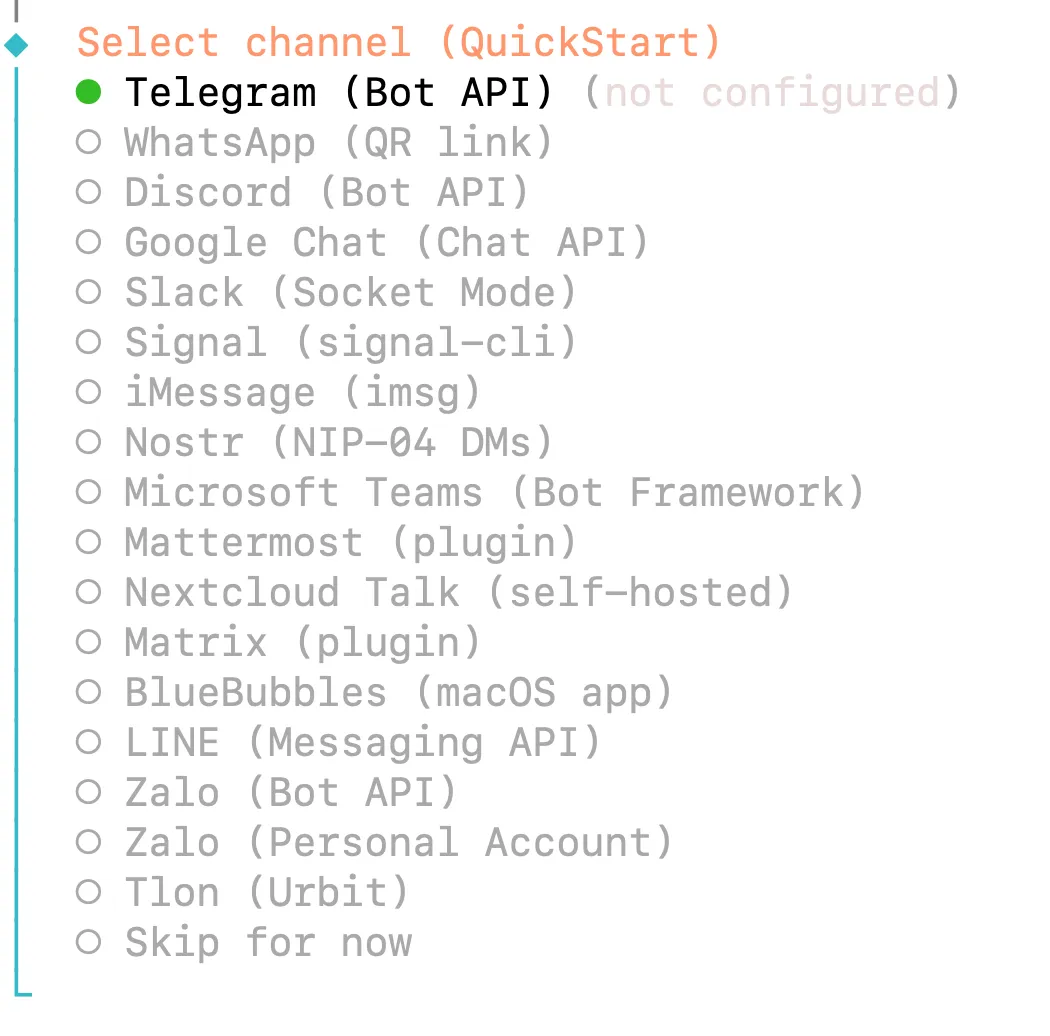

OpenClaw prend en charge huit plateformes de messagerie. Telegram et WhatsApp offrent la configuration la plus simple pour les utilisateurs qui préfèrent les interfaces de chat aux terminaux.

Configuration de Telegram

Telegram utilise l'API Bot, offrant une authentification propre sans codes QR.

Créez un bot via @BotFather de Telegram :

- Ouvrez Telegram et recherchez @BotFather

- Envoyez

/newbotet suivez les instructions - Choisissez un nom (par exemple, "Mon Assistant OpenClaw")

- Choisissez un nom d'utilisateur se terminant par "bot" (par exemple, "myclawbot")

- Copiez le jeton API fourni

Pendant l'intégration d'OpenClaw, collez ce jeton lorsque vous y êtes invité. La passerelle se connecte immédiatement et affiche un message de confirmation.

Configuration de WhatsApp

WhatsApp utilise le jumelage par code QR via le protocole WhatsApp Web.

Exécutez la commande de connexion au canal :

openclaw channels login

Un code QR apparaît dans votre terminal. Scannez-le avec votre téléphone :

- Ouvrez WhatsApp → Paramètres → Appareils connectés

- Appuyez sur "Connecter un appareil"

- Scannez le code QR affiché

La connexion persiste jusqu'à ce que vous dissociiez manuellement l'appareil. Utilisez un numéro de téléphone dédié pour OpenClaw plutôt que votre numéro personnel — cela protège vos messages privés si le bot se comporte mal.

Sécurité : Jumelage des Canaux

Lorsqu'une personne envoie un message à votre bot pour la première fois, OpenClaw envoie un code de jumelage. Approuvez l'accès via la CLI :

openclaw pairing approve telegram <CODE>

Cela empêche l'accès non autorisé même si quelqu'un découvre le nom d'utilisateur de votre bot. Configurez l'approbation automatique pour les contacts de confiance dans ~/.openclaw/openclaw.json si vous le souhaitez.

Plusieurs Canaux

OpenClaw fonctionne simultanément sur plusieurs plateformes. Envoyez des commandes via Telegram, recevez des notifications via WhatsApp et surveillez l'état via Discord — le tout connecté au même backend IA. Chaque canal maintient des contrôles d'accès et un statut de jumelage séparés.

Configuration de la Sécurité des Canaux

Contrôlez qui peut interagir avec votre assistant IA à l'aide de listes d'autorisation. Configurez-les dans ~/.openclaw/openclaw.json :

Liste d'autorisation Telegram :

{

"channels": {

"telegram": {

"token": "YOUR_BOT_TOKEN",

"allowedChatIds": [123456789, 987654321]

}

}

}Liste d'autorisation WhatsApp :

{

"channels": {

"whatsapp": {

"allowFrom": ["+1234567890", "+0987654321"]

}

}

}Restreindre l'accès empêche les utilisateurs non autorisés de consommer votre quota API ou d'accéder à votre assistant IA. Sans liste d'autorisation, toute personne qui découvre le nom d'utilisateur de votre bot peut envoyer des messages et déclencher des requêtes IA.

Gestion de votre Agent IA OpenClaw

Une fois configuré, interagissez avec votre agent IA via des messages en langage naturel. OpenClaw traite votre texte, l'envoie à Claude Code ou Gemini 3 Pro, et renvoie la réponse via votre plateforme de messagerie.

Commandes de Base

Envoyez n'importe quelle requête directement :

Analyze the code in ~/projects/myapp and suggest optimizations

Vérifiez l'état du système :

/status

Ceci affiche le modèle actif, l'utilisation des jetons et le coût actuel.

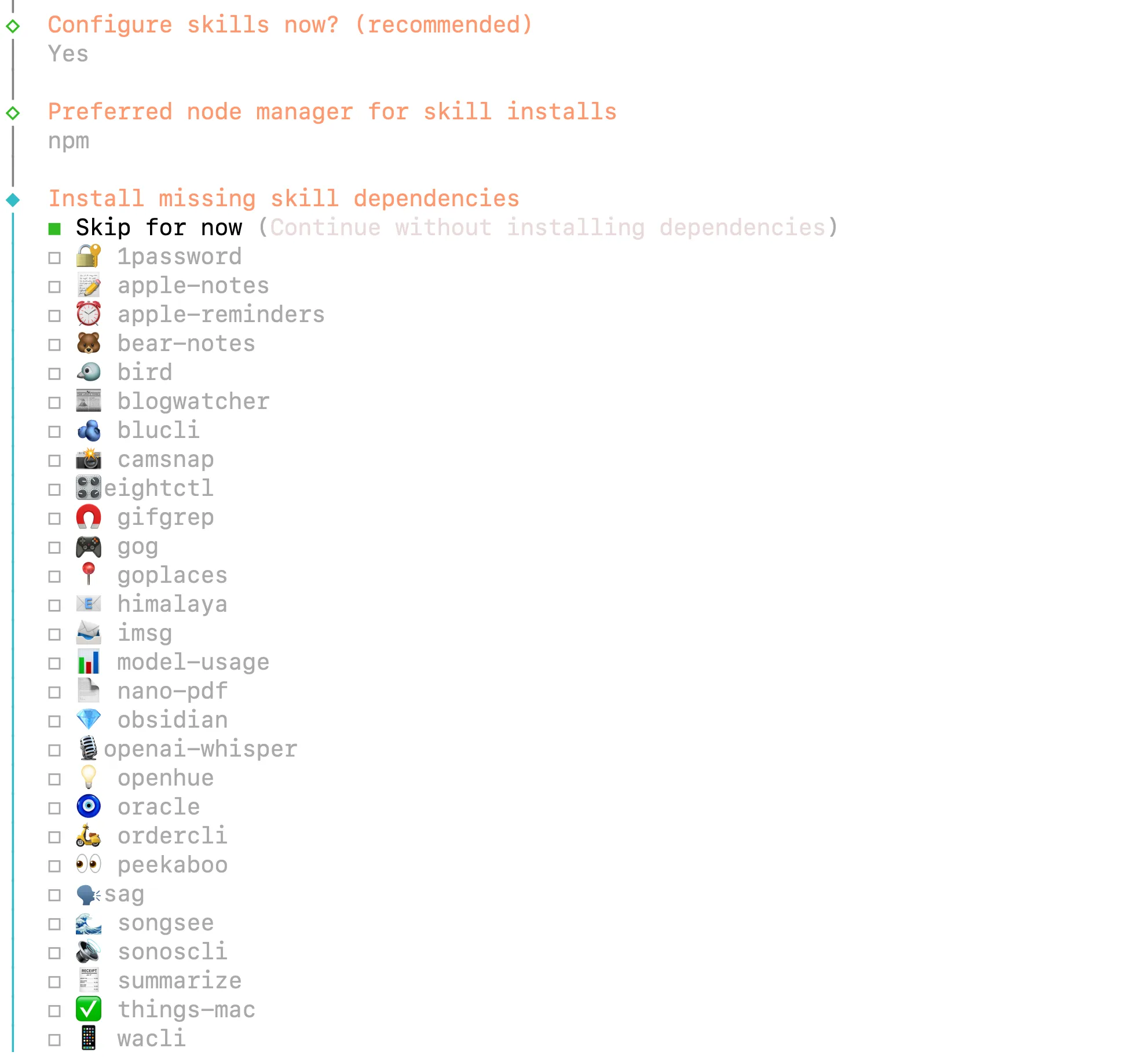

Compétences et Extensions

OpenClaw utilise des "compétences" — des dossiers d'outils qui étendent les capacités. Activez les compétences pendant l'intégration ou ajoutez-les plus tard :

- Accès au système de fichiers - Lire, écrire et gérer des fichiers

- Automatisation du navigateur - Naviguer sur des sites web, extraire des données

- Recherche web - Moteurs de recherche avec des résumés de résultats

- Intégration d'e-mails - Envoyer et recevoir des e-mails

- Accès au calendrier - Planifier et récupérer des événements

Les compétences se configurent automatiquement lorsque vous les activez. Le bot apprend les outils disponibles et les invoque en fonction de vos requêtes en langage naturel.

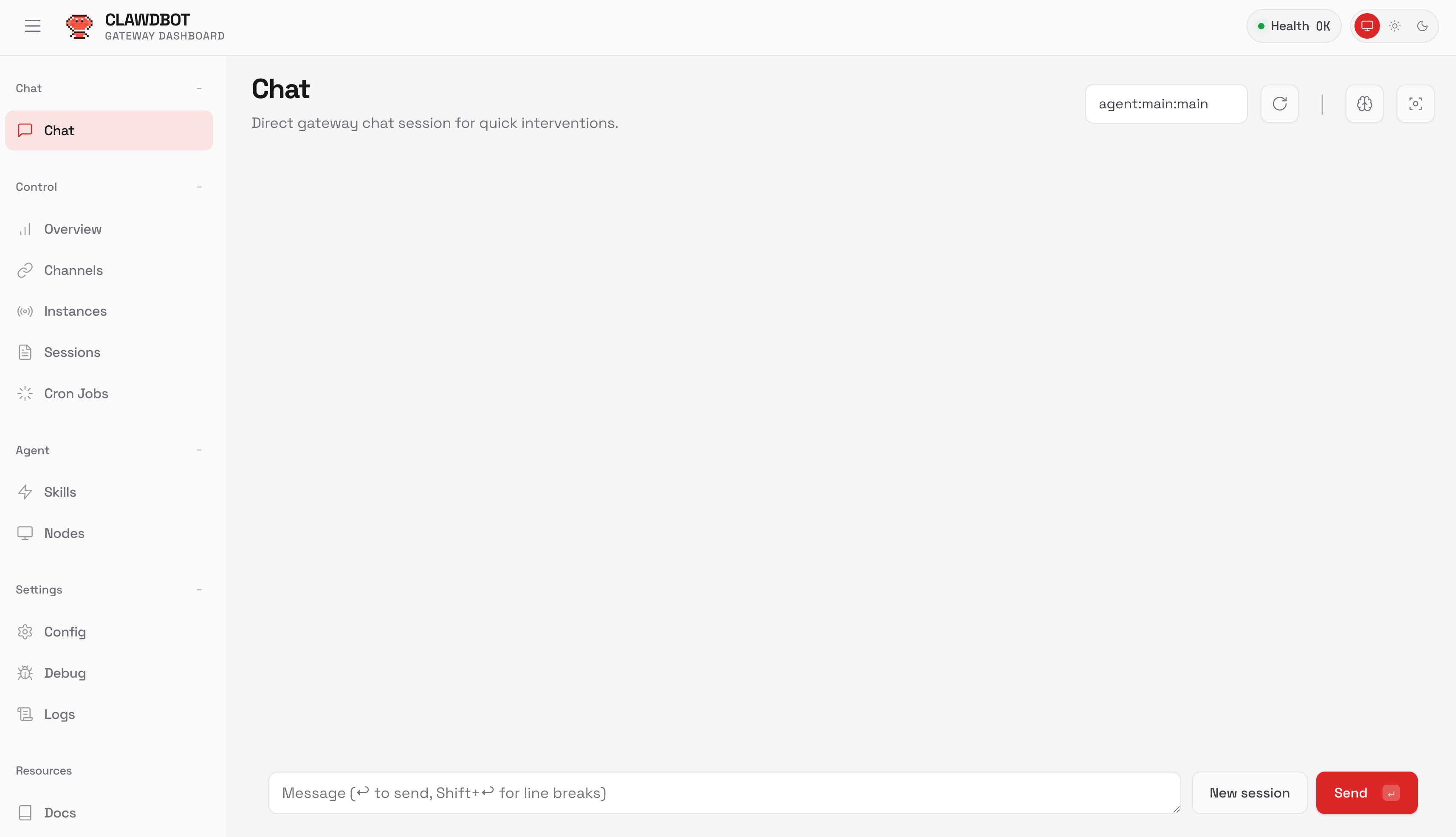

Tableau de Bord Web

Accédez à l'interface de gestion à l'adresse http://localhost:18789 (ou votre port configuré). Le tableau de bord affiche :

- Connexions de canal actives

- Historique des messages et journaux

- Configuration et commutation des modèles

- Utilisation des jetons et suivi des coûts

- Gestion des compétences

Ceci offre une alternative à la gestion par terminal pour les utilisateurs qui préfèrent les interfaces graphiques.

Mémoire Persistante

Contrairement aux chatbots sans état, OpenClaw maintient le contexte à travers les conversations. Il stocke l'historique des conversations, les préférences de l'utilisateur et les modèles appris localement à l'aide de SQLite. Votre assistant se souvient des discussions précédentes et améliore les réponses au fil du temps.

Configurez la rétention dans ~/.openclaw/openclaw.json :

{

"memory": {

"enabled": true,

"database": "./data/openclaw.db",

"retention_days": 90

}

}

Commandes de Gestion de la Mémoire

Effacez l'historique des conversations si les réponses deviennent incohérentes ou si vous souhaitez repartir à zéro : openclaw memory clear

Exportez la mémoire pour la sauvegarde ou l'analyse : openclaw memory export > backup.json

Importez les mémoires précédemment exportées : openclaw memory import backup.json

Les fichiers de mémoire contiennent l'historique des conversations et les préférences apprises. Stockez les sauvegardes en toute sécurité — elles peuvent contenir des informations sensibles provenant d'interactions précédentes.

Exigences de Contexte

OpenClaw nécessite des modèles avec une longueur de contexte d'au moins 64 000 jetons. Claude Code et Gemini 3 Pro dépassent cette exigence. Si vous utilisez des modèles locaux via Ollama, vérifiez la longueur du contexte :

ollama show <model> --modelfile

Augmentez-le avec un Modelfile personnalisé si nécessaire :

FROM <model>

PARAMETER num_ctx 65536

Exécution en tant que Service

Activez le démarrage automatique au boot en installant le démon pendant l'intégration :

openclaw onboard --install-daemon

Ou démarrez manuellement :

openclaw gateway --port 18789 --verbose

La passerelle fonctionne de manière persistante, traitant les messages et maintenant les connexions de canal. Vérifiez l'état à tout moment :

openclaw gateway status

Considérations de Sécurité

Exécutez OpenClaw en tant qu'utilisateur non privilégié. Isolez-le sur un VPS ou une machine dédiée si possible. Examinez les permissions des compétences avant de les activer — l'accès au système de fichiers permet au bot de lire et d'écrire des fichiers partout où votre utilisateur dispose des permissions.

Stockez les clés API dans des variables d'environnement ou la configuration sécurisée d'OpenClaw, jamais dans le contrôle de version. Changez les clés tous les trimestres. Surveillez le tableau de bord pour toute activité inhabituelle.

Mise à Jour d'OpenClaw

Maintenez OpenClaw à jour pour recevoir les correctifs de sécurité et les nouvelles fonctionnalités :

npm update -g openclawOu réexécutez l'installateur :

curl -fsSL https://openclaw.ai/install.sh | bashConsultez le journal des modifications avant les mises à jour majeures. Les fichiers de configuration restent compatibles entre les versions, mais les nouvelles fonctionnalités peuvent nécessiter des ajustements de configuration.

Modèles de Commandes Avancées OpenClaw

Utilisez les commandes slash pour contrôler le comportement d'OpenClaw directement depuis le chat : /run default "Analyze this codebase"

Ceci exécute une compétence ou une recette spécifique. Les recettes sont des flux de travail prédéfinis combinant plusieurs compétences — comme vérifier les e-mails, résumer les événements du calendrier et générer un rapport quotidien.

Forcez des niveaux de raisonnement spécifiques : Liste de contrôle d'expédition /think high

Le drapeau /think high active le mode de raisonnement étendu pour les problèmes complexes. Utilisez /think low pour les requêtes simples afin de réduire le temps de réponse et la consommation de jetons.

Déclenchez l'automatisation du navigateur : Réservez le vol le moins cher pour Berlin le mois prochain

OpenClaw lance un navigateur, recherche des agrégateurs de vols, compare les prix et renvoie la meilleure option avec des liens de réservation.

Conclusion

OpenClaw transforme Claude Code et Gemini 3 Pro, d'outils liés au terminal, en assistants de messagerie accessibles. Vous configurez une seule fois à l'aide de vos identifiants API existants, connectez votre plateforme de messagerie préférée et interagissez via un chat naturel. Votre IA gère les tâches complexes pendant que vous restez mobile.

Lors de la création d'intégrations API — qu'il s'agisse de tester les points de terminaison OpenClaw, de déboguer les flux d'authentification ou de gérer plusieurs configurations de fournisseurs — rationalisez votre développement avec Apidog. Il offre des tests d'API visuels, une génération automatique de documentation et des outils de débogage collaboratifs qui complètent votre flux de travail d'assistant IA.