OpenAI est depuis longtemps un leader dans le domaine de l'intelligence artificielle, faisant progresser continuellement les capacités des modèles d'apprentissage automatique. Leur dernière offre, le modèle o3-pro, marque une nouvelle étape importante dans ce parcours. Dévoilé début 2025, o3-pro se distingue par ses performances et son adaptabilité exceptionnelles, ce qui en fait un atout majeur dans le paysage de l'IA. Cet article explore les benchmarks, la tarification et la tarification de l'API du modèle o3-pro d'OpenAI, offrant un aperçu détaillé de ce qui fait de ce modèle une innovation remarquable.

Vous voulez une plateforme intégrée, tout-en-un, pour que votre équipe de développeurs travaille ensemble avec une productivité maximale ?

Apidog répond à toutes vos demandes et remplace Postman à un prix beaucoup plus abordable !

Qu'est-ce qu'OpenAI o3-pro ?

Le modèle o3-pro d'OpenAI est un modèle linguistique de pointe conçu pour s'attaquer à un large éventail de tâches avec une précision et une rapidité impressionnantes. Il s'appuie sur l'héritage des modèles précédents comme GPT-4 et o1, intégrant les dernières avancées en traitement du langage naturel, apprentissage automatique et apprentissage profond. Son architecture est optimisée pour offrir à la fois un traitement rapide et une grande précision, répondant ainsi à un large éventail d'applications, de la simple génération de texte à la résolution de problèmes complexes.

I’ve been secretly testing o3-pro for a while now 👀

— Flavio Adamo (@flavioAd) June 10, 2025

Extremely cheaper, faster, and way more precise than o1-pro (and coding with o3 vs o3-pro is night and day)

Got some cool tests coming, starting with (of course) a tougher version of the Hexagon Bauncing ball

o3-pro is the… https://t.co/BDUyA7TXms pic.twitter.com/fG5l7LlGp4

Une caractéristique distinctive d'o3-pro est sa capacité à produire et à comprendre du texte qui imite étroitement la communication humaine, en maintenant la cohérence et la pertinence même dans des scénarios complexes. Cela est rendu possible grâce à de vastes ensembles de données d'entraînement, des algorithmes avancés et des techniques d'entraînement innovantes. Au-delà du texte, o3-pro prend en charge les entrées multimodales, gérant de manière transparente des types de données comme les images parallèlement au texte, élargissant ainsi son utilité.

Ce modèle excelle dans les tâches nécessitant une compréhension contextuelle approfondie, telles que la synthèse de longs documents, la traduction de langues ou la réponse à des questions nuancées. Il excelle également dans les efforts créatifs, y compris l'écriture de récits, le codage et même la génération de compositions musicales. Avec de telles capacités polyvalentes, o3-pro est appelé à transformer des industries comme l'éducation, la santé, le divertissement et la finance, offrant des outils puissants tant aux particuliers qu'aux organisations.

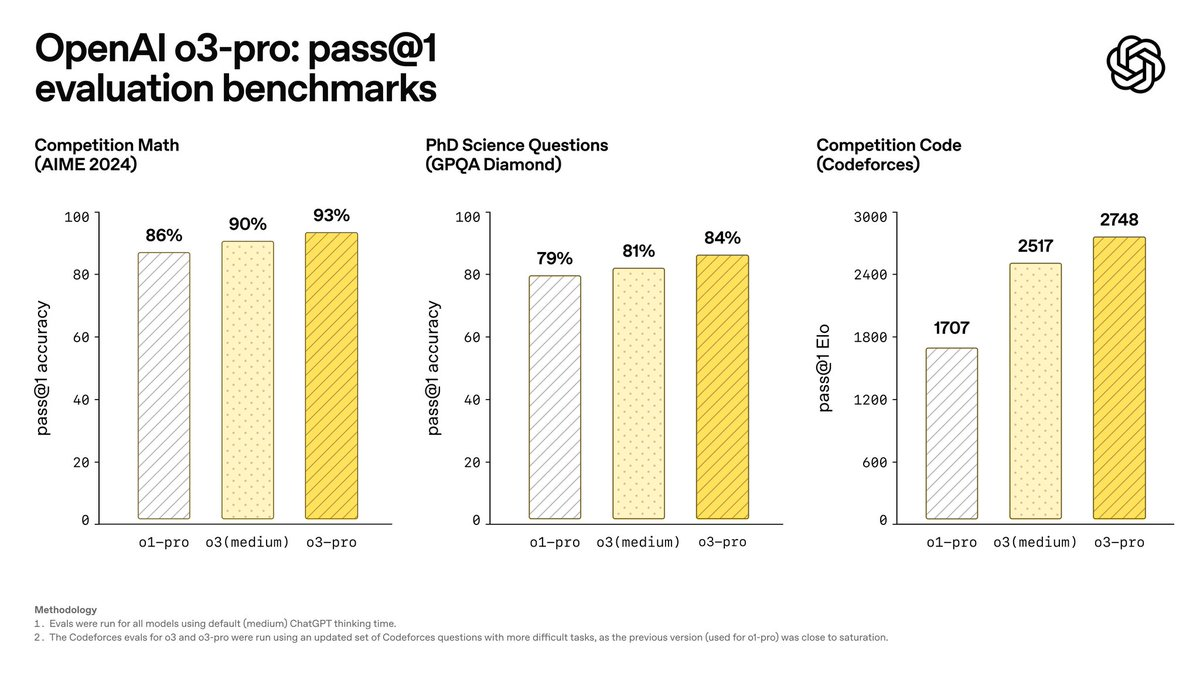

Benchmarks d'OpenAI o3-pro

Les benchmarks sont essentiels pour évaluer les performances d'un modèle d'IA, et o3-pro a placé la barre plus haut sur plusieurs métriques. Les évaluations internes d'OpenAI révèlent qu'o3-pro excelle sur les benchmarks d'IA importants, démontrant sa supériorité dans des domaines comme les mathématiques et les connaissances scientifiques.

Dans le benchmark AIME 2024, qui teste les compétences mathématiques, o3-pro surpasse le modèle phare de Google, Gemini 2.5 Pro. Cette réussite souligne sa capacité exceptionnelle à résoudre des équations complexes et à appliquer un raisonnement logique, ce qui en fait un atout précieux pour les applications techniques et académiques.

De même, sur le benchmark GPQA Diamond – une évaluation rigoureuse de la compréhension scientifique de niveau doctorat – o3-pro surpasse Claude 4 Opus d'Anthropic. Cela démontre sa compréhension profonde et précise des concepts scientifiques avancés, le positionnant comme un choix de premier ordre pour la recherche et l'utilisation professionnelle.

Au-delà de ces tests spécifiques, o3-pro démontre des forces remarquables en compréhension du langage naturel, en vitesse de génération de texte et en performance des tâches multimodales. Sa capacité à maintenir la précision tout en traitant les données rapidement le distingue de ses concurrents. OpenAI a également testé rigoureusement o3-pro pour sa fiabilité, le soumettant à des tests de résistance et à des défis adverses pour garantir qu'il reste stable et sécurisé dans des conditions exigeantes. Ces résultats confirment qu'o3-pro est un modèle puissant et fiable, prêt pour un déploiement dans le monde réel.

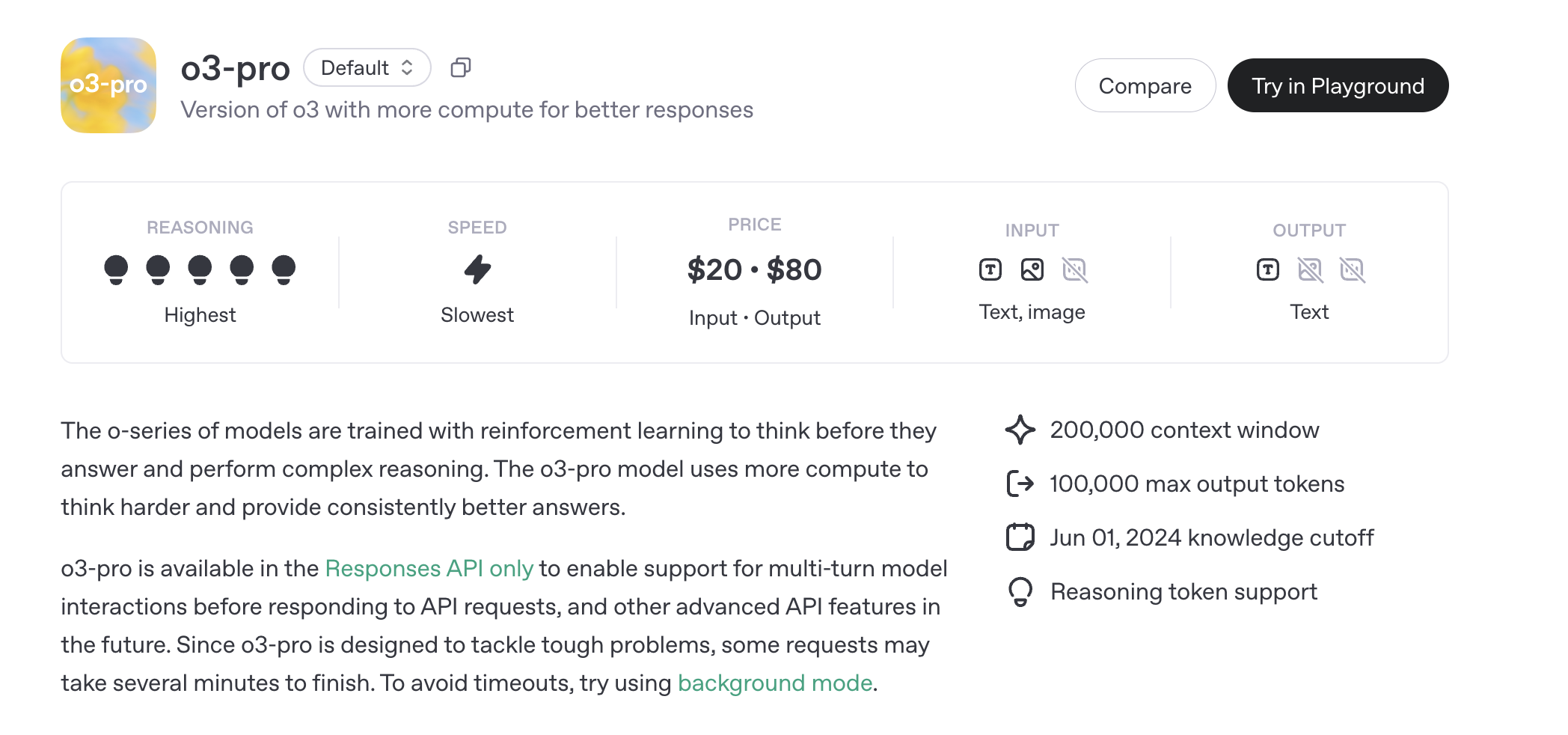

Tarification d'OpenAI o3-pro

La tarification d'OpenAI pour o3-pro est structurée autour de l'utilisation de son API, sans plans d'abonnement autonomes pour l'accès individuel ou professionnel. Au lieu de cela, les coûts sont liés à la consommation de tokens, reflétant la nature intensive en calcul du modèle. Vous trouverez ci-dessous une ventilation détaillée de la structure tarifaire.

Tarification de l'API o3-pro

Le modèle o3-pro est accessible uniquement via l'API Responses, avec une tarification basée sur le nombre de tokens traités. Les tokens représentent des morceaux de texte, avec environ 1 million de tokens équivalant à 750 000 mots – à peu près la longueur d'un roman comme Guerre et Paix.

- Tokens d'entrée : 20,00 $ par million de tokens

- Tokens de sortie : 80,00 $ par million de tokens

Les tokens de sortie sont plus chers en raison de la demande computationnelle plus élevée pour générer des réponses. À titre de comparaison, le modèle standard o3 coûte 2,00 $ par million de tokens d'entrée et 8,00 $ par million de tokens de sortie, tandis qu'o3-mini est encore moins cher à 1,10 $ et 4,40 $, respectivement. Le coût élevé d'o3-pro reflète ses exigences accrues en matière de raisonnement et de calcul.

Des coûts supplémentaires peuvent s'appliquer pour des fonctionnalités spécifiques aux outils, telles que la recherche de fichiers ou la génération d'images, qui entraînent des frais par appel. Par exemple, l'utilisation de l'outil de recherche de fichiers ou l'intégration de la génération d'images via l'API s'ajoutera au coût total en fonction de l'utilisation.

Tarification de l'API Batch o3-pro

Pour les utilisateurs à volume élevé, OpenAI propose une option d'API Batch, qui traite les requêtes de manière asynchrone pour une meilleure rentabilité. La tarification de l'API Batch pour o3-pro reflète les tarifs standards : 20,00 $ par million de tokens d'entrée et 80,00 $ par million de tokens de sortie. C'est idéal pour les applications nécessitant un traitement à grande échelle, comme l'analyse de données ou la génération de contenu en masse.

Tarification Entreprise et Personnalisée

Les entreprises ayant une utilisation intensive de l'API peuvent négocier des plans tarifaires personnalisés, qui peuvent inclure des remises sur volume et un support amélioré. Ces plans sont adaptés à l'échelle du projet, garantissant la rentabilité pour les déploiements à grande échelle. OpenAI propose également des capacités de fine-tuning, permettant aux développeurs de personnaliser o3-pro pour des tâches spécifiques, bien que cela entraîne des coûts supplémentaires basés sur les ressources computationnelles.

Remises et Accessibilité

Pour promouvoir l'accessibilité, OpenAI propose des tarifs réduits pour les institutions éducatives et les organisations à but non lucratif. Les organisations éligibles peuvent demander des remises, rendant o3-pro plus abordable pour la recherche académique ou les projets à impact social. Des promotions périodiques peuvent également réduire les coûts pour les nouveaux utilisateurs ou les utilisateurs à volume élevé.

Limites de débit d'o3-pro

Les limites de débit sont essentielles pour garantir un accès équitable et fiable à l'API, plafonnant le nombre de requêtes ou de tokens traités dans une période donnée. Les limites de débit d'OpenAI pour o3-pro varient selon le niveau d'utilisation, s'adaptant automatiquement à mesure que les utilisateurs augmentent leur activité API et leurs dépenses.

Vous trouverez ci-dessous une ventilation des niveaux et de leurs limites respectives :

- Niveau Gratuit : Non pris en charge pour o3-pro.

- Niveau 1 : 500 requêtes par minute (RPM), 30 000 tokens par minute (TPM), limite de file d'attente batch de 90 000.

- Niveau 2 : 5 000 RPM, 450 000 TPM, limite de file d'attente batch de 1 350 000.

- Niveau 3 : 5 000 RPM, 800 000 TPM, limite de file d'attente batch de 50 000 000.

- Niveau 4 : 10 000 RPM, 2 000 000 TPM, limite de file d'attente batch de 200 000 000.

- Niveau 5 : 10 000 RPM, 30 000 000 TPM, limite de file d'attente batch de 5 000 000 000.

Les niveaux supérieurs débloquent une capacité accrue, permettant aux développeurs de gérer des charges de travail plus importantes. La limite de file d'attente batch régit le nombre de tokens pouvant être mis en file d'attente pour un traitement asynchrone, ce qui est essentiel pour les utilisateurs de l'API Batch. Ces limites garantissent un accès équitable tout en s'adaptant à divers cas d'utilisation, des applications à petite échelle aux solutions d'entreprise.

Fonctionnalités et limitations de l'API o3-pro

Le modèle o3-pro prend en charge une gamme de points de terminaison (endpoints) et de fonctionnalités de l'API, bien que certains ne soient pas disponibles en raison de sa conception intensive en calcul :

- Points de terminaison pris en charge : Chat Completions, Responses, Assistants, Batch, Fine-tuning, Embeddings, Génération d'images, Modification d'images, Génération vocale, Transcription, Traduction, Modération.

- Points de terminaison non pris en charge : Realtime, Completions (hérité).

- Fonctionnalités :

- Appel de fonction : Pris en charge, permettant l'intégration avec des outils externes.

- Sorties structurées : Prises en charge, garantissant des formats de réponse cohérents.

- Outils : La recherche de fichiers, la génération d'images et le MCP (Model Control Protocol) sont pris en charge via l'API Responses. La recherche web, l'interpréteur de code et l'utilisation de l'ordinateur ne sont pas pris en charge.

- Limitations :

- Le streaming n'est pas pris en charge, reflétant le traitement plus lent et délibéré du modèle.

- Le fine-tuning est disponible mais pas la distillation ni les sorties prédites.

- Les entrées audio ne sont pas prises en charge ; seules les entrées texte et image sont acceptées.

Les snapshots, tels qu'o3-pro-2025-06-10, permettent aux utilisateurs de fixer une version spécifique du modèle pour des performances constantes, garantissant la stabilité pour les environnements de production.

Conclusion

Le modèle o3-pro d'OpenAI est un modèle d'IA puissant, excellant dans le raisonnement complexe et offrant des performances de premier ordre sur des benchmarks comme AIME 2024 et GPQA Diamond. Sa tarification – 20 $ par million de tokens d'entrée et 80 $ par million de tokens de sortie – reflète sa nature intensive en calcul, avec les options Batch API et entreprise offrant de la flexibilité pour les utilisateurs à volume élevé. Les limites de débit, s'étendant du Niveau 1 au Niveau 5, garantissent un accès équitable tout en prenant en charge diverses charges de travail.

Disponible exclusivement via l'API Responses, la fenêtre contextuelle de 200 000 tokens d'o3-pro et la prise en charge d'outils comme la recherche de fichiers et la génération d'images en font un choix polyvalent pour les développeurs. Malgré sa vitesse plus lente et ses coûts plus élevés par rapport à o3 et o3-mini, ses capacités de raisonnement inégalées le positionnent comme une solution de premier plan pour aborder les tâches d'IA les plus difficiles. Alors qu'OpenAI continue d'innover, o3-pro témoigne du potentiel transformateur de l'IA avancée, stimulant le progrès dans toutes les industries et applications.

Vous voulez une plateforme intégrée, tout-en-un, pour que votre équipe de développeurs travaille ensemble avec une productivité maximale ?

Apidog répond à toutes vos demandes et replaces Postman at a much more affordable price !