```html

OpenAI a élargi sa gamme de modèles d'IA puissants avec o1-pro, une nouvelle offre conçue pour les tâches de raisonnement avancé et de résolution de problèmes. Dans le cadre de l'évolution d'OpenAI au-delà de la série GPT, les modèles "o" représentent des systèmes d'IA spécialisés optimisés pour des cas d'utilisation particuliers. Dans ce guide complet, nous allons explorer tout ce que vous devez savoir sur o1-pro, y compris ses capacités, sa structure de prix et comment l'implémenter dans vos applications grâce à diverses méthodes, y compris avec des outils de test d'API comme Apidog.

Qu'est-ce que o1-pro ? Et dans quelle mesure est-il bon ?

o1-pro est le modèle spécialisé d'OpenAI pour les tâches de raisonnement complexes. Il fait partie de la famille de modèles "o1" qui excellent dans la pensée étape par étape et la résolution de problèmes. La variante "pro" offre des capacités améliorées par rapport au modèle de base, ce qui la rend adaptée aux applications exigeantes qui nécessitent un raisonnement sophistiqué.

Contrairement aux modèles plus généraux comme GPT-4o, o1-pro a été spécifiquement adapté aux tâches qui nécessitent une progression logique, un raisonnement mathématique et une analyse structurée. Cette focalisation spécialisée lui permet d'exceller dans les domaines où la pensée méthodique et la décomposition des problèmes sont cruciales.

o1-pro est conçu avec les points forts suivants :

- Raisonnement avancé : Excellent pour décomposer les problèmes complexes en étapes logiques, ce qui le rend idéal pour les tâches nécessitant une pensée et une analyse structurées. Il peut naviguer dans des arbres de décision complexes et fournir des chemins de raisonnement explicites.

- Résolution de problèmes mathématiques : Gère le raisonnement mathématique, les preuves et les calculs avec une précision améliorée. Le modèle démontre une force particulière en algèbre, en calcul, en statistiques et en logique formelle.

- Analyse de code : Capable d'analyser, de déboguer et d'expliquer le code avec une compréhension détaillée. Il peut fonctionner dans plusieurs langages de programmation et identifier les erreurs logiques ou les opportunités d'optimisation.

- Pensée structurée : Produit des réponses plus claires et plus structurées pour les requêtes complexes, avec des décompositions naturelles des problèmes en plusieurs étapes et un raisonnement clairement délimité.

- Recherche et analyse : Effectue une analyse approfondie des sujets avec une organisation logique, comparant différentes perspectives et évaluant méthodiquement les preuves.

- Traitement de la chaîne de pensée : Montre explicitement son processus de raisonnement, ce qui facilite le suivi des lignes de pensée complexes et la vérification des conclusions.

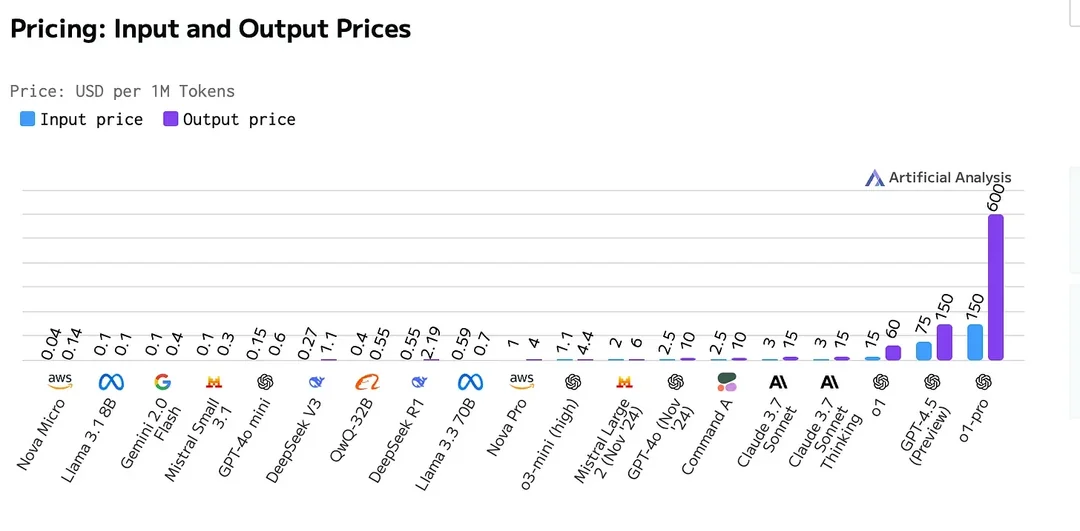

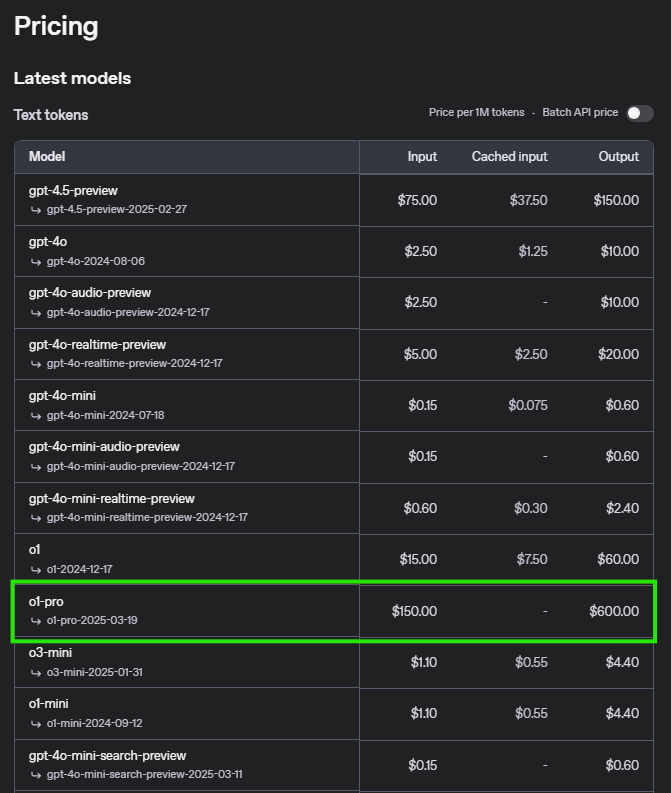

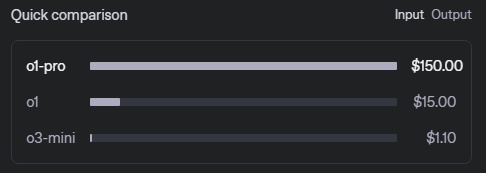

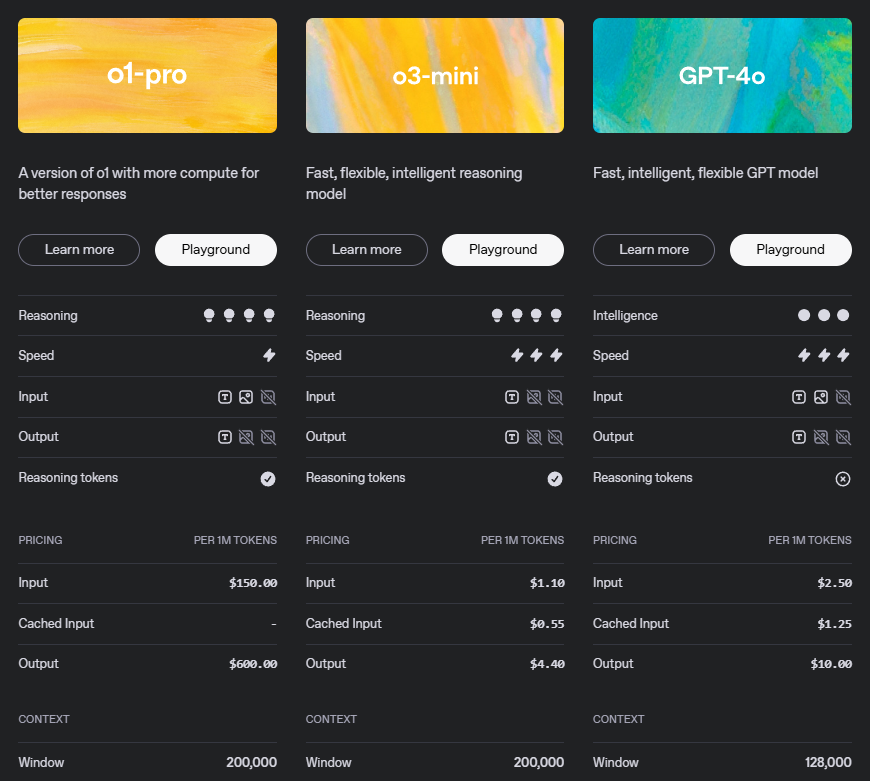

Tarification de l'API o1-pro

Comprendre la structure de prix est essentiel pour planifier votre utilisation de l'API. Voici la répartition détaillée pour o1-pro :

Ce modèle de tarification reflète les capacités sophistiquées de o1-pro, en particulier son raisonnement avancé et la qualité de ses résultats. Le coût plus élevé des jetons de sortie reconnaît la valeur des réponses structurées et bien raisonnées que le modèle génère.

Exemples de scénarios de tarification

| Opération | Prix |

|---|---|

| Entrée (Invite) | 5 $ par million de jetons |

| Sortie (Achèvement) | 15 $ par million de jetons |

Scénario 1 : Utilisation à petite échelle

Pour un scénario avec 500 000 jetons d'entrée et 200 000 jetons de sortie :

- Coût d'entrée : 500 000 jetons × 5/million de jetons = 2,50 $

- Coût de sortie : 200 000 jetons × 15/million de jetons = 3,00 $

- Coût total : 5,50 $

Scénario 2 : Utilisation à moyenne échelle

Pour un scénario avec 5 millions de jetons d'entrée et 2 millions de jetons de sortie :

- Coût d'entrée : 5 000 000 jetons × 5/million de jetons = 25,00 $

- Coût de sortie : 2 000 000 jetons × 15/million de jetons = 30,00 $

- Coût total : 55,00 $

Scénario 3 : Utilisation à grande échelle

Pour un scénario avec 50 millions de jetons d'entrée et 20 millions de jetons de sortie :

- Coût d'entrée : 50 000 000 jetons × 5/million de jetons = 250,00 $

- Coût de sortie : 20 000 000 jetons × 15/million de jetons = 300,00 $

- Coût total : 550,00 $

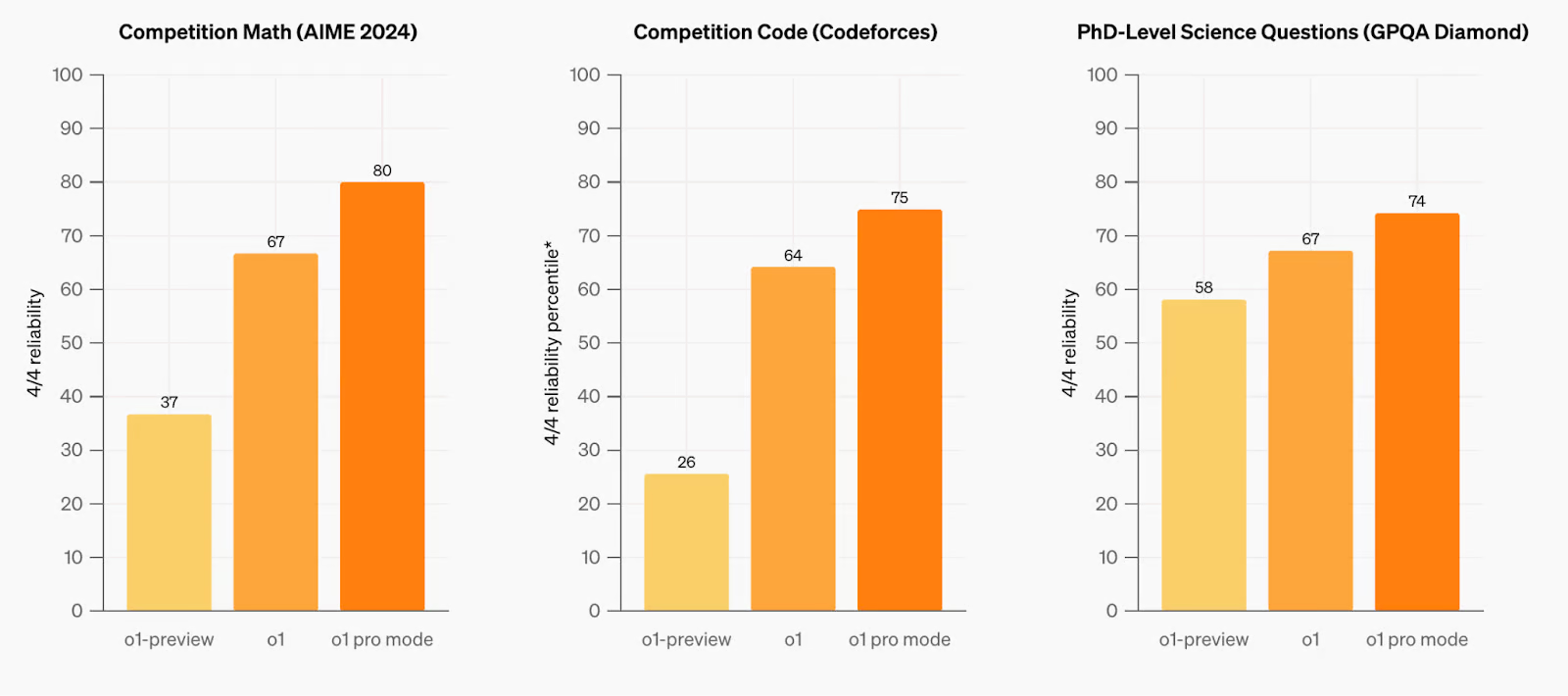

Comparaison avec les modèles précédents

o1-pro démontre des avancées notables en matière de raisonnement, de résolution de problèmes et de compréhension de contextes longs. Le modèle a été rigoureusement testé sur divers points de référence, démontrant des améliorations par rapport à ses prédécesseurs dans le traitement des requêtes complexes et des tâches de raisonnement en plusieurs étapes. Dans des domaines clés tels que les mathématiques, le codage et la planification structurée, o1-pro présente une précision et une fiabilité accrues, surpassant les modèles précédents en termes de performances et d'efficacité. Son architecture optimisée permet une meilleure compréhension des invites complexes, ce qui en fait un concurrent de taille pour les applications avancées nécessitant un raisonnement de haut niveau et des capacités de contexte étendues.

Vous pouvez trouver la comparaison complète des modèles OpenAI, y compris les spécifications détaillées et les points de référence, sur la page de documentation officielle d'OpenAI.

Exigences et limites de débit de l'API OpenAI O1 Pro

| Niveau | Qualification | Limites d'utilisation |

|---|---|---|

| Gratuit | L'utilisateur doit se trouver dans une zone géographique autorisée | 100 $/mois |

| Niveau 1 | 5 $ payés | 100 $/mois |

| Niveau 2 | 50 $ payés et plus de 7 jours depuis le premier paiement réussi | 500 $/mois |

| Niveau 3 | 100 $ payés et plus de 7 jours depuis le premier paiement réussi | 1 000 $/mois |

| Niveau 4 | 250 $ payés et plus de 14 jours depuis le premier paiement réussi | 5 000 $/mois |

| Niveau 5 | 1 000 $ payés et plus de 30 jours depuis le premier paiement réussi | 50 000 $/mois |

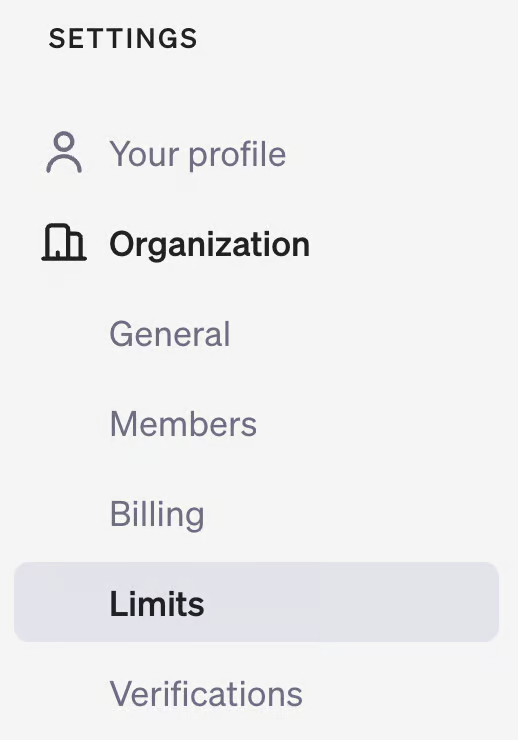

Pour vérifier votre niveau d'utilisation, visitez votre page de compte sur la plateforme de développement OpenAI et consultez la section "Limites" sous "Organisation".

Comment utiliser l'API 01

L'implémentation de o1-pro dans vos applications est simple. Suivez ces étapes pour commencer :

1. Prérequis

- Une clé API OpenAI (obtenue à partir de votre tableau de bord OpenAI)

- Un environnement de développement compatible avec les bibliothèques appropriées

- Crédits API suffisants ou mode de paiement lié à votre compte OpenAI

2. Installation

Installez la bibliothèque OpenAI pour votre langage de programmation préféré :

Pour Python :

pip install openai

Pour JavaScript :

npm install openai

Pour les autres langages, reportez-vous à la documentation officielle d'OpenAI pour les bibliothèques clientes.

3. Exemple d'implémentation Python

Voici comment utiliser o1-pro en Python avec des paramètres détaillés :

from openai import OpenAI

client = OpenAI(api_key="your-api-key")

response = client.chat.completions.create(

model="o1-pro",

messages=[

{"role": "system", "content": "Vous êtes un assistant d'IA spécialisé dans le raisonnement mathématique. Fournissez des solutions claires, étape par étape, avec des explications pour chaque étape."},

{"role": "user", "content": "Résolvez ce problème de calcul étape par étape : trouvez la dérivée de f(x) = x^3*ln(x)."}

],

temperature=0.1, # Température plus basse pour un raisonnement plus précis

max_tokens=1024, # Ajuster en fonction de la longueur de réponse attendue

top_p=0.95,

frequency_penalty=0,

presence_penalty=0

)

print(response.choices[0].message.content)

4. Exemple d'implémentation JavaScript

Pour les applications Node.js avec une configuration plus détaillée :

import OpenAI from 'openai';

const openai = new OpenAI({

apiKey: 'your-api-key',

});

async function askO1Pro() {

try {

const response = await openai.chat.completions.create({

model: 'o1-pro',

messages: [

{role: 'system', content: 'Vous êtes un assistant d'IA spécialisé dans le raisonnement mathématique. Fournissez des solutions claires, étape par étape, avec des explications pour chaque étape.'},

{role: 'user', content: 'Résolvez ce problème de calcul étape par étape : trouvez la dérivée de f(x) = x^3*ln(x).'}

],

temperature: 0.1,

max_tokens: 1024,

top_p: 0.95,

frequency_penalty: 0,

presence_penalty: 0

});

console.log(response.choices[0].message.content);

// Facultatif : Suivre l'utilisation des jetons

console.log("Jetons d'invite :", response.usage.prompt_tokens);

console.log("Jetons d'achèvement :", response.usage.completion_tokens);

console.log("Jetons totaux :", response.usage.total_tokens);

} catch (error) {

console.error('Erreur :', error);

}

}

askO1Pro();

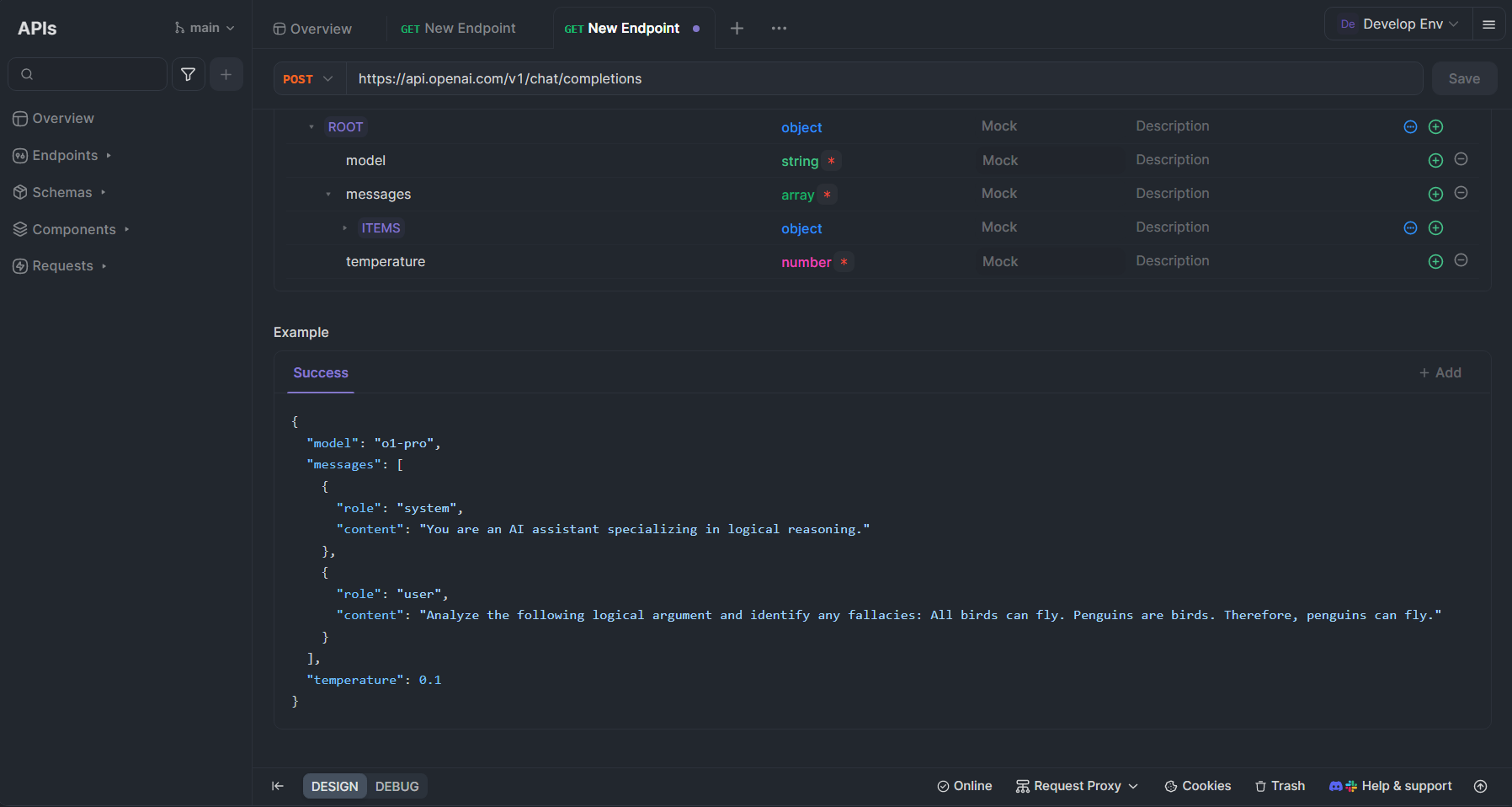

Tester l'API o1-pro avec Apidog

Apidog est une plateforme de développement d'API complète qui peut considérablement rationaliser votre travail avec o1-pro et d'autres API OpenAI. Voici comment vous pouvez utiliser Apidog pour tester et intégrer o1-pro dans votre flux de travail :

Configuration de o1-pro dans Apidog

- Créer un compte : Inscrivez-vous à Apidog sur apidog.com si vous n'avez pas déjà de compte.

- Créer une nouvelle collection d'API : Dans votre tableau de bord Apidog, créez une nouvelle collection spécifiquement pour les API OpenAI.

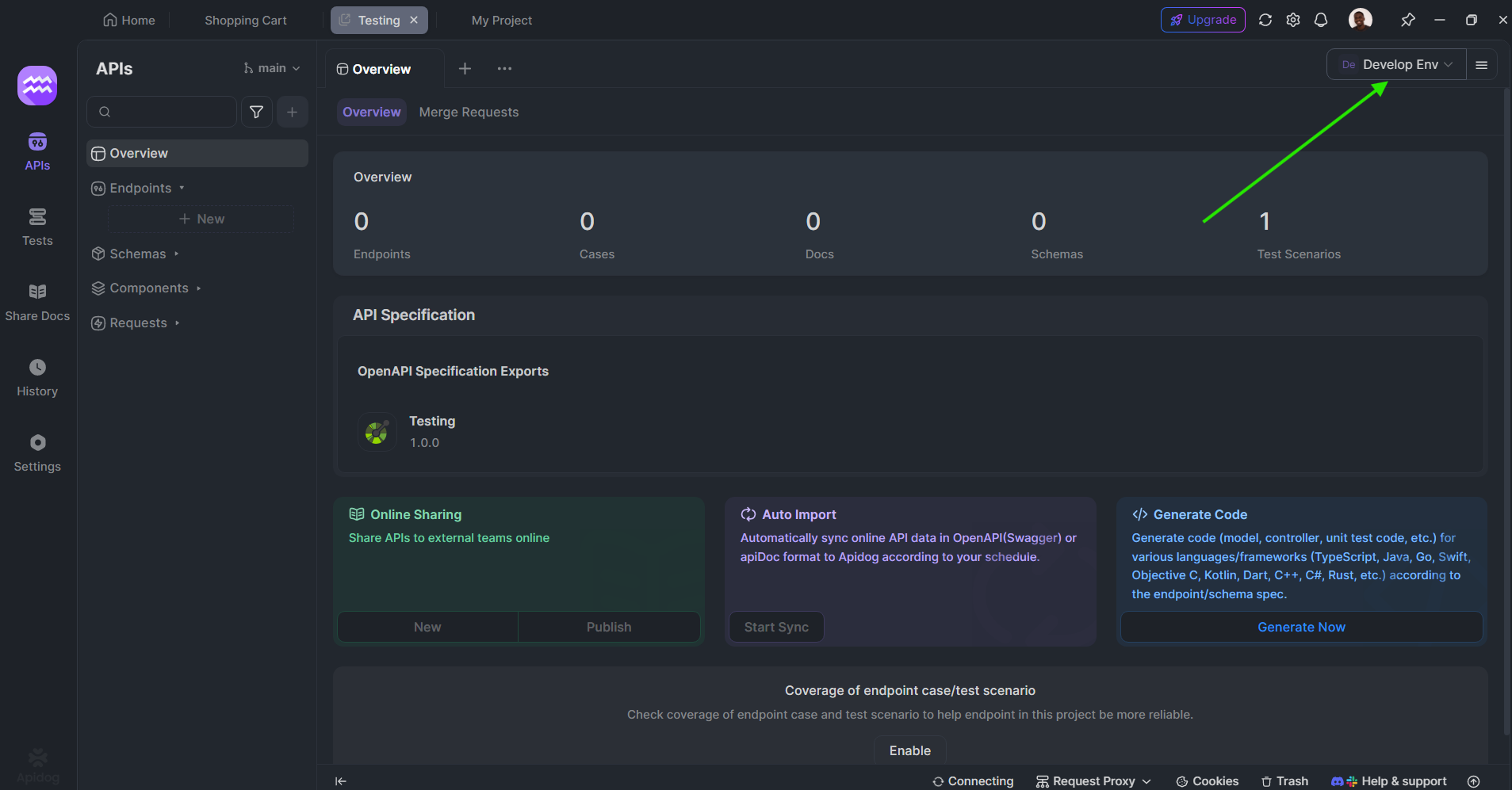

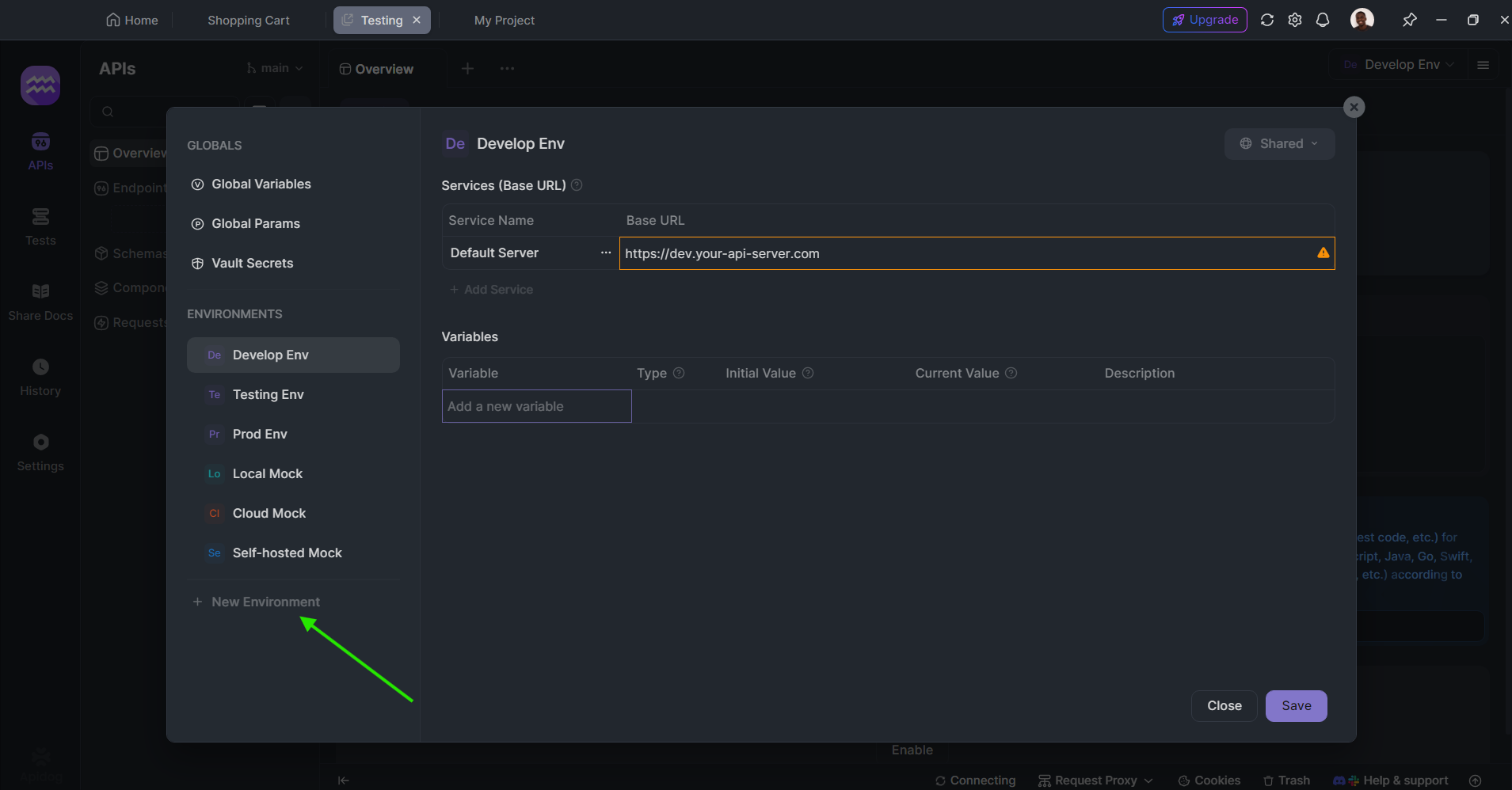

Définir les variables d'environnement : Configurez votre clé API OpenAI en tant que variable d'environnement pour un accès sécurisé et pratique :

- Accédez à Environnements dans le coin supérieur droit

- Créez un nouvel environnement appelé "OpenAI"

- Ajoutez une variable nommée "OPENAI_API_KEY" avec votre clé API réelle comme valeur

Créer une requête pour o1-pro :

- Créez une nouvelle requête POST

- Définissez l'URL sur

https://api.openai.com/v1/chat/completions - Ajoutez un en-tête d'autorisation avec la valeur

Bearer {{OPENAI_API_KEY}} - Dans le corps de la requête (JSON), utilisez :

{

"model": "o1-pro",

"messages": [

{

"role": "system",

"content": "Vous êtes un assistant d'IA spécialisé dans le raisonnement logique."

},

{

"role": "user",

"content": "Analysez l'argument logique suivant et identifiez les erreurs : Tous les oiseaux peuvent voler. Les pingouins sont des oiseaux. Par conséquent, les pingouins peuvent voler."

}

],

"temperature": 0.1

}

Avantages de l'utilisation d'Apidog avec o1-pro

Apidog offre plusieurs avantages pour travailler avec o1-pro :

- Tests interactifs : Testez les appels d'API en temps réel et consultez les réponses formatées, ce qui facilite l'itération sur les invites.

- Documentation automatique : Documentez automatiquement vos implémentations d'API, ce qui facilite la collaboration en équipe.

- Mocking d'API : Créez des réponses simulées pour les appels d'API o1-pro pendant le développement.

- Fonctionnalités de collaboration : Partagez des collections d'API avec les membres de l'équipe pour un développement collaboratif.

- Gestion de l'environnement : Basculez facilement entre les environnements de développement, de pré-production et de production avec différentes clés API.

- Visualisation des réponses : Obtenez une représentation visuelle claire de l'utilisation des jetons et des coûts pour une meilleure gestion du budget.

- Historique des requêtes : Gardez une trace des appels d'API précédents à des fins de référence et d'optimisation.

Meilleures pratiques pour l'utilisation des API o1-pro

Pour maximiser l'efficacité de o1-pro et optimiser vos coûts :

- Structurez clairement vos invites : Pour les tâches de raisonnement complexes, structurez vos invites avec des instructions claires et des résultats attendus. Envisagez d'utiliser des puces ou des instructions numérotées pour les problèmes en plusieurs parties.

- Utilisez efficacement les messages système : Définissez le contexte avec des messages système pour guider o1-pro vers l'approche de raisonnement souhaitée. Soyez précis sur le type de raisonnement (déductif, inductif, etc.) que vous attendez.

Ajustez les paramètres de température :

- Température plus basse (0,1-0,3) pour un raisonnement plus précis et déterministe et les problèmes mathématiques

- Température modérée (0,3-0,7) pour un raisonnement équilibré avec une certaine flexibilité

- Température plus élevée pour des approches de résolution de problèmes plus créatives

- Demandez une réflexion étape par étape : Demandez explicitement des étapes de raisonnement détaillées lors de la résolution de problèmes complexes. Des phrases comme "Réfléchissez à cela étape par étape" ou "Montrez votre raisonnement" aident à activer les points forts de o1-pro.

- Surveillez l'utilisation des jetons : Gardez une trace des jetons d'entrée et de sortie pour gérer efficacement les coûts. Envisagez d'implémenter une fonction d'estimation des jetons dans votre application.

- Regroupez les requêtes associées : Dans la mesure du possible, combinez les questions associées en un seul appel d'API plutôt que d'effectuer plusieurs appels distincts.

- Implémentez la mise en cache : Mettez en cache les réponses courantes pour éviter les appels d'API redondants pour les informations fréquemment demandées.

- Utilisez des techniques de chaîne de pensée : Pour les problèmes complexes, implémentez une invite de chaîne de pensée en demandant au modèle de "réfléchir à ce problème étape par étape avant de fournir la réponse finale".

Conclusion

o1-pro représente une avancée significative dans les capacités de raisonnement de l'IA, offrant des outils puissants pour les tâches nécessitant une pensée structurée et une résolution de problèmes complexes. Avec sa structure de prix compétitive et sa mise en œuvre simple, il est accessible aux développeurs qui cherchent à améliorer leurs applications avec des capacités de raisonnement avancées.

En suivant les directives d'implémentation et les meilleures pratiques décrites dans cet article, vous pouvez intégrer efficacement o1-pro dans vos flux de travail et profiter de ses capacités de raisonnement sophistiquées tout en gérant efficacement vos coûts d'API. Des outils comme Apidog rationalisent davantage le processus de développement et de test, ce qui facilite l'exploitation du plein potentiel de o1-pro pour vos cas d'utilisation spécifiques.

Alors que les capacités de raisonnement de l'IA continuent de progresser, les modèles comme o1-pro deviendront de plus en plus des composants essentiels dans les applications qui nécessitent non seulement de l'intelligence, mais aussi une pensée structurée et logique que les utilisateurs peuvent suivre et comprendre.

```