Souhaitez-vous discuter avec des modèles de langage puissants comme Llama 3.1 ou Mistral sans rester bloqué dans un terminal ? Open WebUI est votre billet pour une interface élégante, semblable à ChatGPT, qui rend l’interaction avec les LLM d’Ollama amusante et intuitive. Il vous permet d’enregistrer les historiques de discussion, de stocker des invites et même de télécharger des documents pour des réponses plus intelligentes, le tout dans votre navigateur. Dans ce guide pour débutants, je vous guiderai à travers l’installation d’Ollama, le test d’un modèle dans le terminal, puis l’amélioration avec Open WebUI pour une expérience plus conviviale. Nous utiliserons Docker pour une configuration rapide et le testerons avec une invite amusante. Prêt à rendre les discussions d’IA faciles ? Commençons !

Qu’est-ce qu’Open WebUI ? Votre centre de commande LLM

Open WebUI est une interface web open source et auto-hébergée qui se connecte à Ollama, vous permettant d’interagir avec des modèles de langage volumineux (LLM) comme Llama 3.1 ou Mistral dans un tableau de bord basé sur un navigateur. Contrairement à l’interface de ligne de commande d’Ollama, Open WebUI ressemble à ChatGPT, offrant :

- Historique des discussions : enregistrez et revisitez vos conversations.

- Stockage des invites : stockez et réutilisez vos invites préférées.

- Téléchargements de documents : ajoutez des fichiers pour des réponses contextuelles (Retrieval-Augmented Generation, ou RAG).

- Changement de modèle : basculez facilement entre les modèles en un clic.

Avec plus de 50 000 étoiles sur GitHub, Open WebUI est un succès pour les développeurs et les passionnés d’IA qui souhaitent une méthode collaborative et graphique pour travailler avec les LLM localement. Tout d’abord, lançons Ollama pour voir pourquoi Open WebUI vaut la peine d’être ajouté !

Installation et test d’Ollama

Avant de plonger dans Open WebUI, configurons Ollama et testons un modèle comme Llama 3.1 ou Mistral dans le terminal. Cela vous donne une base de référence pour apprécier l’interface intuitive d’Open WebUI.

1. Vérifiez la configuration système requise :

- OS : Windows, macOS ou Linux (Ubuntu 24.04 ou similaire).

- Matériel : au moins 16 Go de RAM et 10 Go de stockage libre pour les modèles (Llama 3.1 8B nécessite ~5 Go). Un GPU (par exemple, NVIDIA 1060 4 Go) est facultatif pour des performances plus rapides.

- Logiciel : Ollama, téléchargeable sur ollama.com.

2. Installez Ollama : téléchargez et installez Ollama depuis ollama.com pour votre système d’exploitation. Suivez les invites de l’installateur, c’est une configuration rapide. Vérifiez l’installation avec :

ollama --version

Attendez-vous à une version comme 0.1.44 (avril 2025). En cas d’échec, assurez-vous qu’Ollama est dans votre PATH.

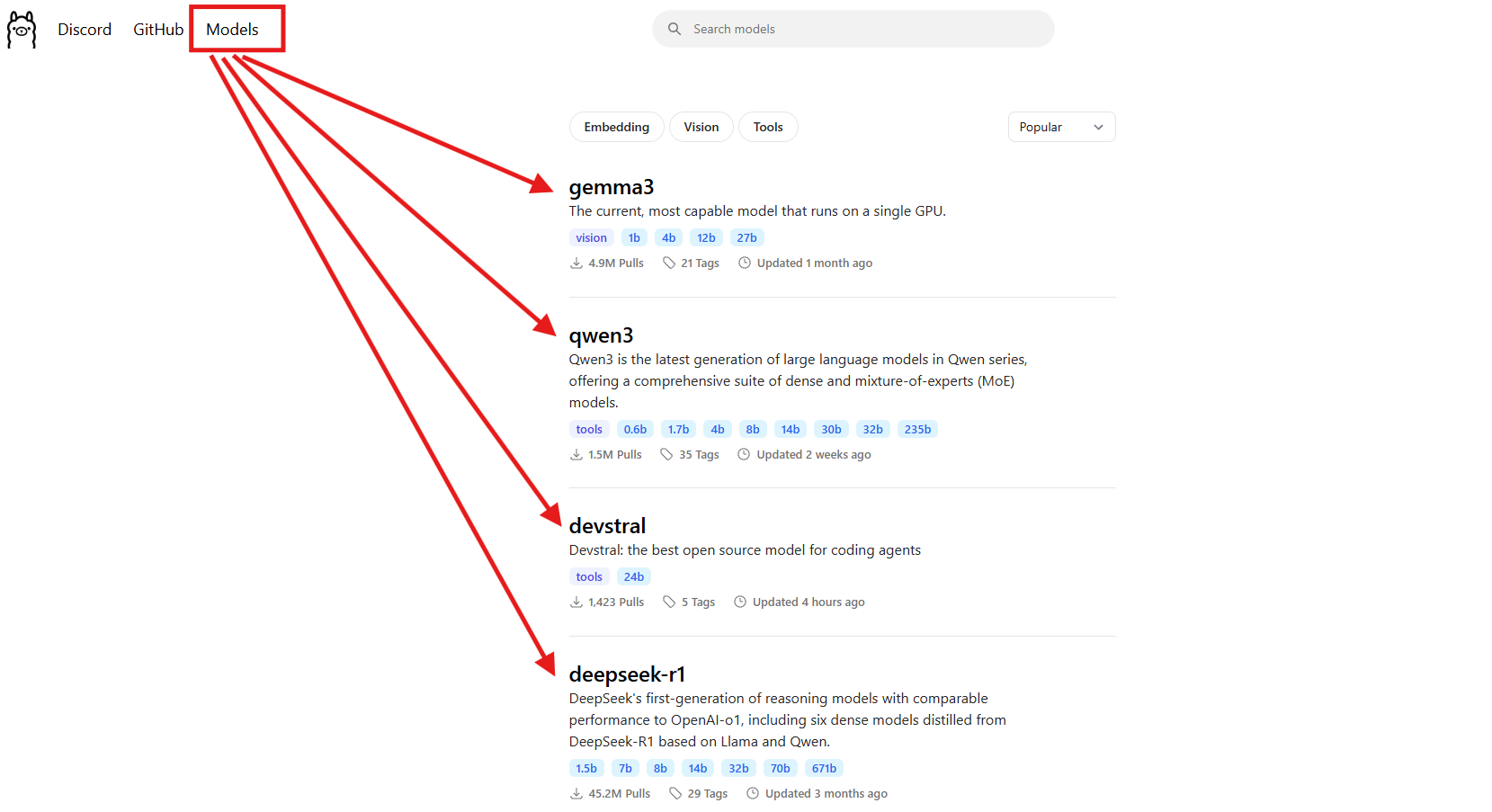

3. Téléchargez un modèle : choisissez un modèle comme Llama 3.1 (8B) ou Mistral (7B). Pour ce guide, nous utiliserons Llama 3.1 :

ollama pull llama3.1

Cela télécharge ~5 Go, alors prenez un café si votre connexion Internet est lente. Vérifiez qu’il est installé :

ollama list

Recherchez llama3.1:latest. Mistral (ollama pull mistral) est une autre excellente option si vous souhaitez un modèle plus léger (~4 Go).

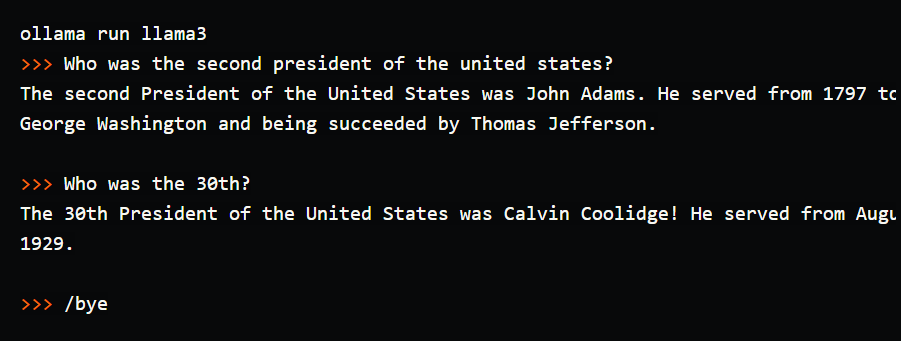

4. Testez le modèle dans le terminal : essayez une invite simple pour voir Ollama en action :

ollama run llama3.1

À l’invite (>>>), tapez : « Racontez-moi une blague de papa sur les ordinateurs. » Appuyez sur Entrée. Vous pourriez obtenir : « Pourquoi l’ordinateur est-il allé chez le médecin ? Il avait un virus ! » Quittez avec /bye. J’ai exécuté cela et j’ai obtenu une blague digne d’un rire, mais taper dans le terminal était maladroit, pas d’historique de discussion, pas d’invites enregistrées. C’est là qu’Open WebUI brille, offrant une interface visuelle pour enregistrer les conversations, réutiliser les invites et télécharger des documents pour des réponses plus riches. Configurons-le !

Configuration de votre environnement pour Open WebUI

Maintenant que vous avez vu l’interface du terminal d’Ollama, préparons-nous pour Open WebUI afin de rendre votre expérience LLM plus intuitive. Nous supposerons que vous avez Docker installé, car il est requis pour la configuration d’Open WebUI.

1. Vérifiez Docker : assurez-vous que Docker est installé et en cours d’exécution :

docker --version

Attendez-vous à quelque chose comme Docker 27.4.0. Si vous n’avez pas Docker, téléchargez et installez Docker Desktop depuis leur site Web officiel, c’est une configuration rapide pour Windows, macOS ou Linux.

2. Créez un dossier de projet : gardez les choses organisées :

mkdir ollama-webui

cd ollama-webui

Ce dossier sera votre base pour l’exécution d’Open WebUI.

3. Assurez-vous qu’Ollama est en cours d’exécution : démarrez Ollama dans un terminal séparé :

ollama serve

Cela exécute l’API d’Ollama à http://localhost:11434. Gardez ce terminal ouvert, car Open WebUI en a besoin pour se connecter à vos modèles.

Installation d’Open WebUI avec Docker

Avec Ollama et Llama 3.1 prêts, installons Open WebUI à l’aide d’une seule commande Docker pour une configuration rapide et fiable.

1. Exécutez Open WebUI : dans votre dossier ollama-webui, exécutez :

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

Cette commande :

- Extrait l’image Open WebUI (

ghcr.io/open-webui/open-webui:main, ~3,77 Go). - Mappe le port 3000 (local) vers 8080 (conteneur) pour l’accès au navigateur.

- Ajoute

host.docker.internalpour se connecter à l’API d’Ollama àlocalhost:11434. - Utilise un volume (

open-webui) pour conserver l’historique des discussions et les paramètres. - Nomme le conteneur

open-webuiet le configure pour redémarrer automatiquement.

Cela prend une minute à télécharger. Vérifiez qu’il est en cours d’exécution avec docker ps, recherchez le conteneur open-webui.

2. Accédez à Open WebUI : ouvrez votre navigateur et accédez à http://localhost:3000. Vous verrez la page d’accueil d’Open WebUI. Cliquez sur « S’inscrire » pour créer un compte (le premier utilisateur obtient des privilèges d’administrateur). Utilisez un mot de passe fort et enregistrez-le en toute sécurité. Vous êtes maintenant prêt à discuter ! Si la page ne se charge pas, assurez-vous que le conteneur est en cours d’exécution (docker logs open-webui) et que le port 3000 est libre.

Utilisation d’Open WebUI : discuter et explorer les fonctionnalités

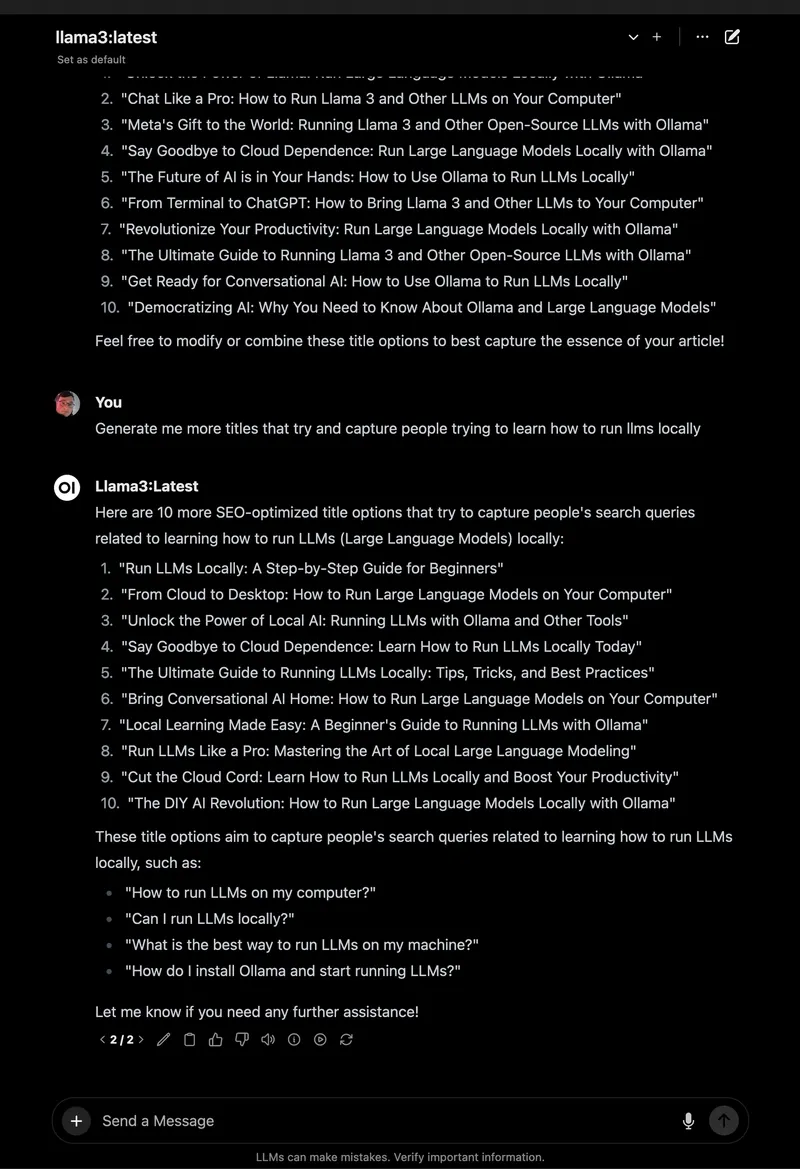

Avec Open WebUI en cours d’exécution, plongeons-nous dans la discussion avec Llama 3.1 et explorons ses fonctionnalités impressionnantes, qui en font une énorme mise à niveau par rapport au terminal.

1. Commencer à discuter :

- Dans Open WebUI, sélectionnez

llama3.1:8bdans le sélecteur de modèle en haut à gauche (il devrait apparaître depuis que vous l’avez extrait). - Cliquez sur « Nouvelle discussion » dans la barre latérale.

- Entrez la même invite : « Racontez-moi une blague de papa sur les ordinateurs. »

- Appuyez sur Entrée. Vous obtiendrez une réponse comme : « Pourquoi l’ordinateur est-il allé à l’école d’art ? Parce qu’il voulait apprendre à dessiner un meilleur octet ! »

L’interface est propre, avec votre invite et votre réponse enregistrées automatiquement dans l’historique des discussions.

2. Enregistrer et organiser les discussions : dans la barre latérale gauche, cliquez sur l’icône d’épingle pour enregistrer la discussion. Renommez-la (par exemple, « Blagues de papa ») pour un accès facile. Vous pouvez archiver ou supprimer des discussions via la barre latérale, en gardant vos expériences organisées, bien mieux que le défilement du terminal !

3. Stocker les invites : enregistrez l’invite de la blague de papa pour la réutiliser :

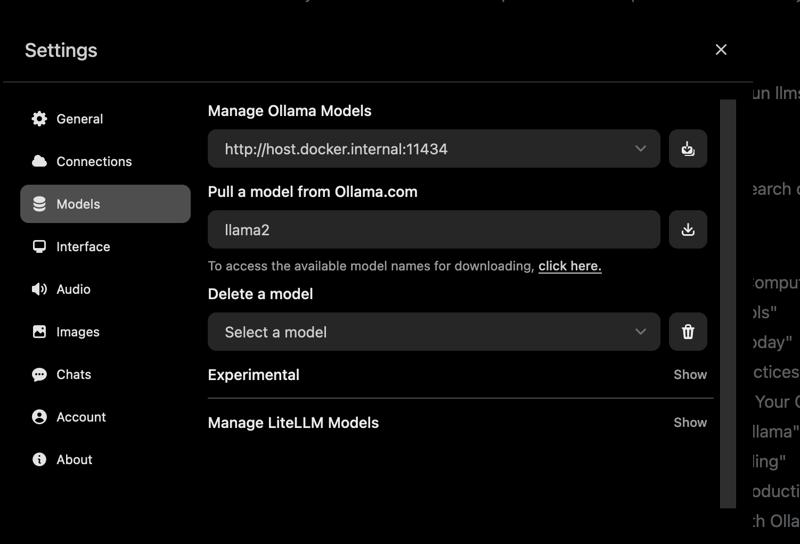

- Accédez à Paramètres > Invites.

- Cliquez sur « Nouvelle invite », nommez-la « Blague de papa » et collez : « Racontez-moi une blague de papa sur les ordinateurs. »

- Enregistrez. Vous pouvez maintenant l’appliquer dans n’importe quelle discussion en un seul clic.

4. Télécharger un document pour RAG : ajoutez du contexte à vos discussions :

- Cliquez sur l’icône « # » dans l’entrée de discussion pour ouvrir la bibliothèque de documents.

- Téléchargez un fichier texte (par exemple, un guide Spring Boot 3.2).

- Demandez : « Comment puis-je utiliser le client REST dans Spring Boot 3.2 ? » Llama 3.1 fera référence au document, en donnant un extrait de code comme

RestClient.create().get().uri("/users").retrieve().

J’ai testé cela avec un PDF de tutoriel Python, et Open WebUI a réussi à donner des réponses contextuelles, contrairement aux réponses de base du terminal.

5. Explorer d’autres fonctionnalités :

- Changer de modèles : utilisez le sélecteur de modèle pour essayer Mistral ou d’autres modèles que vous avez extraits (

ollama pull mistral). - Personnaliser les réponses : cliquez sur « Contrôle de discussion » pour ajuster le ton (par exemple, « drôle ») ou la longueur.

- Outils d’administration : dans Paramètres > Administration, gérez les utilisateurs ou restreignez l’accès aux modèles (idéal pour les équipes).

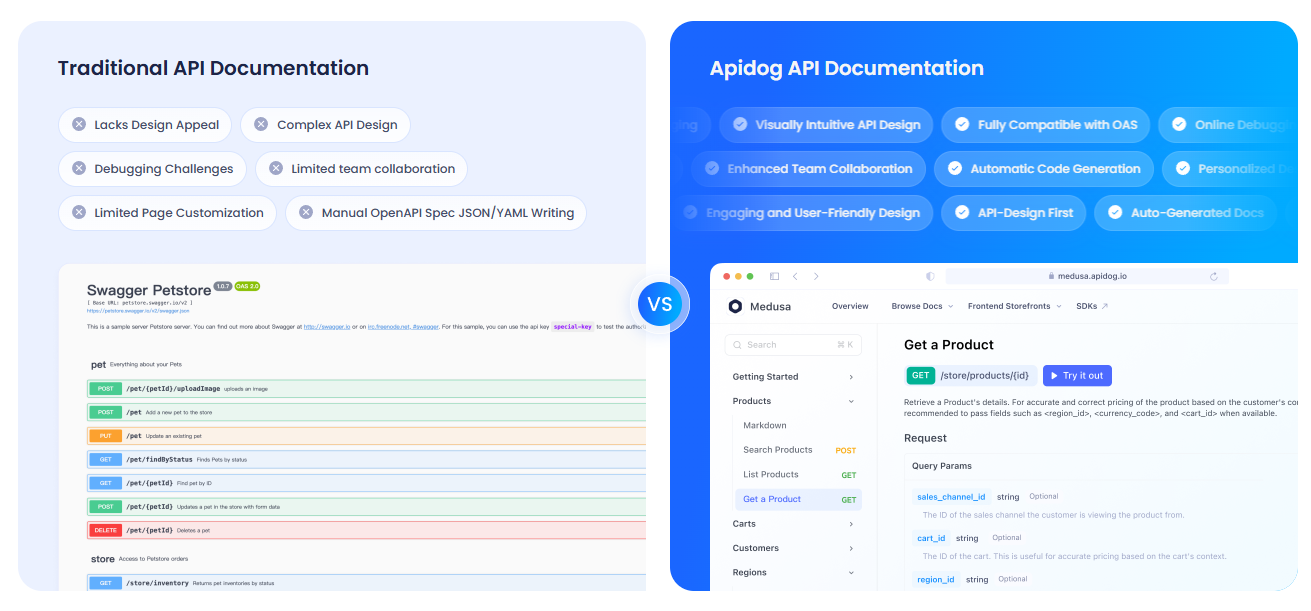

Documenter vos API avec APIdog

Vous utilisez Open WebUI pour interagir avec l’API d’Ollama et vous souhaitez documenter votre configuration ? APIdog est un outil fantastique pour créer une documentation d’API interactive. Son interface élégante et ses options d’auto-hébergement en font l’outil idéal pour partager vos projets d’IA, consultez-le !

Dépannage et conseils

- Problèmes de connexion : si Open WebUI ne trouve pas Ollama, assurez-vous que

ollama serveest en cours d’exécution et que le port 11434 est ouvert. Vérifiez les journaux Docker :docker logs open-webui. - Conflits de ports : si le port 3000 est utilisé, arrêtez le conteneur (

docker stop open-webui), supprimez-le (docker rm open-webui) et réexécutez la commandedocker runavec un nouveau port (par exemple,-p 3001:8080). - Réponses lentes : utilisez un GPU avec les balises

:cudad’Ollama ou des modèles plus petits comme Mistral pour la vitesse. - Communauté : rejoignez les discussions GitHub ou Discord d’Open WebUI pour obtenir de l’aide et des idées.

Pourquoi choisir Open WebUI ?

Open WebUI transforme Ollama d’un outil de terminal maladroit en une plateforme puissante et conviviale :

- Interface intuitive : le tableau de bord basé sur un navigateur est parfait pour les débutants et les professionnels.

- Organisation : les discussions et les invites enregistrées maintiennent votre travail bien rangé, contrairement aux journaux de terminal.

- Conscience du contexte : les téléchargements de documents permettent le RAG pour des réponses plus intelligentes.

- Confidentialité : s’exécute localement, protégeant vos données.

Après avoir testé le terminal et Open WebUI, je suis convaincu de la facilité et des fonctionnalités de l’interface graphique. C’est comme passer d’un téléphone à clapet à un smartphone !

Pour conclure : votre aventure Open WebUI vous attend

Vous êtes passé des discussions de terminal à une configuration Open WebUI complète avec Ollama, rendant les interactions LLM fluides et amusantes ! Avec Llama 3.1, les discussions enregistrées et les téléchargements de documents, vous êtes prêt à explorer l’IA comme jamais auparavant. Essayez de nouveaux modèles, stockez plus d’invites ou documentez vos API avec APIdog. Partagez vos réussites Open WebUI sur le GitHub d’Open WebUI, je suis ravi de voir ce que vous créez ! Bon bricolage d’IA !