Si vous avez déjà confié votre smartphone à un tout-petit et que vous l'avez vu appuyer sur tous les boutons, balayer l'écran au hasard et réussir d'une manière ou d'une autre à faire planter votre application en 30 secondes, alors vous venez d'assister au Test du Singe dans sa forme la plus pure. Cela semble chaotique, presque irresponsable, et pourtant c'est précisément ce chaos qui révèle des bugs que les tests structurés ne détectent pas. Le caractère aléatoire qui fait que le test du singe semble indiscipliné est exactement ce qui le rend précieux.

Les équipes professionnelles d'assurance qualité utilisent le Test du Singe de manière stratégique, et non négligente. Elles le déploient pour découvrir les fuites de mémoire, les exceptions non gérées et les plantages système qui n'apparaissent que lorsque le logiciel est confronté à des séquences d'entrée imprévisibles. Ce guide vous montrera comment exploiter correctement le test du singe, comprendre ses types et l'intégrer judicieusement dans votre stratégie d'AQ.

Qu'est-ce que le Test du Singe exactement ?

Le Test du Singe est une technique de test logiciel où l'on fournit des entrées aléatoires, inattendues ou invalides à une application et où l'on observe son comportement. Le nom vient du théorème du singe infini : si un singe tape au hasard sur un clavier pendant suffisamment longtemps, il finira par produire un texte significatif. En test, le "singe" est un programme ou un testeur humain qui sollicite l'application sans suivre de cas de test prédéterminés.

Contrairement aux tests structurés, le test du singe ne valide pas les exigences. Il pose une question plus simple mais cruciale : l'application peut-elle gérer le chaos sans planter ? Cette approche excelle à trouver :

- Les fuites de mémoire dues à des opérations répétées

- Les exceptions non gérées dues à des combinaisons de données invalides

- Les conditions de concurrence dans les processus asynchrones

- Les blocages d'interface utilisateur suite à des interactions utilisateur rapides

- Les vulnérabilités de sécurité dues à des entrées mal formées

Cette technique est particulièrement précieuse pour les applications mobiles, les applications web et les API qui sont confrontées à un comportement utilisateur imprévisible en production.

Les trois types de Test du Singe : Bête, Intelligent et Brillant

Tous les Tests du Singe ne sont pas égaux. Cette technique s'étend d'un spectre entièrement aléatoire à un spectre intelligemment guidé.

1. Test du singe bête

Le test du singe bête est purement aléatoire. L'outil de test ne connaît rien de l'application. Il clique sur des coordonnées aléatoires, saisit du texte sans signification et envoie des données mal formées. Il ne peut pas reconnaître les erreurs, naviguer intentionnellement ou adapter son comportement.

Avantages : Nécessite une configuration minimale, trouve des plantages inattendus, faible maintenance

Inconvénients : Manque des chemins critiques, génère de nombreux tests non pertinents, ne peut pas vérifier l'exactitude

Idéal pour : Les tests de stress de la robustesse de l'interface utilisateur, les tests exploratoires précoces

Un singe bête pourrait cliquer 1 000 fois sur le bouton "Soumettre" sans remplir aucun champ, révélant un bug de validation de formulaire qui fait planter le serveur.

2. Test du singe intelligent

Le test du singe intelligent connaît la structure de l'application. Il comprend les formats d'entrée valides, les contraintes de navigation et les transitions d'état attendues. Il agit toujours de manière aléatoire dans ces limites, mais évite les actions manifestement invalides.

Avantages : Scénarios de test plus pertinents, taux de détection de bugs plus élevé, respecte les règles métier

Inconvénients : Nécessite une configuration initiale, nécessite des mappings mis à jour lorsque l'interface utilisateur change

Idéal pour : Les tests de régression, la validation de la robustesse des flux de travail

Un singe intelligent sait qu'un champ de carte de crédit accepte 16 chiffres. Il entrera des numéros aléatoires de 16 chiffres (certains valides, d'autres non) mais ne tapera pas de lettres ou de caractères spéciaux.

3. Test du singe brillant

Le test du singe brillant combine le hasard avec l'apprentissage. Il observe le comportement de l'application, se souvient des actions qui ont conduit à des plantages par le passé, et oriente les tests futurs vers ces zones vulnérables. C'est la forme la plus sophistiquée de Test du Singe, utilisant souvent l'IA ou des algorithmes génétiques.

Avantages : Très efficace, s'adapte aux changements d'application, trouve des bugs profonds

Inconvénients : Configuration complexe, nécessite des outils spécialisés, consommation de ressources plus élevée

Idéal pour : Les produits matures nécessitant des tests de stabilité approfondis, le fuzzing de sécurité

Un singe brillant pourrait découvrir que l'ouverture d'un modal, sa fermeture, puis la rotation rapide de l'appareil provoquent une fuite de mémoire. Il répétera ensuite ce modèle avec des variations pour confirmer la vulnérabilité.

| Type | Connaissance de l'application | Effort de configuration | Taux de détection de bugs | Meilleur cas d'utilisation |

|---|---|---|---|---|

| Bête | Aucune | Très faible | Faible | Test de plantage |

| Intelligent | Structure et règles | Moyen | Moyen | Test de flux de travail |

| Brillant | Auto-apprentissage | Élevé | Élevé | Test de stabilité approfondi |

Avantages et inconvénients du Test du Singe

Comme toute autre technique, le Test du Singe présente des compromis.

Avantages :

- Trouve des cas limites manqués par les humains : Le hasard explore des combinaisons auxquelles les testeurs ne penseraient pas

- Révèle des problèmes de robustesse : Expose les fuites de mémoire, les plantages et les blocages sous contrainte

- Coût initial faible pour les tests bêtes : Peut démarrer avec une configuration minimale

- Évolutif : Les singes automatisés fonctionnent 24h/24 et 7j/7 sans fatigue

- Bon pour la sécurité : Le fuzzing avec des données mal formées trouve des vulnérabilités d'injection

Inconvénients :

- Couverture imprévisible : Ne peut garantir que toutes les fonctionnalités sont testées

- Beaucoup de faux positifs : Les échecs aléatoires peuvent ne pas représenter de réels problèmes utilisateurs

- Pas de validation des exigences : Ne confirme pas que le logiciel répond aux besoins métier

- Difficile à reproduire : Les échecs de test aléatoires peuvent être difficiles à reproduire et à déboguer

- Documentation limitée : Difficile de prouver ce qui a été testé aux auditeurs

Remarque : Le Test du Singe ne doit jamais être votre seule stratégie de test. C'est un complément puissant aux tests structurés, pas un remplacement !

Où le Test du Singe brille : applications du monde réel

Le Test du Singe est le plus précieux dans les scénarios suivants :

- Test d'applications mobiles : Les utilisateurs tapent au hasard, font pivoter les appareils, changent d'applications et interrompent les connexions réseau. Les singes simulent efficacement ce chaos, trouvant les plantages que les tests structurés manquent.

- Test de résilience d'API : Les API reçoivent des requêtes mal formées, des charges utiles incomplètes et des en-têtes inattendus. Le test du singe avec des structures de données aléatoires révèle des exceptions non gérées et des failles de sécurité.

- Test de stress de l'interface utilisateur : Les clics rapides, le redimensionnement de fenêtres et la navigation dans les menus peuvent exposer des problèmes de threading et des conditions de blocage de l'interface utilisateur.

- Test de jeux : Les joueurs effectuent des séquences inattendues. Un singe pourrait sauter, tirer et faire une pause simultanément, révélant un bug de rendu.

- Test d'appareils IoT : Les appareils sont confrontés à des conditions réseau et à des interactions utilisateur imprévisibles. Les singes simulent les coupures de connexion et les pressions répétées sur les boutons.

Test du Singe vs Test Guérilla vs Test Ad Hoc

Ces termes sont souvent confondus. Voici comment ils diffèrent :

- Test du Singe : Aléatoire systématique, souvent automatisé, axé sur la robustesse.

- Test Guérilla : Test rapide et informel avec de vrais utilisateurs dans leur environnement naturel (par exemple, tester une application de café dans un café réel).

- Test Ad Hoc : Test non structuré et exploratoire, guidé par l'intuition du testeur plutôt que par des scripts.

| Aspect | Test du Singe | Test Guérilla | Test Ad Hoc |

|---|---|---|---|

| Approche | Aléatoire, automatisée | Observation en situation réelle | Exploration intuitive |

| Objectif | Trouver des plantages/blocages | Valider l'utilisation réelle | Découvrir des problèmes inattendus |

| Environnement | Labo/CI/CD | Similaire à la production | N'importe lequel |

| Qui effectue | Outils automatisés ou testeurs | Utilisateurs finaux | Testeurs expérimentés |

| Documentation | Minimale | Notes d'observation | Notes de session |

Tous les trois sont de nature exploratoire, mais le Test du Singe est le seul qui utilise le hasard délibéré comme stratégie principale.

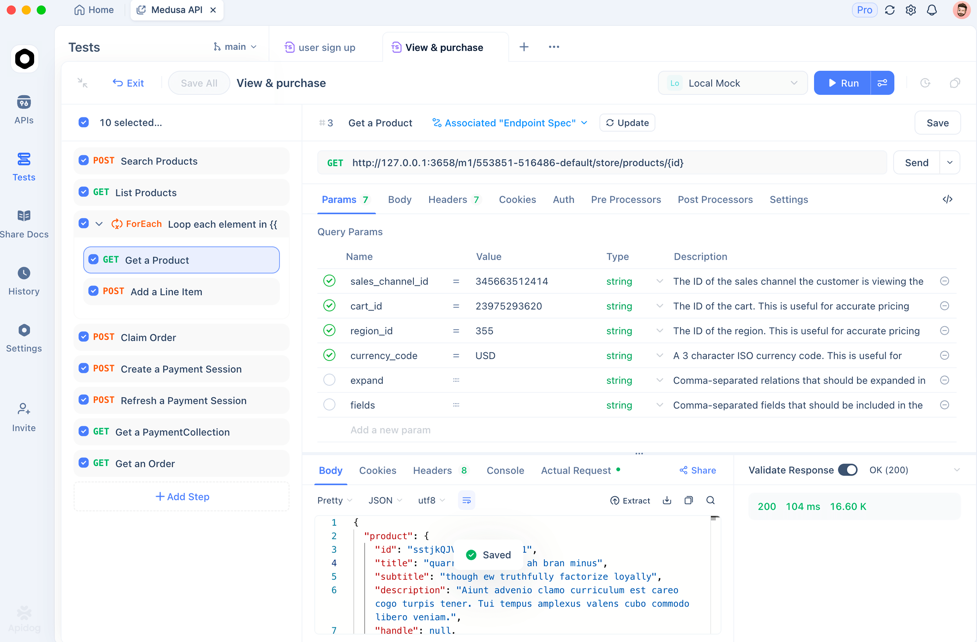

Comment Apidog aide avec le Test du Singe pour les API

Alors que le Test du Singe est traditionnellement axé sur l'interface utilisateur, les API ont aussi besoin de tests du singe ! Des requêtes aléatoires avec des paramètres, des en-têtes et des charges utiles inattendus peuvent faire planter votre backend. **Apidog** applique les principes du test du singe aux tests d'API de manière contrôlée et reproductible.

Pendant la phase de Développement des Cas de Test de votre Cycle de Vie des Tests Logiciels, Apidog peut générer des scénarios de test "singe intelligent" pour vos points de terminaison d'API. Au lieu d'un pur hasard, il comprend votre spécification d'API et crée des variations qui testent la robustesse :

// Apidog génère automatiquement ces scénarios de test du singe :

1. POST /api/users with valid JSON → Expect 201

2. POST /api/users with missing required field → Expect 400

3. POST /api/users with extra unknown field → Expect 200 (should ignore)

4. POST /api/users with SQL injection in email → Expect 400/500 (should not crash)

5. POST /api/users with 10MB JSON payload → Expect 413

6. POST /api/users with malformed JSON → Expect 400

7. Rapid-fire 100 requests with random data → System should not crash

L'IA d'Apidog comprend les types de données et les contraintes, générant des valeurs aléatoires mais plausibles. Elle crée des tests de limites, des tentatives d'injection et des mutations de charge utile qui imitent un "singe intelligent" sondant votre API à la recherche de faiblesses.

Pendant l'Exécution des Tests, vous pouvez exécuter ces tests du singe automatiquement dans le cadre de votre pipeline CI/CD. Apidog offre :

- Capacités de fuzzing : Envoyez des milliers de requêtes aléatoires pour trouver les points de rupture

- Simulation de charge : Combinez des requêtes aléatoires avec une exécution concurrente pour tester à la fois la robustesse et les performances

- Journalisation détaillée : Capturez les paires requête/réponse exactes pour un débogage reproductible

- Analyse de sécurité : Identifiez quelles entrées aléatoires créent des vulnérabilités

Cette approche vous offre les avantages du Test du Singe (trouver des défaillances inattendues) sans les inconvénients (résultats non reproductibles et absence de suivi de couverture).

Bonnes pratiques pour la mise en œuvre du Test du Singe

Pour utiliser efficacement le Test du Singe sans perdre de temps, suivez ces directives :

- Commencez avec des Singes Intelligents : Les singes bêtes génèrent trop de bruit. Commencez avec un outil comme Apidog qui comprend la structure de votre application et génère des variations aléatoires pertinentes.

- Définissez des Limites de Temps : Exécutez les tests du singe pendant des durées fixes (par exemple, 2 heures pendant la nuit) pour limiter la portée tout en trouvant des bugs.

- Surveillez la Santé du Système : Utilisez des outils de surveillance des performances d'application (APM) en conjonction avec les tests du singe pour détecter les fuites de mémoire et les pics de CPU qui indiquent des problèmes sous-jacents.

- Enregistrez Tout : Enregistrez toutes les actions aléatoires afin de pouvoir reproduire les échecs. Les journaux de requêtes détaillés d'Apidog rendent cela automatique.

- Intégrez avec le CI/CD : Exécutez les tests du singe sur les builds nocturnes pour détecter les régressions de stabilité sans ralentir le développement.

- Ne vous Fiez pas uniquement aux Singes : Utilisez le test du singe comme 20 % de votre stratégie, en complément des tests fonctionnels et de régression structurés.

Questions fréquemment posées

Q1 : Le test du singe est-il la même chose que le fuzzing ?

Rép : Le fuzzing est un type spécifique de Test du Singe axé sur la sécurité. Il envoie délibérément des données mal formées, inattendues ou aléatoires pour trouver des vulnérabilités comme les dépassements de tampon ou les failles d'injection. Tout fuzzing est un test du singe, mais tout test du singe n'est pas du fuzzing.

Q2 : Le test du singe peut-il entièrement remplacer les tests manuels ?

Rép : Non. Le Test du Singe trouve les plantages et les problèmes de robustesse, mais ne peut pas valider que le logiciel répond aux exigences métier ou offre une bonne expérience utilisateur. Il complète les tests manuels, en particulier pour la découverte de cas limites, mais ne remplace jamais l'exécution de cas de test structurés.

Q3 : Combien de temps dois-je exécuter les tests du singe ?

Rép : Pour les tests d'interface utilisateur, 30 à 60 minutes d'interaction aléatoire révèlent souvent des problèmes de stabilité majeurs. Pour les tests d'API avec Apidog, exécutez les tests de fuzzing pendant 2 à 4 heures ou 10 000 requêtes, selon la première éventualité. L'objectif est la confiance statistique, pas les tests infinis.

Q4 : Quel est le meilleur outil pour le test du singe des applications mobiles ?

Rép : Pour Android, le UI/Application Exerciser Monkey est intégré au SDK. Pour iOS, des outils comme FastMonkey offrent des capacités similaires. Pour le multiplateforme, considérez Appium avec des générateurs de scripts aléatoires personnalisés. Pour le test du singe d'API, **Apidog** est l'option la plus efficace.

Q5 : Comment mesurer l'efficacité du test du singe ?

Rép : Suivez ces métriques : nombre de plantages pour 1 000 actions, défauts uniques trouvés, couverture de code atteinte pendant les exécutions du singe, et temps jusqu'à la première défaillance. Si vos tests du singe trouvent des bugs critiques dans la première heure, ils apportent de la valeur.

Conclusion

Le Test du Singe mérite une place dans votre stratégie qualité — non pas comme un dernier recours chaotique, mais comme une technique disciplinée pour trouver les bugs que les tests structurés manquent. En comprenant les différences entre les singes bêtes, intelligents et brillants, et en suivant les bonnes pratiques de mise en œuvre, vous pouvez exploiter le hasard pour améliorer la robustesse du logiciel.

Pour les tests d'API, les outils modernes comme **Apidog** intègrent les principes du test du singe dans un cadre automatisé et contrôlé. Vous obtenez la puissance de détection du chaos sans le cauchemar de la reproductibilité. L'outil génère des variations intelligentes, les exécute à grande échelle et fournit les journaux dont vous avez besoin pour corriger ce qui ne va pas.

Commencez petit. Ajoutez un test du singe de 30 minutes à votre build nocturne. Suivez ce qu'il trouve. Vous découvrirez probablement des plantages, des fuites de mémoire ou des problèmes de sécurité qui vous auraient embarrassé en production. Le Test du Singe n'est pas une question de témérité — il s'agit d'être minutieux d'une manière que les cas de test méthodiques ne peuvent pas atteindre. Adoptez le chaos, et votre logiciel en sera plus fort.