Mistral AI s'est rapidement fait un nom grâce à ses modèles de langage performants. Que vous cherchiez à créer un chatbot, à générer du texte créatif, à analyser des données, à écrire du code ou à intégrer du texte pour une recherche sémantique, l'API Mistral fournit les outils dont vous avez besoin. Mais comme tout outil puissant, il y a une porte d'entrée : la clé API.

Considérez une clé API comme votre mot de passe secret ou votre identifiant unique. Elle dit à Mistral : "Hé, c'est moi ! J'ai la permission d'utiliser vos services." Sans elle, les serveurs de l'API ne sauraient pas qui fait la requête ni s'il est autorisé.

Ce guide est votre compagnon étape par étape pour naviguer dans la configuration initiale, comprendre le paysage des modèles Mistral, effectuer vos premiers appels d'API et même utiliser des outils comme APidog pour interagir avec l'API. Nous allons tout décomposer de manière conversationnelle, dans le but de vous amener de zéro à effectuer des appels d'API réussis.

Temps estimé : La lecture et le suivi peuvent prendre 30 à 45 minutes.

Prérequis : Une compréhension de base de ce qu'est une API est utile, mais pas strictement nécessaire. Nous expliquerons les concepts au fur et à mesure. Vous aurez également besoin d'une connexion Internet et d'un navigateur Web.

Prêt ? Obtenons cette clé API !

Vous voulez une plateforme intégrée, tout-en-un, pour que votre équipe de développeurs travaille ensemble avec une productivité maximale ?

Apidog répond à toutes vos demandes et remplace Postman à un prix beaucoup plus abordable !

Étape 1 : Configuration de votre compte Mistral AI

Tout d'abord, vous avez besoin d'un compte sur la plateforme de Mistral, connue sous le nom de "La Plateforme".

- Accédez à la console : Ouvrez votre navigateur Web et rendez-vous sur console.mistral.ai.

- Inscrivez-vous ou connectez-vous :

- Si vous êtes nouveau, cliquez sur l'option d'inscription. Vous devrez probablement fournir une adresse e-mail et créer un mot de passe, ou vous pourrez peut-être vous inscrire en utilisant un compte Google ou GitHub existant. Suivez les instructions à l'écran, qui peuvent inclure la vérification de votre adresse e-mail.

- Si vous avez déjà un compte, connectez-vous simplement avec vos identifiants.

3. Informations de facturation (Important !) : Il s'agit d'une étape cruciale qui fait souvent trébucher les gens. Pour réellement utiliser l'API (même si vous prévoyez d'utiliser initialement des modèles gratuits, la plateforme exige souvent des informations de facturation pour activer les clés), vous devez configurer la facturation.

- Une fois connecté, recherchez une section généralement intitulée "Espace de travail" ou le nom de votre compte dans la barre latérale ou le menu de navigation.

- Dans cette section, trouvez "Facturation".

- Cliquez dessus et suivez les instructions pour ajouter vos informations de paiement (généralement une carte de crédit). Ne vous inquiétez pas, vous n'êtes généralement facturé que pour ce que vous utilisez, et de nombreux modèles peuvent avoir des niveaux gratuits ou des crédits initiaux, mais l'activation des paiements est souvent nécessaire pour activer vos clés API pour une utilisation générale. La page de tarification de Mistral (liée plus tard) contient les détails.

- Assurez-vous que vos paiements sont marqués comme "actifs" ou "activés". Il peut falloir quelques instants après l'ajout des détails pour que le statut se mette à jour.

Vous avez maintenant un compte Mistral AI prêt à l'emploi ! L'étape suivante consiste à générer cette clé très importante.

Étape 2 : Génération de votre clé API secrète

Avec votre compte configuré et la facturation activée, créons la clé elle-même.

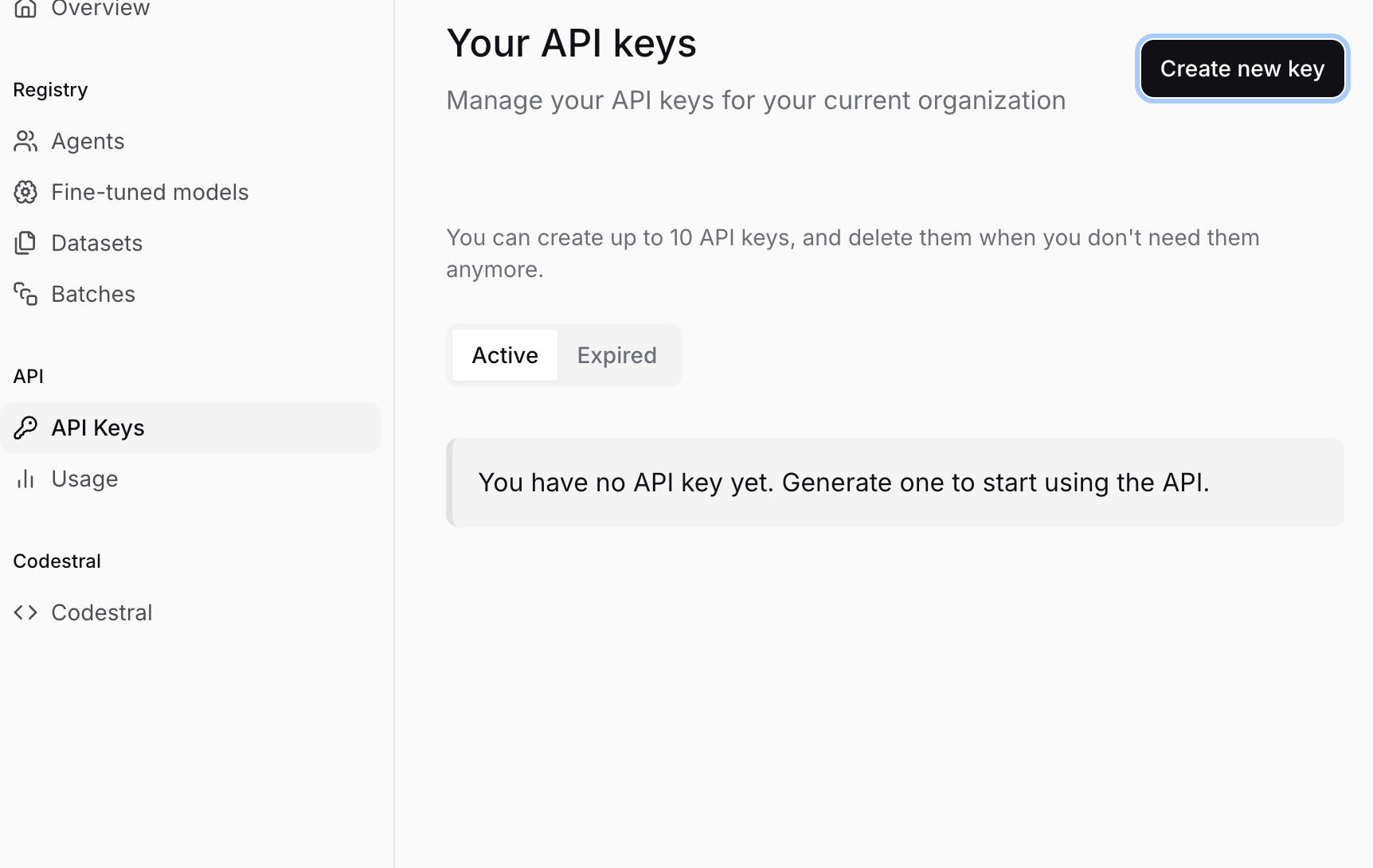

- Accédez aux clés API : Une fois connecté à la console Mistral (console.mistral.ai), recherchez une section nommée "Clés API" dans la barre latérale ou le menu de navigation. Cliquez dessus.

- Créez une nouvelle clé : Vous devriez voir un bouton comme "Créer une nouvelle clé" ou "+ Nouvelle clé". Cliquez dessus.

- Nommez votre clé (facultatif mais recommandé) : Vous pouvez être invité à donner un nom à votre clé. C'est très utile pour l'organisation, surtout si vous prévoyez de créer plusieurs clés plus tard (par exemple, une pour "Mon projet de chatbot", une autre pour "Script d'analyse de données"). Choisissez un nom descriptif.

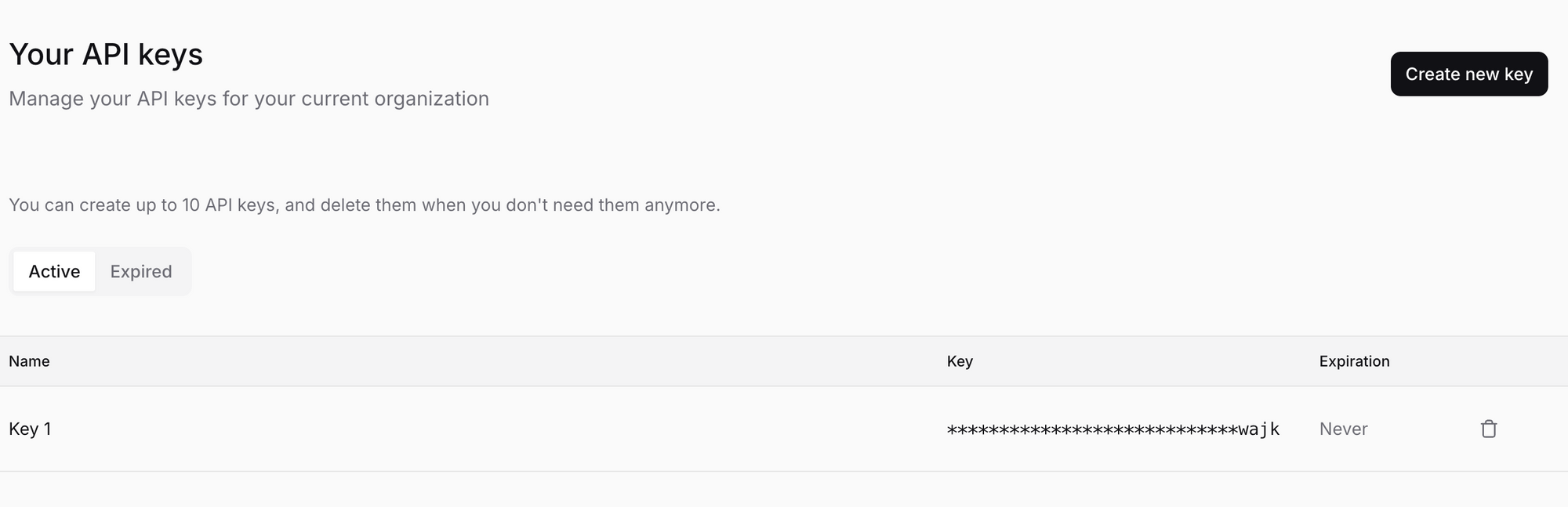

- Générez et COPIEZ votre clé : Cliquez sur le bouton de confirmation final (par exemple, "Créer", "Générer"). Mistral générera maintenant une clé API unique pour vous. Elle ressemblera à une longue chaîne de caractères aléatoires, quelque chose comme

sk-aBcDeFgHiJkLmNoPqRsTuVwXyZ1234567890....... - !!! ÉTAPE CRITIQUE : CONSERVEZ VOTRE CLÉ EN TOUTE SÉCURITÉ !!!

- Mistral ne vous montrera cette clé QU'UNE SEULE FOIS. Si vous fermez la fenêtre ou naviguez ailleurs sans la copier, vous ne la verrez jamais plus. Vous devrez générer une nouvelle clé.

- Copiez la clé immédiatement. Cliquez sur l'icône de copie ou sélectionnez et copiez manuellement l'intégralité de la chaîne.

- Stockez-la en toute sécurité. Utilisez un gestionnaire de mots de passe (comme 1Password, Bitwarden, Dashlane) ou une application de prise de notes sécurisée. NE l'enregistrez PAS dans un fichier texte brut sur votre bureau, ne l'envoyez PAS par e-mail sans protection et ne l'intégrez PAS directement dans votre code (plus de détails plus tard). Traitez cette clé comme un mot de passe pour votre compte bancaire - toute personne qui l'a peut effectuer des appels d'API facturés à votre compte.

- Ne la partagez pas. Sérieusement.

Vous l'avez fait ! Vous possédez maintenant une clé API Mistral AI. Conservez-la en sécurité et voyons comment l'utiliser.

Étape 3 : Comprendre le paysage des modèles Mistral

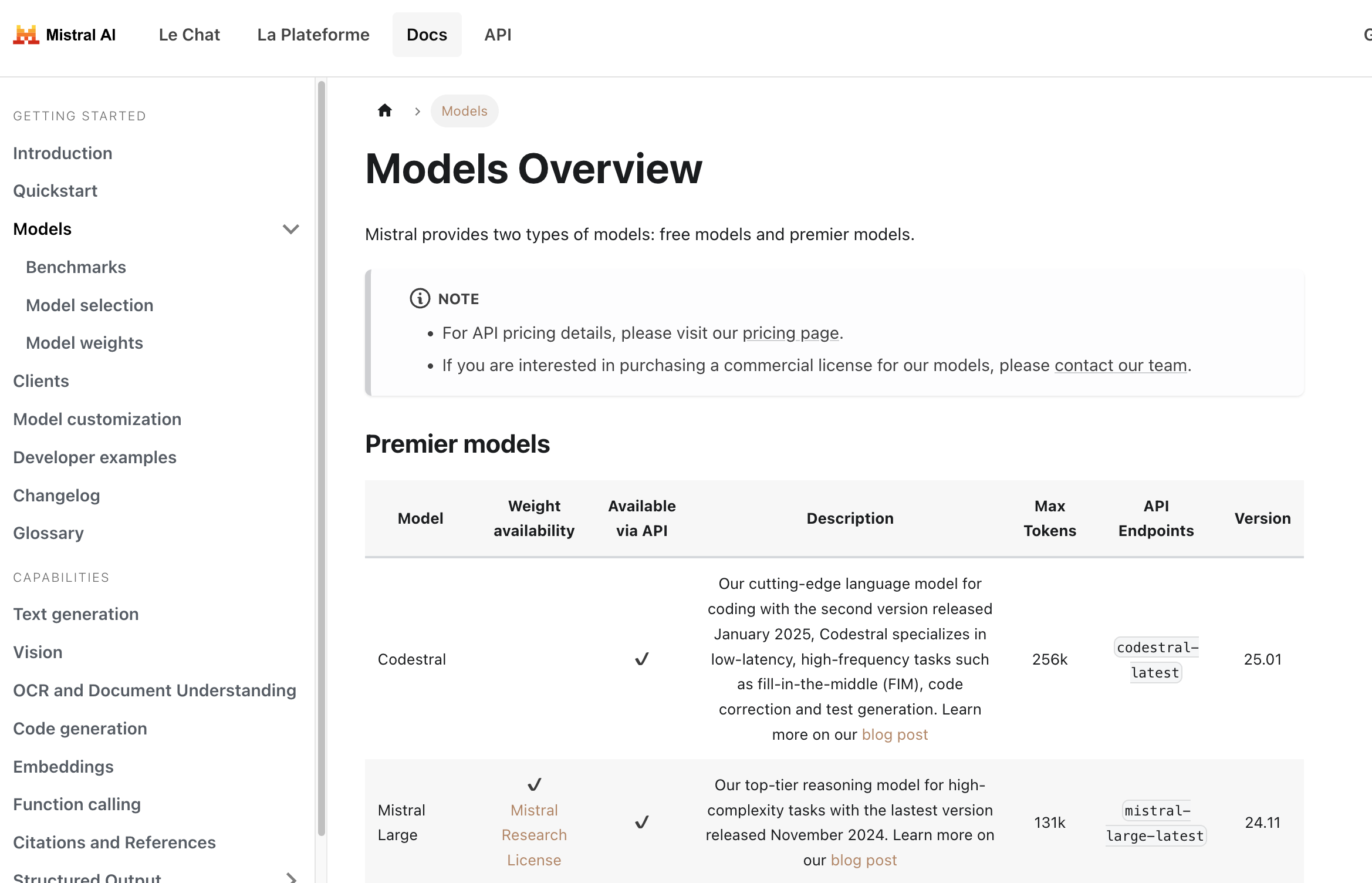

Avant de faire un appel d'API, vous devez dire à Mistral quel modèle vous souhaitez utiliser. Mistral propose une variété de modèles adaptés à différentes tâches, équilibrant performances, coûts et capacités. Choisir le bon est essentiel.

Vous pouvez trouver un aperçu détaillé des modèles ici : Mistral Models Overview

Voici une ventilation rapide des types de modèles que vous rencontrerez :

Modèles Premier : Ce sont les modèles les plus performants de Mistral, nécessitant souvent un paiement.

Mistral Large: Leur modèle phare, conçu pour les tâches de raisonnement complexes. Il dispose d'une grande fenêtre contextuelle (peut gérer beaucoup de texte) et de performances solides sur divers benchmarks.Codestral: Modèles spécialisés affinés pour la génération de code, l'achèvement et les tâches d'explication. Excellent pour les développeurs.Pixtral Large: Un puissant modèle multimodal capable de comprendre à la fois le texte et les images.Mistral Embed: Un modèle très efficace spécialement conçu pour créer des représentations numériques (embeddings) de texte pour des tâches telles que la recherche sémantique, le clustering et la classification.Mistral Moderation: Un outil pour détecter les contenus nuisibles ou indésirables dans le texte.Mistral OCR: Service pour extraire le texte entrelacé avec des images de documents.- Modèles spécialisés comme

Mistral Saba(pour les langues du Moyen-Orient/Asie du Sud) ouMinistral(modèles edge efficaces).

Modèles gratuits (souvent avec des poids ouverts) : Ces modèles peuvent avoir des poids disponibles sous des licences permissives (comme Apache 2.0), ce qui signifie que la communauté de l'IA peut les étudier et s'appuyer sur eux. Ils sont souvent disponibles via l'API également, parfois avec des niveaux gratuits plus généreux ou des coûts inférieurs.

Mistral Small: Un modèle plus petit très performant, équilibrant performances et efficacité. Souvent un excellent point de départ.- Les anciens modèles comme

Mistral 7BouMixtral 8x7Bpeuvent encore être répertoriés, mais pourraient passer au statut hérité (voir ci-dessous).

Versioning des modèles et balises latest :

Vous remarquerez que les modèles ont souvent des noms comme mistral-large-latest ou mistral-large-2411.

*-latest: Cette balise pointe toujours vers la version stable la plus récente de ce modèle (par exemple,mistral-large-latestpointe actuellement versmistral-large-2411). L'utilisation delatestest pratique pour toujours avoir les dernières fonctionnalités, mais sachez que le modèle sous-jacent peut changer, ce qui pourrait légèrement modifier le comportement ou les sorties au fil du temps.*-YYYYMM(par exemple,mistral-large-2411) : Cela fait référence à une version spécifique et datée du modèle (publiée en novembre 2024 dans cet exemple). L'utilisation d'une version datée garantit la cohérence. Votre application utilisera toujours exactement la même version du modèle, ce qui est crucial pour les environnements de production où un comportement prévisible est primordial.

Recommandation : Pour le développement et l'exploration, latest est correct. Pour les applications de production, envisagez fortement d'utiliser une version datée pour la stabilité.

Obsolescence du modèle :

L'IA évolue rapidement ! Mistral publie continuellement des modèles plus récents et meilleurs. Dans le cadre de ce cycle, les anciens modèles sont finalement obsolètes et retirés. La page Models Overview comprend une section sur les modèles hérités, montrant leurs dates d'obsolescence et de retrait. Vérifiez toujours cela si vous vous appuyez sur un ancien modèle et planifiez votre migration vers de nouvelles alternatives bien à l'avance.

Choisir un modèle :

- Tâche : Que devez-vous faire ? (Chat, code, embeddings, analyse d'images ?)

- Complexité : Quelle est la difficulté de la tâche ? (Questions-réponses simples vs. raisonnement nuancé ?)

- Coût : Consultez la page de tarification ! Les modèles plus volumineux coûtent généralement plus cher.

- Vitesse : Les modèles plus petits sont généralement plus rapides.

Commencez par un modèle plus petit et moins cher (comme mistral-small-latest) et voyez s'il répond à vos besoins. Sinon, passez à des modèles plus volumineux ou plus spécialisés.

Étape 4 : Effectuer votre premier appel d'API (achèvement de chat) avec Python

Faisons en sorte que quelque chose se produise ! Le cas d'utilisation le plus courant est l'achèvement de chat - donner au modèle une invite ou un historique de conversation et obtenir une réponse. Le point de terminaison principal de Mistral pour cela est /v1/chat/completions.

Nous utiliserons le modèle mistral-large-latest pour cet exemple, mais vous pouvez remplacer n'importe quel nom de modèle de chat approprié.

Remarque de sécurité importante : Dans les exemples ci-dessous, nous utilisons souvent os.environ["MISTRAL_API_KEY"] (Python) ou process.env.MISTRAL_API_KEY (TypeScript). Cela suppose que vous avez défini votre clé API comme une variable d'environnement nommée MISTRAL_API_KEY. Ceci est fortement recommandé plutôt que de coller la clé directement dans votre code.

- Comment définir une variable d'environnement (temporaire pour la session du terminal) :

- Mac/Linux :

export MISTRAL_API_KEY='your_actual_api_key_here' - Windows (Invite de commandes) :

set MISTRAL_API_KEY=your_actual_api_key_here - Windows (PowerShell) :

$env:MISTRAL_API_KEY='your_actual_api_key_here' - Remplacez

your_actual_api_key_herepar la clé que vous avez enregistrée. N'oubliez pas d'omettre les guillemets si vous utilisez l'invite de commandes Windows. Pour une configuration plus permanente, recherchez comment définir des variables d'environnement de manière persistante sur votre système d'exploitation.

Installez la bibliothèque :

pip install mistralai

Créez un fichier Python (par exemple, mistral_test.py) :

import os

from mistralai.client import MistralClient

from mistralai.models.chat_completion import ChatMessage

# Chargez la clé API à partir des variables d'environnement

api_key = os.environ.get("MISTRAL_API_KEY")

if not api_key:

raise ValueError("MISTRAL_API_KEY environment variable not set!")

# Définissez le modèle que vous souhaitez utiliser

model_name = "mistral-large-latest" # Ou choisissez un autre modèle

# Initialisez le client Mistral

client = MistralClient(api_key=api_key)

print(f"Envoi de la requête au modèle : {model_name}")

# Définissez les messages de conversation

# La liste 'messages' contient l'historique du chat ou une seule invite utilisateur

messages = [

ChatMessage(role="user", content="Quel est le meilleur fromage français ?")

# Vous pouvez ajouter d'autres messages pour l'historique de la conversation :

# ChatMessage(role="assistant", content="Il existe de merveilleux fromages français ! Cela dépend de vos goûts. Préférez-vous le fromage à pâte molle, à pâte dure ou bleu ?"),

# ChatMessage(role="user", content="Je préfère le fromage à pâte molle.")

]

try:

# Effectuez l'appel d'API au point de terminaison d'achèvement du chat

chat_response = client.chat(

model=model_name,

messages=messages,

# Paramètres facultatifs :

# temperature=0.7, # Contrôle le caractère aléatoire (0.0 = déterministe, 1.0 = plus aléatoire)

# max_tokens=150 # Limite la longueur de la réponse

)

# Imprimez la réponse du modèle

if chat_response.choices:

print("Réponse du modèle :")

print(chat_response.choices[0].message.content)

else:

print("Aucune réponse reçue.")

# Vous pouvez également imprimer l'objet de réponse complet pour voir les détails d'utilisation, etc.

# print("\nObjet de réponse complet :")

# print(chat_response)

except Exception as e:

print(f"Une erreur s'est produite : {e}")

Exécutez le script :

python mistral_test.py

Vous devriez voir la réponse du modèle imprimée dans votre terminal !

Étape 5 : Tester les embeddings Mistral AI avec l'API

Mistral ne se limite pas au chat ! Examinons une autre capacité clé : les embeddings. Les embeddings transforment le texte en vecteurs numériques qui capturent la signification sémantique. Les textes ayant des significations similaires auront des vecteurs proches les uns des autres dans l'espace vectoriel. Ceci est fondamental pour RAG (Retrieval-Augmented Generation), la recherche sémantique, les systèmes de recommandation, etc.

Le modèle d'embedding de Mistral est accessible via le point de terminaison /v1/embeddings, généralement en utilisant l'identifiant de modèle mistral-embed.

Voyons comment obtenir des embeddings pour quelques phrases avec Python :

import os

from mistralai.client import MistralClient

api_key = os.environ.get("MISTRAL_API_KEY")

if not api_key:

raise ValueError("MISTRAL_API_KEY environment variable not set!")

model_name = "mistral-embed"

client = MistralClient(api_key=api_key)

print(f"Demande d'embeddings en utilisant le modèle : {model_name}")

texts_to_embed = [

"Mistral AI fournit des modèles de langage puissants.",

"Les embeddings sont des représentations numériques du texte.",

"Quel temps fait-il aujourd'hui ?"

]

try:

embeddings_response = client.embeddings(

model=model_name,

input=texts_to_embed

)

# La réponse contient une liste d'objets d'embedding, chacun avec le vecteur

print(f"Reçu {len(embeddings_response.data)} embeddings.")

# Imprimez les quelques premières dimensions du premier embedding à titre d'exemple

if embeddings_response.data:

first_embedding_vector = embeddings_response.data[0].embedding

print(f"Dimensions de chaque embedding : {len(first_embedding_vector)}")

print(f"5 premières dimensions du premier embedding : {first_embedding_vector[:5]}")

# Vous stockeriez généralement ces vecteurs pour une utilisation ultérieure

# print("\nRéponse complète des embeddings :")

# print(embeddings_response)

except Exception as e:

print(f"Une erreur s'est produite : {e}")

Exécutez ce script Python, et vous verrez les dimensions des embeddings et un extrait du premier.

Autres capacités :

Mistral offre encore plus ! Bien que nous ne détaillions pas le code ici, assurez-vous d'explorer la documentation officielle pour :

- Achèvement (Hérité) : Bien que le chat soit souvent préféré, il peut y avoir des points de terminaison d'achèvement plus simples discutés ici : Mistral Completion Capabilities

- Compréhension de documents (OCR) : Extraction de texte à partir de documents, gérant potentiellement les mises en page et les images : Mistral Document Capabilities

- Appel de fonction : Permettre aux modèles d'interagir avec des outils et des API externes.

- Ajustement fin : Personnalisation des modèles sur vos propres données (souvent une fonctionnalité d'entreprise).

Reportez-vous toujours à la documentation officielle de Mistral AI pour obtenir les informations les plus récentes sur les points de terminaison, les paramètres et les capacités.

Étape 6 : Comprendre la tarification et surveiller l'utilisation

L'utilisation de modèles d'IA puissants a souvent un coût. Il est crucial de comprendre comment Mistral facture l'utilisation de son API.

- La tarification varie selon le modèle : Les modèles plus volumineux et plus performants coûtent généralement plus par jeton (entrée et sortie) que les modèles plus petits. Les modèles d'embedding ont leur propre tarification, généralement basée sur le nombre de jetons traités.

- Jetons : Les modèles d'IA traitent le texte par blocs appelés jetons. Un jeton n'est pas exactement un mot ; il peut s'agir d'un mot, d'une partie d'un mot ou d'une ponctuation. En gros, 1000 jetons représentent environ 750 mots, mais cela varie. La tarification est généralement spécifiée comme "coût pour 1 million de jetons d'entrée" et "coût pour 1 million de jetons de sortie".

- Consultez la page de tarification officielle : La tarification peut changer. Reportez-vous toujours à la page de tarification officielle de Mistral AI pour connaître les derniers détails. Vous pouvez généralement trouver un lien vers celle-ci sur leur site Web principal ou dans la documentation Models Overview.

- Surveillez votre utilisation : La console Mistral AI (console.mistral.ai) dispose généralement d'une section (souvent sous "Facturation" ou "Utilisation") où vous pouvez suivre vos appels d'API et les coûts associés. Vérifiez régulièrement cela pour éviter les surprises.

- Définissez des budgets/alertes : Si la plateforme le permet, définissez des limites de dépenses ou des alertes pour vous avertir si votre utilisation dépasse certains seuils.

Soyez attentif à votre utilisation, en particulier lors du développement d'applications susceptibles de faire de nombreux appels. Optimisez vos invites et choisissez le modèle le plus rentable qui répond à vos besoins.

Étape 7 : Effectuer des appels d'API avec APidog

Bien que le codage soit courant, vous souhaitez parfois une interface graphique pour tester rapidement les points de terminaison de l'API. Des outils comme Postman, Insomnia ou APidog sont excellents pour cela. Examinons l'utilisation d'APidog pour effectuer le même appel d'achèvement de chat qu'auparavant.

Téléchargez et installez APidog : Si vous ne l'avez pas déjà fait, téléchargez APidog à partir de leur site Web officiel et installez-le sur votre ordinateur.

Lancez APidog : Ouvrez l'application.

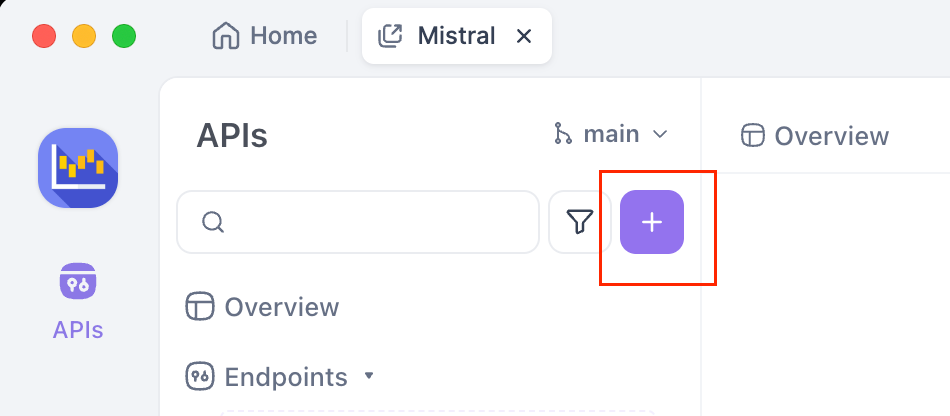

Créez une nouvelle requête : Vous verrez probablement un bouton "+" ou une option pour créer une "Nouvelle requête". Cliquez dessus.

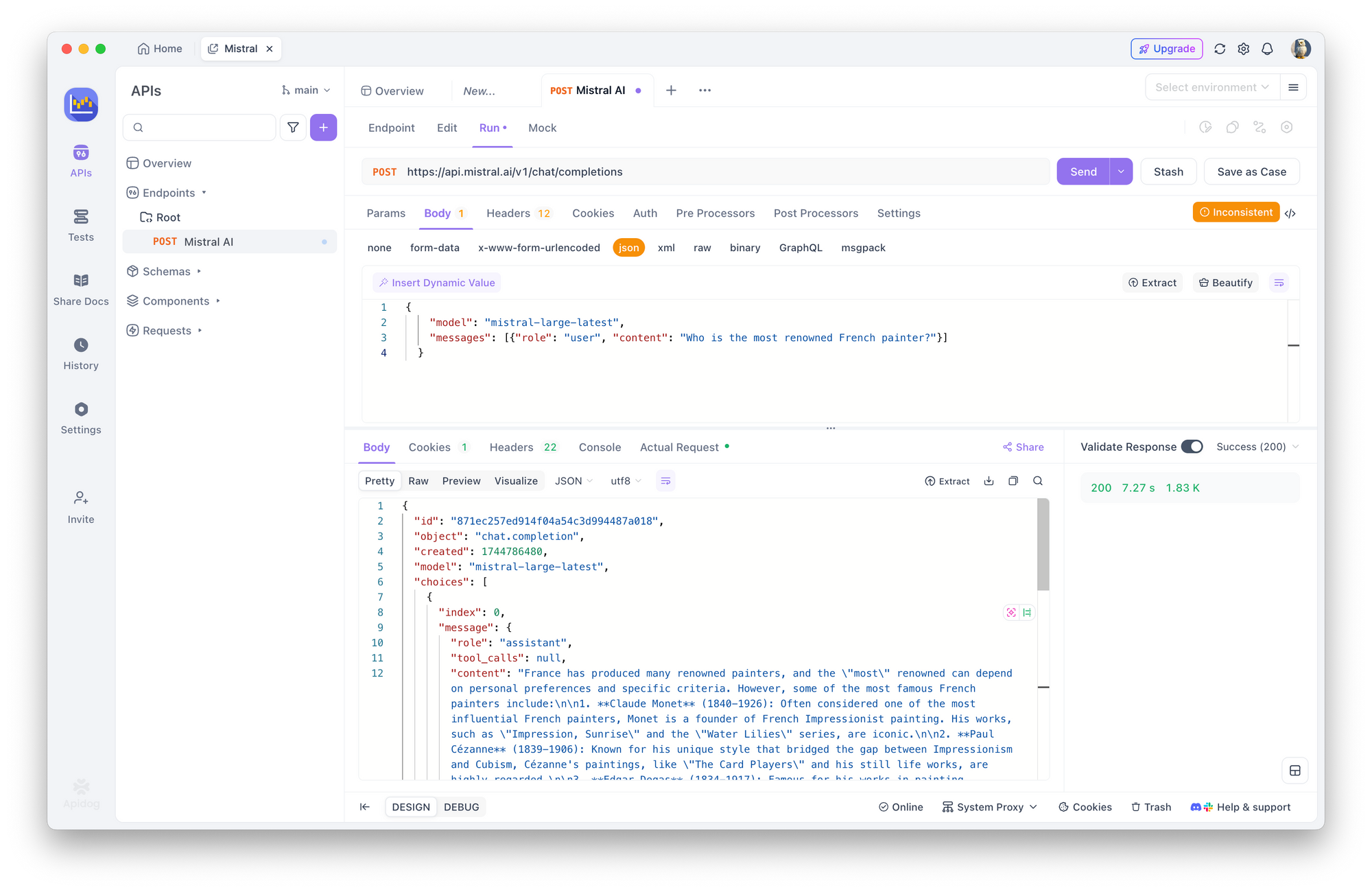

Définir la méthode HTTP et l'URL :

- Dans la zone de requête, recherchez le menu déroulant pour la méthode HTTP (elle est généralement par défaut sur

GET). Remplacez-la parPOST. - Dans le champ de saisie de l'URL à côté, entrez le point de terminaison d'achèvement du chat Mistral :

https://api.mistral.ai/v1/chat/completions

Configurer l'autorisation :

- Recherchez les onglets sous la barre d'URL comme "Params", "Authorization", "Headers", "Body". Cliquez sur l'onglet "Authorization".

- Dans le menu déroulant "Type" de cet onglet, sélectionnez "Bearer Token".

- Un champ intitulé "Token" apparaîtra à droite. Collez votre clé API Mistral enregistrée dans ce champ.

Définir les en-têtes de requête :

- Cliquez sur l'onglet "Headers".

- Vous devez ajouter deux en-têtes :

- Dans la première ligne vide sous "Key", tapez

Content-Type. Dans la colonne "Value" à côté, tapezapplication/json. - Dans la ligne vide suivante, tapez

Acceptpour la "Key" etapplication/jsonpour la "Value". - Définissez également

Authorization:Bearer $MISTRAL_API_KEY

Fournir le corps de la requête :

- Cliquez sur l'onglet "Body".

- Sélectionnez le bouton radio "raw".

- Juste à droite de "raw", il y a souvent un menu déroulant affichant le format (par exemple, "Text"). Remplacez ce menu déroulant par "JSON".

- Dans la grande zone de texte ci-dessous, collez la charge utile JSON pour votre requête :

{

"model": "mistral-large-latest",

"messages": [{"role": "user", "content": "Qui est le peintre français le plus renommé ?"}]

}

Envoyez la requête : Recherchez le bouton "Envoyer" (généralement affiché en évidence près de la barre d'URL) et cliquez dessus.

Afficher la réponse : APidog effectuera l'appel à l'API Mistral. La réponse du serveur apparaîtra dans la section inférieure de la fenêtre APidog, généralement sous un onglet "Response" ou "Body". Vous devriez voir la réponse JSON, y compris la réponse du modèle dans choices[0].message.content. Vous pouvez également inspecter les en-têtes de réponse et les codes d'état (espérons 200 OK !).

L'utilisation d'un outil comme APidog est fantastique pour expérimenter différents modèles, invites et paramètres sans écrire de code.

Étape 8 : Meilleures pratiques et sécurité (un bref récapitulatif)

Travailler avec des clés API exige de la responsabilité. Réitérons quelques points cruciaux :

- NE JAMAIS coder en dur les clés : Ne collez pas votre clé API directement dans votre code source (

my_key = "sk-..."). Si vous validez ce code dans un référentiel public (comme GitHub), votre clé sera exposée et d'autres pourraient l'utiliser, accumulant des frais sur votre compte. - Utilisez des variables d'environnement : Comme le montrent les exemples de code, le chargement des clés à partir de variables d'environnement (

os.environ,process.env) est une pratique standard beaucoup plus sûre. - Outils de gestion des secrets : Pour les applications plus robustes, en particulier dans les environnements d'équipe ou les déploiements cloud, utilisez des services de gestion des secrets dédiés (comme AWS Secrets Manager, Google Secret Manager, HashiCorp Vault).

- Privilège minimal : Si Mistral permet de créer des clés avec des autorisations spécifiques (ce n'est pas toujours disponible), créez des clés qui n'ont que les autorisations nécessaires pour une application particulière.

- Rotation des clés : Pour une sécurité renforcée, envisagez de générer périodiquement de nouvelles clés et de retirer les anciennes (par exemple, tous les quelques mois), bien que cela nécessite de mettre à jour vos applications.

- Surveillez régulièrement : Gardez un œil sur votre tableau de bord d'utilisation dans la console Mistral. Une activité inhabituelle pourrait indiquer une clé compromise.

Conclusion : Allez-y et construisez !

Vous avez réussi à naviguer dans le processus d'obtention et d'utilisation d'une clé API Mistral AI ! Nous avons couvert :

- La configuration de votre compte Mistral et l'activation de la facturation.

- La génération et le stockage sécurisé de votre clé API unique.

- La compréhension des différents modèles Mistral et comment en choisir un.

- L'exécution d'appels d'API à l'aide de Python, TypeScript et cURL pour les achèvements de chat et les embeddings.

- La vérification des prix et la surveillance de votre utilisation.

- L'utilisation d'un outil GUI comme APidog pour faciliter les tests d'API.

- Le renforcement des meilleures pratiques de sécurité essentielles.

L'API Mistral est une passerelle vers des capacités d'IA incroyablement puissantes. Votre clé API est la clé littérale pour déverrouiller ce potentiel. En suivant les étapes et les meilleures pratiques décrites ici, vous êtes en bonne voie pour intégrer une IA de pointe dans vos propres projets.

N'hésitez pas à explorer davantage la documentation officielle de Mistral - c'est la source ultime de vérité pour tous les paramètres, modèles et fonctionnalités avancées disponibles.

Bonne construction !

Vous voulez une plateforme intégrée, tout-en-un, pour que votre équipe de développeurs travaille ensemble avec une productivité maximale ?

Apidog répond à toutes vos demandes et remplace Postman à un prix beaucoup plus abordable !