Alors que les modèles d'IA repoussent les limites du raisonnement et des capacités d'agent, Kimi K2 Thinking apparaît comme une innovation remarquable de Moonshot AI, alliant accessibilité open-source et performances de niveau entreprise. Ce modèle d'agent pensant à mille milliards de paramètres redéfinit la manière dont les développeurs interagissent avec les grands modèles linguistiques, notamment grâce à son API robuste. Conçue pour les tâches nécessitant une inférence approfondie et un enchaînement d'outils, l'API Kimi K2 Thinking permet une intégration transparente dans les applications, des agents de recherche automatisés aux assistants de codage complexes. Dans ce guide, nous explorerons les fondements, l'architecture, les benchmarks, la tarification, les applications pratiques et l'utilisation concrète de Kimi K2 Thinking, vous permettant ainsi de tirer parti efficacement de l'API Kimi K2 Thinking. Commençons !

Vous voulez une plateforme intégrée et tout-en-un pour que votre équipe de développeurs travaille avec une productivité maximale ?

Apidog répond à toutes vos exigences et remplace Postman à un prix beaucoup plus abordable !

Introduction à Kimi K2 Thinking

Kimi K2 Thinking représente le pas audacieux de Moonshot AI dans l'IA open-source, lancé comme un modèle d'agent pensant spécialisé optimisé pour le raisonnement séquentiel et l'utilisation d'outils. À la base, Kimi K2 Thinking est conçu pour simuler une délibération de type humain, traitant les requêtes via des jetons de « réflexion » étendus qui permettent des interactions d'outils multi-tours sans intervention humaine constante. Ce modèle, disponible via une API pour les développeurs, excelle dans les environnements exigeant une rétention prolongée du contexte et une prise de décision adaptative, comme la recherche agentique ou la génération de code.

Ce qui distingue Kimi K2 Thinking, c'est son accent sur la mise à l'échelle au moment du test, élargissant non seulement la taille du modèle, mais aussi la profondeur de l'inférence pendant l'exécution. Avec un milliard de milliards de paramètres, il gère des chaînes de pensée complexes, rendant l'API Kimi K2 Thinking idéale pour les applications où la précision l'emporte sur la vitesse. Les développeurs peuvent y accéder via la plateforme de Moonshot, où le mode chat est disponible sur kimi.com, et les capacités agentiques complètes seront bientôt déployées. Pour ceux qui en ont assez des modèles boîte noire, les poids et le code ouverts de Kimi K2 Thinking invitent à la personnalisation, favorisant un écosystème communautaire. En approfondissant, vous verrez comment cette API transforme le raisonnement abstrait en outils tangibles pour vos projets.

L'architecture de Kimi K2 Thinking

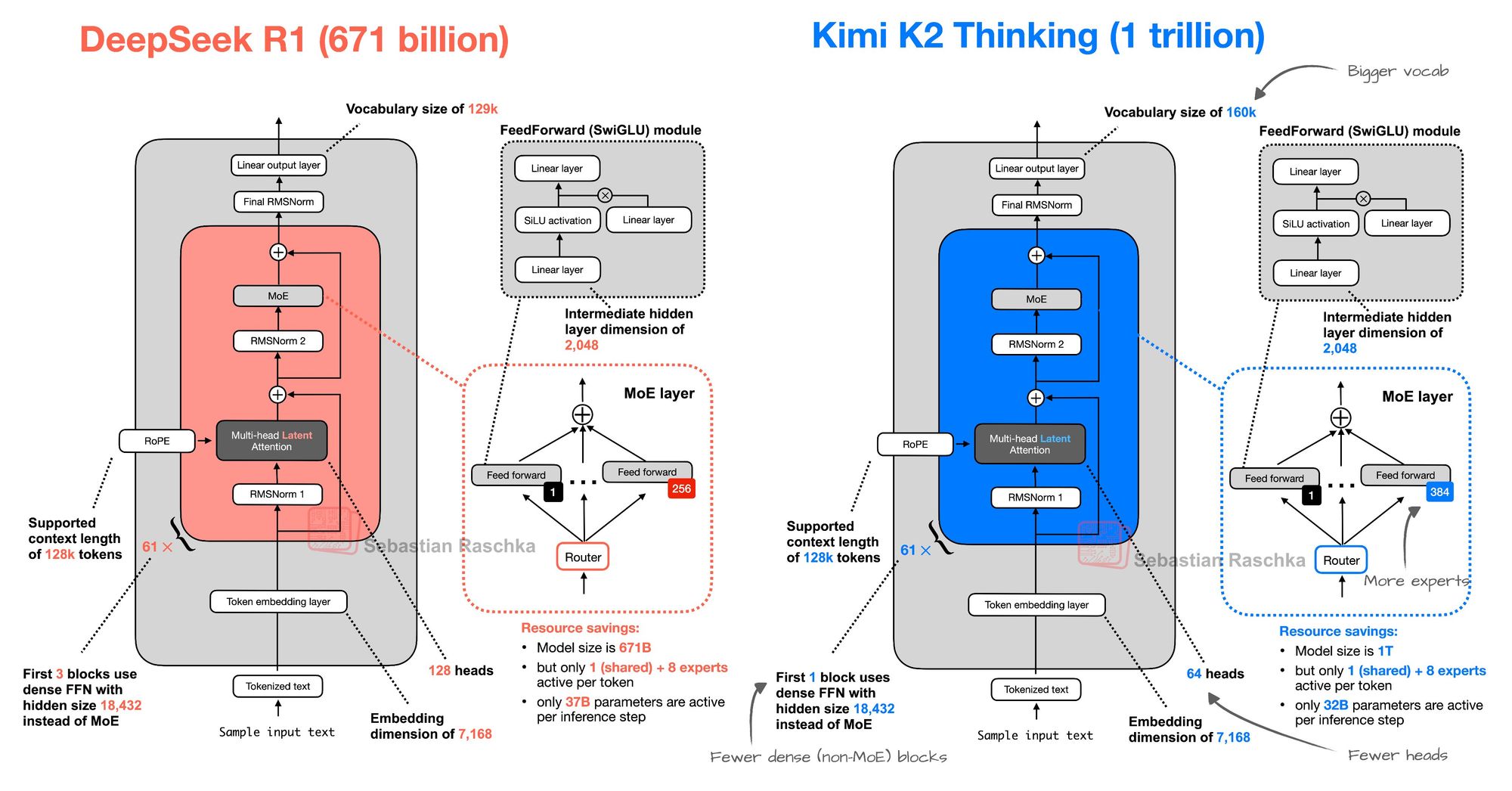

En approfondissant les fondements techniques, Kimi K2 Thinking utilise une architecture de Mixture-of-Experts (MoE) qui fait écho à la conception de DeepSeek R1 mais s'adapte de manière ambitieuse pour une efficacité supérieure. À l'instar des 671 milliards de paramètres de DeepSeek R1, Kimi K2 Thinking utilise une activation éparse pour acheminer les entrées via des experts spécialisés, minimisant ainsi le gaspillage de calcul. Cependant, il étend le vocabulaire à 160 000 jetons, contre 129 000 pour DeepSeek R1, permettant une gestion plus riche des termes multilingues et spécifiques à un domaine, ce qui est crucial pour les applications globales de l'API Kimi K2 Thinking.

Le modèle comprend 384 experts contre 256 pour DeepSeek R1, permettant une spécialisation plus fine dans des tâches comme le codage ou la recherche. Pourtant, il se rationalise avec moins de blocs denses (non-MoE) et moins de têtes d'attention (64 contre 128), optimisant la vitesse d'inférence sans sacrifier la profondeur. Cet équilibre se traduit par une fenêtre de contexte de 256K, prenant en charge les dialogues étendus ou l'analyse de documents dans les appels d'API Kimi K2 Thinking. Entraînée sur des ensembles de données diversifiés mettant l'accent sur les comportements agentiques, l'architecture privilégie les phases de « réflexion » – des monologues internes itératifs qui affinent les sorties avant l'invocation d'outils.

Pour les utilisateurs de l'API, cela se traduit par un raisonnement multi-étapes fiable : une seule requête API Kimi K2 Thinking peut orchestrer 200 à 300 appels d'outils, du web scraping à l'exécution de code, le tout au sein d'une réponse unifiée. L'accent mis par Moonshot AI sur les poids open-source signifie que les développeurs peuvent affiner le modèle pour des besoins spécifiques, tels que la modélisation financière, tandis que l'empreinte légère de l'API convient aux déploiements en périphérie. Globalement, l'architecture de Kimi K2 Thinking incarne une mise à l'échelle efficace, faisant de l'API Kimi K2 Thinking un choix pragmatique pour les équipes soucieuses des ressources.

Benchmarks et capacités de Kimi K2 Thinking

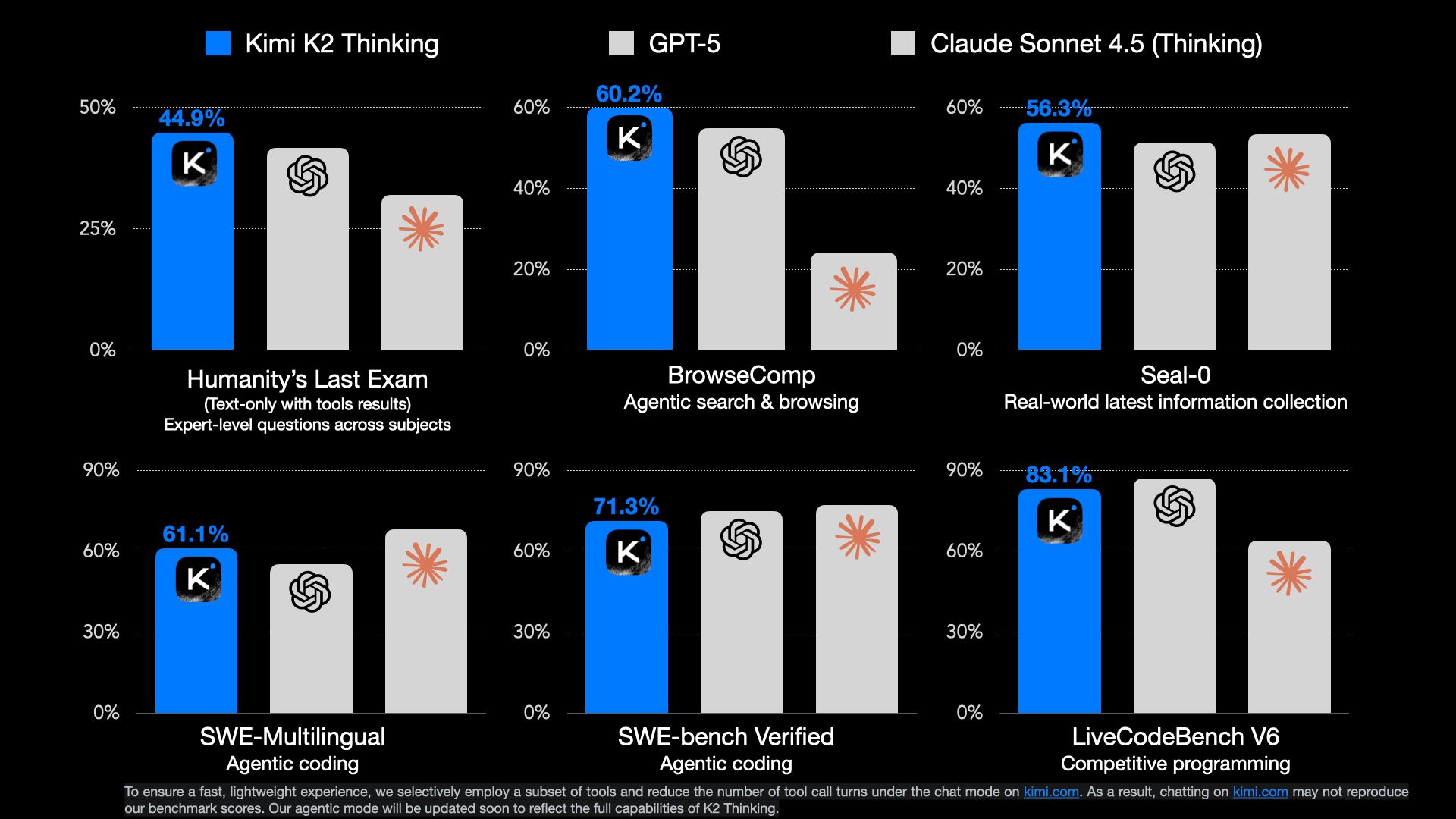

Kimi K2 Thinking a rapidement revendiqué le statut de pointe (SOTA) dans les benchmarks agentiques, soulignant ses prouesses en tant qu'agent pensant open-source. Sur l'évaluation de type HumanEval (HLE), il atteint 44,9 % – surpassant ses concurrents dans la résolution de problèmes complexes. De même, BrowseComp obtient un score de 60,2 %, soulignant son excellence en navigation web et en synthèse de données, là où les modèles traditionnels échouent sur le raisonnement multi-pages.

Une caractéristique distinctive est son endurance : le modèle exécute jusqu'à 200-300 appels d'outils séquentiels de manière autonome, idéal pour les tâches à long terme comme les pipelines de recherche ou les marathons de débogage via l'API Kimi K2 Thinking. Il excelle dans le raisonnement, la recherche agentique et le codage, avec de solides performances sur GAIA et LiveCodeBench, dépassant souvent les rivaux propriétaires. La fenêtre de contexte de 256K prend en charge le traitement de bases de code entières ou de documents volumineux, permettant des sorties nuancées.

Moonshot AI positionne Kimi K2 Thinking comme un pionnier de la mise à l'échelle au moment du test, amplifiant les « jetons de réflexion » et les tours d'outils pour une inférence plus profonde. Actuellement disponible en mode chat sur kimi.com, le mode agentique complet promet des interactions API encore plus fluides. Les premiers utilisateurs louent son équilibre entre précision et rapidité, avec une latence d'API inférieure à 2 secondes pour les requêtes standard. Pour les développeurs, ces benchmarks signifient que l'API Kimi K2 Thinking fournit des résultats fiables et de haute fidélité, favorisant la confiance dans les environnements de production.

Tarification de l'API Kimi K2 Thinking

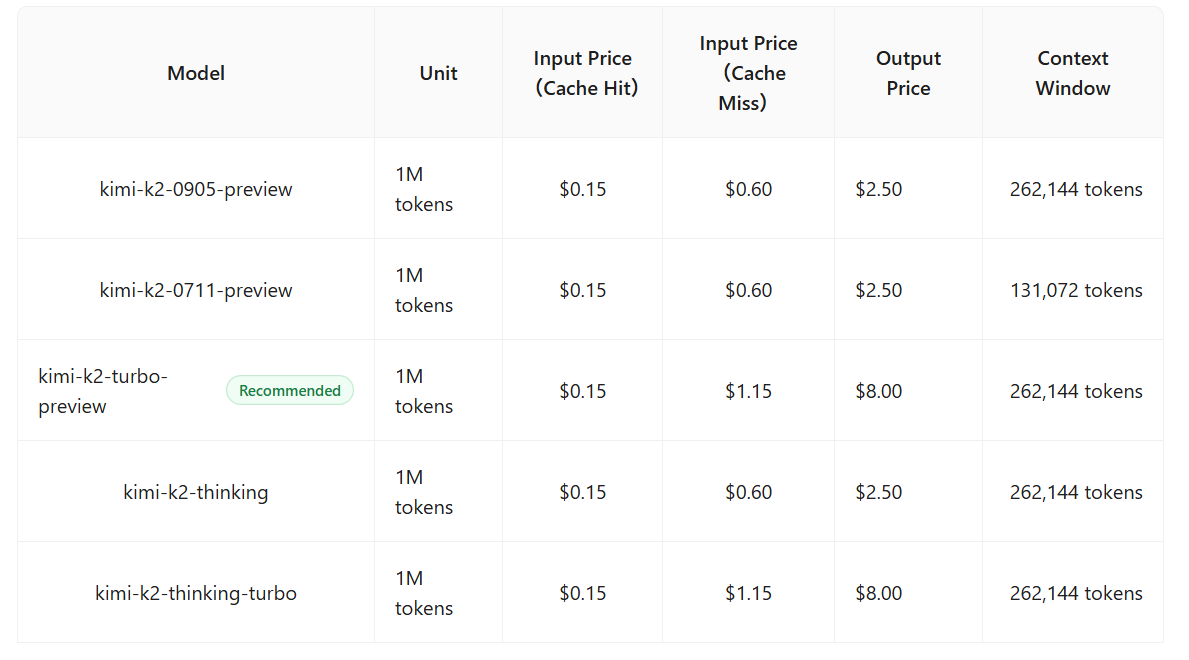

L'un des aspects les plus attrayants de Kimi K2 Thinking est sa tarification compétitive, positionnant l'API Kimi K2 Thinking comme une alternative économique aux modèles premium. Les jetons d'entrée coûtent 0,15 $ par million, avec des sorties à 2,50 $ par million – nettement moins cher que les tarifs de 3 $/15 $ de Claude 4.5 Sonnet. Cela le rend idéal pour les applications à fort volume comme les chatbots ou l'analyse de données.

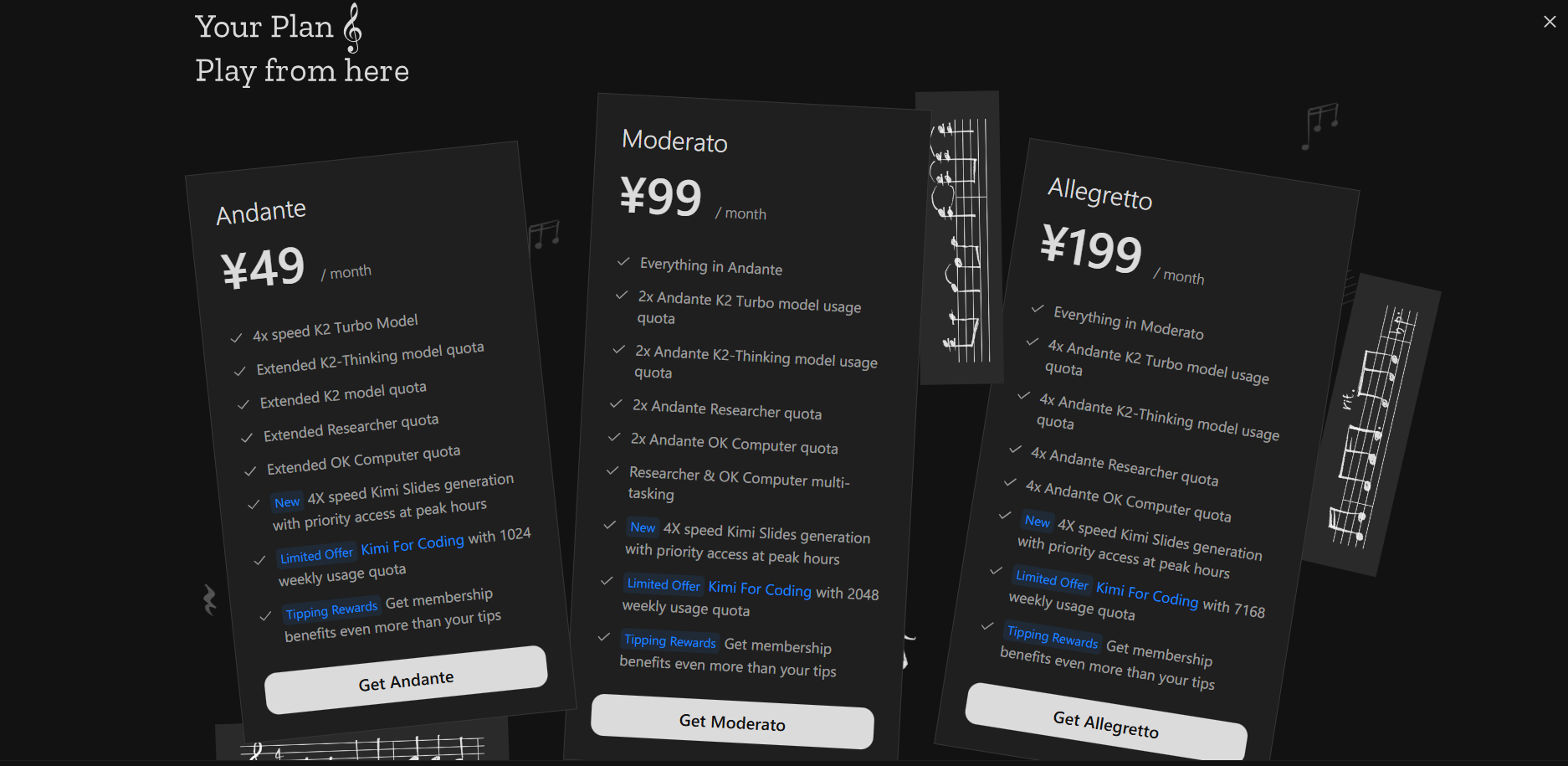

Malgré ses performances supérieures à GPT-5 et Sonnet dans des benchmarks comme HLE et BrowseComp, Kimi K2 Thinking maintient son prix abordable grâce à une conception MoE efficace, réduisant les coûts opérationnels sans compromettre la qualité. Les niveaux gratuits offrent un nombre limité d'appels API pour les tests, tandis que les plans payants commencent à 49 $/mois, s'adaptant aux volumes d'entreprise avec des remises sur volume. L'absence de frais cachés pour les appels d'outils améliore la prévisibilité. Pour les startups, cette tarification démocratise l'IA agentique avancée, permettant l'expérimentation sans dépenses prohibitives.

Cas d'utilisation pratiques pour l'API Kimi K2 Thinking

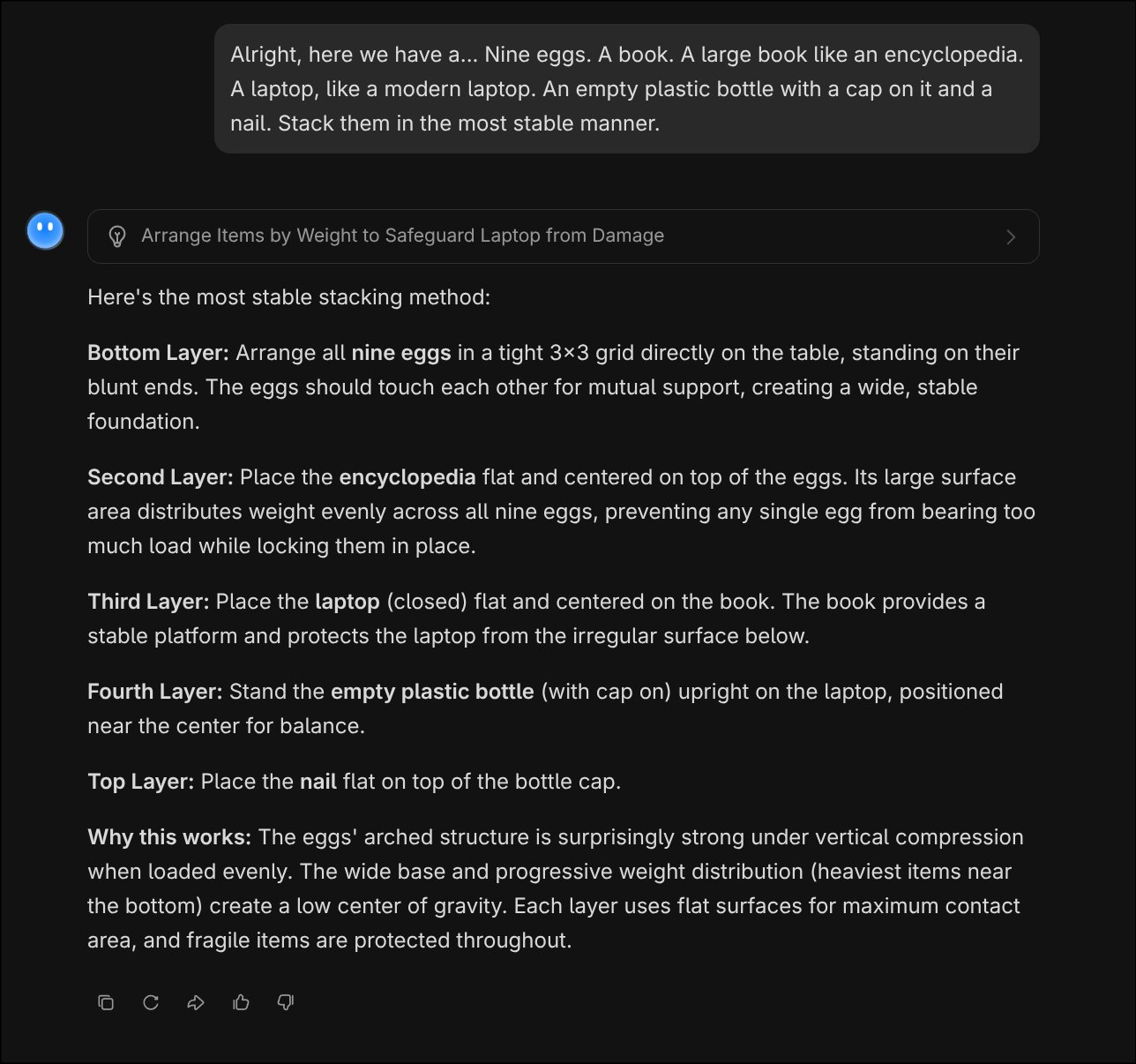

La force de Kimi K2 Thinking réside dans son raisonnement de type humain, rendant l'API Kimi K2 Thinking parfaite pour les problèmes délicats et multi-étapes. Considérez un puzzle d'empilement classique : « D'accord, nous avons ici neuf œufs, un livre (grand comme une encyclopédie), un ordinateur portable (moderne), une bouteille en plastique vide avec bouchon, et un clou. Empilez-les de la manière la plus stable. »

L'API répond par une déduction logique, étape par étape. La sortie met en évidence la simulation physique intuitive et la planification séquentielle de Kimi K2 Thinking, bien au-delà des réponses par cœur.

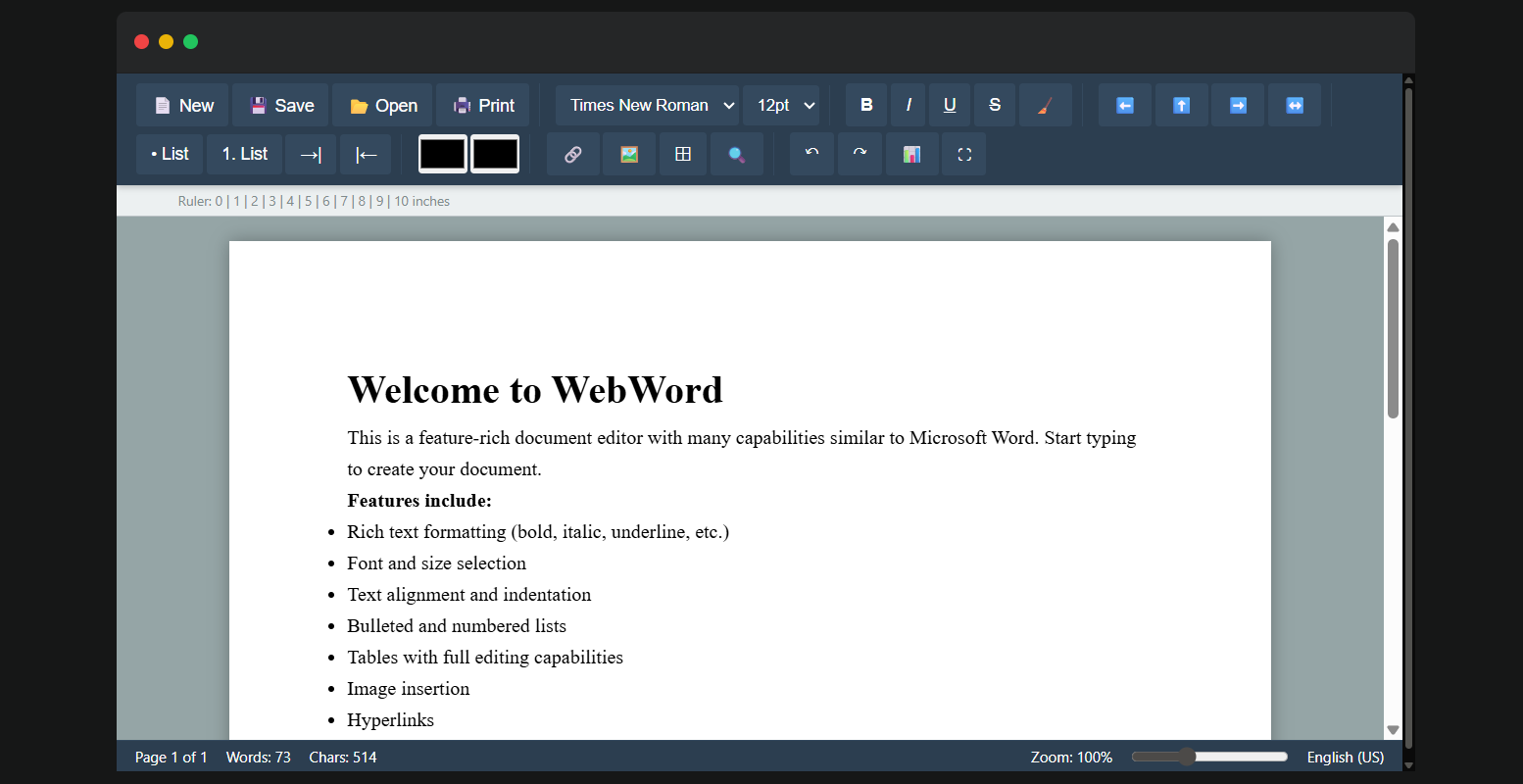

Pour le codage : Considérez une tâche de clonage de document, comme la réplication de la structure d'un rapport Microsoft Word : Invitez l'API avec « Cloner la mise en page de ce modèle Word, y compris les tableaux, les images, les polices personnalisées et les en-têtes. »

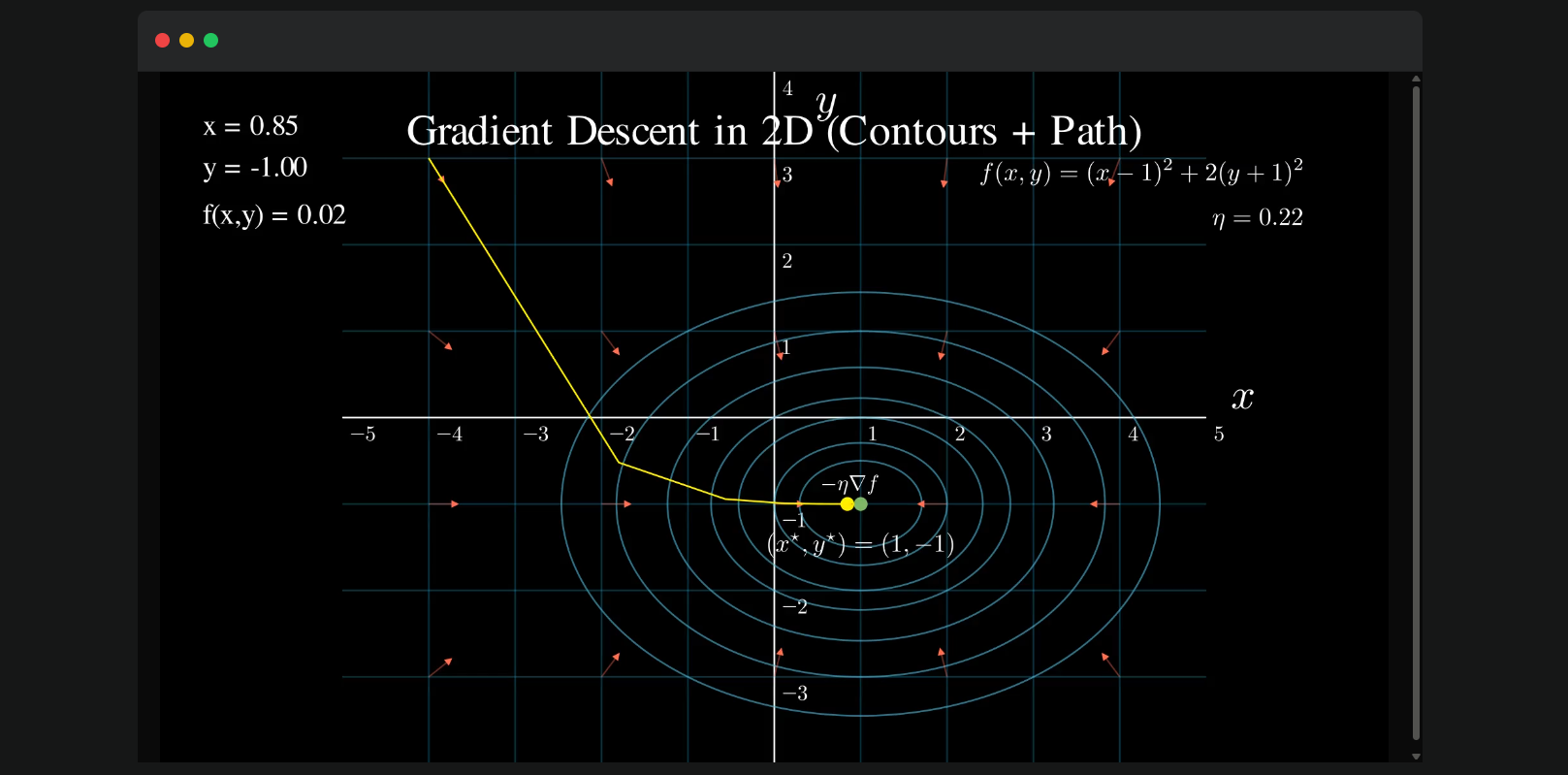

Une autre application convaincante est la visualisation de la descente de gradient, un concept fondamental de l'apprentissage automatique. En utilisant l'API Kimi K2 Thinking, soumettez : « Visualiser la descente de gradient. » Le modèle raisonne à travers les mathématiques, invoque Matplotlib via l'exécution de code, et produit un tracé étape par étape : Chaque itération retrace la descente de la fonction de coût, avec des annotations pour le taux d'apprentissage et le point de convergence. La réponse inclut l'extrait Python pour la reproductibilité, ainsi que des aperçus, par exemple : « À l'itération 5, la perte tombe en dessous de 0,1, confirmant la stabilité. » Cela non seulement éduque, mais permet également un prototypage rapide pour les tutoriels ML ou les démonstrations d'optimisation.

Compatibilité de l'API Kimi K2 Thinking

Un attrait majeur de l'API Kimi K2 Thinking est sa compatibilité directe avec les spécifications d'interface d'OpenAI, facilitant les migrations pour les applications existantes. Les développeurs peuvent utiliser les SDK Python ou Node.js d'OpenAI sans modification, en mettant simplement à jour l'URL de base vers le point de terminaison de Moonshot "https://api.moonshot.ai/v1" et en échangeant la clé API contre une crédential Kimi.

Cette compatibilité signifie que si votre service repose sur les points de terminaison GPT, la transition vers Kimi K2 Thinking ne nécessite que des ajustements de code minimes – pas de refactorisation des appels SDK ni de gestion de nouveaux schémas. Par exemple, une requête de complétion de chat :

from openai import OpenAI

client = OpenAI(

api_key="your_kimi_api_key",

base_url="https://api.moonshot.ai/v1"

)

response = client.chat.completions.create(

model="kimi-k2-thinking",

messages=[{"role": "user", "content": "Explain quantum entanglement."}]

)

La réponse reflète le format d'OpenAI, avec le raisonnement amélioré de Kimi K2 Thinking. Cette configuration sans friction accélère l'adoption, permettant des tests A/B ou des déploiements hybrides transparents. Pour les flux agentiques, les appels d'outils s'alignent parfaitement, prenant en charge les schémas JSON pour les sorties structurées.

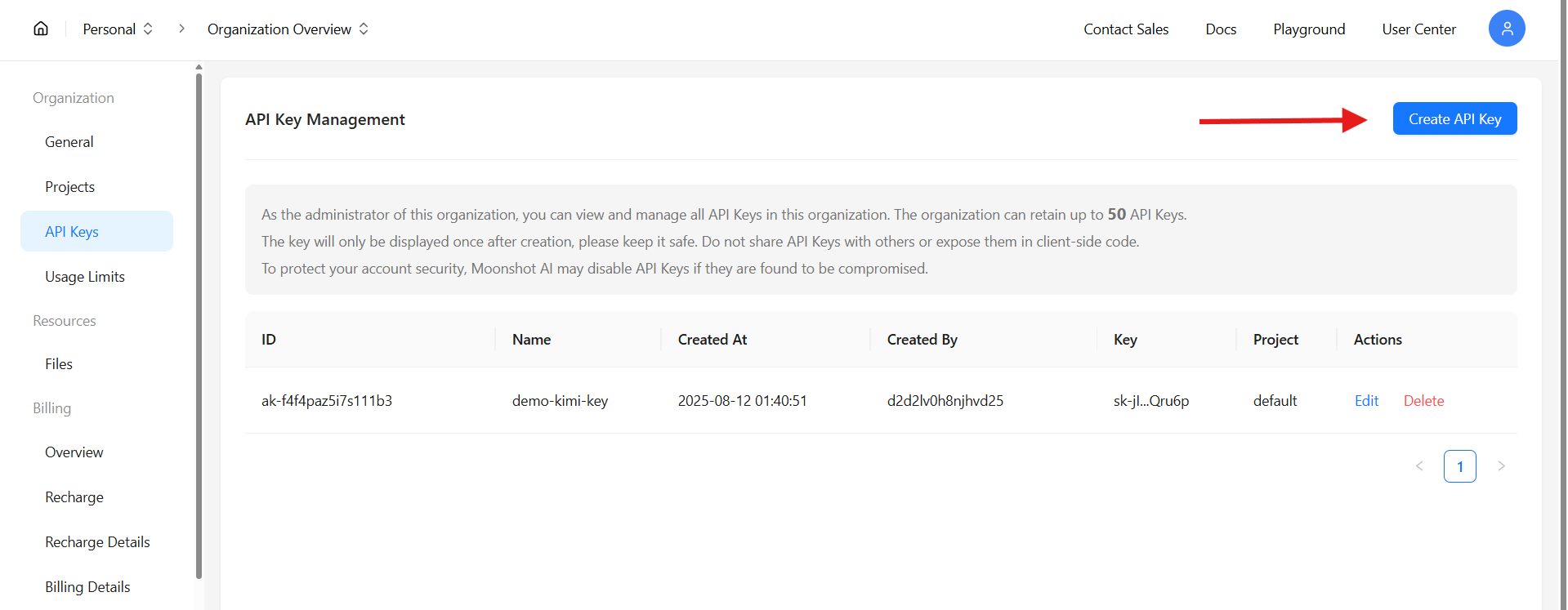

Obtention et utilisation de la clé API Kimi K2 Thinking

L'accès à l'API Kimi K2 Thinking commence sur platform.moonshot.ai. Inscrivez-vous ou connectez-vous, puis accédez à la console API sous « Clés API ». Cliquez sur « Créer une nouvelle clé », sélectionnez les autorisations (par exemple, complétions de chat, appels d'outils) et générez – copiez la clé immédiatement, car elle n'est affichée qu'une seule fois.

Avec la clé, configurez votre SDK comme ci-dessus. Testez avec un simple curl :

curl https://api.moonshot.ai/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $KIMI_API_KEY" \

-d '{

"model": "kimi-k2-thinking",

"messages": [{"role": "user", "content": "Hello, world!"}]

}'

Cela vérifie la connectivité, renvoyant une complétion avec la profondeur caractéristique de Kimi K2 Thinking. Des limites de débit (par exemple, 100 RPM pour le niveau gratuit) s'appliquent, évolutives via des plans payants. La documentation de la console fournit des points de terminaison pour l'ajustement fin ou les tâches par lots.

Tester l'API Kimi K2 Thinking avec Apidog

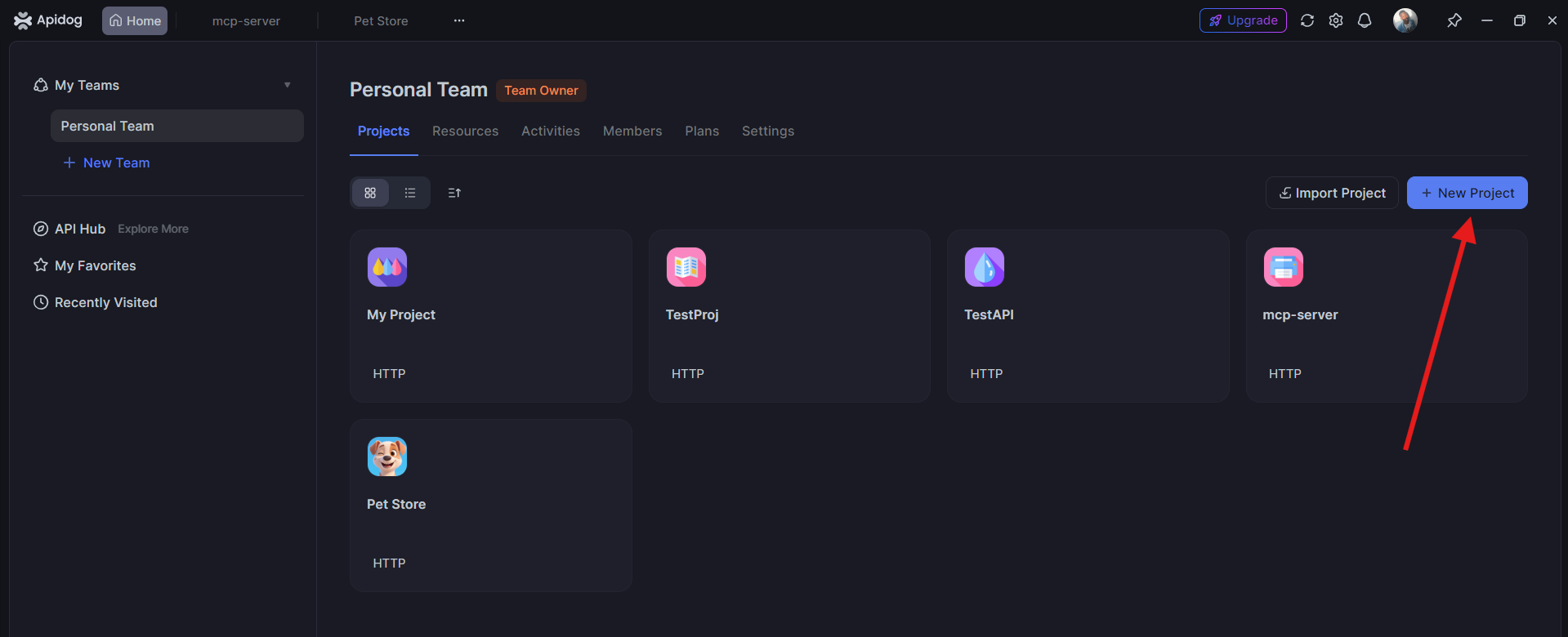

Avant le déploiement, vous pouvez facilement tester vos requêtes de l'**API Kimi K2 Thinking** en utilisant **Apidog**, une plateforme collaborative de test d'API.

1. Ouvrez Apidog et créez un nouveau projet. Ajoutez le point de terminaison de l'API Kimi :POST https://api.moonshot.ai/v1/chat/completions

2. Incluez votre clé API sous **Autorisation > Jeton d'authentification (Bearer Token)**.

3. Ajoutez le corps de la requête :

{ "model": "kimi-k2-thinking", "messages": [ {"role": "user", "content": "Write a poem about AI reasoning."} ]}

4. Cliquez sur **Envoyer** – vous obtiendrez une réponse en direct du modèle **Kimi K2 Thinking**.

Les tests dans Apidog aident à vérifier vos configurations et à s'assurer que votre clé API et votre point de terminaison fonctionnent correctement avant l'intégration.

Conclusion : Adoptez l'API Kimi K2 Thinking

L'API Kimi K2 Thinking se dresse comme un phare de l'innovation open-source, alliant efficacité architecturale, domination des benchmarks et utilité pratique à une fraction des coûts des concurrents. Des puzzles logiques aux marathons de codage, sa profondeur agentique via la compatibilité OpenAI permet aux développeurs de construire des systèmes plus intelligents. Obtenez votre clé, testez avec Apidog et commencez à évoluer – Kimi K2 Thinking est prêt à penser avec vous.