Dans le monde en rapide évolution du développement assisté par l'IA, Cursor est devenu un IDE favori pour de nombreux ingénieurs. Mais à mesure que le paysage de l'IA évolue, les attentes des développeurs aussi. La communauté est en effervescence avec des demandes pour que Kimi K2—le modèle d'intelligence agentique ouvert de Moonshot AI—soit nativement pris en charge dans Cursor. Pourquoi ? Parce que Kimi K2 change la donne pour le codage, le raisonnement et l'utilisation d'outils, et son rapport coût-efficacité est difficile à battre.

Cet article explique pourquoi les développeurs exigent Kimi K2 dans Cursor, comment vous pouvez l'utiliser dès aujourd'hui (même sans prise en charge native), et comment Apidog MCP Server peut faire passer votre flux de travail au niveau supérieur.

Astuce de pro :

Apidog MCP ServerCommencez avec Apidog MCP Server et découvrez une intégration IA-API transparente.

Kimi K2 : Intelligence agentique ouverte pour les développeurs

Kimi K2 n'est pas seulement un autre grand modèle linguistique. Il est conçu pour les tâches agentiques—ce qui signifie qu'il ne se contente pas de répondre aux questions, il agit. Avec 32 milliards de paramètres activés (sur 1 trillion au total), Kimi K2 atteint des performances de pointe en codage, en mathématiques et en utilisation d'outils.

Fonctionnalités clés :

- Codage agentique : Automatisez les flux de travail complexes, de l'analyse de données à la génération de code.

- Utilisation d'outils : Kimi K2 peut comprendre et utiliser des outils, ce qui le rend idéal pour la création d'applications agentiques.

- Open Source : Les modèles de base et d'instruction sont disponibles en téléchargement et personnalisation.

Cas d'utilisation :

- Analyse de données salariales avec des flux de travail statistiques multi-étapes.

- Refactoring et débogage de code automatisés.

- Création d'agents personnalisés qui interagissent avec les API, les fichiers et les outils externes.

Benchmarks :

Kimi K2 égale ou surpasse les principaux modèles open-source et propriétaires sur une gamme de tâches, y compris LiveCodeBench, SWE-bench, et plus encore.

Pourquoi les développeurs veulent Kimi K2 dans Cursor

La demande pour Kimi K2 dans Cursor est forte et claire au sein de la communauté :

- « Le modèle Kimi K2 est une bête, et si bon marché que nous en avons besoin dans Cursor, cela aidera à faire beaucoup avec le plan tarifaire pro. »

- « +1 pour ça, certains modèles open source ont vraiment repoussé les limites, l'équipe devrait se sevrer d'Anthropic progressivement et envisager de travailler plus étroitement avec les modèles open source. »

- « Absolument, c'est exactement ce que je suis venu demander. »

Pourquoi cet enthousiasme ?

- Performance : Kimi K2 est un modèle de type Mixture-of-Experts (MoE) avec 1 trillion de paramètres, optimisé pour les tâches agentiques, le codage et le raisonnement.

- Coût : À seulement 60 cents par million de jetons d'entrée (manque de cache) et 2,5 $ par million de jetons de sortie, c'est l'un des modèles haute performance les plus abordables disponibles.

- Open Source : Kimi K2 est véritablement ouvert, avec des poids et des API disponibles pour que chacun puisse l'utiliser, le tester et l'intégrer.

Que manque-t-il ?

Malgré sa puissance, Kimi K2 n'est pas encore un modèle intégré à Cursor. Mais la demande de la communauté pousse au changement — et en attendant, il existe des solutions de contournement.

Comment utiliser Kimi K2 dans Cursor (Guide étape par étape)

Bien que Cursor ne prenne pas encore nativement en charge Kimi K2, vous pouvez l'utiliser dès aujourd'hui via OpenRouter. Voici comment faire :

1. Créer un compte OpenRouter

- Allez sur https://openrouter.ai/ et inscrivez-vous.

2. Ajouter des crédits

- Visitez https://openrouter.ai/settings/credits pour ajouter des crédits à votre compte.

3. Générer une clé API

- Allez sur https://openrouter.ai/settings/keys et créez une nouvelle clé API.

4. Configurer Cursor

Dans Cursor, naviguez vers settings > Models.

Remplacez l'URL du modèle par https://openrouter.ai/api/v1 et collez votre clé API.

5. Ajouter Kimi K2 comme modèle personnalisé

Cliquez sur Add Custom Model et entrez moonshotai/kimi-k2.

6. Commencer à utiliser Kimi K2 dans Cursor

Vous pouvez maintenant utiliser Kimi K2 pour le codage, le raisonnement et plus encore—directement dans Cursor.

Note :

Le mode Agent peut ne pas fonctionner comme d'habitude, car il ne s'agit pas d'une intégration native de Cursor. Mais pour la plupart des tâches, Kimi K2 offre des résultats exceptionnels.

Boostez votre flux de travail : Connectez Kimi K2 à vos spécifications d'API avec Apidog MCP Server

Bien qu'utiliser Kimi K2 dans Cursor soit puissant, vous pouvez débloquer encore plus de valeur en connectant vos spécifications d'API directement à vos outils d'IA avec Apidog MCP Server.

Qu'est-ce qu'Apidog MCP Server ?

Apidog MCP Server vous permet d'utiliser votre spécification d'API comme source de données pour les IDE basés sur l'IA comme Cursor. Cela signifie que vous pouvez :

- Générer ou modifier du code basé sur votre spécification d'API.

- Rechercher et analyser votre documentation API avec l'IA.

- Automatiser les mises à jour de code, la génération de DTO et les tâches de documentation.

Comment configurer Apidog MCP Server avec Cursor

Prérequis :

Avant de commencer, assurez-vous des points suivants :

✅ Node.js est installé (version 18+ ; dernière LTS recommandée)

✅ Vous utilisez un IDE qui prend en charge MCP, tel que : Cursor

Étape 1 : Préparer votre fichier OpenAPI

Vous aurez besoin d'accéder à votre définition d'API :

- Une URL (par exemple,

https://petstore.swagger.io/v2/swagger.json) - Ou un chemin de fichier local (par exemple,

~/projects/api-docs/openapi.yaml) - Formats pris en charge :

.jsonou.yaml(OpenAPI 3.x recommandé)

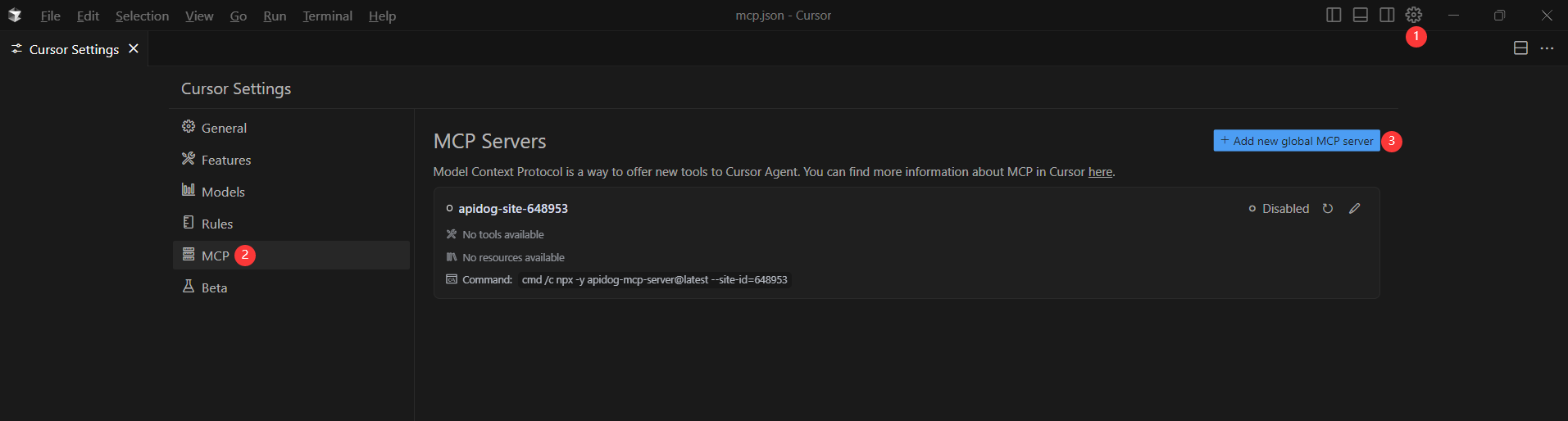

Étape 2 : Ajouter la configuration MCP à Cursor

Vous allez maintenant ajouter la configuration au fichier mcp.json de Cursor.

N'oubliez pas de remplacer <oas-url-or-path> par votre URL OpenAPI réelle ou votre chemin local.

- Pour MacOS/Linux :

{

"mcpServers": {

"API specification": {

"command": "npx",

"args": [

"-y",

"apidog-mcp-server@latest",

"--oas=https://petstore.swagger.io/v2/swagger.json"

]

}

}

}Pour Windows :

{

"mcpServers": {

"API specification": {

"command": "cmd",

"args": [

"/c",

"npx",

"-y",

"apidog-mcp-server@latest",

"--oas=https://petstore.swagger.io/v2/swagger.json"

]

}

}

}Étape 3 : Vérifier la connexion

Après avoir enregistré la configuration, testez-la dans l'IDE en demandant à Kimi K2 (ou à tout agent IA) de :

Please fetch API documentation via MCP and tell me how many endpoints exist in the project.Si cela fonctionne, vous verrez une réponse structurée qui liste les points de terminaison et leurs détails. Si ce n'est pas le cas, vérifiez le chemin d'accès à votre fichier OpenAPI et assurez-vous que Node.js est correctement installé.

Exemples de cas d'utilisation :

- « Utilisez MCP pour récupérer la spécification d'API et générer des enregistrements Java pour le schéma 'Product'. »

- « Basé sur la spécification d'API, ajoutez de nouveaux champs au DTO 'User'. »

- « Ajoutez des commentaires pour chaque champ dans la classe 'Order' basé sur la documentation API. »

Pourquoi Apidog MCP Server ?

- Intégration transparente entre vos documents API et vos outils IA.

- Automatisez les tâches répétitives de codage et de documentation.

- Gardez votre API et votre base de code synchronisées—plus de mises à jour manuelles.

Conclusion : L'avenir du développement basé sur l'IA est ouvert, flexible et automatisé

La demande pour Kimi K2 dans Cursor est un signal clair : les développeurs veulent plus de choix, plus de puissance et plus de flexibilité dans leurs outils d'IA. Bien que le support natif soit encore à l'horizon, vous pouvez utiliser Kimi K2 dans Cursor dès aujourd'hui avec OpenRouter—et faire passer votre flux de travail encore plus loin en connectant votre documentation API avec Apidog MCP Server.

Prêt à découvrir le prochain niveau de développement d'API intelligent et automatisé ?

- Configurez Kimi K2 dans Cursor en suivant les étapes ci-dessus.

- Connectez vos documents API à Cursor avec Apidog MCP Server.

- Profitez d'un flux de travail de développement agentique fluide qui vous fait gagner du temps, réduit les erreurs et renforce votre équipe.