Kimi K2 se distingue comme un modèle d'intelligence agentique véritablement ouvert. Développé par Moonshot AI, Kimi K2 est un modèle de mélange d'experts (MoE) doté d'un billion de paramètres, optimisé pour le raisonnement avancé, le codage et l'utilisation d'outils. Mieux encore, il est accessible à tous — sans murs payants, sans formulaires de recherche, sans listes d'attente.

Ce guide explore quatre méthodes pratiques et gratuites pour utiliser Kimi K2, et vous montre comment optimiser votre flux de travail en connectant Kimi K2 à vos spécifications d'API avec Apidog MCP Server.

Conseil de pro : Apidog MCP Server

Méthode 1 : Utiliser Kimi K2 gratuitement via le site web officiel

L'interface de chat officielle de Kimi K2 est le moyen le plus simple d'essayer le modèle gratuitement. Il suffit de se rendre sur kimi.com et de se connecter (l'interface utilisateur est en chinois, mais Google Traduction fonctionne bien). Une fois connecté, sélectionnez le modèle Kimi-K2 dans le menu déroulant.

Caractéristiques principales :

- Utilisation illimitée — pas de limites de jetons ou de temps.

- Accès direct aux capacités de raisonnement et de recherche de Kimi K2.

- Aucune installation ni exigence matérielle.

Comment démarrer :

- Visitez kimi.com.

- Connectez-vous ou créez un compte.

- Utilisez Google Traduction si nécessaire.

- Sélectionnez "Kimi-K2" dans le menu déroulant du modèle.

- Commencez à discuter et à explorer les capacités du modèle.

Limitations :

L'interface web est plus un outil de recherche basé sur l'IA qu'un chatbot complet, mais elle est parfaite pour des tests rapides et un accès gratuit illimité.

Méthode 2 : Essayer Kimi K2 gratuitement sur Hugging Face Spaces

Si vous souhaitez interagir avec Kimi K2 dans un environnement plus flexible, Hugging Face Spaces propose une démo gratuite.

- Visitez le Kimi K2 Instruct Space.

- Connectez-vous avec votre compte Hugging Face.

- Saisissez vos invites et voyez comment Kimi K2 répond.

Avantages :

- Aucune installation requise.

- Idéal pour tester des invites et voir comment Kimi K2 gère diverses tâches.

- Piloté par la communauté — souvent mis à jour avec les dernières versions du modèle.

Remarque :

Les performances peuvent être plus lentes que l'interface utilisateur officielle, car le modèle s'exécute sur des ressources backend partagées.

Méthode 3 : Exécuter Kimi K2 localement avec des poids open-source

Pour les développeurs et les chercheurs qui souhaitent un contrôle total, les poids de Kimi K2 sont open-source et disponibles en téléchargement.

- Obtenez les poids depuis Hugging Face.

- Déployez sur votre propre matériel en utilisant des moteurs d'inférence comme vLLM, SGLang, KTransformers ou TensorRT-LLM.

- Affinez ou personnalisez le modèle pour vos besoins spécifiques.

Avantages :

- Flexibilité et confidentialité maximales.

- Idéal pour les solutions personnalisées, la recherche et l'utilisation en entreprise.

- Aucune limite d'utilisation — exécutez autant d'inférences que votre matériel le permet.

Mises en garde :

- Nécessite des ressources de calcul importantes (plusieurs GPU ou un cluster puissant).

- La configuration et la maintenance sont plus complexes que l'utilisation d'un service hébergé.

Méthode 4 : Utiliser Kimi K2 gratuitement via l'API OpenRouter

Si vous souhaitez intégrer Kimi K2 dans vos propres applications ou outils, OpenRouter fournit un point d'accès API gratuit pour Kimi K2.

- Visitez la page Kimi K2 d'OpenRouter.

- Inscrivez-vous pour un compte et obtenez votre clé API.

- Utilisez l'API dans votre code, vos chatbots ou vos flux de travail d'automatisation.

Exemple d'utilisation en Python :

from openai import OpenAI

client = OpenAI(

base_url="https://openrouter.ai/api/v1",

api_key="<OPENROUTER_API_KEY>",

)

completion = client.chat.completions.create(

extra_headers={

"HTTP-Referer": "<YOUR_SITE_URL>", # Optional. Site URL for rankings on openrouter.ai.

"X-Title": "<YOUR_SITE_NAME>", # Optional. Site title for rankings on openrouter.ai.

},

extra_body={},

model="moonshotai/kimi-k2:free",

messages=[

{

"role": "user",

"content": "What is the meaning of life?"

}

]

)

print(completion.choices[0].message.content)Pourquoi utiliser l'API ?

- Intégrez Kimi K2 dans votre IDE, votre chatbot ou votre pipeline d'automatisation.

- Aucun coût pour les jetons d'entrée/sortie sur le niveau gratuit.

- Prend en charge un large éventail d'applications, des agents de codage à l'analyse de données.

Bonus : Connectez Kimi K2 à vos spécifications d'API avec Apidog MCP Server

Bien que Kimi K2 soit puissant en soi, vous pouvez en tirer encore plus de valeur en le connectant à vos spécifications d'API à l'aide d'Apidog MCP Server.

Qu'est-ce qu'Apidog MCP Server ?

Apidog MCP Server vous permet d'utiliser votre spécification d'API comme source de données pour les IDE et les outils basés sur l'IA. Cela signifie que vous pouvez :

- Générer ou modifier du code basé sur votre spécification d'API.

- Rechercher et analyser votre documentation d'API avec l'IA.

- Automatiser les mises à jour de code, la génération de DTO et les tâches de documentation.

Comment configurer Apidog MCP Server avec Kimi K2

Prérequis :

Avant de commencer, assurez-vous de ce qui suit :

✅ Node.js est installé (version 18+ ; la dernière LTS est recommandée)

✅ Vous utilisez un IDE qui prend en charge MCP, tel que : Cursor

Étape 1 : Préparez votre fichier OpenAPI

Vous aurez besoin d'accéder à votre définition d'API :

- Une URL (par exemple,

https://petstore.swagger.io/v2/swagger.json) - Ou un chemin de fichier local (par exemple,

~/projects/api-docs/openapi.yaml) - Formats pris en charge :

.jsonou.yaml(OpenAPI 3.x recommandé)

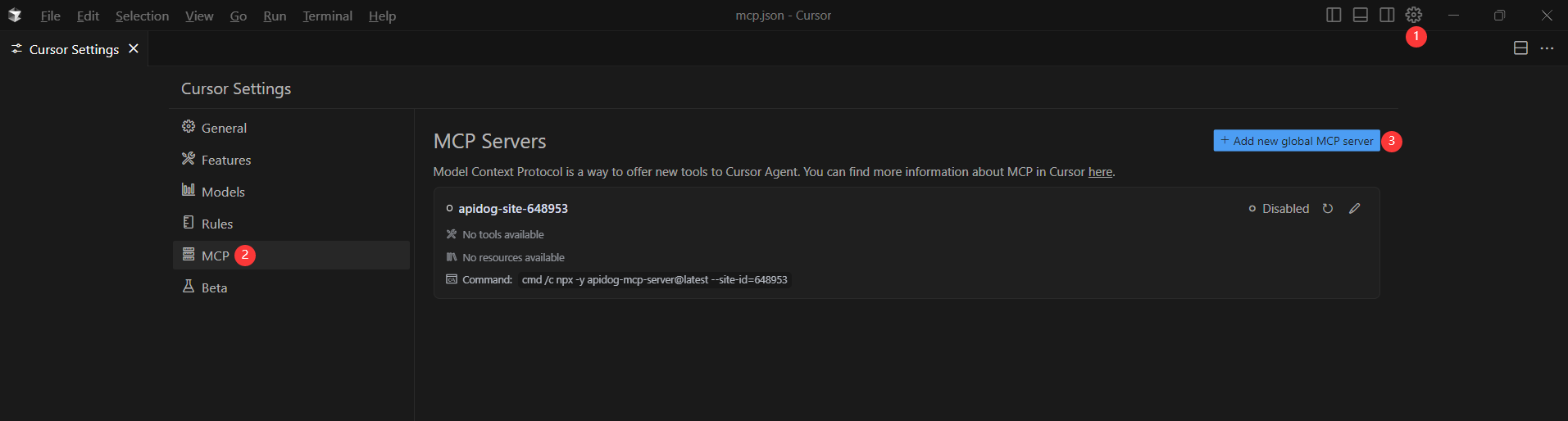

Étape 2 : Ajoutez la configuration MCP à Cursor

Vous allez maintenant ajouter la configuration au fichier mcp.json de Cursor.

N'oubliez pas de remplacer <oas-url-or-path> par votre URL OpenAPI réelle ou votre chemin local.

- Pour MacOS/Linux :

{

"mcpServers": {

"API specification": {

"command": "npx",

"args": [

"-y",

"apidog-mcp-server@latest",

"--oas=https://petstore.swagger.io/v2/swagger.json"

]

}

}

}Pour Windows :

{

"mcpServers": {

"API specification": {

"command": "cmd",

"args": [

"/c",

"npx",

"-y",

"apidog-mcp-server@latest",

"--oas=https://petstore.swagger.io/v2/swagger.json"

]

}

}

}Étape 3 : Vérifiez la connexion

Après avoir enregistré la configuration, testez-la dans l'IDE en demandant à Kimi K2 (ou à tout agent IA) de :

Veuillez récupérer la documentation de l'API via MCP et me dire combien de points d'accès existent dans le projet.Si cela fonctionne, vous verrez une réponse structurée qui liste les points d'accès et leurs détails. Si ce n'est pas le cas, vérifiez le chemin d'accès à votre fichier OpenAPI et assurez-vous que Node.js est correctement installé.

Exemples de cas d'utilisation :

- « Utilisez MCP pour récupérer la spécification d'API et générer des enregistrements Java pour le schéma 'Produit'. »

- « Basé sur la spécification d'API, ajoutez de nouveaux champs au DTO 'Utilisateur'. »

- « Ajoutez des commentaires pour chaque champ de la classe 'Commande' en fonction de la documentation de l'API. »

Pourquoi Apidog MCP Server ?

- Intégration transparente entre vos documents API et vos outils IA.

- Automatisez les tâches répétitives de codage et de documentation.

- Gardez votre API et votre base de code synchronisées — plus de mises à jour manuelles.

Conclusion : Libérez la puissance de Kimi K2 gratuit et d'Apidog MCP Server

Dans le paysage en rapide évolution de l'IA, Kimi K2 change la donne — ouvert, puissant et accessible à tous. Que vous souhaitiez discuter, tester, exécuter localement ou intégrer via API, il existe une méthode gratuite qui correspond à vos besoins.

Mais ne vous arrêtez pas là. En connectant Kimi K2 à vos spécifications d'API avec Apidog MCP Server, vous pouvez automatiser la génération de code, rationaliser la documentation et dynamiser votre flux de travail de développement. Apidog est la plateforme de développement API tout-en-un qui réunit vos mondes IA et API.

Conseil de pro : Apidog MCP Server

Prêt à commencer ?

- Essayez Kimi K2 gratuitement en utilisant l'une des méthodes ci-dessus.

- Configurez Apidog MCP Server et connectez vos documents API à vos outils IA préférés.

- Découvrez le niveau supérieur du développement API intelligent et automatisé.