L'essor des modèles de langage volumineux (LLM) open-source a rendu plus facile que jamais la création d'outils basés sur l'IA qui rivalisent avec les solutions propriétaires comme ChatGPT Operator d'OpenAI. Parmi ces modèles open-source, DeepSeek R1 se distingue par ses solides capacités de raisonnement, son accessibilité gratuite et son adaptabilité. En combinant DeepSeek R1 avec des outils comme Browser Use, vous pouvez créer une alternative puissante et entièrement open-source à ChatGPT Operator sans dépenser des centaines de dollars en abonnements premium.

Cet article vous guidera à travers le processus de configuration de DeepSeek R1 et Browser Use pour créer un agent d'IA capable d'effectuer des tâches complexes, notamment l'automatisation web, le raisonnement et les interactions en langage naturel.

Que vous soyez débutant ou développeur expérimenté, ce guide étape par étape vous aidera à démarrer.

Qu'est-ce que ChatGPT Operator et pourquoi avez-vous besoin d'une alternative open source ?

ChatGPT Operator est une fonctionnalité premium proposée par OpenAI qui permet aux utilisateurs de créer des agents d'IA avancés capables d'effectuer des tâches complexes telles que le raisonnement, l'automatisation web et la résolution de problèmes en plusieurs étapes.

ChatGPT Operator coûte 200 $ par mois, ce qui le rend moins accessible aux particuliers, aux petites entreprises ou aux organisations disposant de budgets limités.

4. Booking a one-way flight from Zurich to Vienna using the Booking integration

— Rowan Cheung (@rowancheung) January 23, 2025

This one required a bit of back and forth, with ChatGPT Operator pinging me and asking for my flight preference and having me take control of entering payment details pic.twitter.com/XZiqUsQgVh

ChatGPT Operator réservait un billet d'avion dans la vidéo ci-dessus

Pourquoi avez-vous besoin d'une alternative open source

Bien que ChatGPT Operator soit puissant, il présente plusieurs limites qui rendent une alternative open source attrayante :

- Coût : Les frais d'abonnement de 200 $ par mois peuvent être prohibitifs pour de nombreux utilisateurs.

- Confidentialité des données : L'utilisation d'API propriétaires nécessite l'envoi de données à des serveurs externes, ce qui peut ne pas être conforme aux politiques de confidentialité ou aux exigences réglementaires.

- Personnalisation limitée : Les solutions propriétaires restreignent souvent le réglage fin ou les optimisations spécifiques aux tâches, limitant leur adaptabilité pour des cas d'utilisation spécialisés.

En optant pour des outils open-source comme DeepSeek R1 et Browser Use, vous pouvez surmonter ces défis et débloquer plusieurs avantages :

- Économies de coûts : DeepSeek R1 et Browser Use sont entièrement gratuits et open source, ce qui élimine les frais d'abonnement.

- Contrôle total : L'hébergement des outils localement ou sur votre propre serveur garantit une confidentialité et une sécurité complètes des données.

- Personnalisation : Vous pouvez affiner le modèle pour des tâches spécifiques, l'intégrer à d'autres outils et modifier le système pour répondre à vos besoins uniques.

Une approche open source réduit non seulement la dépendance aux plateformes propriétaires, mais vous permet également de créer une solution adaptée à vos besoins tout en conservant le contrôle des coûts et des données.

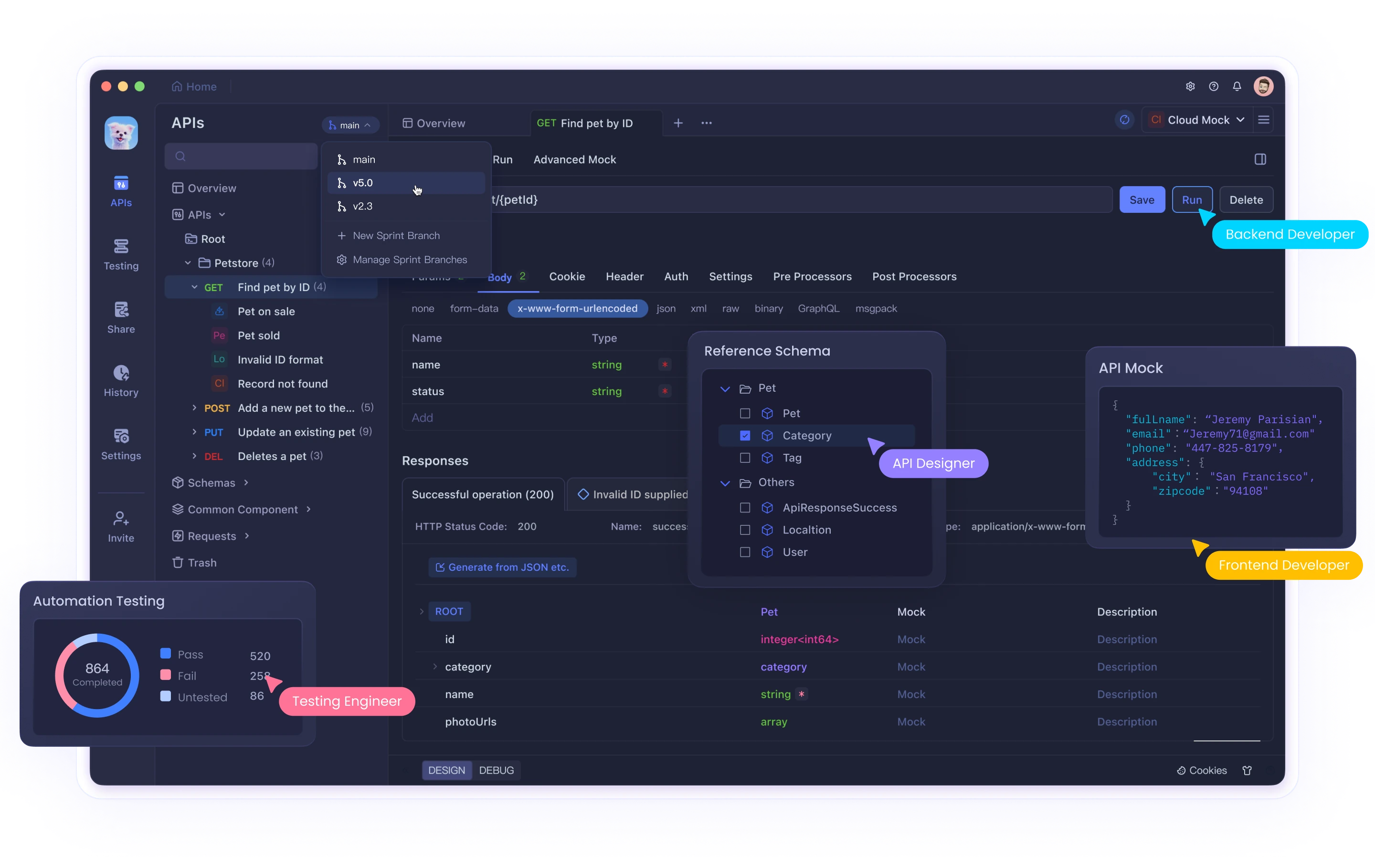

Vous devez jeter un coup d'œil à Apidog, l'outil de test d'API tout-en-un qui vous guide tout au long du cycle, de la conception de l'API à la documentation de l'API, et qui dynamise la productivité de votre équipe de développement !

Composants clés : DeepSeek R1 et Browser Use

DeepSeek R1

DeepSeek R1 est un LLM open-source optimisé pour les tâches de raisonnement. Il excelle dans la résolution de problèmes par la pensée en chaîne, l'aide au codage et la compréhension du langage naturel. Il est disponible en plusieurs tailles (par exemple, 1,5 milliard, 7 milliards de paramètres), ce qui le rend adaptable à différentes capacités matérielles.

Browser Use

Browser Use est un outil open-source qui permet aux agents d'IA d'effectuer des tâches basées sur un navigateur, telles que l'exploration web, le remplissage de formulaires et la navigation automatisée. Il fournit une interface conviviale et peut être intégré à des LLM comme DeepSeek R1 pour une fonctionnalité améliorée.

Étape 1 : Configuration de votre environnement

Configuration matérielle requise

- Pour les petites versions de DeepSeek R1 (par exemple, 1,5 milliard de paramètres), un processeur ou un GPU de milieu de gamme (8 Go de VRAM) est suffisant.

- Les versions plus volumineuses nécessitent des GPU haut de gamme (par exemple, NVIDIA A100 ou RTX 4090).

Système d'exploitation

- Linux ou macOS est recommandé pour faciliter la configuration. Les utilisateurs de Windows peuvent utiliser WSL (Windows Subsystem for Linux).

Environnement Python

Créez un environnement virtuel Python pour isoler les dépendances :

python -m venv venv

source venv/bin/activate # Sur Linux/macOS

# Sur Windows:

# venv\Scripts\activate

Installez les bibliothèques requises :

pip install torch torchvision transformers sentencepiece

Étape 2 : Exécuter DeepSeek avec l'API ou localement avec Ollama

Utilisation de l'API DeepSeek

Pour interagir avec l'API DeepSeek, suivez ces étapes mises à jour :

Obtenir une clé API :

- Inscrivez-vous sur la plateforme DeepSeek et générez une clé API à partir de la section « Clés API ». Enregistrez cette clé en toute sécurité, car elle ne sera plus affichée.

Effectuer votre premier appel d'API :

L'API DeepSeek est compatible avec le format d'API d'OpenAI, ce qui facilite l'intégration avec les SDK ou logiciels OpenAI existants. Voici un exemple d'implémentation Python :

from openai import OpenAI

client = OpenAI(api_key="<Your_DeepSeek_API_Key>", base_url="https://api.deepseek.com")

response = client.chat.completions.create(

model="deepseek-reasoner", # Utilisez 'deepseek-reasoner' pour DeepSeek-R1

messages=[

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Explain quantum entanglement."}

],

stream=False # Définir sur True si vous souhaitez des réponses en streaming

)

print(response.choices[0].message.content)

Exemple cURL :

Si vous préférez utiliser cURL, voici comment vous pouvez faire une requête :

curl https://api.deepseek.com/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer <Your_DeepSeek_API_Key>" \

-d '{

"model": "deepseek-reasoner",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "What is the capital of France?"}

],

"stream": false

}'

Sélection du modèle :

- Spécifiez

model="deepseek-reasoner"pour DeepSeek-R1. - Utilisez

model="deepseek-chat"pour les tâches de discussion générales.

Le base_url peut également être défini sur https://api.deepseek.com/v1 pour les configurations compatibles avec OpenAI, bien que le chemin /v1 n'ait aucune relation avec les versions du modèle.

Exécution de DeepSeek localement avec Ollama

Ollama simplifie l'exécution de grands modèles de langage comme DeepSeek-R1 sur votre machine locale. Voici comment le configurer et l'utiliser correctement :

Installer Ollama :

- Téléchargez et installez Ollama à partir de son site Web officiel.

Extraire le modèle souhaité :

Utilisez les commandes suivantes pour télécharger des versions spécifiques de DeepSeek-R1 :

# Pour le modèle 7B (par défaut):

ollama pull deepseek-r1:7b

# Pour un modèle 1,5B plus petit :

ollama pull deepseek-r1:1.5b

# Pour les modèles plus volumineux comme 70B :

ollama pull deepseek-r1:70b

Exécuter le modèle localement :

Une fois téléchargé, exécutez le modèle en utilisant :

ollama run deepseek-r1:7b

Cela démarrera une session interactive où vous pourrez interagir directement avec le modèle.

Variantes de modèles :

DeepSeek propose plusieurs versions distillées basées sur les architectures Qwen et Llama, optimisées pour différents cas d'utilisation :

DeepSeek-R1-Distill-Qwen-7B :

ollama run deepseek-r1:7b-qwen-distill

DeepSeek-R1-Distill-Llama-70B :

ollama run deepseek-r1:70b-llama-distill

Considérations matérielles :

- Les modèles plus petits comme 1,5B ou 7B peuvent s'exécuter sur des GPU grand public ou même des processeurs.

- Les modèles plus volumineux (par exemple, 70B) nécessitent des GPU haut de gamme avec une VRAM importante (par exemple, NVIDIA A100 ou RTX 4090).

Discussion interactive via l'API :

Ollama fournit une API pour intégrer des modèles exécutés localement dans vos applications :

curl http://localhost:11434/api/chat -d '{

"model": "deepseek-r1:7b",

"messages": [

{"role": "user", "content": "Write a short poem about the stars."}

]

}'

Étape 3 : Installation de Browser Use

Browser Use permet à votre agent d'IA d'interagir avec les navigateurs web. Suivez ces étapes :

Installation

Clonez le référentiel Browser Use à partir de GitHub :

git clone https://github.com/browser-use/browser-use.git

cd browser-use

pip install -r requirements.txt

Configuration

Configurez l'interface utilisateur web de Browser Use :

python webui.py

Ouvrez l'interface utilisateur web dans votre navigateur pour configurer les paramètres de l'agent. Vous pouvez spécifier :

- Le modèle LLM (par exemple, DeepSeek R1)

- Paramètres du navigateur (par exemple, taille de la fenêtre)

Étape 4 : Combinaison de DeepSeek R1 et Browser Use

Pour créer un agent d'IA fonctionnel qui intègre les deux outils :

Configuration de l'agent

Modifiez les paramètres de l'agent dans Browser Use pour le connecter à DeepSeek R1 :

{

"model": "deepseek-r1",

"base_url": "http://localhost:5000",

"browser_settings": {

"window_height": 1080,

"window_width": 1920,

"keep_browser_open": true

}

}

Exécution de l'agent

Démarrez DeepSeek R1 et Browser Use :

# Démarrer le serveur API DeepSeek R1

python -m deepseek.api_server

# Démarrer l'interface utilisateur web de Browser Use

python webui.py

Une fois les deux services en cours d'exécution, l'agent peut effectuer des tâches telles que le remplissage de formulaires, l'exploration de données ou la navigation autonome sur des sites web.

Étape 5 : Ingénierie des invites pour de meilleurs résultats

Pour optimiser les performances de votre agent d'IA, utilisez des techniques d'ingénierie des invites. Par exemple :

Modèle d'invite général

<instructions>

Vous êtes un assistant d'IA chargé d'automatiser les tâches web à l'aide de Browser Use.

Suivez ces étapes :

1. Accédez à [site web].

2. Effectuez [tâche spécifique].

3. Renvoyez les résultats dans un format structuré.

</instructions>

<example>

Accédez à https://example.com et extrayez tous les hyperliens.

</example>

Cette structure garantit la clarté et améliore la précision de l'exécution des tâches.

Voici quelques démos que vous pouvez essayer en exécutant :

uv pip install gradio

python examples/gradio_demo.py

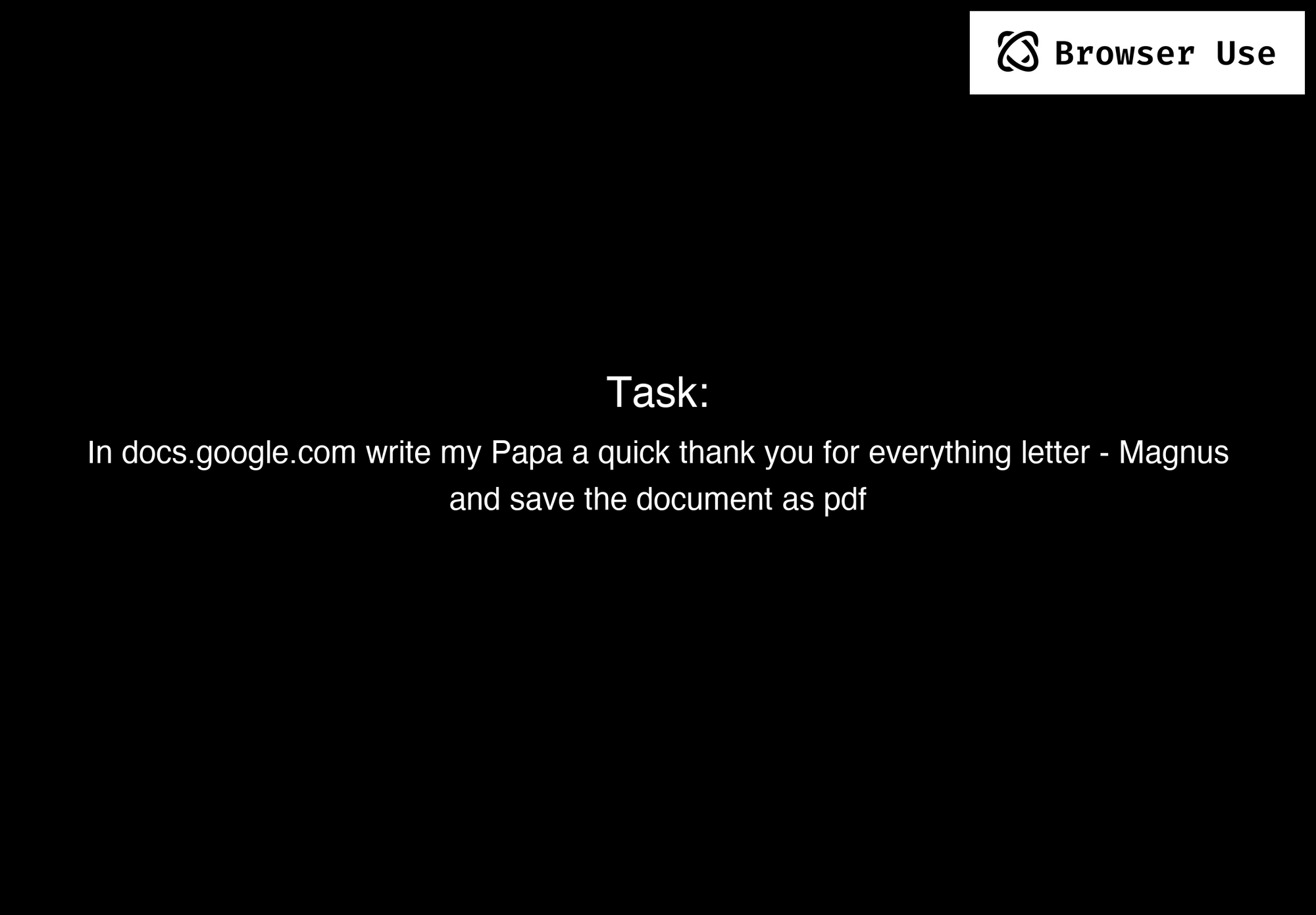

Exemple 1.

Invite : Écrivez une lettre dans Google Docs à mon Papa, en le remerciant pour tout, et enregistrez le document au format PDF.

Exemple 2.

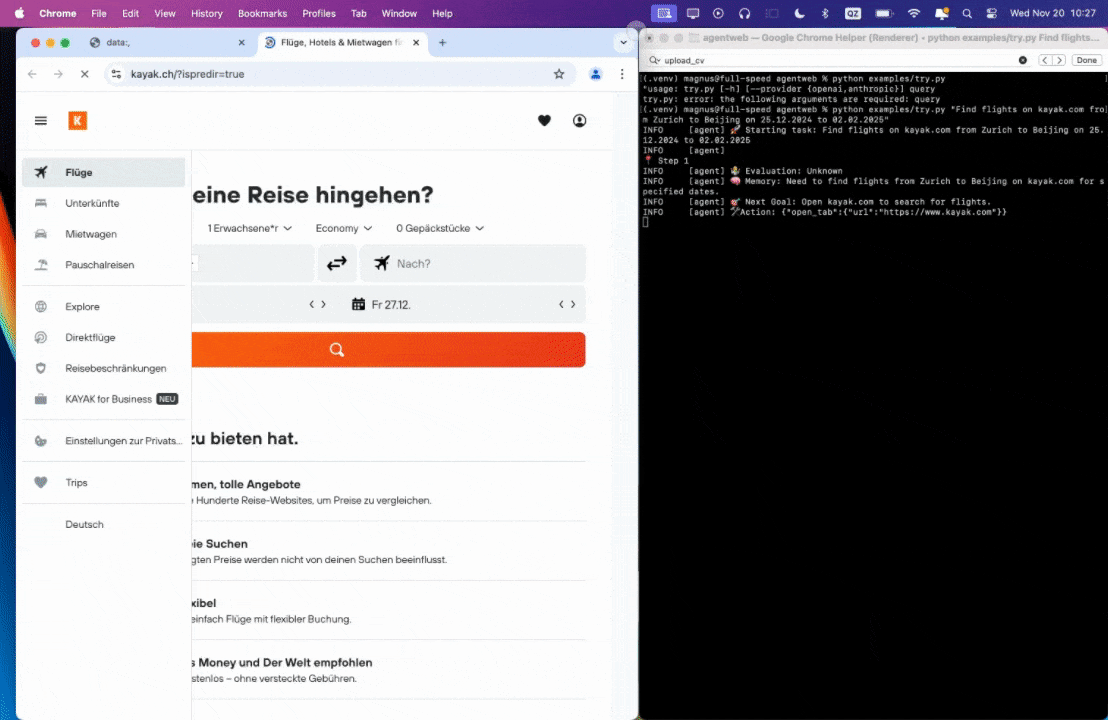

Invite : Trouvez des vols sur kayak.com de Zurich à Pékin du 25.12.2024 au 02.02.2025.

Exemple 3.

Invite : Lisez mon CV et trouvez des emplois en ML, enregistrez-les dans un fichier, puis commencez à postuler pour ceux-ci dans de nouveaux onglets, si vous avez besoin d'aide, demandez-moi »

0:00/1×

Conclusion

En combinant DeepSeek R1 avec Browser Use, vous pouvez créer une alternative ChatGPT Operator entièrement fonctionnelle, gratuite, open source et hautement personnalisable. Cette configuration permet non seulement de réduire les coûts, mais vous donne également un contrôle total sur la confidentialité des données et le comportement du système.

Que vous automatisiez des tâches web, construisiez des agents conversationnels ou expérimentiez des fonctionnalités d'IA avancées comme la génération augmentée par récupération, ce guide fournit tout ce dont vous avez besoin pour commencer. Adoptez la puissance de l'open source et créez votre propre assistant intelligent dès aujourd'hui !

Vous devez jeter un coup d'œil à Apidog, l'outil de test d'API tout-en-un qui vous guide tout au long du cycle, de la conception de l'API à la documentation de l'API, et qui dynamise la productivité de votre équipe de développement !