```html

Récemment, l’IA puissante de Meta, Llama 3.2 , a été lancée en tant que modèle de langage révolutionnaire, offrant des capacités impressionnantes pour le traitement du texte et des images. Pour les développeurs et les passionnés d'IA désireux d'exploiter la puissance de ce modèle avancé sur leurs machines locales, des outils comme LM Studio se démarquent. Ce guide complet vous guidera tout au long du processus d'exécution de Llama 3.2 localement à l'aide de ces plateformes puissantes, vous permettant de tirer parti de la technologie d'IA de pointe sans dépendre des services cloud.

Quoi de neuf avec Llama 3.2 : Le dernier cri en matière d'innovation en IA

Avant de plonger dans le processus d'installation, explorons brièvement ce qui rend Llama 3.2 spécial :

- Capacités multimodales : Llama 3.2 peut traiter à la fois du texte et des images, ouvrant de nouvelles possibilités pour les applications d'IA.

- Efficacité améliorée : Conçu pour de meilleures performances avec une latence réduite, ce qui le rend idéal pour le déploiement local.

- Différentes tailles de modèles : Disponible en plusieurs tailles, des modèles légers 1B et 3B adaptés aux appareils périphériques aux versions puissantes 11B et 90B pour les tâches plus complexes.

- Contexte étendu : Prend en charge une longueur de contexte de 128 K, ce qui permet une compréhension et une génération de contenu plus complètes.

Exécuter Llama 3.2 avec LM Studio localement

LM Studio offre une approche plus conviviale avec une interface graphique. Voici comment exécuter Llama 3.2 localement à l'aide de LM Studio :

Étape 1 : Télécharger et installer LM Studio

- Visitez le site Web de LM Studio.

- Téléchargez la version compatible avec votre système d'exploitation.

- Suivez les instructions d'installation fournies.

Étape 2 : Lancer LM Studio

Une fois installé, ouvrez LM Studio. Vous serez accueilli par une interface intuitive.

Étape 3 : Rechercher et télécharger Llama 3.2

- Utilisez la fonction de recherche dans LM Studio pour trouver Llama 3.2.

- Sélectionnez la version appropriée de Llama 3.2 pour vos besoins (par exemple, 3B pour les applications légères ou 11B pour les tâches plus complexes).

- Cliquez sur le bouton de téléchargement pour démarrer le processus de téléchargement.

Étape 4 : Configurer le modèle

Après le téléchargement, vous pouvez configurer divers paramètres :

- Ajustez la longueur du contexte si nécessaire (Llama 3.2 prend en charge jusqu'à 128 K).

- Définissez les valeurs de température et d'échantillonnage top-p pour contrôler le caractère aléatoire de la sortie.

- Expérimentez avec d'autres paramètres pour affiner le comportement du modèle.

Étape 5 : Commencer à interagir avec Llama 3.2

Avec le modèle configuré, vous pouvez maintenant :

- Utiliser l'interface de chat pour avoir des conversations avec Llama 3.2.

- Essayez différentes invites pour explorer les capacités du modèle.

- Utilisez la fonctionnalité Playground pour expérimenter des invites et des paramètres plus avancés.

Étape 6 : Configurer un serveur local (facultatif)

Pour les développeurs, LM Studio vous permet de configurer un serveur local :

- Accédez à l'onglet Serveur dans LM Studio.

- Configurez les paramètres du serveur (port, points de terminaison de l'API, etc.).

- Démarrez le serveur pour utiliser Llama 3.2 via des appels d'API dans vos applications.

Meilleures pratiques pour exécuter Llama 3.2 localement

Pour tirer le meilleur parti de votre configuration locale de Llama 3.2, tenez compte de ces bonnes pratiques :

- Considérations matérielles : Assurez-vous que votre machine répond aux exigences minimales. Un GPU dédié peut améliorer considérablement les performances, en particulier pour les modèles de plus grande taille.

- Ingénierie des invites : Créez des invites claires et spécifiques pour obtenir les meilleurs résultats de Llama 3.2. Expérimentez avec différentes formulations pour optimiser la qualité de la sortie.

- Mises à jour régulières : Gardez à jour à la fois l'outil que vous avez choisi (LM Studio) et le modèle Llama 3.2 pour obtenir les meilleures performances et les dernières fonctionnalités.

- Expérimenter avec les paramètres : N'hésitez pas à ajuster les paramètres pour trouver le bon équilibre pour votre cas d'utilisation. Des valeurs plus faibles produisent généralement des sorties plus ciblées et déterministes, tandis que des valeurs plus élevées introduisent plus de créativité et de variabilité.

- Utilisation éthique : Utilisez toujours les modèles d'IA de manière responsable et soyez conscient des biais potentiels dans les sorties. Envisagez de mettre en œuvre des mesures de protection ou des filtres supplémentaires si vous effectuez un déploiement dans des environnements de production.

- Confidentialité des données : L'exécution de Llama 3.2 localement améliore la confidentialité des données. Soyez attentif aux données que vous saisissez et à la façon dont vous utilisez les sorties du modèle, en particulier lors du traitement d'informations sensibles.

- Gestion des ressources : Surveillez les ressources de votre système lors de l'exécution de Llama 3.2, en particulier pendant de longues périodes ou avec des modèles de plus grande taille. Envisagez d'utiliser des gestionnaires de tâches ou des outils de surveillance des ressources pour garantir des performances optimales.

Dépanner les problèmes courants

Lors de l'exécution de Llama 3.2 localement, vous pourriez rencontrer des difficultés. Voici des solutions aux problèmes courants :

- Performances lentes :

- Assurez-vous d'avoir suffisamment de RAM et de puissance CPU/GPU.

- Essayez d'utiliser une taille de modèle plus petite si disponible (par exemple, 3B au lieu de 11B).

- Fermez les applications d'arrière-plan inutiles pour libérer des ressources système.

2. Erreurs de mémoire insuffisante :

- Réduisez la longueur du contexte dans les paramètres du modèle.

- Utilisez une variante de modèle plus petite si disponible.

- Mettez à niveau la RAM de votre système si possible.

3. Problèmes d'installation :

- Vérifiez si votre système répond aux exigences minimales pour LM Studio.

- Assurez-vous d'avoir la dernière version de l'outil que vous utilisez.

- Essayez d'exécuter l'installation avec des privilèges d'administrateur.

4. Échecs de téléchargement du modèle :

- Vérifiez la stabilité de votre connexion Internet.

- Désactivez temporairement les pare-feu ou les VPN qui pourraient interférer avec le téléchargement.

- Essayez de télécharger pendant les heures creuses pour une meilleure bande passante.

5. Sorties inattendues :

- Examinez et affinez vos invites pour plus de clarté et de spécificité.

- Ajustez la température et d'autres paramètres pour contrôler le caractère aléatoire de la sortie.

- Assurez-vous d'utiliser la bonne version et configuration du modèle.

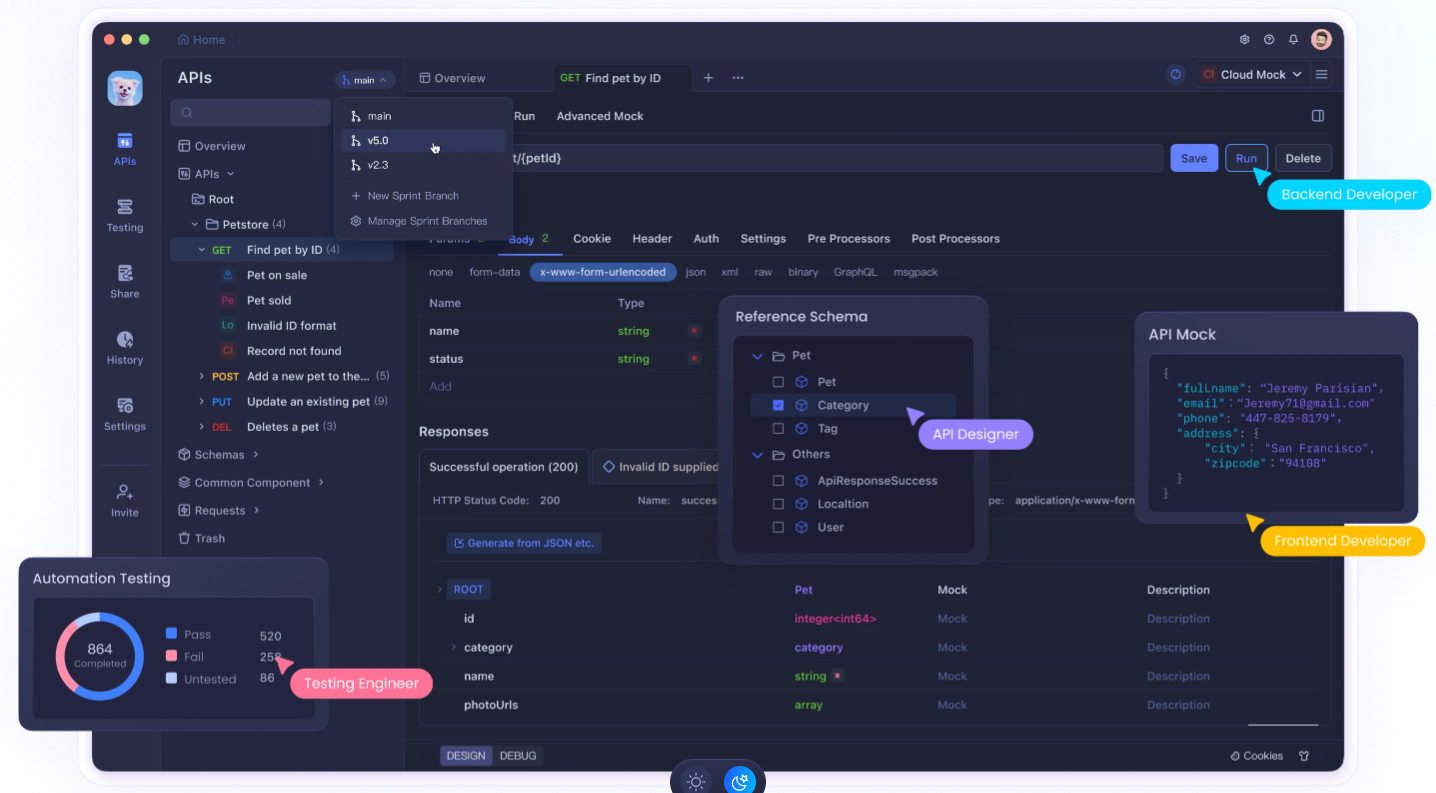

Utiliser Apidog pour améliorer votre développement d'API

L'exécution de Llama 3.2 localement est puissante, son intégration dans vos applications nécessite souvent un développement et des tests d'API robustes. C'est là qu' Apidog entre en jeu. Apidog est une plateforme de développement d'API complète qui peut améliorer considérablement votre flux de travail lorsque vous travaillez avec des LLM locaux comme Llama 3.2.

Principales fonctionnalités d'Apidog pour l'intégration de LLM locaux :

- Conception et documentation d'API : Concevez et documentez facilement les API pour vos intégrations Llama 3.2, en assurant une communication claire entre votre modèle local et d'autres parties de votre application.

- Tests automatisés : Créez et exécutez des tests automatisés pour vos points de terminaison d'API Llama 3.2, garantissant la fiabilité et la cohérence des réponses de votre modèle.

- Serveurs simulés : Utilisez la fonctionnalité de serveur simulé d'Apidog pour simuler les réponses de Llama 3.2 pendant le développement, vous permettant de progresser même lorsque vous n'avez pas un accès immédiat à votre configuration locale.

- Gestion de l'environnement : Gérez différents environnements (par exemple, Llama 3.2 local, API de production) dans Apidog, ce qui facilite le passage d'une configuration à l'autre pendant le développement et les tests.

- Outils de collaboration : Partagez vos conceptions d'API Llama 3.2 et les résultats des tests avec les membres de l'équipe, favorisant une meilleure collaboration dans les projets axés sur l'IA.

- Surveillance des performances : Surveillez les performances de vos points de terminaison d'API Llama 3.2, ce qui vous aide à optimiser les temps de réponse et l'utilisation des ressources.

- Tests de sécurité : Mettez en œuvre des tests de sécurité pour vos intégrations d'API Llama 3.2, en vous assurant que votre déploiement de modèle local n'introduit pas de vulnérabilités.

Premiers pas avec Apidog pour le développement de Llama 3.2 :

- Inscrivez-vous pour un compte Apidog.

- Créez un nouveau projet pour votre intégration d'API Llama 3.2.

- Concevez vos points de terminaison d'API qui interagiront avec votre instance Llama 3.2 locale.

- Configurez des environnements pour gérer différentes configurations (par exemple, les configurations de LM Studio).

- Créez des tests automatisés pour vous assurer que vos intégrations Llama 3.2 fonctionnent correctement.

- Utilisez la fonctionnalité de serveur simulé pour simuler les réponses de Llama 3.2 lors des premières étapes de développement.

- Collaborez avec votre équipe en partageant les conceptions d'API et les résultats des tests.

En tirant parti d'Apidog en plus de votre configuration locale de Llama 3.2, vous pouvez créer des applications plus robustes, bien documentées et minutieusement testées, basées sur l'IA.

Conclusion : Adopter la puissance de l'IA locale

L'exécution de Llama 3.2 localement représente une étape importante vers la démocratisation de la technologie de l'IA. Que vous choisissiez l'interface conviviale de LM Studio ou une autre, vous disposez désormais des outils nécessaires pour exploiter la puissance des modèles de langage avancés sur votre propre machine.

N'oubliez pas que le déploiement local de modèles de langage volumineux comme Llama 3.2 n'est qu'un début. Pour vraiment exceller dans le développement de l'IA, envisagez d'intégrer des outils comme Apidog dans votre flux de travail. Cette plateforme puissante peut vous aider à concevoir, tester et documenter les API qui interagissent avec votre instance Llama 3.2 locale, rationalisant ainsi votre processus de développement et garantissant la fiabilité de vos applications basées sur l'IA.

Alors que vous vous lancez dans votre voyage avec Llama 3.2, continuez à expérimenter, restez curieux et efforcez-vous toujours d'utiliser l'IA de manière responsable. L'avenir de l'IA n'est pas seulement dans le cloud – il est ici, sur votre machine locale, attendant d'être exploré et exploité pour des applications innovantes. Avec les bons outils et les bonnes pratiques, vous pouvez libérer tout le potentiel de l'IA locale et créer des solutions révolutionnaires qui repoussent les limites de ce qui est possible en matière de technologie.

```