OpenAI fait progresser les capacités de l'intelligence artificielle en introduisant gpt-realtime parallèlement à des améliorations significatives de l'API Realtime. Ce développement cible les développeurs qui créent des applications vocales interactives, offrant un traitement direct de la parole à la parole qui capture des nuances telles que le ton et les indices non-verbaux. Les ingénieurs ont désormais accès à un modèle qui traite les entrées audio et génère des réponses avec une faible latence, marquant un changement dans la manière dont l'IA gère les conversations en temps réel.

De plus, cette mise à jour s'aligne sur la demande croissante de systèmes d'IA multimodaux. Les développeurs intègrent l'audio, le texte et les images de manière transparente, élargissant les possibilités d'applications dans le service client, les assistants virtuels et le divertissement interactif. Alors que nous explorons ces avancées, considérez comment de petites améliorations dans la conception des API mènent à des améliorations substantielles de l'expérience utilisateur.

Comprendre GPT-Realtime : Le modèle central

OpenAI lance gpt-realtime comme un modèle spécialisé conçu pour les interactions de bout en bout de parole à parole. Ce modèle élimine les pipelines traditionnels qui séparent la reconnaissance vocale, le traitement du langage et la synthèse vocale. Au lieu de cela, il gère tout dans un cadre unifié, réduisant la latence et préservant les subtilités de la parole humaine.

gpt-realtime excelle dans la génération de sorties audio au son naturel. Par exemple, il répond à des instructions comme "parlez rapidement et professionnellement" ou "adoptez un ton empathique avec un accent français". Un tel contrôle précis permet aux développeurs d'adapter les voix de l'IA à des scénarios spécifiques, améliorant l'engagement dans les applications du monde réel.

De plus, le modèle démontre une intelligence supérieure dans le traitement des entrées audio natives. Il détecte les éléments non-verbaux, tels que les rires ou les pauses, et s'adapte en conséquence. Si un utilisateur change de langue en plein milieu d'une phrase, gpt-realtime fait de même sans interruption.

Cette capacité découle d'un entraînement avancé sur divers ensembles de données, lui permettant d'obtenir un score de 30,5 % sur le benchmark audio MultiChallenge — une amélioration notable par rapport aux itérations précédentes.

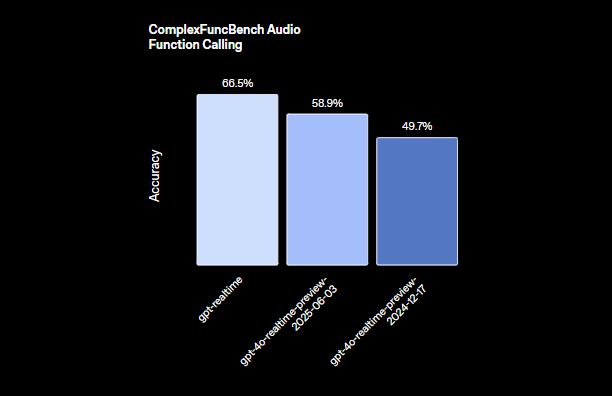

Les ingénieurs apprécient la façon dont gpt-realtime intègre l'appel de fonctions. Avec un score de 66,5 % sur le ComplexFuncBench, il exécute les outils de manière asynchrone, garantissant que les conversations restent fluides même pendant des calculs prolongés. Par exemple, pendant que l'IA traite une requête de base de données, elle continue d'engager l'utilisateur avec des réponses de remplissage ou des mises à jour.

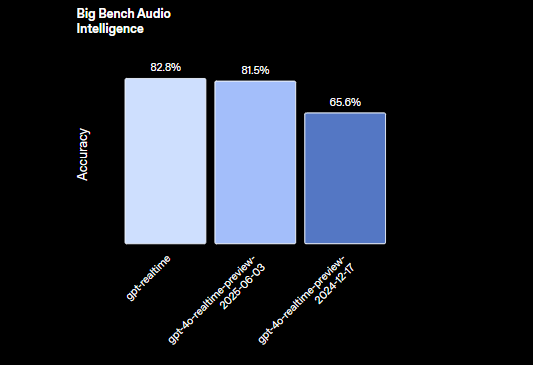

De plus, gpt-realtime prend en charge les tâches de raisonnement avec une précision de 82,8 % sur l'évaluation Big Bench Audio. Cela lui permet de gérer des requêtes complexes impliquant une déduction logique directement à partir d'entrées audio, en contournant entièrement la conversion de texte.

OpenAI introduit deux nouvelles voix, Marin et Cedar, exclusives à ce modèle, ainsi que des mises à jour de huit voix existantes pour des sorties plus expressives. Ces améliorations garantissent que les interactions de l'IA semblent plus humaines, comblant le fossé entre les réponses scriptées et le dialogue authentique.

En passant aux implications pratiques, les développeurs exploitent gpt-realtime pour créer des applications qui répondent en temps réel, telles que des services de traduction en direct ou des outils de narration interactive. L'efficacité du modèle minimise la surcharge computationnelle, le rendant adapté au déploiement sur des appareils périphériques ou des infrastructures cloud.

Fonctionnalités clés de l'API Realtime

L'API Realtime reçoit des mises à niveau substantielles, complétant les capacités de gpt-realtime. OpenAI l'équipe de fonctionnalités qui facilitent les agents vocaux prêts pour la production, en se concentrant sur la fiabilité, l'évolutivité et la facilité d'intégration.

Premièrement, le support de serveur MCP (Multi-Cloud Provider) distant se distingue. Les développeurs configurent des serveurs externes pour les appels d'outils, tels que l'intégration avec Stripe pour les paiements. Cette configuration simplifie les flux de travail en déchargeant des fonctions spécifiques vers des services spécialisés. Vous spécifiez l'URL du serveur, les jetons d'autorisation et les exigences d'approbation directement dans la session API.

Ensuite, la fonctionnalité d'entrée d'image étend la portée multimodale de l'API. Les applications ajoutent des images, des photos ou des captures d'écran aux sessions en cours, permettant des conversations visuellement fondées. Par exemple, un utilisateur télécharge un diagramme, et l'IA le décrit ou répond à des questions sur son contenu. Cette fonctionnalité traite les images comme des éléments statiques, contrôlés par la logique de l'application pour maintenir le contexte.

De plus, le support SIP (Session Initiation Protocol) connecte l'API aux réseaux téléphoniques publics, aux systèmes PBX et aux téléphones de bureau. Cela relie l'IA numérique à la téléphonie traditionnelle, permettant aux agents vocaux de gérer les appels depuis des lignes fixes ou des mobiles de manière transparente.

Les invites réutilisables représentent un autre ajout clé. Les développeurs sauvegardent et réutilisent les messages, les outils, les variables et les exemples de développeur sur plusieurs sessions. Cela favorise la cohérence et réduit le temps de configuration pour les interactions récurrentes, telles que les scripts de support client standard.

L'API optimise les interactions à faible latence, garantissant une haute fiabilité dans les environnements de production. Elle traite les entrées multimodales — audio et images — tout en maintenant l'état de la session, ce qui évite la perte de contexte dans les conversations prolongées.

En termes de gestion audio, l'API Realtime s'interface directement avec gpt-realtime pour générer une parole expressive. Elle capture des nuances que les systèmes traditionnels rejettent souvent, menant à des expériences utilisateur plus engageantes.

Les développeurs bénéficient également de fonctionnalités de niveau entreprise, y compris la Résidence des Données de l'UE pour la conformité et les engagements de confidentialité qui protègent les données sensibles.

En se concentrant sur les métriques de performance, ces mises à jour améliorent collectivement l'utilité de l'API. Par exemple, l'appel de fonctions asynchrone prévient les goulots d'étranglement, permettant à l'IA de faire plusieurs tâches sans interrompre le flux.

Comment utiliser l'API GPT-Realtime : Un guide étape par étape

Les développeurs intègrent l'API gpt-realtime via des points de terminaison et des configurations simples. Commencez par obtenir des clés API depuis la plateforme OpenAI, en vous assurant que votre compte prend en charge l'API Realtime.

Pour initier une session, envoyez une requête POST pour créer un secret client en temps réel. Incluez des paramètres de session comme les outils et les types. Pour l'intégration MCP distante, structurez la charge utile comme suit :

// Ce code configure un outil pour les paiements Stripe, où l'API achemine les appels vers le serveur spécifié sans nécessiter l'approbation de l'utilisateur à chaque fois.

{

"session": {

"type": "realtime",

"tools": [

{

"type": "mcp",

"server_label": "stripe",

"server_url": "https://mcp.stripe.com",

"authorization": "{access_token}",

"require_approval": "never"

}

]

}

}

Une fois la session démarrée, gérez les interactions en temps réel via des connexions WebSocket. Établissez une connexion WebSocket au point de terminaison de l'API Realtime, en envoyant des flux audio sous forme de données binaires. L'API traite les entrées et renvoie les sorties audio en temps réel.

Pour l'entrée audio, encodez la parole de l'utilisateur et transmettez-la. gpt-realtime analyse l'audio, générant des réponses basées sur le contexte de la session. Pour incorporer des images, utilisez l'événement de création d'élément de conversation :

{

"type": "conversation.item.create",

"previous_item_id": null,

"item": {

"type": "message",

"role": "user",

"content": [

{

"type": "input_image",

"image_url": "data:image/png;base64,{base64_image_data}"

}

]

}

}

Remplacez {base64_image_data} par l'image encodée en base64 réelle. Cela ajoute un contexte visuel, permettant à l'IA de s'y référer dans ses réponses.

Gérez l'état de la session en définissant des limites de jetons et en tronquant les tours plus anciens pour contrôler les coûts. Pour les conversations longues, effacez périodiquement l'historique inutile tout en conservant les détails clés.

Pour gérer les appels de fonctions, définissez des outils dans la configuration de la session. Lorsque l'IA invoque une fonction, l'API l'exécute de manière asynchrone, envoyant des mises à jour intermédiaires pour maintenir la conversation vivante.

Pour l'intégration SIP, configurez votre application pour acheminer les appels via des passerelles compatibles. Cela implique la configuration de jonctions SIP et leur liaison aux sessions de l'API Realtime.

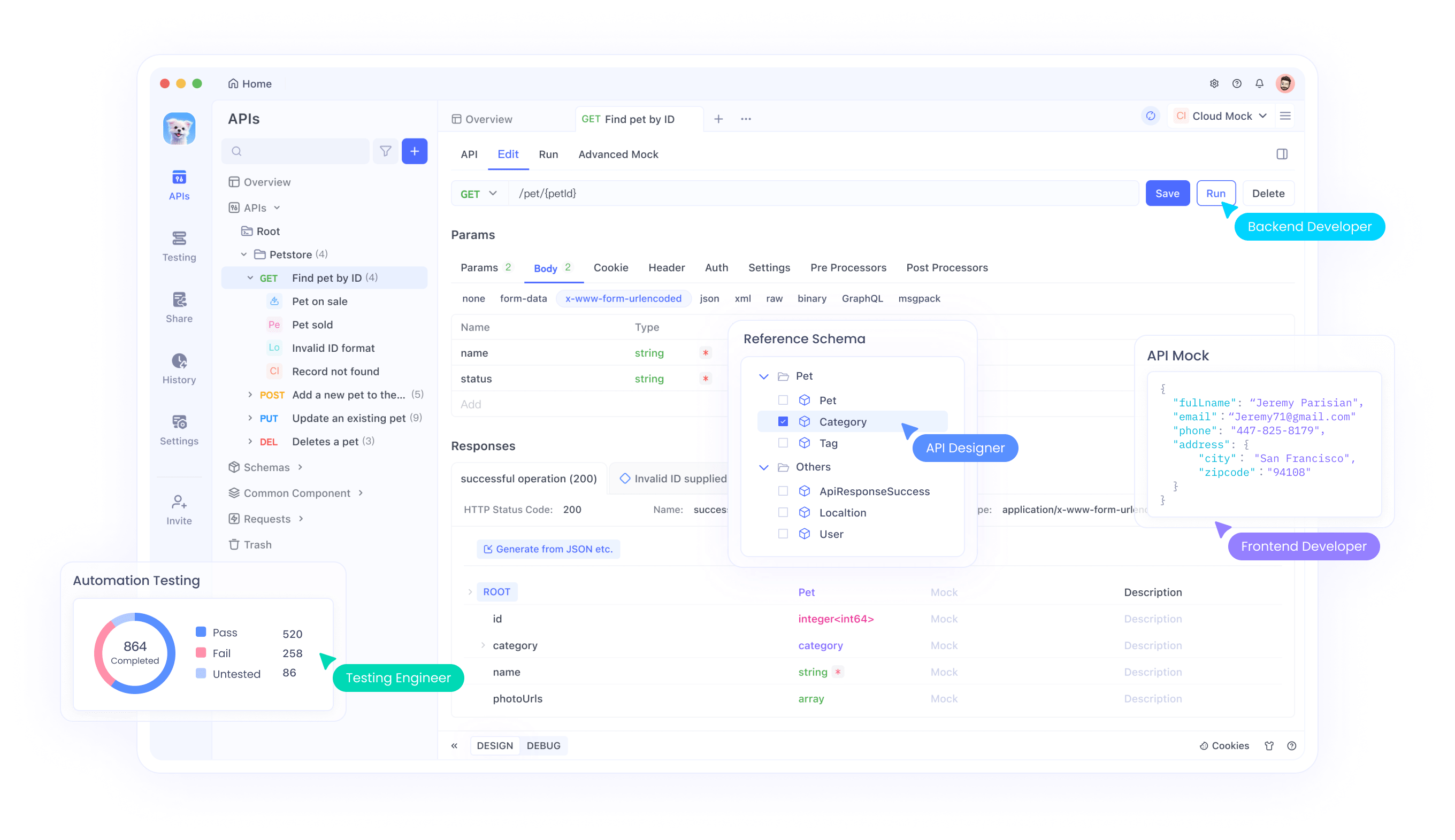

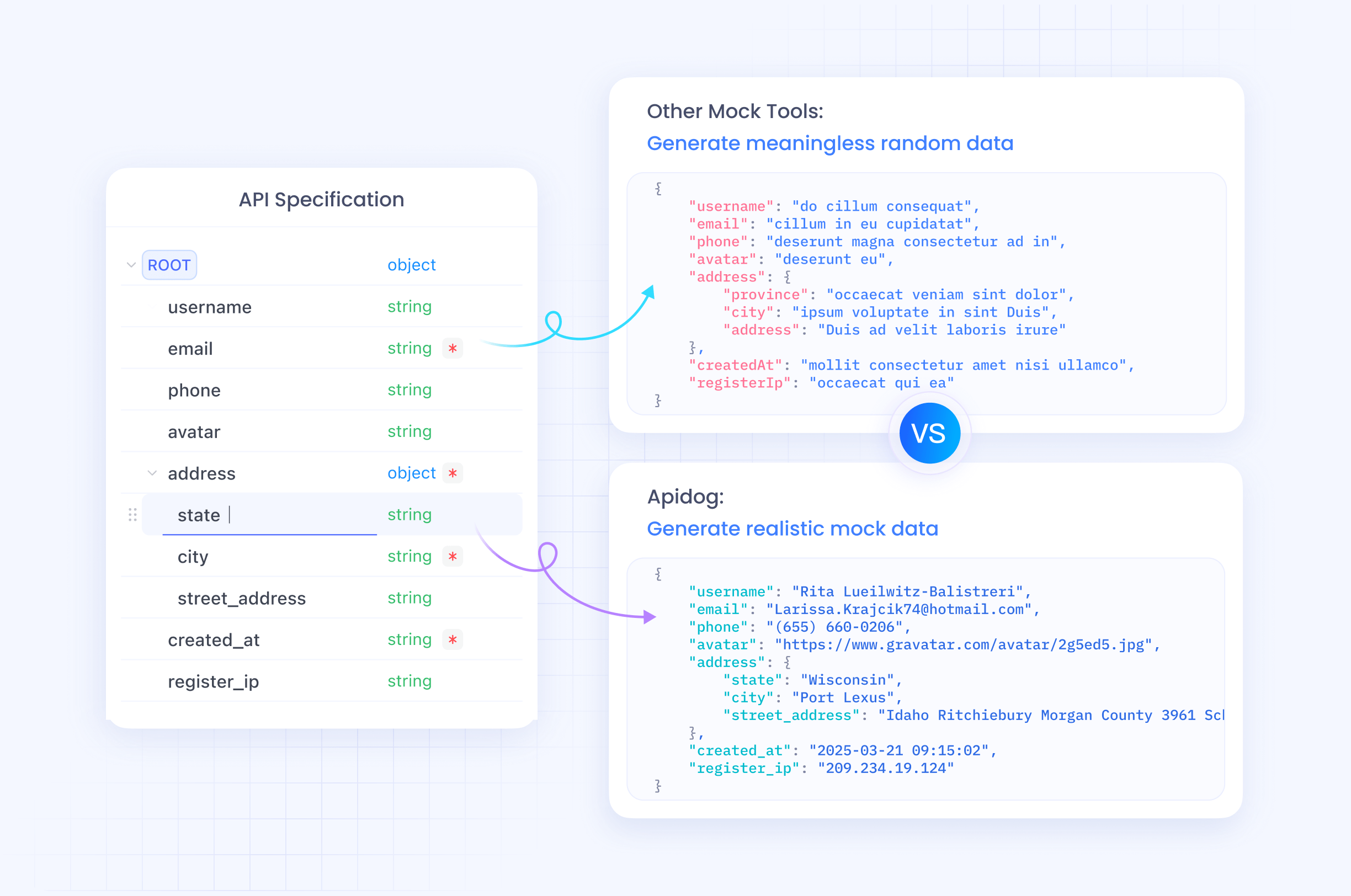

Tester ces intégrations s'avère crucial. Ici, Apidog brille en tant qu'outil de gestion d'API. Il prend en charge les tests WebSocket, vous permettant de simuler des échanges audio en temps réel et d'inspecter les réponses. Téléchargez Apidog gratuitement pour simuler des points de terminaison, valider les charges utiles et assurer une connectivité transparente avec gpt-realtime.

En pratique, construisez un agent vocal simple en combinant ces éléments. Capturez l'entrée du microphone, diffusez-la vers l'API et lisez l'audio généré. Des bibliothèques comme WebSocket en JavaScript ou le module websockets de Python facilitent cela.

Surveillez la latence en chronométrant les réponses aller-retour. Les optimisations d'OpenAI garantissent des délais inférieurs à la seconde dans la plupart des cas, mais les conditions du réseau influencent les performances.

Gérez les erreurs avec élégance, par exemple en réessayant les connexions échouées ou en revenant à des interactions textuelles si le traitement audio rencontre des problèmes.

Pour aller plus loin, intégrez des invites réutilisables. Stockez un modèle d'invite avec des instructions comme "Répondez toujours avec empathie" et appliquez-le aux nouvelles sessions via les paramètres de l'API.

Pour une utilisation avancée, combinez gpt-realtime avec d'autres modèles OpenAI. Acheminez le raisonnement complexe vers GPT-4o tout en utilisant gpt-realtime pour l'entrée/sortie audio, créant ainsi des systèmes hybrides.

Les considérations de sécurité incluent le chiffrement des données en transit et la gestion sécurisée des jetons d'accès. Les engagements de confidentialité d'OpenAI sont utiles, mais mettez en œuvre des mesures de protection supplémentaires pour les applications sensibles.

Intégrer Apidog pour une gestion efficace des API

Apidog s'impose comme un outil essentiel pour les développeurs travaillant avec l'API gpt-realtime. Cette plateforme offre des fonctionnalités complètes de test, de documentation et de collaboration d'API, adaptées aux intégrations complexes comme les WebSockets en temps réel.

Les ingénieurs utilisent Apidog pour concevoir visuellement des requêtes API, importer des spécifications OpenAPI et exécuter des tests automatisés. Pour l'API Realtime, simulez des flux audio et vérifiez les entrées multimodales sans écrire de code étendu.

De plus, les capacités de simulation d'Apidog permettent le prototypage avant l'implémentation complète. Créez des serveurs de simulation qui imitent les réponses de gpt-realtime, accélérant les cycles de développement.

L'outil prend en charge la collaboration d'équipe, le partage de cas de test et d'environnements. Cela s'avère inestimable pour les équipes distribuées qui construisent des agents vocaux.

Puisqu'Apidog gère l'encodage base64 pour les images et les données binaires pour l'audio, il simplifie le débogage. Suivez les cycles de requête/réponse en temps réel, identifiant les goulots d'étranglement tôt.

En passant au déploiement, utilisez la surveillance d'Apidog pour garantir la disponibilité et les performances de l'API après le lancement.

Tarification, disponibilité et implications futures

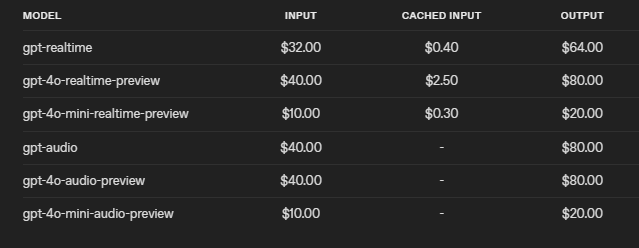

OpenAI tarife gpt-realtime de manière compétitive, réduisant les coûts de 20 % par rapport à la version d'aperçu. Facturez 32 $ par million de jetons d'entrée audio (0,40 $ pour les jetons mis en cache) et 64 $ par million de jetons de sortie. Cette structure encourage une utilisation efficace, avec des contrôles pour limiter le contexte et tronquer les sessions.

L'API sera disponible pour tous les développeurs le 28 août 2025, avec un accès mondial incluant les régions de l'UE.

À l'avenir, ces avancées ouvrent la voie à une IA vocale omniprésente. Des industries comme la santé l'adoptent pour les interactions avec les patients, tandis que l'éducation l'utilise pour le tutorat interactif.

Cependant, des défis subsistent, tels que garantir une utilisation éthique et atténuer les biais dans le traitement audio.

En résumé, gpt-realtime et l'API Realtime d'OpenAI redéfinissent l'IA en temps réel, offrant des outils que les développeurs exploitent pour des applications innovantes. De petits ajustements dans l'intégration génèrent des gains significatifs, soulignant une mise en œuvre précise.