Le 13 mai, un nouveau modèle ChatGPT appelé GPT-4o a été annoncé. Comparé aux modèles précédents, GPT-4o a un temps de réponse deux fois plus rapide que les modèles précédents et peut comprendre le texte, les images, l'audio et la vidéo. Dans cet article, nous fournirons une explication complète des informations de base sur le dernier modèle GPT-4o d'OpenAI et présenterons comment intégrer l'API GPT-4o dans vos propres services.

Apidog est également un outil entièrement gratuit, alors commencez par cliquer sur le bouton ci-dessous ! 👇👇👇

Qu'est-ce que GPT-4o ?

GPT-4o est le dernier modèle d'IA annoncé par OpenAI le 13 mai. Le "o" dans "4o" signifie "omni", c'est-à-dire "englobant tout". Contrairement aux interactions précédentes basées sur le texte et les images avec ChatGPT, GPT-4o vous permet d'interagir avec lui en utilisant une combinaison de texte, d'audio, d'images et de vidéo.

Pour plus de détails, visitez le site officiel : https://openai.com/index/hello-gpt-4o/

Principales caractéristiques de GPT-4o

Alors, quelles sont les fonctionnalités du dernier modèle d'OpenAI, GPT-4o, par rapport aux modèles précédents ?

Temps de réponse 2X plus rapide

Selon OpenAI, trois étapes sont nécessaires pour que GPT-4 ait une conversation avec des humains :

- Convertir la parole en texte

- Générer du texte de réponse

- Convertir le texte en parole

Dans les modèles précédents, le délai moyen de ce processus était de 2,8 secondes pour GPT-3.5 et de 5,4 secondes pour GPT-4. Cependant, le GPT-4o actuel peut répondre en seulement 232 millisecondes, avec un temps de réponse moyen de 320 millisecondes, ce qui correspond presque à la vitesse de réaction d'un humain. En d'autres termes, l'utilisation du dernier modèle GPT-4o peut permettre une interaction quasi en temps réel avec l'IA.

Comprend le ton audio

Les modèles GPT précédents ne pouvaient pas reconnaître le ton de la voix de l'orateur ou le bruit de fond, ce qui entraînait la perte de certaines informations dans les conversations. Cependant, avec l'introduction de GPT-4o, il peut désormais comprendre les jetons audio de l'orateur, ou les émotions, ce qui le rend plus humain.

Réduction de jetons pour de nombreuses langues

De plus, GPT-4o a compressé le nombre de jetons utilisés pour 20 langues, telles que le japonais. L'utilisation du japonais comme exemple signifie que lors de l'utilisation de ChatGPT en japonais, moins de jetons seront utilisés.

- Pour l'interaction "Bonjour, je m'appelle GPT-4o. Je suis un nouveau type de modèle linguistique. Ravi de vous rencontrer", le nombre de jetons utilisés est passé de 37 à 26, soit une réduction de 1,4 fois.

Autres informations importantes de l'annonce de GPT-4o

En plus des fonctionnalités du modèle GPT-4o lui-même, les informations suivantes ont également été mises en évidence lors de l'annonce de GPT-4o :

Presque tous les services sont gratuits

Les services précédemment payants comme GPTs, GPT Store et GPT-4 seront rendus disponibles gratuitement suite à l'annonce de GPT-4o.

Application de bureau fournie

Alors que ChatGPT n'était disponible en ligne que jusqu'à présent, une nouvelle application de bureau macOS ChatGPT a été annoncée lors de l'annonce du modèle GPT-4o. Une application Windows devrait également sortir au second semestre de cette année.

Comprendre les détails de GPT-4o

Si vous souhaitez connaître les informations détaillées sur le nouveau modèle d'IA d'OpenAI - GPT-4o, vous pouvez consulter leur enregistrement vidéo de la conférence de presse.

Comment accéder à l'API GPT-4o ?

Lors du développement d'applications web, il est très pratique d'utiliser des API pour intégrer les fonctionnalités d'IA dans vos propres services. Avec l'annonce du modèle GPT-4o, vous devrez utiliser l'API GPT-4o pour introduire les capacités exceptionnelles du modèle GPT-4o dans vos propres services. Alors, l'API GPT-4o est-elle utilisable ? Combien cela coûte-t-il ? Examinons de plus près ces questions.

L'API GPT-4o est-elle disponible ?

Selon les dernières informations d'OpenAI, l'API du modèle GPT-4o est déjà disponible en tant que modèle de texte et de vision dans l'API Chat Completions, l'API Assistants et l'API Batch.

Mises à jour de l'API GPT-4o

Par rapport aux API des modèles ChatGPT précédents, l'API GPT-4o est considérée comme meilleure dans les domaines suivants :

- Intelligence supérieure : Fournit des performances de niveau GPT-4 Turbo en matière de texte, de raisonnement et de codage, et établit de nouvelles normes élevées en matière de capacités multilingues, audio et visuelles.

- Vitesse de réponse 2x plus rapide : La vitesse de génération de jetons est doublée par rapport à GPT-4 Turbo.

- Prix 50 % moins cher : 50 % moins cher que GPT-4 Turbo pour les jetons d'entrée et de sortie.

- Limite de débit 5x plus élevée : La limite de débit est 5 fois supérieure à celle de GPT-4 Turbo, jusqu'à 10 millions de jetons par minute.

- Capacités visuelles améliorées : Les capacités visuelles ont été améliorées pour la plupart des tâches.

- Capacités linguistiques non anglaises améliorées : Traitement amélioré des langues non anglaises et utilisation d'un nouveau tokenizer pour tokeniser le texte non anglais plus efficacement.

Tarification de l'API GPT-4o

Alors, combien coûte l'utilisation de ce dernier modèle d'API GPT-4o ? Selon le site officiel de l'API OpenAI, GPT-4o est plus rapide et plus rentable que GPT-4 Turbo, tout en offrant des capacités de vision plus puissantes. Ce modèle a un contexte de 128K et couvre les connaissances jusqu'en octobre 2023. De plus, il est 50 % moins cher que GPT-4 Turbo. Le plan tarifaire spécifique est le suivant :

Selon la page de tarification de l'API OpenAI, le coût/la tarification de GPT-4o est le suivant :

- Entrée de texte : 5 $ / 1 million de jetons

- Sortie de texte : 15 $ / 1 million de jetons

Et, le coût du traitement de la vision (génération d'images) est calculé en fonction de la largeur et de la hauteur de l'image. Par exemple, le coût de traitement d'une image de 150 pixels de haut et de 150 pixels de large est de 0,001275 $. Les utilisateurs peuvent librement ajuster la résolution de l'image, et le prix est basé sur le nombre de pixels.

Ainsi, qu'il s'agisse d'entrée, de sortie ou de génération d'images, le coût d'utilisation de l'API GPT-4o est la moitié de celui de GPT-4 Turbo.

Notes importantes lors de l'utilisation de l'API GPT-4o

Lors de l'utilisation de l'API GPT-4o ou de la tentative de passer d'autres modèles à l'API GPT-4o, vous devez faire attention aux points suivants :

- L'API GPT-4o peut comprendre la vidéo sans audio grâce à la capacité de perception. Plus précisément, vous devez convertir la vidéo en images (2 à 4 images par seconde, soit échantillonnées uniformément, soit en utilisant un algorithme de sélection d'images clés), puis saisir ces images dans le modèle.

- Au 14 mai 2024, l'API GPT-4o ne prend pas encore en charge la modalité audio. Cependant, OpenAI prévoit de fournir la modalité audio à des testeurs de confiance dans les prochaines semaines.

- Au 14 mai 2024, l'API GPT-4o ne prend pas en charge la génération d'images pendant un certain temps, donc si vous avez besoin de la génération d'images, il est recommandé d'utiliser l'API DALL-E 3.

- OpenAI recommande à tous les utilisateurs utilisant actuellement GPT-4 ou GPT-4 Turbo d'envisager de passer à GPT-4o. GPT-4o n'est pas nécessairement plus performant que GPT-4 ou GPT-4 Turbo dans tous les cas, OpenAI suggère donc de comparer les sorties et d'essayer GPT-4o pour évaluer ses capacités avant d'envisager de changer.

Testez et gérez facilement l'API GPT-4o avec Apidog

Lors de l'utilisation de l'API GPT-4o, des tâches telles que les tests et la gestion des API deviennent essentielles.

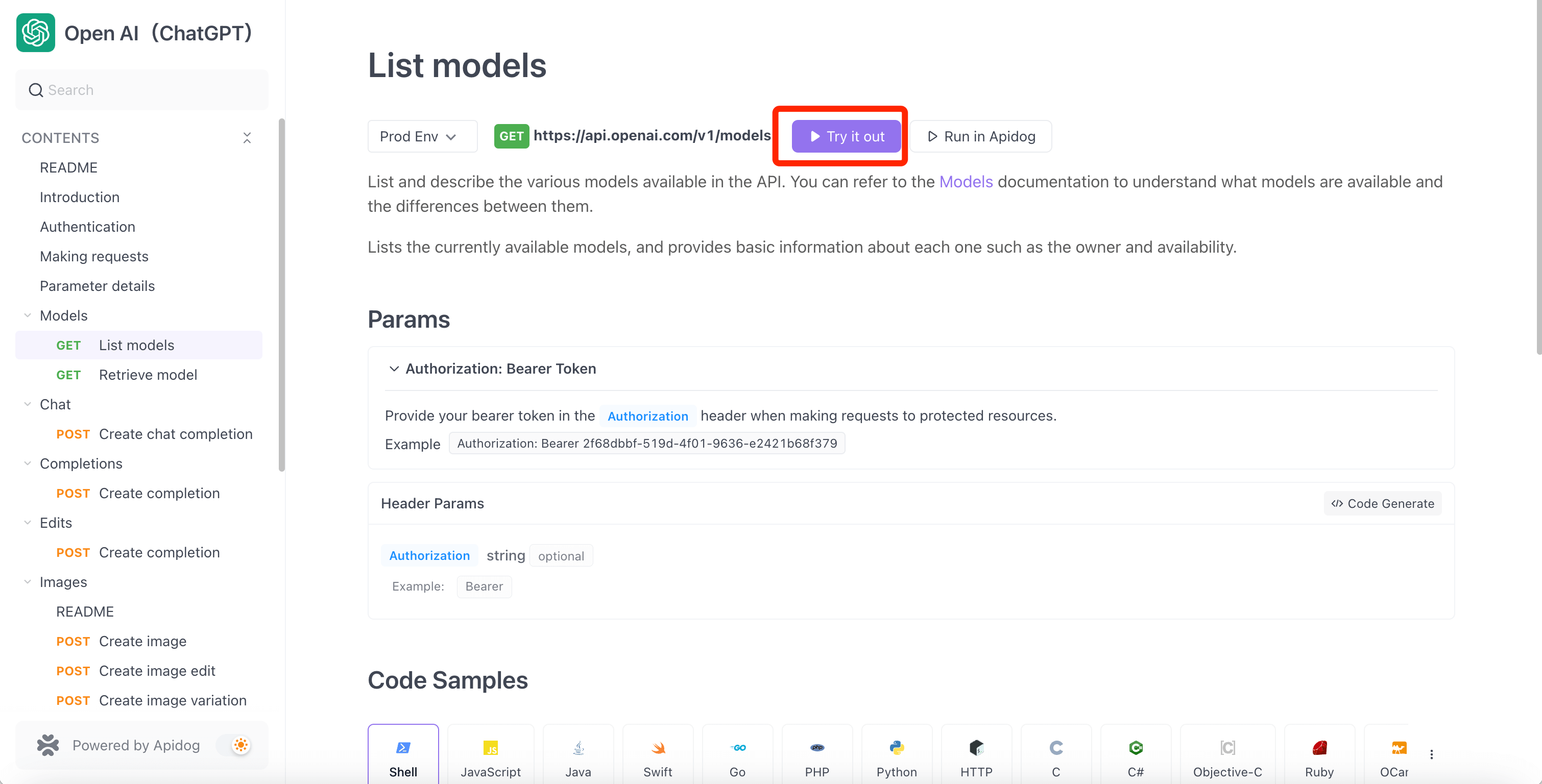

En utilisant l'outil de gestion d'API le plus pratique - Apidog, vous pouvez gérer n'importe quelle API de manière plus pratique et efficace. Puisque l'API GPT-4o est déjà disponible, vous pouvez accéder à l'API Hub sur Apidog et accéder facilement au projet d'API OpenAI. Ensuite, vous pouvez cloner le projet d'API GPT-4o dans votre projet, utiliser et tester l'API GPT-4o, et la gérer facilement avec Apidog.

De plus, Apidog prend en charge les événements envoyés par le serveur (SSE), ce qui facilite le streaming de l'API GPT-4o ! Pour plus de détails, consultez cet article :

Condition préalable à l'utilisation de l'API GPT-4o : Clé API OpenAI

Pour commencer à utiliser l'API GPT-4o, vous devez d'abord obtenir un jeton d'API OpenAI. Suivez le tutoriel ci-dessous pour obtenir votre clé API OpenAI.

1. Inscrivez-vous pour un compte OpenAI

Pour commencer à utiliser l'API GPT-4o, vous devez d'abord créer un compte OpenAI. Accédez au site officiel d'OpenAI et cliquez sur le bouton "Get Started" dans le coin supérieur droit pour créer un compte.

2. Obtenez la clé API OpenAI

Après avoir créé votre compte OpenAI, vous devez obtenir une clé API pour l'authentification, ce qui est une exigence pour utiliser l'API GPT-4o. Suivez ces étapes pour obtenir votre clé API ChatGPT :

Étape 1 : Accédez à la page des clés API sur OpenAI et connectez-vous avec votre compte (ou créez un nouveau compte si vous n'en avez pas).

Étape 2 : Cliquez sur le bouton "Create new secret key" pour générer une nouvelle clé API.

Après avoir généré la clé API, elle s'affichera immédiatement à l'écran. Cependant, vous ne pourrez plus afficher la clé API, il est donc recommandé de l'enregistrer et de la stocker en toute sécurité.

Testez et gérez l'API GPT-4o avec Apidog

Apidog est un outil incroyablement pratique pour utiliser l'API GPT-4o. Apidog dispose d'un projet d'API OpenAI qui couvre toutes les API fournies par OpenAI. Si vous souhaitez vérifier les API fournies par OpenAI, accédez à la page suivante :

Actuellement, l'API GPT-4o n'est disponible que dans l'API Chat Completions, l'API Assistants et l'API Batch, alors sélectionnez chacune d'elles dans le menu de gauche du projet d'API OpenAI pour commencer à utiliser l'API GPT-4o.

Étape par étape : Utilisation de l'API GPT-4o avec Apidog

Lorsque vous accédez au projet d'API OpenAI sur Apidog, vous pouvez facilement tester les API OpenAI en suivant ces étapes. Voyons comment utiliser le GPT-4o avec l'API Chat Completions.

Étape 1 : Accédez au projet d'API OpenAI sur Apidog, sélectionnez le point de terminaison de l'API Chat Completions dans le menu de gauche, et sur le nouvel écran de requête, entrez la méthode HTTP et l'URL du point de terminaison conformément aux spécifications de ChatGPT. Ensuite, dans l'onglet "Body", écrivez le message que vous souhaitez envoyer à ChatGPT au format JSON.

Remarque : Pour utiliser GPT-4o, spécifiez le modèle comme "gpt-4o" en incluant "model":"gpt-4o".

Étape 2 : Passez à l'onglet "Header", ajoutez le paramètre Authorization pour vous authentifier auprès de l'API ChatGPT, entrez la clé API ChatGPT que vous avez obtenue et cliquez sur le bouton "Send".

Remarque : Dans Apidog, vous pouvez stocker votre clé API OpenAI en tant que variable d'environnement. Stocker la clé API OpenAI en tant que variable d'environnement signifie que vous pouvez directement référencer la variable d'environnement plus tard sans avoir à ressaisir la clé API à plusieurs reprises, ce qui est pratique.

Résumé

Dans cet article, nous avons fourni une explication détaillée du dernier modèle d'OpenAI, GPT-4o. GPT-4o a un temps de réponse deux fois plus rapide que les modèles précédents et peut comprendre le texte, les images, l'audio et la vidéo. De plus, le nombre de jetons utilisés pour le japonais a été réduit, ce qui améliore la rentabilité.

L'API GPT-4o est disponible dans l'API Chat Completions, l'API Assistants et l'API Batch, avec des fonctionnalités telles qu'une intelligence supérieure, une vitesse de réponse 2x plus rapide, une tarification 50 % moins chère, une limite de débit 5x plus élevée, des capacités visuelles améliorées et des capacités linguistiques non anglaises améliorées par rapport aux API des modèles ChatGPT précédents.

Pour utiliser l'API GPT-4o, vous devez d'abord créer un compte OpenAI et obtenir une clé API. Ensuite, avec Apidog, vous pouvez facilement tester et gérer l'API GPT-4o. Apidog dispose d'un projet d'API OpenAI qui couvre les spécifications de l'API GPT-4o, et vous pouvez stocker votre clé API en tant que variable d'environnement pour éviter de la ressaisir.

À l'avenir, la prise en charge audio sera ajoutée à l'API GPT-4o. En tirant parti des excellentes fonctionnalités de GPT-4o et en les intégrant à vos services, vous pouvez offrir une expérience d'IA encore meilleure.