Les développeurs recherchent constamment des outils qui améliorent la productivité sans gonfler les coûts. GLM-4.5 apparaît comme un véritable atout dans ce domaine, offrant des capacités robustes pour les tâches de codage. Lorsque vous l'associez à Claude Code, vous accédez à une assistance IA avancée qui rivalise avec les modèles de pointe. D

Comprendre GLM-4.5 : Le fondement du codage IA avancé

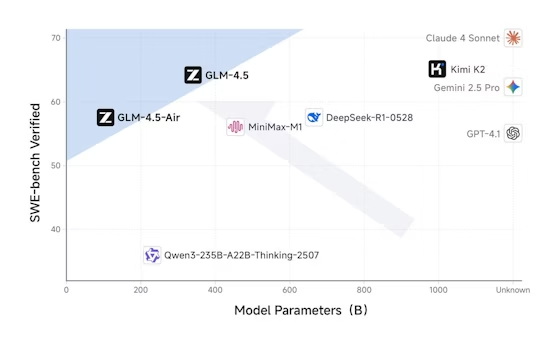

Z.ai développe GLM-4.5 en tant que modèle de langage étendu phare, conçu pour les applications orientées agent. Les ingénieurs de Z.ai utilisent une architecture de mélange d'experts (MoE), qui active 32 milliards de paramètres sur un total de 355 milliards lors de chaque passage avant. Cette conception optimise l'efficacité, permettant au modèle de gérer des tâches complexes sans surcharge computationnelle excessive. De plus, GLM-4.5 subit un pré-entraînement sur 15 billions de jetons, suivi d'un réglage fin sur des ensembles de données spécialisés pour la génération de code, le raisonnement et les comportements d'agent.

Le modèle prend en charge une fenêtre de contexte de 128 000 jetons, lui permettant de traiter des bases de code étendues ou des instructions multi-étapes en une seule fois. Les développeurs apprécient cette fonctionnalité car elle réduit le besoin de requêtes répétées. De plus, GLM-4.5 intègre des modes de raisonnement hybrides : le mode Pensée pour les problèmes complexes et le mode Non-Pensée pour les réponses rapides. Vous les activez via le paramètre thinking.type dans les appels API, offrant une flexibilité basée sur les exigences de la tâche.

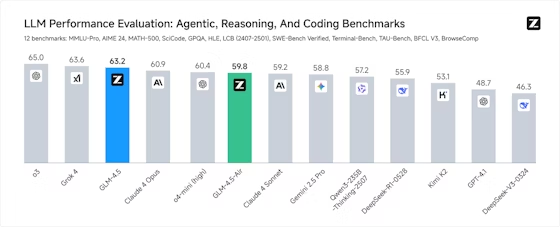

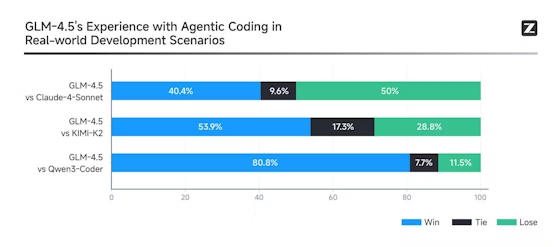

Les benchmarks soulignent les prouesses de GLM-4.5. Il se classe deuxième mondialement sur 12 suites, y compris MMLU Pro pour le raisonnement multifacette et LiveCodeBench pour les défis de codage en temps réel. En termes pratiques, cela signifie que GLM-4.5 génère des scripts Python ou des fonctions JavaScript avec une grande précision, surpassant souvent des modèles comme Claude 3.5 Sonnet dans les tâches d'appel de fonctions. Cependant, sa véritable force réside dans les fonctions agentiques, où il invoque des outils, navigue sur le web ou conçoit des composants logiciels de manière autonome.

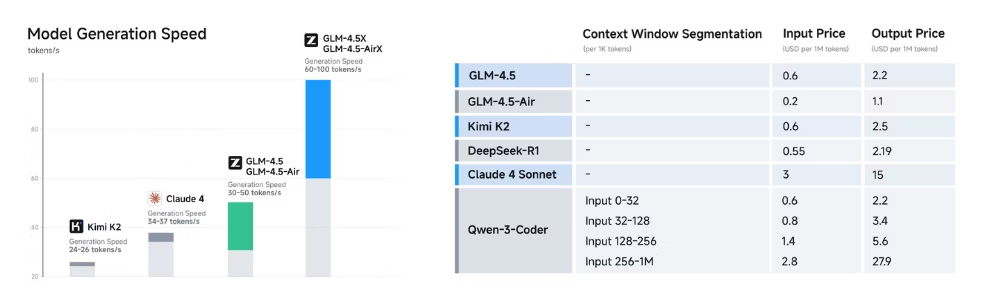

GLM-4.5-Air, une variante plus légère avec un total de 106 milliards de paramètres et 12 milliards actifs, complète le modèle principal pour les scénarios exigeant de la vitesse plutôt que de la puissance brute. Les deux variantes s'intègrent parfaitement aux outils de développement, ce qui les rend idéales pour les environnements de codage. En conséquence, les équipes adoptent GLM-4.5 pour rationaliser les flux de travail, du débogage du code existant au prototypage de nouvelles applications.

Qu'est-ce que Claude Code et pourquoi l'intégrer à GLM-4.5 ?

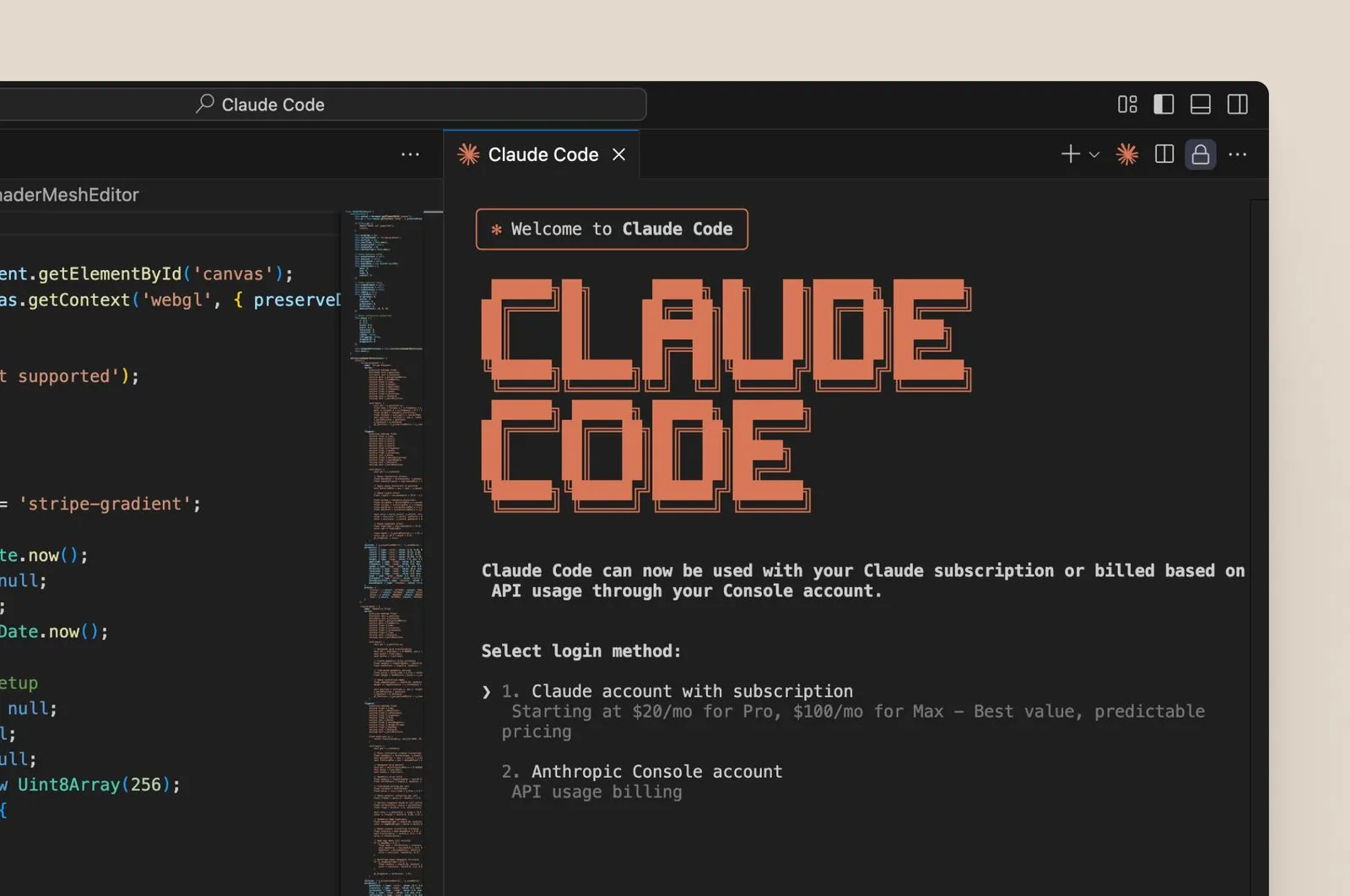

Claude Code sert d'assistant de codage basé sur le terminal qui exploite l'IA pour automatiser les tâches de développement. Les utilisateurs l'installent comme un outil CLI ou l'intègrent dans des IDE comme VS Code. Conçu à l'origine autour des modèles Claude d'Anthropic, Claude Code exécute des commandes, génère des extraits de code et gère des dépôts via des entrées en langage naturel. Par exemple, vous pourriez lui demander de "refactoriser cette fonction pour une meilleure performance", et il répondrait avec du code optimisé.

L'intégration avec GLM-4.5 s'effectue via le point de terminaison API compatible Anthropic de Z.ai. Cette compatibilité vous permet de remplacer les modèles Claude par GLM-4.5 sans altérer la fonctionnalité principale de Claude Code. Par conséquent, les développeurs acheminent les requêtes vers les serveurs de Z.ai, bénéficiant des taux d'invocation d'outils supérieurs de GLM-4.5 — jusqu'à 90 % de succès dans les benchmarks.

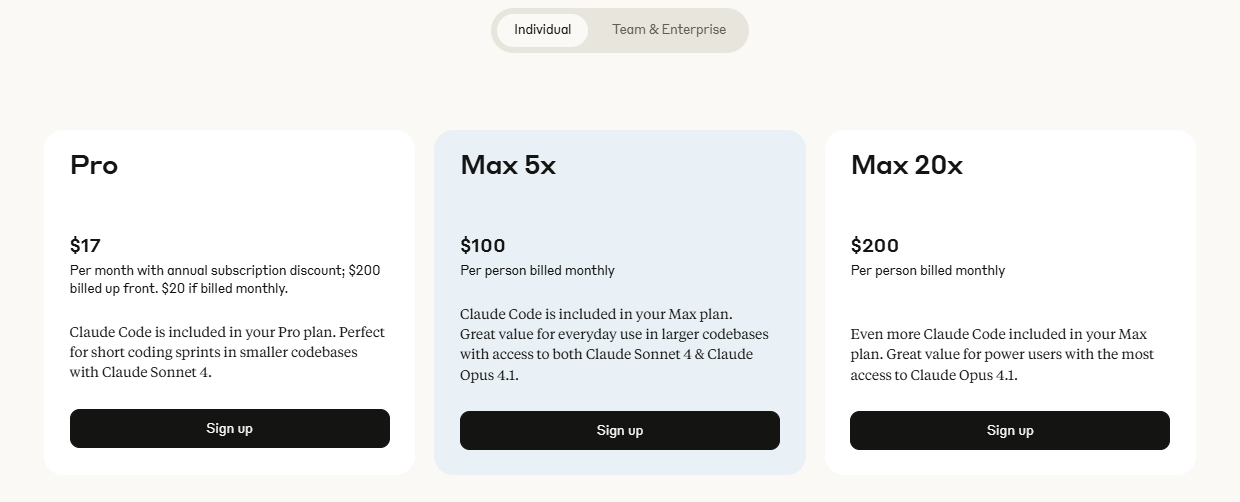

Pourquoi faire ce changement ? GLM-4.5 offre des avantages en termes de coûts et des performances améliorées dans le codage agentique. Les plans Claude traditionnels peuvent coûter 100 à 200 $ par mois pour une utilisation intensive, mais les plans de codage GLM de Z.ai commencent à 3 $ pour Lite et 15 $ pour Pro, offrant 3 fois l'utilisation des niveaux Claude comparables. Cette accessibilité attire les développeurs indépendants et les startups. De plus, GLM-4.5 excelle dans des domaines comme le développement front-end et la correction de bugs, accomplissant en quelques minutes des tâches qui prendraient des heures manuellement.

Avantages de l'utilisation de GLM-4.5 avec Claude Code

La combinaison de GLM-4.5 et de Claude Code offre des avantages tangibles. Premièrement, vous obtenez des cycles d'itération plus rapides. La vitesse de génération de GLM-4.5 dépasse les 100 jetons par seconde, permettant des suggestions de code en temps réel dans Claude Code. Cette rapidité s'avère cruciale lors des sessions de débogage, où des corrections rapides évitent les interruptions de flux de travail.

Deuxièmement, l'intégration améliore la précision. Le réglage fin par apprentissage par renforcement de GLM-4.5 garantit des sorties fiables, réduisant les hallucinations dans la génération de code. Par exemple, il respecte les meilleures pratiques dans des langages comme Java ou C++, intégrant automatiquement la gestion des erreurs et l'optimisation. Par conséquent, les développeurs passent moins de temps à réviser le code généré par l'IA.

Troisièmement, l'efficacité des coûts se distingue. Le plan GLM Coding Pro à 15 $/mois débloque des tâches intensives avec 3 fois la capacité du plan Max de Claude. Le plan Lite à 3 $ convient aux besoins légers, rendant l'IA avancée accessible. Alimentés par GLM-4.5 et GLM-4.5-Air, ces plans promettent des intégrations d'outils à venir, élargissant encore les capacités.

La sécurité s'améliore également. L'API de Z.ai prend en charge les sorties structurées comme JSON, garantissant des réponses prévisibles dans Claude Code. De plus, la mise en cache du contexte minimise les calculs redondants, réduisant la latence lors des sessions longues.

Enfin, la nature open-source de GLM-4.5 permet la personnalisation. Les équipes affinent le modèle pour des tâches spécifiques à un domaine, l'intégrant plus profondément dans les flux de travail de Claude Code. Dans l'ensemble, cette association transforme le codage d'une entreprise solitaire en un processus augmenté par l'IA.

Guide étape par étape : Configuration de GLM-4.5 dans Claude Code

Vous commencez par préparer votre environnement. Installez Claude Code via son CLI officiel ou son extension. Ensuite, inscrivez-vous sur la plateforme de Z.ai pour obtenir une clé API. Abonnez-vous à un plan de codage GLM si votre utilisation dépasse les niveaux gratuits — Lite convient aux débutants.

Configurez l'intégration. Dans les paramètres de Claude Code, localisez le fichier de configuration de l'API (souvent ~/.claude/config.yaml). Mettez à jour l'URL de base vers le point de terminaison de Z.ai : https://api.z.ai/api/paas/v4/chat/completions. Insérez votre clé API dans l'en-tête d'autorisation.

Testez la configuration. Lancez Claude Code et émettez une commande simple : "Générer une fonction Python pour trier une liste." GLM-4.5 traite cela via l'API compatible, renvoyant du code. Vérifiez la sortie pour la justesse.

Activez les fonctionnalités avancées. Définissez le thinking.type sur "enabled" pour les tâches complexes. Cela active le raisonnement profond de GLM-4.5, idéal pour les décisions architecturales. Utilisez le streaming en ajoutant stream: true aux requêtes, permettant l'affichage progressif du code dans Claude Code.

Gérez les outils. GLM-4.5 prend en charge les appels de fonctions — définissez des outils dans votre prompt, et le modèle les invoque. Pour la navigation web, incluez un outil de navigateur ; Claude Code les achemine de manière transparente.

Dépannage des problèmes. Si l'authentification échoue, régénérez votre clé. Pour les limites de débit, surveillez l'utilisation dans le tableau de bord de Z.ai. Apidog aide ici en simulant des appels avant l'intégration en direct.

Test de l'API GLM-4.5 avec Apidog : Assurer la fiabilité

Apidog rationalise les tests d'API, le rendant essentiel pour l'intégration de GLM-4.5. Vous créez un nouveau projet dans Apidog et importez la spécification OpenAPI de Z.ai. Définissez des points de terminaison comme /chat/completions.

Construisez des requêtes. Définissez les en-têtes avec votre clé API et le type de contenu comme JSON. Dans le corps, spécifiez le modèle comme "glm-4.5" et ajoutez un tableau de messages pour les prompts.

Exécutez les tests. Apidog exécute les appels, affichant les réponses avec les codes d'état. Affirmez les sorties attendues, telles que le code structuré en JSON.

Automatisez les scénarios. Construisez des suites de tests pour les variations — testez le mode Pensée versus Non-Pensée, ou différentes températures (0.6 pour une créativité équilibrée).

Surveillez les performances. Apidog suit la latence et les erreurs, aidant à optimiser les paramètres avant le déploiement de Claude Code.

Intégrez avec CI/CD. Exportez les scripts Apidog vers les pipelines, assurant la fiabilité de GLM-4.5 après les mises à jour.

Utilisation avancée : Exploiter les fonctionnalités agentiques de GLM-4.5 dans Claude Code

GLM-4.5 excelle dans les tâches agentiques. Vous définissez des agents dans les prompts de Claude Code, et GLM-4.5 les orchestre. Par exemple, créez un agent de refactoring : "Analysez cette base de code et suggérez des améliorations."

Utilisez l'invocation multi-outils. GLM-4.5 gère les chaînes — parcourir la documentation, générer du code, le tester — le tout en une seule session.

Ajustez pour des spécificités. Téléchargez des ensembles de données sur Z.ai pour des modèles personnalisés, puis acheminez Claude Code vers eux.

Mettez à l'échelle avec la mise en cache. Stockez les contextes dans le cache de GLM-4.5, accélérant le codage itératif.

Combinez les variantes. Passez à GLM-4.5-Air pour les tâches rapides, en réservant le GLM-4.5 complet pour les tâches intensives.

Tarification et plans : Rendre GLM-4.5 abordable pour les utilisateurs de Claude Code

Z.ai adapte ses plans pour Claude Code. Le plan Lite à 3 $/mois offre 3 fois l'utilisation de Claude Pro pour le codage occasionnel. Le plan Pro à 15 $/mois triple Claude Max, convenant aux professionnels.

Des niveaux gratuits existent pour les tests, mais les plans débloquent un potentiel illimité. Comparez : l'API standard coûte 0,2 $/M jetons d'entrée, mais les plans sont groupés pour des économies.

Défis courants et solutions

Pics de latence ? Optimisez les prompts. Erreurs dans les appels d'outils ? Affinez les définitions. Apidog les identifie tôt.

Conclusion

L'intégration de GLM-4.5 avec Claude Code donne du pouvoir aux développeurs. Suivez ces étapes, exploitez Apidog et transformez votre pratique de codage. La combinaison offre efficacité, précision et abordabilité — commencez dès aujourd'hui.