La sortie de modèles d'IA avancés comme Gemini 2.5 Pro de Google suscite un enthousiasme important au sein de la communauté des développeurs. Ses capacités améliorées de raisonnement, de codage et de compréhension multimodale promettent de révolutionner la façon dont nous construisons des applications. Cependant, l'accès à des modèles de pointe s'accompagne souvent de questions sur le coût et la disponibilité. De nombreux développeurs se demandent : « Comment puis-je utiliser Gemini 2.5 Pro gratuitement ? » Bien que l'accès direct et illimité à l'API implique généralement des coûts, il existe des moyens légitimes d'interagir avec ce modèle puissant sans aucun frais, principalement via son interface web, et même par programmation via des projets communautaires.

La méthode officielle pour utiliser Gemini 2.5 Pro gratuitement : l'interface web

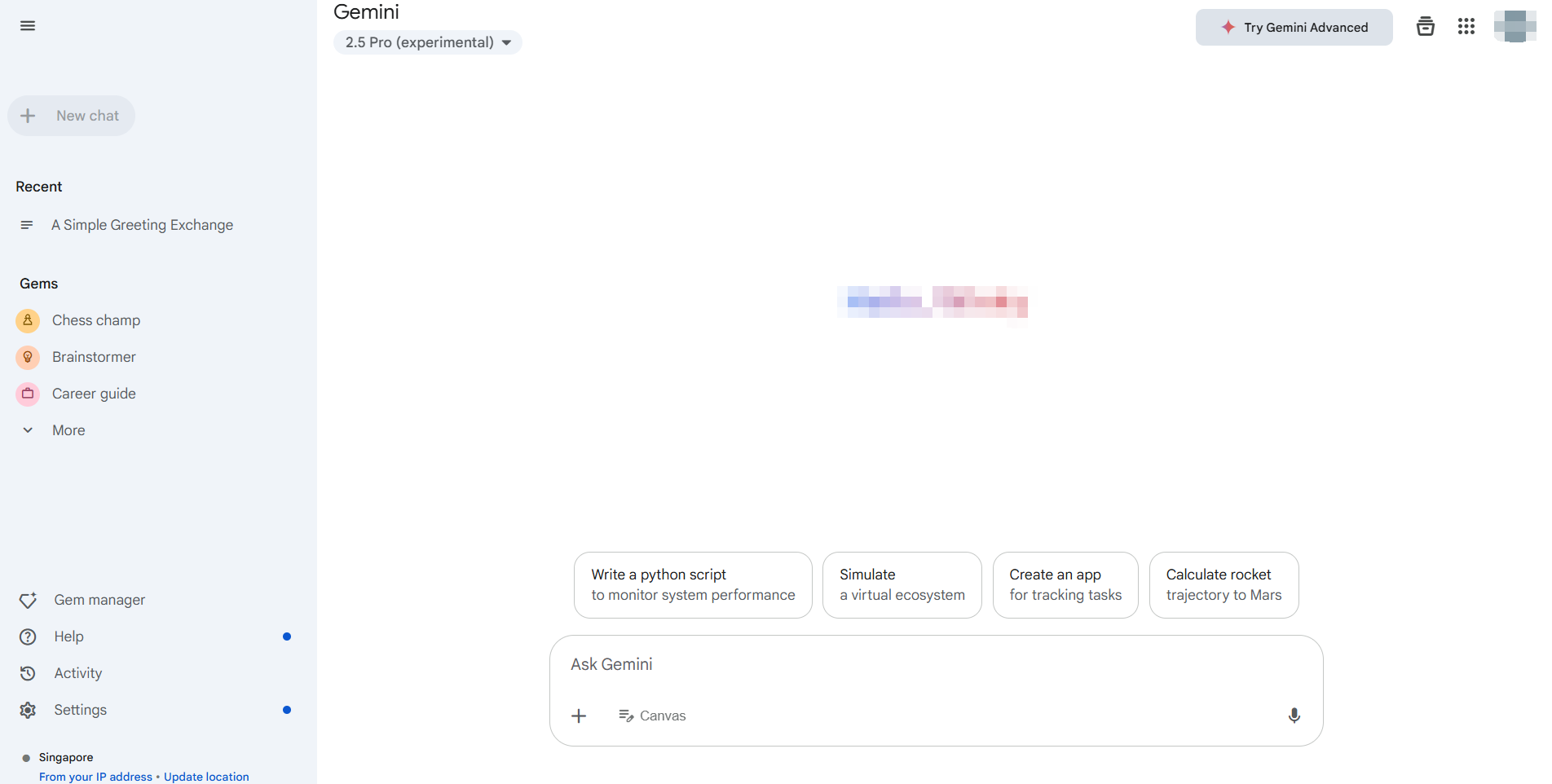

La méthode la plus simple et officiellement prise en charge pour utiliser Gemini 2.5 Pro sans aucun frais est via son application web dédiée, généralement accessible à l'adresse https://gemini.google.com/. Google donne accès à ses derniers modèles, dont Gemini 2.5 Pro (la disponibilité peut varier selon la région et le statut du compte), via cette interface pour les utilisateurs généraux.

Principaux avantages de l'interface web :

- Zéro coût : Il s'agit de l'offre standard gratuite offrant une interaction directe.

- Accès complet aux fonctionnalités : Vous pouvez généralement exploiter les principales capacités du modèle, notamment la génération de texte, le brainstorming, l'aide au codage et potentiellement la génération d'images (comme avec Imagen3, sous réserve de disponibilité) et les interactions avec les extensions Google Workspace (Gmail, Docs, Drive, etc.).

- Interface utilisateur conviviale : L'interface web est conçue pour être facile à utiliser, ne nécessitant aucune configuration autre que la connexion à votre compte Google.

Comment l'utiliser :

- Accédez à l'application web Gemini.

- Connectez-vous avec votre compte Google.

- Assurez-vous que Gemini 2.5 Pro est sélectionné si plusieurs modèles sont disponibles (souvent indiqué dans les paramètres ou près de l'entrée de l'invite).

5. Commencez à interagir ! Tapez vos invites, téléchargez des fichiers (si pris en charge) et explorez ses capacités.

Pour de nombreux utilisateurs et développeurs ayant besoin d'évaluer Gemini 2.5 Pro, de tester des invites ou d'effectuer des tâches non programmatiques, l'interface web officielle est la solution idéale et gratuite. Elle offre un accès direct à la puissance du modèle sans nécessiter de clés API ni de quotas d'utilisation associés à l'API payante. Cette méthode répond parfaitement au besoin d'utiliser Gemini 2.5 Pro gratuitement pour l'exploration et l'interaction manuelle.

Comment utiliser Gemini 2.5 Pro par programmation sans coût direct d'API

Bien que l'interface web soit idéale pour une utilisation manuelle, les développeurs ont souvent besoin d'un accès programmatique pour l'intégration, l'automatisation ou le traitement par lots. L'API Google Generative AI officielle pour les modèles comme Gemini 2.5 Pro implique généralement des coûts basés sur l'utilisation de jetons. Cependant, la communauté des développeurs crée souvent des outils pour combler ce fossé.

Un de ces outils, mis en évidence dans les ressources communautaires comme la bibliothèque Python Gemini API, permet aux développeurs d'interagir avec l'interface web gratuite Gemini par programmation.

Avertissement crucial : Il est essentiel de comprendre qu'il ne s'agit PAS de l'API Google Generative AI officielle. Ces bibliothèques fonctionnent en rétro-ingénierie des appels d'API privés de l'application web et en utilisant des cookies de navigateur pour l'authentification.

- Non officiel : Non pris en charge ni approuvé par Google.

- Potentiellement instable : Repose sur des éléments d'interface web qui peuvent changer sans préavis, ce qui casse la bibliothèque.

- Considérations de sécurité : Nécessite l'extraction des cookies d'authentification de votre navigateur, ce qui comporte des risques de sécurité inhérents s'ils ne sont pas gérés avec soin.

- Conditions d'utilisation : L'utilisation pourrait violer les conditions d'utilisation de Google pour l'application web.

Malgré ces mises en garde, de telles bibliothèques offrent aux développeurs un moyen d'expérimenter et d'utiliser Gemini 2.5 Pro sans aucun coût au-delà des limitations de la version gratuite de l'interface web elle-même, mais de manière automatisée.

Guide étape par étape :

Conditions préalables : Assurez-vous que Python 3.10+ est installé.

Installation : Installez la bibliothèque en utilisant pip :

pip install -U gemini_webapi

# Optional: Install browser-cookie3 for easier cookie fetching

pip install -U browser-cookie3Authentification (la partie délicate) :

- Connectez-vous à

gemini.google.comdans votre navigateur web. - Ouvrez les outils de développement (F12), accédez à l'onglet

Networket actualisez la page. - Trouvez une requête (n'importe quelle requête fonctionne généralement).

- Dans les en-têtes de requête (généralement sous "Cookies"), trouvez et copiez les valeurs de

__Secure-1PSIDet__Secure-1PSIDTS. Traitez-les comme des mots de passe ! - Alternative : Si

browser-cookie3est installé, la bibliothèque peut être en mesure d'importer automatiquement les cookies si vous êtes connecté via un navigateur pris en charge, ce qui simplifie cette étape, mais repose toujours sur l'état du navigateur local.

Initialisation et utilisation de base :

import asyncio

from gemini_webapi import GeminiClient

from gemini_webapi.constants import Model # Import Model constants

# --- Authentication ---

# Method 1: Manually paste cookies (handle securely!)

Secure_1PSID = "YOUR__SECURE_1PSID_COOKIE_VALUE"

Secure_1PSIDTS = "YOUR__SECURE_1PSIDTS_COOKIE_VALUE" # May be optional

async def run_gemini():

# Method 2: Use browser-cookie3 (if installed and logged in)

# client = GeminiClient(proxy=None) # Attempts auto-cookie import

# Initialize with manual cookies

client = GeminiClient(Secure_1PSID, Secure_1PSIDTS, proxy=None)

await client.init(timeout=30) # Initialize connection

# --- Select Model and Generate Content ---

prompt = "Explain the difference between REST and GraphQL APIs."

# Use the Gemini 2.5 Pro model identifier

print(f"Sending prompt to Gemini 2.5 Pro...")

response = await client.generate_content(prompt, model=Model.G_2_5_PRO) # Use the specific model

print("\nResponse:")

print(response.text)

# Close the client session (important for resource management)

await client.close()

if __name__ == "__main__":

asyncio.run(run_gemini())Consultez plus de détails sur l'intégration ici.

Explorer davantage : Des bibliothèques comme celle-ci prennent souvent en charge les fonctionnalités disponibles dans l'interface utilisateur web, telles que le chat multi-tours (client.start_chat()), les téléchargements de fichiers, les demandes de génération d'images et l'utilisation d'extensions (@Gmail, @Youtube), reflétant les capacités de l'application web par programmation.

N'oubliez pas que cette approche automatise l'interaction avec la version web gratuite, et non avec l'API payante. Elle permet une expérimentation programmatique avec Gemini 2.5 Pro sans coût direct d'API, mais comporte des avertissements importants en matière de fiabilité et de sécurité.

Le défi du débogage avec les LLM

Que vous interagissiez avec Gemini 2.5 Pro via le web, l'API officielle ou des bibliothèques non officielles, la compréhension et le débogage des réponses sont cruciaux, en particulier lorsqu'il s'agit de sorties complexes ou en streaming. De nombreux LLM, en particulier sous forme d'API, utilisent des Server-Sent Events (SSE) pour diffuser les réponses jeton par jeton ou par morceaux. Cela donne une impression de temps réel, mais peut être difficile à déboguer à l'aide de clients HTTP standard.

Les outils de test d'API traditionnels peuvent simplement afficher des données SSE brutes : des morceaux, ce qui rend difficile la reconstitution du message complet ou la compréhension du flux d'informations, en particulier le « processus de pensée » du modèle s'il est fourni. C'est là qu'un outil spécialisé devient inestimable.

Présentation d'Apidog : Une plateforme de développement d'API complète et tout-en-un conçue pour gérer l'ensemble du cycle de vie de l'API – de la conception et de la documentation au débogage, aux tests automatisés et à la simulation. Bien que puissant sur toute la ligne, Apidog excelle particulièrement dans la gestion des protocoles d'API modernes, ce qui en fait un outil de test d'API exceptionnel pour les développeurs travaillant avec des LLM. Ses fonctionnalités de débogage SSE sont spécifiquement conçues pour relever les défis des réponses en streaming.

Maîtriser les réponses LLM en temps réel

Travailler avec des LLM comme Gemini 2.5 Pro implique souvent des Server-Sent Events (SSE) pour la diffusion en continu des résultats. Cette technologie permet au modèle d'IA d'envoyer des données à votre client en temps réel, en affichant du texte généré ou même des étapes de raisonnement au fur et à mesure. Bien que ce soit excellent pour l'expérience utilisateur, le débogage des flux SSE bruts dans les outils de base peut être un cauchemar de messages fragmentés.

Apidog, en tant qu'outil de test d'API de premier plan, transforme le débogage SSE d'une corvée en un processus clair. Voici comment Apidog vous aide à maîtriser les flux LLM :

- Détection automatique SSE : Lorsque vous envoyez une requête à un point de terminaison LLM à l'aide d'Apidog, si l'en-tête de réponse

Content-Typeesttext/event-stream, Apidog le reconnaît automatiquement comme un flux SSE. - Vue chronologique en temps réel : Au lieu de simplement vider les lignes

data:brutes, Apidog présente les messages entrants par ordre chronologique dans une vue « Chronologie » dédiée. Cela vous permet de voir le flux d'informations exactement tel que le serveur l'envoie. - Fusion automatique intelligente : C'est un véritable changement de donne pour le débogage SSE des LLM. Apidog possède une intelligence intégrée pour reconnaître les formats de streaming courants utilisés par les principaux fournisseurs d'IA, notamment :

- Format compatible avec l'API OpenAI (utilisé par beaucoup)

- Format compatible avec l'API Gemini

- Format compatible avec l'API Claude

- Format compatible avec l'API Ollama (pour les modèles exécutés localement, souvent JSON Streaming/NDJSON)

Si le flux correspond à ces formats, Apidog fusionne automatiquement les fragments de messages individuels (morceaux data:) dans la réponse finale complète et cohérente ou les étapes intermédiaires. Fini de copier et coller manuellement des morceaux ! Vous voyez l'image complète telle que l'IA l'a voulue.

4. Visualisation du processus de pensée : Pour les modèles qui diffusent leur raisonnement ou leurs « pensées » en même temps que le contenu principal (comme certaines configurations de DeepSeek), Apidog peut souvent afficher clairement ces méta-informations dans la chronologie, fournissant ainsi des informations précieuses sur le processus du modèle.

L'utilisation d'Apidog pour le débogage SSE signifie que vous obtenez une vue claire, en temps réel et souvent structurée automatiquement de la façon dont votre point de terminaison LLM répond. Cela facilite considérablement l'identification des problèmes, la compréhension du processus de génération et la garantie que la sortie finale est correcte par rapport aux clients HTTP génériques ou aux outils de test d'API traditionnels qui manquent de gestion SSE spécialisée.

Conclusion : Accéder à Gemini 2.5 Pro gratuitement

Vous pouvez explorer Gemini 2.5 Pro gratuitement via son interface web officielle. Les développeurs à la recherche d'un accès de type API sans frais peuvent essayer des outils créés par la communauté, bien que ceux-ci comportent des risques tels que l'instabilité et les problèmes potentiels de conditions d'utilisation.

Pour travailler avec des LLM comme Gemini, en particulier lorsqu'il s'agit de réponses en streaming, les outils traditionnels ne suffisent pas. C'est là qu'Apidog brille. Avec des fonctionnalités telles que la détection SSE automatique, les vues chronologiques et la fusion intelligente des données fragmentées, Apidog facilite grandement le débogage des réponses en temps réel. Sa prise en charge de l'analyse personnalisée rationalise davantage les flux de travail complexes, ce qui en fait un incontournable pour le développement moderne d'API et de LLM.