Le modèle Dream 7B, développé par l'équipe NLP de l'Université de Hong Kong en collaboration avec Huawei Noah's Ark Lab, représente une avancée révolutionnaire dans la technologie des modèles de langage. Utilisant une approche basée sur la diffusion pour la génération de texte au lieu des méthodes autorégressives traditionnelles, Dream 7B introduit de nouvelles possibilités pour un traitement du langage plus cohérent, flexible et puissant.

Cet outil API vous permet de tester et de déboguer les points de terminaison de votre modèle sans effort. Téléchargez Apidog gratuitement dès aujourd'hui et rationalisez votre flux de travail tout en explorant les capacités de Mistral Small 3.1 !

Comprendre l'architecture de Dream 7B

Dream 7B (où "Dream" signifie Diffusion REAsoning Model) est un modèle de langage à 7 milliards de paramètres qui exploite la modélisation de diffusion discrète pour la génération de texte. Contrairement aux modèles autorégressifs conventionnels comme GPT ou LLaMA qui génèrent du texte séquentiellement de gauche à droite, Dream 7B affine dynamiquement la séquence complète en parallèle, en partant d'un état entièrement bruité.

Cette différence architecturale fondamentale permet à Dream 7B de traiter les informations contextuelles bidirectionnelles plus efficacement, ce qui se traduit par une cohérence et des capacités de raisonnement améliorées. Le modèle a été initialisé avec des poids de Qwen2.5 7B et entraîné sur environ 580 milliards de tokens provenant de jeux de données tels que Dolma v1.7, OpenCoder et DCLM-Baseline.

Comment Dream 7B surpasse les modèles traditionnels

Le modèle Dream 7B démontre plusieurs avantages significatifs par rapport aux modèles de langage autorégressifs traditionnels :

- Modélisation contextuelle bidirectionnelle : En affinant la séquence entière simultanément, Dream 7B peut mieux intégrer les informations des deux directions, améliorant ainsi la cohérence globale.

- Capacités de planification plus fortes : L'évaluation sur des tâches complexes montre que Dream 7B surpasse de manière significative les modèles autorégressifs de taille similaire dans les problèmes qui nécessitent une planification et une satisfaction des contraintes.

- Contrôle de génération flexible : L'architecture basée sur la diffusion permet une génération de texte d'ordre arbitraire, permettant des applications plus diverses, notamment l'achèvement de texte, le remplissage et la génération contrôlée.

- Compromis qualité-vitesse réglable : Les utilisateurs peuvent contrôler dynamiquement le nombre d'étapes de diffusion pour équilibrer la qualité de la génération et l'efficacité computationnelle.

Performance de Dream 7B dans les tests de référence

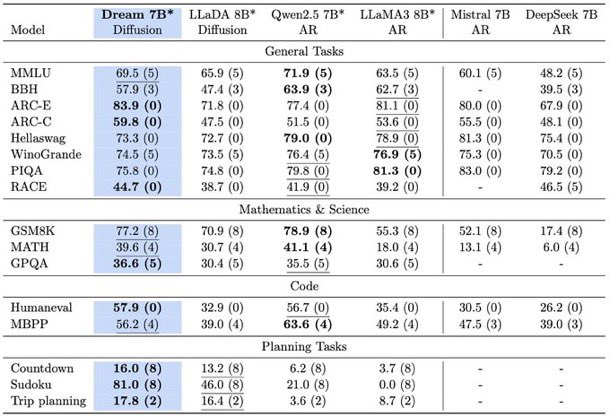

Le modèle Dream 7B a été soumis à une évaluation approfondie sur diverses références, démontrant constamment des performances compétitives par rapport aux principaux modèles autorégressifs de taille similaire. Dans les tâches générales de langage, le raisonnement mathématique et la génération de code, Dream 7B correspond ou dépasse les capacités des modèles de premier plan comme LLaMA3 8B et Qwen2.5 7B.

Plus particulièrement, dans les tâches axées sur la planification telles que Countdown et Sudoku, Dream 7B surpasse de manière significative les modèles de taille similaire et approche parfois même les performances de modèles beaucoup plus grands comme DeepSeek V3 671B. Cela met en évidence les capacités de raisonnement exceptionnelles du modèle lorsqu'il traite des contraintes et des objectifs complexes.

Innovations de formation derrière Dream 7B

Le développement de Dream 7B a intégré plusieurs innovations clés qui ont contribué à ses performances exceptionnelles :

Initialisation des poids autorégressive

Plutôt que de s'entraîner à partir de zéro, l'équipe Dream 7B a initialisé le modèle en utilisant les poids du modèle autorégressif Qwen2.5 7B. Cette approche a fourni une base solide de compréhension du langage, réduisant considérablement le temps et les ressources d'entraînement requis. Une sélection minutieuse du taux d'apprentissage était cruciale pour préserver les connaissances précieuses de l'initialisation tout en permettant une formation de diffusion efficace.

Rescheduling du bruit au niveau du token adaptatif au contexte

Une nouvelle technique introduite dans Dream 7B est le mécanisme de rescheduling du bruit au niveau du token adaptatif au contexte. Cette approche réaffecte dynamiquement le niveau de bruit pour chaque token en fonction de ses informations contextuelles, fournissant ainsi des conseils plus précis pour le processus d'apprentissage. Contrairement aux approches d'entraînement par diffusion précédentes qui appliquaient des niveaux de bruit uniformes sur des phrases entières, l'approche plus granulaire de Dream 7B conduit à un apprentissage plus efficace.

Applications pratiques du modèle Dream 7B

Les capacités uniques du modèle Dream 7B permettent une variété d'applications pratiques avec lesquelles les modèles autorégressifs traditionnels ont du mal :

Achèvement et remplissage de texte flexibles

Dream 7B peut générer du texte dans des ordres arbitraires, ce qui le rend particulièrement efficace pour des tâches telles que le remplissage des lacunes dans le contenu existant ou l'achèvement du texte avec des contraintes spécifiques. Le modèle peut même être invité à générer du texte qui se termine par une phrase cible exacte, démontrant ainsi ses capacités de compréhension bidirectionnelle.

Ordre de génération contrôlé

Les utilisateurs peuvent ajuster le comportement de décodage de Dream 7B pour l'adapter à différentes tâches, de la génération plus traditionnelle de gauche à droite à la génération d'ordre entièrement aléatoire. Cette flexibilité rend le modèle adaptable à diverses exigences d'application.

Optimisation qualité-vitesse

La possibilité d'ajuster le nombre d'étapes de diffusion offre un avantage unique pour les applications réelles. Les utilisateurs peuvent choisir moins d'étapes pour des résultats plus rapides et de qualité brouillon ou plus d'étapes pour des résultats de meilleure qualité, ce qui permet une allocation dynamique des ressources en fonction des besoins spécifiques.

Réglage fin supervisé de Dream 7B

Pour améliorer son alignement avec les instructions de l'utilisateur, l'équipe Dream 7B a effectué un réglage fin supervisé à l'aide d'un ensemble de données organisé de 1,8 million de paires d'instructions de Tulu 3 et SmolLM2. Après trois époques de réglage fin, Dream 7B a démontré de solides performances en suivant les instructions de l'utilisateur, comparables à celles des modèles autorégressifs.

Le modèle résultant, Dream-v0-Instruct-7B, est publiquement disponible aux côtés du modèle de base (Dream-v0-Base-7B) pour que les chercheurs et les praticiens puissent expérimenter et s'appuyer dessus.

Exigences techniques pour l'exécution de Dream 7B

La mise en œuvre de Dream 7B nécessite des configurations techniques spécifiques :

- GPU avec au moins 20 Go de mémoire

- Bibliothèque Transformers (version 4.46.2)

- PyTorch (version 2.5.1) avec prise en charge de SdpaAttention

Le modèle prend en charge divers paramètres pour le contrôle de la génération, notamment :

steps: Contrôle les pas de temps de diffusion (moins d'étapes donnent des résultats plus rapides mais plus grossiers)temperature: Module les probabilités du token suivant (valeurs inférieures pour des résultats plus précis, supérieures pour plus de diversité)top_pettop_k: Contrôler la diversité de la générationalg: Détermine la stratégie de remasking dans l'échantillonnage par diffusion

Orientations futures pour la technologie Dream 7B

Le succès de Dream 7B ouvre de nombreuses possibilités pour le développement futur de modèles de langage basés sur la diffusion :

- Mise à l'échelle supplémentaire : Suite aux performances impressionnantes à 7B paramètres, la mise à l'échelle à des tailles plus importantes pourrait potentiellement remettre en question la domination des modèles autorégressifs de premier plan actuels.

- Techniques de post-entraînement avancées : L'équipe prévoit d'explorer des méthodes d'alignement et de réglage des instructions plus sophistiquées, spécialement conçues pour les modèles de langage par diffusion.

- Applications spécialisées : Les capacités de planification uniques et l'inférence flexible de Dream 7B le rendent prometteur pour des applications dans des domaines tels que l'IA incarnée, les agents autonomes et les systèmes de prise de décision à long terme.

- Extensions multimodales : La nature du traitement parallèle des modèles de diffusion pourrait potentiellement être étendue pour gérer plusieurs modalités simultanément.

Conclusion : La promesse de Dream 7B dans le paysage de l'IA

Dream 7B représente une étape importante dans l'évolution des modèles de langage, démontrant que les approches basées sur la diffusion peuvent égaler ou dépasser les méthodes autorégressives traditionnelles tout en offrant des avantages uniques en termes de flexibilité et de capacités de raisonnement.

Alors que le domaine de l'intelligence artificielle continue d'évoluer, des modèles comme Dream 7B remettent en question la sagesse conventionnelle selon laquelle les architectures autorégressives sont l'approche optimale pour la modélisation du langage. Les performances impressionnantes et les capacités uniques de Dream 7B suggèrent que les modèles de langage basés sur la diffusion pourraient jouer un rôle de plus en plus important dans la prochaine génération de systèmes d'IA.

En fournissant à la fois les poids du modèle et le code d'implémentation en tant que ressources open source, l'équipe Dream 7B permet une expérimentation et une innovation plus larges dans cette direction prometteuse, accélérant potentiellement le développement de modèles de langage plus performants, flexibles et efficaces à l'avenir.