Les développeurs du monde entier comptent sur CodeX, le puissant assistant de codage basé sur l'IA d'OpenAI, pour optimiser leurs flux de travail et s'attaquer aux tâches de programmation complexes. Cependant, des discussions récentes sur des plateformes comme X révèlent une préoccupation croissante : de nombreux utilisateurs perçoivent que CodeX fournit des résultats sous-optimaux par rapport à ses performances initiales. Vous rencontrez des bugs frustrants, des réponses plus lentes ou des suggestions de code incomplètes, et vous vous demandez si l'outil a réellement décliné. Cette perception persiste malgré les affirmations d'OpenAI concernant des améliorations continues et des métriques montrant une croissance de l'utilisation.

Les ingénieurs signalent des cas où CodeX a du mal avec des tâches complexes, telles que l'application de correctifs ou la gestion de conversations prolongées, ce qui conduit à des suppositions de dégradation. Pourtant, l'équipe d'OpenAI s'attaque activement à ces problèmes par le biais d'enquêtes rigoureuses, démontrant un engagement envers la transparence. Par exemple, ils ont récemment publié un rapport détaillé décrivant les conclusions des retours d'utilisateurs et des évaluations internes.

Comprendre CodeX : ses fonctionnalités essentielles et son évolution

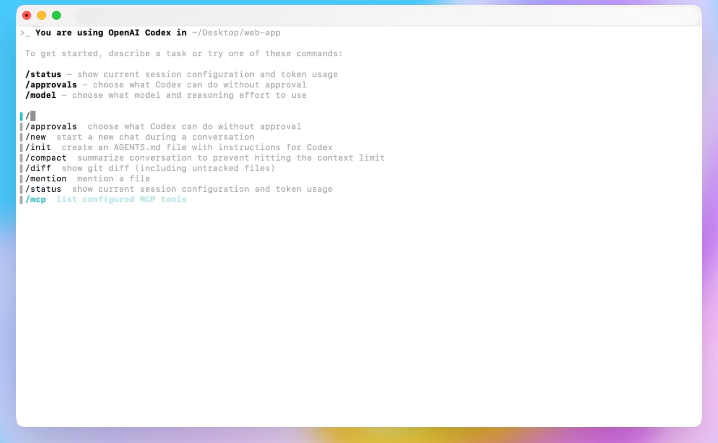

CodeX représente une avancée significative dans la programmation assistée par l'IA, s'appuyant sur les fondations d'OpenAI en matière de grands modèles linguistiques. Les ingénieurs conçoivent CodeX pour interpréter les invites en langage naturel et générer des extraits de code, déboguer les problèmes et même gérer des dépôts entiers. Contrairement aux plugins d'IDE traditionnels, CodeX s'intègre profondément aux interfaces de ligne de commande et aux éditeurs, permettant des interactions fluides.

OpenAI a lancé CodeX comme une évolution de modèles antérieurs tels que Codex, intégrant des améliorations de l'architecture GPT-5. Cette itération se concentre sur la persistance, permettant à l'IA de réessayer des tâches et de s'adapter aux retours des utilisateurs au sein des sessions. Par conséquent, les développeurs utilisent CodeX pour diverses applications, de l'écriture de scripts simples aux intégrations de systèmes complexes.

Cependant, à mesure que l'adoption croît, les utilisateurs repoussent les limites de CodeX. Par exemple, les tâches initiales peuvent impliquer des fonctions de base, mais les utilisateurs avancés tentent des modifications multi-fichiers ou des orchestrations d'API. Ce changement révèle des limitations, soulevant des questions sur la cohérence des performances.

De plus, CodeX utilise des outils comme `apply_patch` pour les modifications de fichiers et la compaction pour la gestion du contexte. Ces fonctionnalités améliorent l'utilisabilité mais introduisent des variables qui affectent les résultats. Lorsque vous saisissez une invite, CodeX la traite via une API de réponses, qui diffuse des jetons et analyse les résultats. Toute divergence dans ce pipeline peut se manifester par une perception de simplification excessive.

Rapports d'utilisateurs : signes que CodeX pourrait sous-performer

Les utilisateurs partagent activement leurs expériences sur les plateformes sociales, soulignant les cas où CodeX ne répond pas aux attentes. Par exemple, un développeur sur X a noté que CodeX excelle dans les tâches initiales mais a du mal avec la complexité croissante, ce qui conduit à des suppositions de dégradation du modèle.

Plus précisément, les rapports incluent des cas où CodeX génère des différences incorrectes lors de l'application de correctifs, entraînant des suppressions et des recréations de fichiers. Ce comportement perturbe les flux de travail, en particulier lors de sessions interrompues. Une autre plainte courante concerne la latence ; les tâches qui étaient auparavant effectuées rapidement s'étendent désormais en raison de nouvelles tentatives avec des délais d'attente prolongés.

De plus, les utilisateurs observent des changements de langue en cours de réponse, comme le passage de l'anglais au coréen, attribués à des bugs dans l'échantillonnage contraint. Ces anomalies affectent moins de 0,25 % des sessions mais amplifient la frustration lorsqu'elles sont rencontrées.

En outre, la compaction — une fonctionnalité qui résume les conversations pour gérer le contexte — fait l'objet de critiques. À mesure que les sessions s'allongent, plusieurs compactions dégradent la précision, ce qui incite OpenAI à ajouter des avertissements : démarrez de nouvelles conversations pour des interactions ciblées.

De plus, les variations matérielles y contribuent ; les configurations plus anciennes entraînent de légères baisses de performances, impactant la rétention. Les développeurs ayant des forfaits premium signalent des incohérences, bien que les métriques montrent une croissance globale.

En passant de ces rapports, l'analyse des preuves quantitatives apporte de la clarté sur la question de savoir si ces problèmes indiquent une véritable dégradation ou une évolution de l'utilisation.

Analyse des preuves : métriques, retours et modèles d'utilisation

OpenAI collecte des données étendues sur les performances de CodeX, y compris des évaluations sur différentes versions de CLI et de matériel. Les évaluations confirment des améliorations, telles qu'une réduction de 10 % de l'utilisation des jetons après les mises à jour de CLI 0.45, sans régressions dans les tâches principales.

Cependant, les retours des utilisateurs via la commande `/feedback` révèlent des tendances. Les ingénieurs trient plus de 100 problèmes par jour, les liant à des matériels ou des fonctionnalités spécifiques. Les modèles prédictifs corrèlent la rétention avec des facteurs comme le système d'exploitation et le type de forfait, identifiant le matériel comme un coupable mineur.

De plus, l'analyse des sessions montre une utilisation accrue de la compaction au fil du temps, corrélée à des baisses de performances. Les évaluations quantifient cela : la précision diminue avec des compactions répétées.

De plus, l'intégration de la recherche web (`--search`) et les changements d'invites sur deux mois ne montrent aucun impact négatif. Pourtant, les inefficacités du cache d'authentification ajoutent 50 ms de latence par requête, ce qui accentue les perceptions des utilisateurs.

De plus, l'utilisation évolue ; de plus en plus de développeurs emploient des outils MCP, augmentant la complexité de la configuration. OpenAI recommande des configurations minimalistes pour des résultats optimaux.

Par conséquent, les preuves suggèrent que les perceptions proviennent du fait de pousser CodeX sur des tâches plus difficiles plutôt que d'une simplification inhérente. Comme l'a résumé un utilisateur de X, « CodeX est si bon que les gens ont continué à l'utiliser pour des tâches plus difficiles et il ne les a pas aussi bien réussies, puis les gens ont simplement supposé que le modèle s'était dégradé. »

Cette analyse prépare le terrain pour la réponse d'investigation d'OpenAI, qui aborde ces points directement.

Réponse d'OpenAI : l'enquête transparente sur les performances de CodeX

OpenAI s'engage à la transparence, promettant d'enquêter sérieusement sur les rapports de dégradation. Tibo, un membre de l'équipe Codex, a annoncé l'enquête sur X, décrivant un plan pour améliorer les mécanismes de feedback, standardiser l'utilisation interne et exécuter des évaluations supplémentaires.

Les ingénieurs ont agi rapidement, publiant la CLI 0.50 avec un `/feedback` amélioré, liant les problèmes aux clusters et au matériel. Ils ont supprimé plus de 60 indicateurs de fonctionnalité, simplifiant la pile.

De plus, une équipe dédiée a émis des hypothèses et testé des problèmes quotidiennement. Cette approche a permis de découvrir des correctifs, allant du retrait de matériel plus ancien à l'amélioration de la compaction.

De plus, OpenAI a partagé un rapport complet intitulé « Ghosts in the Codex Machine », détaillant les conclusions sans régressions majeures mais reconnaissant des facteurs combinés.

En outre, ils ont réinitialisé les limites de débit et remboursé les crédits en raison d'un bug de facturation, démontrant des actions centrées sur l'utilisateur.

Passant aux spécificités, les principales conclusions du rapport éclairent les nuances techniques derrière les préoccupations des utilisateurs.

Principales conclusions du rapport de dégradation de CodeX d'OpenAI

Le rapport conclut qu'il n'existe pas de problème majeur unique ; au lieu de cela, des changements de comportement et des problèmes mineurs s'accumulent. Pour le matériel, les évaluations et les modèles ont identifié des unités plus anciennes, ce qui a conduit à leur suppression et à des optimisations de l'équilibrage de charge.

En ce qui concerne la compaction, une fréquence plus élevée au fil du temps dégrade les sessions. OpenAI a amélioré les implémentations pour éviter les résumés récursifs et a ajouté des incitations pour les utilisateurs.

Pour `apply_patch`, de rares échecs entraînent des suppressions risquées ; des mesures d'atténuation limitent de telles séquences, avec des améliorations du modèle prévues.

Les délais d'attente ne montrent pas de régressions générales — la latence s'améliore — mais des tentatives inefficaces persistent. Les investissements visent une meilleure gestion des processus longs.

Un bug d'échantillonnage contraint provoque des jetons hors distribution, qui sera corrigé de manière imminente.

Les audits de l'API de réponses révèlent des changements mineurs d'encodage sans impact sur les performances.

D'autres sondes, comme les évaluations sur les versions de CLI et les invites, confirment la stabilité.

De plus, les configurations évolutives avec davantage d'outils recommandent la simplicité.

Ces conclusions valident les expériences des utilisateurs tout en ne prouvant aucune simplification globale.

Améliorations mises en œuvre et orientations futures pour CodeX

OpenAI agit sur les conclusions, déployant des correctifs tels que des avertissements de compaction et des corrections d'échantillonnage. Les purges matérielles et les réductions de latence améliorent la fiabilité.

De plus, ils forment une équipe permanente pour surveiller les performances réelles, recrutant des talents pour des optimisations continues.

De plus, la socialisation des retours augmente, assurant un apport continu.

Les travaux futurs incluent des améliorations de la persistance du modèle et de l'adaptabilité des outils.

Par conséquent, CodeX évolue, abordant les perceptions par des améliorations basées sur les données.

Cependant, en attendant ces améliorations, les développeurs recherchent des compléments comme Apidog.

Outils complémentaires : comment Apidog améliore les flux de travail de CodeX

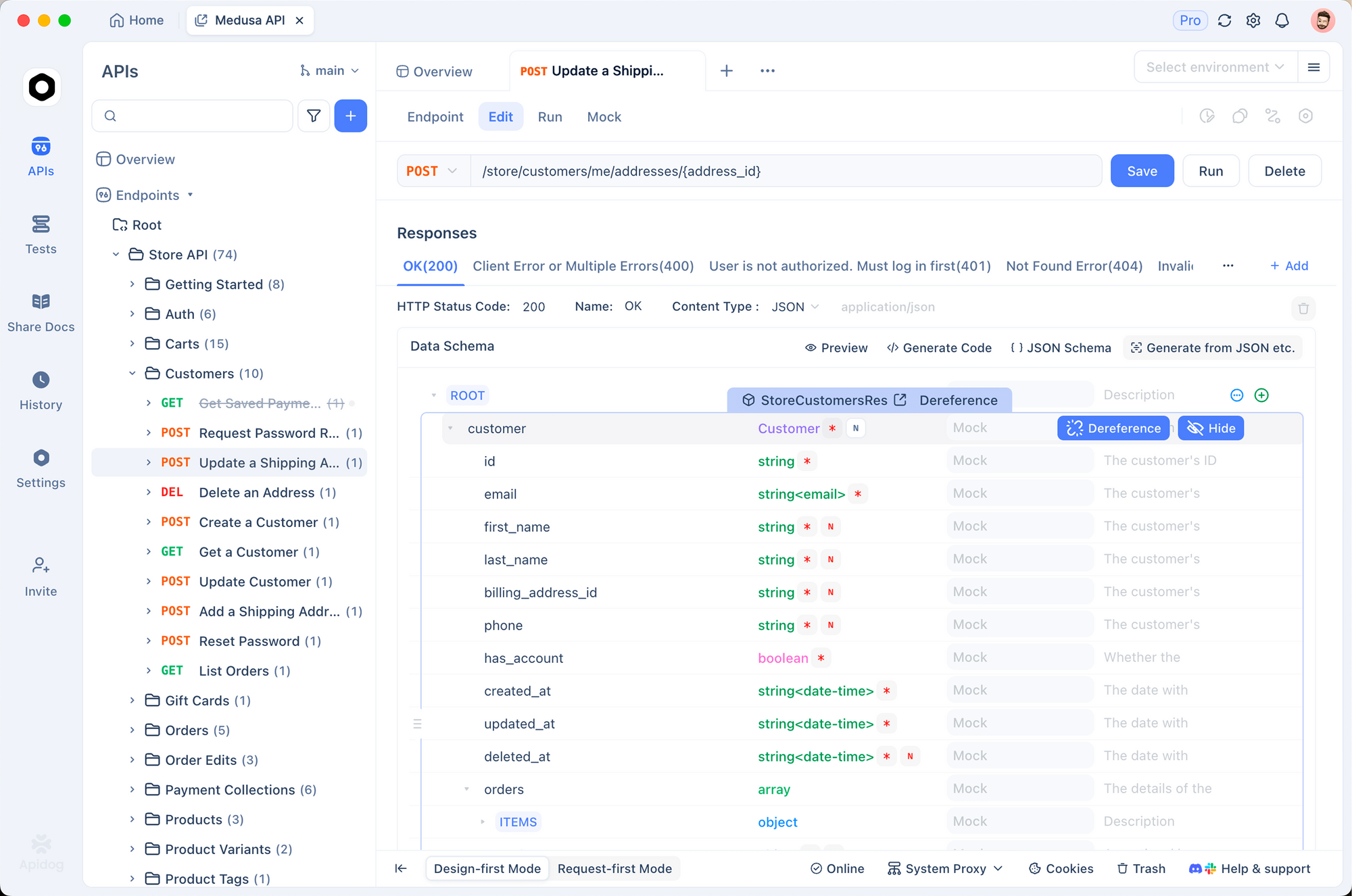

Lorsque CodeX gère des tâches d'API, des incohérences surviennent, en particulier dans les intégrations. Apidog, une plateforme API robuste, comble cette lacune.

Les développeurs utilisent Apidog pour concevoir, tester et documenter des API, garantissant que le code généré par CodeX fonctionne correctement.

Par exemple, simulez des points d'extrémité dans Apidog avant l'implémentation de CodeX, réduisant ainsi les erreurs.

De plus, le téléchargement gratuit d'Apidog offre des fonctionnalités de collaboration, de versioning et d'automatisation — idéal pour les équipes confrontées aux limitations de CodeX.

Passant en douceur, Apidog s'intègre aux environnements de codage, validant les sorties de l'IA.

Ainsi, associer CodeX à Apidog optimise le développement, atténuant les dégradations perçues.

Études de cas : exemples concrets tirés des discussions sur X

Les fils de discussion sur X fournissent des exemples frappants. Un utilisateur a souligné que le succès de CodeX engendrait une ambition excessive, faisant écho à l'évolution de l'utilisation décrite dans le rapport.

Un autre a discuté de la vitesse de la CLI, passant à des alternatives pour des tâches rapides, soulignant les préoccupations de latence.

De plus, les réinitialisations de facturation ont résolu les surcharges, rétablissant la confiance.

Ces anecdotes, combinées aux données du rapport, illustrent des problèmes multifacettes.

Bonnes pratiques pour maximiser les performances de CodeX

Pour contrer les perceptions, adoptez des pratiques : gardez les sessions courtes, minimisez les outils, utilisez `/feedback`.

De plus, surveillez les mises à jour ; les améliorations de la CLI ont un impact direct sur les résultats.

En outre, expérimentez avec les invites pour plus de précision.

Par conséquent, ces étapes améliorent les expériences.

Conclusion : adopter le changement dans CodeX et au-delà

Les utilisateurs perçoivent CodeX comme moins performant en raison de tâches complexes et de problèmes mineurs, mais les preuves montrent une évolution, pas un déclin. L'enquête et les correctifs d'OpenAI confirment leur engagement.

De plus, l'intégration d'Apidog assure des flux de travail résilients.

En fin de compte, adaptez vos stratégies, exploitez les outils et contribuez avec vos retours — de petits ajustements génèrent des gains significatifs en productivité.