Dans le monde des applications basées sur l'IA, l'API Claude d'Anthropic est devenue une solution incontournable pour de nombreux développeurs à la recherche de capacités avancées de traitement du langage. Cependant, comme pour tout service populaire, vous êtes susceptible de rencontrer des limites de débit qui peuvent temporairement interrompre les fonctionnalités de votre application. Comprendre ces limites et mettre en œuvre des stratégies pour travailler avec elles est crucial pour maintenir une expérience utilisateur fluide.

Pour le codage IA, Claude est apparu comme un assistant puissant pour les utilisateurs occasionnels et les développeurs. Cependant, de nombreux utilisateurs rencontrent une frustration courante : les limites de débit.

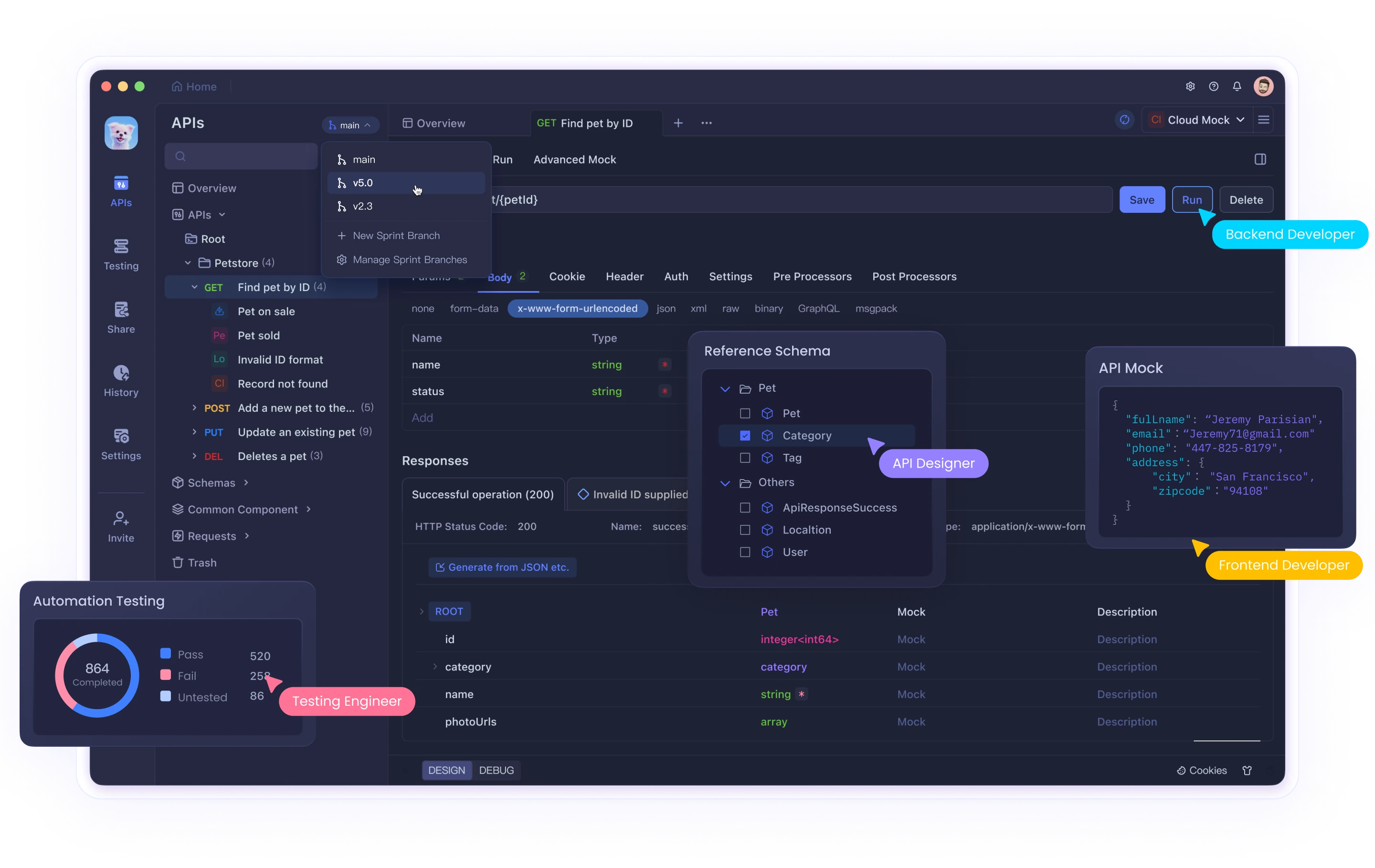

Que vous utilisiez l'interface web de Claude ou que vous l'intégriez à son API via des outils comme Cursor ou Cline, atteindre ces limites peut perturber votre flux de travail et votre productivité. Bien que des outils comme Claude offrent de puissantes capacités d'IA, la gestion efficace des interactions avec l'API nécessite des outils de test et de débogage appropriés. Apidog aide les développeurs à naviguer dans ces complexités lorsqu'ils travaillent avec l'IA et d'autres API.

Ce guide complet explorera pourquoi les limites de débit de l'API Claude existent, comment identifier quand vous les avez atteintes et fournira trois solutions détaillées pour vous aider à surmonter efficacement ces défis.

Quelles sont les limites de débit de l'API Claude et pourquoi existent-elles ?

Les limites de débit sont des restrictions imposées par les fournisseurs d'API pour contrôler le volume de requêtes qu'un utilisateur peut effectuer dans un délai spécifique. Anthropic met en œuvre ces limites pour plusieurs raisons importantes :

- Gestion des ressources du serveur : empêcher un seul utilisateur de consommer trop de ressources informatiques

- Accès équitable : garantir une répartition équitable de l'accès à l'API entre tous les utilisateurs

- Prévention des abus : protection contre les activités malveillantes telles que le scraping ou les attaques DDoS

- Stabilité du service : maintien des performances globales du système pendant les périodes de forte utilisation

Limites de débit spécifiques de l'API Claude

Les limites de débit de Claude varient en fonction de votre type de compte :

- Utilisateurs gratuits : environ 100 messages par jour, avec le quota réinitialisé à minuit

- Utilisateurs Pro : environ cinq fois la limite des utilisateurs gratuits (environ 500 messages par jour)

- Utilisateurs de l'API : limites personnalisées en fonction de votre plan et de vos accords spécifiques avec Anthropic

De plus, pendant les périodes de forte utilisation, ces limites peuvent être appliquées plus strictement et vous pouvez subir une limitation temporaire avant même d'atteindre votre allocation maximale.

Identification des problèmes de limite de débit

Vous avez probablement atteint une limite de débit lorsque votre application reçoit un code d'état HTTP 429 Too Many Requests. La réponse comprend généralement des en-têtes avec des informations sur :

- Quand vous pouvez reprendre les requêtes

- Vos statistiques d'utilisation actuelles

- Informations sur le quota restant

Solution 1 : implémenter une limitation de débit appropriée dans votre code

L'approche la plus fondamentale pour gérer les limites de débit de l'API consiste à implémenter une limitation de débit côté client. Cela empêche de manière proactive votre application de dépasser le volume de requêtes autorisé.

Utilisation d'un algorithme de seau de jetons

Le seau de jetons est un algorithme populaire pour la limitation de débit qui fonctionne comme suit :

- Maintien d'un « seau » qui se remplit de jetons à un rythme constant

- Consommation d'un jeton pour chaque requête d'API

- Blocage des requêtes lorsqu'aucun jeton n'est disponible

Voici une implémentation Python :

import time

import threading

class TokenBucket:

def __init__(self, tokens_per_second, max_tokens):

self.tokens_per_second = tokens_per_second

self.max_tokens = max_tokens

self.tokens = max_tokens

self.last_refill = time.time()

self.lock = threading.Lock()

def _refill_tokens(self):

now = time.time()

elapsed = now - self.last_refill

new_tokens = elapsed * self.tokens_per_second

self.tokens = min(self.max_tokens, self.tokens + new_tokens)

self.last_refill = now

def get_token(self):

with self.lock:

self._refill_tokens()

if self.tokens >= 1:

self.tokens -= 1

return True

return False

def wait_for_token(self, timeout=None):

start_time = time.time()

while True:

if self.get_token():

return True

if timeout is not None and time.time() - start_time > timeout:

return False

time.sleep(0.1) # Sleep to avoid busy waiting

# Example usage with Claude API

import anthropic

# Create a rate limiter (5 requests per second, max burst of 10)

rate_limiter = TokenBucket(tokens_per_second=5, max_tokens=10)

client = anthropic.Anthropic(api_key="your_api_key")

def generate_with_claude(prompt):

# Wait for a token to become available

if not rate_limiter.wait_for_token(timeout=30):

raise Exception("Timed out waiting for rate limit token")

try:

response = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1000,

messages=[{"role": "user", "content": prompt}]

)

return response.content

except Exception as e:

if "429" in str(e):

print("Rate limit hit despite our rate limiting! Backing off...")

time.sleep(10) # Additional backoff

return generate_with_claude(prompt) # Retry

raise

Cette implémentation :

- Crée un seau de jetons qui se remplit à un rythme constant

- Attend que les jetons soient disponibles avant de faire des requêtes

- Met en œuvre un repli supplémentaire si des limites de débit sont toujours rencontrées

Gestion des réponses 429 avec repli exponentiel

Même avec une limitation de débit proactive, vous pourriez occasionnellement atteindre des limites. L'implémentation d'un repli exponentiel aide votre application à récupérer en douceur :

import time

import random

def call_claude_api_with_backoff(prompt, max_retries=5, base_delay=1):

retries = 0

while retries <= max_retries:

try:

# Wait for rate limiter token

rate_limiter.wait_for_token()

# Make the API call

response = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1000,

messages=[{"role": "user", "content": prompt}]

)

return response.content

except Exception as e:

if "429" in str(e) and retries < max_retries:

# Calculate delay with exponential backoff and jitter

delay = base_delay * (2 ** retries) + random.uniform(0, 0.5)

print(f"Rate limited. Retrying in {delay:.2f} seconds...")

time.sleep(delay)

retries += 1

else:

raise

raise Exception("Max retries exceeded")

Cette fonction :

- Tente d'effectuer l'appel d'API

- Si une erreur 429 se produit, elle attend un temps croissant de manière exponentielle

- Ajoute une gigue aléatoire pour empêcher la synchronisation des requêtes

- Abandonne après un nombre maximal de tentatives

Solution 2 : implémenter la mise en file d'attente et la priorisation des requêtes

Pour les applications avec différents niveaux d'importance des requêtes, l'implémentation d'une file d'attente de requêtes avec gestion des priorités peut optimiser votre utilisation de l'API.

Création d'un système de file d'attente prioritaire

import heapq

import threading

import time

from dataclasses import dataclass, field

from typing import Any, Callable, Optional

@dataclass(order=True)

class PrioritizedRequest:

priority: int

execute_time: float = field(compare=False)

callback: Callable = field(compare=False)

args: tuple = field(default_factory=tuple, compare=False)

kwargs: dict = field(default_factory=dict, compare=False)

class ClaudeRequestQueue:

def __init__(self, requests_per_minute=60):

self.queue = []

self.lock = threading.Lock()

self.processing = False

self.requests_per_minute = requests_per_minute

self.interval = 60 / requests_per_minute

def add_request(self, callback, priority=0, delay=0, *args, **kwargs):

"""Add a request to the queue with the given priority."""

with self.lock:

execute_time = time.time() + delay

request = PrioritizedRequest(

priority=-priority, # Negate so higher values have higher priority

execute_time=execute_time,

callback=callback,

args=args,

kwargs=kwargs

)

heapq.heappush(self.queue, request)

if not self.processing:

self.processing = False

threading.Thread(target=self._process_queue, daemon=True).start()

def _process_queue(self):

"""Process requests from the queue, respecting rate limits."""

while True:

with self.lock:

if not self.queue:

self.processing = False

return

# Get the highest priority request that's ready to execute

request = self.queue[0]

now = time.time()

if request.execute_time > now:

# Wait until the request is ready

wait_time = request.execute_time - now

time.sleep(wait_time)

continue

# Remove the request from the queue

heapq.heappop(self.queue)

# Execute the request outside the lock

try:

request.callback(*request.args, **request.kwargs)

except Exception as e:

print(f"Error executing request: {e}")

# Wait for the rate limit interval

time.sleep(self.interval)

# Example usage

queue = ClaudeRequestQueue(requests_per_minute=60)

def process_result(result, callback):

print(f"Got result: {result[:50]}...")

if callback:

callback(result)

def make_claude_request(prompt, callback=None, priority=0):

def execute():

try:

response = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1000,

messages=[{"role": "user", "content": prompt}]

)

process_result(response.content, callback)

except Exception as e:

if "429" in str(e):

# Re-queue with a delay if rate limited

print("Rate limited, re-queuing...")

queue.add_request(

make_claude_request,

priority=priority-1, # Lower priority for retries

delay=10, # Wait 10 seconds before retrying

prompt=prompt,

callback=callback,

priority=priority

)

else:

print(f"Error: {e}")

queue.add_request(execute, priority=priority)

# Make some requests with different priorities

make_claude_request("High priority question", priority=10)

make_claude_request("Medium priority question", priority=5)

make_claude_request("Low priority question", priority=1)

Cette implémentation :

- Crée une file d'attente prioritaire pour les requêtes d'API

- Traite les requêtes en fonction de la priorité et de l'heure d'exécution prévue

- Régule automatiquement les requêtes pour rester en dessous des limites de débit

- Gère les nouvelles tentatives avec une priorité décroissante

Solution 3 : distribuer les requêtes sur plusieurs instances

Pour les applications à volume élevé, la distribution des requêtes de l'API Claude sur plusieurs instances peut vous aider à dépasser les limites d'un seul compte.

Équilibrage de la charge sur plusieurs clés API

import random

import threading

from datetime import datetime, timedelta

class APIKeyManager:

def __init__(self, api_keys, requests_per_day_per_key):

self.api_keys = {}

self.lock = threading.Lock()

# Initialize each API key's usage tracking

for key in api_keys:

self.api_keys[key] = {

'key': key,

'daily_limit': requests_per_day_per_key,

'used_today': 0,

'last_reset': datetime.now().date(),

'available': True

}

def _reset_daily_counters(self):

"""Reset daily counters if it's a new day."""

today = datetime.now().date()

for key_info in self.api_keys.values():

if key_info['last_reset'] < today:

key_info['used_today'] = 0

key_info['last_reset'] = today

key_info['available'] = True

def get_available_key(self):

"""Get an available API key that hasn't exceeded its daily limit."""

with self.lock:

self._reset_daily_counters()

available_keys = [

key_info for key_info in self.api_keys.values()

if key_info['available'] and key_info['used_today'] < key_info['daily_limit']

]

if not available_keys:

return None

# Choose a key with the fewest used requests today

selected_key = min(available_keys, key=lambda k: k['used_today'])

selected_key['used_today'] += 1

# If key has reached its limit, mark as unavailable

if selected_key['used_today'] >= selected_key['daily_limit']:

selected_key['available'] = False

return selected_key['key']

def mark_key_used(self, api_key):

"""Mark that a request was made with this key."""

with self.lock:

if api_key in self.api_keys:

self.api_keys[api_key]['used_today'] += 1

if self.api_keys[api_key]['used_today'] >= self.api_keys[api_key]['daily_limit']:

self.api_keys[api_key]['available'] = False

def mark_key_rate_limited(self, api_key, retry_after=60):

"""Mark a key as temporarily unavailable due to rate limiting."""

with self.lock:

if api_key in self.api_keys:

self.api_keys[api_key]['available'] = False

# Start a timer to mark the key available again after the retry period

def make_available_again():

with self.lock:

if api_key in self.api_keys:

self.api_keys[api_key]['available'] = True

timer = threading.Timer(retry_after, make_available_again)

timer.daemon = True

timer.start()

# Example usage

api_keys = [

"key1_abc123",

"key2_def456",

"key3_ghi789"

]

key_manager = APIKeyManager(api_keys, requests_per_day_per_key=100)

def call_claude_api_distributed(prompt):

api_key = key_manager.get_available_key()

if not api_key:

raise Exception("No available API keys - all have reached their daily limits")

client = anthropic.Anthropic(api_key=api_key)

try:

response = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1000,

messages=[{"role": "user", "content": prompt}]

)

return response.content

except Exception as e:

if "429" in str(e):

# Parse retry-after header if available, otherwise use default

retry_after = 60 # Default

key_manager.mark_key_rate_limited(api_key, retry_after)

# Recursively try again with a different key

return call_claude_api_distributed(prompt)

else:

raise

Cette approche :

- Gère plusieurs clés API et suit leur utilisation

- Distribue les requêtes pour rester en dessous des limites de débit par clé

- Gère les réponses de limite de débit en supprimant temporairement les clés affectées de la rotation

- Réinitialise automatiquement les compteurs d'utilisation quotidiennement

Meilleures pratiques pour la gestion des limites de débit de l'API Claude

Au-delà des trois solutions ci-dessus, voici quelques bonnes pratiques supplémentaires :

Surveillez votre utilisation de manière proactive

- Implémentez des tableaux de bord pour suivre votre utilisation de l'API

- Configurez des alertes lorsque vous approchez des limites de débit

- Examinez régulièrement les modèles d'utilisation pour identifier les opportunités d'optimisation

Implémenter une dégradation gracieuse

- Concevez votre application pour fournir des réponses alternatives en cas de limitation de débit

- Envisagez de mettre en cache les réponses précédentes pour des requêtes similaires

- Fournissez des commentaires transparents aux utilisateurs en cas de limites de débit

Optimisez vos invites

- Réduisez les appels d'API inutiles en créant des invites plus efficaces

- Combinez les requêtes associées en une seule requête dans la mesure du possible

- Prétraitez les entrées pour éliminer le besoin de demandes de clarification

Communiquez avec Anthropic

- Pour les applications de production, envisagez de passer à des plans de niveau supérieur

- Contactez Anthropic au sujet des limites de débit personnalisées pour votre cas d'utilisation spécifique

- Restez informé des mises à jour de la plateforme et des modifications des politiques de limitation de débit

Conclusion

Les limites de débit font inévitablement partie du travail avec toute API puissante comme Claude. En mettant en œuvre les solutions décrites dans cet article : code de limitation de débit approprié, mise en file d'attente des requêtes et gestion des requêtes distribuées, vous pouvez créer des applications robustes qui gèrent avec élégance ces limitations.

N'oubliez pas que les limites de débit existent pour garantir un accès équitable et la stabilité du système pour tous les utilisateurs. Travailler dans ces limites améliore non seulement la fiabilité de votre application, mais contribue également à la santé globale de l'écosystème.

Avec une planification et une mise en œuvre minutieuses de ces stratégies, vous pouvez maximiser votre utilisation des puissantes capacités d'IA de Claude tout en maintenant une expérience fluide pour vos utilisateurs, même lorsque votre application évolue.