Souhaitez-vous connecter votre modèle de langage volumineux (LLM) préféré à une boîte à outils de superpouvoirs, comme le web scraping ou les opérations sur fichiers, sans vous emmêler dans le code ? C’est là qu’intervient MCP-Use : une bibliothèque Python open source élégante qui vous permet de connecter n’importe quel LLM à n’importe quel serveur MCP avec facilité. Considérez-la comme un adaptateur universel pour vos rêves d’IA alimentés par API ! Dans ce guide du débutant, je vais vous expliquer comment utiliser MCP-Use pour relier les LLM et les serveurs Model Context Protocol (MCP). Que vous soyez codeur ou simplement curieux, ce tutoriel est fait pour vous. Prêt à faire de votre LLM une rockstar multitâche ? Plongeons-nous !

Maintenant, passons à la magie de MCP-Use…

Qu’est-ce que MCP-Use ? Votre connecteur IA-outil

Alors, qu’est-ce que MCP-Use ? C’est une bibliothèque Python qui agit comme un pont, permettant à n’importe quel LLM (pensez à Claude, GPT-4o ou DeepSeek) de communiquer avec les serveurs MCP, des outils spécialisés qui donnent à l’IA accès à des éléments tels que les navigateurs Web, les systèmes de fichiers ou même les recherches Airbnb. Basé sur les adaptateurs LangChain, MCP-Use simplifie la connexion de l’API de votre LLM à ces serveurs, afin que vous puissiez créer des agents personnalisés qui font plus que simplement discuter. Les utilisateurs l’appellent « la méthode open source pour créer des clients MCP locaux », et ils n’ont pas tort : c’est 100 % gratuit et flexible.

Pourquoi s’embêter ? Les serveurs MCP sont comme des ports USB pour l’IA, permettant à votre LLM d’appeler des fonctions, d’extraire des données ou d’automatiser des tâches via des interfaces de type API standardisées. Avec MCP-Use, vous n’avez pas besoin de vous battre avec des intégrations personnalisées : il suffit de brancher et de jouer. Commençons !

Installation de MCP-Use : rapide et indolore

L’exécution de MCP-Use est un jeu d’enfant, surtout si vous êtes à l’aise avec Python. Le référentiel GitHub (github.com/pietrozullo/mcp-use) l’explique clairement. Voici comment commencer.

Étape 1 : Prérequis

Vous aurez besoin de :

- Python : version 3.11 ou supérieure. Vérifiez avec

python --version. Pas de Python ? Récupérez-le sur python.org.

- pip : le gestionnaire de paquets de Python (généralement fourni avec Python).

- Git (facultatif) : pour cloner le référentiel si vous souhaitez le dernier code.

- API Keys : pour les LLM premium comme OpenAI ou Anthropic. Nous aborderons ce point plus tard.

Étape 2 : Installer MCP-Use

Utilisons pip dans un environnement virtuel pour que tout soit bien rangé :

Créer un dossier de projet :

mkdir mcp-use-project

cd mcp-use-project

Configurer un environnement virtuel :

python -m venv mcp-env

Activez-le :

- Mac/Linux :

source mcp-env/bin/activate - Windows :

mcp-env\Scripts\activate

Installer MCP-Use :

pip install mcp-use

Ou, si vous souhaitez la version de pointe, clonez le référentiel :

git clone https://github.com/pietrozullo/mcp-use.git

cd mcp-use

pip install .

Ajouter des fournisseurs LangChain :

MCP-Use s’appuie sur LangChain pour les connexions LLM. Installez le fournisseur pour votre LLM :

- OpenAI :

pip install langchain-openai - Anthropic :

pip install langchain-anthropic - Autres : consultez la documentation des modèles de chat de LangChain.

Vérifier l’installation :

Exécutez :

python -c "import mcp_use; print(mcp_use.__version__)"

Vous devriez voir un numéro de version (par exemple, 0.42.1 en avril 2025). Sinon, vérifiez votre version de Python ou pip.

C’est tout ! MCP-Use est prêt à connecter votre LLM aux serveurs MCP. Cela m’a pris environ cinq minutes, comment se passe votre configuration ?

Connecter un LLM à un serveur MCP avec MCP-Use

Maintenant, faisons en sorte que la magie opère : connecter un LLM à un serveur MCP à l’aide de MCP-Use. Nous allons utiliser un exemple simple : connecter GPT-4o d’OpenAI à un serveur Playwright MCP pour la navigation Web.

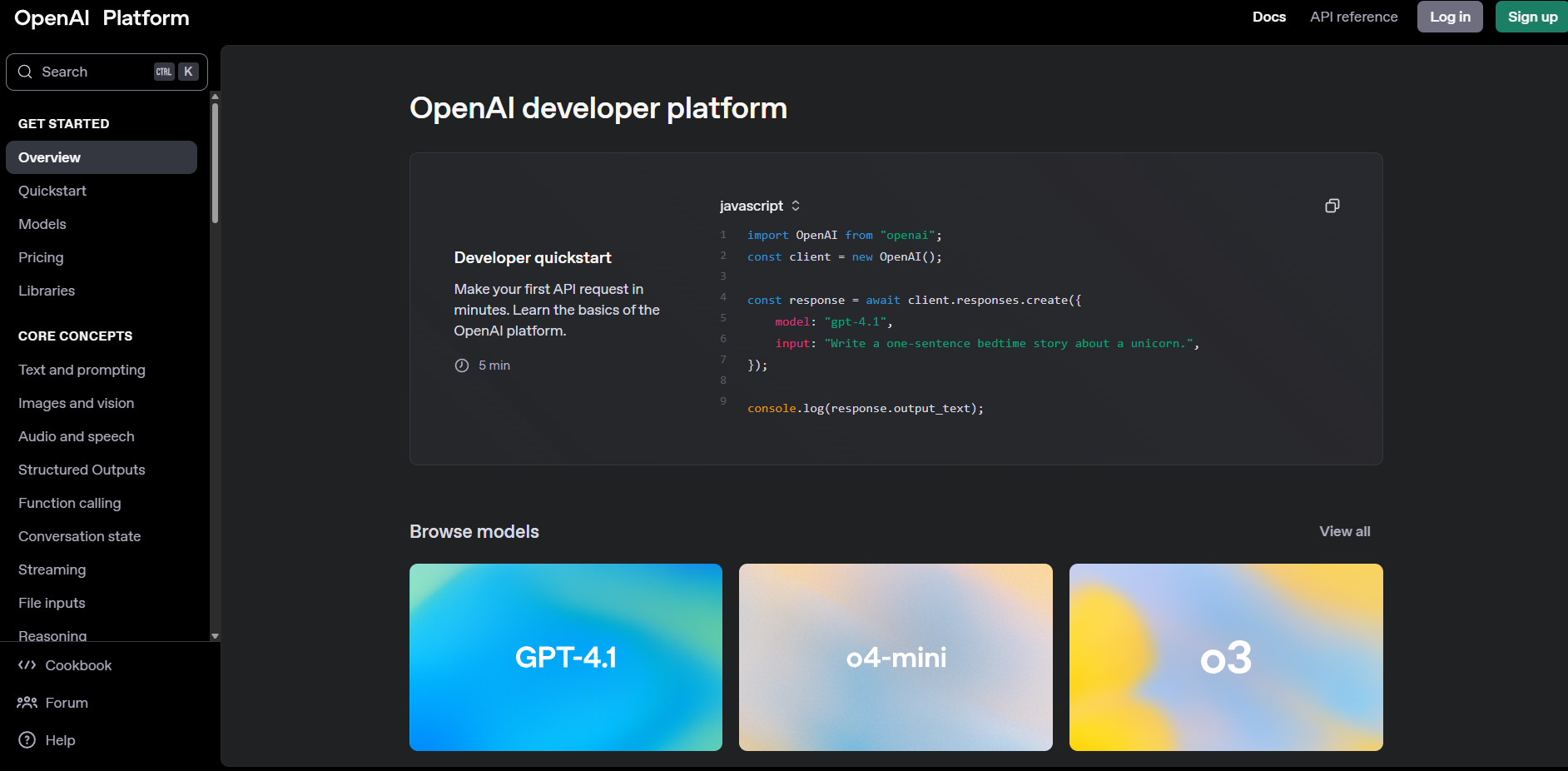

Étape 1 : Obtenez votre clé API LLM

Pour GPT-4o, récupérez une clé API sur platform.openai.com. Inscrivez-vous, créez une clé et enregistrez-la en toute sécurité. D’autres LLM comme Claude (via console.anthropic.com) ou DeepSeek (sur la plateforme Deepseek) fonctionneront également.

Étape 2 : Configurer les variables d’environnement

MCP-Use adore les fichiers .env pour le stockage sécurisé des clés API. Créez un fichier .env dans votre dossier de projet :

touch .env

Ajoutez votre clé et enregistrez-la :

OPENAI_API_KEY=sk-xxx

Important : gardez vos API_Keys hors de Git en ajoutant le fichier .env à .gitignore.

Étape 3 : Configurer le serveur MCP

Les serveurs MCP fournissent des outils que votre LLM peut utiliser. Nous allons utiliser le serveur Playwright MCP pour l’automatisation du navigateur. Créez un fichier de configuration appelé browser_mcp.json :

{

"mcpServers": {

"playwright": {

"command": "npx",

"args": ["@playwright/mcp@latest"],

"env": {

"DISPLAY": ":1"

}

}

}

}

Cela indique à MCP-Use d’exécuter le serveur MCP de Playwright. Enregistrez-le dans votre dossier de projet.

Étape 4 : Écrivez votre premier script MCP-Use

Créons un script Python pour connecter GPT-4o au serveur Playwright et trouver un restaurant. Créez mcp_example.py :

import asyncio

import os

from dotenv import load_dotenv

from langchain_openai import ChatOpenAI

from mcp_use import MCPAgent, MCPClient

async def main():

# Load environment variables

load_dotenv()

# Create MCPClient from config file

client = MCPClient.from_config_file("browser_mcp.json")

# Create LLM (ensure model supports tool calling)

llm = ChatOpenAI(model="gpt-4o")

# Create agent

agent = MCPAgent(llm=llm, client=client, max_steps=30)

# Run a query

result = await agent.run("Find the best restaurant in San Francisco")

print(f"\nResult: {result}")

if __name__ == "__main__":

asyncio.run(main())

Ce script :

- Charge votre clé API à partir de

.env. - Configure un client MCP avec le serveur Playwright.

- Connecte GPT-4o via LangChain.

- Exécute une requête pour rechercher des restaurants.

Étape 5 : Exécutez-le

Assurez-vous que votre environnement virtuel est actif, puis :

python mcp_example.py

MCP-Use lancera le serveur Playwright, permettra à GPT-4o de naviguer sur le Web et imprimera quelque chose comme : « Résultat : le meilleur restaurant de San Francisco est Gary Danko, connu pour son menu dégustation exquis. » (Vos résultats peuvent varier !) J’ai exécuté cela et j’ai obtenu une recommandation solide en moins d’une minute, c’est plutôt cool, non ?

Connexion à plusieurs serveurs MCP

MCP-Use brille lorsque vous vous connectez à plusieurs serveurs pour des tâches complexes. Ajoutons un serveur Airbnb MCP à notre configuration pour les recherches d’hébergement. Mettez à jour browser_mcp.json :

{

"mcpServers": {

"playwright": {

"command": "npx",

"args": ["@playwright/mcp@latest"],

"env": {

"DISPLAY": ":1"

}

},

"airbnb": {

"command": "npx",

"args": ["-y", "@openbnb/mcp-server-airbnb", "--ignore-robots-txt"]

}

}

}

Réexécutez mcp_example.py avec une nouvelle requête :

result = await agent.run("Find a restaurant and an Airbnb in San Francisco")

MCP-Use permet au LLM d’utiliser les deux serveurs : Playwright pour les recherches de restaurants, Airbnb pour l’hébergement. L’agent décide quel serveur appeler, ce qui rend votre IA super polyvalente.

Pourquoi MCP-Use est génial pour les débutants

MCP-Use est le rêve d’un débutant car :

- Configuration simple : un

pip installet un court script vous permettent de démarrer. - Flexible : fonctionne avec n’importe quel LLM et serveur MCP, de Claude au suivi des problèmes de GitHub.

- Open Source : gratuit et personnalisable, avec une communauté GitHub accueillante.

Comparé aux intégrations API personnalisées, MCP-Use est beaucoup moins problématique, ce qui vous permet de vous concentrer sur la création de choses sympas.

Conseils de pro pour la réussite de MCP-Use

- Vérifiez la compatibilité du modèle : seuls les LLM avec appel d’outils (comme GPT-4o ou Claude 3.7 Sonnet) fonctionnent.

- Utilisez Scalar pour les spécifications : validez les spécifications de l’API du serveur pour éviter les surprises.

- Explorez les serveurs MCP : parcourez mcp.so pour les serveurs comme Firecrawl (web scraping) ou ElevenLabs (synthèse vocale).

- Rejoignez la communauté : signalez les bogues ou suggérez des fonctionnalités sur le MCP-Use GitHub.

Conclusion : Votre aventure MCP-Use vous attend

Félicitations, vous êtes maintenant prêt à suralimenter n’importe quel LLM avec MCP-Use ! De la connexion de GPT-4o à un serveur Playwright, vous disposez des outils nécessaires pour créer des agents d’IA qui naviguent, recherchent et bien plus encore. Essayez d’ajouter un serveur GitHub MCP ensuite ou demandez à votre agent de planifier tout un voyage. Le référentiel MCP-Use contient d’autres exemples, et la communauté MCP est en pleine effervescence sur X. Et pour un style API supplémentaire, n’oubliez pas de consulter apidog.com.