Le développement logiciel moderne est confronté à un défi majeur : créer des cas de test complets qui détectent réellement les bugs avant qu'ils n'atteignent la production. Les approches de test traditionnelles sont souvent insuffisantes, laissant les équipes se démener pour corriger les problèmes après le déploiement. Cependant, l'intelligence artificielle offre désormais une solution puissante qui transforme notre approche de la création et de l'exécution des cas de test.

Comprendre la génération de cas de test basée sur l'IA

L'intelligence artificielle apporte des capacités sans précédent aux tests logiciels. Les algorithmes d'apprentissage automatique analysent les modèles de code, le comportement des utilisateurs et les données historiques des bugs pour générer des cas de test que les testeurs humains pourraient négliger. Cette technologie ne remplace pas l'expertise humaine, mais l'amplifie, créant une couverture plus approfondie avec moins d'effort manuel.

Les systèmes d'IA excellent dans la reconnaissance de formes et peuvent identifier les points de défaillance potentiels en examinant la structure du code, les points d'extrémité d'API et les flux de données. Ces systèmes apprennent des cycles de test précédents, améliorant continuellement leur capacité à prédire où des problèmes pourraient survenir. Par conséquent, les équipes obtiennent une meilleure couverture de test tout en réduisant le temps passé sur les tâches de test répétitives.

Avantages de l'IA dans le développement de cas de test

Couverture de test améliorée

Les algorithmes d'IA analysent systématiquement les composants logiciels pour identifier les lacunes de test. Les tests manuels traditionnels manquent souvent des cas limites en raison des limitations humaines et des contraintes de temps. En revanche, les systèmes basés sur l'IA examinent chaque chemin de code possible, générant des cas de test pour des scénarios que les développeurs pourraient ne pas envisager.

Les modèles d'apprentissage automatique étudient les modèles de comportement des applications et créent des cas de test qui couvrent à la fois les cas d'utilisation courants et les conditions limites inhabituelles. Cette approche complète réduit considérablement la probabilité que des bugs atteignent les environnements de production.

Cycles de test accélérés

La vitesse devient cruciale dans les flux de travail de développement modernes. L'IA réduit considérablement le temps nécessaire pour créer et exécuter des cas de test. Alors que les testeurs humains pourraient passer des heures à écrire des suites de tests complètes, les systèmes d'IA génèrent des centaines de cas de test en quelques minutes.

De plus, les systèmes d'IA mettent automatiquement à jour les cas de test lorsque des modifications de code se produisent. Cette adaptation dynamique garantit que les suites de tests restent pertinentes et efficaces tout au long du cycle de vie du développement, éliminant le besoin de maintenance manuelle des tests.

Qualité des tests améliorée

Les cas de test générés par l'IA démontrent souvent une qualité supérieure à ceux créés manuellement. Les algorithmes d'apprentissage automatique analysent de grandes quantités de données de test pour identifier les stratégies de test les plus efficaces. Ces systèmes apprennent des cas de test réussis et intègrent des modèles éprouvés dans la nouvelle génération de tests.

De plus, l'IA élimine les erreurs humaines qui se produisent couramment lors de la création manuelle de tests. La cohérence s'améliore pour tous les cas de test, garantissant que les normes de test restent uniformes tout au long du projet.

Principaux outils d'IA pour la génération de cas de test

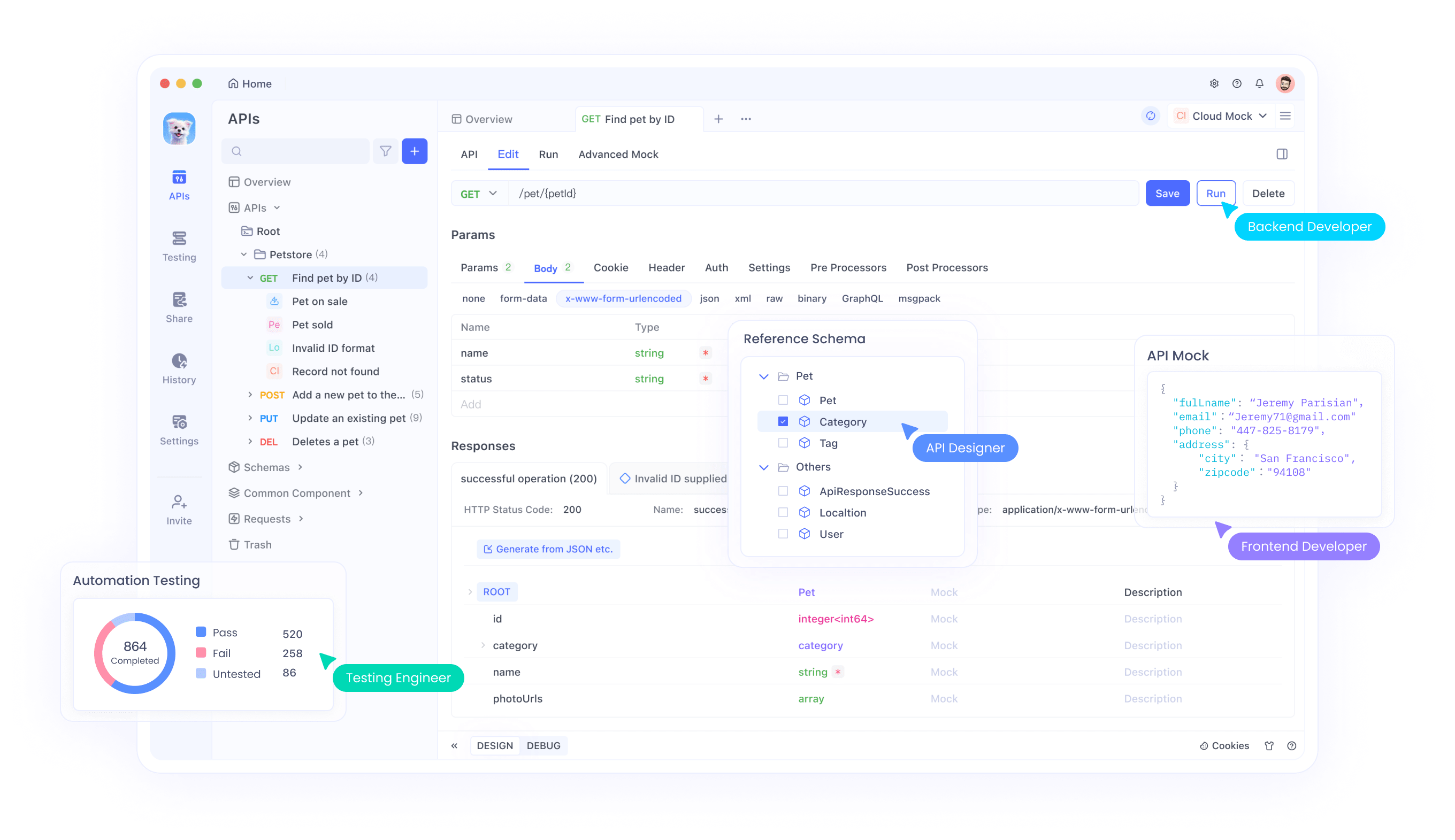

Apidog : Plateforme complète de test d'API

Apidog représente une solution de pointe en matière de tests d'API basés sur l'IA. Cette plateforme combine la génération intelligente de cas de test avec des capacités d'exécution robustes. Les utilisateurs peuvent générer automatiquement des cas de test à partir des spécifications d'API, réduisant ainsi l'effort manuel tout en assurant une couverture complète.

Le moteur d'IA de la plateforme analyse la documentation API et crée automatiquement des scénarios de test qui valident la fonctionnalité, les performances et la sécurité. Les capacités d'apprentissage automatique d'Apidog améliorent continuellement la qualité des cas de test en fonction des résultats d'exécution et des commentaires des utilisateurs.

Outils de traitement du langage naturel

Plusieurs outils d'IA exploitent le traitement du langage naturel pour convertir les exigences en cas de test exécutables. Ces systèmes analysent les récits d'utilisateurs, les critères d'acceptation et la documentation pour générer des suites de tests complètes.

Les outils basés sur le PNL (traitement du langage naturel) comprennent le contexte et l'intention, créant des cas de test qui s'alignent sur les exigences métier. Cette approche comble le fossé entre les parties prenantes commerciales et les équipes techniques, garantissant que les tests valident les besoins réels des utilisateurs.

Frameworks de test d'apprentissage automatique

Les frameworks avancés intègrent des algorithmes d'apprentissage automatique directement dans les flux de travail de test. Ces outils analysent le comportement des applications, identifient les modèles et génèrent des cas de test qui s'adaptent aux exigences logicielles changeantes.

Les frameworks ML excellent dans les tests de régression, générant automatiquement des cas de test qui vérifient que les nouvelles modifications de code ne cassent pas les fonctionnalités existantes. Cette capacité s'avère particulièrement précieuse dans les environnements d'intégration continue.

Stratégies de mise en œuvre pour les tests d'IA

Mise en place d'environnements de test basés sur l'IA

La mise en œuvre réussie des tests d'IA nécessite une planification et une configuration minutieuses. Les équipes doivent d'abord évaluer leur infrastructure de test actuelle et identifier les domaines où l'IA peut apporter le plus de valeur. Cette évaluation doit prendre en compte les outils existants, l'expertise de l'équipe et les exigences du projet.

L'intégration avec les outils de développement existants devient cruciale pour une adoption transparente. Les plateformes de test d'IA doivent se connecter aux systèmes de contrôle de version, aux pipelines d'intégration continue et aux outils de gestion de projet. Cette intégration garantit que les cas de test générés par l'IA s'intègrent naturellement dans les flux de travail établis.

Formation des modèles d'IA pour vos besoins spécifiques

Les systèmes d'IA nécessitent des données d'entraînement pour générer des cas de test efficaces. Les équipes doivent fournir des données de test historiques, des rapports de bugs et des dépôts de code pour entraîner les modèles d'IA. Ce processus d'entraînement aide les systèmes d'IA à comprendre les modèles et les exigences spécifiques au projet.

Des mises à jour régulières des modèles garantissent que les systèmes d'IA restent à jour avec l'évolution des bases de code et des exigences commerciales changeantes. Les équipes doivent établir des processus pour réintroduire de nouvelles données dans les systèmes d'IA, permettant une amélioration continue de la qualité des cas de test.

Établissement de portes de qualité

Les cas de test générés par l'IA nécessitent une validation avant exécution. Les équipes doivent mettre en œuvre des processus de révision qui combinent l'efficacité de l'IA avec l'expertise humaine. Cette approche hybride garantit que les cas de test générés répondent aux normes de qualité tout en conservant les avantages de vitesse de la génération par l'IA.

Les portes de qualité doivent inclure la validation automatisée de la syntaxe des cas de test, la vérification de la logique et l'alignement sur les exigences métier. Ces points de contrôle empêchent les cas de test de mauvaise qualité d'entrer dans le pipeline d'exécution.

Meilleures pratiques pour le développement de cas de test IA

Combiner l'IA avec l'expertise humaine

Les stratégies de test les plus efficaces combinent les capacités de l'IA avec l'intuition humaine. Les systèmes d'IA excellent dans la génération de cas de test complets, tandis que les testeurs humains apportent le contexte, la créativité et la connaissance du domaine.

Les équipes doivent établir des rôles clairs où l'IA gère les tâches répétitives de génération de tests, et les humains se concentrent sur les scénarios complexes, les tests exploratoires et le développement de la stratégie de test. Cette division du travail maximise les forces de l'IA et des testeurs humains.

Maintenir la pertinence des cas de test

Les cas de test générés par l'IA nécessitent une maintenance continue pour rester efficaces. Les équipes doivent régulièrement examiner et mettre à jour les cas de test en fonction des modifications de l'application, des commentaires des utilisateurs et des modèles de découverte de bugs.

Les systèmes de gestion automatisée des cas de test peuvent aider à maintenir la pertinence en suivant les résultats d'exécution des tests et en identifiant les cas de test obsolètes ou redondants. Cette maintenance continue garantit que les suites de tests continuent de fournir de la valeur au fil du temps.

Surveillance et optimisation

La surveillance continue des performances des tests d'IA permet l'optimisation et l'amélioration. Les équipes doivent suivre des métriques telles que la couverture de test, les taux de détection de bugs et les taux de faux positifs pour évaluer l'efficacité de l'IA.

L'analyse régulière de ces métriques aide à identifier les domaines d'amélioration et guide les ajustements des algorithmes d'IA et des données d'entraînement. Cette approche itérative garantit que les systèmes de test d'IA évoluent et s'améliorent continuellement.

Défis courants et solutions

Problèmes de qualité des données

Les systèmes d'IA dépendent de données d'entraînement de haute qualité pour générer des cas de test efficaces. Une mauvaise qualité des données conduit à des cas de test inefficaces qui manquent des bugs ou génèrent de faux positifs. Les équipes doivent investir dans des processus de nettoyage et de validation des données pour s'assurer que les systèmes d'IA reçoivent des données d'entraînement précises.

Les solutions incluent la mise en œuvre de pipelines de validation de données, l'établissement de normes de qualité des données et l'audit régulier des ensembles de données d'entraînement. Ces mesures aident à maintenir la qualité des cas de test générés par l'IA.

Complexité de l'intégration

L'intégration des outils de test d'IA avec les flux de travail de développement existants peut présenter des défis techniques. Les systèmes hérités peuvent manquer d'API ou de points d'intégration nécessaires à la connectivité des outils d'IA.

Les équipes doivent évaluer les exigences d'intégration dès le début du processus de sélection et choisir des outils d'IA qui s'alignent sur leur infrastructure technique. Des approches d'implémentation progressive peuvent aider à minimiser les perturbations tout en permettant aux équipes de s'adapter aux nouveaux flux de travail.

Gestion des lacunes de compétences

Les outils de test d'IA nécessitent de nouvelles compétences et connaissances que de nombreuses équipes peuvent ne pas posséder. Les organisations doivent investir dans la formation et le développement des compétences pour maximiser les avantages des tests basés sur l'IA.

Les programmes de formation doivent couvrir l'utilisation des outils d'IA, les processus de révision des cas de test et la gestion des modèles d'IA. De plus, les équipes doivent établir des pratiques de partage des connaissances pour distribuer l'expertise en tests d'IA au sein de l'organisation.

Mesurer le succès avec les tests d'IA

Indicateurs clés de performance

Une mesure efficace nécessite des KPI clairs qui démontrent la valeur des tests d'IA. Les métriques importantes incluent le pourcentage de couverture de test, les taux de détection de bugs, le temps de cycle de test et le coût par cas de test.

Les équipes doivent établir des mesures de référence avant la mise en œuvre de l'IA pour évaluer précisément l'amélioration. Des mesures et des rapports réguliers aident à démontrer le retour sur investissement et à guider les futurs investissements en tests d'IA.

Calcul du ROI

Le calcul du retour sur investissement pour les tests d'IA implique de mesurer les économies de coûts résultant de la réduction de l'effort de test manuel, de l'amélioration de la détection des bugs et de cycles de publication plus rapides.

Les calculs d'économies de coûts doivent inclure la réduction du temps du personnel de test, la diminution des coûts de correction des bugs et l'amélioration de la satisfaction client grâce à des versions de meilleure qualité. Ces calculs de ROI complets aident à justifier les investissements en tests d'IA et à guider les décisions d'expansion.

Tendances futures des tests d'IA

Intégration avancée de l'apprentissage automatique

Les futurs outils de test d'IA intégreront des algorithmes d'apprentissage automatique plus sophistiqués qui fourniront des informations plus approfondies sur le comportement des logiciels. Ces systèmes prédiront les points de défaillance potentiels avec une plus grande précision et généreront des cas de test plus ciblés.

Les avancées en matière d'apprentissage profond et de réseaux neuronaux permettront aux systèmes d'IA de comprendre les interactions logicielles complexes et de générer des cas de test qui valident le comportement à l'échelle du système plutôt que de simples composants individuels.

Systèmes de test autonomes

L'avenir promet des systèmes de test entièrement autonomes qui nécessitent une intervention humaine minimale. Ces systèmes généreront, exécuteront et maintiendront automatiquement les cas de test tout en s'adaptant continuellement aux modifications logicielles.

Les tests autonomes permettront une validation continue tout au long du cycle de vie du développement, fournissant un retour immédiat sur la qualité du code et la fonctionnalité. Cette capacité de test en temps réel révolutionnera la façon dont les équipes abordent l'assurance qualité logicielle.

Conclusion

La génération de cas de test basée sur l'IA représente un changement fondamental dans les approches de test logiciel. En tirant parti des algorithmes d'apprentissage automatique et de l'automatisation intelligente, les équipes peuvent obtenir une meilleure couverture de test, des cycles de test plus rapides et une qualité logicielle améliorée.

Le succès des tests d'IA nécessite une mise en œuvre minutieuse, une optimisation continue et la bonne combinaison des capacités de l'IA avec l'expertise humaine. Les équipes qui adoptent ces technologies tout en restant concentrées sur la qualité et les besoins des utilisateurs obtiendront des avantages concurrentiels significatifs dans le développement logiciel.

L'avenir des tests logiciels réside dans la combinaison intelligente de l'automatisation par l'IA et de la créativité humaine. Les organisations qui investissent dès aujourd'hui dans les capacités de test d'IA seront mieux placées pour livrer des logiciels de haute qualité sur un marché de plus en plus concurrentiel.