Une équipe s'est fortement appuyée sur l'IA pour générer le code de son application, une pratique désormais appelée « vibe coding ». Moins d'une semaine après le déploiement, leur serveur a été compromis. Le développeur qui a partagé cet incident a pu immédiatement deviner le vecteur d'attaque car les vulnérabilités étaient prévisibles. Cet article explique ce qui n'a pas fonctionné, pourquoi le code généré par l'IA est particulièrement vulnérable aux exploits de sécurité, et fournit une liste de contrôle concrète pour sécuriser les projets assistés par l'IA avant qu'ils n'atteignent la production.

L'incident : Ce qui s'est passé

L'histoire est apparue sur la communauté r/webdev de Reddit en janvier 2026, gagnant rapidement plus de 400 votes positifs et suscitant une discussion intense. Un développeur a partagé ce qui s'est passé dans son entreprise lorsque deux collègues ont adopté le « vibe coding » – la pratique de construire rapidement des applications en utilisant des outils de génération de code IA comme ChatGPT, Claude ou Cursor avec une révision manuelle minimale.

L'équipe était enthousiaste. Ils ont livré rapidement. L'IA a géré tout, des requêtes de base de données aux flux d'authentification. Au moment du déploiement, l'IA a même suggéré le numéro de version « 16.0.0 » pour leur première version – un détail qui, plus tard, semblerait d'une ironie sombre.

Une semaine après le déploiement, le serveur a été piraté.

Le développeur qui a partagé l'histoire n'a pas été surpris. En examinant le code, il a pu immédiatement identifier de multiples vulnérabilités de sécurité introduites par l'IA. Les attaquants les avaient également découvertes.

Ce n'est pas un incident isolé. Les chercheurs en sécurité ont alerté sur ce qu'ils appellent les « vulnérabilités synthétiques » — des failles de sécurité qui apparaissent presque exclusivement dans le code généré par l'IA en raison de la manière dont les modèles linguistiques sont entraînés et dont ils abordent les tâches de codage.

Pourquoi le code généré par l'IA est vulnérable

Les assistants de codage IA sont entraînés sur de vastes dépôts de code public. Cela crée plusieurs angles morts en matière de sécurité :

1. Les données d'entraînement incluent du code vulnérable

GitHub, Stack Overflow et les sites de tutoriels contiennent des millions de lignes de code non sécurisé. Les exemples écrits à des fins d'apprentissage omettent souvent les considérations de sécurité. Les schémas obsolètes restent dans les données d'entraînement. L'IA apprend de tout cela de la même manière.

Lorsque vous demandez à une IA d'écrire du code d'authentification, elle pourrait reproduire un modèle d'un tutoriel de 2018 qui manquait de protection CSRF, ou une réponse de Stack Overflow qui stockait les mots de passe en clair pour des raisons de simplicité.

2. L'IA optimise pour « ça marche » et non pour la « sécurité »

Les modèles linguistiques génèrent du code qui satisfait la demande. Si vous demandez un point d'accès de connexion, l'IA crée quelque chose qui connecte les utilisateurs. Que cette implémentation résiste à l'injection SQL, hache correctement les mots de passe ou valide les jetons de session est secondaire par rapport à l'objectif principal.

Ceci est fondamentalement différent de la façon de penser des développeurs expérimentés. Les développeurs soucieux de la sécurité se demandent « comment cela pourrait-il être exploité ? » à chaque étape. Les assistants IA n'appliquent pas naturellement cette mentalité adversative.

3. Les limitations de la fenêtre de contexte empêchent une sécurité holistique

Les vulnérabilités de sécurité émergent souvent des interactions entre les composants. Une vérification d'authentification peut exister dans un fichier tandis qu'une requête de base de données dans un autre fichier suppose que l'authentification a déjà eu lieu. L'IA générant du code fichier par fichier ou fonction par fonction ne peut pas toujours maintenir ce contexte de sécurité.

4. Les développeurs font trop confiance à la production de l'IA

C'est le facteur humain. Lorsque le code provient d'une IA qui semble confiante et compétente, les développeurs sautent souvent la révision minutieuse qu'ils appliqueraient au code d'un membre junior de l'équipe. L'approche du « vibe coding » l'embrasse explicitement : générer vite, livrer vite, corriger plus tard.

Le problème est que les vulnérabilités de sécurité ne peuvent souvent pas être « corrigées plus tard » une fois que les attaquants les ont découvertes en premier.

Les 7 failles de sécurité les plus courantes dans les API générées par l'IA

Basé sur l'analyse des dépôts de code générés par l'IA et des audits de sécurité, ces vulnérabilités apparaissent le plus fréquemment :

1. Validation des entrées manquante ou faible

Les points d'accès générés par l'IA acceptent souvent directement les entrées utilisateur sans assainissement :

// AI-generated: Vulnerable to injection

app.post('/search', (req, res) => {

const query = req.body.searchTerm;

db.query(`SELECT * FROM products WHERE name LIKE '%${query}%'`);

});

La correction nécessite des requêtes paramétrées, des limites de longueur d'entrée et une validation des caractères — étapes que l'IA omet fréquemment.

2. Flux d'authentification défectueux

Les problèmes courants incluent :

- Jetons stockés dans le localStorage au lieu de cookies httpOnly

- Expiration des jetons manquante

- ID de session faibles ou prévisibles

- Pas de limitation de débit sur les tentatives de connexion

- Jetons de réinitialisation de mot de passe qui n'expirent pas

3. Exposition excessive des données

L'IA a tendance à renvoyer des objets de base de données complets plutôt que de sélectionner des champs spécifiques :

// AI-generated: Returns sensitive fields

app.get('/user/:id', (req, res) => {

const user = await User.findById(req.params.id);

res.json(user); // Includes passwordHash, internalNotes, etc.

});

4. Vérifications d'autorisation manquantes

L'IA crée des points d'accès qui fonctionnent mais oublie de vérifier que l'utilisateur demandeur a la permission :

// AI-generated: No ownership verification

app.delete('/posts/:id', async (req, res) => {

await Post.deleteOne({ _id: req.params.id });

res.json({ success: true });

});

// N'importe quel utilisateur authentifié peut supprimer n'importe quel message

5. Dépendances non sécurisées

L'IA suggère souvent des packages populaires sans vérifier les vulnérabilités connues :

// AI suggests outdated package with CVEs

const jwt = require('jsonwebtoken'); // Version not specified

Sans un épinglage de version explicite et une analyse des vulnérabilités, les projets héritent d'une dette de sécurité dès le premier jour.

6. Secrets et identifiants codés en dur

Cela apparaît étonnamment souvent dans le code généré par l'IA :

// AI-generated: Secret in source code

const stripe = require('stripe')('sk_live_abc123...');

L'IA apprend des tutoriels et des exemples où les clés codées en dur sont courantes à des fins d'illustration.

7. En-têtes de sécurité manquants

Les applications Express, Flask ou Rails générées par l'IA manquent généralement de :

- Configuration CORS (ou CORS excessivement permissif)

- En-têtes Content-Security-Policy

- X-Frame-Options

- Middleware de limitation de débit

- Application HTTPS

Liste de contrôle des tests de sécurité pour les projets assistés par l'IA

Avant de déployer tout projet avec du code généré par l'IA, parcourez cette liste de contrôle :

Authentification et autorisation

- [ ] Tous les points d'accès nécessitent une authentification là où cela est approprié

- [ ] Les vérifications d'autorisation vérifient que l'utilisateur possède/peut accéder aux ressources demandées

- [ ] Les mots de passe sont hachés avec bcrypt, Argon2, ou similaire (facteur de coût ≥10)

- [ ] Les jetons de session sont cryptographiquement aléatoires et expirent

- [ ] Les tentatives de connexion échouées sont limitées en débit

- [ ] Les jetons de réinitialisation de mot de passe sont à usage unique et limités dans le temps

- [ ] Les JWT incluent l'expiration et sont validés côté serveur

Validation des entrées

- [ ] Toutes les entrées utilisateur sont validées pour le type, la longueur et le format

- [ ] Les requêtes de base de données utilisent des instructions paramétrées

- [ ] Les téléchargements de fichiers valident le type, la taille et recherchent les logiciels malveillants

- [ ] Les URL et les redirections sont validées par rapport à des listes blanches

- [ ] Les analyseurs JSON/XML ont des limites de taille configurées

Protection des données

- [ ] Les réponses API ne renvoient que les champs nécessaires

- [ ] Les données sensibles sont chiffrées au repos

- [ ] Les identifiants de base de données utilisent des variables d'environnement, pas du code

- [ ] Les secrets sont stockés dans des systèmes de gestion des secrets appropriés

- [ ] Les journaux ne contiennent pas de mots de passe, de jetons ou d'informations personnelles identifiables

Sécurité du transport

- [ ] HTTPS est appliqué en production

- [ ] Les en-têtes HSTS sont configurés

- [ ] TLS 1.2+ est requis

- [ ] Les cookies sécurisés ont les drapeaux Secure et HttpOnly

Sécurité spécifique à l'API

- [ ] La limitation de débit prévient les abus

- [ ] CORS est configuré pour des origines spécifiques, et non

* - [ ] Le versioning API permet de déprécier les points d'accès non sécurisés

- [ ] Les messages d'erreur ne divulguent pas de détails internes

- [ ] GraphQL a des limites de profondeur/complexité de requête

Dépendances

- [ ] Tous les packages ont des versions spécifiques épinglées

- [ ]

npm audit/pip check/ similaire ne révèle aucune vulnérabilité critique - [ ] Les mises à jour automatiques des dépendances sont configurées

- [ ] Aucun package n'est abandonné ou non maintenu

Comment tester la sécurité de votre API avant le déploiement

La révision manuelle n'est pas suffisante. Vous avez besoin de tests systématiques qui détectent les vulnérabilités introduites par l'IA et que votre révision a manquées.

Étape 1 : Analyse de sécurité automatisée

Utilisez des outils conçus pour trouver les vulnérabilités courantes :

# Pour les projets Node.js

npm audit --audit-level=high

# Pour les projets Python

pip-audit

# Pour les images de conteneurs

trivy image your-app:latest

Étape 2 : Tests de sécurité des API

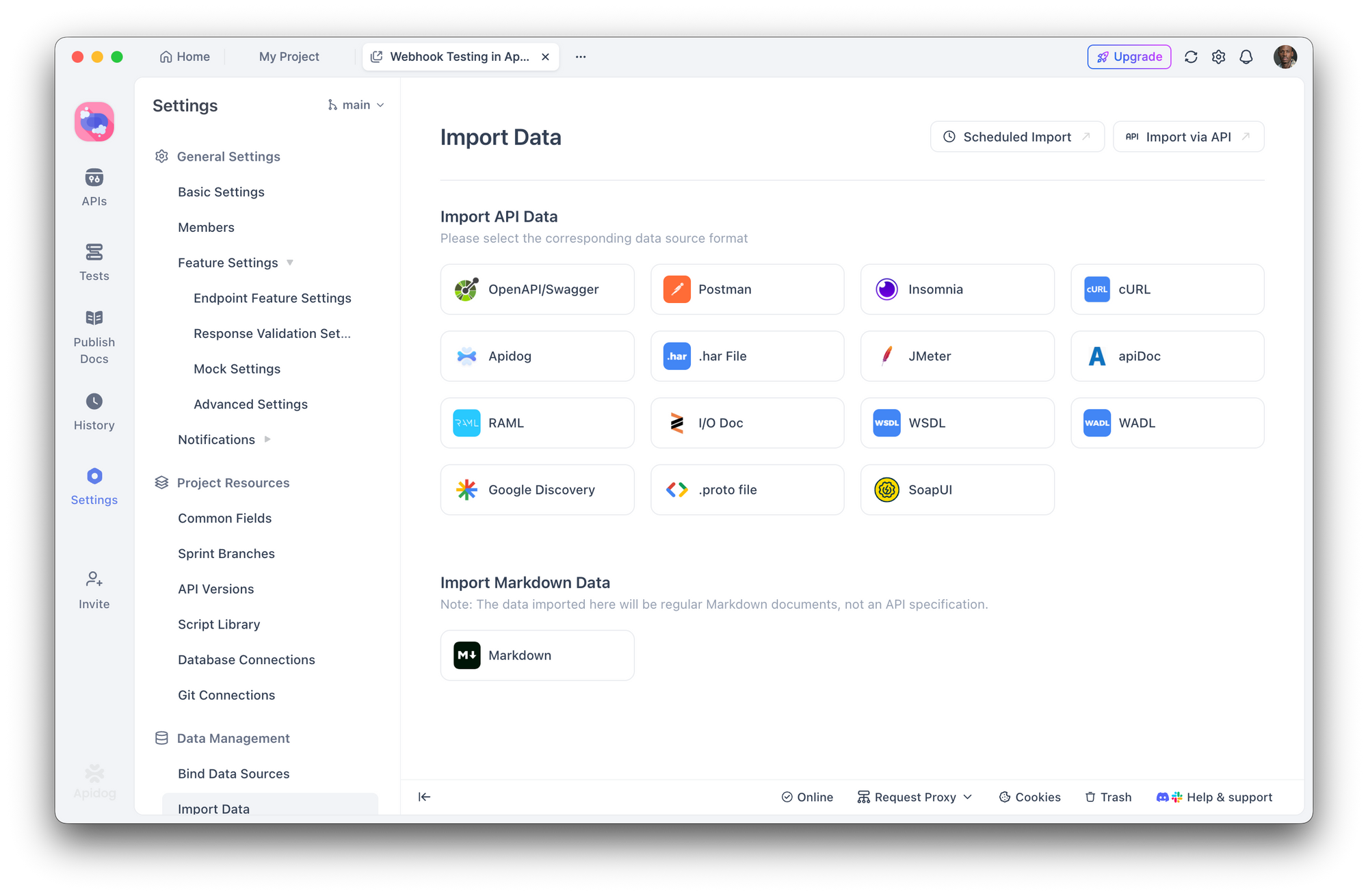

C'est là que Apidog devient essentiel. Au lieu de tester manuellement chaque point d'accès, vous pouvez :

- Importez votre spécification API (OpenAPI/Swagger) ou laissez Apidog découvrir les points d'accès

2. Créez des scénarios de test de sécurité qui vérifient :

- L'authentification manquante renvoie 401

- Un utilisateur incorrect accédant à des ressources renvoie 403

- Une entrée invalide renvoie 400 avec des messages d'erreur sécurisés

- Les tentatives d'injection SQL sont bloquées

- Exécutez des suites de tests automatisées avant chaque déploiement

- Intégrez avec CI/CD pour détecter les régressions

Avec le constructeur de tests visuels d'Apidog, vous n'avez pas besoin d'écrire des tests de sécurité à partir de zéro. Définissez des assertions telles que « la réponse ne doit pas contenir 'password' » ou « une requête sans jeton d'authentification doit renvoyer 401 » et exécutez-les sur l'ensemble de votre surface d'API.

Étape 3 : Simulation de tests d'intrusion

Testez votre API comme le ferait un attaquant :

- Énumérez les points d'accès - Existe-t-il des routes cachées ou non documentées ?

- Testez le contournement d'authentification - Pouvez-vous accéder à des routes protégées sans jetons valides ?

- Tentez des attaques par injection - Injection SQL, NoSQL, commande sur tous les champs d'entrée

- Vérifiez les IDOR - L'utilisateur A peut-il accéder aux données de l'utilisateur B en modifiant les ID ?

- Abusez des limites de débit - Que se passe-t-il avec 1000 requêtes par seconde ?

Les scénarios de test d'Apidog vous permettent de simuler ces attaques de manière systématique, en enregistrant les résultats pour comparaison entre les déploiements.

Étape 4 : Audit des en-têtes de sécurité

Vérifiez vos en-têtes de réponse :

curl -I https://your-api.com/endpoint

Recherchez :

Strict-Transport-SecurityX-Content-Type-Options: nosniffX-Frame-Options: DENYContent-Security-Policy

Construire un flux de travail axé sur la sécurité avec les outils d'IA

Les assistants de codage IA ne vont pas disparaître — ils deviennent de plus en plus puissants. La solution n'est pas de les éviter, mais d'intégrer la sécurité dans votre flux de travail.

Ingénierie des invites pour la sécurité

Lorsque vous utilisez l'IA pour générer du code, demandez explicitement des considérations de sécurité :

Au lieu de :

"Créer un point d'accès d'enregistrement d'utilisateur"

Demandez :

"Créez un point d'accès d'enregistrement d'utilisateur avec validation des entrées, hachage de mot de passe en utilisant bcrypt avec un facteur de coût de 12, protection contre les attaques temporelles, limitation de débit, et gestion appropriée des erreurs qui ne divulgue pas d'informations sur l'existence des e-mails"

Étapes de révision obligatoires

Établissez un flux de travail où le code généré par l'IA doit passer par :

- Révision humaine - Ce code fait-il ce que nous avions prévu ?

- Linting automatisé - ESLint, Pylint avec des plugins de sécurité

- Analyse de sécurité - Snyk, npm audit, vérification des dépendances OWASP

- Tests d'API - Suites de tests Apidog validant les exigences de sécurité

- Déploiement en staging - Exécutez des tests d'intégration dans un environnement réaliste

Traitez le code IA comme une entrée non fiable

C'est le changement de mentalité clé. Le code de l'IA doit être traité avec le même scepticisme que le code d'un contributeur inconnu. Déploieriez-vous du code provenant d'une demande de tirage aléatoire sans révision ? Appliquez la même norme au code généré par l'IA.

Conclusion

Le piratage de serveur survenu une semaine après le déploiement n'a pas été causé par des attaquants sophistiqués ou des exploits zero-day. Il a été causé par des vulnérabilités courantes que les outils d'IA introduisent régulièrement et que les pratiques de « vibe coding » manquent habituellement.

La génération de code par l'IA est puissante. Elle accélère le développement et rend les tâches complexes accessibles. Mais sans tests de sécurité systématiques, cette rapidité devient une vulnérabilité.

Des outils comme Apidog rendent les tests de sécurité pratiques en vous permettant de définir et d'automatiser les exigences de sécurité sur l'ensemble de votre surface d'API. L'objectif n'est pas de ralentir le développement assisté par l'IA, mais de construire la couche de vérification que le code généré par l'IA exige.

Votre serveur ne se soucie pas de savoir si le code a été écrit par un humain ou une IA. Il se soucie seulement de savoir si ce code est sécurisé.