Vercel ha entrado en la arena de la IA con su API v0, presentando el modelo v0-1.0-md. Esta API está diseñada para potenciar a los desarrolladores en la creación de aplicaciones web modernas, ofreciendo un conjunto de características pensadas para la velocidad, la eficiencia y la facilidad de integración. Este artículo ofrece una visión general completa de la API v0-1.0-md de Vercel, cubriendo sus características, precios y cómo empezar, incluyendo una mirada a cómo aprovecharla con herramientas de desarrollo de API como APIdog.

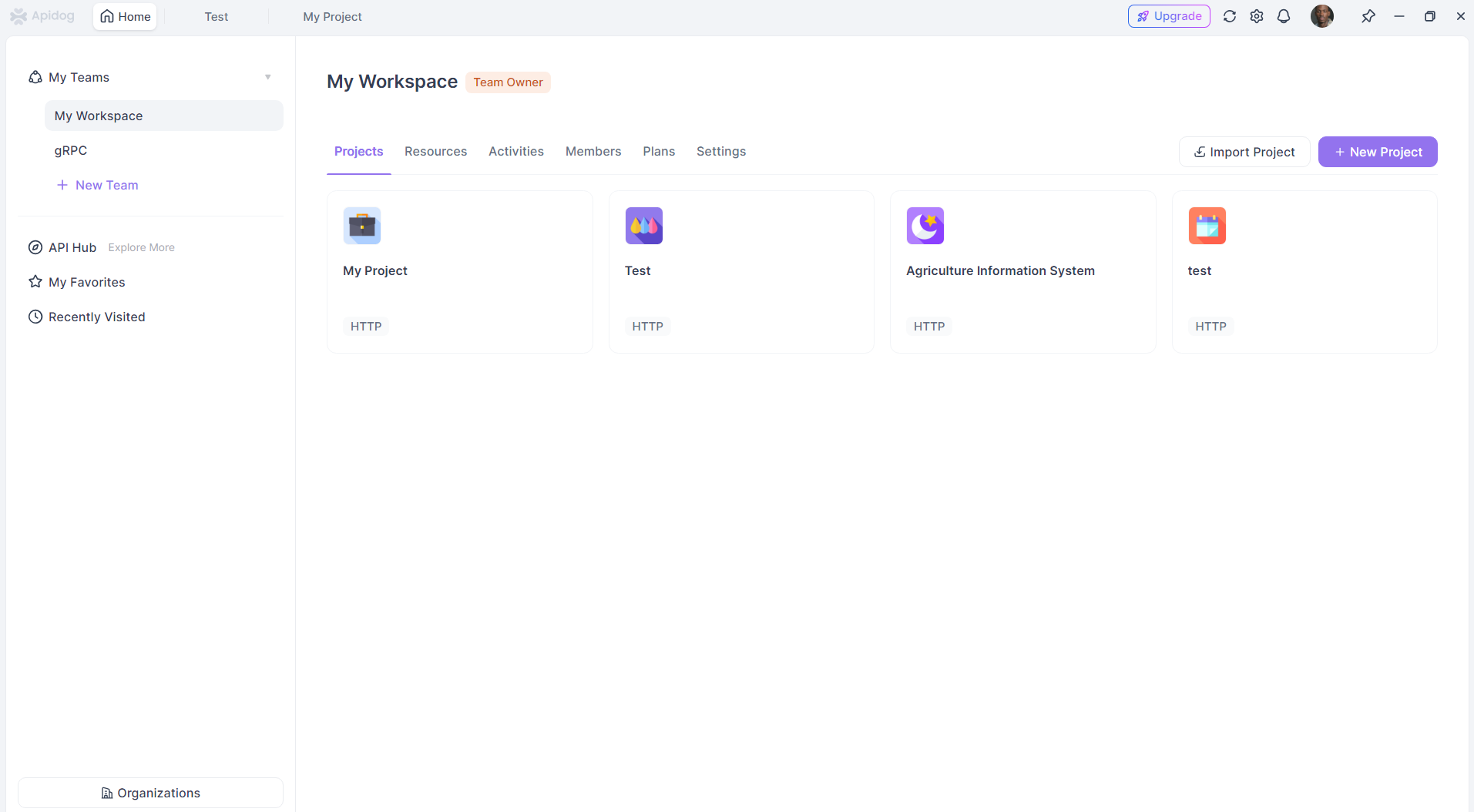

¿Quiere una plataforma integrada, todo en uno, para que su equipo de desarrollo trabaje junto con máxima productividad?

¡Apidog satisface todas sus demandas y reemplaza a Postman a un precio mucho más asequible!

Características de la API v0-1.0-md de Vercel

El modelo v0-1.0-md se encuentra en el corazón de la API v0, aportando un conjunto robusto de capacidades adaptadas a los desafíos del desarrollo web contemporáneo.

Completados conscientes del Framework: Una de las características destacadas es su conocimiento de las pilas de desarrollo web modernas. El modelo ha sido evaluado y optimizado para frameworks populares como Next.js y, naturalmente, la propia plataforma de Vercel. Esto significa que los desarrolladores pueden esperar completados de código y sugerencias más relevantes y contextualmente precisas cuando trabajan dentro de estos ecosistemas.

Capacidades de corrección automática: Escribir código perfecto al primer intento es una rareza. El modelo v0-1.0-md ayuda en esto identificando y corrigiendo automáticamente problemas de codificación comunes durante el proceso de generación. Esto puede reducir significativamente el tiempo de depuración y mejorar la calidad general del código.

Funcionalidad de edición rápida: La velocidad es un tema recurrente con la API v0. La función de edición rápida transmite las ediciones en línea a medida que están disponibles. Este bucle de retroalimentación en tiempo real permite a los desarrolladores ver los cambios instantáneamente, fomentando una experiencia de desarrollo más dinámica e interactiva.

Compatibilidad con OpenAI: Reconociendo la adopción generalizada de los estándares de API de OpenAI, Vercel ha asegurado que el modelo v0-1.0-md sea compatible con el formato de la API OpenAI Chat Completions. Esta es una ventaja significativa, ya que permite a los desarrolladores utilizar la API v0 con cualquier herramienta, SDK o biblioteca existente que ya admita la estructura de OpenAI. Esta interoperabilidad reduce la barrera de entrada y permite una integración más sencilla en los flujos de trabajo existentes.

Entrada multimodal: La API no se limita a interacciones basadas en texto. Admite entradas multimodales, lo que significa que puede procesar datos tanto de texto como de imagen. Las imágenes deben proporcionarse como datos codificados en base64. Esto abre un abanico de posibilidades para aplicaciones que requieren comprender o generar contenido basado en información visual junto con indicaciones textuales.

Llamadas a funciones/herramientas: Las aplicaciones de IA modernas a menudo requieren interacción con sistemas externos o la ejecución de funciones específicas. El modelo v0-1.0-md admite llamadas a funciones y herramientas, lo que permite a los desarrolladores definir herramientas personalizadas que la IA puede invocar. Esto amplía las capacidades del modelo más allá de la simple generación de texto, permitiéndole realizar acciones, recuperar datos de otras API o interactuar con otros servicios como parte de la generación de su respuesta.

Respuestas de streaming de baja latencia: Para aplicaciones que requieren interacción en tiempo real, como chatbots o asistentes de codificación en vivo, la latencia es un factor crítico. La API v0 está diseñada para proporcionar respuestas rápidas y en streaming. Esto significa que en lugar de esperar a que se genere la respuesta completa, los datos se envían en fragmentos a medida que están disponibles, lo que lleva a una experiencia de usuario mucho más receptiva y atractiva.

Optimización para el desarrollo web: El modelo está específicamente optimizado para tareas de desarrollo web frontend y full-stack. Este enfoque garantiza que su entrenamiento y capacidades estén alineados con los desafíos y requisitos comunes de la construcción de aplicaciones web modernas, desde la generación de componentes de UI hasta la escritura de lógica del lado del servidor.

Los desarrolladores pueden experimentar con el modelo v0-1.0-md directamente en el AI Playground proporcionado por Vercel. Esto permite probar diferentes indicaciones (prompts), observar las respuestas del modelo y familiarizarse con sus capacidades antes de integrarlo en un proyecto.

Precios y acceso a la API v0 de Vercel

El acceso a la API v0 de Vercel, y consecuentemente al modelo v0-1.0-md, se encuentra actualmente en beta. Para utilizar la API, los usuarios deben tener un plan Premium o Team con facturación basada en el uso habilitada. La información detallada sobre la estructura de precios se puede encontrar típicamente en la página oficial de precios de Vercel. Como ocurre con muchos programas beta, es recomendable verificar los últimos términos y condiciones directamente con Vercel.

Para empezar a usar la API, el primer paso es crear una clave de API en v0.dev. Esta clave se utilizará para autenticar las solicitudes a la API.

Límites de uso

Como la mayoría de los servicios de API, la API v0 de Vercel tiene límites de uso establecidos para garantizar un uso justo y mantener la estabilidad del servicio. Los límites actualmente documentados para el modelo v0-1.0-md son:

- Máximo de mensajes por día: 200

- Tamaño máximo de la ventana de contexto: 128.000 tokens

- Tamaño máximo del contexto de salida: 32.000 tokens

Estos límites están sujetos a cambios, especialmente a medida que la API salga de la fase beta. Para usuarios o aplicaciones que requieran límites más altos, Vercel proporciona un punto de contacto (support@v0.dev) para discutir posibles aumentos. También es importante tener en cuenta que al usar la API, los desarrolladores aceptan los Términos de la API de Vercel.

Cómo usar la API v0 de Vercel

Integrar la API v0 de Vercel en un proyecto está diseñado para ser sencillo, particularmente para desarrolladores familiarizados con el formato de la API de OpenAI o que utilizan el ecosistema de Vercel.

Integración con AI SDK: Vercel recomienda usar su AI SDK, una biblioteca de TypeScript diseñada específicamente para trabajar con <V0Text /> y otros modelos compatibles con OpenAI. Este SDK simplifica el proceso de realizar llamadas a la API, manejar respuestas e integrar capacidades de IA en las aplicaciones.

Para empezar, normalmente instalarías los paquetes necesarios:

npm install ai @ai-sdk/openai

Ejemplo de uso (JavaScript/TypeScript):

El siguiente ejemplo demuestra cómo usar la función generateText del AI SDK para interactuar con el modelo v0-1.0-md:

import { generateText } from 'ai';

import { createOpenAI } from '@ai-sdk/openai';

// Configurar el cliente de la API v0 de Vercel

const vercel = createOpenAI({

baseURL: 'https://api.v0.dev/v1', // El endpoint de la API v0

apiKey: process.env.VERCEL_V0_API_KEY, // Tu clave de API v0 de Vercel

});

async function getAIChatbotResponse() {

try {

const { text } = await generateText({

model: vercel('v0-1.0-md'), // Especificar el modelo de Vercel

prompt: 'Create a Next.js AI chatbot with authentication',

});

console.log(text);

return text;

} catch (error) {

console.error("Error generating text:", error);

// Manejar el error apropiadamente

}

}

getAIChatbotResponse();

En este ejemplo:

- Importamos

generateTextde la bibliotecaaiycreateOpenAIde@ai-sdk/openai. - Se crea un cliente compatible con OpenAI usando

createOpenAI, configurado con la URL base de la API v0 (https://api.v0.dev/v1) y tu clave de API v0 de Vercel (que debe almacenarse de forma segura, por ejemplo, como una variable de entorno). - Se llama a la función

generateText, pasando el clientevercelconfigurado (especificando el modelov0-1.0-md) y la indicación (prompt) deseada. - La respuesta de la API, que contiene el texto generado, está entonces disponible en la variable

text.

Referencia de la API:

Para la interacción directa con la API, sin el SDK, o para comprender la mecánica subyacente, la referencia de la API es clave.

Endpoint: POST https://api.v0.dev/v1/chat/completions

Este único endpoint se utiliza para generar respuestas del modelo basadas en un historial de conversación.

Encabezados (Headers):

Authorization: Requerido. Un token Bearer en el formatoBearer $V0_API_KEY.Content-Type: Requerido. Debe serapplication/json.

Cuerpo de la solicitud (Request Body): El cuerpo de la solicitud es un objeto JSON con los siguientes campos principales:

model(cadena, Requerido): El nombre del modelo. Para esta API, debe ser"v0-1.0-md".messages(array, Requerido): Una lista de objetos de mensaje que forman el historial de conversación. Cada objeto de mensaje debe tener:role(cadena, Requerido): Identifica al remitente, puede ser"user","assistant"o"system".content(cadena o array, Requerido): El contenido real del mensaje. Puede ser una cadena simple o un array de bloques de texto e imagen para entrada multimodal.stream(booleano, Opcional): Si se establece entrue, la API devolverá la respuesta como un stream de Server-Sent Events (SSE). El valor predeterminado esfalse.tools(array, Opcional): Definiciones de cualquier herramienta personalizada (por ejemplo, funciones) que el modelo pueda llamar.tool_choice(cadena u objeto, Opcional): Especifica qué herramienta debe llamar el modelo, si se proporcionan herramientas.

Ejemplo de solicitud (cURL):

Así es como podrías hacer una llamada directa a la API usando cURL:

curl https://api.v0.dev/v1/chat/completions \

-H "Authorization: Bearer $V0_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "v0-1.0-md",

"messages": [

{ "role": "user", "content": "Create a Next.js AI chatbot" }

]

}'

Ejemplo con Streaming (cURL):

Para recibir una respuesta en streaming:

curl https://api.v0.dev/v1/chat/completions \

-H "Authorization: Bearer $V0_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "v0-1.0-md",

"stream": true,

"messages": [

{ "role": "user", "content": "Add login to my Next.js app" }

]

}'

Formato de respuesta:

Sin streaming (stream: false): La API devuelve un único objeto JSON que contiene la respuesta completa. Este objeto incluye un id, el nombre del model, un tipo de object (por ejemplo, chat.completion), una marca de tiempo created y un array choices. Cada elección en el array contiene el message (con role: "assistant" y el content de la respuesta) y un finish_reason (por ejemplo, "stop").

{

"id": "v0-123",

"model": "v0-1.0-md",

"object": "chat.completion",

"created": 1715620000,

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": "Aquí tienes cómo añadir inicio de sesión a tu aplicación Next.js..."

},

"finish_reason": "stop"

}

]

}

Streaming (stream: true): El servidor envía una serie de fragmentos de datos formateados como Server-Sent Events (SSE). Cada evento comienza con data: seguido de un objeto JSON que representa un delta parcial de la respuesta. Esto permite al cliente procesar la respuesta incrementalmente.

data: {

"id": "v0-123",

"model": "v0-1.0-md",

"object": "chat.completion.chunk",

"choices": [

{

"delta": {

"role": "assistant",

"content": "Aquí tienes cómo"

},

"index": 0,

"finish_reason": null

}

]

}

Un fragmento final típicamente tendrá un finish_reason distinto de null.

Uso de la API v0 de Vercel con APIdog

APIdog es una plataforma de API completa diseñada para el diseño, desarrollo, prueba y documentación de API. Su fortaleza reside en unificar estas diferentes etapas del ciclo de vida de la API. Puedes usar APIdog para interactuar con la API v0 de Vercel, al igual que con cualquier otra API basada en HTTP.

Aquí tienes un enfoque general para usar la API v0 de Vercel con APIdog:

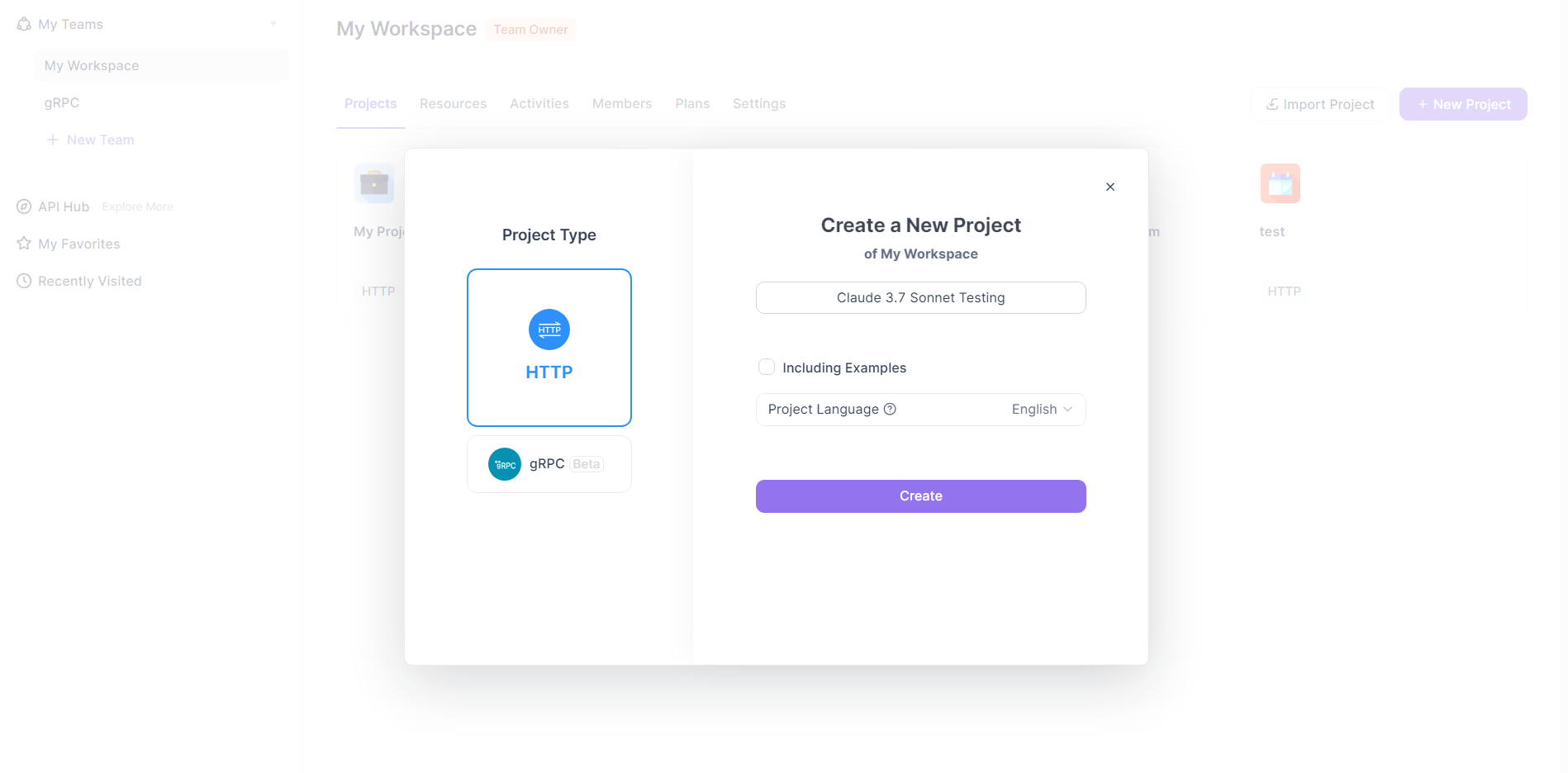

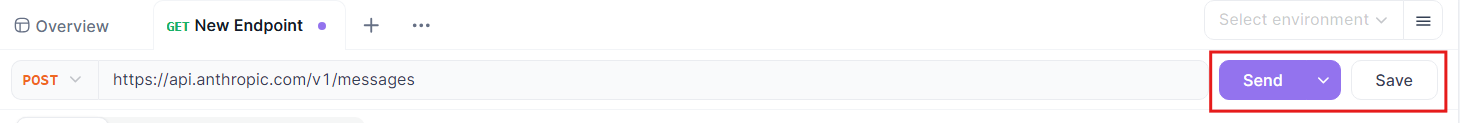

Crear una nueva solicitud en APIdog:

- Dentro de tu proyecto de APIdog, inicia la creación de una nueva solicitud. Esto se hace típicamente haciendo clic en un icono "+" y seleccionando "New Request" (Nueva solicitud) o una opción similar.

- APIdog admite varios tipos de solicitud; para la API v0 de Vercel, estarás creando una solicitud HTTP.

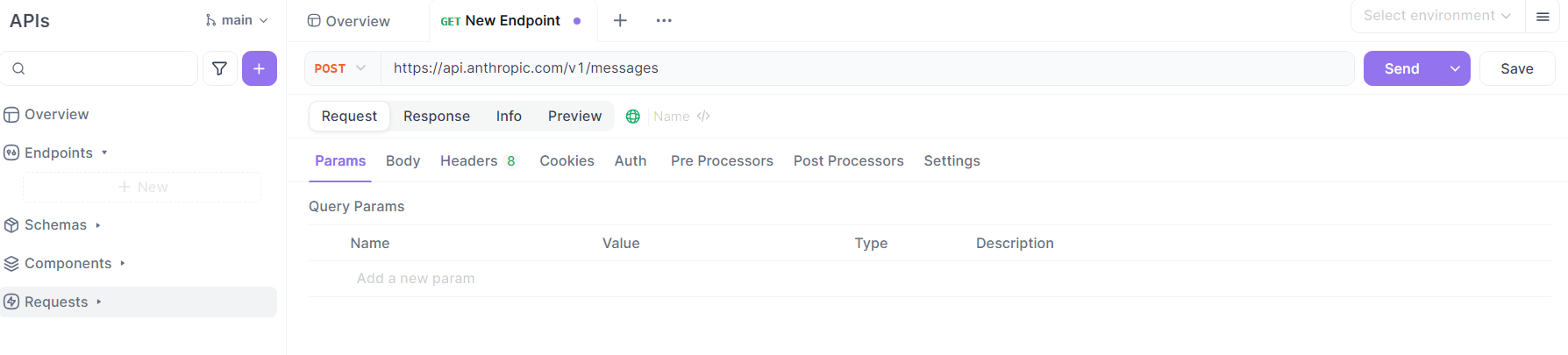

Configurar los detalles de la solicitud:

- Método: Selecciona

POSTcomo método HTTP, como se especifica en la documentación de la API v0 de Vercel. - URL: Introduce el endpoint de la API v0 de Vercel:

https://api.v0.dev/v1/chat/completions. - Encabezados (Headers):

- Añade un encabezado

Authorization. El valor debe serBearer YOUR_VERCEL_V0_API_KEY, reemplazandoYOUR_VERCEL_V0_API_KEYcon la clave de API real que obtuviste de v0.dev. - Añade un encabezado

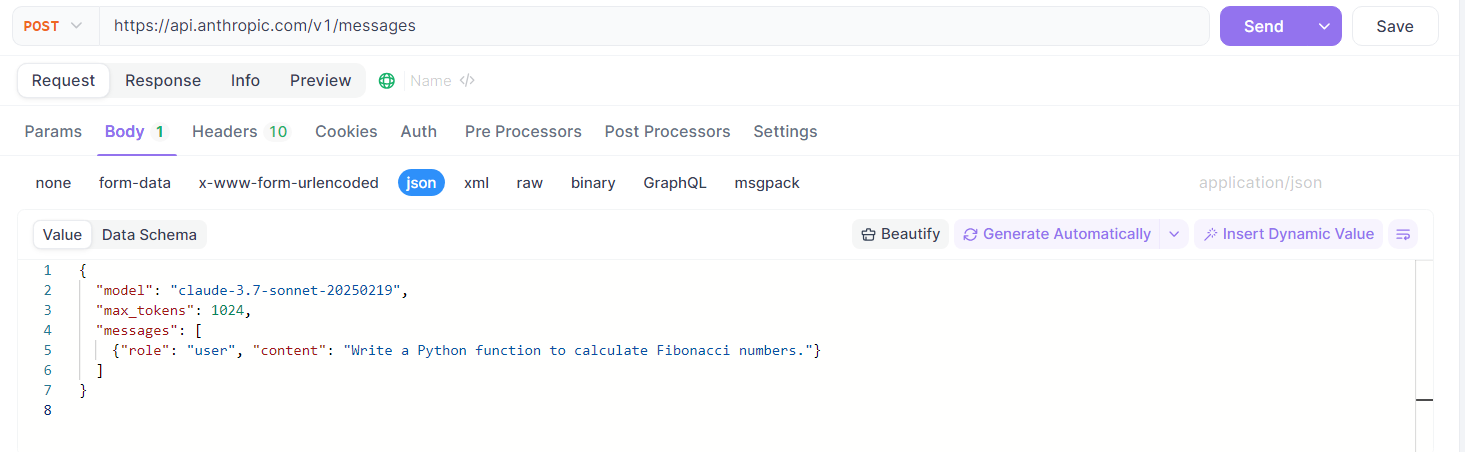

Content-Typecon el valorapplication/json. - Cuerpo (Body):

Cambia a la pestaña "Body" (Cuerpo) en APIdog y selecciona el tipo de entrada "raw" (crudo), luego elige "JSON" como formato.

Construye el payload JSON de acuerdo con las especificaciones de la API v0 de Vercel. Por ejemplo:

{

"model": "v0-1.0-md",

"messages": [

{ "role": "user", "content": "Genera un componente de React para un spinner de carga." }

],

"stream": false // o true, dependiendo de tus necesidades

}

Puedes personalizar el array messages con el historial de conversación y la indicación (prompt) que desees. También puedes incluir campos opcionales como stream, tools o tool_choice según sea necesario.

Enviar la solicitud:

- Una vez que todos los detalles estén configurados, haz clic en el botón "Send" (Enviar) en APIdog.

Ver la respuesta:

- APIdog mostrará la respuesta del servidor en el panel de respuesta.

- Si

streamerafalse, verás la respuesta JSON completa. - Si

streameratrue, el manejo de SSE por parte de APIdog puede variar. Puede mostrar los fragmentos a medida que llegan o acumularlos. Consulta la documentación de APIdog para obtener detalles sobre el manejo de respuestas en streaming. Es posible que necesites usar las capacidades de scripting de APIdog o escenarios de prueba para un manejo de streaming más avanzado.

Utilizar las características de APIdog (Opcional):

- Entornos: Almacena tu

V0_API_KEYy la URL base (https://api.v0.dev) como variables de entorno en APIdog para una gestión más sencilla en diferentes solicitudes o proyectos. - Guardado de Endpoints: Guarda esta solicitud configurada como un "Endpoint Case" (Caso de Endpoint) o dentro de una definición de API en APIdog. Esto te permite reutilizar y versionar fácilmente tus interacciones con la API v0 de Vercel.

- Escenarios de Prueba: Si necesitas realizar una secuencia de llamadas o incorporar la API v0 de Vercel en un flujo de trabajo de prueba más amplio, crea Escenarios de Prueba en APIdog.

- Validación Automatizada: Si defines una especificación de API para la API v0 de Vercel dentro de APIdog (o importas una si está disponible), APIdog puede validar automáticamente las respuestas contra este esquema.

Siguiendo estos pasos, puedes usar eficazmente APIdog como cliente para enviar solicitudes a la API v0 de Vercel, inspeccionar respuestas y gestionar tus interacciones de API de manera estructurada. Esto es particularmente útil para probar indicaciones (prompts), explorar las características de la API e integrar contenido o lógica generada por IA en aplicaciones durante las fases de desarrollo y prueba.

Conclusión

La API v0-1.0-md de Vercel representa un paso significativo de Vercel en el ámbito del desarrollo asistido por IA. Su enfoque en frameworks web modernos, compatibilidad con OpenAI y características como la corrección automática y la entrada multimodal la convierten en una opción atractiva para los desarrolladores que buscan construir aplicaciones web de próxima generación. Aunque actualmente está en beta y sujeta a requisitos de plan específicos, el diseño de la API y el AI SDK de soporte sugieren un compromiso para proporcionar una herramienta potente pero accesible. Ya sea utilizada directamente a través de su API REST, mediante el AI SDK o gestionada con herramientas como APIdog, el modelo v0-1.0-md ofrece una vía prometedora para integrar capacidades avanzadas de IA en el flujo de trabajo de desarrollo web, agilizando tareas y desbloqueando nuevas posibilidades creativas. A medida que la API madure y potencialmente amplíe sus ofertas, sin duda será un espacio a seguir para los desarrolladores interesados en aprovechar la IA en sus proyectos.