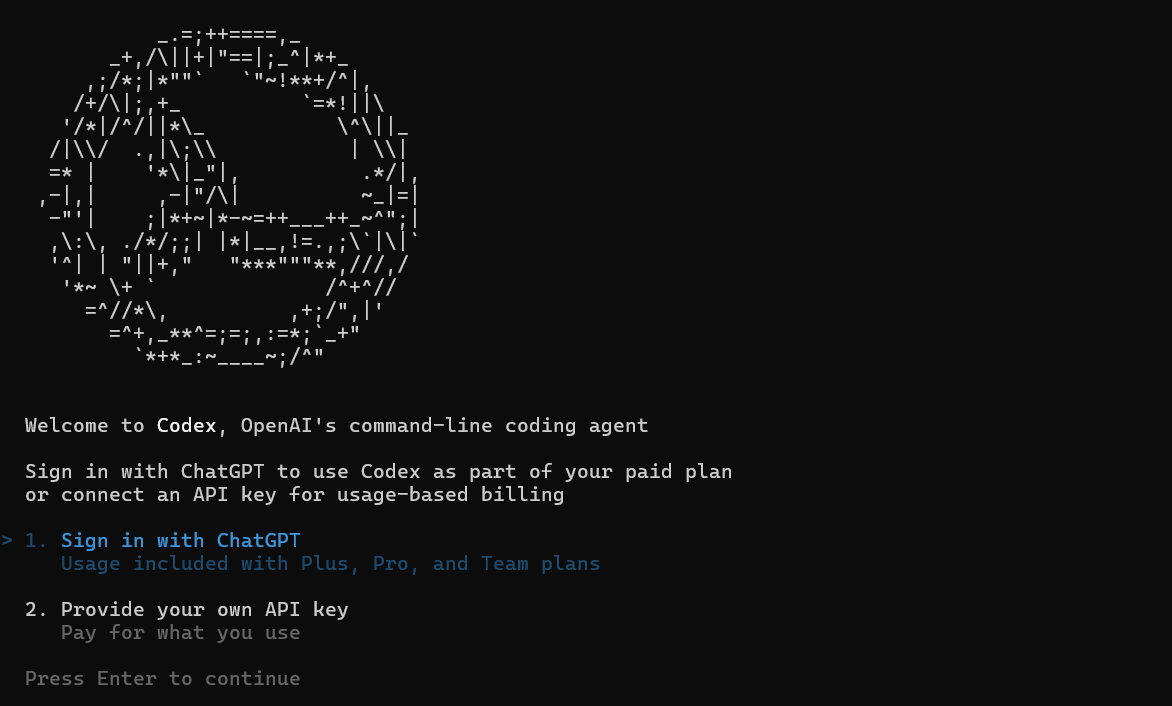

Imagínate esto: Estás inmerso en una maratón de codificación, alimentando a tu compañero de IA con una enorme base de código para refactorizar, cuando de repente —¡zas!— se ahoga con un "límite de tokens excedido". ¿Te suena familiar? Si estás utilizando **Codex**, la ingeniosa herramienta de codificación de OpenAI, esos **límites de tokens de Codex** pueden sentirse como un jarro de agua fría en pleno flujo de trabajo. Pero no temas, colega desarrollador, esto no es un punto final; es una invitación a ser más inteligente con tus prompts. A partir de septiembre de 2025, **Codex** (impulsado por modelos como GPT-5-Codex) cuenta con generosas ventanas de tokens que manejan todo, desde correcciones rápidas hasta renovaciones de mono-repositorios. En este desglose sencillo, desglosaremos lo que realmente significan esos **límites de tokens de Codex**, cómo exprimirles hasta la última gota y consejos para mejorar tu uso. Ya seas un hacker solitario o un líder de equipo, dominar esto mantendrá tus sesiones de IA funcionando sin problemas. ¡Vamos a decodificar los tokens y a subir de nivel tu juego con **Codex**!

¿Quieres una plataforma integrada y todo en uno para que tu equipo de desarrolladores trabaje con máxima productividad?

¡Apidog satisface todas tus demandas y reemplaza a Postman a un precio mucho más asequible!

Desmitificando los Límites de Tokens de Codex: El Juego de los Números

En esencia, los límites de tokens de Codex giran en torno a la ventana de contexto, el "espacio cerebral" total que puede ocupar tu solicitud. A diferencia de los modelos más antiguos limitados a 4K u 8K tokens, Codex —lanzado en mayo de 2025 y actualizado con codex-1— cuenta con una impresionante longitud de contexto de 192,000 tokens. Eso es suficiente para abarcar un repositorio de tamaño mediano (piensa en unas 50,000 líneas de código) dejando espacio para tu prompt, historial y salida. Los tokens de entrada (tu código + instrucciones) alcanzan un máximo de alrededor de 150K, con la salida limitada a 42K para mantener las respuestas rápidas, sumando ese punto óptimo de 192K.

¿Por qué tan espacioso? Codex está diseñado para la ingeniería del mundo real: ¿Depurando una aplicación heredada? Incluye el módulo completo. ¿Construyendo una característica? Incluye especificaciones, dependencias y pruebas sin recortar. La variante codex-mini-latest lo reduce a 128K para tareas más ligeras (preguntas y respuestas de código, ediciones rápidas), pero el codex-1 completo brilla para trabajos pesados. Los límites por mensaje se vinculan a tu plan: los usuarios Plus obtienen de 30 a 150 mensajes/5 horas, pero cada uno puede consumir hasta 192K si es complejo. No hay un límite estricto por solicitud más allá de la ventana; se trata más bien del uso general para evitar colapsos del servidor.

Estos límites no son estáticos; OpenAI está iterando basándose en la retroalimentación. Las vistas previas de principios de 2025 eran "ilimitadas" para pruebas, pero ahora están escalonadas para la sostenibilidad. Para los usuarios de la API, se paga por token: $1.50/1M de entrada, $6/1M de salida en codex-mini, con descuentos del 75% por caché para repeticiones. En resumen: los límites de tokens de Codex son generosos para la mayoría de los desarrolladores, pero una ingeniería de prompts inteligente los convierte en superpoderes.

Cómo Aprovechar los Límites de Tokens de Codex: Maximiza tu Ventana

¿Alcanzando ese techo de 192K? Nah, con estrategias inteligentes, rara vez lo tocarás, y cuando lo hagas, te encantará. La clave para dominar los límites de tokens de Codex es tratarlos como RAM: carga lo que importa, elimina lo superfluo e itera de manera eficiente.

Primero, divide inteligentemente: Para bases de código grandes, resume los archivos no esenciales ("Aquí está utils.py; concéntrate en la lógica de autenticación") para liberar tokens para rutas críticas. Herramientas como git diff o cargas selectivas reducen el 50% de las entradas sin perder contexto. En la CLI, usa --context-file para precargar resúmenes, manteniendo tu prompt conciso.

Aprovecha el almacenamiento en caché: ¿Patrones repetidos? El descuento del 75% de OpenAI en prompts almacenados en caché significa que regenerar un conjunto de pruebas estándar cuesta muy poco. Haz un prompt una vez con el contexto completo, luego haz referencia a él: "Basado en la refactorización de autenticación anterior". Esto encadena sesiones sin recargar todo, extendiendo tu ventana a lo largo de maratones.

Hazte multimodal: GPT-5-Codex consume imágenes (capturas de pantalla de errores) sin afectar los tokens; describe un error de interfaz de usuario visualmente, ahorrando la sobrecarga de texto. Para las salidas, establece --max-output 10K para centrarte en las correcciones, no en ensayos.

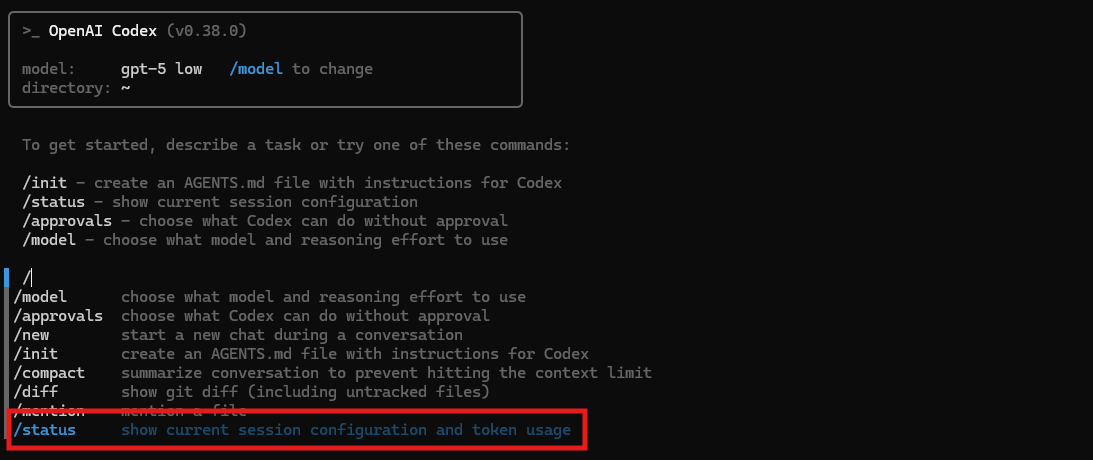

Monitoriza como un halcón: El panel de control de la CLI muestra el consumo en tiempo real (ej., 486K usados, 32% de contexto restante). Establece alertas para el 80%: pausa, resume el progreso en AGENTS.md y reanuda. Los usuarios Pro obtienen una granularidad más fina, detectando "tragatoken" como el razonamiento verboso.

¿Casos extremos? Monorepos: Utiliza la búsqueda vectorial para recuperar fragmentos relevantes sobre la marcha, alimentando solo 20K a la vez. Esta carga dinámica elude los límites estáticos, ideal para la expansión empresarial. ¿El resultado? Tareas que desbordarían modelos antiguos fluyen sin problemas, con desarrolladores reportando un rendimiento 3 veces mayor.

Las Mejores Formas de Utilizar Codex: Más Allá de los Límites

Los límites de tokens de Codex son solo el lienzo; la verdadera maestría proviene de usarlo como una navaja suiza para la vida del desarrollador. Comienza con la CLI para los guerreros de la terminal: codex debug app.py --context 50K ingiere la mitad de tu límite para correcciones específicas, generando diferencias de PR. Combínalo con la extensión de VS Code para sugerencias en línea: pasa el ratón sobre una función, pulsa "Probar con Codex" y generará suites dentro de 10K tokens.

Para equipos, delega: Asigna agentes a través del modo nube (casi ilimitado para ráfagas) para tareas paralelas: uno depura el frontend (20K tokens), otro el backend (ventana separada). Integra MCP para la transferencia de contexto: Pasa un estado resumido entre agentes, minimizando las recargas.

La ingeniería de prompts amplifica la utilización: "Prioriza la eficiencia: Explica la solución en 500 tokens, el código en 2K." Esto exprime el valor de las salidas. Encadena con herramientas: usa la Búsqueda de Archivos para extraer fragmentos (5K tokens), alimenta al Intérprete para su ejecución (sin costo adicional), luego refina.

¿Empresa? Los límites personalizados a través de créditos te permiten ráfagas de más de 500K por tarea, perfecto para migraciones. ¿Nivel gratuito? Quédate con el mini-modelo para lo básico de 128K, actualizando cuando te enganches.

¿Trampas? Sobrecargar los prompts infla las entradas; mantenlos modulares. Siempre verifica las salidas; los tokens ahorrados en alucinaciones superan las repeticiones desperdiciadas.

Conclusión: Los Tokens Son Tu Aliado, No Tu Enemigo

Los límites de tokens de Codex —esa potencia de 192K— no son barreras; son planos para una genialidad eficiente. Al dividir, almacenar en caché y encadenar, conviertes las limitaciones en creatividad, haciendo de Codex tu copiloto definitivo. Ya sean sprints de CLI o maratones de IDE, optimiza sin piedad y observa cómo se dispara la productividad. ¿Tienes algún truco para ahorrar tokens? ¡Compártelo en cualquier plataforma de desarrolladores, hackeemos los límites juntos!