Si alguna vez te has sentado en una reunión de planificación de pruebas y has oído a alguien decir: "Escribamos un script de prueba para esta característica", mientras que otra persona intervino y dijo: "Tendré el caso de prueba listo para mañana", puede que te hayas preguntado si realmente estaban hablando de la misma cosa. Estos términos se usan indistintamente, y mezclarlos definitivamente conduciría a confusión, expectativas no coincidentes y lagunas en la cobertura de pruebas que solo aparecen después del lanzamiento.

Por lo tanto, comprender la diferencia entre un caso de prueba y un script de prueba no es un adorno académico, es una distinción práctica que afecta cómo diseñas las pruebas, quién las ejecuta y cómo las mantienes a lo largo del tiempo. Esta guía aclarará la diferencia, te mostrará cuándo usar un enfoque particular y te dará las mejores prácticas que harán que tu esfuerzo de prueba sea más efectivo y menos caótico.

¿Qué es un Caso de Prueba?

Un caso de prueba es un conjunto de condiciones o variables bajo las cuales un probador determina si un sistema bajo prueba satisface los requisitos. Piénsalo como una receta: te dice los ingredientes (condiciones previas), los pasos (acciones) y cómo debería verse el plato final (resultados esperados). Los casos de prueba son documentos centrados en el ser humano, diseñados para ser leídos, comprendidos y ejecutados por personas.

Un caso de prueba bien escrito responde a estas preguntas:

- ¿Qué requisito específico estamos probando?

- ¿Qué condiciones deben existir antes de empezar?

- ¿Qué acciones exactas realizamos?

- ¿Qué datos utilizamos?

- ¿Cómo sabemos si la prueba pasó o falló?

Los casos de prueba residen en herramientas de gestión de pruebas como Apidog, TestRail, hojas de Excel o incluso páginas de Confluence. Priorizan la claridad y la exhaustividad sobre la precisión técnica porque su audiencia incluye probadores manuales, analistas de negocio y propietarios de producto que pueden no leer código.

Por ejemplo, un caso de prueba para una función de inicio de sesión podría verse así:

ID del Caso de Prueba: TC_Login_001

Objetivo: Verificar que un usuario válido puede iniciar sesión con credenciales correctas

Condiciones Previas: La cuenta de usuario existe; el usuario está en la página de inicio de sesión

Pasos:

- Introducir nombre de usuario: test@example.com

- Introducir contraseña: ValidPass123

- Hacer clic en el botón Iniciar sesión

Resultado Esperado: El usuario es redirigido al panel de control; el mensaje de bienvenida muestra el nombre de usuario

Observa el enfoque en la legibilidad humana y el detalle explícito. Cualquiera puede ejecutar este caso de prueba, incluso si no lo escribió.

¿Qué es un Script de Prueba?

Un script de prueba es un conjunto automatizado de instrucciones escritas en un lenguaje de programación que ejecuta los pasos de la prueba sin intervención humana. Si un caso de prueba es una receta, un script de prueba es un robot de cocina programado para seguir esa receta perfectamente cada vez, a la velocidad de una máquina.

Los scripts de prueba son código. Utilizan frameworks como Selenium, Playwright o Cypress para interactuar con aplicaciones a través de APIs, navegadores o interfaces móviles. Su audiencia es técnica: ingenieros de automatización y desarrolladores que mantienen la suite. Los scripts se centran en la precisión, la reutilización y la integración con las pipelines de CI/CD.

El mismo escenario de inicio de sesión como script de prueba (usando Playwright):

test('valid user login', async ({ page }) => {

await page.goto('/login');

await page.locator('#username').fill('test@example.com');

await page.locator('#password').fill('ValidPass123');

await page.locator('button[type="submit"]').click();

await expect(page).toHaveURL('/dashboard');

await expect(page.locator('#welcome-msg')).toContainText('test@example.com');

});

El script realiza la misma validación, pero lo hace programáticamente, se ejecuta en milisegundos y se integra directamente en tu suite de pruebas automatizadas.

Caso de Prueba vs Script de Prueba: Las Diferencias Clave

Comprender la diferencia entre caso de prueba y script de prueba significa reconocer que sirven a propósitos distintos. Así es como se comparan en dimensiones críticas:

| Aspecto | Caso de Prueba | Script de Prueba |

|---|---|---|

| Formato | Documento legible por humanos (texto) | Código legible por máquina (JavaScript, Python, etc.) |

| Audiencia | Probadores manuales, BAs, propietarios de producto | Ingenieros de automatización, desarrolladores |

| Ejecución | Manual, paso a paso por una persona | Automatizado, ejecutado por frameworks |

| Velocidad | Más lento, limitado por el ritmo humano | Extremadamente rápido, se ejecuta en segundos |

| Mantenimiento | Actualizaciones de texto simples, pero muchas copias | Refactorización de código, control de versiones |

| Costo Inicial | Bajo tiempo de creación, alto tiempo de ejecución | Alto tiempo de creación, bajo tiempo de ejecución |

| Flexibilidad | El probador puede adaptarse sobre la marcha | Rígido; el código debe actualizarse para los cambios |

| Mejor Para | Pruebas exploratorias, de UX, ad-hoc | Pruebas de regresión, smoke, basadas en datos |

La idea central de la comparación entre caso de prueba y script de prueba es esta: los casos de prueba definen qué probar, mientras que los scripts de prueba definen cómo probarlo automáticamente. El primero se centra en la cobertura y la claridad; el segundo en la velocidad de ejecución y la repetibilidad.

Cuándo usar Casos de Prueba vs Scripts de Prueba

Elegir entre casos de prueba manuales y scripts automatizados no es cuestión de preferencia, sino de contexto. Utiliza esta guía para tomar la decisión correcta:

Usa Casos de Prueba Cuando:

- La característica cambia con frecuencia (la automatización se rompería constantemente)

- Estás probando la experiencia de usuario, el diseño visual o la calidad subjetiva

- La prueba requiere un juicio humano complejo que es difícil de codificar

- Necesitas una validación rápida y única de una nueva característica

- Tu equipo carece de habilidades o infraestructura de automatización

Usa Scripts de Prueba Cuando:

- La prueba debe ejecutarse repetidamente en cada lanzamiento (suite de regresión)

- Necesitas retroalimentación rápida sobre la funcionalidad principal (pipelines de CI/CD)

- Se requiere prueba basada en datos con cientos de combinaciones de entrada

- Los pasos de la prueba son estables y es poco probable que cambien

- Tienes los recursos técnicos para mantener el código de automatización

La mayoría de los equipos maduros utilizan ambos. Mantienen una biblioteca de casos de prueba manuales para pruebas exploratorias y de UX, mientras construyen una suite de regresión automatizada a partir de los casos de prueba más críticos y estables.

Mejores Prácticas para Escribir Casos de Prueba y Scripts de Prueba

Ya sea que estés documentando una prueba manual o codificando un script automatizado, estos principios fortalecen ambos:

Para Casos de Prueba:

- Sé Explícito, No Asumas: Escribe los pasos para que un nuevo miembro del equipo pueda ejecutarlos sin hacer preguntas. "Hacer clic en el botón Enviar" es mejor que "Enviar el formulario".

- Una Prueba, Un Propósito: Cada caso de prueba debe validar un único requisito o escenario. Las pruebas combinadas ocultan fallos y complican la depuración.

- Incluye Datos Reales: En lugar de "nombre de usuario válido", usa "test.user@company.com". Los datos reales eliminan la ambigüedad y aceleran la ejecución.

- Vincula a Requisitos: Cada caso de prueba debe rastrearse hasta un requisito, historia de usuario o criterio de aceptación. Esto asegura la cobertura y ayuda con el análisis de impacto cuando los requisitos cambian.

Para Scripts de Prueba:

- Sigue el Modelo Page Object: Separa la lógica de prueba de los localizadores de UI. Cuando el ID del botón de inicio de sesión cambia, actualizas un objeto de página, no cincuenta scripts.

- Haz Pruebas Independientes: Cada script debe configurar sus propios datos y limpiar después de sí mismo. Un estado compartido crea pruebas inestables que fallan aleatoriamente.

- Usa Nombres Descriptivos: Una prueba llamada

test_login_001no te dice nada. Nómbralatest_valid_user_redirects_to_dashboard_after_login. - Implementa Esperas Inteligentes: Nunca uses temporizadores de espera fijos. Usa esperas del framework que pausen hasta que los elementos estén listos. Esto elimina las condiciones de carrera y acelera la ejecución.

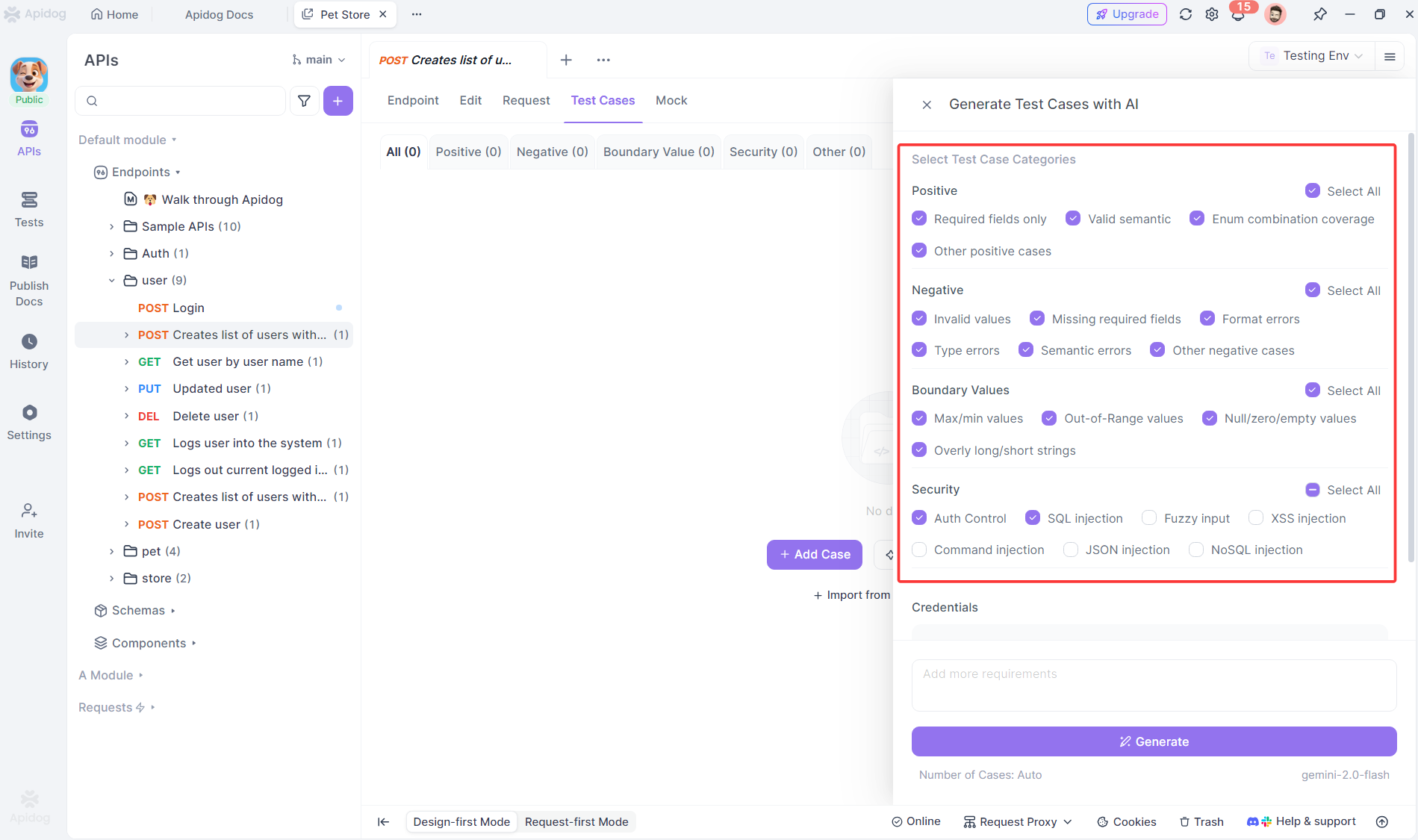

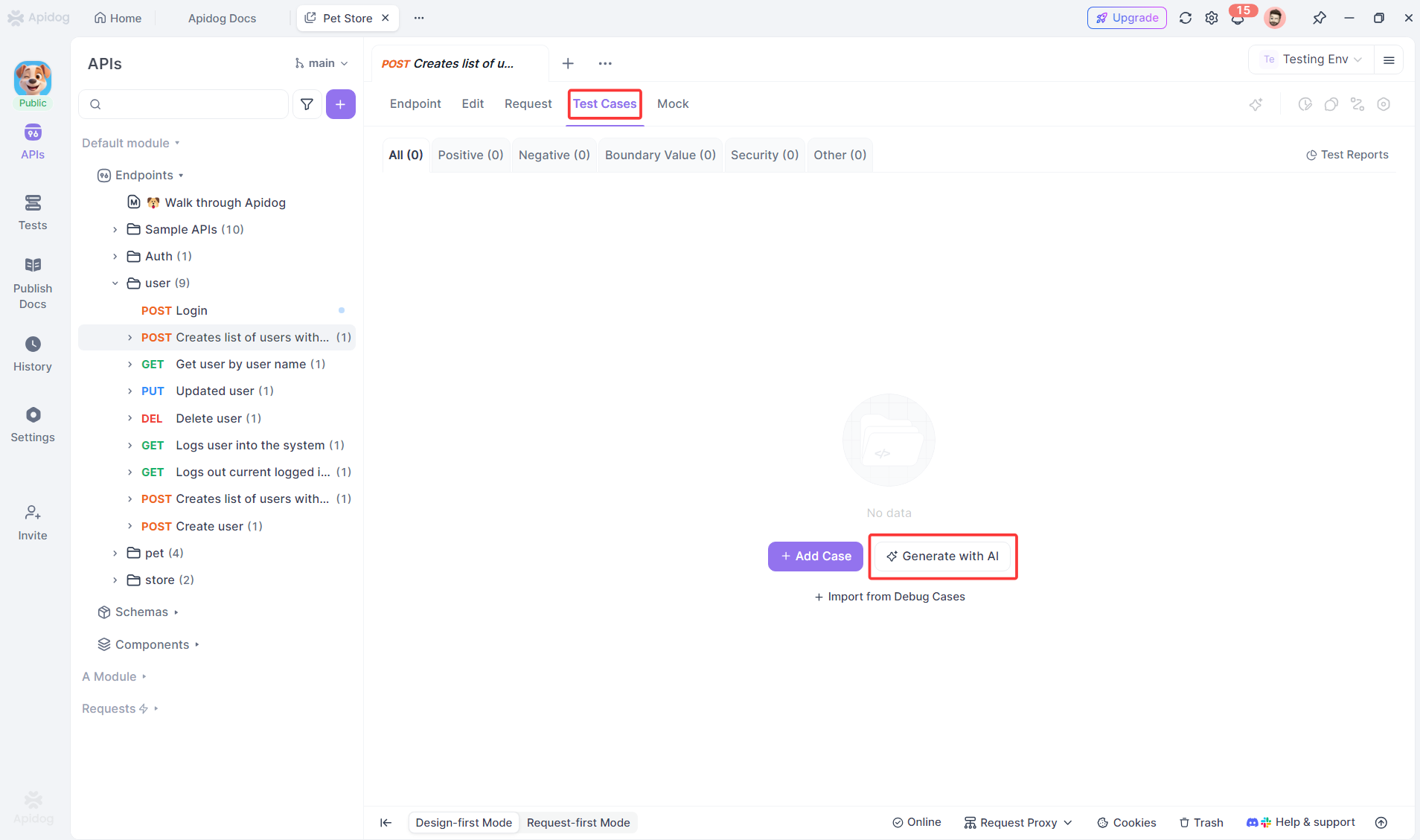

Cómo Apidog Ayuda a Generar Casos de Prueba Automáticamente

Uno de los mayores cuellos de botella en las pruebas es el esfuerzo manual requerido para escribir casos de prueba completos. Aquí es donde Apidog cambia las reglas del juego.

Apidog utiliza IA para analizar tu documentación de API y generar automáticamente casos de prueba —no scripts— para cada endpoint. Crea pruebas de ruta positiva, pruebas negativas con datos inválidos, pruebas de valores límite y pruebas de seguridad basadas en tu especificación. Cada caso de prueba generado incluye condiciones previas, datos de entrada exactos, códigos de estado HTTP esperados y puntos de validación de respuesta.

Por ejemplo, cuando importas una especificación OpenAPI para una API de pago, Apidog produce instantáneamente casos de prueba para:

- Pago exitoso con tarjeta válida

- Fallo de pago con tarjeta caducada

- Fallo de pago por fondos insuficientes

- Cantidad inválida (negativa, cero, que excede el límite)

- Campos obligatorios faltantes

Esta automatización no reemplaza el juicio humano, acelera la base. Tu equipo revisa los casos de prueba generados, los refina para la lógica de negocio y los prioriza para su ejecución. Lo que antes llevaba días ahora lleva horas, y las lagunas de cobertura se reducen porque la IA comprueba sistemáticamente lo que los humanos podrían pasar por alto.

Cuando estés listo para automatizar, estos casos de prueba bien especificados se convierten limpiamente en scripts de prueba. Los pasos claros y los resultados esperados sirven como un modelo perfecto para tu framework de automatización, ya sea que uses Postman, RestAssured o Playwright.

Preguntas Frecuentes

P1: ¿Un caso de prueba puede convertirse directamente en un script de prueba?

Resp: Sí, pero no automáticamente. Un caso de prueba bien escrito proporciona el modelo para un script de prueba —los pasos, los datos y los resultados esperados se traducen directamente en código. Sin embargo, debes añadir detalles técnicos como localizadores, lógica de configuración/desmontaje y aserciones. Piensa en los casos de prueba como el documento de requisitos para tu automatización.

P2: ¿Es un enfoque mejor que el otro en el debate Caso de Prueba vs Script de Prueba?

Resp: No, sirven para propósitos diferentes. Los casos de prueba manuales sobresalen en pruebas exploratorias, de UX y ad-hoc donde el juicio humano importa. Los scripts de prueba dominan para pruebas de regresión repetitivas donde la velocidad y la consistencia son críticas. Los equipos maduros usan ambos estratégicamente, no religiosamente.

P3: ¿Cómo mantenemos la trazabilidad entre casos de prueba y scripts de prueba?

Resp: Utiliza una herramienta de gestión de pruebas que vincule las pruebas manuales y automatizadas al mismo ID de requisito. En el código de tu script, incluye comentarios que hagan referencia al ID del caso de prueba (por ejemplo, // Automatización para TC_Login_001). Cuando los requisitos cambien, consulta tu sistema para ambas pruebas vinculadas, manuales y automatizadas, para evaluar el impacto.

P4: ¿Deberían los probadores junior escribir scripts de prueba?

Resp: No inicialmente. Comienza con la creación de casos de prueba manuales para que adquieran conocimientos del dominio y fundamentos de prueba. Una vez que entiendan los conceptos básicos de JavaScript o Python, asócialos con ingenieros de automatización senior para coescribir scripts. Saltar directamente a la escritura de scripts sin los fundamentos de prueba crea una automatización frágil e ineficaz.

P5: ¿Cómo maneja Apidog la lógica de negocio compleja en la generación de casos de prueba?

Resp: Apidog genera casos de prueba base completos basados en contratos de API, pero no comprende tus reglas de negocio únicas de forma predeterminada. Debes revisar y mejorar su resultado añadiendo lógica condicional, llamadas a API encadenadas y validaciones específicas del negocio. La IA te proporciona un 80% de cobertura instantáneamente; tu experiencia aporta el 20% final que más importa.

Conclusión

La distinción entre caso de prueba y script de prueba no se trata de elegir bandos, sino de usar la herramienta adecuada para el trabajo. Los casos de prueba aportan claridad, cobertura y juicio humano a tu esfuerzo de calidad. Los scripts de prueba aportan velocidad, repetibilidad e integración a tu pipeline de entrega.

Tu objetivo debe ser una estrategia equilibrada: escribir casos de prueba claros y trazables para la cobertura y la exploración; automatizar los más críticos y estables en scripts mantenibles. Y siempre que sea posible, utiliza herramientas inteligentes como Apidog para acelerar la creación de ambos.

La calidad surge cuando tomas decisiones deliberadas sobre cómo pruebas, no solo qué pruebas. Comprender la diferencia entre un caso de prueba y un script de prueba es el primer paso hacia esas decisiones deliberadas y efectivas.