OpenAI ha sido durante mucho tiempo un líder en el campo de la inteligencia artificial, avanzando continuamente las capacidades de los modelos de aprendizaje automático. Su última oferta, el modelo o3-pro, marca otro hito significativo en este camino. Presentado a principios de 2025, o3-pro destaca por su rendimiento y adaptabilidad excepcionales, convirtiéndose en un punto de inflexión en el panorama de la IA. Este artículo explora los benchmarks, los precios y los precios de la API de o3-pro de OpenAI, ofreciendo una mirada detallada a lo que hace de este modelo una innovación destacada.

¿Quieres una plataforma integrada, todo en uno, para que tu equipo de desarrolladores trabaje en conjunto con máxima productividad?

Apidog satisface todas tus demandas, y reemplaza a Postman a un precio mucho más asequible!

¿Qué es OpenAI o3-pro?

El modelo o3-pro de OpenAI es un modelo de lenguaje de vanguardia diseñado para abordar una amplia gama de tareas con impresionante precisión y velocidad. Se basa en el legado de modelos anteriores como GPT-4 y o1, integrando los últimos avances en procesamiento del lenguaje natural, aprendizaje automático y aprendizaje profundo. Su arquitectura está optimizada para ofrecer procesamiento rápido y alta precisión, adaptándose a una amplia gama de aplicaciones, desde la simple generación de texto hasta la resolución de problemas complejos.

I’ve been secretly testing o3-pro for a while now 👀

— Flavio Adamo (@flavioAd) June 10, 2025

Extremely cheaper, faster, and way more precise than o1-pro (and coding with o3 vs o3-pro is night and day)

Got some cool tests coming, starting with (of course) a tougher version of the Hexagon Bauncing ball

o3-pro is the… https://t.co/BDUyA7TXms pic.twitter.com/fG5l7LlGp4

Una característica distintiva de o3-pro es su capacidad para producir y comprender texto que se asemeja mucho a la comunicación humana, manteniendo la coherencia y la relevancia incluso en escenarios complejos. Esto es posible gracias a vastos conjuntos de datos de entrenamiento, algoritmos avanzados y técnicas de entrenamiento innovadoras. Más allá del texto, o3-pro admite entradas multimodales, manejando sin problemas tipos de datos como imágenes junto con texto, ampliando su utilidad.

Este modelo destaca en tareas que exigen una profunda comprensión contextual, como resumir documentos extensos, traducir idiomas o responder preguntas matizadas. También sobresale en esfuerzos creativos, incluyendo la escritura de narrativas, la codificación e incluso la generación de composiciones musicales. Con capacidades tan versátiles, o3-pro está destinado a transformar industrias como la educación, la atención médica, el entretenimiento y las finanzas, ofreciendo herramientas poderosas tanto para individuos como para organizaciones.

Benchmarks de OpenAI o3-pro

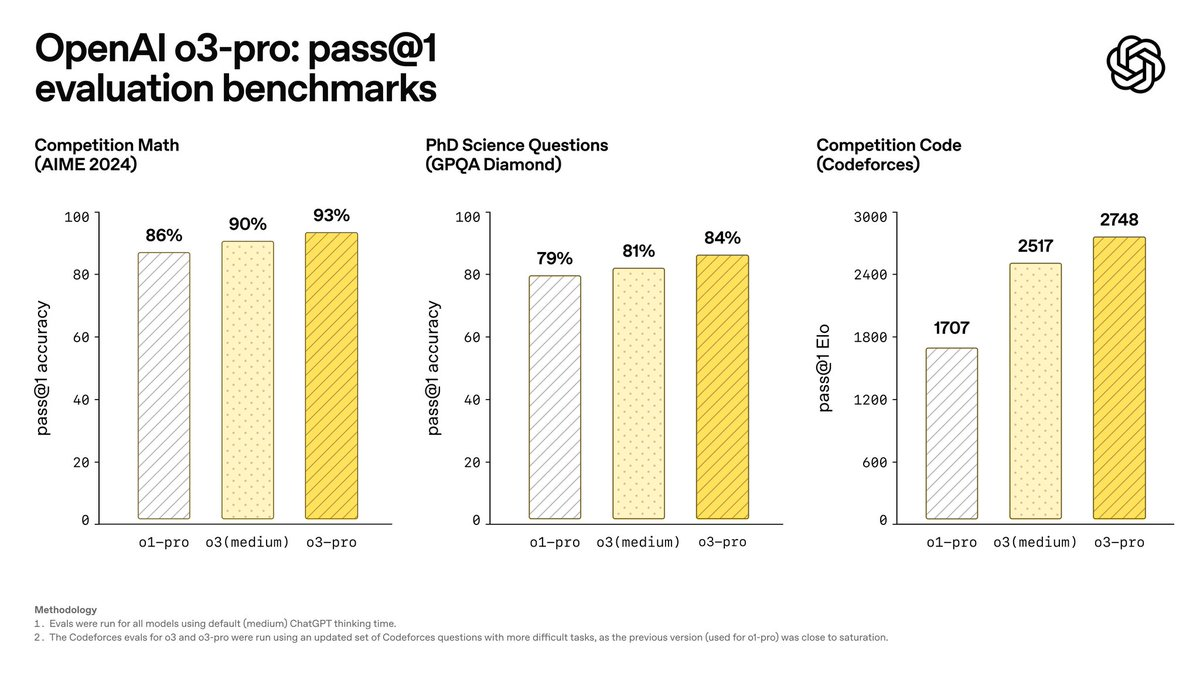

Los benchmarks son esenciales para medir el rendimiento de un modelo de IA, y o3-pro ha elevado el listón en múltiples métricas. Las evaluaciones internas de OpenAI revelan que o3-pro sobresale en benchmarks de IA destacados, mostrando su superioridad en áreas como las matemáticas y el conocimiento científico.

En el benchmark AIME 2024, que evalúa la competencia matemática, o3-pro supera al modelo líder de Google, Gemini 2.5 Pro. Este logro subraya su excepcional capacidad para resolver ecuaciones complejas y aplicar el razonamiento lógico, convirtiéndolo en un activo valioso para aplicaciones técnicas y académicas.

De manera similar, en el benchmark GPQA Diamond —una evaluación rigurosa de la comprensión científica a nivel de doctorado— o3-pro supera a Claude 4 Opus de Anthropic. Esto demuestra su comprensión profunda y precisa de conceptos científicos avanzados, posicionándolo como una opción principal para la investigación y el uso profesional.

Más allá de estas pruebas específicas, o3-pro muestra notables fortalezas en la comprensión del lenguaje natural, la velocidad de generación de texto y el rendimiento en tareas multimodales. Su capacidad para mantener la precisión mientras procesa datos rápidamente lo distingue de sus competidores. OpenAI también ha probado rigurosamente o3-pro en cuanto a fiabilidad, sometiéndolo a pruebas de estrés y desafíos adversarios para garantizar que permanezca estable y seguro en condiciones exigentes. Estos resultados confirman a o3-pro como un modelo potente y fiable listo para su implementación en el mundo real.

Precios de OpenAI o3-pro

La estructura de precios de OpenAI para o3-pro se basa en el uso de su API, sin planes de suscripción independientes para acceso individual o empresarial. En cambio, los costos están ligados al consumo de tokens, lo que refleja la naturaleza computacionalmente intensiva del modelo. A continuación, se presenta un desglose detallado de la estructura de precios.

Precios de la API de o3-pro

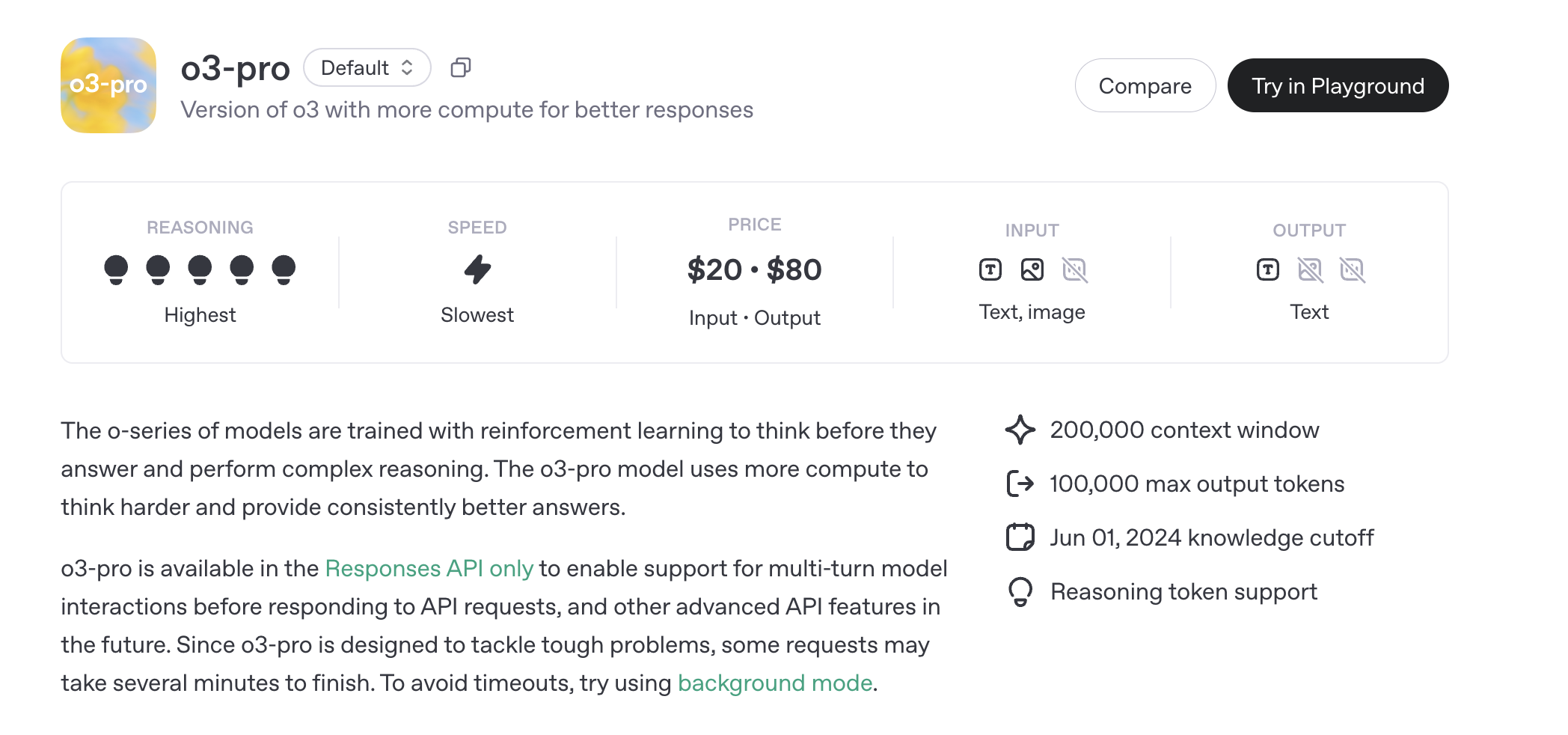

El modelo o3-pro es accesible solo a través de la API de Respuestas, con precios basados en el número de tokens procesados. Los tokens representan fragmentos de texto, con aproximadamente 1 millón de tokens equivalentes a 750.000 palabras, aproximadamente la longitud de una novela como Guerra y Paz.

- Tokens de Entrada: $20.00 por 1 millón de tokens

- Tokens de Salida: $80.00 por 1 millón de tokens

Los tokens de salida son más caros debido a la mayor demanda computacional para generar respuestas. A modo de comparación, el modelo estándar o3 cuesta $2.00 por millón de tokens de entrada y $8.00 por millón de tokens de salida, mientras que o3-mini es aún más barato, a $1.10 y $4.40, respectivamente. El costo elevado de o3-pro refleja sus requisitos mejorados de razonamiento y computación.

Pueden aplicarse costos adicionales por características específicas de herramientas, como la búsqueda de archivos o la generación de imágenes, que conllevan tarifas por llamada. Por ejemplo, usar la herramienta de búsqueda de archivos o integrar la generación de imágenes a través de la API aumentará el gasto total en función del uso.

Precios de la API de Lotes de o3-pro

Para usuarios de alto volumen, OpenAI ofrece una opción de API de Lotes, que procesa las solicitudes de forma asíncrona para optimizar costos. Los precios de la API de Lotes para o3-pro reflejan las tarifas estándar: $20.00 por millón de tokens de entrada y $80.00 por millón de tokens de salida. Esto es ideal para aplicaciones que requieren procesamiento a gran escala, como análisis de datos o generación masiva de contenido.

Precios Empresariales y Personalizados

Las empresas con un uso extenso de la API pueden negociar planes de precios personalizados, que pueden incluir descuentos por volumen y soporte mejorado. Estos planes se adaptan a la escala del proyecto, garantizando la rentabilidad para implementaciones a gran escala. OpenAI también ofrece capacidades de ajuste fino (fine-tuning), lo que permite a los desarrolladores personalizar o3-pro para tareas específicas, aunque esto conlleva costos adicionales basados en los recursos computacionales.

Descuentos y Accesibilidad

Para promover la accesibilidad, OpenAI ofrece tarifas reducidas para instituciones educativas y organizaciones sin fines de lucro. Las organizaciones elegibles pueden solicitar descuentos, haciendo que o3-pro sea más asequible para la investigación académica o proyectos de impacto social. Las promociones periódicas también pueden reducir los costos para usuarios nuevos o de alto volumen.

Límites de Tasa de o3-pro

Los límites de tasa son críticos para garantizar un acceso justo y fiable a la API, limitando el número de solicitudes o tokens procesados dentro de un período de tiempo determinado. Los límites de tasa de OpenAI para o3-pro varían según el nivel de uso, escalando automáticamente a medida que los usuarios aumentan su actividad y gasto en la API.

A continuación, se presenta un desglose de los niveles y sus respectivos límites:

- Nivel Gratuito: No compatible con o3-pro.

- Nivel 1: 500 solicitudes por minuto (RPM), 30.000 tokens por minuto (TPM), límite de cola de lotes de 90.000.

- Nivel 2: 5.000 RPM, 450.000 TPM, límite de cola de lotes de 1.350.000.

- Nivel 3: 5.000 RPM, 800.000 TPM, límite de cola de lotes de 50.000.000.

- Nivel 4: 10.000 RPM, 2.000.000 TPM, límite de cola de lotes de 200.000.000.

- Nivel 5: 10.000 RPM, 30.000.000 TPM, límite de cola de lotes de 5.000.000.000.

Los niveles superiores desbloquean una mayor capacidad, permitiendo a los desarrolladores manejar cargas de trabajo más grandes. El límite de cola de lotes rige el número de tokens que pueden ponerse en cola para procesamiento asíncrono, algo crítico para los usuarios de la API de Lotes. Estos límites aseguran un acceso equitativo al tiempo que se adaptan a diversos casos de uso, desde aplicaciones a pequeña escala hasta soluciones de nivel empresarial.

Características y Limitaciones de la API de o3-pro

El modelo o3-pro es compatible con una variedad de puntos finales (endpoints) y características de la API, aunque algunos no están disponibles debido a su diseño computacionalmente intensivo:

- Puntos Finales Compatibles (Supported Endpoints): Chat Completions, Responses, Assistants, Batch, Fine-tuning, Embeddings, Image Generation, Image Edit, Speech Generation, Transcription, Translation, Moderation.

- Puntos Finales No Compatibles (Unsupported Endpoints): Realtime, Completions (legacy).

- Características (Features):

- Llamada a Funciones (Function Calling): Compatible, permitiendo la integración con herramientas externas.

- Salidas Estructuradas (Structured Outputs): Compatible, asegurando formatos de respuesta consistentes.

- Herramientas (Tools): La búsqueda de archivos, la generación de imágenes y MCP (Protocolo de Control del Modelo) son compatibles a través de la API de Respuestas. La búsqueda web, el intérprete de código y el uso de la computadora no son compatibles.

- Limitaciones (Limitations):

- El streaming no es compatible, lo que refleja el procesamiento más lento y deliberado del modelo.

- El ajuste fino (fine-tuning) está disponible, pero no la destilación ni las salidas predichas.

- Las entradas de audio no son compatibles; solo se aceptan entradas de texto e imagen.

Las instantáneas (snapshots), como o3-pro-2025-06-10, permiten a los usuarios fijar una versión específica del modelo para un rendimiento consistente, asegurando la estabilidad para entornos de producción.

Conclusión

El o3-pro de OpenAI es un modelo de IA potente, que destaca en el razonamiento complejo y ofrece un rendimiento de primer nivel en benchmarks como AIME 2024 y GPQA Diamond. Su precio —$20 por millón de tokens de entrada y $80 por millón de tokens de salida— refleja su naturaleza computacionalmente intensiva, con opciones de API de Lotes y empresariales que ofrecen flexibilidad para usuarios de alto volumen. Los límites de tasa, que escalan del Nivel 1 al Nivel 5, garantizan un acceso justo al tiempo que soportan diversas cargas de trabajo.

Disponible exclusivamente a través de la API de Respuestas, la ventana de contexto de 200.000 tokens de o3-pro y el soporte para herramientas como la búsqueda de archivos y la generación de imágenes lo convierten en una opción versátil para los desarrolladores. A pesar de su menor velocidad y mayores costos en comparación con o3 y o3-mini, sus capacidades de razonamiento inigualables lo posicionan como una solución líder para abordar las tareas de IA más desafiantes. A medida que OpenAI continúa innovando, o3-pro se erige como un testimonio del potencial transformador de la IA avanzada, impulsando el progreso en todas las industrias y aplicaciones.

¿Quieres una plataforma integrada, todo en uno, para que tu equipo de desarrolladores trabaje en conjunto con máxima productividad?

Apidog satisface todas tus demandas, y reemplaza a Postman a un precio mucho más asequible!