OpenAI ha ampliado su línea de modelos de IA potentes con o1-pro, una nueva oferta diseñada para tareas avanzadas de razonamiento y resolución de problemas. Como parte de la evolución de OpenAI más allá de la serie GPT, los modelos "o" representan sistemas de IA especializados optimizados para casos de uso particulares. En esta guía completa, exploraremos todo lo que necesita saber sobre o1-pro, incluidas sus capacidades, estructura de precios y cómo implementarlo en sus aplicaciones a través de varios métodos, incluso con herramientas de prueba de API como Apidog.

¿Qué es o1-pro? ¿Y qué tan bueno es?

o1-pro es el modelo especializado de OpenAI para tareas complejas de razonamiento. Es parte de la familia de modelos "o1" que sobresalen en el pensamiento paso a paso y la resolución de problemas. La variante "pro" ofrece capacidades mejoradas sobre el modelo base, lo que la hace adecuada para aplicaciones exigentes que requieren un razonamiento sofisticado.

A diferencia de los modelos de propósito más general como GPT-4o, o1-pro se ha ajustado específicamente para tareas que requieren progresión lógica, razonamiento matemático y análisis estructurado. Este enfoque especializado le permite desempeñarse excepcionalmente bien en áreas donde el pensamiento metódico y la descomposición de problemas son cruciales.

o1-pro está diseñado con las siguientes fortalezas:

- Razonamiento avanzado: Sobresale en la descomposición de problemas complejos en pasos lógicos, lo que lo hace ideal para tareas que requieren pensamiento y análisis estructurados. Puede navegar por árboles de decisión complejos y proporcionar rutas de razonamiento explícitas.

- Resolución de problemas matemáticos: Maneja el razonamiento matemático, las pruebas y los cálculos con mayor precisión. El modelo demuestra una fortaleza particular en álgebra, cálculo, estadística y lógica formal.

- Análisis de código: Capaz de analizar, depurar y explicar el código con una comprensión detallada. Puede trabajar en múltiples lenguajes de programación e identificar errores lógicos u oportunidades de optimización.

- Pensamiento estructurado: Produce respuestas más claras y estructuradas para consultas complejas, con desgloses naturales de problemas de varios pasos y razonamiento claramente delineado.

- Investigación y análisis: Realiza un análisis en profundidad de temas con organización lógica, comparando diferentes perspectivas y evaluando metódicamente la evidencia.

- Procesamiento de cadena de pensamiento: Muestra explícitamente su proceso de razonamiento, lo que facilita el seguimiento de líneas de pensamiento complejas y la verificación de conclusiones.

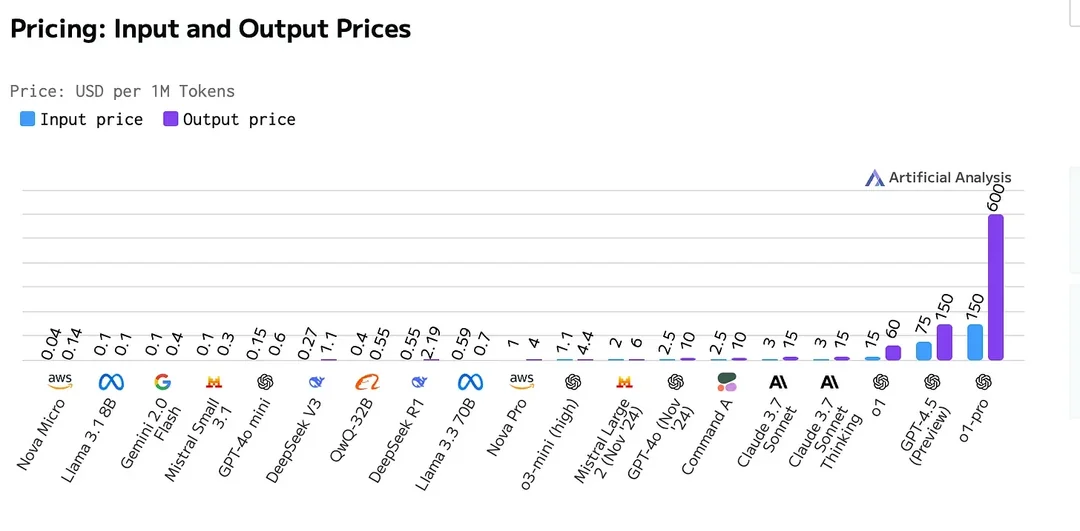

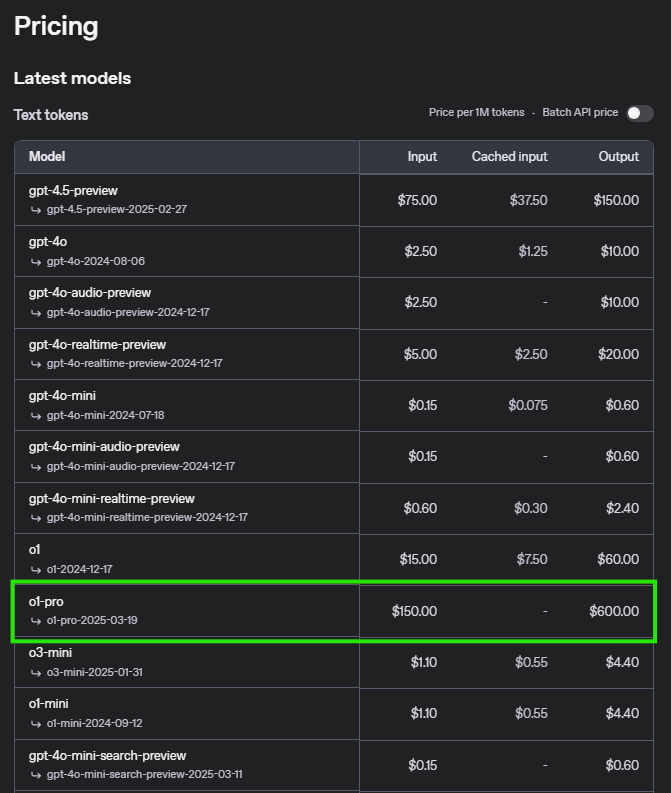

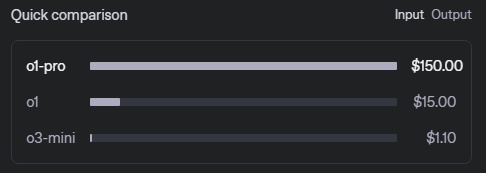

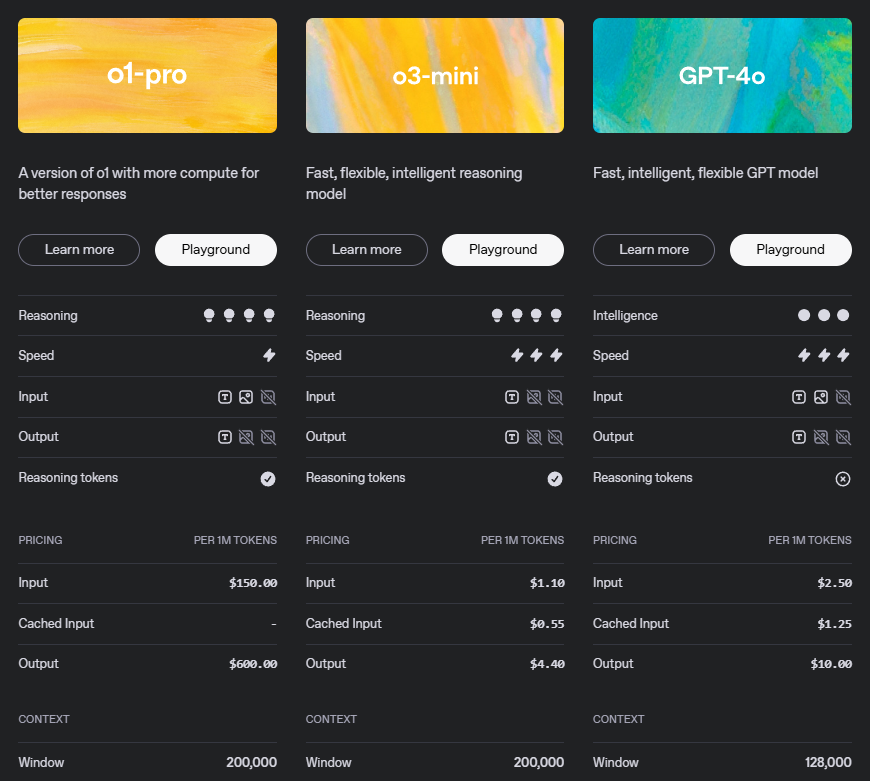

Precios de la API o1-pro

Comprender la estructura de precios es esencial para planificar el uso de su API. Aquí está el desglose detallado de o1-pro:

Este modelo de precios refleja las sofisticadas capacidades de o1-pro, particularmente su razonamiento avanzado y calidad de salida. El mayor costo de los tokens de salida reconoce el valor de las respuestas estructuradas y bien razonadas que genera el modelo.

Escenarios de ejemplo de precios

| Operación | Precio |

|---|---|

| Entrada (Prompt) | $5 por millón de tokens |

| Salida (Finalización) | $15 por millón de tokens |

Escenario 1: Uso a pequeña escala

Para un escenario con 500.000 tokens de entrada y 200.000 tokens de salida:

- Costo de entrada: 500.000 tokens × 5/millón de tokens = 2,50

- Costo de salida: 200.000 tokens × 15/millón de tokens = 3,00

- Costo total: $5,50

Escenario 2: Uso a mediana escala

Para un escenario con 5 millones de tokens de entrada y 2 millones de tokens de salida:

- Costo de entrada: 5.000.000 de tokens × 5/millón de tokens = 25,00

- Costo de salida: 2.000.000 de tokens × 15/millón de tokens = 30,00

- Costo total: $55,00

Escenario 3: Uso a gran escala

Para un escenario con 50 millones de tokens de entrada y 20 millones de tokens de salida:

- Costo de entrada: 50.000.000 de tokens × 5/millón de tokens = 250,00

- Costo de salida: 20.000.000 de tokens × 15/millón de tokens = 300,00

- Costo total: $550,00

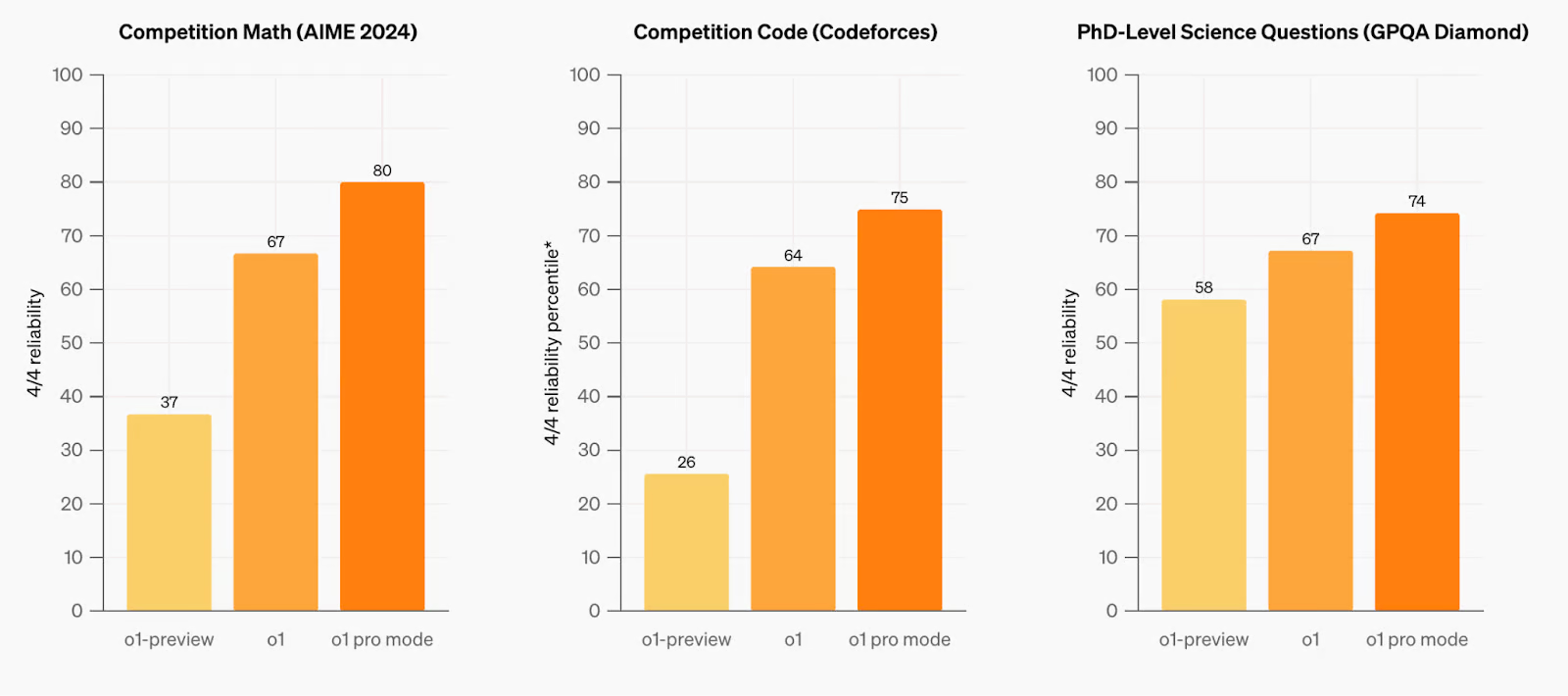

Comparación con modelos anteriores

o1-pro demuestra notables avances en el razonamiento, la resolución de problemas y la comprensión del contexto largo. El modelo ha sido rigurosamente probado en varios puntos de referencia, mostrando mejoras con respecto a sus predecesores en el manejo de consultas complejas y tareas de razonamiento de varios pasos. En dominios clave como las matemáticas, la codificación y la planificación estructurada, o1-pro exhibe una mayor precisión y confiabilidad, superando a los modelos anteriores tanto en rendimiento como en eficiencia. Su arquitectura optimizada permite una mejor comprensión de las indicaciones intrincadas, lo que lo convierte en un fuerte contendiente para aplicaciones avanzadas que requieren razonamiento de alto nivel y capacidades de contexto extendido.

Puede encontrar la comparación completa de los modelos de OpenAI, incluidas las especificaciones detalladas y los puntos de referencia, en la página oficial de documentación de OpenAI.

Requisitos de la API OpenAI O1 Pro y límites de velocidad

| Nivel | Calificación | Límites de uso |

|---|---|---|

| Gratis | El usuario debe estar en una geografía permitida | $100/mes |

| Nivel 1 | $5 pagados | $100/mes |

| Nivel 2 | $50 pagados y más de 7 días desde el primer pago exitoso | $500/mes |

| Nivel 3 | $100 pagados y más de 7 días desde el primer pago exitoso | $1,000/mes |

| Nivel 4 | $250 pagados y más de 14 días desde el primer pago exitoso | $5,000/mes |

| Nivel 5 | $1,000 pagados y más de 30 días desde el primer pago exitoso | $50,000/mes |

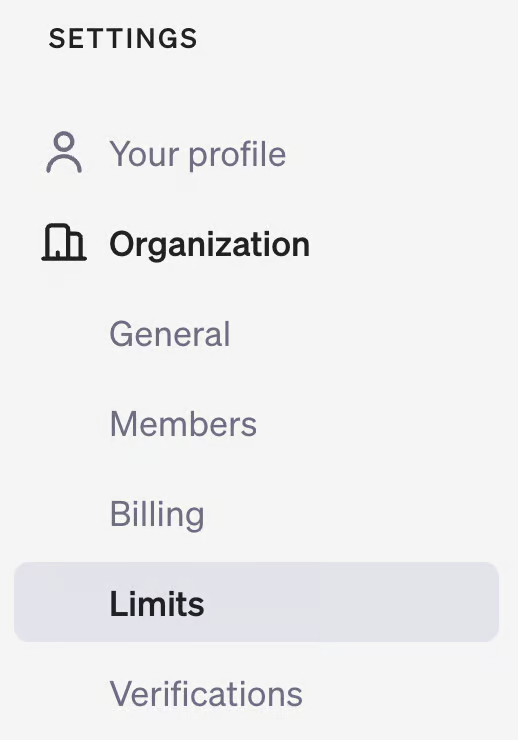

Para verificar su nivel de uso, visite la página de su cuenta en la plataforma para desarrolladores de OpenAI y consulte la sección "Límites" en "Organización".

Cómo usar la API 01

Implementar o1-pro en sus aplicaciones es sencillo. Siga estos pasos para comenzar:

1. Requisitos previos

- Una clave de API de OpenAI (obtener de su panel de control de OpenAI)

- Un entorno de desarrollo compatible con las bibliotecas apropiadas

- Créditos de API suficientes o método de pago vinculado a su cuenta de OpenAI

2. Instalación

Instale la biblioteca OpenAI para su lenguaje de programación preferido:

Para Python:

pip install openai

Para JavaScript:

npm install openai

Para otros lenguajes, consulte la documentación oficial de OpenAI para las bibliotecas de cliente.

3. Ejemplo de implementación de Python

Aquí se explica cómo usar o1-pro en Python con parámetros detallados:

from openai import OpenAI

client = OpenAI(api_key="your-api-key")

response = client.chat.completions.create(

model="o1-pro",

messages=[

{"role": "system", "content": "Eres un asistente de IA especializado en razonamiento matemático. Proporcione soluciones claras paso a paso con explicaciones para cada paso."},

{"role": "user", "content": "Resuelva este problema de cálculo paso a paso: encuentre la derivada de f(x) = x^3*ln(x)."}

],

temperature=0.1, # Temperatura más baja para un razonamiento más preciso

max_tokens=1024, # Ajustar según la longitud de respuesta esperada

top_p=0.95,

frequency_penalty=0,

presence_penalty=0

)

print(response.choices[0].message.content)

4. Ejemplo de implementación de JavaScript

Para aplicaciones Node.js con una configuración más detallada:

import OpenAI from 'openai';

const openai = new OpenAI({

apiKey: 'your-api-key',

});

async function askO1Pro() {

try {

const response = await openai.chat.completions.create({

model: 'o1-pro',

messages: [

{role: 'system', content: 'Eres un asistente de IA especializado en razonamiento matemático. Proporcione soluciones claras paso a paso con explicaciones para cada paso.'},

{role: 'user', content: 'Resuelva este problema de cálculo paso a paso: encuentre la derivada de f(x) = x^3*ln(x).'}

],

temperature: 0.1,

max_tokens: 1024,

top_p: 0.95,

frequency_penalty: 0,

presence_penalty: 0

});

console.log(response.choices[0].message.content);

// Optional: Track token usage

console.log("Prompt tokens:", response.usage.prompt_tokens);

console.log("Completion tokens:", response.usage.completion_tokens);

console.log("Total tokens:", response.usage.total_tokens);

} catch (error) {

console.error('Error:', error);

}

}

askO1Pro();

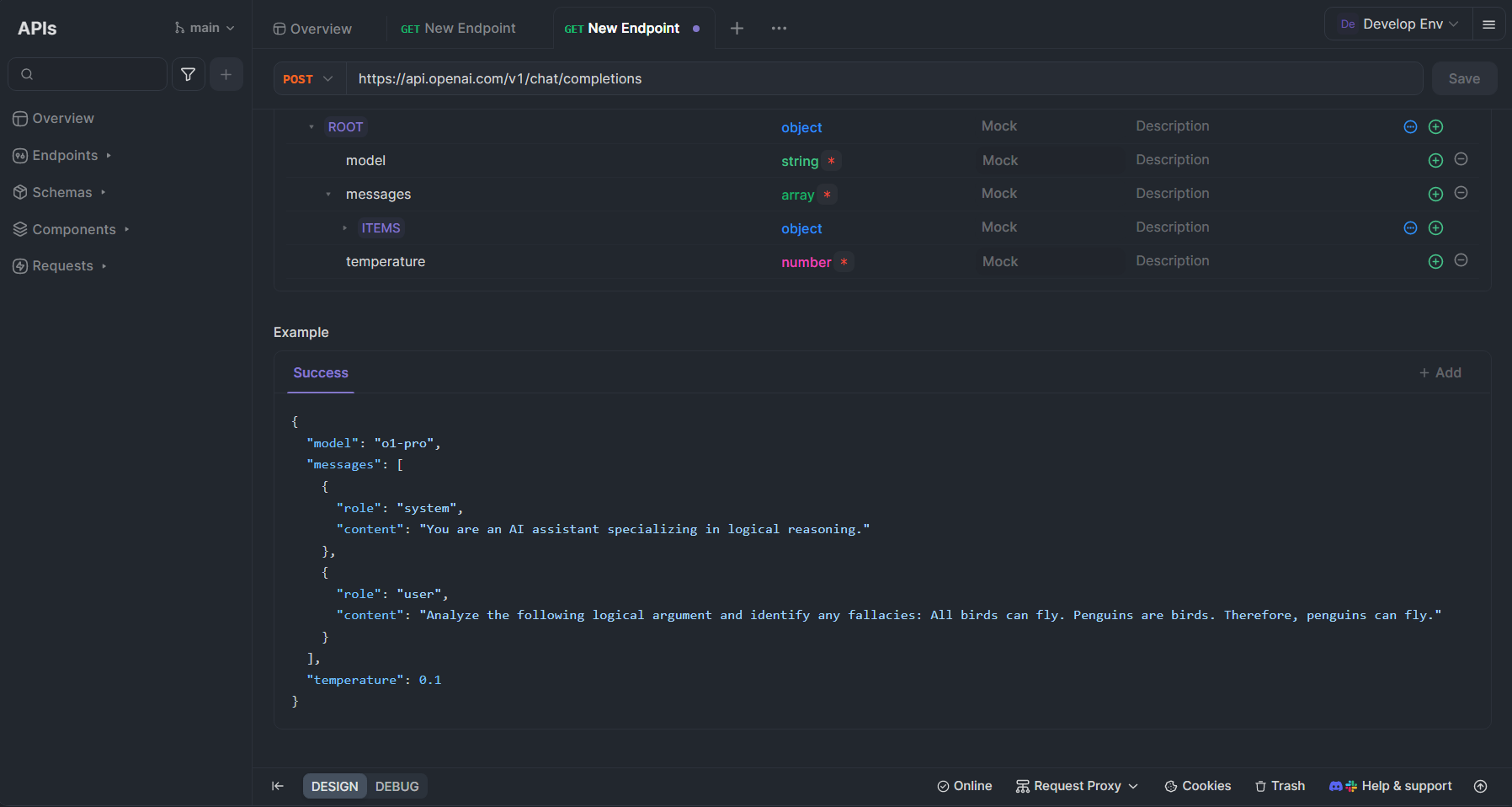

Probar la API o1-pro con Apidog

Apidog es una plataforma integral de desarrollo de API que puede optimizar significativamente su trabajo con o1-pro y otras API de OpenAI. Aquí se explica cómo puede aprovechar Apidog para probar e integrar o1-pro en su flujo de trabajo:

Configurar o1-pro en Apidog

- Crear una cuenta: Regístrese en Apidog en apidog.com si aún no tiene una cuenta.

- Crear una nueva colección de API: En su panel de control de Apidog, cree una nueva colección específicamente para las API de OpenAI.

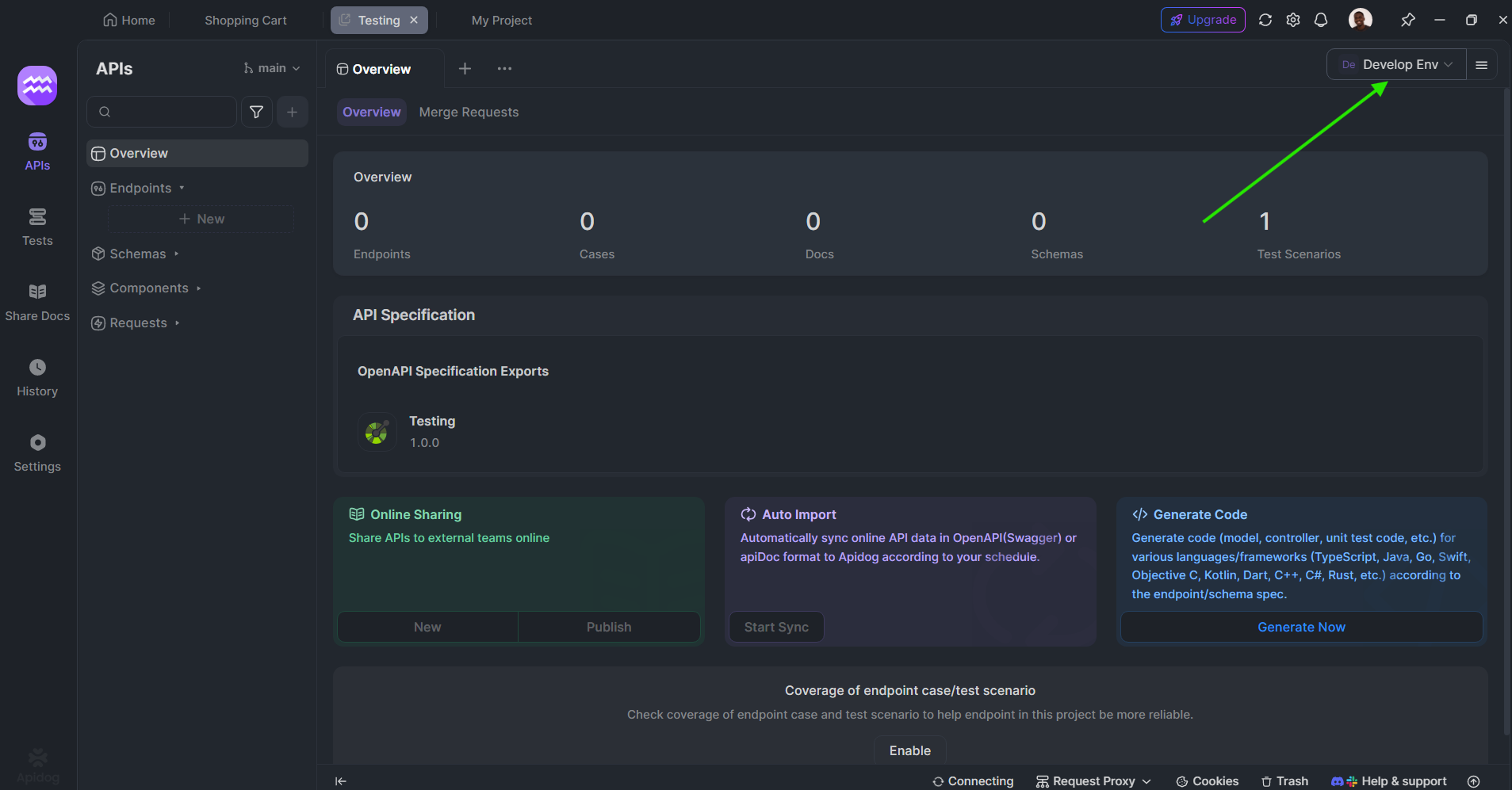

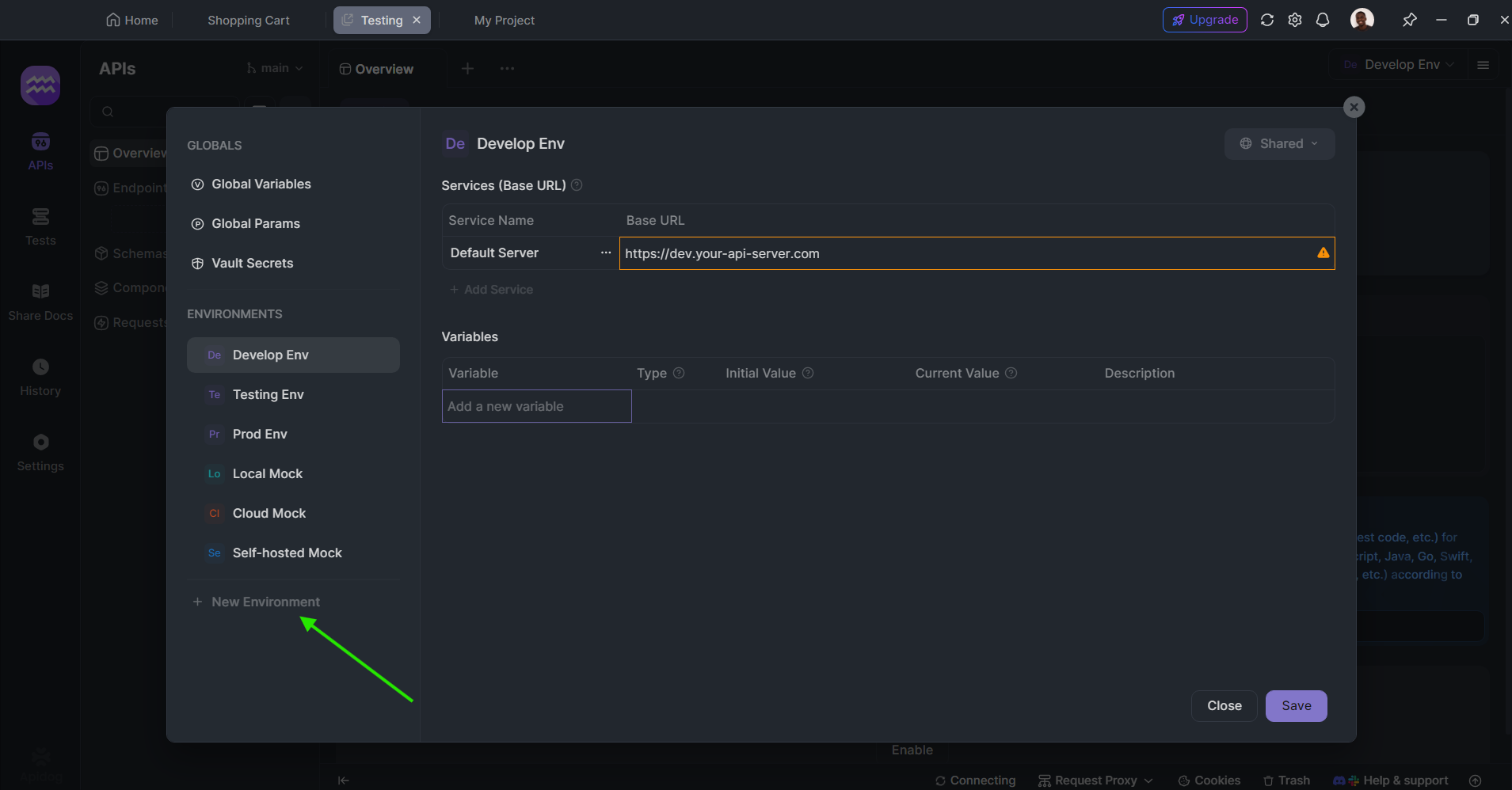

Establecer variables de entorno: Configure su clave de API de OpenAI como una variable de entorno para un acceso seguro y conveniente:

- Vaya a Entornos en la esquina superior derecha

- Cree un nuevo entorno llamado "OpenAI"

- Agregue una variable llamada "OPENAI_API_KEY" con su clave de API real como valor

Crear una solicitud para o1-pro:

- Cree una nueva solicitud POST

- Establezca la URL en

https://api.openai.com/v1/chat/completions - Agregue un encabezado de autorización con el valor

Bearer {{OPENAI_API_KEY}} - En el cuerpo de la solicitud (JSON), use:

{

"model": "o1-pro",

"messages": [

{

"role": "system",

"content": "Eres un asistente de IA especializado en razonamiento lógico."

},

{

"role": "user",

"content": "Analice el siguiente argumento lógico e identifique cualquier falacia: Todos los pájaros pueden volar. Los pingüinos son pájaros. Por lo tanto, los pingüinos pueden volar."

}

],

"temperature": 0.1

}

Beneficios de usar Apidog con o1-pro

Apidog ofrece varias ventajas para trabajar con o1-pro:

- Pruebas interactivas: Pruebe las llamadas API en tiempo real y vea las respuestas formateadas, lo que facilita la iteración en las indicaciones.

- Documentación automática: Documente sus implementaciones de API automáticamente, lo que facilita la colaboración en equipo.

- Simulación de API: Cree respuestas simuladas para las llamadas API de o1-pro durante el desarrollo.

- Funciones de colaboración: Comparta colecciones de API con los miembros del equipo para el desarrollo colaborativo.

- Administración del entorno: Cambie fácilmente entre entornos de desarrollo, prueba y producción con diferentes claves de API.

- Visualización de la respuesta: Obtenga una representación visual clara del uso de tokens y los costos para una mejor administración del presupuesto.

- Historial de solicitudes: Realice un seguimiento de las llamadas API anteriores para referencia y optimización.

Mejores prácticas para usar las API de o1-pro

Para maximizar la eficacia de o1-pro y optimizar sus costos:

- Estructure sus indicaciones claramente: Para tareas complejas de razonamiento, estructure sus indicaciones con instrucciones claras y salidas esperadas. Considere usar viñetas o instrucciones numeradas para problemas de varias partes.

- Use los mensajes del sistema de manera efectiva: Establezca el contexto con mensajes del sistema para guiar a o1-pro hacia el enfoque de razonamiento que desea. Sea específico sobre el tipo de razonamiento (deductivo, inductivo, etc.) que espera.

Ajustar los parámetros de temperatura:

- Temperatura más baja (0,1-0,3) para un razonamiento más preciso y determinista y problemas matemáticos

- Temperatura moderada (0,3-0,7) para un razonamiento equilibrado con cierta flexibilidad

- Temperatura más alta para enfoques de resolución de problemas más creativos

- Solicitar pensamiento paso a paso: Solicite explícitamente pasos de razonamiento detallados al resolver problemas complejos. Frases como "Piense en esto paso a paso" o "Muestre su razonamiento" ayudan a activar las fortalezas de o1-pro.

- Supervisar el uso de tokens: Realice un seguimiento de los tokens de entrada y salida para administrar los costos de manera efectiva. Considere implementar una función de estimación de tokens en su aplicación.

- Procesar por lotes las consultas relacionadas: Cuando sea posible, combine preguntas relacionadas en una sola llamada API en lugar de realizar varias llamadas separadas.

- Implementar el almacenamiento en caché: Almacene en caché las respuestas comunes para evitar llamadas API redundantes para la información solicitada con frecuencia.

- Usar técnicas de cadena de pensamiento: Para problemas complejos, implemente el mensaje de cadena de pensamiento pidiéndole al modelo que "piense en este problema paso a paso antes de proporcionar la respuesta final".

Conclusión

o1-pro representa un avance significativo en las capacidades de razonamiento de la IA, que ofrece herramientas poderosas para tareas que requieren pensamiento estructurado y resolución de problemas complejos. Con su estructura de precios competitiva y su implementación sencilla, es accesible para los desarrolladores que buscan mejorar sus aplicaciones con capacidades de razonamiento avanzadas.

Siguiendo las pautas de implementación y las mejores prácticas descritas en este artículo, puede integrar eficazmente o1-pro en sus flujos de trabajo y aprovechar sus sofisticadas capacidades de razonamiento mientras administra sus costos de API de manera eficiente. Herramientas como Apidog agilizan aún más el proceso de desarrollo y prueba, lo que facilita el aprovechamiento de todo el potencial de o1-pro para sus casos de uso específicos.

A medida que las capacidades de razonamiento de la IA continúan avanzando, los modelos como o1-pro se convertirán cada vez más en componentes esenciales en las aplicaciones que requieren no solo inteligencia, sino también un pensamiento lógico y estructurado que los usuarios puedan seguir y comprender.