El implacable avance de la inteligencia artificial está transformando industrias, y la ingeniería de software se encuentra a la vanguardia de esta transformación. Las herramientas impulsadas por IA ya no son conceptos futuristas, sino asistentes prácticos que aumentan las capacidades de los desarrolladores y optimizan flujos de trabajo complejos. OpenAI, un nombre destacado en la investigación de IA, ha presentado recientemente su última contribución a este panorama en evolución: ChatGPT Codex, un agente de ingeniería de software basado en la nube diseñado para abordar una multitud de tareas de codificación en paralelo. Esta nueva oferta, inicialmente disponible para usuarios de ChatGPT Pro, Team y Enterprise, con versiones Plus y Edu en el horizonte, promete redefinir la forma en que los desarrolladores interactúan con sus bases de código y construyen software.

¿Quieres una plataforma integrada y todo en uno para que tu equipo de desarrolladores trabaje junto con máxima productividad?

¡Apidog satisface todas tus demandas y reemplaza a Postman a un precio mucho más asequible!

El amanecer de la ingeniería de software impulsada por IA: Presentando Codex

Imagina un panel de control que te pregunta: "¿Qué deberíamos codificar a continuación?", completo con un cuadro de indicaciones, selectores de repositorio y rama, y una lista de tareas, todo ello sobre un fondo pastel con temática de código. Esta es la puerta de entrada a Codex, un agente preparado para convertirse en una parte indispensable del conjunto de herramientas de un desarrollador. Codex está diseñado para manejar una amplia gama de tareas, desde escribir nuevas funcionalidades y responder preguntas complejas sobre una base de código hasta corregir errores y proponer solicitudes de extracción (pull requests) para revisión. Cada tarea se procesa meticulosamente en su propio entorno de sandbox en la nube, precargado con el repositorio específico, garantizando aislamiento y enfoque.

En esencia, Codex está impulsado por codex-1, una versión especializada del modelo o3 de OpenAI, ajustada para las sutilezas de la ingeniería de software. La destreza de este modelo proviene de un riguroso aprendizaje por refuerzo, donde fue entrenado en tareas de codificación del mundo real en diversos entornos. El objetivo era claro: generar código que no solo funcione sin problemas, sino que también refleje las preferencias estilísticas humanas, se adhiera precisamente a las instrucciones y pueda ejecutar pruebas de forma iterativa hasta lograr un resultado satisfactorio. El lanzamiento de Codex significa un paso importante hacia una asistencia de codificación más inteligente y autónoma.

Bajo el capó: Cómo opera Codex

El acceso a Codex es sencillo para los usuarios elegibles de ChatGPT, con una sección dedicada en la barra lateral. Los desarrolladores pueden asignar nuevas tareas de codificación escribiendo una indicación e iniciando el comando "Code", o plantear preguntas sobre su base de código utilizando la función "Ask".

El verdadero poder de Codex reside en sus capacidades de procesamiento paralelo. Cada tarea se maneja de forma independiente dentro de un sandbox en la nube separado y aislado. Este entorno viene precargado con la base de código relevante, lo que permite a Codex leer y editar archivos, ejecutar comandos (incluyendo arneses de prueba, linters y verificadores de tipo) y operar sin interferencias de otras tareas en curso. Los tiempos de finalización de las tareas varían, generalmente entre uno y treinta minutos dependiendo de la complejidad, y los usuarios pueden monitorear el progreso en tiempo real.

Un aspecto crucial de Codex es su compromiso con el trabajo verificable. Una vez completada una tarea, Codex confirma sus cambios dentro de su entorno. No solo presenta el código final; proporciona evidencia verificable de sus acciones a través de citas de registros de terminal y salidas de prueba. Esta transparencia permite a los desarrolladores rastrear cada paso dado durante la finalización de la tarea, fomentando la confianza y permitiendo una revisión exhaustiva. Luego, los usuarios pueden decidir solicitar revisiones adicionales, abrir una solicitud de extracción (pull request) en GitHub, o integrar directamente los cambios en su entorno de desarrollo local. Además, el entorno de Codex se puede configurar para reflejar de cerca la configuración de desarrollo real del usuario, garantizando compatibilidad y relevancia.

Guiando al agente: El papel de AGENTS.md y las directivas del sistema

Para mejorar aún más su eficacia y adaptar su comportamiento a las necesidades específicas del proyecto, Codex puede ser guiado por archivos AGENTS.md ubicados dentro de un repositorio. Estos archivos de texto, al igual que el familiar README.md, sirven como un canal de comunicación entre los desarrolladores humanos y el agente de IA. A través de AGENTS.md, los desarrolladores pueden informar a Codex sobre cómo navegar por la base de código, qué comandos ejecutar para las pruebas y la mejor manera de adherirse a los estándares y prácticas de codificación establecidos del proyecto. Al igual que con los desarrolladores humanos, los agentes de Codex funcionan de manera óptima cuando se les proporcionan entornos de desarrollo bien configurados, configuraciones de prueba fiables y documentación clara.

El mensaje subyacente del sistema para codex-1 también revela un conjunto explícito de instrucciones que rigen su comportamiento. Por ejemplo, al modificar archivos, se le indica a Codex que no cree nuevas ramas, que use git para confirmar los cambios (reintentando en caso de fallos de pre-commit), y que se asegure de que el área de trabajo (worktree) quede en un estado limpio. Enfatiza que solo se evaluará el código confirmado y que los commits existentes no deben ser modificados.

La especificación de AGENTS.md es bastante detallada. Su alcance es todo el árbol de directorios con raíz en su ubicación, y sus instrucciones tienen precedencia según la profundidad de anidamiento, aunque las indicaciones directas del usuario pueden anularlas. Una directiva clave es que si AGENTS.md incluye verificaciones programáticas, Codex debe ejecutar todas ellas y esforzarse por validar su éxito después de todos los cambios de código, incluso para modificaciones aparentemente simples como actualizaciones de documentación. Las instrucciones de citación también son rigurosas, exigiendo referencias precisas de rutas de archivo y salidas de terminal para cualquier archivo navegado o comando ejecutado, asegurando un claro rastro de auditoría.

Poniendo a prueba a Codex: Rendimiento y benchmarks

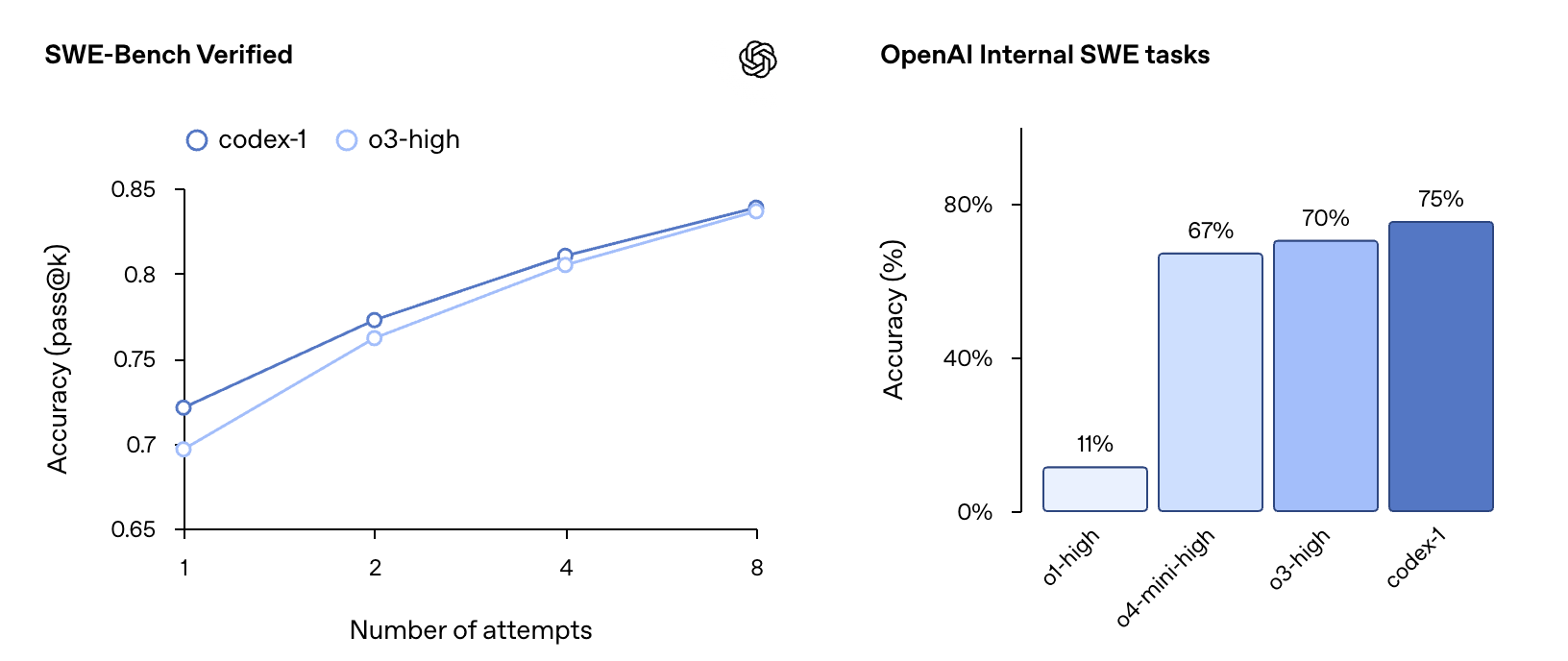

OpenAI informa que codex-1 demuestra un sólido rendimiento en evaluaciones de codificación y benchmarks internos, incluso sin una personalización extensa a través de archivos AGENTS.md o scaffolding específico. En el benchmark SWE-Bench Verified, codex-1 mostró una progresión de precisión pass@k del 67% en k=1 al 75% en k=8, superando a o3-high (que obtuvo un 70% en k=8 en un subconjunto ligeramente diferente). En las tareas internas de Ingeniería de Software (SWE) de OpenAI, un conjunto curado de desafíos internos del mundo real, codex-1 logró una precisión del 70%, significativamente mayor que o1-high (25%), o4-mini-high (40%) y o3-high (61%). Estas pruebas se realizaron con codex-1 con una longitud de contexto máxima de 192k tokens y un 'esfuerzo de razonamiento' medio, reflejando las configuraciones disponibles en el producto.

Construyendo con confianza: Seguridad, confianza y consideraciones éticas

Codex se lanza como una vista previa de investigación, alineándose con la estrategia de despliegue iterativo de OpenAI. Este enfoque permite el aprendizaje y el refinamiento basados en el uso en el mundo real. La seguridad y la transparencia fueron primordiales en el diseño de Codex. La capacidad de los usuarios para verificar las salidas a través de citas, registros de terminal y resultados de pruebas es una piedra angular de esta filosofía, una salvaguarda que se vuelve cada vez más vital a medida que los modelos de IA manejan tareas de codificación más complejas de forma independiente.

Cuando se enfrenta a la incertidumbre o a fallos en las pruebas, el agente Codex está diseñado para comunicar explícitamente estos problemas, permitiendo a los usuarios tomar decisiones informadas. Sin embargo, OpenAI subraya que sigue siendo esencial que los usuarios revisen y validen manualmente todo el código generado por el agente antes de la integración y ejecución.

Abordar el potencial de uso indebido, particularmente en áreas como el desarrollo de malware, es una preocupación crítica. Codex ha sido entrenado para identificar y rechazar precisamente las solicitudes dirigidas a crear software malicioso, al tiempo que distingue y apoya tareas legítimas y avanzadas que podrían implicar técnicas similares (por ejemplo, ingeniería de kernel de bajo nivel). Marcos de políticas mejorados y evaluaciones de seguridad rigurosas, detalladas en un anexo a la Tarjeta del Sistema o3, refuerzan estos límites.

El agente opera completamente dentro de un contenedor seguro y aislado en la nube. Durante la ejecución de tareas, el acceso a internet está deshabilitado, restringiendo las interacciones únicamente al código proporcionado explícitamente a través de repositorios de GitHub y dependencias preinstaladas configuradas por el usuario. Esto significa que el agente no puede acceder a sitios web externos, API u otros servicios, mitigando significativamente los riesgos de seguridad.

Un toque humano: Alineándose con las preferencias y flujos de trabajo de los desarrolladores

Un objetivo principal durante el entrenamiento de codex-1 fue alinear sus resultados estrechamente con las preferencias y estándares de codificación humanos. En comparación con el modelo de propósito general OpenAI o3, codex-1 produce consistentemente parches más limpios que son más fácilmente revisables por humanos y más fáciles de integrar en flujos de trabajo estándar. Esto se demuestra a través de varios ejemplos de correcciones aplicadas a proyectos de código abierto populares:

Proyecto: Astropy (Librería de Astronomía en Python)

- El error: La función

separability_matrixcalculaba incorrectamente la separabilidad para instancias anidadas deCompoundModel. Por ejemplo, si un modelo compuesto comom.Linear1D(10) & m.Linear1D(5)estaba anidado dentro de otro, la matriz resultante indicaba erróneamente dependencias donde no existían. - La solución de Codex:

- Se realizó una modificación específica a la función

_cstackenastropy/modeling/separable.py. - Este cambio manejó correctamente las dimensiones y valores de la matriz del lado derecho cuando representaba un array precalculado (es decir, un modelo anidado).

- Pruebas: Se añadió una prueba de regresión precisa a

test_separable.pypara confirmar la corrección, asegurando que la salida fuera la matriz de separabilidad esperada en bloques diagonales para modelos anidados. - Comparación: Esta corrección se notó como más directa y menos detallada que una posible alternativa de

o3, que había incluido extensos comentarios explicativos.

Proyecto: Matplotlib (Librería de Trazado en Python)

- El error: Un problema en

mlab._spectral_helpercausaba una corrección de ventana incorrecta debido a una llamada innecesaria anp.abs(). Esto llevaba a resultados inexactos para ventanas con valores negativos (por ejemplo, la ventanaflattop). - La solución de Codex:

- Se eliminaron las llamadas a

np.abs()de(np.abs(window)**2).sum()ynp.abs(window).sum()**2. - Estas se cambiaron a

(window.conjugate() * window).sum()ywindow.sum()**2respectivamente. - Esta modificación asegura que el escalado utilice los valores reales de la ventana, preservando la potencia con precisión.

- Pruebas: Se añadió una nueva prueba,

test_psd_windowarray_negative, alib/matplotlib/tests/test_mlab.pypara verificar específicamente esta corrección utilizando una ventana que contenía valores negativos.

Proyecto: Django (Framework Web en Python)

- El error: Las expresiones solo de duración (por ejemplo,

F('estimated_time') + datetime.timedelta(1)) fallaban en SQLite y MySQL, generando un errordecimal.InvalidOperation. Esto se debía a problemas en la conversión de valores de duración. - La solución de Codex:

- El método

convert_durationfield_valueendjango/db/backends/base/operations.pyse refinó para manejar de forma robusta varios tipos de entrada para la duración (comoNone,timedelta,stringeint). - Se ajustó la compilación de los lados para

DurationExpressionendjango/db/models/expressions.py, asegurando queformat_for_duration_arithmeticse aplique de forma más selectiva, principalmente cuando se combina con tipos de fecha/hora. - Pruebas: Se añadió una nueva prueba,

test_durationfield_only_expression, entests/expressions/tests.pypara validar esta corrección. - Comparación: La solución de

o3para este problema de Django se describió como más extensa en su lógica de verificación de tipos y análisis dentro deconvert_durationfield_value, ofreciendo un enfoque muy detallado para manejar diferentes representaciones de cadenas y números de duraciones.

Proyecto: Expensify (ReportUtils.ts - TypeScript)

- El problema: Los nombres de las salas de los miembros no se actualizaban en el Navegador Izquierdo (LHN) después de borrar la caché.

- Solución propuesta por Codex (basada en los diffs proporcionados relacionados con el almacenamiento en caché de nombres de informes):

- El diff de "Codex" modificó la función

getCacheKeypara incluirpolicyName. Este cambio podría hacer que las claves de caché fueran más específicas, potencialmente evitando la obsolescencia si los nombres de las políticas influyen en los títulos de las salas. - Propuesta alternativa de

OpenAI o3: - El diff de "OpenAI o3" sugirió una solución más estructural para la invalidación de caché: asegurar que

reportNameCachese borre cada vez que se actualiceONYXKEYS.COLLECTION.POLICY. Esto aborda directamente los datos obsoletos al actualizar proactivamente la caché cuando cambia la información subyacente de la política (que puede afectar los nombres de las salas). - Conclusión: Este ejemplo destaca cómo la IA puede proponer diferentes estrategias, desde refinar las claves de caché hasta implementar mecanismos de invalidación más amplios, para abordar tales problemas.

Estos ejemplos ilustran colectivamente la capacidad de Codex para comprender problemas complejos e implementar soluciones específicas y efectivas, frecuentemente incluyendo los casos de prueba necesarios para asegurar la corrección.

Ampliando el alcance: Actualizaciones a la CLI de Codex

Como complemento al agente basado en la nube, OpenAI también ha actualizado la CLI de Codex, un agente de codificación ligero y de código abierto que se ejecuta directamente en la terminal. Una nueva versión más pequeña de codex-1, llamada codex-mini-latest (una versión especializada de o4-mini), es ahora el modelo predeterminado en la CLI de Codex. Está optimizada para preguntas y respuestas de código de baja latencia y edición, conservando sólidas capacidades de seguimiento de instrucciones y estilo.

Conectar una cuenta de desarrollador a la CLI de Codex también se ha simplificado. En lugar de la generación manual de tokens de API, los usuarios ahora pueden iniciar sesión con su cuenta de ChatGPT y seleccionar su organización de API, con la CLI manejando la configuración automática de la clave de API. Los usuarios Plus y Pro que inicien sesión de esta manera también pueden canjear créditos de API gratuitos.

Acceso, asequibilidad y aspiraciones: Disponibilidad, precios y limitaciones

Codex se está implementando actualmente para usuarios de ChatGPT Pro, Enterprise y Team a nivel mundial, y se espera pronto el soporte para Plus y Edu. El acceso inicial será generoso y sin costo adicional durante varias semanas, permitiendo a los usuarios explorar sus capacidades. Posteriormente, OpenAI introducirá acceso con límite de tasa y opciones de precios flexibles para el uso bajo demanda. Para los desarrolladores que utilizan codex-mini-latest a través de la API, tiene un precio de $1.50 por 1 millón de tokens de entrada y $6 por 1 millón de tokens de salida, con un descuento del 75% por almacenamiento en caché de indicaciones.

Como vista previa de investigación, Codex tiene limitaciones. Actualmente carece de funciones como entradas de imágenes para el desarrollo frontend y la capacidad de corregir el rumbo del agente a mitad de tarea. Delegar tareas a un agente remoto también introduce una latencia en comparación con la edición interactiva, lo que puede requerir cierto ajuste en el flujo de trabajo. OpenAI prevé que la interacción con los agentes de Codex se parecerá cada vez más a la colaboración asíncrona con colegas humanos.

El camino por delante: El futuro de la IA en la ingeniería de software con Codex

OpenAI imagina un futuro en el que los desarrolladores impulsen el trabajo que desean poseer y deleguen el resto a agentes de IA altamente capaces, lo que conducirá a un aumento de la velocidad y la productividad. Para lograr esto, están construyendo un conjunto de herramientas Codex que admiten tanto la colaboración en tiempo real como la delegación asíncrona. Si bien las herramientas de emparejamiento de IA como la CLI de Codex se están convirtiendo en normas de la industria, el flujo de trabajo asíncrono y multiagente introducido por Codex en ChatGPT se considera el futuro estándar de facto para producir código de alta calidad.

En última instancia, se espera que estos dos modos de interacción (emparejamiento en tiempo real y delegación de tareas) converjan. Los desarrolladores colaborarán con agentes de IA a través de sus IDEs y herramientas cotidianas para preguntas y respuestas, sugerencias y descarga de tareas más largas en un flujo de trabajo unificado. Los planes futuros incluyen flujos de trabajo de agente más interactivos y flexibles, permitiendo a los desarrolladores proporcionar orientación a mitad de tarea, colaborar en estrategias de implementación y recibir actualizaciones proactivas del progreso. También se planean integraciones más profundas en herramientas como GitHub, la CLI de Codex, ChatGPT Desktop, sistemas de seguimiento de problemas y sistemas CI.

La ingeniería de software es una de las primeras industrias en presenciar ganancias significativas de productividad impulsadas por la IA, abriendo nuevas posibilidades para individuos y equipos pequeños. Si bien son optimistas sobre estos avances, OpenAI también está colaborando con socios para comprender las implicaciones más amplias de la adopción generalizada de agentes en los flujos de trabajo de los desarrolladores y el desarrollo de habilidades en diversas poblaciones.

El lanzamiento de ChatGPT Codex es más que una nueva herramienta; es un vistazo a un futuro donde el ingenio humano y la inteligencia artificial colaboran de manera más fluida que nunca para construir la próxima generación de software. Esto es solo el comienzo, y el potencial de lo que los desarrolladores pueden construir con Codex es vasto y emocionante.