¿Te gustaría chatear con potentes modelos de lenguaje como Llama 3.1 o Mistral sin quedarte atascado en una terminal? Open WebUI es tu boleto a una interfaz elegante, similar a ChatGPT, que hace que interactuar con los LLMs de Ollama sea divertido e intuitivo. Te permite guardar historiales de chat, almacenar prompts e incluso subir documentos para obtener respuestas más inteligentes, todo en tu navegador. En esta guía para principiantes, te guiaré a través de la instalación de Ollama, probaremos un modelo en la terminal y luego daremos un paso más con Open WebUI para una experiencia más fácil de usar. Usaremos Docker para una configuración rápida y lo probaremos con un prompt divertido. ¿Listo para hacer que los chats con IA sean pan comido? ¡Pongámonos en marcha!

¿Qué es Open WebUI? Tu centro de mando para LLMs

Open WebUI es una interfaz web de código abierto y autoalojada que se conecta a Ollama, permitiéndote interactuar con grandes modelos de lenguaje (LLMs) como Llama 3.1 o Mistral en un panel basado en navegador. A diferencia de la interfaz de línea de comandos de Ollama, Open WebUI se siente como ChatGPT, ofreciendo:

- Historial de chat: Guarda y revisa tus conversaciones.

- Almacenamiento de prompts: Guarda y reutiliza tus prompts favoritos.

- Subida de documentos: Añade archivos para respuestas conscientes del contexto (Generación Aumentada por Recuperación, o RAG).

- Cambio de modelo: Cambia fácilmente entre modelos con un clic.

Con más de 50K estrellas en GitHub, Open WebUI es un éxito para desarrolladores y entusiastas de la IA que desean una forma colaborativa y gráfica de trabajar con LLMs localmente. Primero, ¡pongamos Ollama en marcha para ver por qué vale la pena añadir Open WebUI!

Instalando y probando Ollama

Antes de sumergirnos en Open WebUI, configuremos Ollama y probemos un modelo como Llama 3.1 o Mistral en la terminal. Esto te dará una base para apreciar la interfaz intuitiva de Open WebUI.

1. Verifica los requisitos del sistema:

- SO: Windows, macOS o Linux (Ubuntu 24.04 o similar).

- Hardware: Al menos 16 GB de RAM y 10 GB de almacenamiento libre para los modelos (Llama 3.1 8B necesita ~5 GB). Una GPU (por ejemplo, NVIDIA 1060 4GB) es opcional para un rendimiento más rápido.

- Software: Ollama, descargable desde ollama.com.

2. Instala Ollama: Descarga e instala Ollama desde ollama.com para tu sistema operativo. Sigue las indicaciones del instalador, es una configuración rápida. Verifica la instalación con:

ollama --version

Espera una versión como 0.1.44 (abril de 2025). Si falla, asegúrate de que Ollama está en tu PATH.

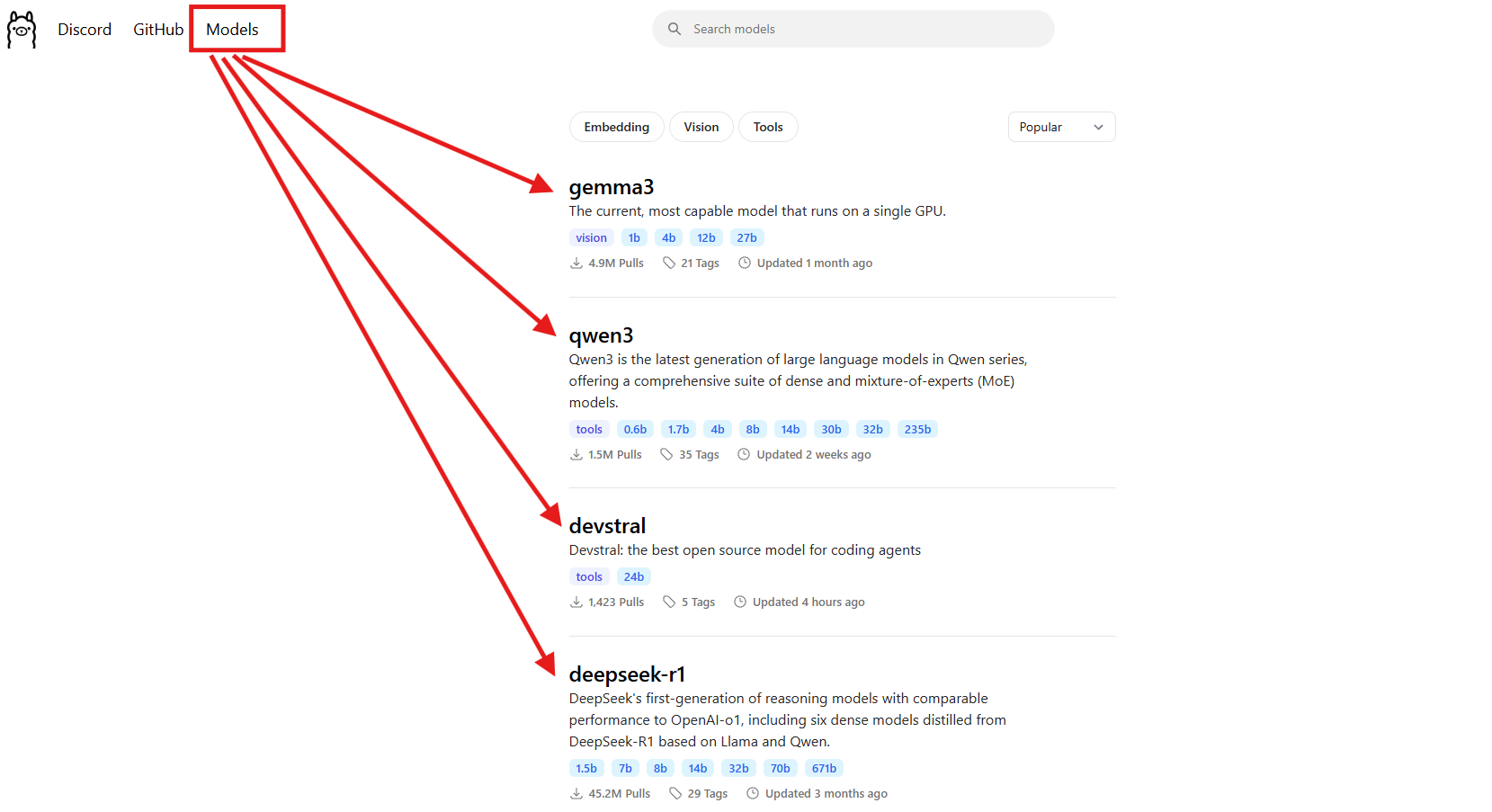

3. Descarga un modelo: Elige un modelo como Llama 3.1 (8B) o Mistral (7B). Para esta guía, usaremos Llama 3.1:

ollama pull llama3.1

Esto descarga ~5 GB, así que tómate un café si tu internet es lento. Verifica que esté instalado:

ollama list

Busca llama3.1:latest. Mistral (ollama pull mistral) es otra gran opción si quieres un modelo más ligero (~4 GB).

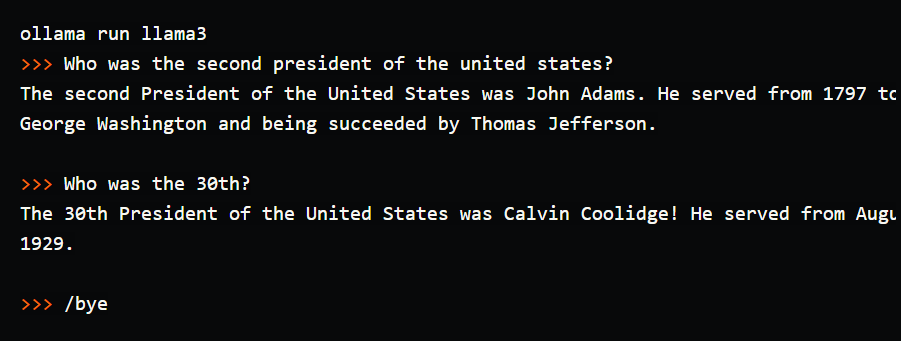

4. Prueba el modelo en la terminal: Prueba un prompt simple para ver Ollama en acción:

ollama run llama3.1

En el prompt (>>>), escribe: "Cuéntame un chiste de padre sobre ordenadores". Pulsa Enter. Podrías obtener: "¿Por qué el ordenador fue al médico? ¡Tenía un virus!" Sal con /bye. Ejecuté esto y obtuve un chiste digno de una carcajada, pero escribir en la terminal se sentía torpe: sin historial de chat, sin prompts guardados. Aquí es donde Open WebUI brilla, ofreciendo una interfaz visual para guardar conversaciones, reutilizar prompts y subir documentos para respuestas más ricas. ¡Vamos a configurarlo!

Configurando tu entorno para Open WebUI

Ahora que has visto la interfaz de terminal de Ollama, preparemos el terreno para Open WebUI para hacer que tu experiencia con LLMs sea más intuitiva. Asumiremos que tienes Docker instalado, ya que es necesario para la configuración de Open WebUI.

1. Verifica Docker: Asegúrate de que Docker está instalado y en ejecución:

docker --version

Espera algo como Docker 27.4.0. Si no tienes Docker, descarga e instala Docker Desktop desde su sitio web oficial, es una configuración rápida para Windows, macOS o Linux.

2. Crea una carpeta de proyecto: Mantén las cosas organizadas:

mkdir ollama-webui

cd ollama-webui

Esta carpeta será tu base para ejecutar Open WebUI.

3. Asegúrate de que Ollama está en ejecución: Inicia Ollama en una terminal separada:

ollama serve

Esto ejecuta la API de Ollama en http://localhost:11434. Mantén esta terminal abierta, ya que Open WebUI la necesita para conectarse a tus modelos.

Instalando Open WebUI con Docker

Con Ollama y Llama 3.1 listos, instalemos Open WebUI usando un solo comando de Docker para una configuración rápida y fiable.

1. Ejecuta Open WebUI: En tu carpeta ollama-webui, ejecuta:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

Este comando:

- Descarga la imagen de Open WebUI (

ghcr.io/open-webui/open-webui:main, ~3.77 GB). - Mapea el puerto 3000 (local) al 8080 (contenedor) para acceso desde el navegador.

- Añade

host.docker.internalpara conectarse a la API de Ollama enlocalhost:11434. - Usa un volumen (

open-webui) para persistir el historial de chat y la configuración. - Nombra el contenedor

open-webuiy lo configura para reiniciar automáticamente.

Tarda un minuto en descargarse. Verifica que se está ejecutando con docker ps, busca el contenedor open-webui.

2. Accede a Open WebUI: Abre tu navegador y ve a http://localhost:3000. Verás la página de bienvenida de Open WebUI. Haz clic en "Sign Up" para crear una cuenta (el primer usuario obtiene privilegios de administrador). Usa una contraseña segura y guárdala bien. ¡Ya estás listo para chatear! Si la página no carga, asegúrate de que el contenedor está en ejecución (docker logs open-webui) y el puerto 3000 está libre.

Usando Open WebUI: Chateando y explorando funciones

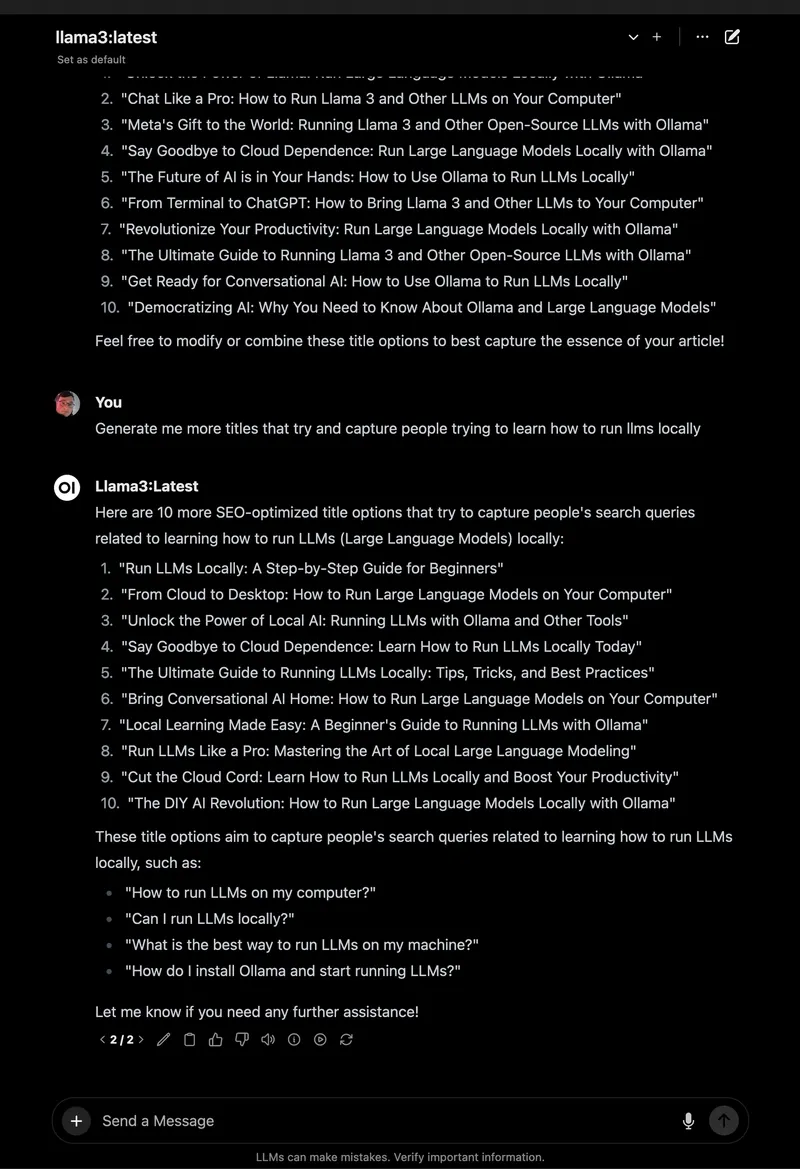

Con Open WebUI en funcionamiento, vamos a sumergirnos en el chat con Llama 3.1 y explorar sus increíbles funciones, que la convierten en una gran mejora respecto a la terminal.

1. Empieza a chatear:

- En Open WebUI, selecciona

llama3.1:8ben el selector de modelo superior izquierdo (debería aparecer ya que lo descargaste). - Haz clic en "New Chat" en la barra lateral.

- Introduce el mismo prompt: "Cuéntame un chiste de padre sobre ordenadores".

- Pulsa Enter. Obtendrás una respuesta como: "¿Por qué el ordenador fue a la escuela de arte? ¡Porque quería aprender a dibujar un byte mejor!"

La interfaz es limpia, con tu prompt y respuesta guardados automáticamente en el historial de chat.

2. Guarda y organiza chats: En la barra lateral izquierda, haz clic en el icono del pin para guardar el chat. Renómbralo (por ejemplo, "Chistes de padre") para acceder fácilmente. Puedes archivar o eliminar chats a través de la barra lateral, manteniendo tus experimentos organizados, ¡mucho mejor que desplazarse por la terminal!

3. Almacena prompts: Guarda el prompt del chiste de padre para reutilizarlo:

- Ve a Settings > Prompts (Configuración > Prompts).

- Haz clic en "New Prompt" (Nuevo Prompt), nómbralo "Chiste de Padre" y pega: "Cuéntame un chiste de padre sobre ordenadores".

- Guarda. Ahora puedes aplicarlo en cualquier chat con un clic.

4. Sube un documento para RAG: Añade contexto a tus chats:

- Haz clic en el icono "#" en la entrada de chat para abrir la biblioteca de documentos.

- Sube un archivo de texto (por ejemplo, una guía de Spring Boot 3.2).

- Pregunta: "¿Cómo uso el REST Client en Spring Boot 3.2?" Llama 3.1 hará referencia al documento, dando un fragmento de código como

RestClient.create().get().uri("/users").retrieve().

Probé esto con un PDF de tutorial de Python, y Open WebUI acertó con las respuestas conscientes del contexto, a diferencia de las respuestas básicas de la terminal.

5. Explora más funciones:

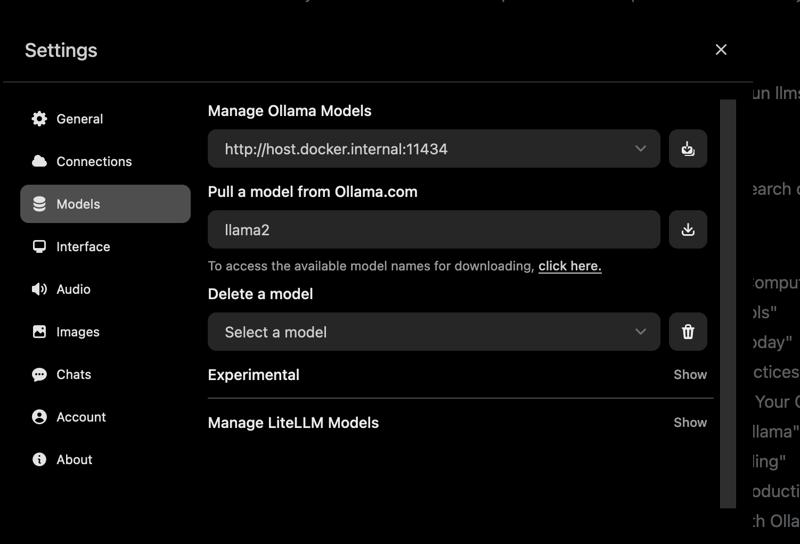

- Cambia de modelo: Usa el selector de modelo para probar Mistral u otros modelos que hayas descargado (

ollama pull mistral). - Personaliza respuestas: Haz clic en "Chat Control" para ajustar el tono (por ejemplo, "divertido") o la longitud.

- Herramientas de administración: En Settings > Admin (Configuración > Admin), gestiona usuarios o restringe el acceso a modelos (ideal para equipos).

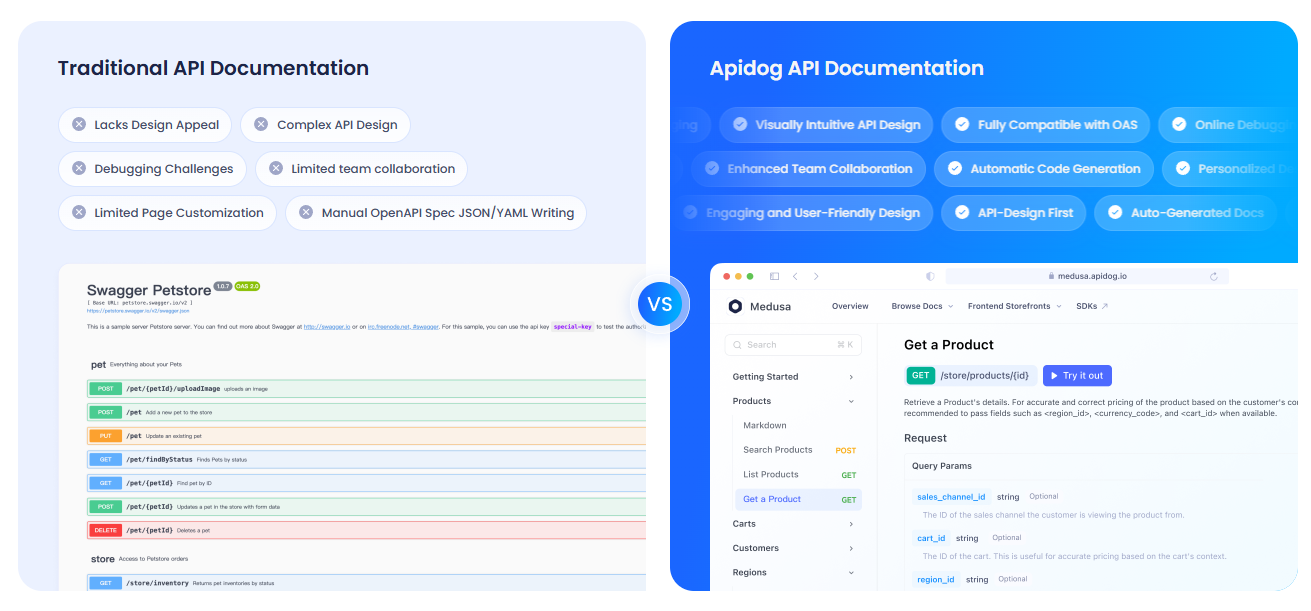

Documentando tus APIs con APIdog

¿Usas Open WebUI para interactuar con la API de Ollama y quieres documentar tu configuración? APIdog es una herramienta fantástica para crear documentación de API interactiva. Su elegante interfaz y opciones de autoalojamiento la hacen ideal para compartir tus proyectos de IA. ¡Échale un vistazo!

Solución de problemas y consejos

- Problemas de conexión: Si Open WebUI no puede encontrar Ollama, asegúrate de que

ollama serveestá en ejecución y el puerto 11434 está abierto. Revisa los logs de Docker:docker logs open-webui. - Conflictos de puertos: Si el puerto 3000 está ocupado, detén el contenedor (

docker stop open-webui), elimínalo (docker rm open-webui) y vuelve a ejecutar el comandodocker runcon un nuevo puerto (por ejemplo,-p 3001:8080). - Respuestas lentas: Usa una GPU con las etiquetas

:cudade Ollama o modelos más pequeños como Mistral para mayor velocidad. - Comunidad: Únete a las discusiones de GitHub o al Discord de Open WebUI para obtener soporte e ideas.

¿Por qué elegir Open WebUI?

Open WebUI transforma Ollama de una herramienta de terminal torpe a una plataforma potente y fácil de usar:

- Interfaz intuitiva: El panel basado en navegador es perfecto para principiantes y profesionales.

- Organización: Los chats y prompts guardados mantienen tu trabajo ordenado, a diferencia de los logs de la terminal.

- Conciencia del contexto: La subida de documentos permite RAG para respuestas más inteligentes.

- Privacidad: Se ejecuta localmente, manteniendo tus datos seguros.

Después de probar tanto la terminal como Open WebUI, estoy convencido de la facilidad y las funciones de la GUI. ¡Es como pasar de un teléfono de tapa a un smartphone!

Conclusión: Tu aventura con Open WebUI te espera

¡Has pasado de los chats en la terminal a una configuración completa de Open WebUI con Ollama, haciendo que las interacciones con LLMs sean fluidas y divertidas! Con Llama 3.1, chats guardados y subida de documentos, estás listo para explorar la IA como nunca antes. Prueba nuevos modelos, guarda más prompts o documenta tus APIs con APIdog. Comparte tus éxitos con Open WebUI en el GitHub de Open WebUI. ¡Estoy emocionado de ver lo que creas! ¡Feliz experimentación con IA!