Ollama avanza las capacidades de IA local con su nueva API de búsqueda web y el servidor MCP. Los desarrolladores ahora acceden a información en tiempo real para mejorar el rendimiento del modelo. Además, esta actualización agiliza las integraciones de herramientas en varios clientes.

Ollama se erige como una plataforma robusta para ejecutar grandes modelos de lenguaje localmente. Los ingenieros la aprovechan para implementar modelos sin depender de servicios en la nube. Sin embargo, la adición de la API de búsqueda web amplía su alcance. Esta API permite a los modelos consultar internet directamente. En consecuencia, las aplicaciones manejan eventos actuales y datos dinámicos de manera más efectiva.

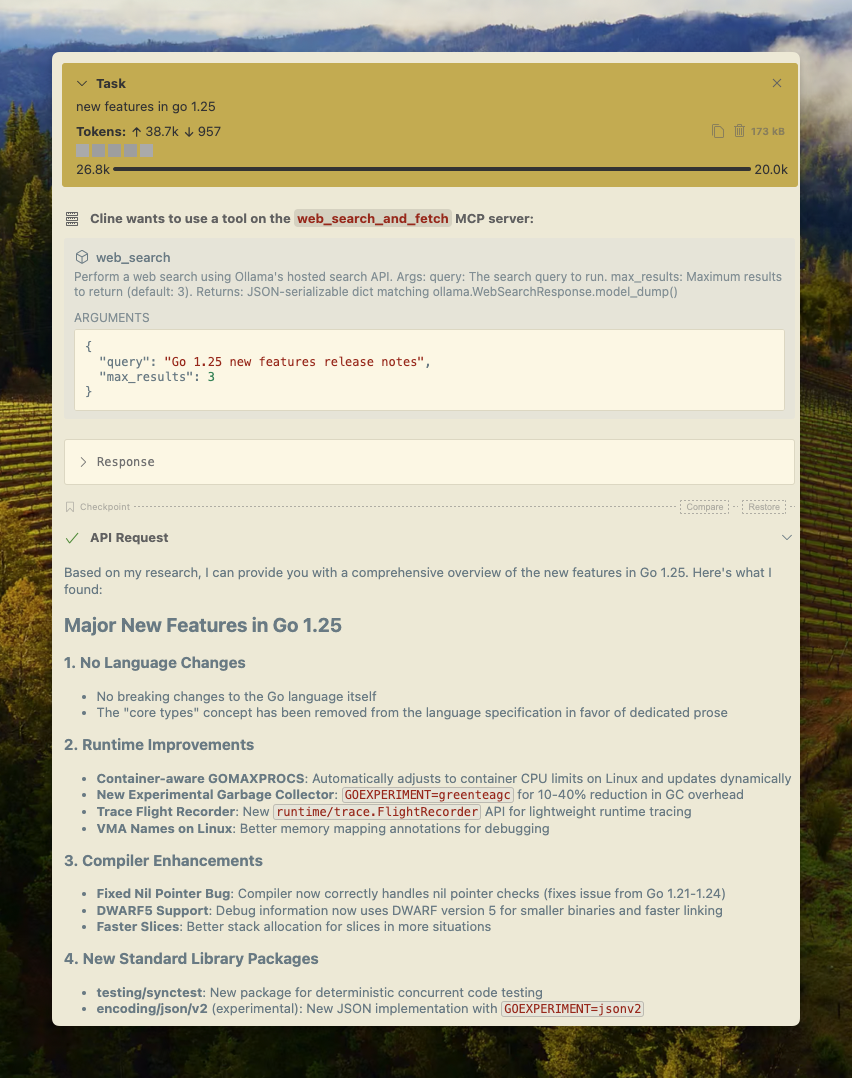

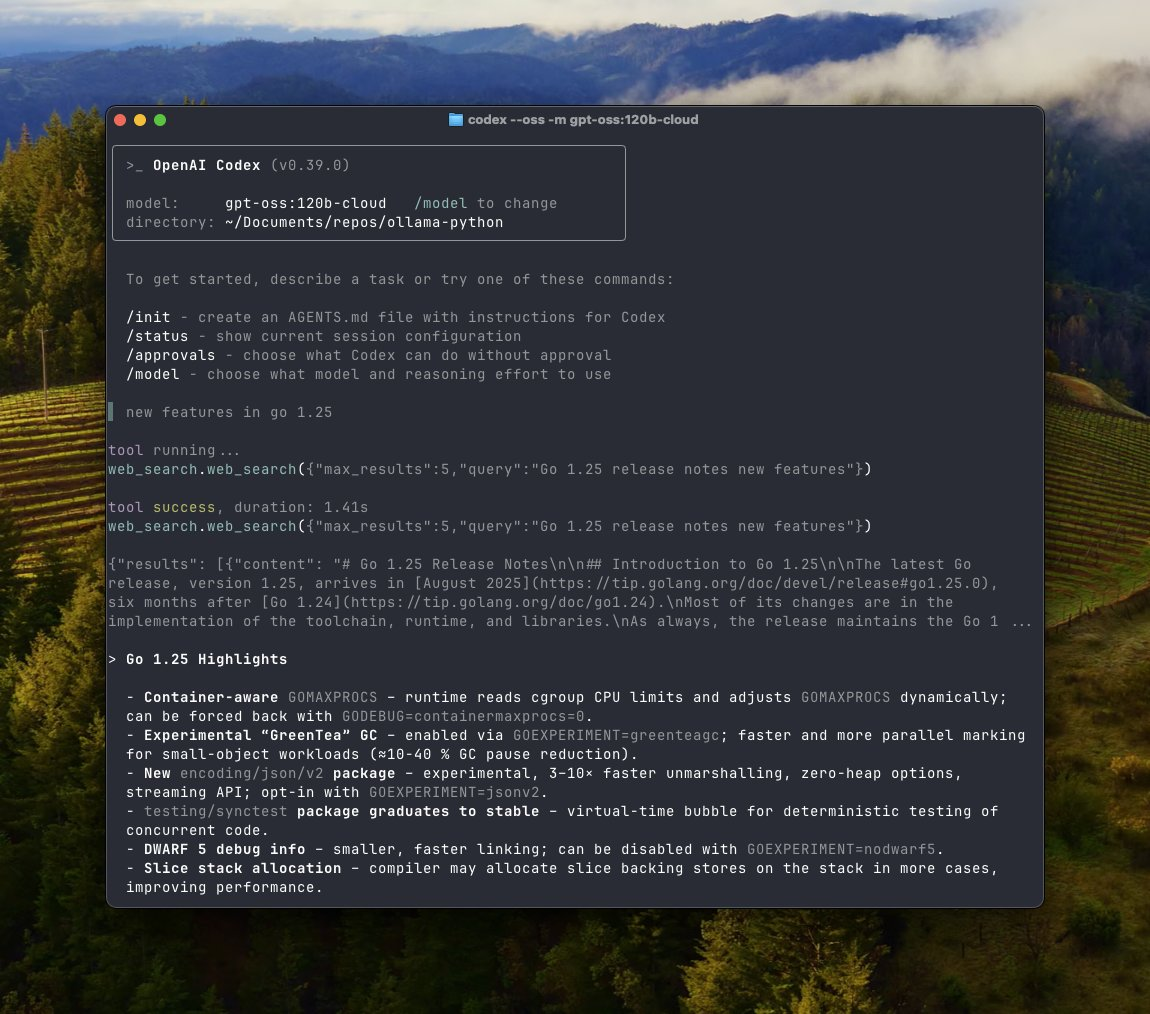

El servidor MCP complementa esto al proporcionar un protocolo estandarizado para el intercambio de contexto. Los desarrolladores conectan modelos a herramientas externas sin esfuerzo. Por ejemplo, el servidor MCP se integra con clientes como Cline, Codex y Goose. Esta configuración permite flujos de trabajo complejos donde los modelos interactúan con los resultados de búsqueda web en tiempo real.

Pasando a los detalles técnicos, la API de búsqueda web de Ollama opera a través de puntos finales REST. Los usuarios envían solicitudes POST a https://ollama.com/api/web_search con un parámetro de consulta. El sistema devuelve resultados relevantes, limitados a un máximo de 10 por defecto. Además, la API de obtención web en https://ollama.com/api/web_fetch recupera contenido de URLs específicas. Ambas requieren una clave API de una cuenta de Ollama.

Ollama garantiza la accesibilidad en todas las plataformas. En macOS, los usuarios instalan a través de Homebrew. Los usuarios de Windows descargan el ejecutable directamente. Linux es compatible con gestores de paquetes sencillos. Independientemente de la plataforma, la API se integra de manera uniforme.

Qué deben saber los desarrolladores sobre Ollama

Ollama impulsa la inferencia local para modelos como Llama y Qwen. Descarga modelos cuantificados de manera eficiente. Los usuarios obtienen modelos con comandos como ollama pull qwen3:4b. Este proceso optimiza para hardware como GPUs NVIDIA o Apple Silicon.

Además, Ollama admite tareas multimodales. Por ejemplo, procesa imágenes y videos junto con texto. La plataforma evoluciona rápidamente, con actualizaciones que mejoran la programación y el manejo del contexto.

Los desarrolladores aprecian la naturaleza de código abierto de Ollama. Personalizan modelos sin depender de un proveedor específico. Sin embargo, surgen limitaciones con el conocimiento estático. Los modelos entrenados con datos pasados tienen dificultades con la información reciente. Aquí, interviene la API de búsqueda web.

La API de Ollama aborda esta brecha. Aumenta las respuestas con datos recientes. Como resultado, las alucinaciones disminuyen significativamente. Los ingenieros construyen aplicaciones confiables para investigación o automatización.

Pasando al servidor MCP, este componente estandariza las interacciones. MCP, o Protocolo de Contexto del Modelo, facilita el intercambio de datos entre modelos y sistemas. Ollama implementa el servidor MCP en Python, lo que permite un uso fluido de las herramientas.

Por ejemplo, el servidor MCP permite operaciones de archivos, cálculos y acceso web. Los desarrolladores lo configuran para LLMs locales, extendiendo las capacidades más allá de la inferencia básica.

Explorando la API de búsqueda web de Ollama en profundidad

La API de búsqueda web de Ollama ofrece resultados estructurados. Los usuarios especifican consultas y un `max_results` opcional. La respuesta incluye fragmentos, URLs y metadatos. Este formato ayuda en el análisis para los agentes.

Para integrar, los desarrolladores usan librerías de Python. Instala con pip install ollama. Luego, llama a ollama.web_search(query="example"). La función maneja la autenticación a través de variables de entorno.

De manera similar, los usuarios de JavaScript aprovechan ollama-js. Importa el módulo e invoca Ollama().webSearch({query: "example"}). Los ejemplos en los repositorios demuestran el manejo de errores y los reintentos.

cURL proporciona una opción de bajo nivel. Crea solicitudes con encabezados para Autorización. Este enfoque es adecuado para scripting o pruebas.

Sin embargo, Apidog mejora este proceso. Como herramienta de gestión de API, Apidog visualiza los puntos finales y los parámetros. Genera fragmentos de código para la API de Ollama, acelerando el desarrollo.

La API soporta contextos largos. Los resultados pueden abarcar miles de tokens. Por lo tanto, los modelos con ventanas extendidas funcionan mejor. Ollama recomienda un mínimo de 32,000 tokens.

Además, el punto final de obtención complementa la búsqueda. Extrae contenido de URLs, evitando la necesidad de un navegador directo. Combina ambos para agentes completos.

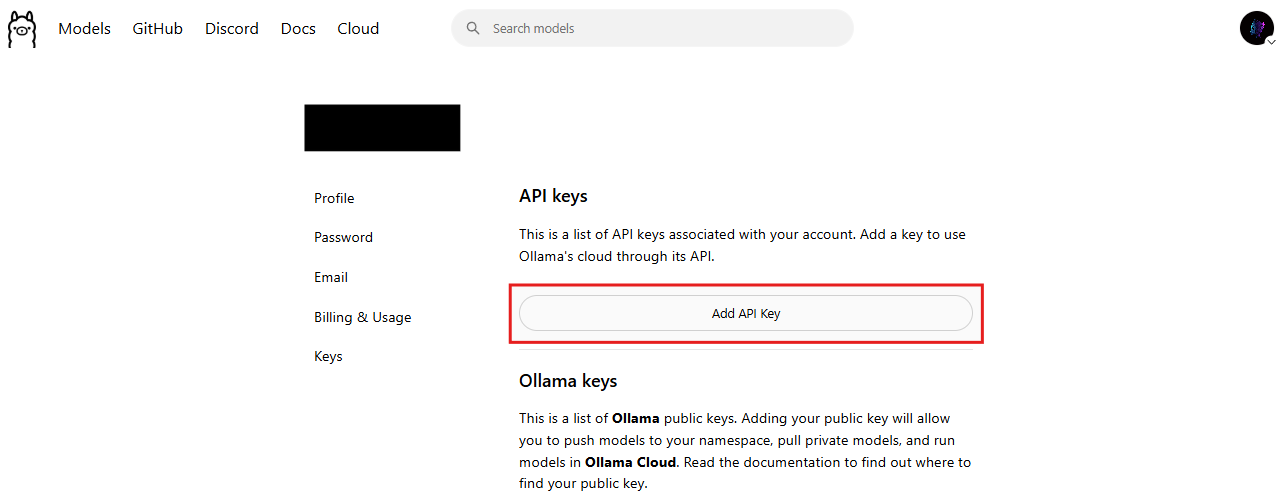

La seguridad sigue siendo primordial. Ollama requiere claves API, lo que evita el acceso no autorizado. Los usuarios generan claves en https://ollama.com/settings/keys.

Pasando al uso práctico, considera un agente de investigación. El agente consulta la búsqueda web, obtiene páginas y sintetiza respuestas. Este flujo de trabajo supera a los modelos estáticos.

Desmitificando el servidor MCP para usuarios de Ollama

El servidor MCP conecta modelos y herramientas. Implementa el Protocolo de Contexto del Modelo, un marco para compartir contexto. En Ollama, un script de Python ejecuta el servidor.

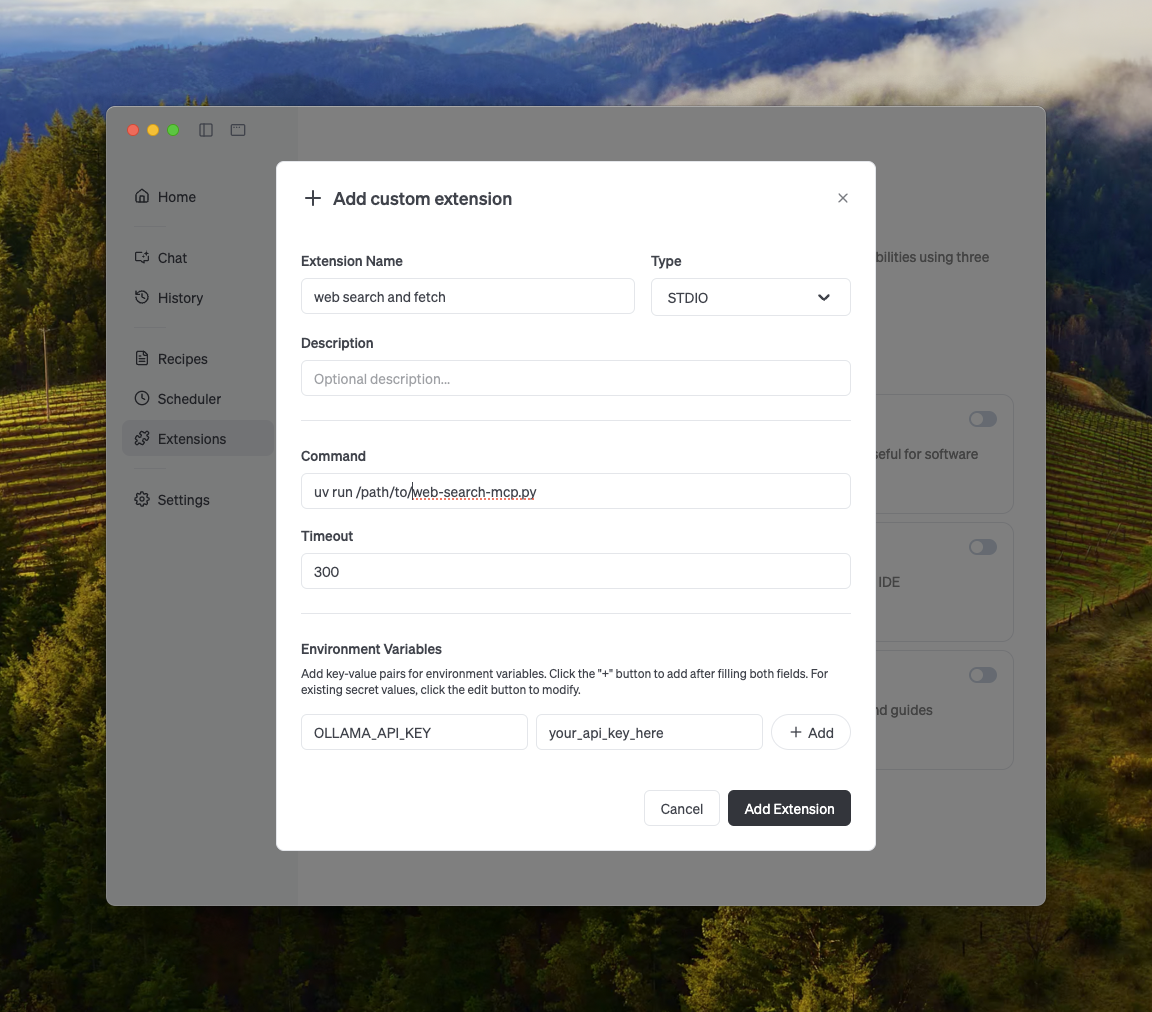

La configuración implica clonar repositorios y establecer entornos. Por ejemplo, uv run web-search-mcp.py lo inicia. Los clientes se conectan a través de interfaces compatibles.

Cline se configura con comandos en la configuración. Agrega OLLAMA_API_KEY a los entornos. Codex edita archivos config.toml. Goose sigue patrones similares.

Esta integración desbloquea la búsqueda web en los clientes. Los modelos llaman a las herramientas dinámicamente, mejorando la interactividad.

Además, el servidor MCP soporta extensiones. Los desarrolladores añaden herramientas personalizadas para correo electrónico, GitHub o imágenes. Esta flexibilidad posiciona a Ollama como infraestructura para agentes.

En Windows con NVIDIA, las instalaciones incluyen controladores CUDA. Linux usa Docker para el aislamiento. macOS se beneficia de la aceleración nativa.

Pasando a configuraciones avanzadas, agrupa múltiples servidores MCP. Esto distribuye las cargas para escalas empresariales.

Cómo integrar la API de Ollama y el servidor MCP

La integración comienza con la creación de una cuenta. Regístrate gratis en el sitio de Ollama. Genera una clave API inmediatamente.

Luego, instala Ollama localmente. Ejecuta ollama serve para iniciar el servidor. Obtén modelos adecuados para herramientas, como gpt-oss.

Para la búsqueda web, establece OLLAMA_API_KEY. Prueba con Python:

import ollama

response = ollama.web_search(query="latest AI news", max_results=5)

print(response)

Esto devuelve JSON con resultados.

Para incorporar el servidor MCP, descarga ejemplos de GitHub. Ejecuta el script y configura los clientes.

Para Cline: Edita la configuración para apuntar al punto final de MCP. Prueba las indicaciones que invocan la búsqueda.

Codex requiere actualizaciones de toml. Especifica el comando y los argumentos.

Goose se integra a través de la configuración de MCP, habilitando herramientas web.

Además, construye agentes personalizados. Usa bucles para manejar interacciones de múltiples turnos. Analiza las llamadas a herramientas y devuelve los resultados.

El manejo de errores resulta crucial. Implementa reintentos para los límites de velocidad. Monitorea el uso para mantenerte dentro de los niveles.

Apidog ayuda aquí. Simula respuestas, prueba la autenticación y documenta flujos de trabajo. Descarga Apidog para prototipar integraciones de Ollama rápidamente.

Construyendo potentes agentes de búsqueda con Ollama

Los agentes representan un caso de uso central. Ollama proporciona ejemplos con Qwen 3.

Obtén el modelo: ollama pull qwen3:4b.

En Python, define herramientas:

tools = [

{"type": "function", "function": {"name": "web_search", "description": "Search the web"}},

{"type": "function", "function": {"name": "web_fetch", "description": "Fetch URL content"}}

]

El bucle de chat procesa mensajes, llama a herramientas y añade resultados.

Este agente responde a consultas como "¿Cuál es el clima actual en Tokio?" buscando y obteniendo información.

Expande a la visión: Analiza imágenes a través de modelos multimodales, luego busca contexto.

Pasando a la optimización, aumenta las longitudes de contexto. Los modelos en la nube manejan hasta su capacidad máxima.

Los agentes reducen costos minimizando llamadas innecesarias. Almacena en caché los resultados localmente.

Además, combina con otras APIs. Integra bases de datos o herramientas de cálculo a través de MCP.

Detalles de precios de Ollama en todas las plataformas

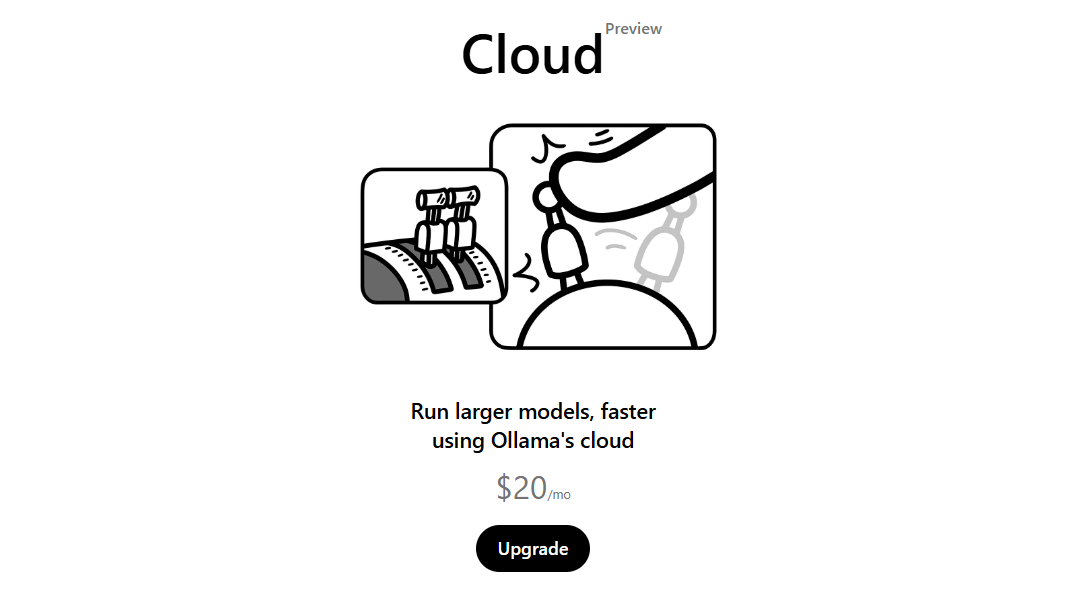

Ollama ofrece precios escalonados. La base es gratuita, con generosos límites de búsqueda. Esto es adecuado para aficionados y pruebas.

Para producción, actualiza las suscripciones. El acceso a la nube comienza en aproximadamente $20 mensuales, según discusiones de la comunidad. Los niveles superiores ofrecen consultas ilimitadas y soporte prioritario.

Las plataformas influyen indirectamente en los costos. Las ejecuciones locales en macOS, Windows, Linux no incurren en tarifas más allá del hardware. Los modelos en la nube facturan por uso.

La API de búsqueda web cobra por llamada en planes avanzados. Sin embargo, los niveles gratuitos cubren la mayoría de las necesidades.

Compara con alternativas: la búsqueda de OpenAI cuesta $10 por cada 1k llamadas. Ollama supera esto para usuarios que priorizan lo local.

Las empresas calculan el ROI. La inferencia local ahorra en transferencia de datos, mientras que la API añade una sobrecarga mínima.

Pasando a la elaboración de presupuestos, monitorea a través de paneles. Ollama proporciona estadísticas de uso.

Casos de uso y ejemplos del mundo real

Los desarrolladores aplican esto en chatbots. Un bot busca noticias, obtiene artículos, resume.

En educación, las herramientas consultan hechos, reduciendo errores.

Los investigadores construyen agentes para revisiones de literatura. Buscan sitios académicos, obtienen PDFs.

El comercio electrónico se integra para recomendaciones de productos. Busca tendencias, obtiene reseñas.

Ejemplo de código para agente:

import ollama

import json

def run_agent(prompt):

messages = [{"role": "user", "content": prompt}]

while True:

response = ollama.chat(model="qwen3:4b", messages=messages, tools=tools)

if "tool_calls" in response["message"]:

for call in response["message"]["tool_calls"]:

if call["function"]["name"] == "web_search":

args = json.loads(call["function"]["arguments"])

result = ollama.web_search(**args)

messages.append({"role": "tool", "content": str(result)})

else:

return response["message"]["content"]

Este bucle maneja las iteraciones.

Además, uso de visión: Describe imágenes, busca coincidencias.

Las empresas automatizan informes. Los agentes compilan datos de fuentes web.

Beneficios de adoptar las nuevas funciones de Ollama

Ollama mejora la privacidad. Los datos permanecen locales, con llamadas a la API opcionales.

La precisión mejora mediante el aumento en tiempo real. Los modelos manejan temas en evolución.

La escalabilidad sigue. El servidor MCP distribuye tareas.

La eficiencia de costos destaca. Los niveles gratuitos minimizan los gastos.

La productividad del desarrollador aumenta. Integraciones como Apidog aceleran los flujos de trabajo.

Pasando a la comunidad, los foros discuten optimizaciones.

El ecosistema crece. Herramientas como OpenWebUI se conectan con Ollama.

Posibles desafíos y soluciones

Los desafíos incluyen límites de velocidad. Solución: Actualizar suscripciones.

Las limitaciones de hardware restringen los modelos. Usa variantes en la nube.

Surge la complejidad de la integración. Sigue la documentación y los ejemplos.

Seguridad: Rota las claves API regularmente.

La depuración de agentes requiere registro. Implementa modos detallados.

Además, prueba en todas las plataformas para asegurar la consistencia.

Concluyendo los avances de Ollama

La API de búsqueda web y el servidor MCP de Ollama marcan un progreso significativo. Los desarrolladores los aprovechan para aplicaciones potentes. Con niveles gratuitos y soporte multiplataforma, la adopción se acelera. Explora más, integra con Apidog y construye la próxima generación de herramientas de IA.