La Inteligencia Artificial (IA) está avanzando rápidamente más allá de la simple generación de texto o el reconocimiento de imágenes. La próxima frontera trata sobre IA que puede tomar medidas, resolver problemas e interactuar con el mundo de maneras significativas. Mistral AI, un nombre destacado en el campo, ha dado un paso importante en esta dirección con su API de Agentes de Mistral. Este potente conjunto de herramientas permite a los desarrolladores crear agentes de IA sofisticados que pueden hacer mucho más que los modelos de lenguaje tradicionales.

En esencia, la API de Agentes está diseñada para superar las limitaciones de los modelos de IA estándar, que a menudo son excelentes para comprender y generar lenguaje, pero tienen dificultades para realizar acciones, recordar interacciones pasadas de manera consistente o utilizar herramientas externas de manera efectiva. La API de Agentes de Mistral aborda estos desafíos equipando sus potentes modelos de lenguaje con características como conectores integrados a diversas herramientas, memoria persistente a lo largo de las conversaciones y la capacidad de coordinar tareas complejas.

Piense en ello como pasar de un bibliotecario muy bien informado que solo puede hablar de libros a un equipo de investigadores expertos que no solo pueden acceder a la información, sino también realizar experimentos, redactar informes y colaborar entre sí. Esta nueva API sirve como base para crear aplicaciones de IA de nivel empresarial que pueden automatizar flujos de trabajo, ayudar en la toma de decisiones complejas y proporcionar experiencias verdaderamente interactivas.

¿Quiere una plataforma integrada y Todo en Uno para que su Equipo de Desarrolladores trabaje junto con máxima productividad?

Apidog satisface todas sus demandas y reemplaza a Postman a un precio mucho más asequible!

¿Qué Hace que los Agentes de Mistral Sean Tan Capaces?

Los modelos de lenguaje tradicionales, aunque competentes en la generación de texto, a menudo se quedan cortos a la hora de ejecutar acciones o recordar información a lo largo de interacciones extendidas. La API de Agentes de Mistral aborda directamente estas limitaciones al sinergizar los modelos de lenguaje de vanguardia de Mistral con un conjunto de potentes características diseñadas para flujos de trabajo agénticos.

Capacidades Principales:

En esencia, la API de Agentes proporciona:

- Conectores Integrados: Son herramientas pre-desplegadas que los agentes pueden invocar bajo demanda. Incluyen:

- Ejecución de Código: Permite a los agentes ejecutar código Python en un entorno seguro (sandbox), útil para cálculos, análisis de datos y computación científica.

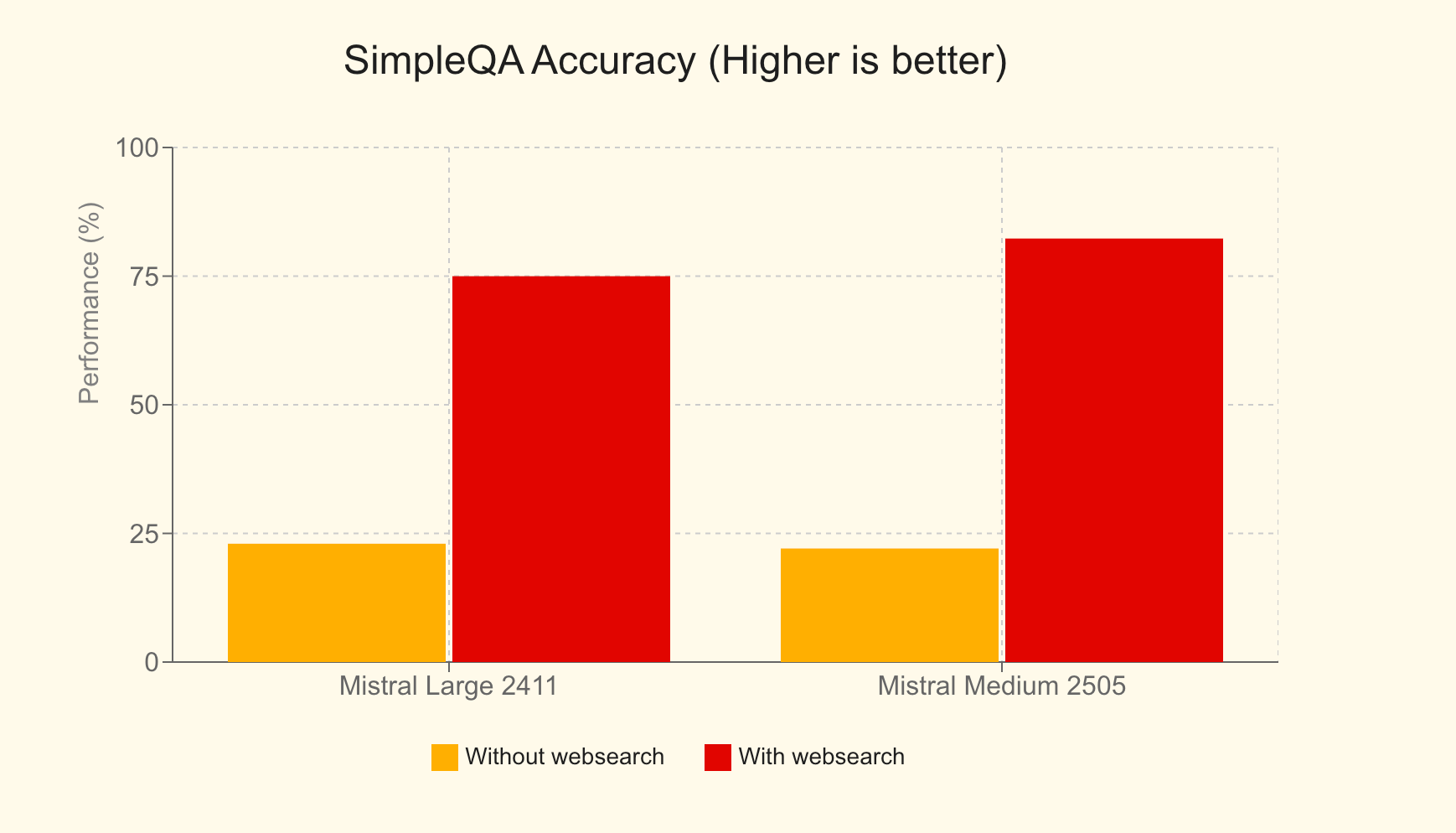

- Búsqueda Web: Otorga a los agentes acceso a información actualizada de internet, mejorando significativamente la precisión y relevancia de las respuestas. Por ejemplo, en el benchmark SimpleQA, Mistral Large con búsqueda web logró una puntuación del 75%, una mejora masiva sobre el 23% sin ella.

- Generación de Imágenes: Aprovechando modelos como Black Forest Lab FLUX1.1 [pro] Ultra, los agentes pueden crear diversas imágenes para aplicaciones que van desde ayudas educativas hasta gráficos de marketing.

- Biblioteca de Documentos: Permite a los agentes acceder y utilizar documentos de Mistral Cloud, impulsando la Generación Aumentada por Recuperación (RAG) integrada para mejorar su base de conocimiento.

- Herramientas MCP: Facilita la integración fluida con sistemas externos a través del Protocolo de Contexto del Modelo (Model Context Protocol), que exploraremos en profundidad en la Parte 3.

- Memoria Persistente: Los agentes pueden mantener el contexto a lo largo de las conversaciones, lo que lleva a interacciones a largo plazo más coherentes y significativas.

- Orquestación Agéntica: La API permite la coordinación de múltiples agentes, cada uno potencialmente especializado en diferentes tareas, para resolver problemas complejos de forma colaborativa.

Esta API no es meramente una extensión de su API de Finalización de Chat; es un marco dedicado específicamente diseñado para simplificar la implementación de casos de uso agénticos. Está diseñada para ser la columna vertebral de las plataformas agénticas de nivel empresarial, permitiendo a las empresas desplegar IA de maneras más prácticas, impactantes y orientadas a la acción.

Agentes de Mistral en Acción: Aplicaciones del Mundo Real

La versatilidad de la API de Agentes se demuestra a través de diversas aplicaciones innovadoras:

- Asistente de Codificación con GitHub: Un flujo de trabajo agéntico donde un agente supervisa a un agente desarrollador (impulsado por DevStral) que interactúa con GitHub, automatizando tareas de desarrollo de software con autoridad completa sobre el repositorio.

- Asistente de Tickets de Linear: Un asistente inteligente que utiliza una arquitectura MCP multi-servidor para transformar transcripciones de llamadas en Documentos de Requisitos de Producto (PRD), luego en problemas de Linear accionables, y posteriormente rastrear los entregables del proyecto.

- Analista Financiero: Un agente asesor que orquesta múltiples servidores MCP para obtener métricas financieras, compilar información y archivar resultados de forma segura, demostrando agregación y análisis de datos complejos.

- Asistente de Viajes: Una herramienta de IA completa para ayudar a los usuarios a planificar viajes, reservar alojamiento y gestionar diversas necesidades relacionadas con los viajes.

- Asistente de Nutrición: Un compañero de dieta impulsado por IA que ayuda a los usuarios a establecer objetivos, registrar comidas, recibir sugerencias de alimentos personalizadas, rastrear el progreso diario y encontrar restaurantes que se ajusten a sus objetivos nutricionales.

Memoria, Contexto y Conversaciones con Estado

Una piedra angular de la API de Agentes es su robusto sistema de gestión de conversaciones. Asegura que las interacciones tengan estado (stateful), lo que significa que el contexto se retiene a lo largo del tiempo. Los desarrolladores pueden iniciar conversaciones de dos maneras principales:

- Con un Agente: Al especificar un

agent_id, aprovecha las capacidades, herramientas e instrucciones preconfiguradas de un agente específico. - Acceso Directo: Puede iniciar una conversación especificando directamente el modelo y los parámetros de finalización, proporcionando acceso rápido a los conectores integrados sin un agente predefinido.

Cada conversación mantiene un historial estructurado a través de "entradas de conversación", asegurando que el contexto se preserve meticulosamente. Este estado permite a los desarrolladores ver conversaciones pasadas, continuar cualquier interacción sin problemas, o incluso ramificarse para iniciar nuevas rutas conversacionales desde cualquier punto del historial. Además, la API admite la transmisión de salidas (streaming), lo que permite actualizaciones en tiempo real e interacciones dinámicas.

Orquestación de Agentes: El Poder de la Colaboración

El verdadero poder diferenciador de la API de Agentes surge en su capacidad para orquestar múltiples agentes. No se trata de una única IA monolítica; se trata de una sinfonía de agentes especializados trabajando en concierto. Mediante la orquestación dinámica, los agentes pueden ser añadidos o eliminados de una conversación según sea necesario, cada uno aportando sus habilidades únicas para abordar diferentes facetas de un problema complejo.

Para construir un flujo de trabajo agéntico con traspasos (handoffs):

- Crear Agentes: Defina y cree todos los agentes necesarios, cada uno equipado con herramientas, modelos e instrucciones específicas adaptadas a su rol.

- Definir Traspasos (Handoffs): Especifique qué agentes pueden delegar tareas a otros. Por ejemplo, un agente principal de servicio al cliente podría traspasar una consulta técnica a un agente especializado en resolución de problemas o una consulta de facturación a un agente financiero.

Estos traspasos permiten una cadena de acciones fluida. Una única solicitud del usuario puede desencadenar una cascada de tareas a través de múltiples agentes, cada uno manejando autónomamente su parte designada. Este enfoque colaborativo desbloquea una eficiencia y efectividad sin precedentes en la resolución de problemas para aplicaciones sofisticadas del mundo real.

Uso Básico de la API de Agentes de Mistral

Habiendo comprendido las capacidades de la API de Agentes de Mistral, exploremos cómo interactuar con ella. La API introduce tres nuevos objetos principales:

- Agentes: Son configuraciones que aumentan las capacidades de un modelo. Una definición de agente incluye valores preseleccionados como el modelo a usar, las herramientas a las que puede acceder, las instrucciones del sistema (prompts) y los parámetros de finalización predeterminados.

- Conversación: Este objeto representa el historial de interacciones y eventos pasados con un asistente. Incluye mensajes del usuario, respuestas del asistente y registros de ejecuciones de herramientas.

- Entrada (Entry): Una entrada es una acción o evento individual dentro de una conversación, creado por el usuario o por un asistente. Ofrece una forma flexible y expresiva de representar interacciones, permitiendo un control más detallado sobre la descripción de eventos.

Cabe destacar que puede aprovechar muchas características, como conversaciones con estado y conectores integrados, sin necesidad de crear y referenciar explícitamente un objeto "Agente" formal primero. Esto proporciona flexibilidad para casos de uso más simples.

Creando un Agente

Para definir un agente especializado, realiza una solicitud a la API especificando varios parámetros:

model: El modelo subyacente de Mistral (por ejemplo,mistral-medium-latest).name: Un nombre descriptivo para su agente.description: Una breve explicación del propósito del agente o la tarea que está diseñado para realizar.instructions(opcional): El prompt del sistema que guía el comportamiento y las respuestas del agente.tools(opcional): Una lista de herramientas que el agente puede usar. Los tipos de herramientas incluyen:function: Herramientas definidas por el usuario, similares a la llamada a funciones estándar en las finalizaciones de chat.web_search/web_search_premium: Herramientas de búsqueda web integradas.code_interpreter: La herramienta integrada para la ejecución de código.image_generation: La herramienta integrada para generar imágenes.completion_args(opcional): Argumentos estándar del sampler de finalización de chat como temperature, top_p, etc.

Aquí tienes un ejemplo de solicitud cURL para crear un agente simple:

curl --location "https://api.mistral.ai/v1/agents" \

--header 'Content-Type: application/json' \

--header 'Accept: application/json' \

--header "Authorization: Bearer $MISTRAL_API_KEY" \

--data '{

"model": "mistral-medium-latest",

"name": "Simple Agent",

"description": "A simple Agent with persistent state."

}'

Actualizando un Agente

Los agentes pueden actualizarse después de su creación. Los argumentos son los mismos que para la creación. Esta operación resulta en un nuevo objeto agente con la configuración actualizada, permitiendo efectivamente el versionado de sus agentes.

curl --location "https://api.mistral.ai/v1/agents/<agent_id>" \

--header 'Content-Type: application/json' \

--header 'Accept: application/json' \

--header "Authorization: Bearer $MISTRAL_API_KEY" \

--data '{

"completion_args": {

"temperature": 0.3,

"top_p": 0.95

},

"description": "An edited simple agent."

}'

Gestionando Conversaciones

Una vez que se crea un agente (o si usa acceso directo), puede iniciar conversaciones.

Iniciando una Conversación:

Debe proporcionar:

agent_id: El ID del agente (si usa un agente predefinido).inputs: El mensaje inicial, que puede ser una cadena simple o una lista de objetos de mensaje.

Esta solicitud devuelve unconversation_id.

Ejemplo (entrada de cadena simple):

curl --location "https://api.mistral.ai/v1/conversations" \

--header 'Content-Type: application/json' \

--header 'Accept: application/json' \

--header "Authorization: Bearer $MISTRAL_API_KEY" \

--data '{

"inputs": "Who is Albert Einstein?",

"stream": false,

"agent_id": "<agent_id>"

}'

Continuando una Conversación:

Para añadir a una conversación existente:

conversation_id: El ID de la conversación a continuar.inputs: El siguiente mensaje o respuesta (cadena o lista de mensajes).

Cada continuación proporciona un nuevoconversation_idsi el estado se almacena. Puede optar por no usar el almacenamiento en la nube configurandostore=False. El parámetrohandoff_executioncontrola cómo se gestionan los traspasos de agentes:server(predeterminado, gestionado por la nube de Mistral) oclient(la respuesta se devuelve al usuario para gestionar el traspaso).

Ejemplo:

curl --location "https://api.mistral.ai/v1/conversations/<conv_id>" \

--header 'Content-Type: application/json' \

--header 'Accept: application/json' \

--header "Authorization: Bearer $MISTRAL_API_KEY" \

--data '{

"inputs": "Translate to French.",

"stream": false,

"store": true,

"handoff_execution": "server"

}'

Transmisión de Salida (Streaming)

Para interacciones en tiempo real, tanto el inicio como la continuación de las conversaciones pueden transmitirse configurando stream: true y asegurándose de que el encabezado Accept sea text/event-stream.

curl --location "https://api.mistral.ai/v1/conversations" \

--header 'Content-Type: application/json' \

--header 'Accept: text/event-stream' \

--header "Authorization: Bearer $MISTRAL_API_KEY" \

--data '{

"inputs": "Who is Albert Einstein?",

"stream": true,

"agent_id": "ag_06811008e6e07cb48000fd3f133e1771"

}'

Al transmitir, recibirá varios tipos de eventos que indican el progreso y el contenido de la respuesta, como:

conversation.response.started: Marca el inicio de la respuesta de la conversación.message.output.delta: Un fragmento de contenido (tokens) para la respuesta del modelo.tool.execution.started/tool.execution.done: Indican el ciclo de vida de la ejecución de una herramienta.agent.handoff.started/agent.handoff.done: Señalan el inicio y el fin de un traspaso de agente.

Estas operaciones básicas forman la base para construir aplicaciones dinámicas e interactivas con agentes de Mistral.

Integrando la API de Agentes de Mistral con el Protocolo de Contexto del Modelo (MCP)

Si bien los conectores integrados ofrecen una potencia significativa, la verdadera extensibilidad de los Agentes de Mistral brilla cuando se combina con el Protocolo de Contexto del Modelo (MCP).

¿Qué es MCP?

El Protocolo de Contexto del Modelo (MCP) es un estándar abierto diseñado para agilizar la integración de modelos de IA con diversas fuentes de datos externas, herramientas y APIs. Proporciona una interfaz estandarizada y segura que permite a los sistemas de IA acceder y utilizar información contextual del mundo real de manera eficiente. En lugar de construir y mantener numerosas integraciones a medida, MCP ofrece una forma unificada para que los modelos de IA se conecten a datos y sistemas en vivo, lo que lleva a respuestas más relevantes, precisas y potentes. Para obtener información detallada, consulte la documentación oficial del Protocolo de Contexto del Modelo.

El SDK de Python de Mistral proporciona mecanismos de integración fluidos para conectar agentes con Clientes MCP. Esto permite que sus agentes interactúen con cualquier servicio o fuente de datos que exponga una interfaz MCP, ya sea una herramienta local, una API de terceros o un sistema empresarial propietario.

Exploraremos tres escenarios comunes para usar MCP con Agentes de Mistral: un servidor MCP local, un servidor MCP remoto sin autenticación y un servidor MCP remoto con autenticación. Todos los ejemplos utilizarán código Python asíncrono.

Escenario 1: Uso de un Servidor MCP Local

Imagine que tiene un script o servicio local (por ejemplo, un proveedor de información meteorológica personalizado) con el que desea que interactúe su agente de Mistral.

Paso 1: Inicializar el Cliente Mistral y la Configuración

Importe los módulos necesarios de mistralai y mcp. Esto incluye Mistral, RunContext, StdioServerParameters (para servidores MCP basados en procesos locales) y MCPClientSTDIO.

import asyncio

import os

from pathlib import Path

from mistralai import Mistral

from mistralai.extra.run.context import RunContext

from mcp import StdioServerParameters

from mistralai.extra.mcp.stdio import MCPClientSTDIO

from mistralai.types import BaseModel

cwd = Path(__file__).parent

MODEL = "mistral-medium-latest" # O su modelo preferido

async def main_local_mcp():

api_key = os.environ["MISTRAL_API_KEY"]

client = Mistral(api_key=api_key)

# Definir parámetros para el servidor MCP local (por ejemplo, ejecutando un script Python)

server_params = StdioServerParameters(

command="python",

args=[str((cwd / "mcp_servers/stdio_server.py").resolve())], # Ruta a su script de servidor MCP

env=None,

)

# Crear un agente

weather_agent = client.beta.agents.create(

model=MODEL,

name="Local Weather Teller",

instructions="Puede informar el tiempo utilizando una herramienta MCP local.",

description="Obtiene el tiempo de una fuente local.",

)

# Definir formato de salida esperado (opcional, pero bueno para datos estructurados)

class WeatherResult(BaseModel):

user: str

location: str

temperature: float

# Crear un Contexto de Ejecución (Run Context)

async with RunContext(

agent_id=weather_agent.id,

output_format=WeatherResult, # Opcional: Para salida estructurada

continue_on_fn_error=True,

) as run_ctx:

# Crear y registrar cliente MCP

mcp_client = MCPClientSTDIO(stdio_params=server_params)

await run_ctx.register_mcp_client(mcp_client=mcp_client)

# Ejemplo de registro de una función Python local como herramienta

import random

@run_ctx.register_func

def get_location(name: str) -> str:

"""Función para obtener una ubicación aleatoria para un usuario."""

return random.choice(["New York", "London", "Paris"])

# Ejecutar el agente

run_result = await client.beta.conversations.run_async(

run_ctx=run_ctx,

inputs="Dime el tiempo en la ubicación de John actualmente.",

)

print("MCP Local - Todas las entradas de ejecución:")

for entry in run_result.output_entries:

print(f"{entry}\n")

if run_result.output_as_model:

print(f"MCP Local - Salida final del modelo: {run_result.output_as_model}")

else:

print(f"MCP Local - Salida final de texto: {run_result.output_as_text}")

# if __name__ == "__main__":

# asyncio.run(main_local_mcp())

En esta configuración, stdio_server.py sería su script que implementa la lógica del servidor MCP, comunicándose a través de stdin/stdout. El RunContext gestiona la interacción, y register_mcp_client hace que el servidor MCP local esté disponible como herramienta para el agente. También puede registrar funciones Python locales directamente usando @run_ctx.register_func.

Transmisión (Streaming) con un Servidor MCP Local:

Para transmitir, use client.beta.conversations.run_stream_async y procese los eventos a medida que llegan:

# Dentro de RunContext, después del registro del cliente MCP

# events = await client.beta.conversations.run_stream_async(

# run_ctx=run_ctx,

# inputs="Dime el tiempo en la ubicación de John actualmente, estilo streaming.",

# )

# streamed_run_result = None

# async for event in events:

# if isinstance(event, RunResult): # Asumiendo que RunResult está definido o importado

# streamed_run_result = event

# else:

# print(f"Evento de streaming: {event}")

# if streamed_run_result:

# # Procesar streamed_run_result

# pass

Escenario 2: Uso de un Servidor MCP Remoto Sin Autenticación

Muchos servicios públicos o internos podrían exponer una interfaz MCP sobre HTTP/SSE sin requerir autenticación.

from mistralai.extra.mcp.sse import MCPClientSSE, SSEServerParams

async def main_remote_no_auth_mcp():

api_key = os.environ["MISTRAL_API_KEY"]

client = Mistral(api_key=api_key)

# Definir la URL para el servidor MCP remoto (por ejemplo, el MCP público de Semgrep)

server_url = "https://mcp.semgrep.ai/sse"

mcp_client = MCPClientSSE(sse_params=SSEServerParams(url=server_url, timeout=100))

async with RunContext(

model=MODEL, # También se puede usar agent_id si un agente está pre-creado

) as run_ctx:

await run_ctx.register_mcp_client(mcp_client=mcp_client)

run_result = await client.beta.conversations.run_async(

run_ctx=run_ctx,

inputs="¿Puedes escribir un archivo hello_world.py y luego verificarlo en busca de vulnerabilidades de seguridad usando las herramientas disponibles?",

)

print("MCP Remoto Sin Autenticación - Todas las entradas de ejecución:")

for entry in run_result.output_entries:

print(f"{entry}\n")

print(f"MCP Remoto Sin Autenticación - Respuesta Final: {run_result.output_as_text}")

# if __name__ == "__main__":

# asyncio.run(main_remote_no_auth_mcp())

Aquí, se utiliza MCPClientSSE con SSEServerParams apuntando a la URL remota. El agente puede entonces aprovechar las herramientas proporcionadas por este servidor MCP remoto. La transmisión sigue el mismo patrón que el ejemplo de MCP local, utilizando run_stream_async.

Escenario 3: Uso de un Servidor MCP Remoto Con Autenticación (OAuth)

Para servicios que requieren autenticación OAuth2 (como Linear, Jira, etc.), el proceso implica algunos pasos adicionales para manejar el flujo de autorización.

from http.server import BaseHTTPRequestHandler, HTTPServer

import threading

import webbrowser

from mistralai.extra.mcp.auth import build_oauth_params

CALLBACK_PORT = 16010 # Asegúrese de que este puerto esté libre

# Configuración del servidor de callback (simplificado de la fuente)

def run_callback_server_util(callback_func, auth_response_dict):

class OAuthCallbackHandler(BaseHTTPRequestHandler):

def do_GET(self):

if "/callback" in self.path or "/oauth/callback" in self.path: # Verificación más robusta

auth_response_dict["url"] = self.path

self.send_response(200)

self.send_header("Content-type", "text/html")

self.end_headers()

self.wfile.write(b"<html><body>Autenticación exitosa. Puede cerrar esta ventana.</body></html>")

callback_func() # Señalar finalización

threading.Thread(target=self.server.shutdown).start()

else:

self.send_response(404)

self.end_headers()

server_address = ("localhost", CALLBACK_PORT)

httpd = HTTPServer(server_address, OAuthCallbackHandler)

threading.Thread(target=httpd.serve_forever, daemon=True).start() # Usar hilo demonio

redirect_url = f"http://localhost:{CALLBACK_PORT}/oauth/callback"

return httpd, redirect_url

async def main_remote_auth_mcp():

api_key = os.environ["MISTRAL_API_KEY"]

client = Mistral(api_key=api_key)

server_url = "https://mcp.linear.app/sse" # Ejemplo: MCP de Linear

mcp_client_auth = MCPClientSSE(sse_params=SSEServerParams(url=server_url))

callback_event = asyncio.Event()

event_loop = asyncio.get_event_loop()

auth_response_holder = {"url": ""}

if await mcp_client_auth.requires_auth():

httpd, redirect_url = run_callback_server_util(

lambda: event_loop.call_soon_threadsafe(callback_event.set),

auth_response_holder

)

try:

oauth_params = await build_oauth_params(mcp_client_auth.base_url, redirect_url=redirect_url)

mcp_client_auth.set_oauth_params(oauth_params=oauth_params)

login_url, state = await mcp_client_auth.get_auth_url_and_state(redirect_url)

print(f"Por favor, vaya a esta URL y autorice: {login_url}")

webbrowser.open(login_url, new=2)

await callback_event.wait() # Esperar el callback de OAuth

token = await mcp_client_auth.get_token_from_auth_response(

auth_response_holder["url"], redirect_url=redirect_url, state=state

)

mcp_client_auth.set_auth_token(token)

print("Autenticación exitosa.")

except Exception as e:

print(f"Error durante la autenticación: {e}")

return # Salir si la autenticación falla

finally:

if 'httpd' in locals() and httpd:

httpd.shutdown()

httpd.server_close()

async with RunContext(model=MODEL) as run_ctx: # O agent_id

await run_ctx.register_mcp_client(mcp_client=mcp_client_auth)

run_result = await client.beta.conversations.run_async(

run_ctx=run_ctx,

inputs="Dime qué proyectos tengo en mi espacio de trabajo de Linear?",

)

print(f"MCP Remoto con Autenticación - Respuesta Final: {run_result.output_as_text}")

# if __name__ == "__main__":

# asyncio.run(main_remote_auth_mcp())

Esto implica configurar un servidor HTTP local para interceptar la redirección de OAuth, guiar al usuario a través de la página de autorización del proveedor, intercambiar el código recibido por un token de acceso y luego configurar el MCPClientSSE con este token. Una vez autenticado, el agente puede interactuar con el servicio MCP protegido. La transmisión sigue nuevamente el patrón establecido.

Conclusión: El Futuro es Agéntico e Interconectado

La API de Agentes de Mistral, especialmente cuando se aumenta con el Protocolo de Contexto del Modelo, ofrece una plataforma robusta y flexible para construir aplicaciones de IA de próxima generación. Al permitir que los agentes no solo razonen y se comuniquen, sino que también interactúen con un vasto ecosistema de herramientas, fuentes de datos y servicios, los desarrolladores pueden crear sistemas verdaderamente inteligentes capaces de abordar problemas complejos del mundo real. Ya sea que esté automatizando flujos de trabajo intrincados, proporcionando asistencia profundamente contextualizada o siendo pionero en nuevas formas de colaboración humano-IA, la combinación de Agentes de Mistral y MCP proporciona el conjunto de herramientas fundamental para este futuro emocionante. A medida que el estándar MCP gane una adopción más amplia, el potencial para crear agentes de IA interconectados y altamente capaces solo continuará creciendo.

¿Quiere una plataforma integrada y Todo en Uno para que su Equipo de Desarrolladores trabaje junto con máxima productividad?

Apidog satisface todas sus demandas y reemplaza a Postman a un precio mucho más asequible!