A medida que los modelos de IA superan los límites del razonamiento y las capacidades agenciales, Kimi K2 Thinking surge como una innovación destacada de Moonshot AI, fusionando la accesibilidad de código abierto con un rendimiento de nivel empresarial. Este modelo de agente pensante de un billón de parámetros redefine la forma en que los desarrolladores interactúan con los grandes modelos de lenguaje, particularmente a través de su robusta API. Diseñada para tareas que requieren inferencia profunda y encadenamiento de herramientas, la API de Kimi K2 Thinking permite una integración perfecta en aplicaciones, desde agentes de investigación automatizados hasta asistentes de codificación complejos. En esta guía, exploraremos los fundamentos, la arquitectura, los puntos de referencia, los precios, las aplicaciones prácticas y el uso práctico de Kimi K2 Thinking, equipándote para aprovechar la API de Kimi K2 Thinking de manera efectiva. ¡Empecemos!

¿Quieres una plataforma integrada y todo en uno para que tu equipo de desarrolladores trabaje en conjunto con la máxima productividad?

¡Apidog satisface todas tus demandas y reemplaza a Postman a un precio mucho más asequible!

Introducción a Kimi K2 Thinking

Kimi K2 Thinking representa el audaz paso adelante de Moonshot AI en la IA de código abierto, lanzándose como un modelo de agente pensante especializado optimizado para el razonamiento secuencial y el uso de herramientas. En su esencia, Kimi K2 Thinking está construido para simular una deliberación similar a la humana, procesando consultas a través de tokens de "pensamiento" extendidos que permiten interacciones de herramientas de múltiples turnos sin la constante intervención humana. Este modelo, disponible a través de API para desarrolladores, sobresale en entornos que exigen una retención prolongada del contexto y una toma de decisiones adaptativa, como la búsqueda agencial o la generación de código.

Lo que distingue a Kimi K2 Thinking es su enfoque en la escalabilidad en tiempo de prueba, expandiendo no solo el tamaño del modelo sino la profundidad de la inferencia durante la ejecución. Con un masivo billón de parámetros, maneja intrincadas cadenas de pensamiento, lo que hace que la API de Kimi K2 Thinking sea ideal para aplicaciones donde la precisión supera la velocidad. Los desarrolladores pueden acceder a ella a través de la plataforma de Moonshot, donde el modo de chat está activo en kimi.com, y las capacidades agenciales completas se implementarán pronto. Para aquellos cansados de los modelos de caja negra, los pesos y el código abiertos de Kimi K2 Thinking invitan a la personalización, fomentando un ecosistema impulsado por la comunidad. A medida que profundicemos, verás cómo esta API convierte el razonamiento abstracto en herramientas tangibles para tus proyectos.

La Arquitectura de Kimi K2 Thinking

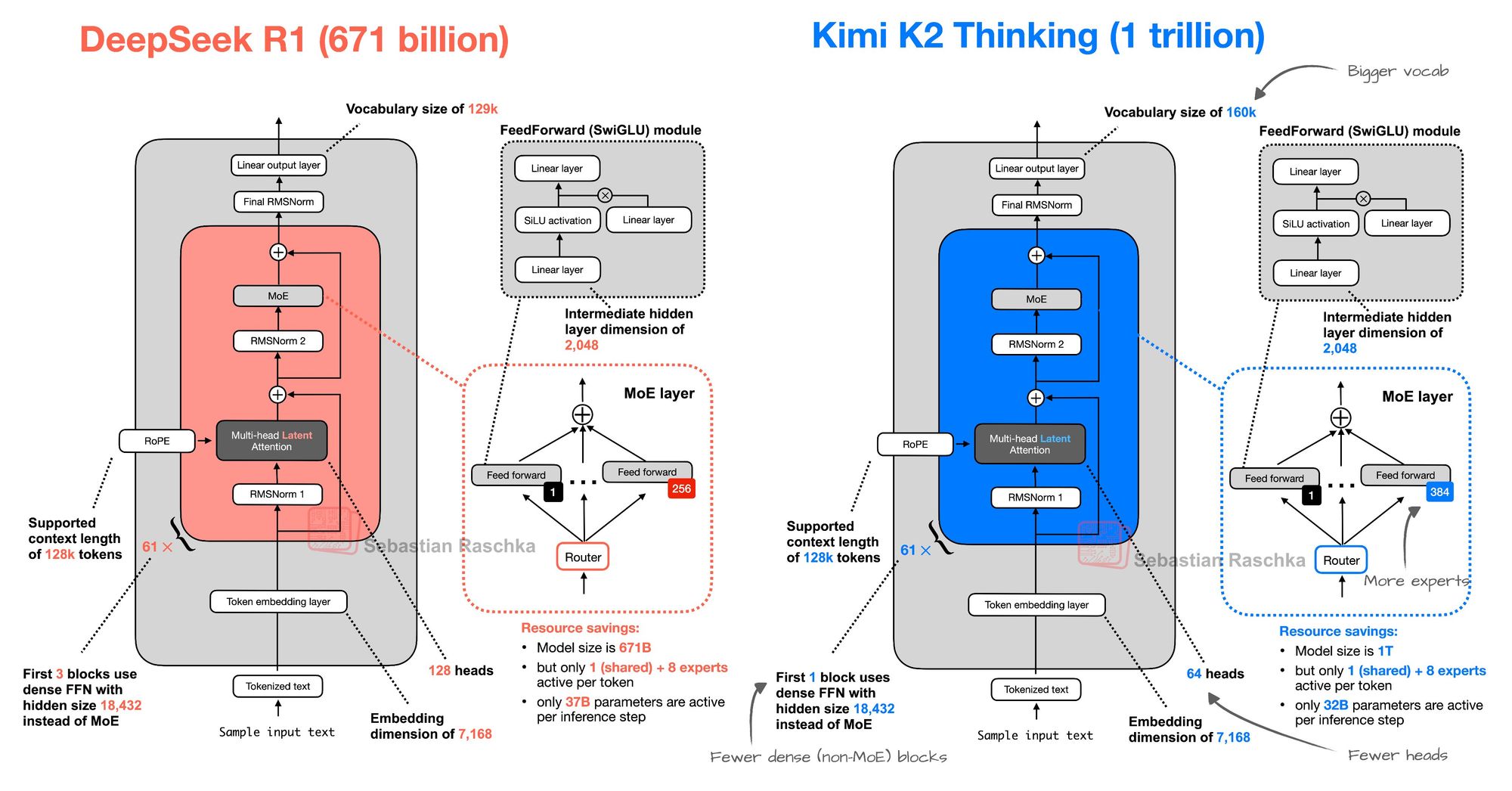

Profundizando en los fundamentos técnicos, Kimi K2 Thinking emplea una arquitectura de Mezcla de Expertos (MoE) que se hace eco del diseño de DeepSeek R1 pero escala ambiciosamente para una eficiencia superior. Al igual que los 671 mil millones de parámetros de DeepSeek R1, Kimi K2 Thinking aprovecha la activación dispersa para enrutar las entradas a través de expertos especializados, minimizando el desperdicio de cómputo. Sin embargo, expande el vocabulario a 160.000 tokens —frente a los 129.000 de DeepSeek R1—, lo que permite un manejo más rico de términos multilingües y específicos de dominio, crucial para las aplicaciones globales de la API de Kimi K2 Thinking.

El modelo cuenta con 384 expertos en comparación con los 256 de DeepSeek R1, lo que permite una especialización más granular en tareas como la codificación o la búsqueda. Sin embargo, se optimiza con menos bloques densos (no-MoE) y cabezas de atención reducidas (64 frente a 128), optimizando la velocidad de inferencia sin sacrificar profundidad. Este equilibrio resulta en una ventana de contexto de 256K, que soporta diálogos extendidos o análisis de documentos en las llamadas a la API de Kimi K2 Thinking. Entrenado en diversos conjuntos de datos que enfatizan los comportamientos agenciales, la arquitectura prioriza las fases de "pensamiento" —monólogos internos iterativos que refinan las salidas antes de la invocación de herramientas.

Para los usuarios de la API, esto se traduce en un razonamiento multi-paso fiable: una única solicitud a la API de Kimi K2 Thinking puede orquestar entre 200 y 300 llamadas a herramientas, desde web scraping hasta ejecución de código, todo dentro de una respuesta unificada. El énfasis de Moonshot AI en los pesos de código abierto significa que los desarrolladores pueden ajustar el modelo para necesidades específicas, como el modelado financiero, mientras que la huella ligera de la API se adapta a implementaciones en el borde. En general, la arquitectura de Kimi K2 Thinking encarna una escalabilidad eficiente, lo que convierte a la API de Kimi K2 Thinking en una opción pragmática para equipos conscientes de los recursos.

Puntos de Referencia y Capacidades de Kimi K2 Thinking

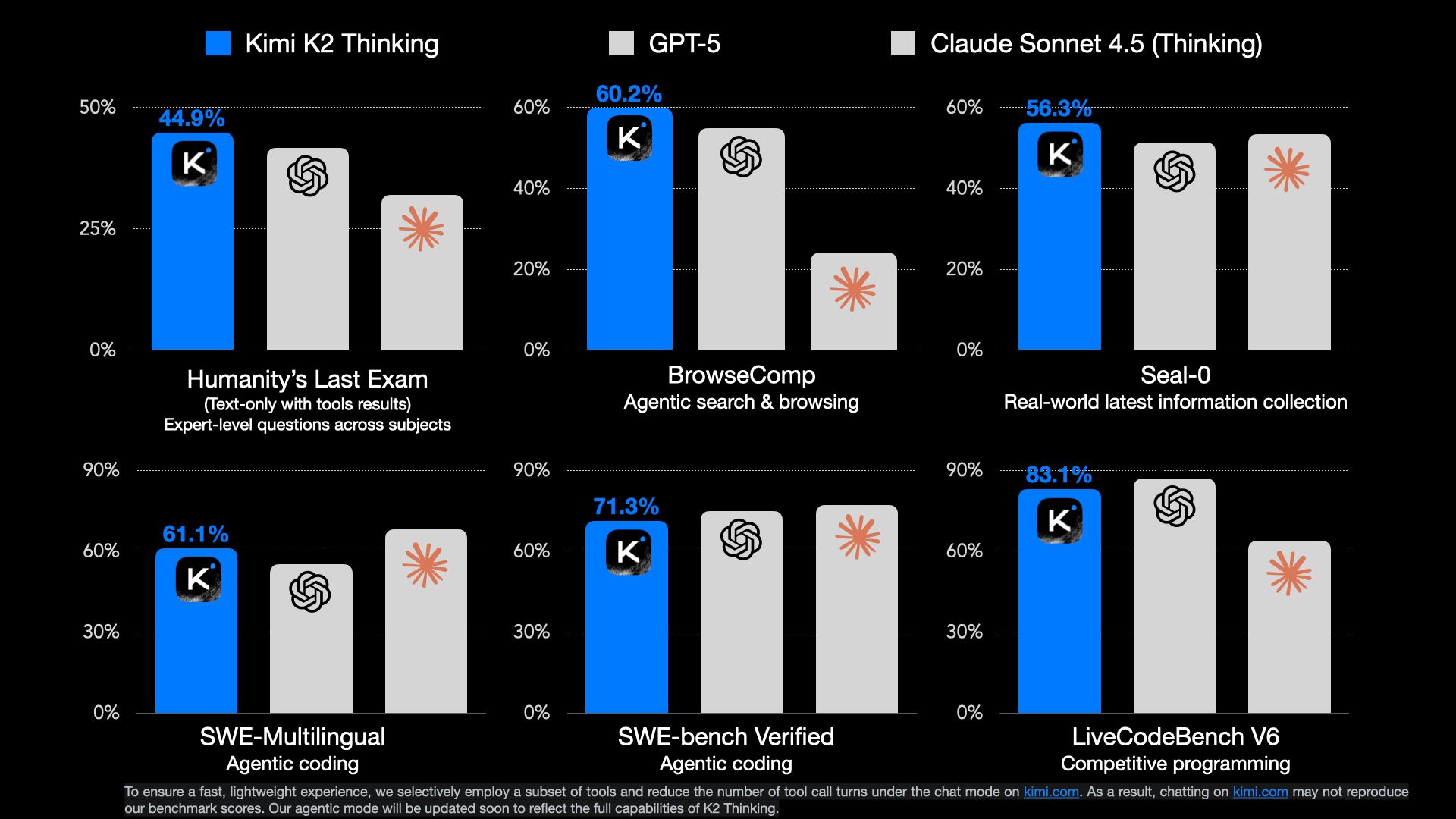

Kimi K2 Thinking ha alcanzado rápidamente el estatus de vanguardia (SOTA) en los puntos de referencia agenciales, lo que subraya su destreza como agente pensante de código abierto. En la Evaluación similar a HumanEval (HLE), logra un 44.9%, superando a sus competidores en la resolución de problemas complejos. De manera similar, BrowseComp obtiene un 60.2%, destacando su excelencia en la navegación web y la síntesis de datos, donde los modelos tradicionales fallan en el razonamiento de múltiples páginas.

Una característica distintiva es su resistencia: el modelo ejecuta hasta 200-300 llamadas de herramientas secuenciales de forma autónoma, ideal para tareas de largo alcance como pipelines de investigación o maratones de depuración a través de la API de Kimi K2 Thinking. Destaca en el razonamiento, la búsqueda agencial y la codificación, con un sólido rendimiento en GAIA y LiveCodeBench, a menudo superando a sus rivales de código cerrado. La ventana de contexto de 256K permite procesar bases de código completas o documentos extensos, lo que posibilita resultados matizados.

Moonshot AI posiciona a Kimi K2 Thinking como pionero en la escalabilidad en tiempo de prueba, amplificando los "tokens de pensamiento" y los turnos de herramientas para una inferencia más profunda. Actualmente en modo chat en kimi.com, el modo agencial completo promete interacciones de API aún más fluidas. Los primeros usuarios elogian su equilibrio entre precisión y velocidad, con una latencia de API inferior a 2 segundos para consultas estándar. Para los desarrolladores, estos puntos de referencia significan que la API de Kimi K2 Thinking ofrece resultados fiables y de alta fidelidad, fomentando la confianza en entornos de producción.

Precios de la API de Kimi K2 Thinking

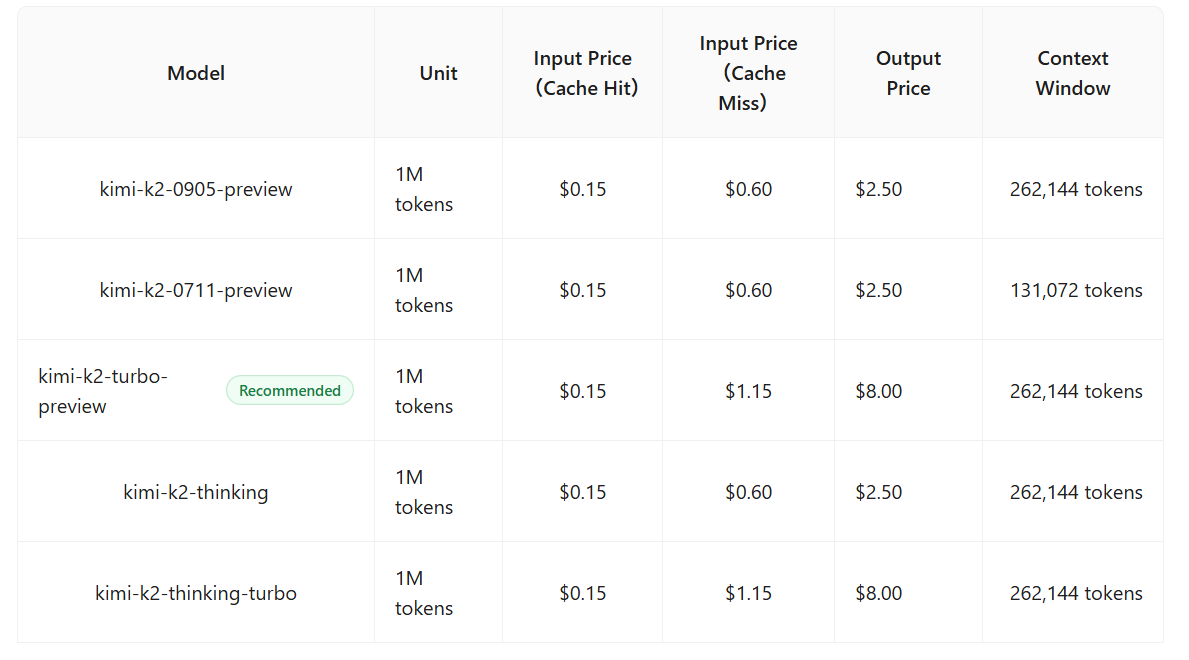

Uno de los aspectos más atractivos de Kimi K2 Thinking es su precio competitivo, posicionando la API de Kimi K2 Thinking como una alternativa económica a los modelos premium. Los tokens de entrada cuestan $0.15 por millón, con salidas a $2.50 por millón, significativamente más bajos que las tarifas de $3/$15 de Claude 4.5 Sonnet. Esto lo hace ideal para aplicaciones de alto volumen como chatbots o análisis de datos.

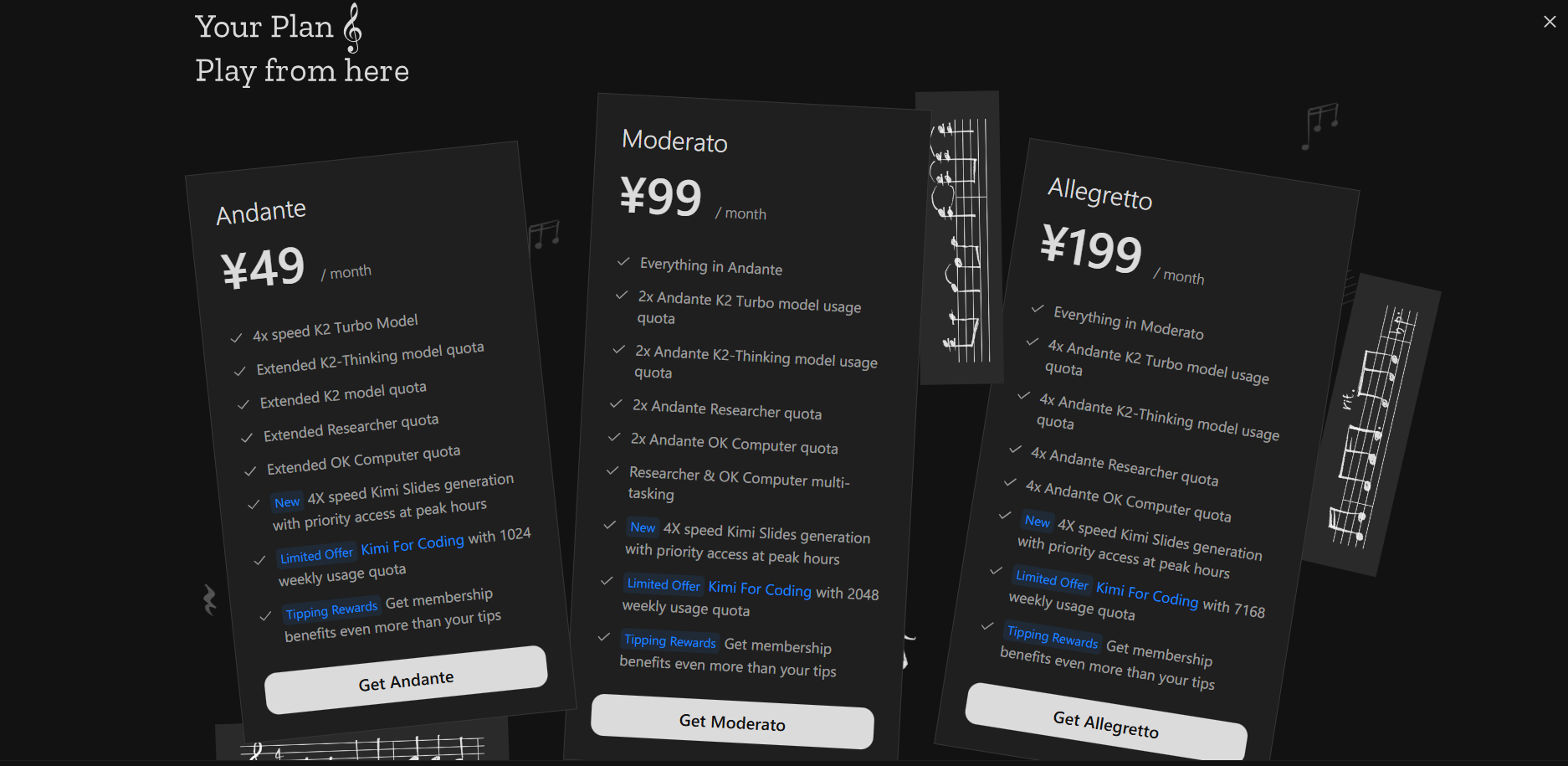

A pesar de superar a GPT-5 y Sonnet en puntos de referencia como HLE y BrowseComp, Kimi K2 Thinking mantiene la asequibilidad a través de un diseño MoE eficiente, reduciendo los costos operativos sin comprometer la calidad. Los niveles gratuitos ofrecen llamadas a la API limitadas para pruebas, mientras que los planes de pago comienzan en $49/mes, escalando a volúmenes empresariales con descuentos por volumen. La ausencia de tarifas ocultas para las llamadas a herramientas mejora la previsibilidad. Para las startups, este precio democratiza la IA agencial avanzada, permitiendo la experimentación sin gastos prohibitivos.

Casos de Uso Prácticos para la API de Kimi K2 Thinking

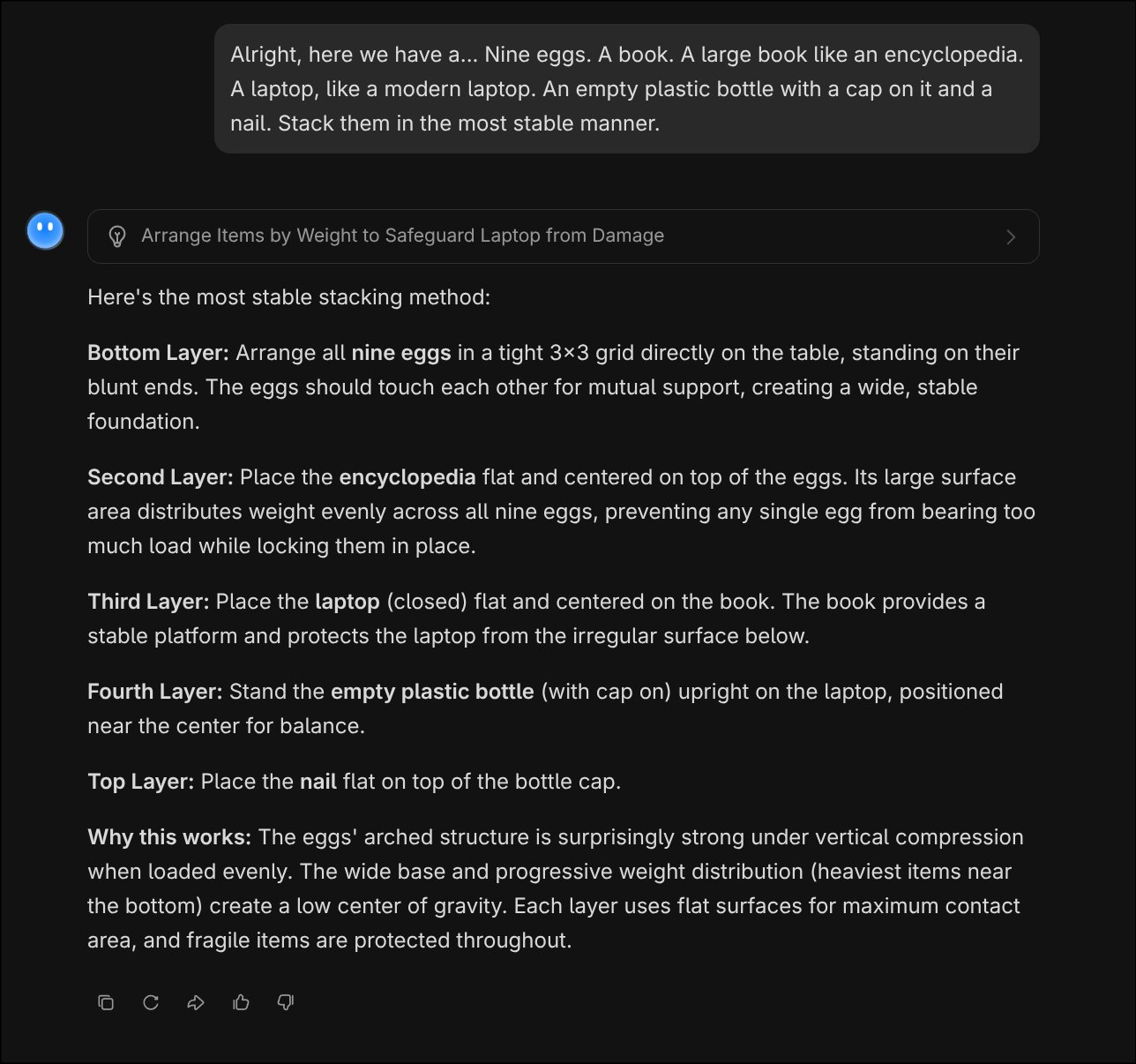

La fortaleza de Kimi K2 Thinking reside en su razonamiento similar al humano, lo que hace que la API de Kimi K2 Thinking sea perfecta para problemas complicados y de varios pasos. Considera un clásico rompecabezas de apilamiento: "Bien, aquí tenemos nueve huevos, un libro (grande como una enciclopedia), una computadora portátil (moderna), una botella de plástico vacía con tapa y un clavo. Apílalos de la manera más estable."

La API responde con deducción lógica y paso a paso. La salida muestra la simulación física intuitiva y la planificación secuencial de Kimi K2 Thinking, mucho más allá de las respuestas rutinarias.

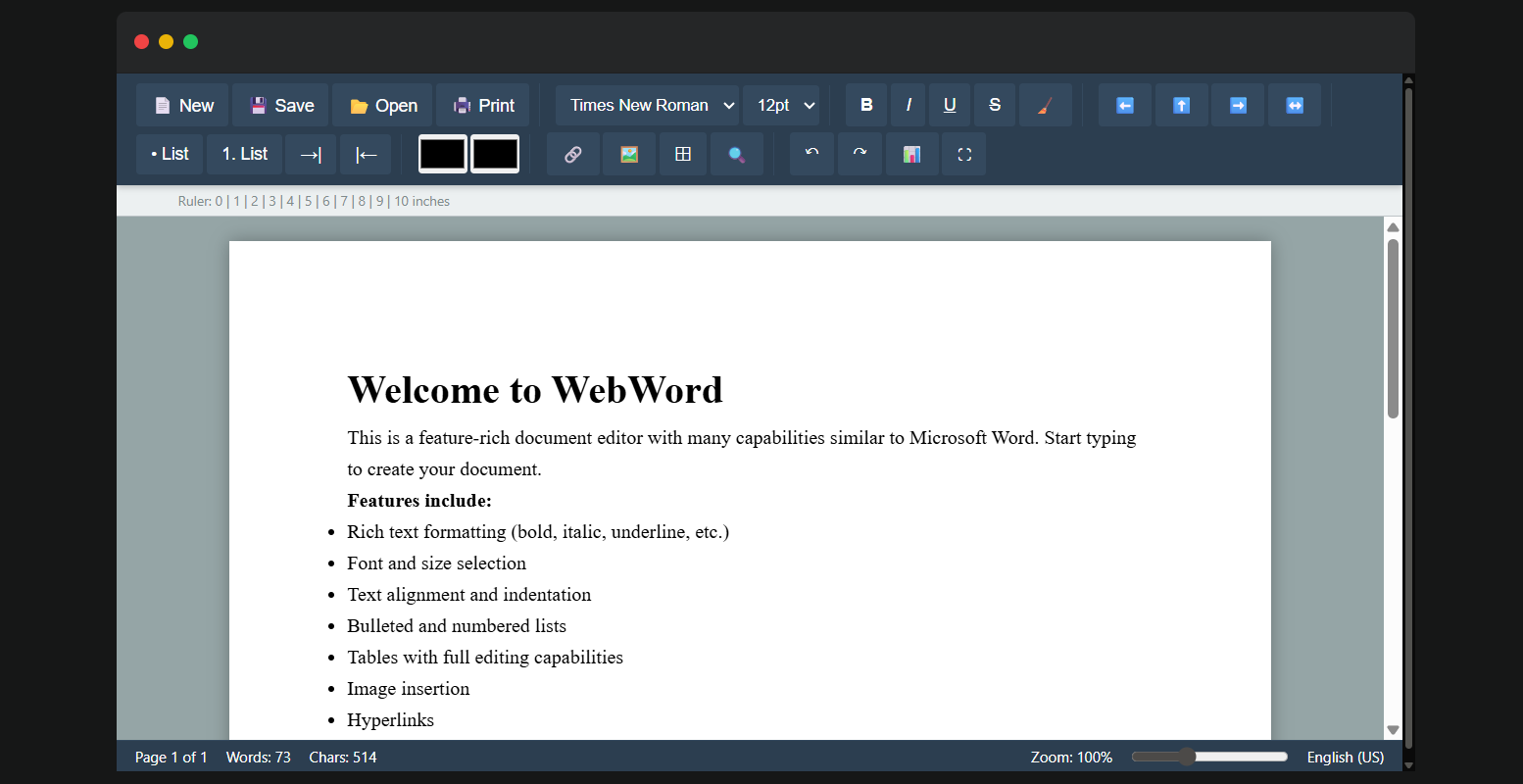

Para la codificación: Considera una tarea de clonación de documentos, como replicar la estructura de un informe de Microsoft Word: Solicita a la API con "Clona el diseño de esta plantilla de Word, incluyendo tablas, imágenes, fuentes personalizadas y encabezados."

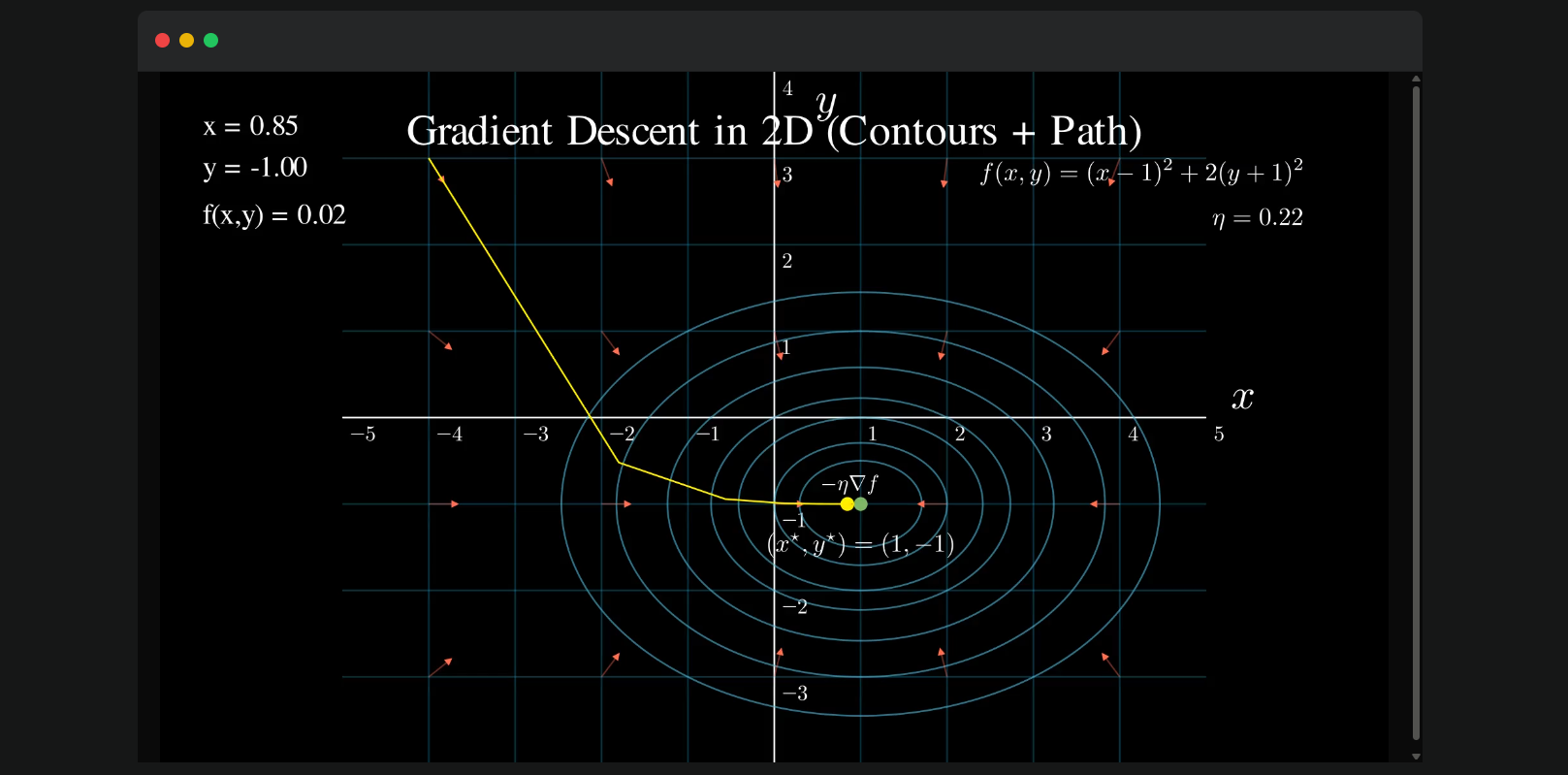

Otra aplicación convincente es la visualización del descenso de gradiente, un concepto fundamental del aprendizaje automático. Usando la API de Kimi K2 Thinking, envía: "Visualiza el descenso de gradiente". El modelo razona a través de las matemáticas, invoca Matplotlib mediante la ejecución de código y produce un gráfico paso a paso: cada iteración traza el descenso de la función de costo, con anotaciones para la tasa de aprendizaje y el punto de convergencia. La respuesta incluye el fragmento de Python para la reproducibilidad, además de información, por ejemplo, "En la iteración 5, la pérdida cae por debajo de 0.1, confirmando la estabilidad". Esto no solo educa, sino que también permite la creación rápida de prototipos para tutoriales de ML o demostraciones de optimización.

Compatibilidad de la API de Kimi K2 Thinking

Uno de los principales atractivos de la API de Kimi K2 Thinking es su compatibilidad directa con las especificaciones de la interfaz de OpenAI, lo que facilita las migraciones para aplicaciones existentes. Los desarrolladores pueden usar los SDK de Python o Node.js de OpenAI sin cambios, simplemente actualizando la `base_url` al endpoint de Moonshot "https://api.moonshot.ai/v1" y cambiando la `api_key` por una credencial de Kimi.

Esta compatibilidad significa que si tu servicio depende de los endpoints de GPT, la transición a Kimi K2 Thinking requiere ajustes mínimos en el código: sin refactorizar llamadas a SDK ni manejar nuevos esquemas. Por ejemplo, una solicitud de completado de chat:

from openai import OpenAI

client = OpenAI(

api_key="your_kimi_api_key",

base_url="https://api.moonshot.ai/v1"

)

response = client.chat.completions.create(

model="kimi-k2-thinking",

messages=[{"role": "user", "content": "Explain quantum entanglement."}]

)

La respuesta refleja el formato de OpenAI, con el razonamiento mejorado de Kimi K2 Thinking. Esta configuración sin fricciones acelera la adopción, permitiendo pruebas A/B o implementaciones híbridas sin problemas. Para flujos agenciales, las llamadas a herramientas se alinean perfectamente, soportando esquemas JSON para salidas estructuradas.

Obtención y Uso de la Clave API de Kimi K2 Thinking

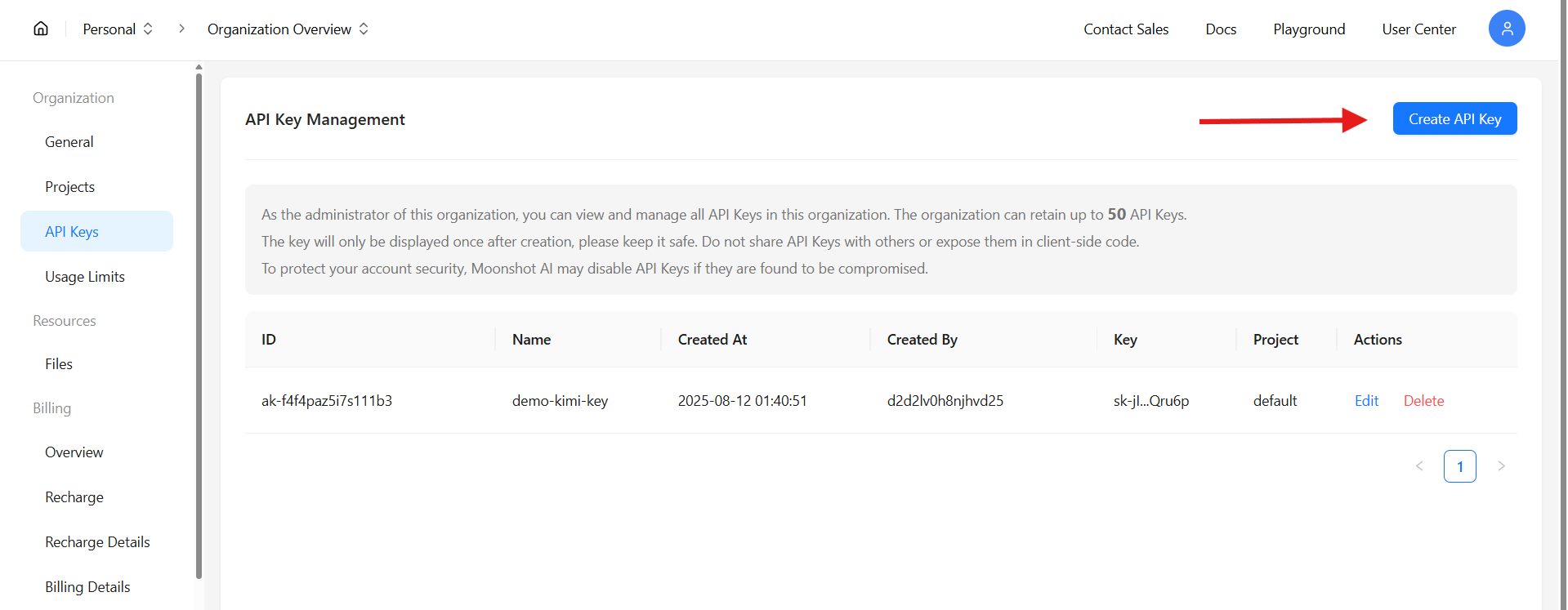

Asegurar el acceso a la API de Kimi K2 Thinking comienza en platform.moonshot.ai. Regístrate o inicia sesión, luego navega a la consola de la API bajo "API Keys". Haz clic en "Create New Key", selecciona los permisos (por ejemplo, completados de chat, llamadas a herramientas) y genera; copia la clave inmediatamente, ya que se muestra solo una vez.

Con la clave, configura tu SDK como se indicó anteriormente. Prueba con un simple curl:

curl https://api.moonshot.ai/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $KIMI_API_KEY" \

-d '{

"model": "kimi-k2-thinking",

"messages": [{"role": "user", "content": "Hello, world!"}]

}'

Esto verifica la conectividad, devolviendo un completado con la profundidad característica de Kimi K2 Thinking. Se aplican límites de tasa (por ejemplo, 100 RPM en el nivel gratuito), escalables a través de planes de pago. La documentación en la consola proporciona endpoints para el ajuste fino o trabajos por lotes.

Probando la API de Kimi K2 Thinking con Apidog

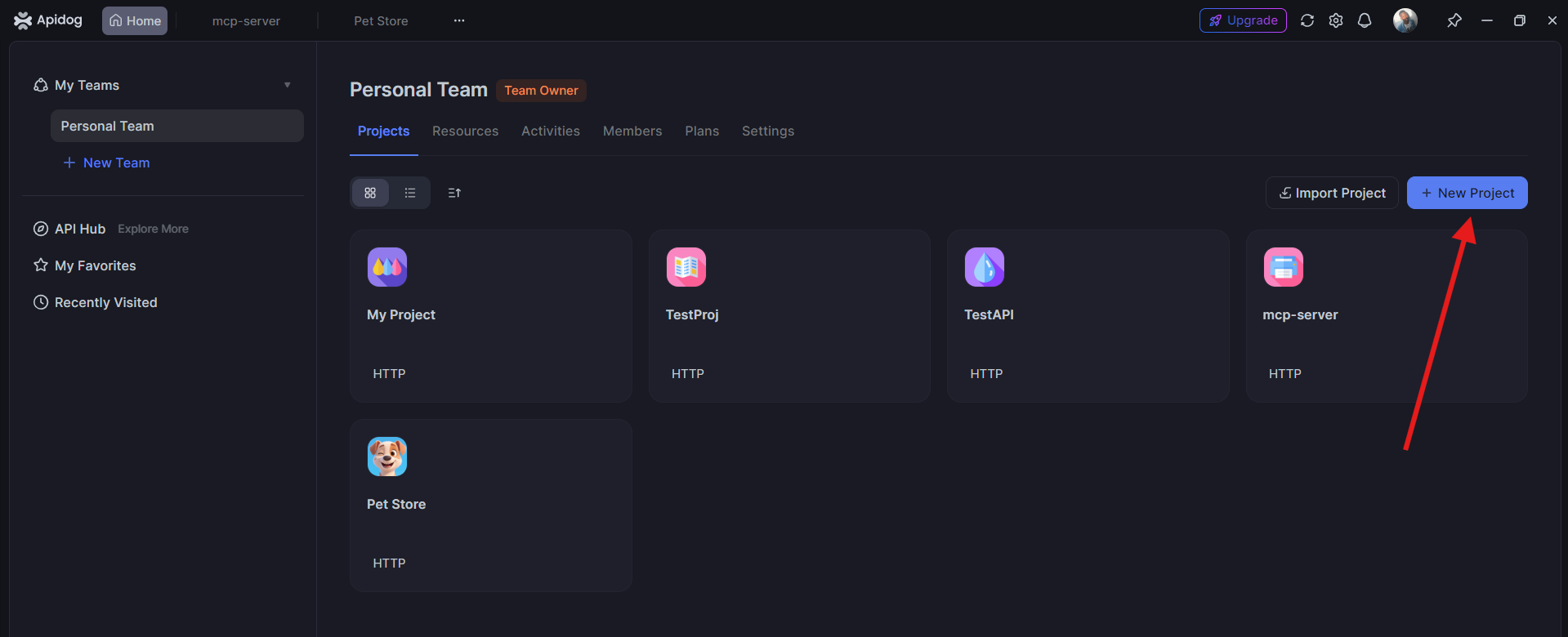

Antes de la implementación, puedes probar fácilmente tus solicitudes a la API de Kimi K2 Thinking usando Apidog, una plataforma colaborativa de prueba de API.

1. Abre Apidog y crea un nuevo proyecto. Agrega el endpoint de la API de Kimi:POST https://api.moonshot.ai/v1/chat/completions

2. Incluye tu clave API en Autorización > Bearer Token.

3. Agrega el cuerpo de la solicitud:

{ "model": "kimi-k2-thinking", "messages": [ {"role": "user", "content": "Escribe un poema sobre el razonamiento de la IA."} ]}

4. Haz clic en Enviar — obtendrás una respuesta en vivo del modelo Kimi K2 Thinking.

Realizar pruebas en Apidog ayuda a verificar tus configuraciones y asegurar que tu clave API y endpoint funcionan correctamente antes de la integración.

Conclusión: Adopta la API de Kimi K2 Thinking

La API de Kimi K2 Thinking se erige como un faro de innovación de código abierto, fusionando eficiencia arquitectónica, dominio en puntos de referencia y utilidad práctica a una fracción de los costos de sus competidores. Desde rompecabezas lógicos hasta maratones de codificación, su profundidad agencial a través de la compatibilidad con OpenAI empodera a los desarrolladores para construir sistemas más inteligentes. Obtén tu clave, prueba con Apidog y comienza a escalar: Kimi K2 Thinking está listo para pensar contigo.