La API GPT-4.1, desarrollada por OpenAI, representa un avance significativo en la inteligencia artificial, ofreciendo a los desarrolladores capacidades robustas para construir aplicaciones que sobresalen en la codificación, el seguimiento de instrucciones y el manejo de tareas de contexto largo. Ya sea que estés creando chatbots inteligentes, automatizando flujos de trabajo o generando contenido dinámico, esta API proporciona las herramientas para integrar la IA de vanguardia en tus proyectos.

¿Qué es la API GPT-4.1?

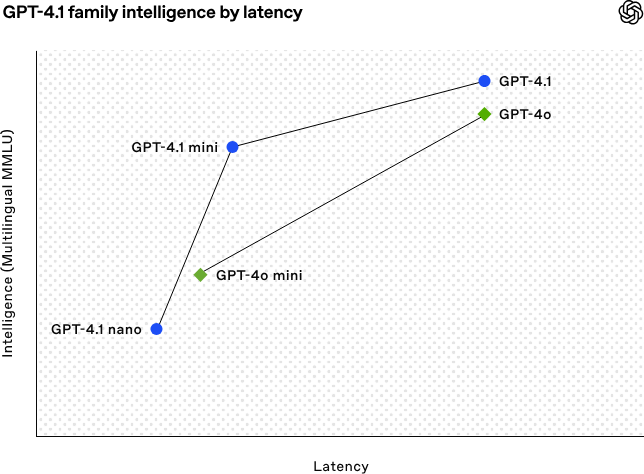

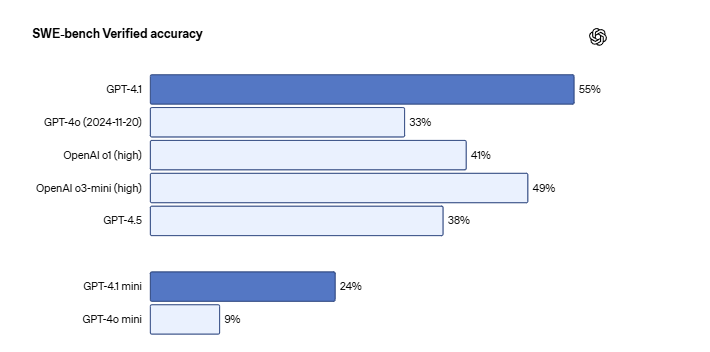

La API GPT-4.1 es una interfaz solo API proporcionada por OpenAI, diseñada para ofrecer un rendimiento mejorado con respecto a sus predecesoras. Admite una ventana de contexto de hasta 1 millón de tokens, lo que le permite procesar y generar texto, código y datos estructurados extensos. Según OpenAI, GPT-4.1 destaca en la utilidad del mundo real, particularmente para los desarrolladores que construyen aplicaciones que requieren una adherencia precisa a las instrucciones y un razonamiento complejo.

Además, la API está disponible en múltiples variantes, incluyendo GPT-4.1-mini y GPT-4.1-nano, que se adaptan a diferentes casos de uso basados en las limitaciones de recursos y las necesidades de rendimiento.

Requisitos previos para usar la API GPT-4.1

Antes de sumergirte en la configuración técnica, asegúrate de tener lo siguiente:

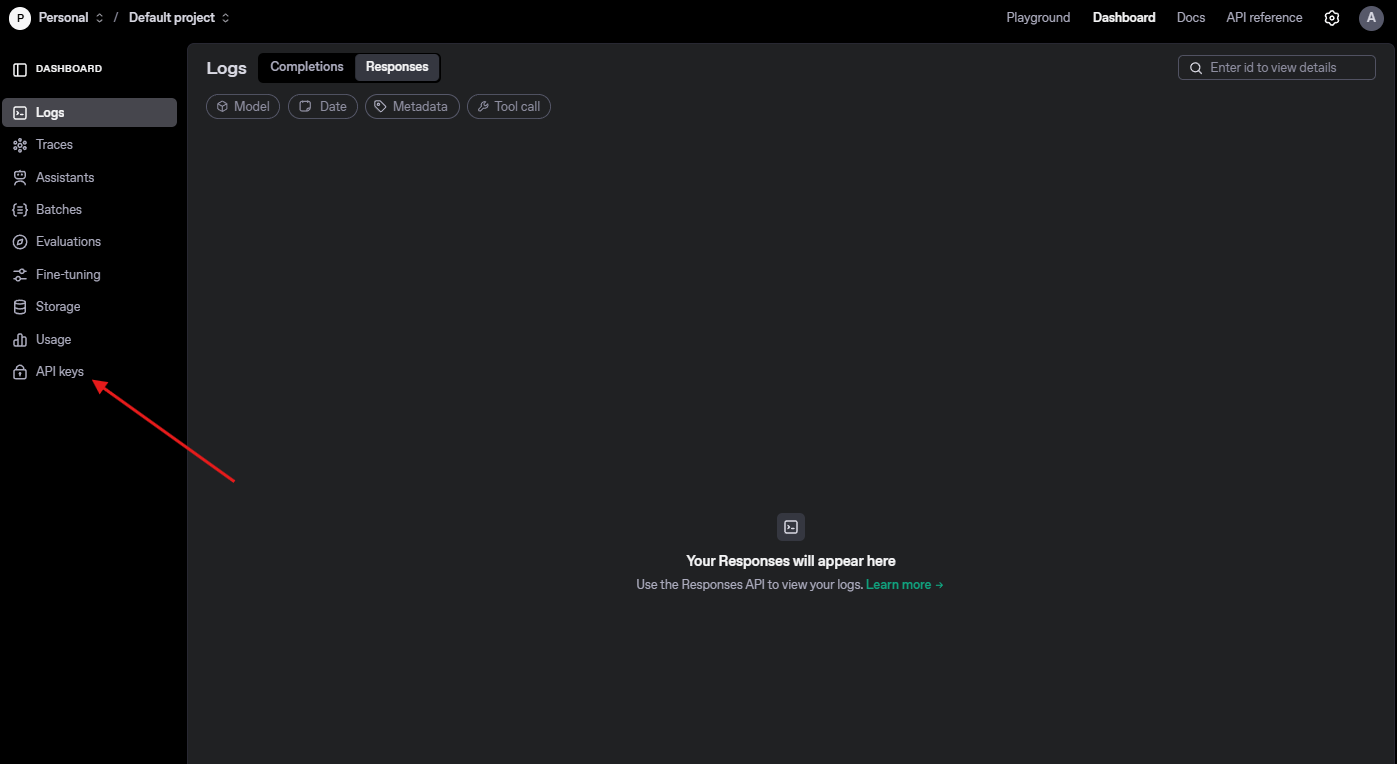

Cuenta de OpenAI: Regístrate en el sitio web de OpenAI para acceder al panel de control de la API.

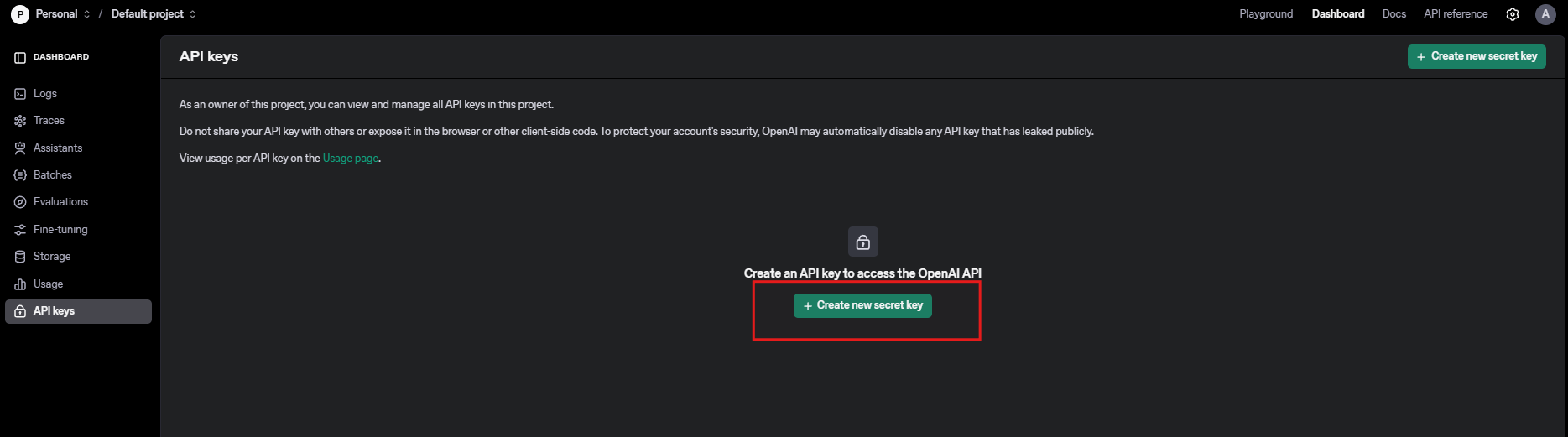

Clave API: Genera una clave API única desde la plataforma OpenAI para autenticar tus solicitudes.

Entorno de programación: Configura un entorno de desarrollo con un lenguaje como Python, Node.js o cURL para realizar solicitudes HTTP.

Instalación de Apidog: Instala Apidog para probar y gestionar tus llamadas API de manera eficiente.

Conocimientos básicos de API: Comprende los métodos HTTP (POST, GET) y el formato JSON para estructurar las solicitudes.

Con esto en su lugar, procedamos a configurar tu entorno para la API GPT-4.1.

Configurando tu entorno para la API GPT-4.1

Para interactuar con la API GPT-4.1, configura tu entorno de desarrollo de la siguiente manera:

Paso 1: Instala el SDK de OpenAI

Para los desarrolladores de Python, el SDK de OpenAI simplifica las interacciones con la API. Instálalo usando pip:

pip install openai

Paso 2: Protege tu clave API

Almacena tu clave API de forma segura, preferiblemente en una variable de entorno, para evitar codificarla directamente en tus scripts. Por ejemplo, en un sistema basado en Unix:

export OPENAI_API_KEY='tu-clave-api-aquí'

Paso 3: Verifica la instalación de Apidog

Descarga e instala Apidog desde Apidog. Crea un nuevo proyecto en Apidog para gestionar tus solicitudes de la API GPT-4.1. La interfaz intuitiva de Apidog te permite probar endpoints, validar respuestas y supervisar el rendimiento sin escribir código extenso.

Paso 4: Prueba la conectividad

Ejecuta un script simple para confirmar tu configuración:

import openai

import os

openai.api_key = os.getenv("OPENAI_API_KEY")

response = openai.ChatCompletion.create(

model="gpt-4.1",

messages=[{"role": "user", "content": "Hola, GPT-4.1!"}]

)

print(response.choices[0].message.content)

Si tiene éxito, verás una respuesta de la API. Ahora, exploremos cómo estructurar las solicitudes de la API.

Estructurando las solicitudes de la API GPT-4.1

La API GPT-4.1 utiliza una arquitectura basada en chat, que requiere solicitudes con formato JSON. Aquí hay un desglose de los componentes clave:

- Modelo: Especifica

"gpt-4.1","gpt-4.1-mini"o"gpt-4.1-nano"según tus necesidades. - Mensajes: Un array de objetos de mensaje que definen el contexto de la conversación. Cada mensaje incluye:

- Rol:

"system","user"o"assistant". - Contenido: El texto o las instrucciones para el modelo.

- Parámetros: Configuraciones opcionales como

temperature(controla la aleatoriedad) ymax_tokens(limita la longitud de la respuesta).

Por ejemplo, para generar un fragmento de código:

response = openai.ChatCompletion.create(

model="gpt-4.1",

messages=[

{"role": "system", "content": "Eres un asistente de codificación."},

{"role": "user", "content": "Escribe una función de Python para calcular el factorial."}

],

temperature=0.7,

max_tokens=200

)

Esta solicitud le indica a GPT-4.1 que actúe como un asistente de codificación y genere una función factorial. Apidog puede ayudarte a probar tales solicitudes permitiéndote ingresar cargas útiles JSON e inspeccionar las respuestas en tiempo real.

A continuación, cubriré cómo manejar las respuestas de la API de manera efectiva.

Manejando las respuestas de la API GPT-4.1

La API GPT-4.1 devuelve un objeto JSON que contiene la salida del modelo. Los campos clave incluyen:

- choices: Un array de opciones de respuesta, que normalmente contiene un elemento a menos que se soliciten múltiples finalizaciones.

- message.content: El texto o código generado.

- usage: Detalles del consumo de tokens para la entrada y la salida.

Aquí te mostramos cómo analizar una respuesta:

response = openai.ChatCompletion.create(

model="gpt-4.1",

messages=[{"role": "user", "content": "Explica la computación cuántica en términos sencillos."}]

)

content = response.choices[0].message.content

tokens_used = response.usage.total_tokens

print(f"Respuesta: {content}")

print(f"Tokens Usados: {tokens_used}")

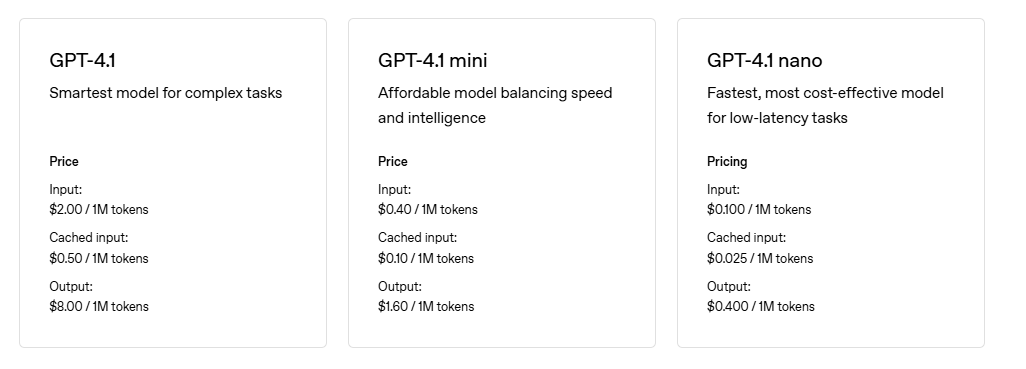

Para optimizar los costos, supervisa el uso de tokens, ya que los precios dependen de los tokens de entrada y salida. Según la página de precios de OpenAI, GPT-4.1 tiene un precio competitivo por sus capacidades, pero los costos pueden acumularse para aplicaciones de alto volumen.

Apidog simplifica el manejo de respuestas al visualizar estructuras JSON y resaltar errores, asegurando que detectes los problemas de forma temprana. Ahora examinemos los casos de uso prácticos para la API GPT-4.1.

Casos de uso prácticos para la API GPT-4.1

La versatilidad de la API GPT-4.1 la hace adecuada para diversas aplicaciones. Aquí hay tres ejemplos:

1. Generación de código

Indica a GPT-4.1 que escriba scripts, depure código o genere código boilerplate. Por ejemplo:

{

"model": "gpt-4.1",

"messages": [

{"role": "user", "content": "Crea un endpoint de API REST en Flask para obtener datos de usuario."}

]

}

Prueba esta solicitud en Apidog para verificar la sintaxis y la funcionalidad del código generado.

2. Creación de contenido

Genera publicaciones de blog, descripciones de productos o contenido de redes sociales. Por ejemplo:

response = openai.ChatCompletion.create(

model="gpt-4.1",

messages=[

{"role": "system", "content": "Eres un escritor de contenido."},

{"role": "user", "content": "Escribe una descripción de producto de 100 palabras para un reloj inteligente."}

]

)

3. Análisis de datos

Usa GPT-4.1 para resumir conjuntos de datos o generar información. Por ejemplo, carga un resumen CSV a través de Apidog y solicita:

{

"model": "gpt-4.1",

"messages": [

{"role": "user", "content": "Analiza estos datos de ventas: [contenido CSV]."}

]

}

Estos casos de uso resaltan la flexibilidad de GPT-4.1. Sin embargo, optimizar el rendimiento requiere ajustar los parámetros, lo cual discutiré a continuación.

Optimizando el rendimiento de la API GPT-4.1

Para maximizar la eficiencia de la API GPT-4.1, ajusta los siguientes parámetros:

- Temperatura: Establece entre 0.0 (determinista) y 1.0 (creativo). Para tareas técnicas, usa 0.3–0.7.

- Max Tokens: Limita la longitud de la salida para reducir los costos y mejorar el tiempo de respuesta.

- Top-p Sampling: Controla la diversidad de la respuesta. Un valor de 0.9 equilibra la coherencia y la variedad.

Por ejemplo:

response = openai.ChatCompletion.create(

model="gpt-4.1",

messages=[{"role": "user", "content": "Resume un artículo de 500 palabras."}],

temperature=0.5,

max_tokens=100,

top_p=0.9

)

Además, agrupa las solicitudes cuando sea posible para minimizar las llamadas a la API. Las funciones de automatización de Apidog pueden programar y ejecutar pruebas por lotes, garantizando un rendimiento constante.

Ahora, abordemos los desafíos comunes y cómo solucionarlos.

Solución de problemas comunes de la API GPT-4.1

A pesar de su robustez, puedes encontrar problemas con la API GPT-4.1. Aquí hay soluciones a problemas frecuentes:

1. Errores de autenticación

- Problema: Clave API no válida (401 No autorizado).

- Solución: Verifica tu clave en el panel de control de OpenAI y asegúrate de que esté configurada correctamente en tu entorno.

2. Límites de velocidad

- Problema: Exceder los límites de solicitud (429 Demasiadas solicitudes).

- Solución: Consulta la documentación de límites de velocidad de OpenAI e implementa una retroceso exponencial en tu código.

3. Salidas inesperadas

- Problema: Respuestas irrelevantes o incompletas.

- Solución: Refina tus indicaciones con instrucciones claras y ajusta parámetros como la temperatura.

El seguimiento de errores de Apidog ayuda a identificar problemas al registrar pares de solicitud-respuesta, lo que facilita la depuración. Por ejemplo, si una respuesta se trunca, Apidog resalta que se excedieron los límites de tokens.

A continuación, explicaré cómo Apidog mejora la integración de la API GPT-4.1.

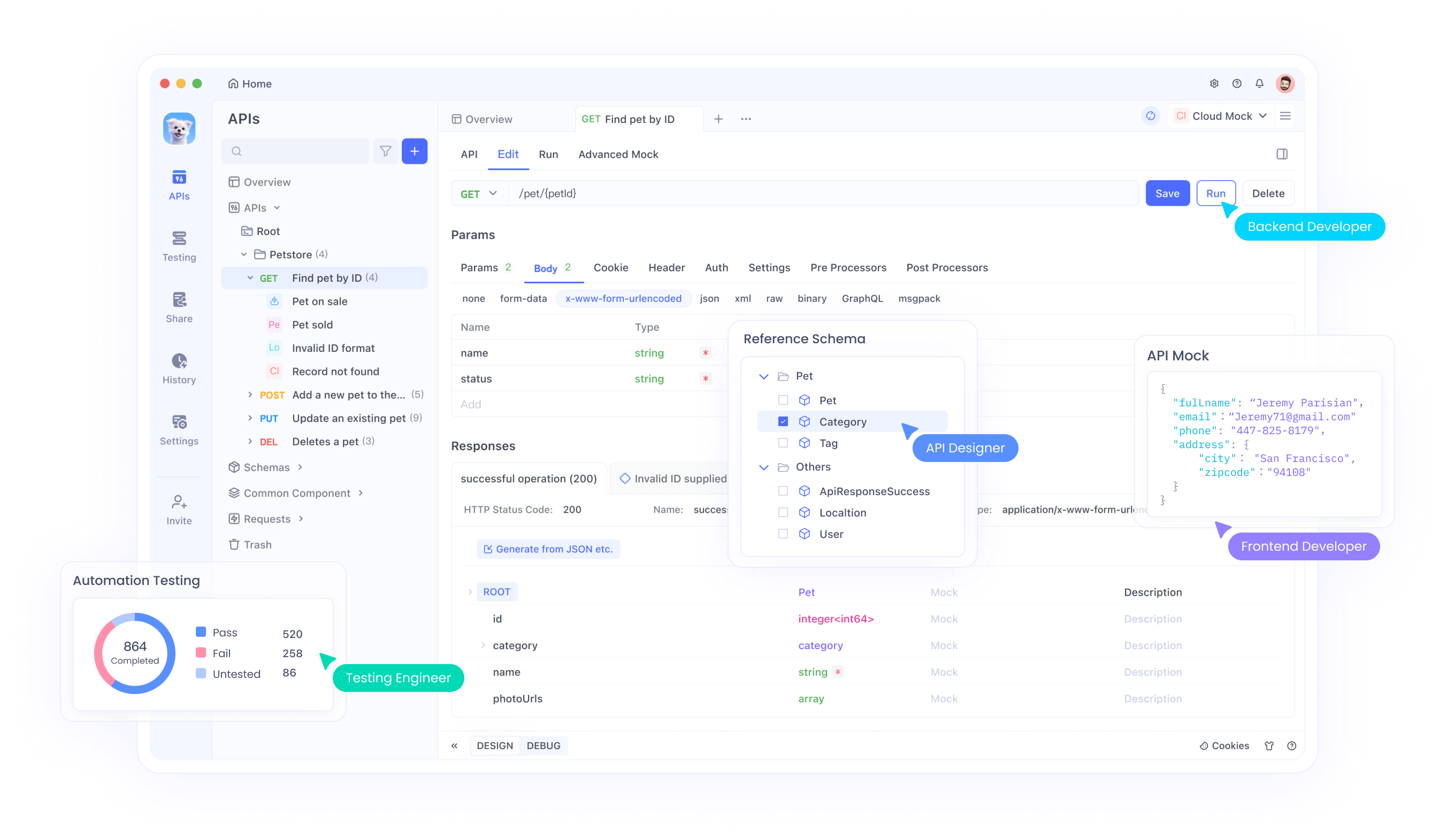

Aprovechando Apidog para la integración de la API GPT-4.1

Apidog es una herramienta poderosa para gestionar flujos de trabajo de API, que ofrece funciones adaptadas a la API GPT-4.1:

- Constructor de solicitudes: Crea y envía solicitudes JSON sin codificar.

- Validación de respuestas: Verifica las salidas con respecto a los formatos esperados.

- Supervisión del rendimiento: Realiza un seguimiento de los tiempos de respuesta y el uso de tokens.

- Colaboración: Comparte proyectos de API con los miembros del equipo para un desarrollo optimizado.

Para usar Apidog:

- Abre Apidog y crea un nuevo proyecto.

- Agrega el endpoint de la API GPT-4.1:

https://api.openai.com/v1/chat/completions. - Ingresa tu clave API en el encabezado de autorización.

- Crea una solicitud, como:

{

"model": "gpt-4.1",

"messages": [{"role": "user", "content": "Solicitud de prueba"}]

}

- Envía la solicitud y analiza la respuesta en la interfaz de Apidog.

Al integrar Apidog, reduces los errores manuales y aceleras el desarrollo. Ahora consideremos las mejores prácticas para un uso seguro y eficiente de la API.

Mejores prácticas para usar la API GPT-4.1

Para garantizar resultados óptimos, sigue estas pautas:

- Protege las claves API: Almacena las claves en variables de entorno o en una solución de bóveda.

- Supervisa los costos: Realiza un seguimiento del uso de tokens para mantenerte dentro del presupuesto, consultando los detalles de precios de OpenAI.

- Usa indicaciones específicas: Crea instrucciones detalladas para minimizar las salidas irrelevantes.

- Prueba iterativamente: Usa Apidog para ejecutar pruebas a pequeña escala antes de implementar a escala.

- Mantente actualizado: Sigue el blog de OpenAI para obtener actualizaciones de la API y nuevas funciones.

Estas prácticas mejoran la fiabilidad y la rentabilidad. Finalmente, resumamos las conclusiones clave.

Conclusión

La API GPT-4.1 permite a los desarrolladores crear aplicaciones sofisticadas impulsadas por IA con capacidades incomparables en codificación, generación de contenido y análisis de datos. Al configurar tu entorno, estructurar las solicitudes y aprovechar herramientas como Apidog, puedes integrar esta API sin problemas en tus proyectos. Además, la optimización de los parámetros y la solución de problemas garantizan un rendimiento constante, mientras que las mejores prácticas protegen la seguridad y la eficiencia.

Comienza a explorar la API GPT-4.1 hoy mismo y descarga Apidog de forma gratuita para optimizar tu flujo de trabajo. Con estas herramientas, estás bien equipado para aprovechar el poder de la IA avanzada en tus aplicaciones.