El auge de los modelos de lenguaje grandes (LLM) de código abierto ha facilitado más que nunca la creación de herramientas impulsadas por IA que rivalizan con soluciones propietarias como ChatGPT Operator de OpenAI. Entre estos modelos de código abierto, DeepSeek R1 destaca por sus sólidas capacidades de razonamiento, su accesibilidad gratuita y su adaptabilidad. Al combinar DeepSeek R1 con herramientas como Browser Use, puedes construir una alternativa potente y totalmente de código abierto a ChatGPT Operator sin gastar cientos de dólares en suscripciones premium.

Este artículo te guiará a través del proceso de configuración de DeepSeek R1 y Browser Use para crear un agente de IA capaz de realizar tareas complejas, incluyendo la automatización web, el razonamiento y las interacciones en lenguaje natural.

Tanto si eres un principiante como un desarrollador experimentado, esta guía paso a paso te ayudará a empezar.

¿Qué es ChatGPT Operator y por qué necesitas una alternativa de código abierto?

ChatGPT Operator es una función premium ofrecida por OpenAI que permite a los usuarios crear agentes de IA avanzados capaces de realizar tareas complejas como el razonamiento, la automatización web y la resolución de problemas en varios pasos.

ChatGPT Operator cuesta 200 $ al mes, lo que lo hace menos accesible para particulares, pequeñas empresas u organizaciones con presupuestos limitados.

4. Booking a one-way flight from Zurich to Vienna using the Booking integration

— Rowan Cheung (@rowancheung) January 23, 2025

This one required a bit of back and forth, with ChatGPT Operator pinging me and asking for my flight preference and having me take control of entering payment details pic.twitter.com/XZiqUsQgVh

ChatGPT Operator estaba reservando un billete de avión en el vídeo anterior

Por qué necesitas una alternativa de código abierto

Aunque ChatGPT Operator es potente, tiene varias limitaciones que hacen que una alternativa de código abierto sea atractiva:

- Coste: La cuota de suscripción de 200 $/mes puede ser prohibitiva para muchos usuarios.

- Privacidad de los datos: El uso de API propietarias requiere el envío de datos a servidores externos, lo que puede no cumplir con las políticas de privacidad o los requisitos reglamentarios.

- Personalización limitada: Las soluciones propietarias a menudo restringen el ajuste fino o las optimizaciones específicas de la tarea, lo que limita su adaptabilidad para casos de uso especializados.

Al optar por herramientas de código abierto como DeepSeek R1 y Browser Use, puedes superar estos desafíos y desbloquear varios beneficios:

- Ahorro de costes: Tanto DeepSeek R1 como Browser Use son completamente gratuitos y de código abierto, lo que elimina las cuotas de suscripción.

- Control total: Alojar las herramientas localmente o en tu propio servidor garantiza la completa privacidad y seguridad de los datos.

- Personalización: Puedes ajustar el modelo para tareas específicas, integrarlo con otras herramientas y modificar el sistema para satisfacer tus necesidades únicas.

Un enfoque de código abierto no solo reduce la dependencia de las plataformas propietarias, sino que también te permite construir una solución adaptada a tus necesidades, manteniendo el control sobre los costes y los datos.

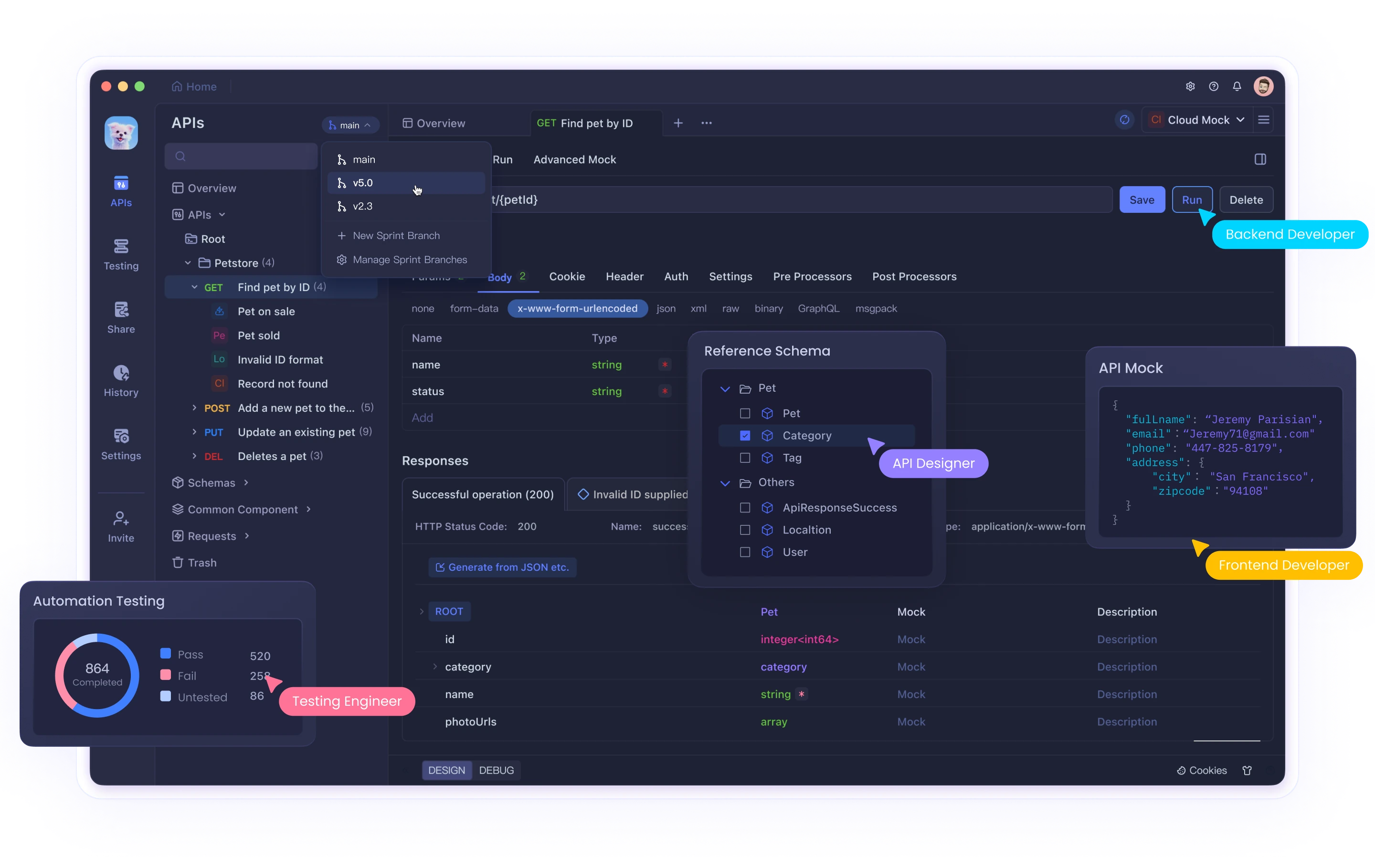

Tienes que echar un vistazo a Apidog, la herramienta de prueba de API todo en uno que te guía a través de todo el ciclo, desde el diseño de la API hasta la documentación de la API, ¡y turbo-carga la productividad de tu equipo de desarrollo!

Componentes clave: DeepSeek R1 y Browser Use

DeepSeek R1

DeepSeek R1 es un LLM de código abierto optimizado para tareas de razonamiento. Destaca en la resolución de problemas de cadena de pensamiento, la asistencia a la codificación y la comprensión del lenguaje natural. Está disponible en varios tamaños (por ejemplo, 1.5B, 7B parámetros), lo que lo hace adaptable a diferentes capacidades de hardware.

Browser Use

Browser Use es una herramienta de código abierto que permite a los agentes de IA realizar tareas basadas en el navegador, como el web scraping, el relleno de formularios y la navegación automatizada. Proporciona una interfaz fácil de usar y puede integrarse con LLM como DeepSeek R1 para mejorar la funcionalidad.

Paso 1: Configurar tu entorno

Requisitos de hardware

- Para las versiones más pequeñas de DeepSeek R1 (por ejemplo, 1.5B parámetros), es suficiente una CPU o una GPU de gama media (8 GB de VRAM).

- Las versiones más grandes requieren GPU de gama alta (por ejemplo, NVIDIA A100 o RTX 4090).

Sistema operativo

- Se recomienda Linux o macOS para facilitar la configuración. Los usuarios de Windows pueden usar WSL (Windows Subsystem for Linux).

Entorno de Python

Crea un entorno virtual de Python para aislar las dependencias:

python -m venv venv

source venv/bin/activate # On Linux/macOS

# On Windows:

# venv\Scripts\activate

Instala las bibliotecas necesarias:

pip install torch torchvision transformers sentencepiece

Paso 2: Ejecutar DeepSeek con API o localmente con Ollama

Uso de la API de DeepSeek

Para interactuar con la API de DeepSeek, sigue estos pasos actualizados:

Obtén una clave de API:

- Regístrate en la plataforma DeepSeek y genera una clave de API desde la sección "API Keys". Guarda esta clave de forma segura, ya que no se volverá a mostrar.

Realiza tu primera llamada a la API:

La API de DeepSeek es compatible con el formato de API de OpenAI, lo que facilita la integración con los SDK o el software de OpenAI existentes. A continuación, se muestra un ejemplo de una implementación de Python:

from openai import OpenAI

client = OpenAI(api_key="<Your_DeepSeek_API_Key>", base_url="https://api.deepseek.com")

response = client.chat.completions.create(

model="deepseek-reasoner", # Use 'deepseek-reasoner' for DeepSeek-R1

messages=[

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Explain quantum entanglement."}

],

stream=False # Set to True if you want streaming responses

)

print(response.choices[0].message.content)

Ejemplo de cURL:

Si prefieres usar cURL, aquí tienes cómo puedes hacer una solicitud:

curl https://api.deepseek.com/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer <Your_DeepSeek_API_Key>" \

-d '{

"model": "deepseek-reasoner",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "What is the capital of France?"}

],

"stream": false

}'

Selección de modelo:

- Especifica

model="deepseek-reasoner"para DeepSeek-R1. - Usa

model="deepseek-chat"para tareas de chat de propósito general.

La base_url también se puede establecer en https://api.deepseek.com/v1 para configuraciones compatibles con OpenAI, aunque la ruta /v1 no tiene relación con las versiones del modelo.

Ejecutar DeepSeek localmente con Ollama

Ollama simplifica la ejecución de modelos de lenguaje grandes como DeepSeek-R1 en tu máquina local. Aquí tienes cómo configurarlo y usarlo correctamente:

Instala Ollama:

- Descarga e instala Ollama desde su sitio web oficial.

Extrae el modelo deseado:

Usa los siguientes comandos para descargar versiones específicas de DeepSeek-R1:

# Para el modelo 7B (predeterminado):

ollama pull deepseek-r1:7b

# Para un modelo 1.5B más pequeño:

ollama pull deepseek-r1:1.5b

# Para modelos más grandes como 70B:

ollama pull deepseek-r1:70b

Ejecuta el modelo localmente:

Una vez descargado, ejecuta el modelo usando:

ollama run deepseek-r1:7b

Esto iniciará una sesión interactiva donde podrás interactuar directamente con el modelo.

Variantes de modelo:

DeepSeek ofrece varias versiones destiladas basadas en las arquitecturas Qwen y Llama, optimizadas para diferentes casos de uso:

DeepSeek-R1-Distill-Qwen-7B:

ollama run deepseek-r1:7b-qwen-distill

DeepSeek-R1-Distill-Llama-70B:

ollama run deepseek-r1:70b-llama-distill

Consideraciones de hardware:

- Los modelos más pequeños como 1.5B o 7B pueden ejecutarse en GPU de consumo o incluso en CPU.

- Los modelos más grandes (por ejemplo, 70B) requieren GPU de gama alta con VRAM significativa (por ejemplo, NVIDIA A100 o RTX 4090).

Chat interactivo a través de la API:

Ollama proporciona una API para integrar modelos que se ejecutan localmente en tus aplicaciones:

curl http://localhost:11434/api/chat -d '{

"model": "deepseek-r1:7b",

"messages": [

{"role": "user", "content": "Write a short poem about the stars."}

]

}'

Paso 3: Instalar Browser Use

Browser Use permite a tu agente de IA interactuar con navegadores web. Sigue estos pasos:

Instalación

Clona el repositorio de Browser Use desde GitHub:

git clone https://github.com/browser-use/browser-use.git

cd browser-use

pip install -r requirements.txt

Configuración

Configura la WebUI de Browser Use:

python webui.py

Abre la WebUI en tu navegador para configurar los ajustes del agente. Puedes especificar:

- El modelo LLM (por ejemplo, DeepSeek R1)

- La configuración del navegador (por ejemplo, el tamaño de la ventana)

Paso 4: Combinar DeepSeek R1 y Browser Use

Para crear un agente de IA funcional que integre ambas herramientas:

Configuración del agente

Modifica la configuración del agente en Browser Use para conectarlo con DeepSeek R1:

{

"model": "deepseek-r1",

"base_url": "http://localhost:5000",

"browser_settings": {

"window_height": 1080,

"window_width": 1920,

"keep_browser_open": true

}

}

Ejecutar el agente

Inicia tanto DeepSeek R1 como Browser Use:

# Start DeepSeek R1 API server

python -m deepseek.api_server

# Start Browser Use WebUI

python webui.py

Una vez que ambos servicios estén en funcionamiento, el agente puede realizar tareas como rellenar formularios, extraer datos o navegar por sitios web de forma autónoma.

Paso 5: Ingeniería de prompts para obtener mejores resultados

Para optimizar el rendimiento de tu agente de IA, utiliza técnicas de ingeniería de prompts. Por ejemplo:

Plantilla de prompt general

<instructions>

Eres un asistente de IA encargado de automatizar tareas web utilizando Browser Use.

Sigue estos pasos:

1. Navega a [sitio web].

2. Realiza [tarea específica].

3. Devuelve los resultados en un formato estructurado.

</instructions>

<example>

Navega a https://example.com y extrae todos los hipervínculos.

</example>

Esta estructura garantiza la claridad y mejora la precisión en la ejecución de tareas.

Aquí tienes algunas demostraciones que puedes probar ejecutando:

uv pip install gradio

python examples/gradio_demo.py

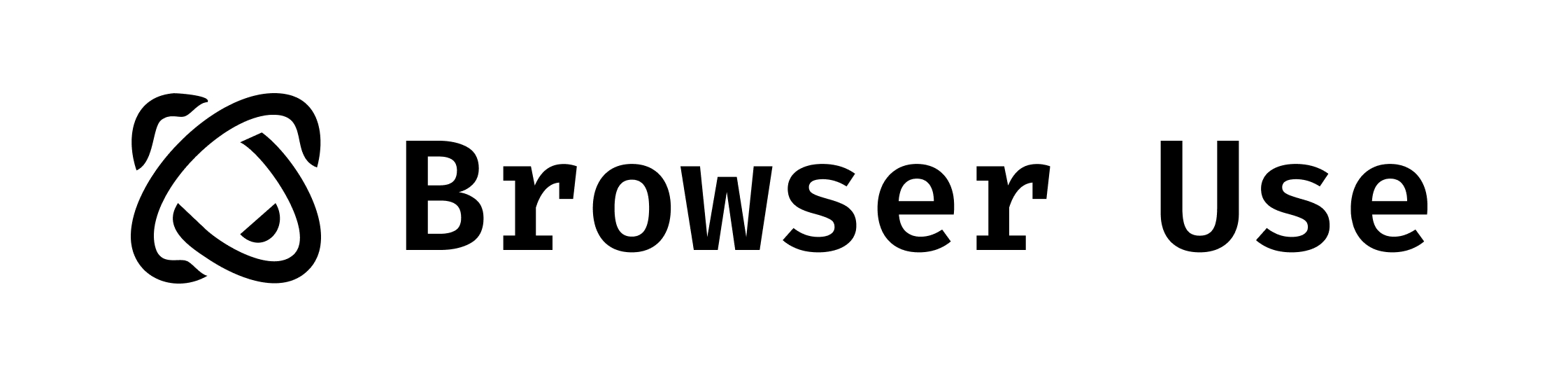

Ejemplo 1.

Prompt: Escribe una carta en Google Docs a mi papá, agradeciéndole todo, y guarda el documento como PDF.

Ejemplo 2.

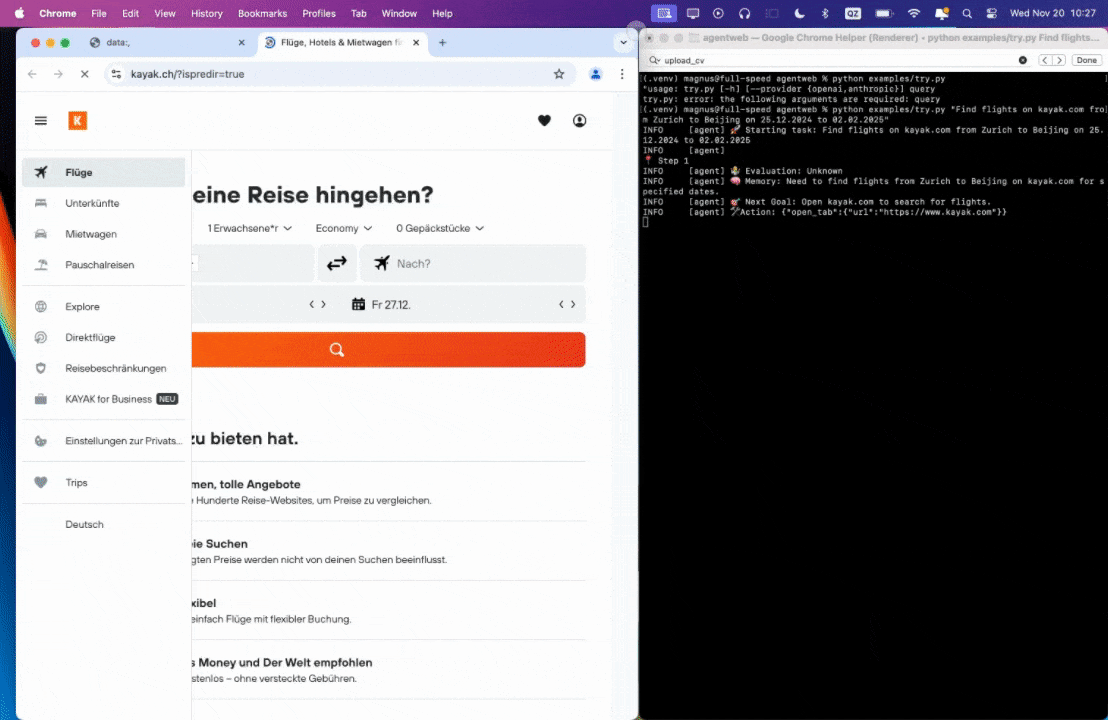

Prompt: Encuentra vuelos en kayak.com de Zúrich a Pekín del 25.12.2024 al 02.02.2025.

Ejemplo 3.

Prompt: Lee mi CV y encuentra trabajos de ML, guárdalos en un archivo y luego empieza a solicitarlos en nuevas pestañas, si necesitas ayuda, pregúntame.

0:00/1×

Conclusión

Al combinar DeepSeek R1 con Browser Use, puedes construir una alternativa a ChatGPT Operator totalmente funcional que es gratuita, de código abierto y altamente personalizable. Esta configuración no solo ahorra costes, sino que también te da control total sobre la privacidad de los datos y el comportamiento del sistema.

Tanto si estás automatizando tareas web, construyendo agentes conversacionales o experimentando con funciones avanzadas de IA como la Generación Aumentada por Recuperación, esta guía te proporciona todo lo que necesitas para empezar. ¡Aprovecha el poder del código abierto y crea tu propio asistente inteligente hoy mismo!

Tienes que echar un vistazo a Apidog, la herramienta de prueba de API todo en uno que te guía a través de todo el ciclo, desde el diseño de la API hasta la documentación de la API, ¡y turbo-carga la productividad de tu equipo de desarrollo!