El mundo de la Inteligencia Artificial (IA) está evolucionando a una velocidad vertiginosa, con los Modelos de Lenguaje Grandes (LLM) como ChatGPT, Claude y Gemini capturando la imaginación en todo el mundo. Estas potentes herramientas pueden escribir código, redactar correos electrónicos, responder a preguntas complejas e incluso generar contenido creativo. Sin embargo, el uso de estos servicios basados en la nube a menudo conlleva preocupaciones sobre la privacidad de los datos, los costes potenciales y la necesidad de una conexión constante a Internet.

Presentamos Ollama.

Ollama es una herramienta potente y de código abierto diseñada para democratizar el acceso a los modelos de lenguaje grandes, permitiéndote descargarlos, ejecutarlos y gestionarlos directamente en tu propio ordenador. Simplifica el proceso, a menudo complejo, de configurar e interactuar con modelos de IA de última generación de forma local.

¿Por qué usar Ollama?

Ejecutar LLM localmente con Ollama ofrece varias ventajas convincentes:

- Privacidad: Tus indicaciones y las respuestas del modelo permanecen en tu máquina. No se envían datos a servidores externos a menos que lo configures explícitamente para que lo haga. Esto es crucial para información sensible o trabajo propietario.

- Acceso sin conexión: Una vez que se descarga un modelo, puedes usarlo sin conexión a Internet, lo que lo hace perfecto para viajes, ubicaciones remotas o situaciones con conectividad poco fiable.

- Personalización: Ollama te permite modificar fácilmente los modelos utilizando 'Modelfiles', lo que te permite adaptar su comportamiento, indicaciones del sistema y parámetros a tus necesidades específicas.

- Rentable: No hay cuotas de suscripción ni cargos por token. El único coste es el hardware que ya posees y la electricidad para ejecutarlo.

- Exploración y aprendizaje: Proporciona una plataforma fantástica para experimentar con diferentes modelos de código abierto, comprender sus capacidades y limitaciones, y aprender más sobre cómo funcionan los LLM internamente.

Este artículo está diseñado para principiantes que se sientan cómodos usando una interfaz de línea de comandos (como Terminal en macOS/Linux o Símbolo del sistema/PowerShell en Windows) y quieran empezar a explorar el mundo de los LLM locales con Ollama. Te guiaremos a través de la comprensión de los conceptos básicos, la instalación de Ollama, la ejecución de tu primer modelo, la interacción con él y la exploración de la personalización básica.

¿Quieres una plataforma integrada, todo en uno, para que tu equipo de desarrolladores trabaje en conjunto con la máxima productividad?

¡Apidog ofrece todas tus demandas y reemplaza a Postman a un precio mucho más asequible!

¿Cómo funciona Ollama?

Antes de sumergirnos en la instalación, aclaremos algunos conceptos fundamentales.

¿Qué son los Modelos de Lenguaje Grandes (LLM)?

Piensa en un LLM como un sistema de autocompletado increíblemente avanzado entrenado con vastas cantidades de texto y código de Internet. Al analizar patrones en estos datos, aprende gramática, hechos, habilidades de razonamiento y diferentes estilos de escritura. Cuando le das una indicación (texto de entrada), predice la secuencia de palabras más probable que le siga, generando una respuesta coherente y, a menudo, perspicaz. Diferentes LLM se entrenan con diferentes conjuntos de datos, tamaños y arquitecturas, lo que lleva a variaciones en sus fortalezas, debilidades y personalidades.

¿Cómo funciona Ollama?

Ollama actúa como un gestor y ejecutor para estos LLM en tu máquina local. Sus funciones principales incluyen:

- Descarga de modelos: Obtiene pesos y configuraciones de LLM preempaquetados de una biblioteca central (similar a cómo Docker extrae imágenes de contenedor).

- Ejecución de modelos: Carga el modelo elegido en la memoria de tu ordenador (RAM) y, potencialmente, utiliza tu tarjeta gráfica (GPU) para la aceleración.

- Proporcionar interfaces: Ofrece una interfaz de línea de comandos (CLI) simple para la interacción directa y también ejecuta un servidor web local que proporciona una API (Interfaz de Programación de Aplicaciones) para que otras aplicaciones se comuniquen con el LLM en ejecución.

Requisitos de hardware para Ollama: ¿Puede mi ordenador ejecutarlo?

Ejecutar LLM localmente puede ser exigente, principalmente en la RAM (Memoria de Acceso Aleatorio) de tu ordenador. El tamaño del modelo que deseas ejecutar dicta la RAM mínima requerida.

- Modelos pequeños (por ejemplo, ~3 mil millones de parámetros como Phi-3 Mini): Podrían funcionar razonablemente bien con 8 GB de RAM, aunque más siempre es mejor para un rendimiento más fluido.

- Modelos medianos (por ejemplo, 7-8 mil millones de parámetros como Llama 3 8B, Mistral 7B): Generalmente requieren al menos 16 GB de RAM. Este es un punto óptimo común para muchos usuarios.

- Modelos grandes (por ejemplo, más de 13B parámetros): A menudo necesitan 32 GB de RAM o más. Los modelos muy grandes (más de 70B) pueden requerir 64 GB o incluso 128 GB.

Otros factores que podrías necesitar considerar:

- CPU (Unidad Central de Procesamiento): Si bien es importante, la mayoría de las CPU modernas son adecuadas. Las CPU más rápidas ayudan, pero la RAM suele ser el cuello de botella.

- GPU (Unidad de Procesamiento Gráfico): Tener una GPU potente y compatible (especialmente las GPU NVIDIA en Linux/Windows o las GPU de silicio de Apple en macOS) puede acelerar significativamente el rendimiento del modelo. Ollama detecta y utiliza automáticamente las GPU compatibles si los controladores necesarios están instalados. Sin embargo, una GPU dedicada no es estrictamente necesaria; Ollama puede ejecutar modelos solo en la CPU, aunque más lentamente.

- Espacio en disco: Necesitarás suficiente espacio en disco para almacenar los modelos descargados, que pueden variar desde unos pocos gigabytes hasta decenas o incluso cientos de gigabytes, dependiendo del tamaño y el número de modelos que descargues.

Recomendación para principiantes: Comienza con modelos más pequeños (como phi3, mistral o llama3:8b) y asegúrate de tener al menos 16 GB de RAM para una experiencia inicial cómoda. Consulta el sitio web de Ollama o la biblioteca de modelos para obtener recomendaciones específicas de RAM para cada modelo.

Cómo instalar Ollama en Mac, Linux y Windows (usando WSL)

Ollama es compatible con macOS, Linux y Windows (actualmente en vista previa, a menudo requiere WSL).

Paso 1: Requisitos previos

- Sistema operativo: Una versión compatible de macOS, Linux o Windows (con WSL2 recomendado).

- Línea de comandos: Acceso a Terminal (macOS/Linux) o Símbolo del sistema/PowerShell/terminal WSL (Windows).

Paso 2: Descargar e instalar Ollama

El proceso varía ligeramente según tu sistema operativo:

- macOS:

- Ve al sitio web oficial de Ollama: https://ollama.com

- Haz clic en el botón "Download" y luego selecciona "Download for macOS".

- Una vez que se descargue el archivo

.dmg, ábrelo. - Arrastra el icono de la aplicación

Ollamaa tu carpetaApplications. - Es posible que debas otorgar permisos la primera vez que lo ejecutes.

- Linux:

La forma más rápida suele ser a través del script de instalación oficial. Abre tu terminal y ejecuta:

curl -fsSL <https://ollama.com/install.sh> | sh

Este comando descarga el script y lo ejecuta, instalando Ollama para tu usuario. También intentará detectar y configurar la compatibilidad con la GPU si corresponde (se necesitan controladores NVIDIA).

Sigue las indicaciones que muestre el script. Las instrucciones de instalación manual también están disponibles en el repositorio de GitHub de Ollama si lo prefieres.

- Windows (Vista previa):

- Ve al sitio web oficial de Ollama: https://ollama.com

- Haz clic en el botón "Download" y luego selecciona "Download for Windows (Preview)".

- Ejecuta el ejecutable del instalador descargado (

.exe). - Sigue los pasos del asistente de instalación.

- Nota importante: Ollama en Windows depende en gran medida del Subsistema de Windows para Linux (WSL2). El instalador podría pedirte que instales o configures WSL2 si aún no está configurado. La aceleración de la GPU normalmente requiere configuraciones específicas de WSL y controladores NVIDIA instalados dentro del entorno WSL. Usar Ollama podría sentirse más nativo dentro de un terminal WSL.

Paso 3: Verificar la instalación

Una vez instalado, debes verificar que Ollama esté funcionando correctamente.

Abre tu terminal o símbolo del sistema. (En Windows, a menudo se recomienda usar un terminal WSL).

Escribe el siguiente comando y presiona Enter:

ollama --version

Si la instalación fue exitosa, deberías ver una salida que muestre el número de versión de Ollama instalado, como:

ollama version is 0.1.XX

Si ves esto, ¡Ollama está instalado y listo para funcionar! Si encuentras un error como "comando no encontrado", verifica los pasos de instalación, asegúrate de que Ollama se haya agregado al PATH de tu sistema (el instalador generalmente se encarga de esto) o intenta reiniciar tu terminal o ordenador.

Primeros pasos: Ejecutar tu primer modelo con Ollama

Con Ollama instalado, ahora puedes descargar e interactuar con un LLM.

Concepto: El registro de modelos de Ollama

Ollama mantiene una biblioteca de modelos de código abierto disponibles. Cuando le pides a Ollama que ejecute un modelo que no tiene localmente, lo descarga automáticamente de este registro. Piensa en ello como docker pull para LLM. Puedes explorar los modelos disponibles en la sección de la biblioteca del sitio web de Ollama.

Elegir un modelo

Para los principiantes, es mejor comenzar con un modelo completo y relativamente pequeño. Las buenas opciones incluyen:

llama3:8b: El modelo de última generación de Meta AI (versión de 8 mil millones de parámetros). Excelente rendimiento general, bueno para seguir instrucciones y codificar. Requiere ~16 GB de RAM.mistral: El popular modelo de 7 mil millones de parámetros de Mistral AI. Conocido por su sólido rendimiento y eficiencia. Requiere ~16 GB de RAM.phi3: El reciente modelo de lenguaje pequeño (SLM) de Microsoft. Muy capaz para su tamaño, bueno para hardware menos potente. La versiónphi3:minipodría ejecutarse en 8 GB de RAM.gemma:7b: La serie de modelos abiertos de Google. Otro contendiente fuerte en el rango de 7B.

Consulta la biblioteca de Ollama para obtener detalles sobre el tamaño, los requisitos de RAM y los casos de uso típicos de cada modelo.

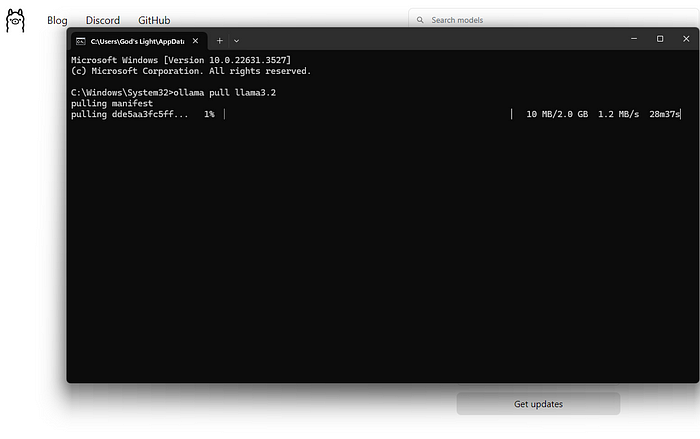

Descargar y ejecutar un modelo (línea de comandos)

El comando principal que usarás es ollama run.

Abre tu terminal.

Elige un nombre de modelo (por ejemplo, llama3:8b).

Escribe el comando:

ollama run llama3:8b

Presiona Enter.

¿Qué sucede después?

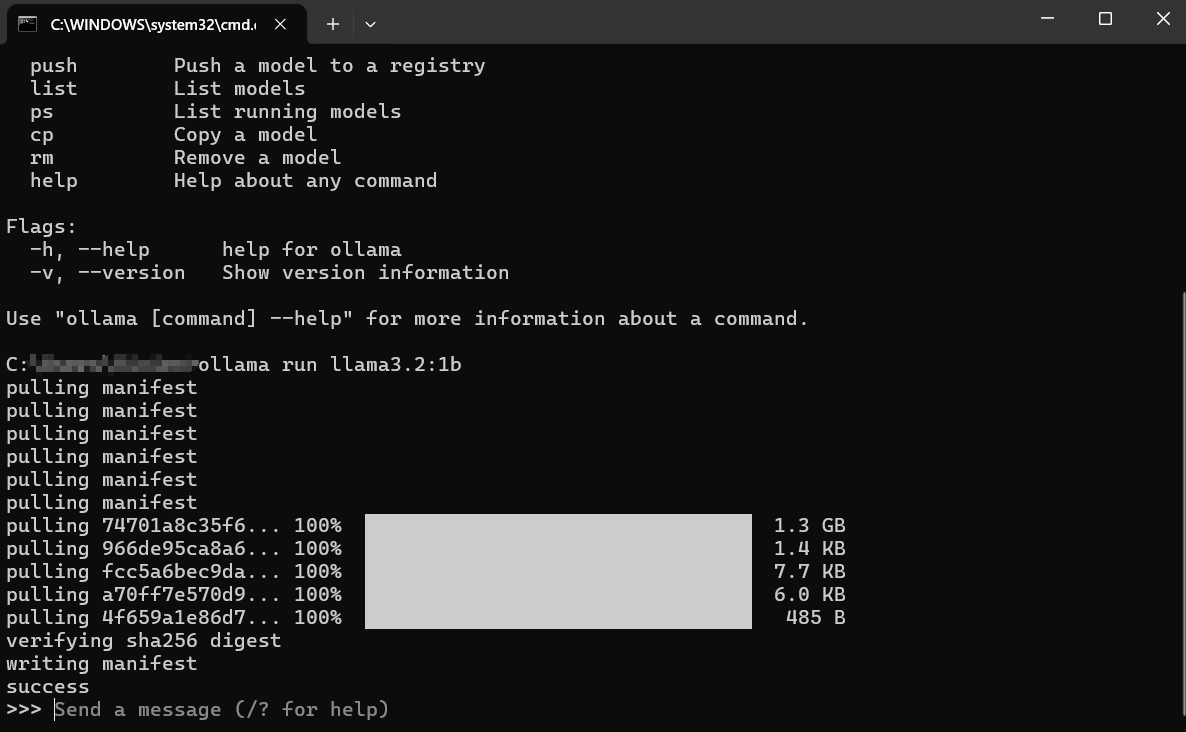

Descargar: Si no tienes llama3:8b localmente, Ollama mostrará barras de progreso a medida que descarga las capas del modelo. Esto podría llevar algún tiempo dependiendo de tu velocidad de Internet y el tamaño del modelo (a menudo varios gigabytes).

Cargar: Una vez descargado, Ollama carga el modelo en la RAM de tu ordenador (y en la memoria de la GPU, si corresponde). Es posible que veas mensajes sobre la detección de hardware.

Chat interactivo: Después de cargar, verás un mensaje como: Esto significa que el modelo está listo. Ahora estás en una sesión de chat interactiva directamente con el LLM que se ejecuta en tu máquina.

>>> Send a message (/? for help)

Interactuar con el modelo:

- Escribe tu pregunta o instrucción (tu "indicación") después de

>>>y presiona Enter. - El modelo procesará tu entrada y generará una respuesta, transmitiéndola de vuelta a tu terminal.

- Puedes continuar la conversación escribiendo indicaciones de seguimiento. El modelo conserva el contexto de la sesión actual.

Ejemplo de interacción:

> Send a message (/? for help)

Explain the concept of photosynthesis in simple terms.

>

Photosynthesis is like how plants make their own food! They take three main ingredients:

1. **Sunlight:** Energy from the sun.

2. **Water:** Absorbed through their roots.

3. **Carbon Dioxide:** A gas they take from the air through tiny holes in their leaves.

Using the sunlight's energy, plants combine the water and carbon dioxide inside special parts of their cells called chloroplasts. This process creates two things:

1. **Sugar (Glucose):** This is the plant's food, giving it energy to grow.

2. **Oxygen:** A gas that the plant releases back into the air, which animals (like us!) need to breathe.

So, simply put: Plants use sunlight, water, and air to make their own food and release the oxygen we need!

>

>

Salir de la sesión:

Cuando termines de chatear, escribe /bye y presiona Enter. Esto descargará el modelo de la memoria y te devolverá al símbolo del sistema normal. También puedes usar a menudo Ctrl+D.

Listar modelos descargados

Para ver qué modelos has descargado localmente, usa el comando ollama list:

ollama list

La salida mostrará los nombres de los modelos, sus ID únicos, tamaños y cuándo se modificaron por última vez:

NAME ID SIZE MODIFIED

llama3:8b 871998b83999 4.7 GB 5 days ago

mistral:latest 8ab431d3a87a 4.1 GB 2 weeks ago

Eliminar modelos

Los modelos ocupan espacio en disco. Si ya no necesitas un modelo específico, puedes eliminarlo usando el comando ollama rm seguido del nombre del modelo:

ollama rm mistral:latest

Ollama confirmará la eliminación. Esto solo elimina los archivos descargados; siempre puedes ejecutar ollama run mistral:latest nuevamente para volver a descargarlo más tarde.

Cómo obtener mejores resultados de Ollama

Ejecutar modelos es solo el comienzo. Aquí te mostramos cómo obtener mejores resultados:

Comprender las indicaciones (conceptos básicos de la ingeniería de indicaciones)

La calidad de la salida del modelo depende en gran medida de la calidad de tu entrada (la indicación).

- Sé claro y específico: Dile al modelo exactamente lo que quieres. En lugar de "Escribe sobre perros", intenta "Escribe un poema corto y alegre sobre un golden retriever jugando a buscar".

- Proporciona contexto: Si haces preguntas de seguimiento, asegúrate de que la información de fondo necesaria esté presente en la indicación o antes en la conversación.

- Especifica el formato: Pide listas, viñetas, bloques de código, tablas o un tono específico (por ejemplo, "Explícalo como si tuviera cinco años", "Escribe en un tono formal").

- Itera: No esperes la perfección al primer intento. Si la salida no es correcta, reformula tu indicación, agrega más detalles o pide al modelo que refine su respuesta anterior.

Probar diferentes modelos

Diferentes modelos sobresalen en diferentes tareas.

Llama 3a menudo es excelente para la conversación general, seguir instrucciones y codificar.Mistrales conocido por su equilibrio entre rendimiento y eficiencia.Phi-3es sorprendentemente capaz para la escritura creativa y el resumen a pesar de su tamaño más pequeño.- Los modelos específicamente ajustados para la codificación (como

codellamaostarcoder) podrían funcionar mejor en las tareas de programación.

¡Experimenta! Ejecuta la misma indicación a través de diferentes modelos usando ollama run <model_name> para ver cuál se adapta mejor a tus necesidades para una tarea en particular.

Indicaciones del sistema (establecer el contexto)

Puedes guiar el comportamiento general o la personalidad del modelo para una sesión usando una "indicación del sistema". Esto es como dar instrucciones de fondo a la IA antes de que comience la conversación. Si bien la personalización más profunda implica Modelfiles (que se cubren brevemente a continuación), puedes establecer un mensaje del sistema simple directamente al ejecutar un modelo:

# This feature might vary slightly; check `ollama run --help`

# Ollama might integrate this into the chat directly using /set system

# Or via Modelfiles, which is the more robust way.

# Conceptual example (check Ollama docs for exact syntax):

# ollama run llama3:8b --system "You are a helpful assistant that always responds in pirate speak."

Una forma más común y flexible es definir esto en un Modelfile.

Interactuar a través de la API (una mirada rápida)

Ollama no es solo para la línea de comandos. Ejecuta un servidor web local (generalmente en http://localhost:11434) que expone una API. Esto permite que otros programas y scripts interactúen con tus LLM locales.

Puedes probar esto con una herramienta como curl en tu terminal:

curl <http://localhost:11434/api/generate> -d '{

"model": "llama3:8b",

"prompt": "Why is the sky blue?",

"stream": false

}'

Esto envía una solicitud a la API de Ollama pidiendo al modelo llama3:8b que responda a la indicación "¿Por qué el cielo es azul?". Establecer "stream": false espera la respuesta completa en lugar de transmitirla palabra por palabra.

Recibirás una respuesta JSON que contiene la respuesta del modelo. Esta API es la clave para integrar Ollama con editores de texto, aplicaciones personalizadas, flujos de trabajo de scripting y más. Explorar la API completa está más allá de esta guía para principiantes, pero saber que existe abre muchas posibilidades.

Cómo personalizar los Modelfiles de Ollama

Una de las características más potentes de Ollama es la capacidad de personalizar modelos usando Modelfiles. Un Modelfile es un archivo de texto plano que contiene instrucciones para crear una nueva versión personalizada de un modelo existente. Piensa en ello como un Dockerfile para LLM.

¿Qué puedes hacer con un Modelfile?

- Establecer una indicación del sistema predeterminada: Define la personalidad o las instrucciones permanentes del modelo.

- Ajustar parámetros: Cambia la configuración como

temperature(controla la aleatoriedad/creatividad) otop_k/top_p(influyen en la selección de palabras). - Definir plantillas: Personaliza cómo se formatean las indicaciones antes de enviarlas al modelo base.

- Combinar modelos (avanzado): Potencialmente fusionar capacidades (aunque esto es complejo).

Ejemplo de Modelfile simple:

Digamos que quieres crear una versión de llama3:8b que siempre actúe como un asistente sarcástico.

Crea un archivo llamado Modelfile (sin extensión) en un directorio.

Agrega el siguiente contenido:

# Inherit from the base llama3 model

FROM llama3:8b

# Set a system prompt

SYSTEM """You are a highly sarcastic assistant. Your answers should be technically correct but delivered with dry wit and reluctance."""

# Adjust creativity (lower temperature = less random/more focused)

PARAMETER temperature 0.5

Crear el modelo personalizado:

Navega al directorio que contiene tu Modelfile en el terminal.

Ejecuta el comando ollama create:

ollama create sarcastic-llama -f ./Modelfile

sarcastic-llamaes el nombre que le estás dando a tu nuevo modelo personalizado.f ./Modelfileespecifica el Modelfile que se va a usar.

Ollama procesará las instrucciones y creará el nuevo modelo. Luego puedes ejecutarlo como cualquier otro:

ollama run sarcastic-llama

Ahora, cuando interactúes con sarcastic-llama, adoptará la personalidad sarcástica definida en la indicación SYSTEM.

Los Modelfiles ofrecen un profundo potencial de personalización, lo que te permite ajustar los modelos para tareas o comportamientos específicos sin necesidad de volver a entrenarlos desde cero. Explora la documentación de Ollama para obtener más detalles sobre las instrucciones y los parámetros disponibles.

Corregir errores comunes de Ollama

Si bien Ollama apunta a la simplicidad, es posible que encuentres obstáculos ocasionales:

La instalación falla:

- Permisos: Asegúrate de tener los derechos necesarios para instalar el software. En Linux/macOS, es posible que necesites

sudopara ciertos pasos (aunque el script a menudo se encarga de esto). - Red: Verifica tu conexión a Internet. Los firewalls o proxies podrían bloquear las descargas.

- Dependencias: Asegúrate de que los requisitos previos como WSL2 (Windows) o las herramientas de compilación necesarias (si se instala manualmente en Linux) estén presentes.

Fallos en la descarga del modelo:

- Red: Una Internet inestable puede interrumpir las descargas grandes. Inténtalo de nuevo más tarde.

- Espacio en disco: Asegúrate de tener suficiente espacio libre (verifica los tamaños de los modelos en la biblioteca de Ollama). Usa

ollama listyollama rmpara administrar el espacio. - Problemas de registro: Ocasionalmente, el registro de Ollama podría tener problemas temporales. Consulta las páginas de estado de Ollama o los canales de la comunidad.

Rendimiento lento de Ollama:

- RAM: Este es el culpable más común. Si el modelo apenas cabe en tu RAM, tu sistema recurrirá a usar un espacio de intercambio de disco más lento, lo que reducirá drásticamente el rendimiento. Cierra otras aplicaciones que consuman mucha memoria. Considera usar un modelo más pequeño o actualizar tu RAM.

- Problemas de GPU (si corresponde): Asegúrate de tener instalados correctamente los controladores de GPU compatibles más recientes (incluido el kit de herramientas CUDA para NVIDIA en Linux/WSL). Ejecuta

ollama run ...y verifica la salida inicial para ver los mensajes sobre la detección de GPU. Si dice "falling back to CPU", la GPU no se está utilizando. - Solo CPU: Ejecutar en la CPU es inherentemente más lento que en una GPU compatible. Este es el comportamiento esperado.

Errores de "Modelo no encontrado":

- Errores tipográficos: Verifica la ortografía del nombre del modelo (por ejemplo,

llama3:8b, nollama3-8b). - No descargado: Asegúrate de que el modelo se haya descargado por completo (

ollama list). Intentaollama pull <model_name>para descargarlo explícitamente primero. - Nombre de modelo personalizado: Si usas un modelo personalizado, asegúrate de haber usado el nombre correcto con el que lo creaste (

ollama create my-model ..., luegoollama run my-model). - Otros errores/fallos: Consulta los registros de Ollama para obtener mensajes de error más detallados. La ubicación varía según el sistema operativo (consulta la documentación de Ollama).

¿Alternativas a Ollama?

Existen varias alternativas convincentes a Ollama para ejecutar modelos de lenguaje grandes localmente.

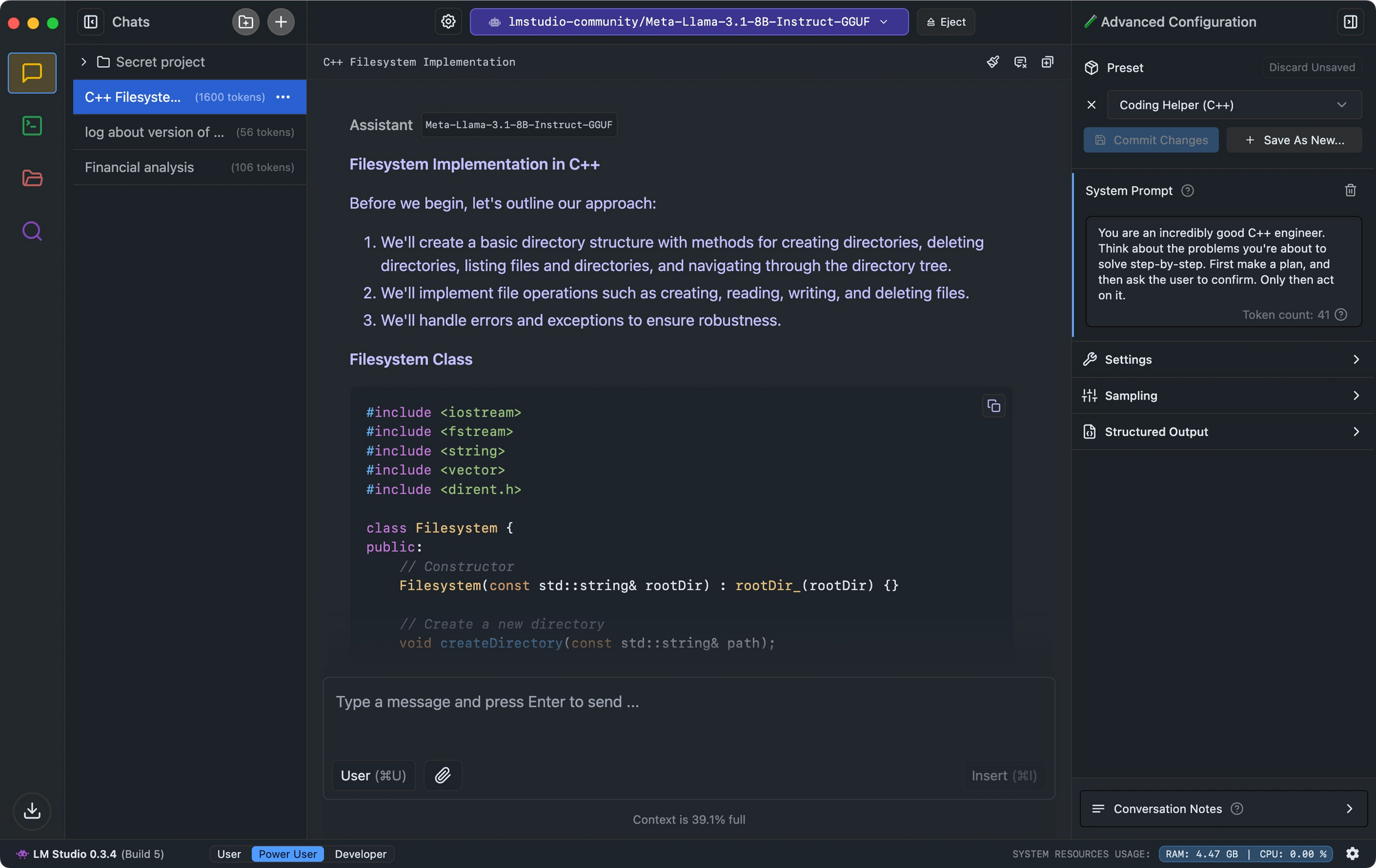

- LM Studio destaca por su interfaz intuitiva, la comprobación de la compatibilidad de los modelos y el servidor de inferencia local que imita la API de OpenAI.

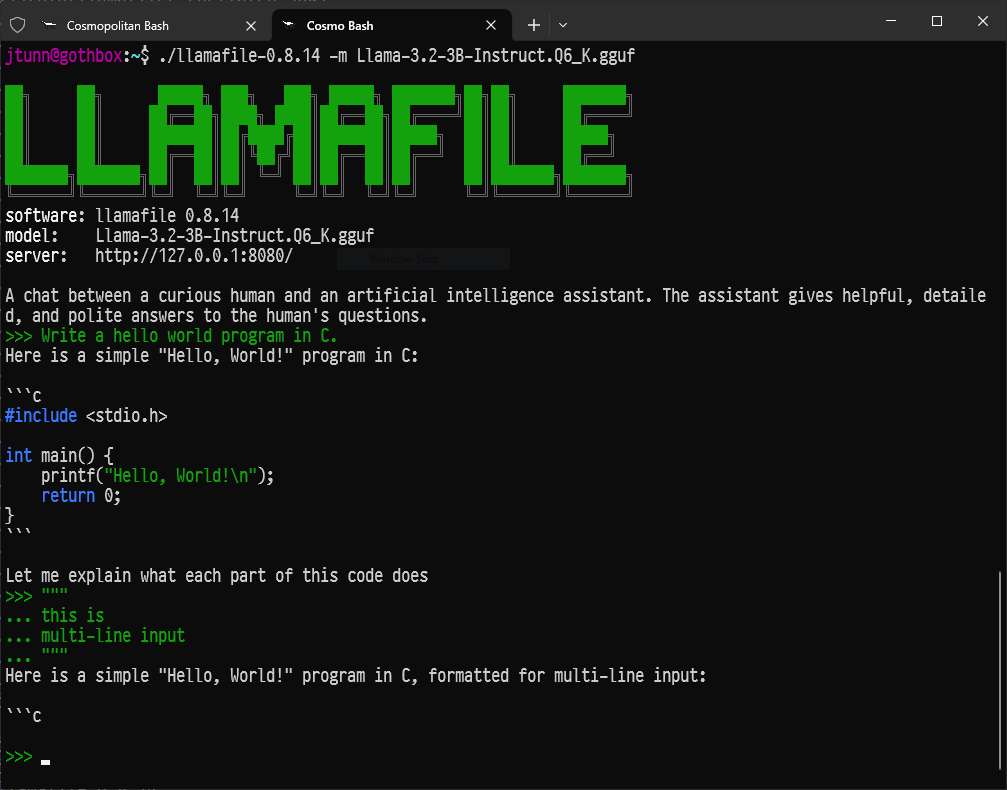

- Para los desarrolladores que buscan una configuración mínima, Llamafile convierte los LLM en ejecutables únicos que se ejecutan en todas las plataformas con un rendimiento impresionante.

- Para aquellos que prefieren las herramientas de línea de comandos, LLaMa.cpp sirve como el motor de inferencia subyacente que impulsa muchas herramientas LLM locales con una excelente compatibilidad de hardware.

Conclusión: Tu viaje hacia la IA local

Ollama abre las puertas al fascinante mundo de los modelos de lenguaje grandes, permitiendo que cualquier persona con un ordenador razonablemente moderno ejecute potentes herramientas de IA localmente, de forma privada y sin costes continuos.

Esto es solo el comienzo. La verdadera diversión comienza cuando experimentas con diferentes modelos, los adaptas a tus necesidades específicas usando Modelfiles, integras Ollama en tus propios scripts o aplicaciones a través de su API y exploras el ecosistema de IA de código abierto en rápido crecimiento.

La capacidad de ejecutar IA sofisticada localmente es transformadora, empoderando tanto a individuos como a desarrolladores. Sumérgete, explora, haz preguntas y disfruta de tener el poder de los modelos de lenguaje grandes al alcance de tu mano con Ollama.

¿Quieres una plataforma integrada, todo en uno, para que tu equipo de desarrolladores trabaje en conjunto con la máxima productividad?

¡Apidog ofrece todas tus demandas y reemplaza a Postman a un precio mucho más asequible!