OpenAI avanza en las capacidades de inteligencia artificial al introducir gpt-realtime junto con mejoras significativas en la API Realtime. Este desarrollo está dirigido a desarrolladores que crean aplicaciones de voz interactivas, ofreciendo procesamiento directo de voz a voz que captura matices como el tono y las señales no verbales. Los ingenieros ahora acceden a un modelo que procesa entradas de audio y genera respuestas con baja latencia, marcando un cambio en cómo la IA maneja las conversaciones en tiempo real.

Además, esta actualización se alinea con la creciente demanda de sistemas de IA multimodales. Los desarrolladores integran audio, texto e imágenes sin problemas, ampliando las posibilidades para aplicaciones en servicio al cliente, asistentes virtuales y entretenimiento interactivo. A medida que exploramos estos avances, considera cómo los pequeños refinamientos en el diseño de la API conducen a mejoras sustanciales en la experiencia del usuario.

Comprendiendo GPT-Realtime: El Modelo Central

OpenAI lanza gpt-realtime como un modelo especializado diseñado para interacciones de voz a voz de extremo a extremo. Este modelo elimina los pipelines tradicionales que separan el reconocimiento de voz, el procesamiento del lenguaje y la síntesis de texto a voz. En su lugar, maneja todo en un marco unificado, reduciendo la latencia y preservando las sutilezas del habla humana.

gpt-realtime sobresale en la generación de salidas de audio de sonido natural. Por ejemplo, responde a instrucciones como "habla rápido y profesionalmente" o "adopta un tono empático con acento francés". Este control de grano fino permite a los desarrolladores adaptar las voces de IA a escenarios específicos, mejorando la interacción en aplicaciones del mundo real.

Además, el modelo demuestra una inteligencia superior en el procesamiento de entradas de audio nativas. Detecta elementos no verbales, como risas o pausas, y se adapta en consecuencia. Si un usuario cambia de idioma a mitad de frase, gpt-realtime lo sigue sin interrupción.

Esta capacidad proviene de un entrenamiento avanzado en diversos conjuntos de datos, lo que le permite obtener una puntuación del 30.5% en el benchmark de audio MultiChallenge, una mejora notable respecto a iteraciones anteriores.

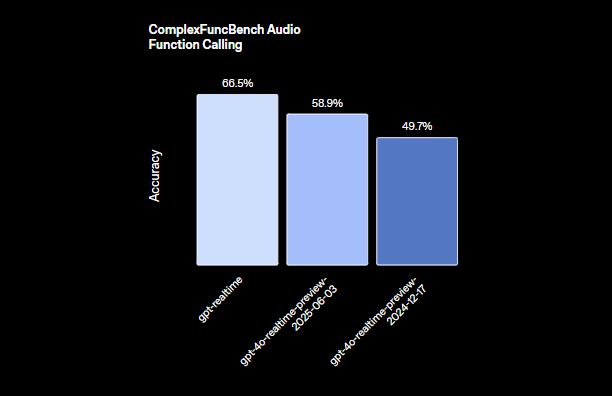

Los ingenieros aprecian cómo gpt-realtime integra la llamada a funciones. Con una puntuación del 66.5% en ComplexFuncBench, ejecuta herramientas de forma asíncrona, asegurando que las conversaciones se mantengan fluidas incluso durante cálculos prolongados. Por ejemplo, mientras la IA procesa una consulta de base de datos, continúa interactuando con el usuario con respuestas de relleno o actualizaciones.

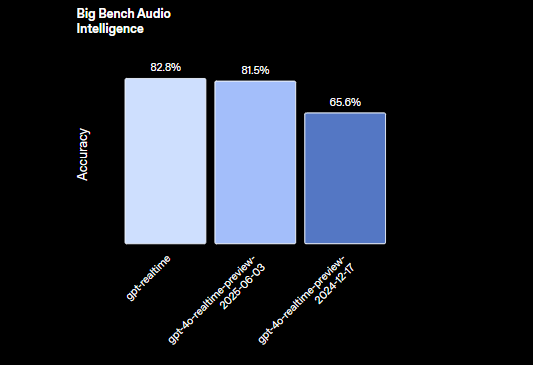

Además, gpt-realtime soporta tareas de razonamiento con un 82.8% de precisión en la evaluación Big Bench Audio. Esto le permite manejar consultas complejas que implican deducción lógica directamente desde entradas de audio, obviando por completo la conversión de texto.

OpenAI presenta dos nuevas voces, Marin y Cedar, exclusivas de este modelo, junto con actualizaciones a ocho voces existentes para salidas más expresivas. Estas mejoras aseguran que las interacciones de IA se sientan más humanas, cerrando la brecha entre las respuestas programadas y el diálogo genuino.

Transitando a las implicaciones prácticas, los desarrolladores aprovechan gpt-realtime para construir aplicaciones que responden en tiempo real, como servicios de traducción en vivo o herramientas interactivas de narración. La eficiencia del modelo minimiza la sobrecarga computacional, haciéndolo adecuado para su implementación en dispositivos de borde o infraestructuras en la nube.

Características Clave de la API Realtime

La API Realtime recibe actualizaciones sustanciales, complementando las capacidades de gpt-realtime. OpenAI la equipa con características que facilitan agentes de voz listos para producción, centrándose en la fiabilidad, escalabilidad y facilidad de integración.

Primero, destaca el soporte para servidores remotos MCP (Multi-Cloud Provider). Los desarrolladores configuran servidores externos para llamadas a herramientas, como la integración con Stripe para pagos. Esta configuración simplifica los flujos de trabajo al descargar funciones específicas a servicios especializados. Se especifica la URL del servidor, los tokens de autorización y los requisitos de aprobación directamente en la sesión de la API.A continuación, la funcionalidad de entrada de imágenes amplía el alcance multimodal de la API. Las aplicaciones añaden imágenes, fotos o capturas de pantalla a las sesiones en curso, permitiendo conversaciones visualmente fundamentadas. Por ejemplo, un usuario sube un diagrama, y la IA lo describe o responde preguntas sobre su contenido. Esta característica trata las imágenes como elementos estáticos, controlados por la lógica de la aplicación para mantener el contexto.

Además, el soporte SIP (Session Initiation Protocol) conecta la API a redes telefónicas públicas, sistemas PBX y teléfonos de escritorio. Esto une la IA digital con la telefonía tradicional, permitiendo que los agentes de voz manejen llamadas desde teléfonos fijos o móviles sin problemas.

Los prompts reutilizables representan otra adición clave. Los desarrolladores guardan y reutilizan mensajes de desarrollador, herramientas, variables y ejemplos en múltiples sesiones. Esto promueve la consistencia y reduce el tiempo de configuración para interacciones recurrentes, como scripts estándar de soporte al cliente.

La API se optimiza para interacciones de baja latencia, asegurando una alta fiabilidad en entornos de producción. Procesa entradas multimodales (audio e imágenes) mientras mantiene el estado de la sesión, lo que evita la pérdida de contexto en conversaciones extendidas.

En términos de manejo de audio, la API Realtime interactúa directamente con gpt-realtime para generar habla expresiva. Captura matices que los sistemas tradicionales a menudo descartan, lo que lleva a experiencias de usuario más atractivas.

Los desarrolladores también se benefician de características de nivel empresarial, incluida la Residencia de Datos de la UE para el cumplimiento y compromisos de privacidad que salvaguardan los datos sensibles.

Cambiando el enfoque a las métricas de rendimiento, estas actualizaciones mejoran colectivamente la utilidad de la API. Por ejemplo, la llamada a funciones asíncrona previene cuellos de botella, permitiendo que la IA realice múltiples tareas sin interrumpir el flujo.

Cómo Usar la API GPT-Realtime: Una Guía Paso a Paso

Los desarrolladores integran la API gpt-realtime a través de endpoints y configuraciones sencillas. Comienza obteniendo las claves API de la plataforma OpenAI, asegurándote de que tu cuenta sea compatible con la API Realtime.

Para iniciar una sesión, envía una solicitud POST para crear un secreto de cliente en tiempo real. Incluye parámetros de sesión como herramientas y tipos. Para la integración remota de MCP, estructura el payload de la siguiente manera:

// POST /v1/realtime/client_secrets

{

"session": {

"type": "realtime",

"tools": [

{

"type": "mcp",

"server_label": "stripe",

"server_url": "https://mcp.stripe.com",

"authorization": "{access_token}",

"require_approval": "never"

}

]

}

}

Este código configura una herramienta para pagos de Stripe, donde la API enruta las llamadas al servidor especificado sin necesidad de aprobación del usuario cada vez.

Una vez que la sesión comienza, maneja las interacciones en tiempo real a través de conexiones WebSocket. Establece un WebSocket al endpoint de la API Realtime, enviando flujos de audio como datos binarios. La API procesa las entradas y devuelve las salidas de audio en tiempo real.

Para la entrada de audio, codifica el habla del usuario y transmítela. gpt-realtime analiza el audio, generando respuestas basadas en el contexto de la sesión. Para incorporar imágenes, usa el evento de creación de elementos de conversación:

{

"type": "conversation.item.create",

"previous_item_id": null,

"item": {

"type": "message",

"role": "user",

"content": [

{

"type": "input_image",

"image_url": "data:image/png;base64,{base64_image_data}"

}

]

}

}

Reemplaza {base64_image_data} con los datos de imagen codificados en base64 reales. Esto añade contexto visual, permitiendo que la IA lo referencie en las respuestas.

Gestiona el estado de la sesión configurando límites de tokens y truncando turnos antiguos para controlar los costos. Para conversaciones largas, borra periódicamente el historial innecesario mientras conservas los detalles clave.

Para manejar las llamadas a funciones, define herramientas en la configuración de la sesión. Cuando la IA invoca una función, la API la ejecuta de forma asíncrona, enviando actualizaciones provisionales para mantener la conversación activa.

Para la integración SIP, configura tu aplicación para enrutar llamadas a través de gateways compatibles. Esto implica configurar troncales SIP y vincularlos a las sesiones de la API Realtime.

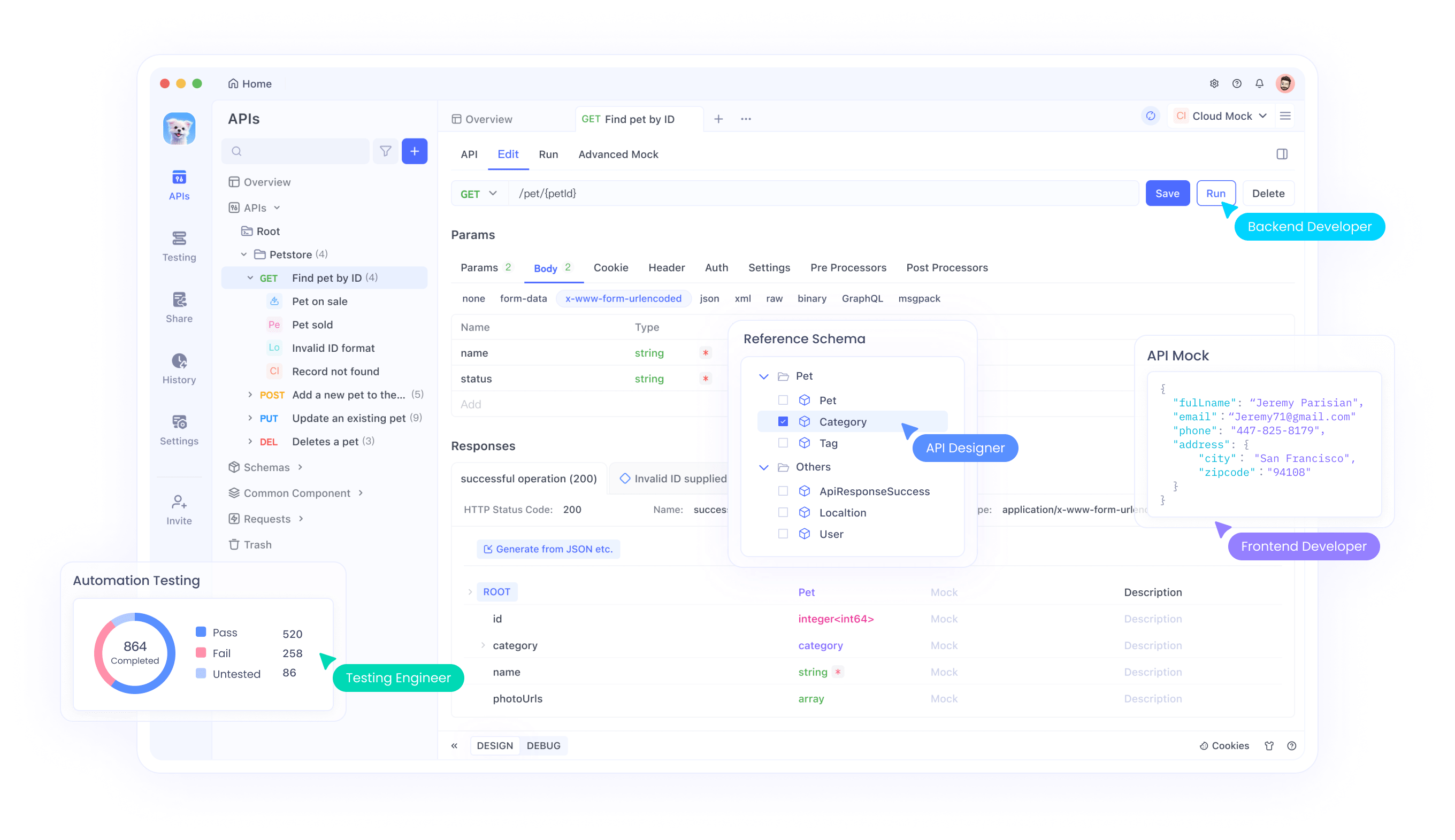

Probar estas integraciones es crucial. Aquí, Apidog brilla como una herramienta de gestión de API. Soporta pruebas de WebSocket, permitiéndote simular intercambios de audio en tiempo real e inspeccionar las respuestas. Descarga Apidog gratis para simular endpoints, validar payloads y asegurar una conectividad perfecta con gpt-realtime.

En la práctica, construye un agente de voz simple combinando estos elementos. Captura la entrada del micrófono, transmítela a la API y reproduce el audio generado. Bibliotecas como WebSocket en JavaScript o el módulo websockets de Python facilitan esto.

Monitorea la latencia midiendo los tiempos de respuesta de ida y vuelta. Las optimizaciones de OpenAI aseguran retrasos de menos de un segundo en la mayoría de los casos, pero las condiciones de la red influyen en el rendimiento.

Maneja los errores de forma elegante, como reintentar conexiones fallidas o recurrir a interacciones basadas en texto si el procesamiento de audio encuentra problemas.

Ampliando esto, incorpora prompts reutilizables. Almacena una plantilla de prompt con instrucciones como "Siempre responde con empatía" y aplícala a nuevas sesiones a través de parámetros de la API.

Para un uso avanzado, combina gpt-realtime con otros modelos de OpenAI. Dirige el razonamiento complejo a GPT-4o mientras usas gpt-realtime para E/S de audio, creando sistemas híbridos.

Las consideraciones de seguridad incluyen cifrar los datos en tránsito y gestionar los tokens de acceso de forma segura. Los compromisos de privacidad de OpenAI ayudan, pero implementa salvaguardas adicionales para aplicaciones sensibles.

Integrando Apidog para una Gestión Eficiente de la API

Apidog emerge como una herramienta vital para los desarrolladores que trabajan con la API gpt-realtime. Esta plataforma ofrece pruebas de API, documentación y funciones de colaboración completas, adaptadas para integraciones complejas como WebSockets en tiempo real.

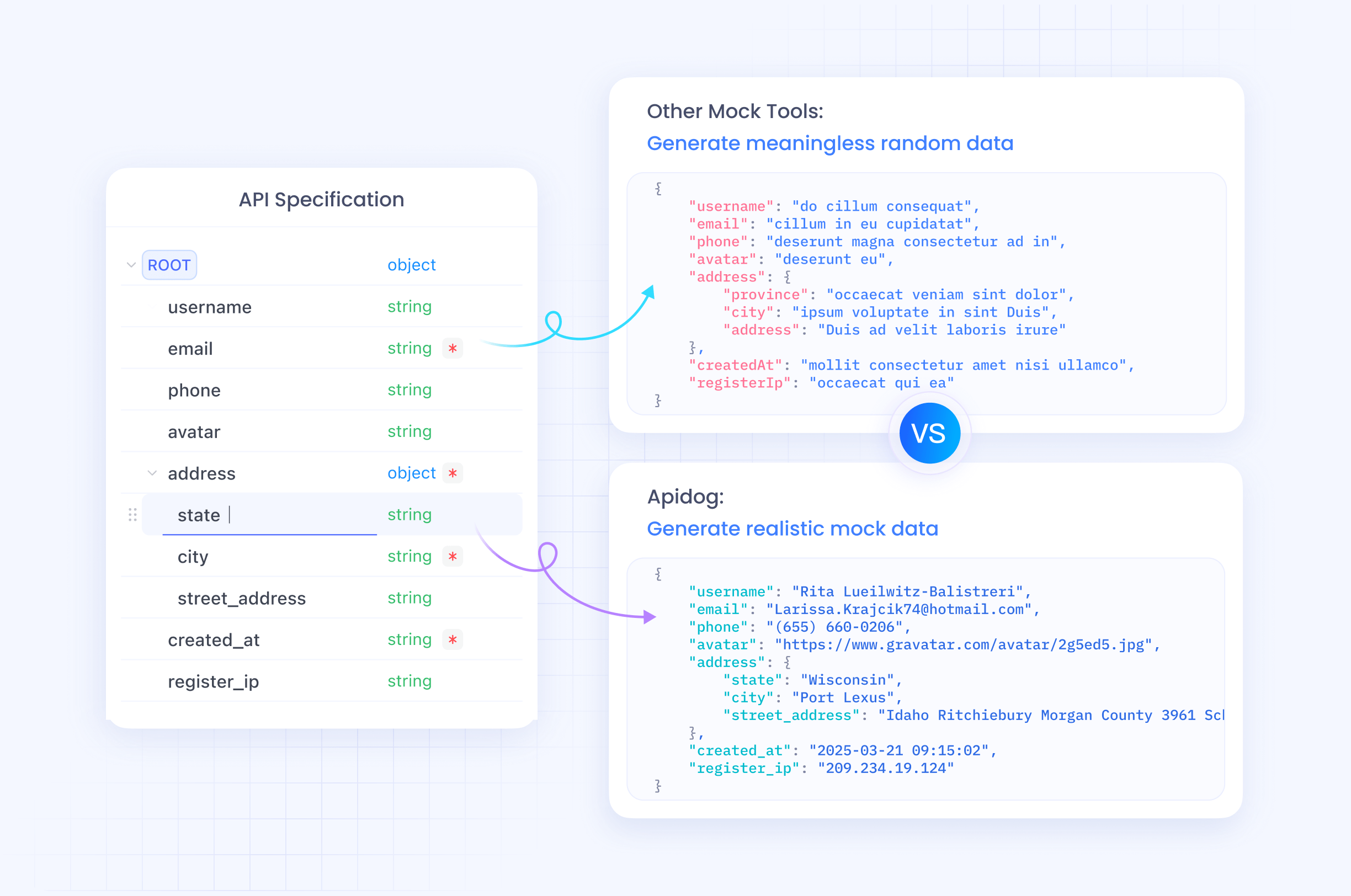

Los ingenieros usan Apidog para diseñar solicitudes de API visualmente, importar especificaciones OpenAPI y ejecutar pruebas automatizadas. Para la API Realtime, simula flujos de audio y verifica entradas multimodales sin escribir código extenso.

Además, las capacidades de mocking de Apidog permiten la creación de prototipos antes de la implementación completa. Crea servidores mock que imitan las respuestas de gpt-realtime, acelerando los ciclos de desarrollo.

La herramienta soporta la colaboración en equipo, compartiendo casos de prueba y entornos. Esto resulta invaluable para equipos distribuidos que construyen agentes de voz.

Dado que Apidog maneja la codificación base64 para imágenes y datos binarios para audio, simplifica la depuración. Rastrea los ciclos de solicitud/respuesta en tiempo real, identificando cuellos de botella tempranamente.

Transitando a la implementación, usa el monitoreo de Apidog para asegurar el tiempo de actividad y el rendimiento de la API después del lanzamiento.

Precios, Disponibilidad e Implicaciones Futuras

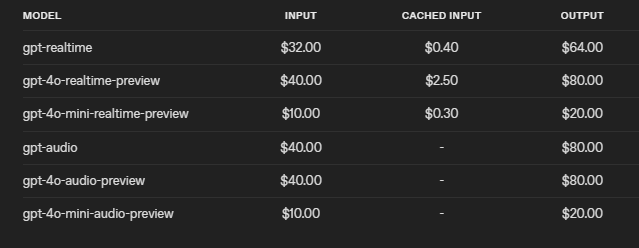

OpenAI establece precios competitivos para gpt-realtime, reduciendo los costos en un 20% respecto a la versión preliminar. Cobra $32 por 1M de tokens de entrada de audio ($0.40 para los cacheados) y $64 por 1M de tokens de salida. Esta estructura fomenta un uso eficiente, con controles para limitar el contexto y truncar sesiones.

La API estará disponible para todos los desarrolladores el 28 de agosto de 2025, con acceso global que incluye las regiones de la UE.

Mirando hacia el futuro, estos avances allanan el camino para la IA de voz ubicua. Industrias como la atención médica la adoptan para las interacciones con pacientes, mientras que la educación la utiliza para tutorías interactivas.

Sin embargo, persisten desafíos, como asegurar el uso ético y mitigar los sesgos en el procesamiento de audio.

En resumen, gpt-realtime y la API Realtime de OpenAI redefinen la IA en tiempo real, ofreciendo herramientas que los desarrolladores aprovechan para aplicaciones innovadoras. Pequeños ajustes en la integración producen ganancias significativas, enfatizando una implementación precisa.