¡Hola, entusiastas de la IA! Abróchense los cinturones porque Open AI acaba de lanzar una bomba con su nuevo modelo de peso abierto, GPT-OSS-120B, y está dando mucho de qué hablar en la comunidad de la IA. Lanzado bajo la licencia Apache 2.0, esta potencia está diseñada para tareas de razonamiento, codificación y agenticas, todo mientras se ejecuta en una sola GPU. En esta guía, profundizaremos en lo que hace especial a GPT-OSS-120B, sus excelentes puntos de referencia, precios asequibles y cómo puedes usarlo a través de la API de OpenRouter. ¡Exploremos esta joya de código abierto y te pondremos a codificar con ella en poco tiempo!

¿Quieres una plataforma integrada y todo en uno para que tu equipo de desarrolladores trabaje junto con máxima productividad?

¡Apidog satisface todas tus demandas y reemplaza a Postman a un precio mucho más asequible!

¿Qué es GPT-OSS-120B?

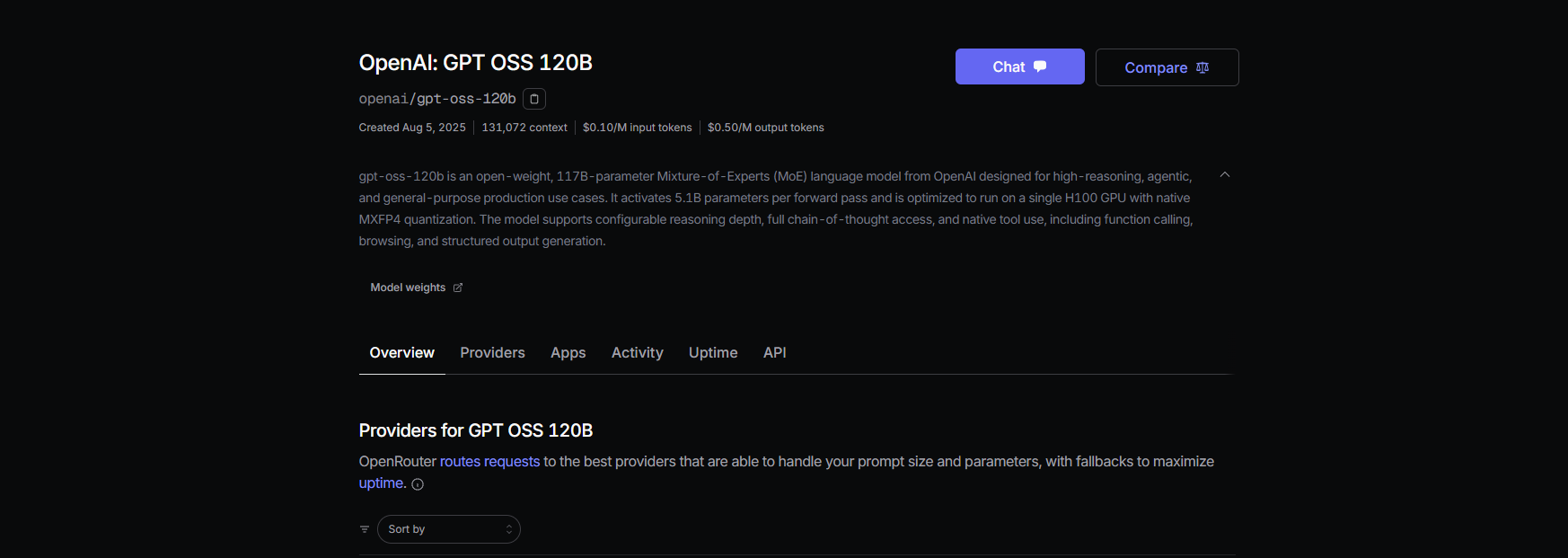

El GPT-OSS-120B de Open AI es un modelo de lenguaje de 117 mil millones de parámetros (con 5.1 mil millones activos por token) que forma parte de su nueva serie de peso abierto GPT-OSS, junto con el más pequeño GPT-OSS-20B. Lanzado el 5 de agosto de 2025, es un modelo de Mezcla de Expertos (MoE) optimizado para la eficiencia, que se ejecuta en una sola GPU NVIDIA H100 o incluso en hardware de consumo con cuantificación MXFP4. Está construido para tareas como el razonamiento complejo, la generación de código y el uso de herramientas, con una enorme ventana de contexto de 128K tokens, ¡piensa en 300-400 páginas de texto! Bajo la licencia Apache 2.0, puedes personalizarlo, implementarlo o incluso comercializarlo, lo que lo convierte en un sueño para desarrolladores y empresas que anhelan control y privacidad.

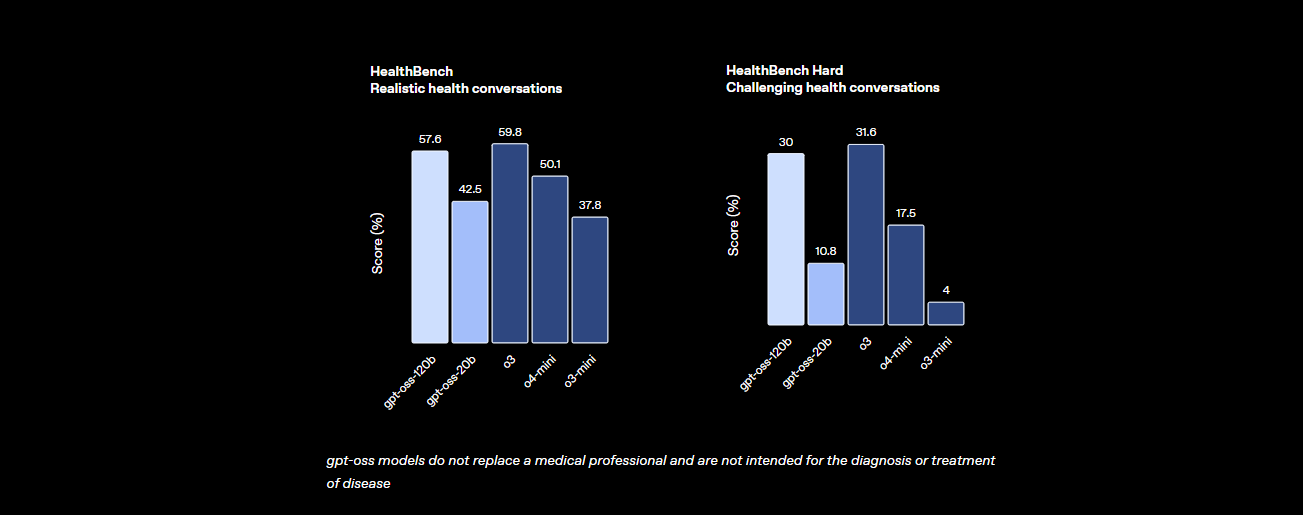

Benchmarks: ¿Cómo se compara GPT-OSS-120B?

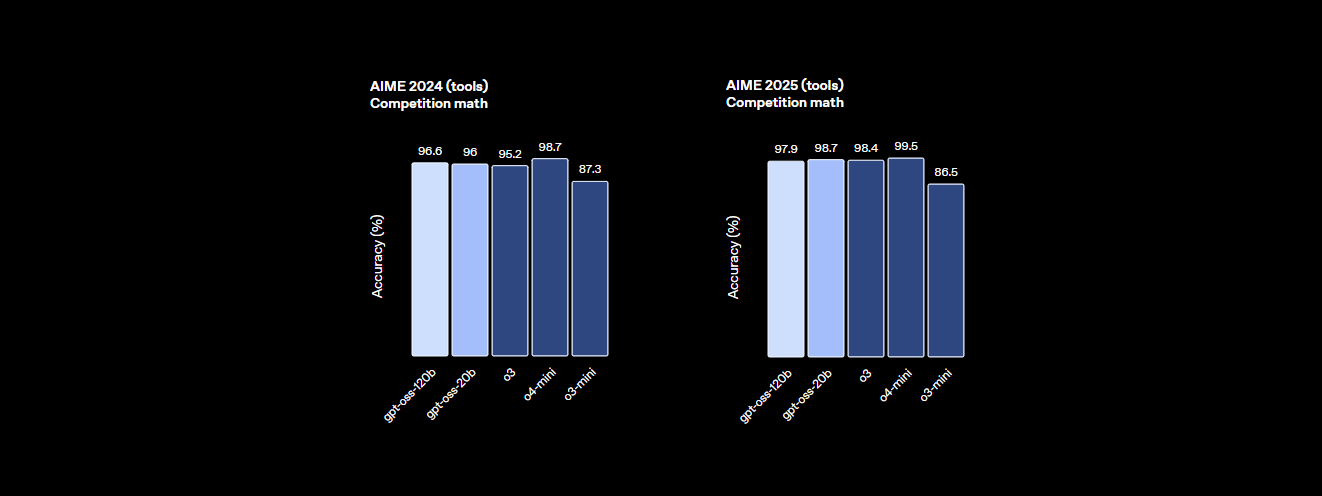

El GPT-OSS-120B no se queda atrás en cuanto a rendimiento. Los benchmarks de Open AI muestran que es un serio contendiente contra modelos propietarios como su propio o4-mini e incluso Claude 3.5 Sonnet. Aquí está el resumen:

- Poder de razonamiento: Obtiene un 94.2% en MMLU (Comprensión del lenguaje multitarea masiva), apenas por debajo del 95.1% de GPT-4, y logra un 96.6% en las competiciones de matemáticas AIME, superando a muchos modelos cerrados.

- Destreza en codificación: En Codeforces, presume de una calificación Elo de 2622, y logra una tasa de aprobación del 87.3% en HumanEval para la generación de código, lo que lo convierte en el mejor amigo de un codificador.

- Salud y uso de herramientas: Supera a o4-mini en HealthBench para consultas relacionadas con la salud y sobresale en tareas agenticas como TauBench, gracias a su razonamiento de cadena de pensamiento (CoT) y sus capacidades de llamada a herramientas.

- Velocidad: En una GPU H100, procesa 45 tokens por segundo, con proveedores como Cerebras alcanzando hasta 3,000 tokens/seg para necesidades de alto volumen. OpenRouter entrega ~500 tokens/seg, superando a muchos modelos cerrados.

Estas estadísticas muestran que GPT-OSS-120B está casi a la par con los modelos propietarios de primer nivel, siendo al mismo tiempo abierto y personalizable. Es una bestia para las matemáticas, la codificación y la resolución general de problemas, con la seguridad incorporada a través del ajuste fino adversario para mantener los riesgos bajos.

Precios: Asequibles y transparentes

¿Una de las mejores partes de GPT-OSS-120B? Es rentable, especialmente en comparación con los modelos propietarios. Así es como se desglosa entre los principales proveedores, según datos recientes para una ventana de contexto de 131K:

- Implementación local: Ejecútalo en tu propio hardware (por ejemplo, una GPU H100 o una configuración de 80 GB de VRAM) sin costes de API. Una configuración GMKTEC EVO-X2 cuesta ~€2000 y consume menos de 200W, perfecto para pequeñas empresas que priorizan la privacidad.

- Baseten: $0.10/M tokens de entrada, $0.50/M tokens de salida. Latencia: 0.20s, Rendimiento: 491.1 tokens/seg. Salida máxima: 131K tokens.

- Fireworks: $0.15/M entrada, $0.60/M salida. Latencia: 0.56s, Rendimiento: 258.9 tokens/seg. Salida máxima: 33K tokens.

- Together: $0.15/M entrada, $0.60/M salida. Latencia: 0.28s, Rendimiento: 131.1 tokens/seg. Salida máxima: 131K tokens.

- Parasail: $0.15/M entrada, $0.60/M salida (cuantificación FP4). Latencia: 0.40s, Rendimiento: 94.3 tokens/seg. Salida máxima: 131K tokens.

- Groq: $0.15/M entrada, $0.75/M salida. Latencia: 0.24s, Rendimiento: 1,065 tokens/seg. Salida máxima: 33K tokens.

- Cerebras: $0.25/M entrada, $0.69/M salida. Latencia: 0.42s, Rendimiento: 1,515 tokens/seg. Salida máxima: 33K tokens. Ideal para necesidades de alta velocidad, alcanzando hasta 3,000 tokens/seg en algunas configuraciones.

Con GPT-OSS-120B, obtienes un alto rendimiento a una fracción del coste de GPT-4 (~$20.00/M tokens), con proveedores como Groq y Cerebras que ofrecen un rendimiento ultrarrápido para aplicaciones en tiempo real.

Cómo usar GPT-OSS-120B con Cline a través de OpenRouter

¿Quieres aprovechar el poder de GPT-OSS-120B para tus proyectos de codificación? Si bien Claude Desktop y Claude Code no admiten la integración directa con modelos de OpenAI como GPT-OSS-120B debido a su dependencia del ecosistema de Anthropic, puedes usar fácilmente este modelo con Cline, una extensión gratuita de código abierto para VS Code, a través de la API de OpenRouter. Además, Cursor ha restringido recientemente su opción Bring Your Own Key (BYOK) para usuarios no Pro, bloqueando funciones como los modos Agente y Edición detrás de una suscripción de $20/mes, lo que convierte a Cline en una alternativa más flexible para los usuarios de BYOK. Aquí te explicamos cómo configurar GPT-OSS-120B con Cline y OpenRouter, paso a paso.

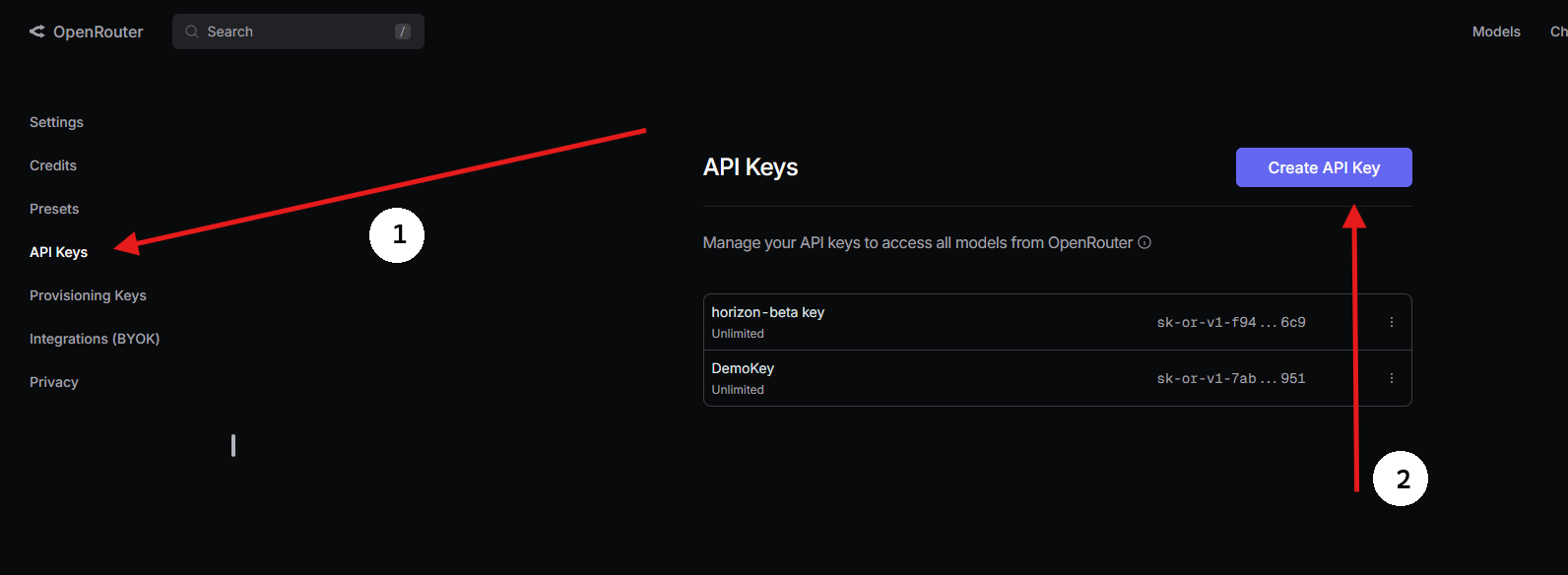

Paso 1: Obtener una clave API de OpenRouter

- Registrarse en OpenRouter:

- Visita openrouter.ai y crea una cuenta gratuita usando Google o GitHub.

2. Buscar GPT-OSS-120B:

- En la pestaña Modelos, busca “gpt-oss-120b” y selecciónalo.

3. Generar una clave API:

- Ve a la sección Claves, haz clic en Crear clave API, nómbrala (por ejemplo, “GPT-OSS-Cursor”) y cópiala. Guárdala de forma segura.

Paso 2: Usar Cline en VS Code con BYOK

Para un acceso BYOK sin restricciones, Cline (una extensión de código abierto para VS Code) es una fantástica alternativa a Cursor. Soporta GPT-OSS-120B a través de OpenRouter sin bloqueos de funciones. Así es como se configura:

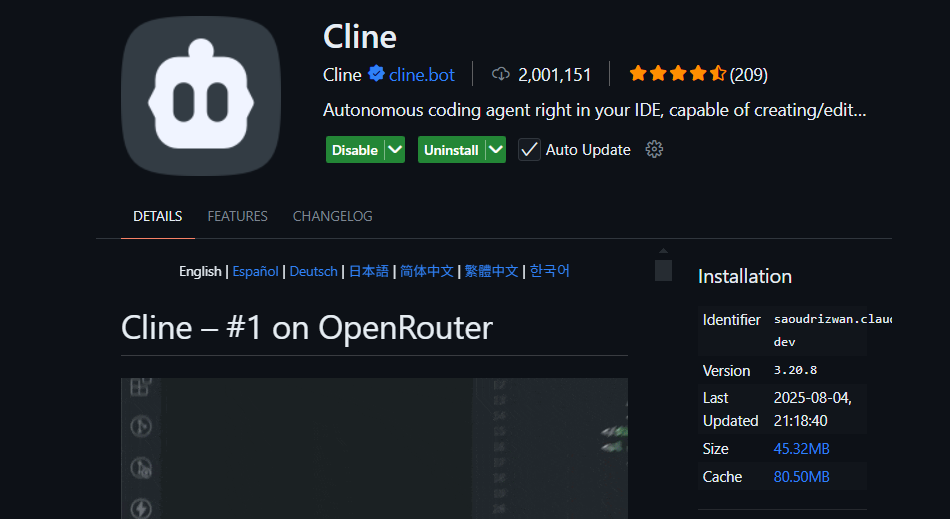

- Instalar Cline:

- Abre VS Code (code.visualstudio.com).

- Ve al panel de Extensiones (

Ctrl+Shift+XoCmd+Shift+X). - Busca “Cline” e instálalo (por nickbaumann98, github.com/cline/cline).

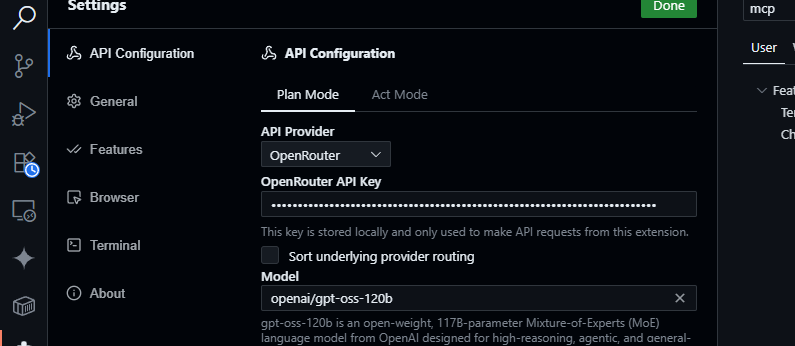

2. Configurar OpenRouter:

- Abre el panel de Cline (haz clic en el icono de Cline en la barra de actividad).

- Haz clic en el icono de engranaje en el panel de Cline.

- Selecciona OpenRouter como proveedor.

- Pega tu clave API de OpenRouter.

- Elige

openai/gpt-oss-120bcomo modelo.

3. Guardar y probar:

- Guarda la configuración. En el panel de chat de Cline, prueba:

Genera una función JavaScript para analizar datos JSON.

- Espera una respuesta como:

function parseJSON(data) {

try {

return JSON.parse(data);

} catch (e) {

console.error("Invalid JSON:", e.message);

return null;

}

}

- Prueba consultas de código:

Resume src/api/server.js

- Cline analizará tu proyecto y devolverá un resumen, aprovechando la ventana de contexto de 128K de GPT-OSS-120B.

¿Por qué Cline en lugar de Cursor o Claude?

- Sin integración con Claude: Claude Desktop y Claude Code están bloqueados a los modelos de Anthropic (por ejemplo, Claude 3.5 Sonnet) y no son compatibles con modelos de OpenAI como GPT-OSS-120B debido a restricciones del ecosistema.

- Restricciones BYOK de Cursor: La reciente prohibición de Cursor sobre BYOK para usuarios no Pro significa que no puedes acceder a los modos Agente o Edición sin una suscripción de $20/mes, incluso con una clave API válida de OpenRouter. Cline no tiene tales límites, ofreciendo acceso completo a las funciones de forma gratuita con tu clave API.

- Privacidad y control: Cline envía las solicitudes directamente a OpenRouter, evitando servidores de terceros (a diferencia del enrutamiento AWS de Cursor), lo que mejora la privacidad.

Consejos para la resolución de problemas

- ¿Clave API no válida? Verifica tu clave en el panel de OpenRouter y asegúrate de que esté activa.

- ¿Modelo no disponible? Revisa la lista de modelos de OpenRouter para openai/gpt-oss-120b. Si falta, prueba proveedores como Fireworks AI o contacta con el soporte de OpenRouter.

- ¿Respuestas lentas? Asegúrate de que tu internet sea estable. Para un rendimiento más rápido, considera modelos más ligeros como GPT-OSS-20B.

- ¿Errores de Cline? Actualiza Cline a través del panel de Extensiones y revisa los registros en el panel de Salida de VS Code.

¿Por qué usar GPT-OSS-120B?

El modelo GPT-OSS-120B es un cambio de juego para desarrolladores y empresas, ofreciendo una combinación convincente de rendimiento, flexibilidad y rentabilidad. He aquí por qué destaca:

- Libertad de código abierto: Con licencia Apache 2.0, puedes ajustar, implementar o comercializar GPT-OSS-120B sin restricciones, dándote control total sobre tus flujos de trabajo de IA.

- Ahorro de costes: Ejecútalo localmente en una sola GPU H100 o hardware de consumo (80 GB de VRAM) para obtener costes de API cero. A través de OpenRouter, los precios son altamente competitivos, alrededor de $0.50/M tokens de entrada y $2.00/M tokens de salida, una fracción de los ~$20.00/M tokens de GPT-4, ofreciendo hasta un 90% de ahorro para usuarios intensivos. Otros proveedores como Groq ($0.15/M entrada, $0.75/M salida) y Cerebras ($0.25/M entrada, $0.69/M salida) también mantienen los costes bajos.

- Rendimiento: Alcanza casi la paridad con el o4-mini de OpenAI, obteniendo un 94.2% en MMLU, un 96.6% en matemáticas AIME y un 87.3% en HumanEval para codificación. Su ventana de contexto de 128K tokens (300-400 páginas) maneja bases de código o documentos masivos con facilidad.

- Razonamiento de cadena de pensamiento (CoT): La transparencia total de CoT del modelo te permite ver su razonamiento paso a paso, lo que facilita la depuración de resultados y la detección de sesgos o errores. Puedes ajustar el esfuerzo de razonamiento (bajo, medio, alto) a través de indicaciones del sistema (por ejemplo, "Razonamiento: alto") para tareas como matemáticas complejas o codificación, equilibrando velocidad y profundidad. Este diseño CoT no supervisado ayuda a los investigadores a monitorear el comportamiento del modelo sin supervisión directa, mejorando la confianza y la seguridad.

- Capacidades agenticas: El soporte nativo para el uso de herramientas, como la navegación web y la ejecución de código Python, lo hace ideal para flujos de trabajo agenticos. Puede encadenar múltiples llamadas a herramientas (por ejemplo, 28 búsquedas web consecutivas en una demostración) para tareas complejas como la agregación de datos o la automatización.

- Privacidad: Alojarlo en las instalaciones (por ejemplo, a través de Dell Enterprise Hub) para un control completo de los datos, perfecto para empresas o usuarios preocupados por la privacidad.

- Flexibilidad: Compatible con OpenRouter, Fireworks AI, Cerebras y configuraciones locales como Ollama o LM Studio, se ejecuta en hardware diverso, desde GPUs RTX hasta Apple Silicon.

El revuelo en la comunidad en X destaca su velocidad (hasta 1,515 tokens/seg en Cerebras) y su destreza en la codificación, con desarrolladores que adoran su capacidad para manejar proyectos de múltiples archivos y su naturaleza de peso abierto para la personalización. Ya sea que estés construyendo agentes de IA o ajustando para tareas específicas, GPT-OSS-120B ofrece un valor inigualable.

Conclusión

El GPT-OSS-120B de Open AI es un modelo revolucionario de peso abierto, que combina un rendimiento de primer nivel con una implementación rentable. Sus benchmarks rivalizan con los modelos propietarios, su precio es asequible y es fácil de integrar con Cursor o Cline a través de la API de OpenRouter. Ya sea que estés codificando, depurando o razonando a través de problemas complejos, este modelo cumple. Pruébalo, experimenta con su ventana de contexto de 128K y cuéntanos tus casos de uso geniales en los comentarios. ¡Soy todo oídos!

Para más detalles, consulta el repositorio en github.com/openai/gpt-oss o el anuncio de Open AI en openai.com.

¿Quieres una plataforma integrada y todo en uno para que tu equipo de desarrolladores trabaje junto con máxima productividad?

¡Apidog satisface todas tus demandas y reemplaza a Postman a un precio mucho más asequible!