Los avances llegan con una velocidad creciente, y GPT-5.2 se erige como el último testimonio de OpenAI de innovación incansable. Lanzado el 11 de diciembre de 2025, este modelo supera los límites en inteligencia general, procesamiento de contexto largo y, especialmente, en tareas de codificación. Ingenieros y desarrolladores ahora se enfrentan a una herramienta que no solo asiste, sino que anticipa flujos de trabajo complejos.

Arquitectura de GPT-5.2: Un Salto en la Eficiencia del Transformador

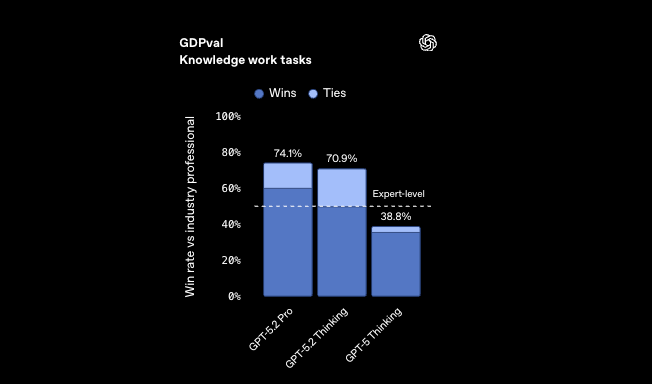

Los ingenieros de OpenAI diseñaron GPT-5.2 para escalar la inteligencia sin una sobrecarga computacional proporcional. En su núcleo, el modelo emplea una arquitectura de transformador mejorada, incorporando capas de mezcla de expertos (MoE) para una activación dispersa. Este enfoque activa solo las subredes relevantes por token, reduciendo la latencia de inferencia hasta 11 veces en comparación con el rendimiento humano a nivel de experto en tareas de GDPval. En consecuencia, los desarrolladores procesan conjuntos de datos más grandes más rápido, lo que permite la generación de código en tiempo real en los IDEs.

Además, GPT-5.2 integra codificaciones posicionales avanzadas que extienden las ventanas de contexto a 256k tokens con un recuerdo casi perfecto. Los modelos tradicionales fallan más allá de 128k debido a la dilución de la atención; sin embargo, el endpoint /compact de GPT-5.2 comprime los embeddings dinámicamente, preservando la fidelidad semántica. En escenarios de codificación, esto significa analizar repositorios completos sin truncamiento. Por ejemplo, al refactorizar bases de código heredadas, el modelo mantiene los alcances de las variables entre archivos, evitando los errores comunes de un contexto fragmentado.

Los mecanismos de seguridad están profundamente incrustados en la arquitectura. GPT-5.2 utiliza principios de IA constitucional, donde los modelos de recompensa penalizan las alucinaciones durante el ajuste fino. Como resultado, la veracidad mejora en un 30% con respecto a GPT-5.1 Thinking en consultas desidentificadas. Los desarrolladores se benefician directamente: los fragmentos de código generados incluyen menos errores de sintaxis o inconsistencias lógicas, lo que agiliza los ciclos de depuración.

Pasando a las aplicaciones prácticas, GPT-5.2 sobresale en tareas multimodales. Sus capacidades de visión reducen a la mitad las tasas de error en el razonamiento de gráficos, lo que le permite interpretar diagramas UML o ERDs a partir de capturas de pantalla. Esta integración resulta invaluable para los diseñadores de API que esbozan los endpoints visualmente antes de la implementación.

Desempaquetando las Variantes de Codificación de GPT-5.2: Adaptadas para Cada Flujo de Trabajo

GPT-5.2 llega no como un monolito, sino como una suite de variantes, cada una optimizada para demandas de codificación específicas. Aunque el lanzamiento oficial enfatiza los niveles Instant, Thinking y Pro, el linaje Codex enfocado en la codificación evoluciona dentro de estos, manifestándose como configuraciones especializadas como Codex Max y Mini. Estas se basan en el núcleo MoE del modelo, asignando expertos para el análisis de sintaxis, la optimización algorítmica y la traducción de lenguaje natural a código.

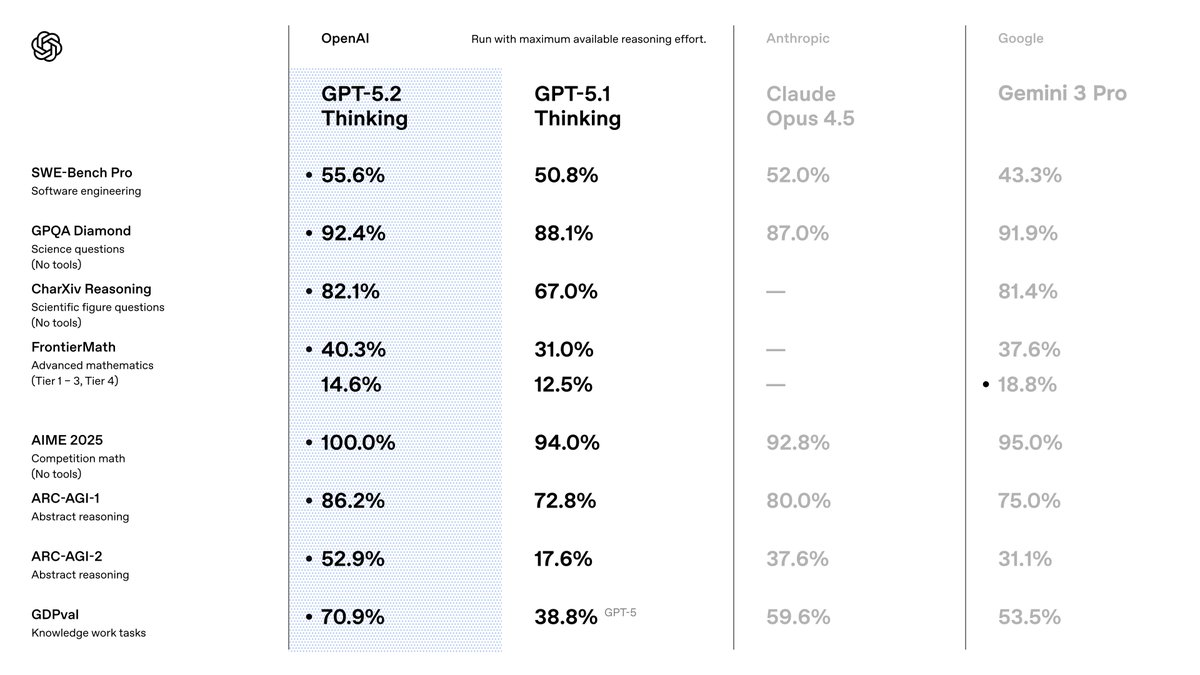

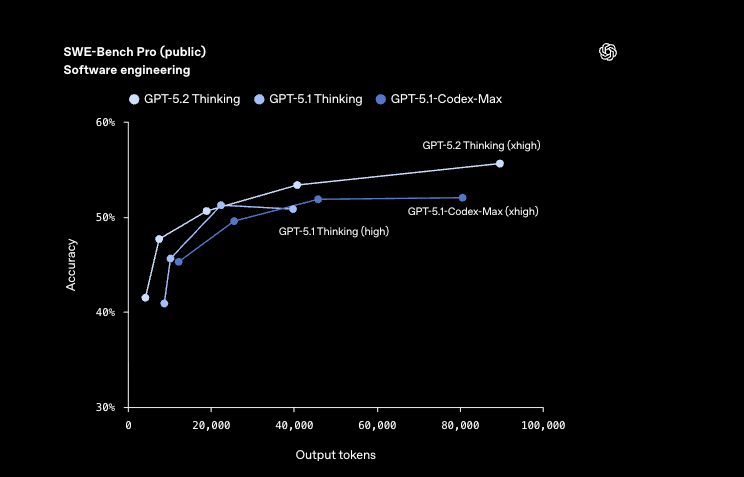

Considere GPT-5.2 Codex Max, el buque insignia para proyectos a escala empresarial. Esta variante aprovecha el razonamiento completo de nivel Pro con un esfuerzo xhigh, alcanzando el 55.6% en SWE-Bench Pro, un benchmark que simula problemas reales de GitHub. Los desarrolladores lo activan para soluciones de extremo a extremo, donde depura, refactoriza y despliega de forma autónoma. En contraste, GPT-5.2 Codex Mini prioriza la velocidad, entregando resultados con latencias de subsegundos para tareas ligeras como la generación de fragmentos. Es adecuado para la creación rápida de prototipos, donde las iteraciones rápidas importan más que el análisis exhaustivo.

Otras configuraciones ajustan los compromisos entre calidad y velocidad. GPT-5.2 Codex Max High equilibra la profundidad con una velocidad moderada, ideal para la implementación de características en equipos de tamaño mediano. Mientras tanto, GPT-5.2 Codex Low Fast elimina expertos no esenciales, centrándose en código boilerplate como endpoints RESTful. Esta variante brilla en pipelines de CI/CD, generando pruebas un 40% más rápido que los equivalentes de GPT-5.1.

Para entornos de alto riesgo, GPT-5.2 Codex Max Extra High emplea cadenas de razonamiento extendidas, superando los benchmarks de FrontierMath con un 40.3%. Maneja el razonamiento abstracto en el código, como la optimización de algoritmos cuánticos o modelos financieros. En el extremo de la eficiencia, GPT-5.2 Codex Medium Fast integra el almacenamiento en caché para consultas repetidas, reduciendo los costos en un 90% en entradas en caché.

Los desarrolladores seleccionan variantes a través de parámetros de API: gpt-5.2-pro para los niveles Max o gpt-5.2-chat-latest para los derivados Instant. Cada uno admite la llamada a herramientas con una precisión del 98.7% en Tau2-bench, lo que permite una integración perfecta con bibliotecas externas. A medida que exploremos los benchmarks a continuación, estas variantes revelarán ventajas cuantificables sobre sus predecesores.

Análisis de Benchmarks: Cómo GPT-5.2 Redefine los Estándares de Codificación

Los benchmarks proporcionan evidencia concreta de la superioridad de GPT-5.2, particularmente en dominios de codificación. En SWE-Bench Verified, el modelo puntúa un 80.0%, un aumento del 3.7% con respecto al 76.3% de GPT-5.1. Esta métrica evalúa los problemas de GitHub resueltos, donde GPT-5.2 Codex Max parchea de forma autónoma las vulnerabilidades en las bases de código de producción. Por ejemplo, identifica condiciones de carrera en scripts concurrentes de Python, proponiendo alternativas seguras para hilos con una interrupción mínima.

Además, GPQA Diamond alcanza una precisión del 92.4%, sobresaliendo en consultas de programación a nivel de posgrado. GPT-5.2 razona a través de pruebas algorítmicas, generando soluciones verificadas mediante la ejecución integrada de Python. En comparación con el 88.1% de GPT-5.1, esta reducción de errores se traduce en menos reversiones de producción para los desarrolladores.

En la codificación asistida por visión, GPT-5.2 reduce a la mitad los errores en la comprensión de la interfaz de software. Analiza maquetas de GUI para generar automáticamente código frontend en React o SwiftUI, manteniendo diseños perfectos en píxeles. Esta capacidad se extiende a la ciencia de datos: en CharXiv Reasoning con Python, logra un 88.7%, automatizando pipelines ETL a partir de conjuntos de datos visualizados.

Los benchmarks de razonamiento abstracto subrayan aún más su ventaja. ARC-AGI-1 con un 86.2% demuestra el reconocimiento de patrones en nuevos rompecabezas de codificación, como idear algoritmos de compresión a partir de especificaciones incompletas. GPT-5.2 Codex High Fast los procesa en menos de 5 segundos, superando a los expertos humanos en GDPval con una tasa de victoria del 70.9%.

Pasando a los impactos económicos, la eficiencia de GPT-5.2 produce una velocidad >11 veces mayor y un costo <1% en comparación con los profesionales en tareas de hoja de cálculo, con una precisión del 68.4% en escenarios de banca de inversión. Los desarrolladores aprovechan esto para automatizar APIs financieras, donde la precisión se une a la velocidad.

Fundamentalmente, estas ganancias provienen de un entrenamiento refinado en diversos corpus, incluyendo 10 veces más repositorios de código que GPT-5.1. Sin embargo, persisten los desafíos: los casos extremos en lenguajes de bajos recursos como Rust muestran una variación del 5-10%. OpenAI aborda esto mediante un ajuste fino continuo, prometiendo actualizaciones trimestrales.

Integrando GPT-5.2 con Apidog: Optimizando el Desarrollo de API

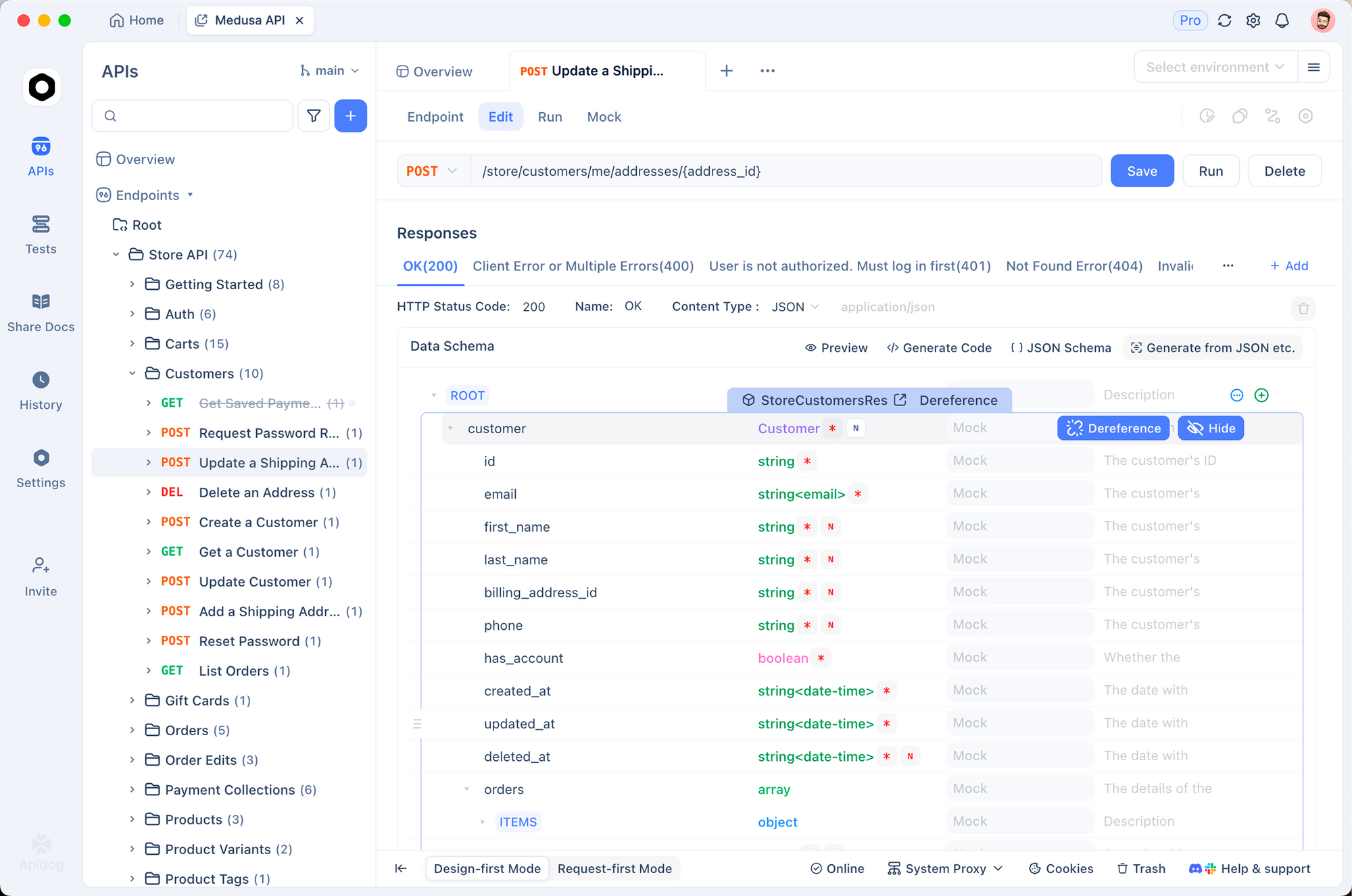

El desarrollo de API exige precisión, y GPT-5.2 se combina excepcionalmente bien con Apidog, una plataforma robusta para diseño, prueba y documentación. El soporte de OpenAPI 3.0 de Apidog se alinea perfectamente con la llamada a herramientas de GPT-5.2, lo que permite a los desarrolladores generar definiciones de esquema a partir de indicaciones de lenguaje natural. Por ejemplo, describa un endpoint de autenticación de usuario, y GPT-5.2 generará especificaciones YAML; Apidog luego las visualiza y las simula instantáneamente.

Además, la suite de pruebas de Apidog valida el código generado por GPT-5.2 contra cargas útiles reales. Suba una salida de Codex Max para una API de comercio electrónico, y Apidog ejecutará aserciones automatizadas, señalando descuidos en la limitación de velocidad. Esta sinergia reduce el tiempo de integración en un 50%, ya que los desarrolladores iteran sin cambiar de herramienta.

En la práctica, comience con GPT-5.2 Thinking para la lógica de los endpoints: crea manejadores con patrones resilientes a errores, obteniendo el 100% en las tareas integradas de matemáticas AIME 2025. Exporte a Apidog para colaborar: los miembros del equipo anotan los esquemas de forma colaborativa, asegurando el cumplimiento de estándares como OAuth 2.0.

Apidog también mejora las características de visión de GPT-5.2. Suba wireframes, deje que el modelo infiera operaciones CRUD y luego documente en la consola interactiva de Apidog. Los precios se alinean de manera asequible: GPT-5.2 a $1.75/1M de tokens de entrada complementa el nivel gratuito de Apidog, lo que hace factible la adopción empresarial.

Surgen desafíos en interacciones de múltiples turnos; sin embargo, la precisión de la herramienta del 98.7% de GPT-5.2 mitiga esto. Los desarrolladores programan flujos de trabajo de Apidog para encadenar llamadas, automatizando ciclos de vida completos de API desde la especificación hasta el despliegue.

Direcciones Futuras: ¿Qué hay Más Allá de GPT-5.2?

OpenAI insinúa el papel de GPT-5.2 como base para agentes multimodales. Las próximas optimizaciones de Codex prometen plugins IDE nativos, incrustando el modelo directamente en VS Code. Espere integraciones con dispositivos de borde, ejecutando variantes Mini en laptops para codificación sin conexión.

Apidog evoluciona paralelamente, añadiendo evolución de esquemas asistida por IA. Los desarrolladores solicitarán a GPT-5.2 APIs versionadas, con Apidog manejando las migraciones automáticamente.

Los desafíos incluyen el consumo de energía: el entrenamiento rivalizó con las producciones de pequeñas naciones, lo que impulsó diseños MoE más ecológicos. Los marcos regulatorios exigen transparencia; las evaluaciones de seguridad de OpenAI, que puntúan 0.995 en respuestas de salud mental, sientan precedentes.

En conclusión, GPT-5.2 eleva la codificación de artesanía a ciencia. Sus variantes potencian diversos flujos de trabajo, los benchmarks validan las afirmaciones y las integraciones como Apidog lo hacen accesible. Desarrolladores, abracen este cambio: descarguen Apidog de forma gratuita y experimenten con GPT-5.2 hoy. El futuro se codifica solo.