El panorama de la inteligencia artificial ha sido testigo de un cambio sísmico con la introducción de GLM-4.5, el innovador modelo de lenguaje de código abierto de Z.ai que desafía el dominio de las soluciones propietarias.

Los desarrolladores modernos se enfrentan a un desafío cada vez más complejo al seleccionar modelos de IA para entornos de producción. Además, la necesidad de un razonamiento sofisticado, una asistencia de codificación fiable y capacidades de agente robustas nunca ha sido más crítica. GLM-4.5 surge como una solución convincente que aborda estos requisitos manteniendo la flexibilidad y la transparencia que exige el desarrollo de código abierto.

Comprendiendo la Arquitectura Revolucionaria de GLM-4.5

GLM-4.5 representa una reimaginación fundamental de cómo los grandes modelos de lenguaje deberían abordar la ejecución inteligente de tareas. El modelo emplea una arquitectura de Mezcla de Expertos (MoE) con 355 mil millones de parámetros totales y 32 mil millones de parámetros activos por pasada hacia adelante, creando un equilibrio óptimo entre eficiencia computacional y capacidad de rendimiento.

Además, la arquitectura incorpora mecanismos avanzados de razonamiento híbrido que permiten un comportamiento más estable durante interacciones de contexto largo y múltiples turnos. La filosofía de diseño prioriza las consideraciones prácticas de despliegue mientras mantiene un rendimiento de vanguardia en diversos dominios de aplicación.

La base técnica se extiende más allá de las arquitecturas de transformadores tradicionales mediante mecanismos de atención innovadores y estrategias optimizadas de distribución de parámetros. En consecuencia, GLM-4.5 logra notables ganancias de eficiencia que se traducen en beneficios tangibles para los despliegues de producción.

Puntos de Referencia de Rendimiento que Redefinen la Excelencia

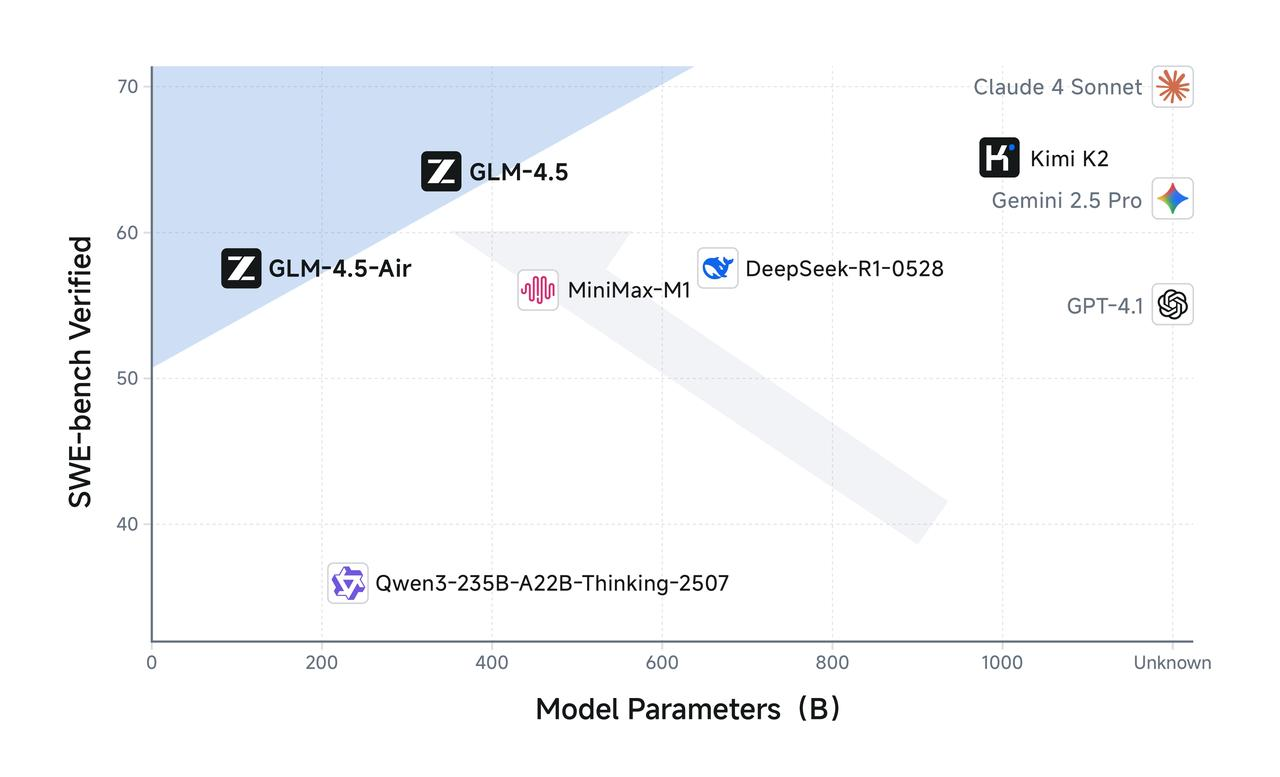

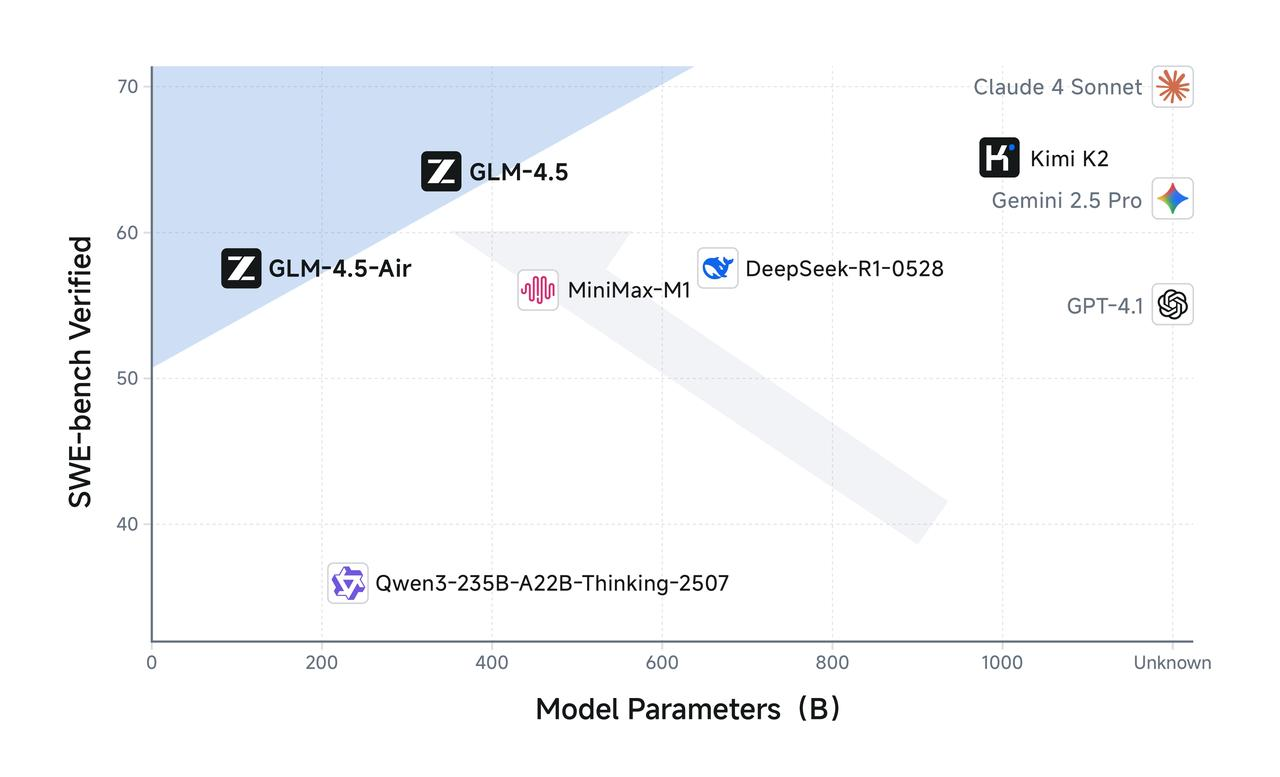

GLM-4.5 logra un rendimiento excepcional con una puntuación de 63.2, ocupando el 3er lugar entre todos los modelos propietarios y de código abierto en 12 puntos de referencia estándar de la industria que cubren capacidades de agente, razonamiento y codificación. Estos resultados demuestran la versatilidad y fiabilidad del modelo en dominios de aplicación críticos.

Además, el rendimiento de los puntos de referencia revela ventajas significativas en áreas técnicas específicas. GLM-4.5 logra un 70.1% en TAU-Bench, un 91.0% en AIME 24 y un 64.2% en SWE-bench Verified, estableciendo nuevos estándares para las capacidades de los modelos de código abierto en tareas de razonamiento matemático e ingeniería de software.

La metodología de evaluación integral garantiza que las métricas de rendimiento reflejen escenarios de aplicación del mundo real en lugar de puntos de referencia sintéticos. Posteriormente, los desarrolladores pueden confiar en estos resultados al tomar decisiones arquitectónicas para sistemas de producción.

Análisis Comparativo Frente a los Líderes de la Industria

Cuando se compara con competidores establecidos, GLM-4.5 demuestra un posicionamiento competitivo notable. El rendimiento del modelo se acerca mucho a las soluciones propietarias, manteniendo al mismo tiempo una transparencia completa y una flexibilidad de personalización que las alternativas de código cerrado no pueden ofrecer.

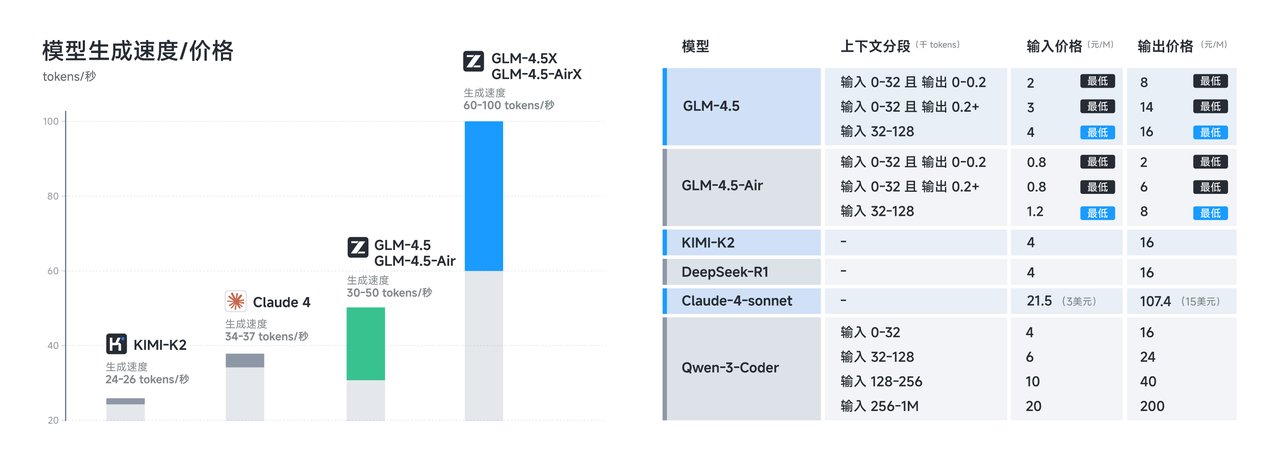

Además, el análisis de rentabilidad revela ventajas sustanciales para las organizaciones que buscan capacidades de IA de alto rendimiento sin los gastos recurrentes asociados con los servicios de API propietarios. El modelo puede ejecutarse con solo ocho chips Nvidia H20 —la mitad de lo que requiere DeepSeek—, lo que reduce significativamente los requisitos de infraestructura y los costos operativos.

La relación rendimiento-costo representa un cambio de paradigma en la forma en que las organizaciones abordan las estrategias de implementación de IA. Por lo tanto, GLM-4.5 permite a equipos y organizaciones más pequeños acceder a capacidades que antes estaban reservadas para empresas con grandes recursos.

Capacidades Avanzadas de Codificación para el Desarrollo Moderno

La competencia de codificación de GLM-4.5 se extiende a múltiples lenguajes de programación y paradigmas de desarrollo. El modelo admite la generación de código en Python, JavaScript, Java, C++, Go, Rust y muchos otros lenguajes, proporcionando una cobertura integral para diversos entornos de desarrollo.

Además, la comprensión del modelo de los principios de ingeniería de software le permite generar código contextualmente apropiado que se adhiere a las mejores prácticas y estándares de la industria. La integración de capacidades avanzadas de depuración mejora aún más el flujo de trabajo de desarrollo al identificar posibles problemas y sugerir optimizaciones.

La funcionalidad de codificación de agente representa un avance significativo en el desarrollo asistido por IA. En consecuencia, los desarrolladores pueden aprovechar GLM-4.5 para tareas complejas de refactorización, decisiones de diseño de arquitectura y escenarios de pruebas automatizadas que requieren una comprensión profunda de las relaciones y dependencias del código.

Integración con Flujos de Trabajo de Desarrollo

Los entornos de desarrollo modernos requieren una integración perfecta con las cadenas de herramientas y los flujos de trabajo existentes. La compatibilidad de la API de GLM-4.5 y las opciones de despliegue flexibles permiten una integración sencilla con plataformas de desarrollo populares y sistemas de integración continua.

Además, la capacidad del modelo para comprender el contexto del proyecto y mantener la coherencia en múltiples archivos y módulos lo hace particularmente valioso para proyectos de software a gran escala. La conciencia contextual se extiende a la comprensión de las convenciones de codificación, los patrones arquitectónicos y los requisitos específicos del dominio.

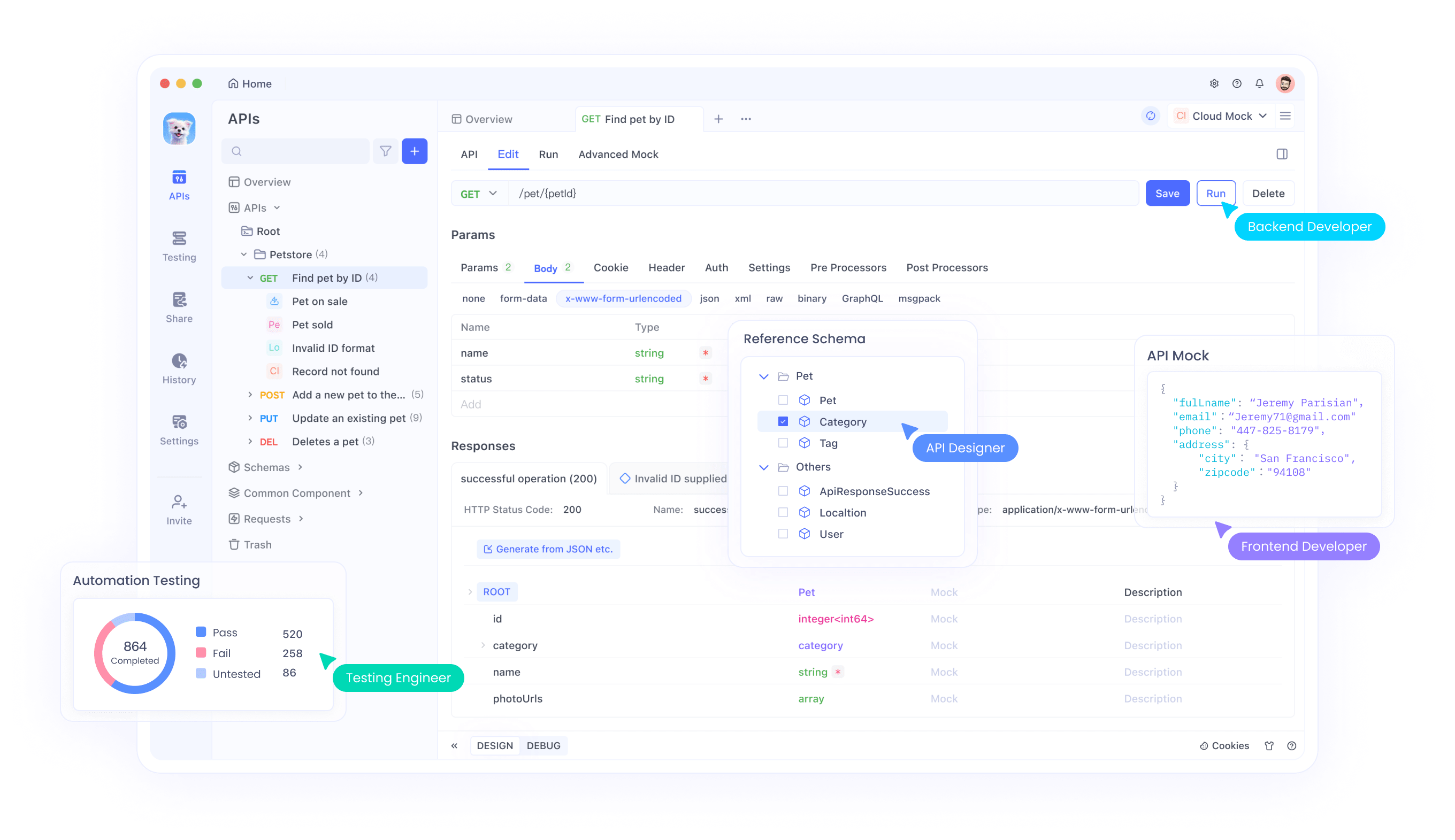

Cuando se combina con el marco integral de pruebas de API de Apidog, los desarrolladores pueden validar sistemáticamente las capacidades de generación de código de GLM-4.5 en diferentes escenarios y garantizar estándares de calidad consistentes durante todo el ciclo de vida del desarrollo.

Capacidades de Agente que Transforman las Interacciones del Usuario

GLM-4.5 mejora particularmente las capacidades de agente, incluyendo la codificación de agente, la búsqueda profunda y el uso general de herramientas, estableciendo nuevas posibilidades para la ejecución autónoma de tareas y la automatización de flujos de trabajo complejos.

La arquitectura de agente permite a GLM-4.5 descomponer solicitudes complejas en subtareas manejables, ejecutarlas sistemáticamente y sintetizar los resultados en soluciones coherentes. Además, la capacidad del modelo para mantener el contexto a lo largo de interacciones extendidas permite escenarios sofisticados de resolución de problemas en múltiples pasos.

Estas capacidades resultan particularmente valiosas en escenarios que requieren refinamiento iterativo, análisis exploratorio y generación de respuestas adaptativas. Posteriormente, las aplicaciones pueden proporcionar experiencias de usuario más inteligentes y receptivas que se adapten a los requisitos cambiantes y a los contextos en evolución.

Integración de Herramientas y Conectividad con Sistemas Externos

Las capacidades de uso de herramientas de GLM-4.5 se extienden más allá de simples llamadas a la API para abarcar patrones de integración sofisticados con sistemas y servicios externos. El modelo puede comprender la documentación de las herramientas, generar configuraciones de parámetros apropiadas y manejar escenarios de error con elegancia.

Además, el mecanismo inteligente de selección de herramientas permite a GLM-4.5 elegir las herramientas óptimas para tareas específicas basándose en el contexto, los requisitos y los recursos disponibles. Esta capacidad reduce significativamente la complejidad de construir aplicaciones sofisticadas impulsadas por IA que requieren múltiples integraciones de sistemas.

Los robustos mecanismos de manejo de errores y recuperación aseguran un funcionamiento fiable en entornos de producción donde las dependencias externas pueden experimentar problemas intermitentes o patrones de disponibilidad cambiantes.

Consideraciones de Implementación Técnica

El despliegue exitoso de GLM-4.5 requiere una cuidadosa consideración de los requisitos de infraestructura, las estrategias de escalado y las técnicas de optimización del rendimiento. El modelo proporciona un rendimiento 8 veces mejor por costo computacional en comparación con modelos densos de capacidad similar, lo que permite una utilización eficiente de los recursos en diversos escenarios de despliegue.

Además, la arquitectura híbrida MoE permite estrategias de escalado flexibles que pueden adaptarse a patrones de carga de trabajo variables y restricciones de recursos. Las organizaciones pueden implementar enfoques de escalado progresivo que se alineen con el crecimiento del uso y las consideraciones presupuestarias.

La flexibilidad de despliegue se extiende a diversos entornos de alojamiento, incluyendo plataformas en la nube, infraestructura local y configuraciones híbridas que equilibran el costo, el rendimiento y los requisitos de privacidad de los datos.

Estrategias de Optimización de Memoria y Computación

El despliegue efectivo de GLM-4.5 implica técnicas sofisticadas de gestión de memoria y optimización de computación que maximizan el rendimiento mientras minimizan el consumo de recursos. La arquitectura del modelo soporta varios enfoques de optimización, incluyendo cuantificación, poda y estrategias de procesamiento por lotes dinámico.

Además, los mecanismos inteligentes de caché pueden mejorar significativamente los tiempos de respuesta para patrones de acceso frecuente y reducir la sobrecarga computacional general. Estas optimizaciones resultan particularmente valiosas en entornos de producción de alto rendimiento.

Al implementar GLM-4.5 con el marco de pruebas de Apidog, los desarrolladores pueden evaluar sistemáticamente el impacto de diferentes estrategias de optimización en el rendimiento del modelo e identificar configuraciones óptimas para casos de uso específicos.

Diseño de API y Patrones de Integración

El diseño de la API de GLM-4.5 sigue los principios RESTful modernos, incorporando al mismo tiempo características avanzadas para respuestas en streaming, procesamiento por lotes y conversaciones con estado. La documentación completa de la API proporciona una guía clara para implementar varios patrones de integración y manejar casos extremos.

Además, la flexibilidad de la API se adapta a diferentes arquitecturas de aplicaciones y patrones de uso sin requerir modificaciones significativas en los sistemas existentes. La compatibilidad con versiones anteriores garantiza rutas de migración fluidas para aplicaciones que actualmente utilizan otros modelos de lenguaje.

Los robustos mecanismos de autenticación y autorización proporcionan características de seguridad de nivel empresarial que cumplen con los requisitos de cumplimiento para aplicaciones sensibles e industrias reguladas.

Limitación de Tasa y Optimización del Rendimiento

Las implementaciones de API en producción requieren estrategias sofisticadas de limitación de tasa y optimización del rendimiento para garantizar una entrega de servicio fiable y una utilización óptima de los recursos. La API de GLM-4.5 incluye mecanismos de limitación de tasa configurables que pueden adaptarse a diferentes patrones de uso y niveles de suscripción.

Además, los sistemas inteligentes de equilibrio de carga y cola de solicitudes ayudan a mantener tiempos de respuesta consistentes incluso durante períodos de uso pico. Estas características resultan esenciales para aplicaciones con patrones de tráfico impredecibles o variaciones de uso estacionales.

Oportunidades de Ajuste Fino y Personalización

GLM-4.5 soporta múltiples enfoques de ajuste fino: LoRA (Low-Rank Adaptation) para un entrenamiento eficiente, ajuste fino de parámetros completos para una máxima personalización, y RLHF (Reinforcement Learning from Human Feedback) para alineación. Estas opciones permiten a las organizaciones adaptar el comportamiento del modelo a dominios y casos de uso específicos.

Además, la documentación completa de ajuste fino y los scripts de ejemplo aceleran el proceso de personalización al tiempo que garantizan la adhesión a las mejores prácticas. La arquitectura modular permite mejoras específicas en áreas de capacidad concretas sin afectar el rendimiento general del modelo.

La infraestructura de ajuste fino soporta varios formatos de datos y metodologías de entrenamiento, permitiendo a las organizaciones aprovechar eficazmente los conjuntos de datos existentes y la experiencia en el dominio.

Estrategias de Adaptación Específicas del Dominio

La personalización exitosa de GLM-4.5 requiere enfoques estratégicos para la adaptación de dominio que equilibren la especialización con la preservación de la capacidad general. La arquitectura del modelo soporta enfoques de aprendizaje incremental que pueden incorporar nuevos conocimientos sin el olvido catastrófico de las capacidades existentes.

Además, los sofisticados marcos de evaluación permiten una evaluación sistemática de la efectividad del ajuste fino a través de diferentes métricas y casos de uso. Estas herramientas resultan esenciales para las organizaciones que buscan optimizar el rendimiento del modelo para aplicaciones específicas.

Los entornos de ajuste fino colaborativos facilitan el desarrollo de modelos en equipo y permiten el intercambio de conocimientos entre diferentes proyectos de personalización dentro de las organizaciones.

Consideraciones de Seguridad y Privacidad

La naturaleza de código abierto de GLM-4.5 permite una auditoría de seguridad integral y personalización para cumplir con requisitos de privacidad específicos. Las organizaciones pueden implementar capas de seguridad adicionales, modificar los procedimientos de manejo de datos y garantizar el cumplimiento de las regulaciones y estándares de la industria relevantes.

Además, las capacidades de despliegue local del modelo proporcionan un control completo sobre el procesamiento y almacenamiento de datos, eliminando las preocupaciones sobre el acceso de terceros a los datos o las políticas de retención. Este control resulta particularmente valioso para organizaciones que manejan información sensible u operan en industrias reguladas.

La arquitectura transparente permite a los equipos de seguridad comprender el comportamiento del modelo, identificar posibles vulnerabilidades e implementar estrategias de mitigación apropiadas adaptadas a modelos de amenaza y perfiles de riesgo específicos.

Gobernanza de Datos y Cumplimiento

La implementación de GLM-4.5 en entornos empresariales requiere una cuidadosa consideración de los requisitos de gobernanza de datos y las obligaciones de cumplimiento. La flexibilidad del modelo permite la implementación de políticas sofisticadas de manejo de datos que se alinean con los requisitos organizacionales y los mandatos regulatorios.

Además, las capacidades completas de registro y auditoría proporcionan visibilidad detallada sobre los patrones de uso del modelo, los patrones de acceso a los datos y los procesos de toma de decisiones. Estas características apoyan los requisitos de informes de cumplimiento y monitoreo de seguridad.

Conclusión: Abrazando el Futuro de la IA de Código Abierto

GLM-4.5 representa un avance transformador en la inteligencia artificial de código abierto que combina un rendimiento excepcional con una flexibilidad y transparencia sin precedentes. Las capacidades integrales del modelo en tareas de razonamiento, codificación y agente lo posicionan como una base ideal para las aplicaciones inteligentes de próxima generación.

Organizaciones que aprovechan GLM-4.5 con plataformas integrales de prueba de API como Apidog obtienen ventajas significativas en velocidad de desarrollo, fiabilidad de despliegue y eficiencia de mantenimiento continuo. Estas herramientas permiten la validación sistemática del rendimiento del modelo, procesos de integración optimizados y capacidades de monitoreo robustas que aseguran implementaciones exitosas en producción.