Los desarrolladores buscan constantemente herramientas que mejoren la productividad sin inflar los costos. GLM-4.5 emerge como un cambio de juego en este espacio, ofreciendo capacidades robustas para tareas de codificación. Al combinarlo con Claude Code, obtendrá acceso a asistencia de IA avanzada que rivaliza con los modelos de primer nivel. M

Comprendiendo GLM-4.5: La base de la codificación avanzada con IA

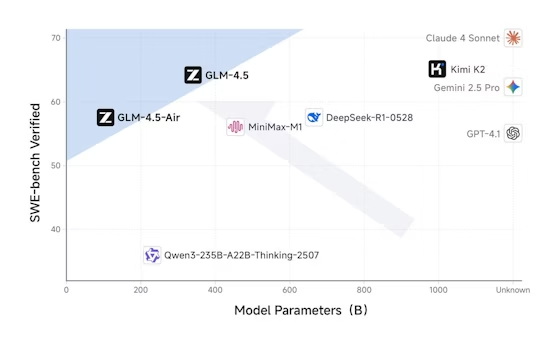

Z.ai desarrolla GLM-4.5 como un modelo de lenguaje grande insignia adaptado para aplicaciones orientadas a agentes. Los ingenieros de Z.ai emplean una arquitectura de Mezcla de Expertos (MoE), que activa 32 mil millones de parámetros de un total de 355 mil millones durante cada pasada hacia adelante. Este diseño optimiza la eficiencia, permitiendo que el modelo maneje tareas complejas sin una sobrecarga computacional excesiva. Además, GLM-4.5 se preentrena con 15 billones de tokens, seguido de un ajuste fino con conjuntos de datos especializados para la generación de código, el razonamiento y los comportamientos de los agentes.

El modelo soporta una ventana de contexto de 128k tokens, lo que le permite procesar bases de código extensas o instrucciones de varios pasos de una sola vez. Los desarrolladores aprecian esta característica porque reduce la necesidad de prompts repetidos. Además, GLM-4.5 incorpora modos de razonamiento híbridos: Modo Pensamiento para problemas complejos y Modo No Pensamiento para respuestas rápidas. Estos se activan a través del parámetro thinking.type en las llamadas API, proporcionando flexibilidad según las demandas de la tarea.

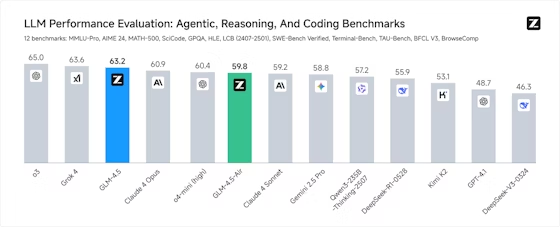

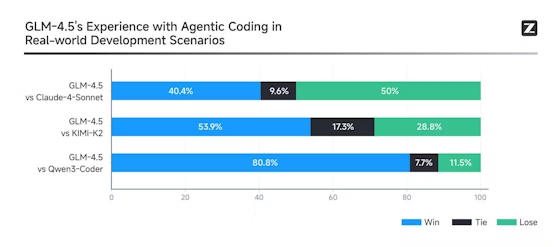

Los benchmarks subrayan la destreza de GLM-4.5. Se clasifica en segundo lugar a nivel mundial en 12 suites, incluyendo MMLU Pro para razonamiento multifacético y LiveCodeBench para desafíos de codificación en tiempo real. En términos prácticos, esto significa que GLM-4.5 genera scripts de Python o funciones de JavaScript con alta precisión, a menudo superando a modelos como Claude 3.5 Sonnet en tareas de llamada de funciones. Sin embargo, su verdadera fortaleza radica en las funciones agénticas, donde invoca herramientas, navega por la web o diseña componentes de software de forma autónoma.

GLM-4.5-Air, una variante más ligera con 106 mil millones de parámetros totales y 12 mil millones activos, complementa el modelo principal para escenarios que demandan velocidad sobre potencia bruta. Ambas variantes se integran sin problemas con las herramientas de desarrollo, haciéndolas ideales para entornos de codificación. Como resultado, los equipos adoptan GLM-4.5 para optimizar los flujos de trabajo, desde la depuración de código heredado hasta la creación de prototipos de nuevas aplicaciones.

¿Qué es Claude Code y por qué integrarlo con GLM-4.5?

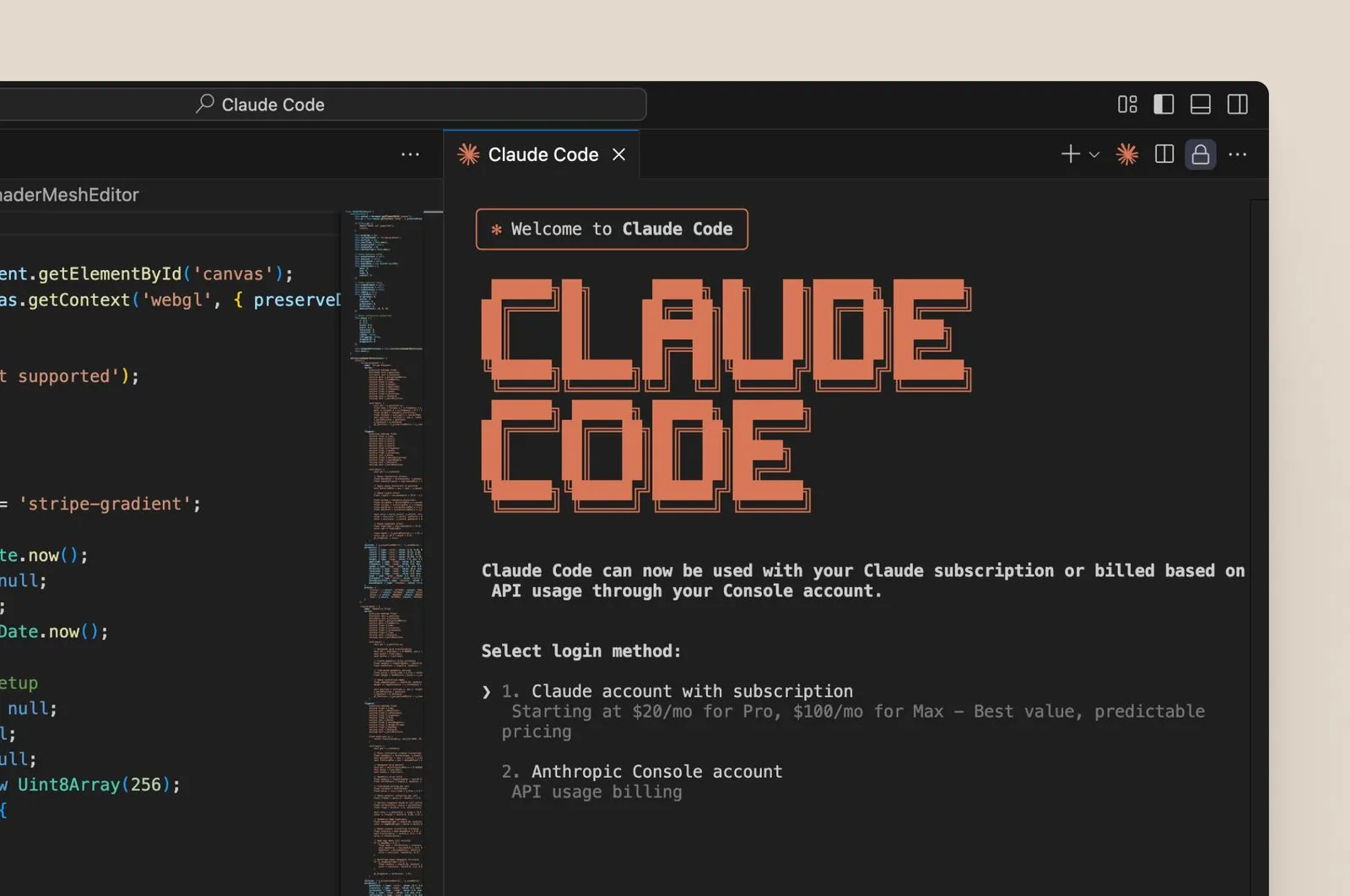

Claude Code sirve como un asistente de codificación basado en terminal que aprovecha la IA para automatizar tareas de desarrollo. Los usuarios lo instalan como una herramienta CLI o lo integran en IDEs como VS Code. Originalmente diseñado en torno a los modelos Claude de Anthropic, Claude Code ejecuta comandos, genera fragmentos de código y gestiona repositorios a través de entradas de lenguaje natural. Por ejemplo, podría instruirlo para "refactorizar esta función para un mejor rendimiento", y responde con código optimizado.

La integración con GLM-4.5 se produce a través del endpoint API compatible con Anthropic de Z.ai. Esta compatibilidad le permite intercambiar los modelos Claude por GLM-4.5 sin alterar la funcionalidad principal de Claude Code. En consecuencia, los desarrolladores enrutan las solicitudes a los servidores de Z.ai, beneficiándose de las tasas superiores de invocación de herramientas de GLM-4.5, hasta un 90% de éxito en los benchmarks.

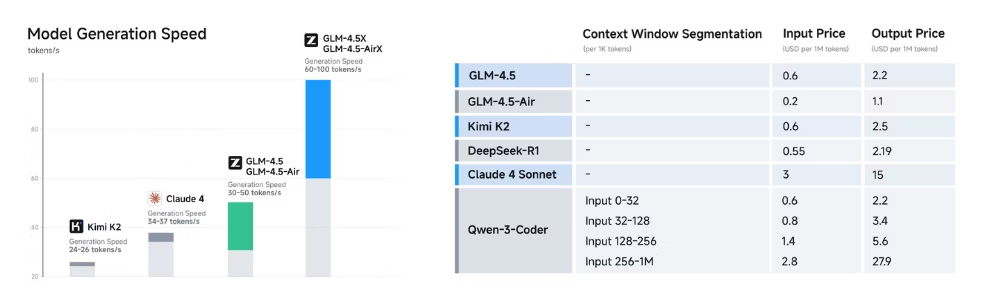

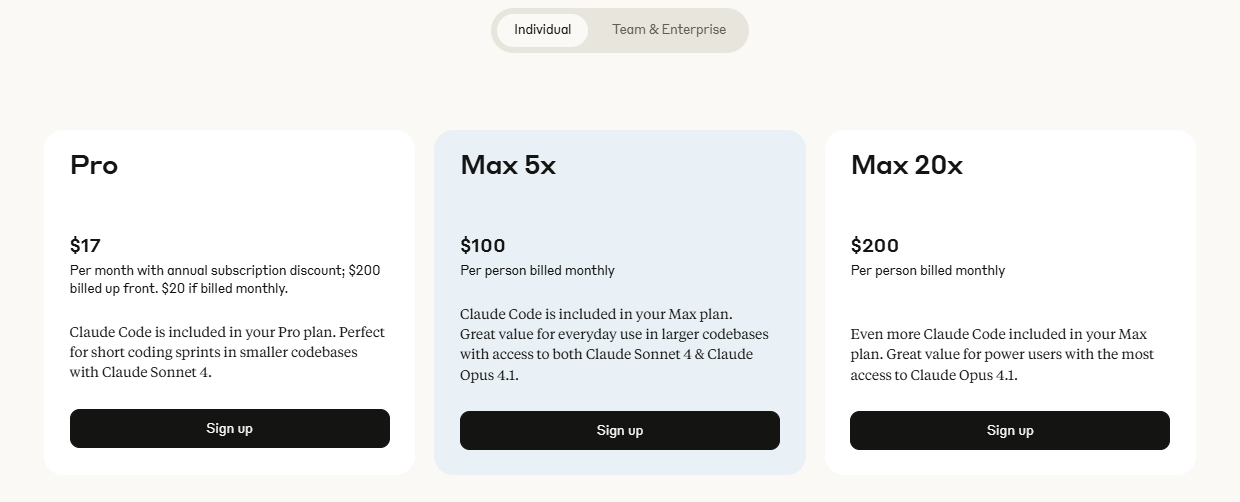

¿Por qué hacer este cambio? GLM-4.5 ofrece ventajas de costo y un rendimiento mejorado en la codificación agéntica. Los planes tradicionales de Claude pueden costar entre $100 y $200 mensuales para un uso intensivo, pero los Planes de Codificación GLM de Z.ai comienzan en $3 para Lite y $15 para Pro, proporcionando 3 veces el uso de los niveles comparables de Claude. Esta asequibilidad atrae a desarrolladores independientes y startups. Además, GLM-4.5 sobresale en dominios como el desarrollo front-end y la corrección de errores, completando tareas en minutos que manualmente podrían llevar horas.

Beneficios de usar GLM-4.5 con Claude Code

La combinación de GLM-4.5 y Claude Code produce ventajas tangibles. Primero, se logran ciclos de iteración más rápidos. La velocidad de generación de GLM-4.5 supera los 100 tokens por segundo, lo que permite sugerencias de código en tiempo real en Claude Code. Esta rapidez resulta crucial durante las sesiones de depuración, donde las correcciones rápidas evitan interrupciones en el flujo de trabajo.

Segundo, la integración mejora la precisión. El ajuste fino por aprendizaje por refuerzo de GLM-4.5 asegura salidas fiables, reduciendo las alucinaciones en la generación de código. Por ejemplo, se adhiere a las mejores prácticas en lenguajes como Java o C++, incorporando el manejo de errores y la optimización automáticamente. Por lo tanto, los desarrolladores dedican menos tiempo a revisar el código generado por IA.

Tercero, destaca la eficiencia de costos. El plan GLM Coding Pro de $15/mes desbloquea tareas intensivas con 3 veces la capacidad del plan Max de Claude. Lite, por $3, se adapta a necesidades ligeras, haciendo accesible la IA avanzada. Impulsados por GLM-4.5 y GLM-4.5-Air, estos planes prometen próximas integraciones de herramientas, expandiendo aún más las capacidades.

La seguridad también mejora. La API de Z.ai soporta salidas estructuradas como JSON, asegurando respuestas predecibles en Claude Code. Además, el almacenamiento en caché de contexto minimiza las computaciones redundantes, reduciendo la latencia en sesiones largas.

Finalmente, la naturaleza de código abierto de GLM-4.5 permite la personalización. Los equipos ajustan el modelo para tareas específicas del dominio, integrándolo más profundamente en los flujos de trabajo de Claude Code. En general, esta combinación transforma la codificación de un esfuerzo solitario en un proceso aumentado por la IA.

Guía paso a paso: Configurando GLM-4.5 en Claude Code

Comienza preparando tu entorno. Instala Claude Code a través de su CLI oficial o extensión. Luego, regístrate en la plataforma de Z.ai para obtener una clave API. Suscríbete a un Plan de Codificación GLM si tu uso excede los niveles gratuitos — Lite funciona para principiantes.

Configura la integración. En la configuración de Claude Code, localiza el archivo de configuración de la API (a menudo ~/.claude/config.yaml). Actualiza la URL base al endpoint de Z.ai: https://api.z.ai/api/paas/v4/chat/completions. Inserta tu clave API en el encabezado de autorización.

Prueba la configuración. Inicia Claude Code y emite un comando simple: "Genera una función de Python para ordenar una lista". GLM-4.5 procesa esto a través de la API compatible, devolviendo el código. Verifica la corrección de la salida.

Habilita las funciones avanzadas. Establece thinking.type en "enabled" para tareas complejas. Esto activa el razonamiento profundo de GLM-4.5, ideal para decisiones arquitectónicas. Usa el streaming añadiendo stream: true a las solicitudes, permitiendo la visualización progresiva del código en Claude Code.

Maneja las herramientas. GLM-4.5 soporta llamadas a funciones — define herramientas en tu prompt, y el modelo las invoca. Para la navegación web, incluye una herramienta de navegador; Claude Code las enruta sin problemas.

Soluciona problemas. Si la autenticación falla, regenera tu clave. Para límites de tasa, monitorea el uso en el panel de Z.ai. Apidog ayuda aquí simulando llamadas antes de la integración en vivo.

Probando la API de GLM-4.5 con Apidog: Garantizando la fiabilidad

Apidog agiliza las pruebas de API, haciéndolo esencial para la integración de GLM-4.5. Crea un nuevo proyecto en Apidog e importa la especificación OpenAPI de Z.ai. Define endpoints como /chat/completions.

Construye solicitudes. Establece los encabezados con tu clave API y el tipo de contenido como JSON. En el cuerpo, especifica el modelo como "glm-4.5" y añade un array de mensajes para los prompts.

Ejecuta pruebas. Apidog ejecuta las llamadas, mostrando las respuestas con códigos de estado. Afirma las salidas esperadas, como código estructurado en JSON.

Automatiza escenarios. Construye suites de prueba para variaciones — prueba el Modo Pensamiento frente al No Pensamiento, o diferentes temperaturas (0.6 para una creatividad equilibrada).

Monitorea el rendimiento. Apidog rastrea la latencia y los errores, ayudando a optimizar los parámetros antes del despliegue de Claude Code.

Integra con CI/CD. Exporta scripts de Apidog a pipelines, asegurando la fiabilidad de GLM-4.5 después de las actualizaciones.

Uso avanzado: Aprovechando las características agénticas de GLM-4.5 en Claude Code

GLM-4.5 brilla en tareas agénticas. Defines agentes en los prompts de Claude Code, y GLM-4.5 los orquesta. Por ejemplo, crea un agente de refactorización: "Analiza esta base de código y sugiere mejoras."

Usa la invocación de múltiples herramientas. GLM-4.5 maneja cadenas — navegar por documentos, generar código, probarlo — todo dentro de una misma sesión.

Ajuste fino para detalles específicos. Sube conjuntos de datos a Z.ai para modelos personalizados, luego enruta Claude Code a ellos.

Escala con caché. Almacena contextos en la caché de GLM-4.5, acelerando la codificación iterativa.

Combina variantes. Cambia a GLM-4.5-Air para tareas rápidas, reservando GLM-4.5 completo para las intensivas.

Precios y planes: Haciendo GLM-4.5 asequible para los usuarios de Claude Code

Z.ai adapta planes para Claude Code. Lite, por $3/mes, ofrece 3 veces el uso de Claude Pro para codificación casual. Pro, por $15/mes, triplica Claude Max, adecuado para profesionales.

Existen niveles gratuitos para pruebas, pero los planes desbloquean un potencial ilimitado. Compara: los costos de la API estándar son de $0.2/M tokens de entrada, pero los planes se agrupan para ahorrar.

Desafíos comunes y soluciones

¿Picos de latencia? Optimiza los prompts. ¿Errores en las llamadas a herramientas? Refina las definiciones. Apidog los identifica temprano.

Conclusión

La integración de GLM-4.5 con Claude Code empodera a los desarrolladores. Sigue estos pasos, aprovecha Apidog y transforma tu práctica de codificación. La combinación ofrece eficiencia, precisión y asequibilidad — comienza hoy mismo.