El lanzamiento de modelos avanzados de IA como el Gemini 2.5 Pro de Google genera un gran entusiasmo dentro de la comunidad de desarrolladores. Su razonamiento mejorado, capacidades de codificación y comprensión multimodal prometen revolucionar la forma en que construimos aplicaciones. Sin embargo, acceder a modelos de vanguardia a menudo trae consigo preguntas sobre costo y disponibilidad. Muchos desarrolladores se preguntan: "¿Cómo puedo usar Gemini 2.5 Pro de forma gratuita?" Aunque el acceso directo y ilimitado a la API generalmente implica costos, existen formas legítimas de interactuar con este poderoso modelo sin ningún costo, principalmente a través de su interfaz web, e incluso programáticamente a través de proyectos comunitarios.

La Forma Oficial de Usar Gemini 2.5 Pro de Forma Gratuita: La Interfaz Web

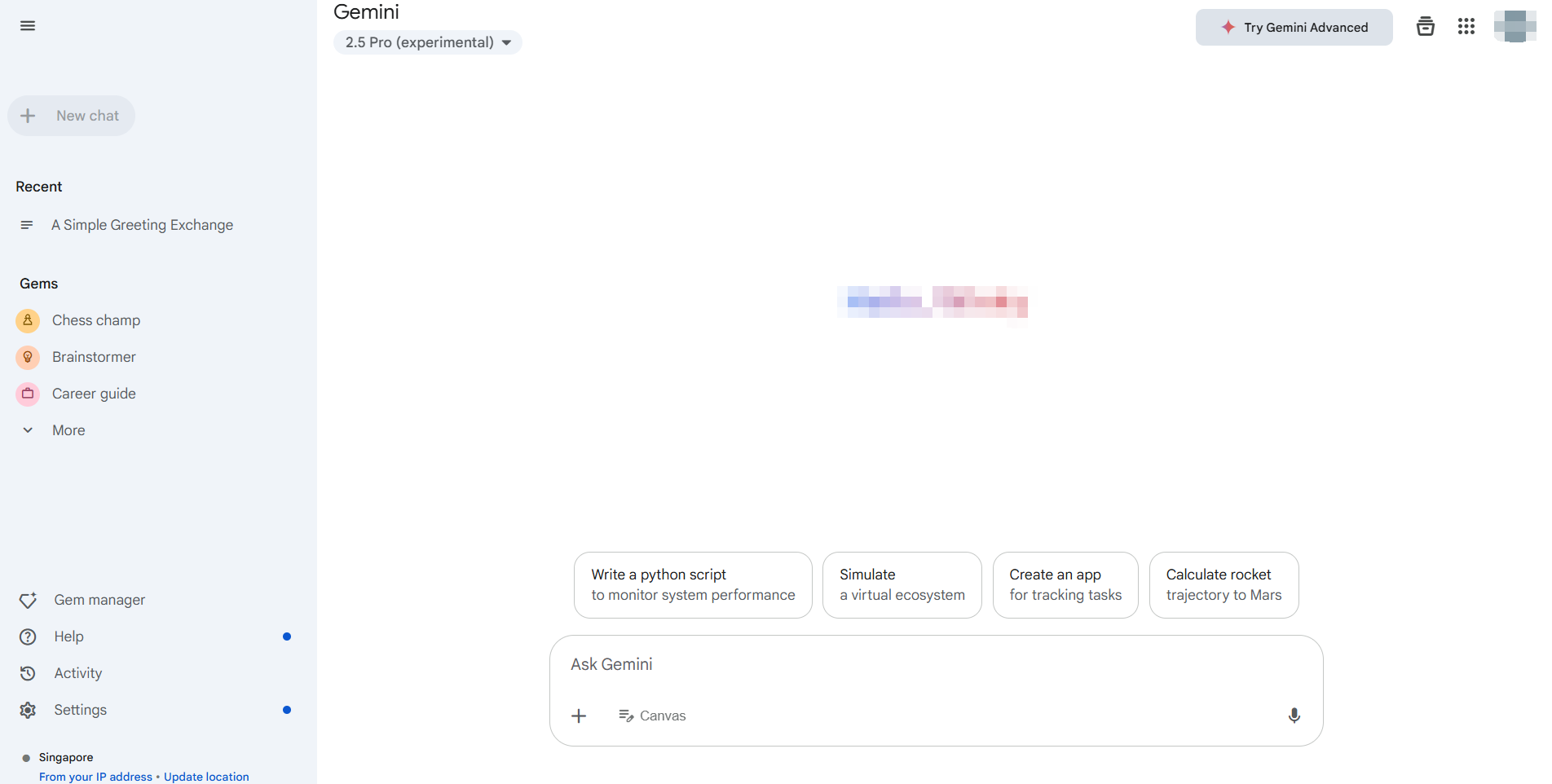

El método más directo y oficialmente respaldado para usar Gemini 2.5 Pro sin ningún costo es a través de su aplicación web dedicada, accesible típicamente en https://gemini.google.com/. Google proporciona acceso a sus últimos modelos, incluido Gemini 2.5 Pro (la disponibilidad puede variar según la región y el estado de la cuenta), a través de esta interfaz para usuarios generales.

Ventajas Clave de la Interfaz Web:

- Costo Cero: Esta es la oferta estándar de nivel gratuito que permite la interacción directa.

- Acceso Completo a Funciones: Generalmente puedes aprovechar las capacidades centrales del modelo, incluyendo generación de texto, lluvia de ideas, asistencia en codificación, y potencialmente generación de imágenes (como con Imagen3, sujeto a disponibilidad) e interacciones con extensiones de Google Workspace (Gmail, Docs, Drive, etc.).

- Interfaz de Usuario Amigable: La interfaz web está diseñada para ser fácil de usar, sin requerir configuración más allá de iniciar sesión en tu cuenta de Google.

Cómo Usarlo:

- Navega a la aplicación web de Gemini.

- Inicia sesión con tu Cuenta de Google.

- Asegúrate de que Gemini 2.5 Pro esté seleccionado si hay múltiples modelos disponibles (a menudo indicado en la configuración o cerca de la entrada de mensaje).

5. ¡Comienza a interactuar! Escribe tus mensajes, sube archivos (si es compatible) y explora sus capacidades.

Para muchos usuarios y desarrolladores que necesitan evaluar Gemini 2.5 Pro, probar mensajes o realizar tareas no programáticas, la interfaz web oficial es la solución ideal y sin costo. Proporciona acceso directo al poder del modelo sin requerir claves API o lidiar con cuotas de uso asociadas a la API de pago. Este método aborda perfectamente la necesidad de usar Gemini 2.5 Pro de forma gratuita para exploración e interacción manual.

Cómo Usar Gemini 2.5 Pro Programáticamente Sin Costo Directo de API

Si bien la interfaz web es excelente para uso manual, los desarrolladores a menudo necesitan acceso programático para integración, automatización o procesamiento por lotes. La API oficial de IA Generativa de Google para modelos como Gemini 2.5 Pro generalmente implica costos basados en el uso de tokens. Sin embargo, la comunidad de desarrolladores a menudo crea herramientas para cerrar esta brecha.

Una de esas herramientas, destacada en recursos comunitarios como la biblioteca de Python de Gemini API, permite a los desarrolladores interactuar con la interfaz web gratuita de Gemini programáticamente.

Advertencia Crucial: Es esencial entender que esto NO es la API oficial de IA Generativa de Google. Estas bibliotecas funcionan mediante la ingeniería inversa de las llamadas a la API privada de la aplicación web y utilizando cookies del navegador para la autenticación.

- No Oficial: No es soportado ni respaldado por Google.

- Potencialmente Inestable: Se basa en elementos de la interfaz web que pueden cambiar sin previo aviso, rompiendo la biblioteca.

- Consideraciones de Seguridad: Requiere extraer cookies de autenticación de tu navegador, lo que conlleva riesgos de seguridad inherentes si no se maneja con cuidado.

- Términos de Servicio: El uso podría violar los términos de servicio de Google para la aplicación web.

A pesar de estas advertencias, tales bibliotecas ofrecen una forma para que los desarrolladores experimenten y usen Gemini 2.5 Pro sin ningún costo más allá de las limitaciones del nivel gratuito de la interfaz web, pero de manera automatizada.

Guía Paso a Paso:

Requisitos Previos: Asegúrate de tener Python 3.10+ instalado.

Instalación: Instala la biblioteca usando pip:

pip install -U gemini_webapi

# Opcional: Instala browser-cookie3 para facilitar la obtención de cookies

pip install -U browser-cookie3Autenticación (La Parte Difícil):

- Inicia sesión en

gemini.google.comen tu navegador web. - Abre las Herramientas para Desarrolladores (F12), ve a la pestaña

Redy actualiza la página. - Encuentra una solicitud (cualquier solicitud suele funcionar).

- En los encabezados de la solicitud (generalmente bajo "Cookies"), encuentra y copia los valores de

__Secure-1PSIDy__Secure-1PSIDTS. ¡Trátalos como contraseñas! - Alternativa: Si

browser-cookie3está instalado, la biblioteca podría ser capaz de importar cookies automáticamente si estás conectado a través de un navegador compatible, simplificando este paso pero aún dependiendo del estado local del navegador.

Inicialización y Uso Básico:

import asyncio

from gemini_webapi import GeminiClient

from gemini_webapi.constants import Model # Importar constantes del modelo

# --- Autenticación ---

# Método 1: Pegar cookies manualmente (¡manejar de forma segura!)

Secure_1PSID = "TU_VALOR_DE_COOKIE__SECURE_1PSID"

Secure_1PSIDTS = "TU_VALOR_DE_COOKIE__SECURE_1PSIDTS" # Puede ser opcional

async def run_gemini():

# Método 2: Usar browser-cookie3 (si está instalado y conectado)

# client = GeminiClient(proxy=None) # Intenta importar cookies automáticamente

# Inicializar con cookies manuales

client = GeminiClient(Secure_1PSID, Secure_1PSIDTS, proxy=None)

await client.init(timeout=30) # Inicializar conexión

# --- Seleccionar Modelo y Generar Contenido ---

prompt = "Explica la diferencia entre las APIs REST y GraphQL."

# Usar el identificador del modelo Gemini 2.5 Pro

print(f"Enviando mensaje a Gemini 2.5 Pro...")

response = await client.generate_content(prompt, model=Model.G_2_5_PRO) # Usar el modelo específico

print("\nRespuesta:")

print(response.text)

# Cerrar la sesión del cliente (importante para la gestión de recursos)

await client.close()

if __name__ == "__main__":

asyncio.run(run_gemini())Consulta más detalles de integración aquí.

Explorando Más: Bibliotecas como esta a menudo soportan funciones disponibles en la interfaz web, como chat de múltiples turnos (client.start_chat()), subidas de archivos, solicitudes de generación de imágenes y el uso de extensiones (@Gmail, @Youtube), reflejando las capacidades de la aplicación web de manera programática.

Recuerda, este enfoque automatiza la interacción con el nivel web gratuito, no con la API de pago. Permite la experimentación programática con Gemini 2.5 Pro sin costo directo de API, pero viene con importantes advertencias de fiabilidad y seguridad.

El Desafío de Depuración con LLMs

Ya sea que interactúes con Gemini 2.5 Pro a través de la web, la API oficial o bibliotecas no oficiales, entender y depurar las respuestas es crucial, especialmente al tratar con salidas complejas o en streaming. Muchos LLMs, particularmente en forma de API, utilizan Eventos Enviados por el Servidor (SSE) para transmitir respuestas token por token o por fragmentos. Esto proporciona una sensación de tiempo real pero puede ser difícil de depurar usando clientes HTTP estándar.

Las herramientas de prueba de API tradicionales pueden simplemente mostrar datos SSE en bruto: fragmentos, lo que dificulta juntar el mensaje completo o entender el flujo de información, particularmente el "proceso de pensamiento" del modelo si se proporciona. Aquí es donde una herramienta especializada se vuelve invaluable.

Presentamos Apidog: Una plataforma integral de desarrollo de API diseñada para manejar todo el ciclo de vida de la API: desde el diseño y la documentación hasta la depuración, pruebas automatizadas y simulación. Si bien es poderosa en todos los aspectos, Apidog destaca particularmente en el manejo de protocolos de API modernos, convirtiéndola en una excepcional herramienta de prueba de API para los desarrolladores que trabajan con LLMs. Sus funciones de depuración de SSE están específicamente construidas para abordar los desafíos de las respuestas en streaming.

Domina las Respuestas en Tiempo Real de LLM

Trabajar con LLMs como Gemini 2.5 Pro a menudo implica Eventos Enviados por el Servidor (SSE) para transmitir resultados. Esta tecnología permite que el modelo de IA envíe datos a tu cliente en tiempo real, mostrando texto generado o incluso pasos de razonamiento a medida que ocurren. Aunque es excelente para la experiencia del usuario, depurar flujos SSE en bruto en herramientas básicas puede ser una pesadilla de mensajes fragmentados.

Apidog, como una de las principales herramientas de prueba de API, transforma la depuración de SSE de una tarea tediosa a un proceso claro. Así es como Apidog te ayuda a controlar los flujos de LLM:

- Detección Automática de SSE: Cuando envías una solicitud a un punto final de LLM utilizando Apidog, si el encabezado de respuesta

Content-Typeestext/event-stream, Apidog lo reconoce automáticamente como un flujo SSE. - Vista de Línea de Tiempo en Tiempo Real: En lugar de simplemente volcar líneas de

data:en bruto, Apidog presenta los mensajes entrantes cronológicamente en una vista dedicada de "Línea de Tiempo". Esto te permite ver el flujo de información exactamente como lo envía el servidor. - Fusión Automática Inteligente: Esto es un cambio radical para la depuración de SSE de LLM. Apidog tiene inteligencia integrada para reconocer formatos de transmisión comunes utilizados por los principales proveedores de IA, incluyendo:

- Formato Compatible con API de OpenAI (utilizado por muchos)

- Formato Compatible con API de Gemini

- Formato Compatible con API de Claude

- Formato Compatible con API de Ollama (para modelos ejecutados localmente, a menudo JSON Streaming/NDJSON)

Si el flujo coincide con estos formatos, Apidog fusiona automáticamente los fragmentos de mensaje individuales (data: fragmentos) en la respuesta final coherente completa o en pasos intermedios. ¡No más copiar y pegar fragmentos manualmente! Ves el panorama completo como la IA lo pretendía.

4. Visualizando el Proceso de Pensamiento: Para modelos que transmiten su razonamiento o "pensamientos" junto con el contenido principal (como ciertas configuraciones de DeepSeek), Apidog a menudo puede mostrar esta información meta de manera clara dentro de la línea de tiempo, proporcionando información invaluable sobre el proceso del modelo.

Usar Apidog para depuración de SSE significa que obtienes una vista clara, en tiempo real, y a menudo estructurada automáticamente de cómo está respondiendo tu punto final de LLM. Esto facilita significativamente la identificación de problemas, la comprensión del proceso de generación y la garantía de que la salida final sea correcta en comparación con clientes HTTP genéricos o herramientas de prueba de API tradicionales que carecen de manejo especializado de SSE.

Conclusión: Accediendo a Gemini 2.5 Pro de Forma Gratuita

Puedes explorar Gemini 2.5 Pro de forma gratuita a través de su interfaz web oficial. Los desarrolladores que buscan acceso similar a la API sin tarifas pueden probar herramientas construidas por la comunidad, aunque estas conllevan riesgos como inestabilidad y posibles problemas con los términos de servicio.

Para trabajar con LLMs como Gemini—especialmente al tratar con respuestas en streaming—las herramientas tradicionales se quedan cortas. Ahí es donde Apidog brilla. Con funciones como detección automática de SSE, vistas de línea de tiempo y fusión inteligente de datos fragmentados, Apidog facilita mucho la depuración de respuestas en tiempo real. Su soporte de análisis personalizado además agiliza flujos de trabajo complejos, convirtiéndola en una herramienta imprescindible para el desarrollo moderno de API y LLM.