Seamos realistas: los asistentes de codificación de IA como GitHub Copilot son fantásticos, pero sus costes de suscripción pueden hacer un agujero en tu bolsillo. Presentamos DeepSeek R1, un modelo de lenguaje de código abierto y gratuito que rivaliza con GPT-4 y Claude 3.5 en tareas de razonamiento y codificación. Combínalo con Cline, un plugin de VS Code que convierte esta IA en un agente de codificación completo, y tendrás una configuración potente que escribe, depura e incluso ejecuta código de forma autónoma, todo ello sin gastar un céntimo.

En esta guía, te guiaré a través de todo lo que necesitas saber, desde la instalación de Cline hasta la optimización de DeepSeek R1 para tus proyectos. ¡Empecemos!

¿Qué hace que DeepSeek R1 sea especial?

1. Es gratis (¡sí, de verdad!)

A diferencia de los modelos propietarios, DeepSeek R1 es totalmente de código abierto y se puede utilizar comercialmente. Sin límites de tokens, sin tarifas ocultas, solo potencia de IA pura.

2. Rendimiento que rivaliza con los modelos de pago

DeepSeek R1 destaca en codificación, matemáticas y razonamiento lógico. Por ejemplo, su variante de parámetro 32B supera al o1-mini de OpenAI en los puntos de referencia de generación de código, y su modelo de 70B iguala a Claude 3.5 Sonnet en tareas complejas.

3. Opciones de implementación flexibles

Ejecútalo localmente para mayor privacidad y velocidad, o utiliza la asequible API de DeepSeek (tan solo 0,01 $ por millón de tokens) para acceder desde la nube.

Configuración de DeepSeek R1 en VS Code con Cline

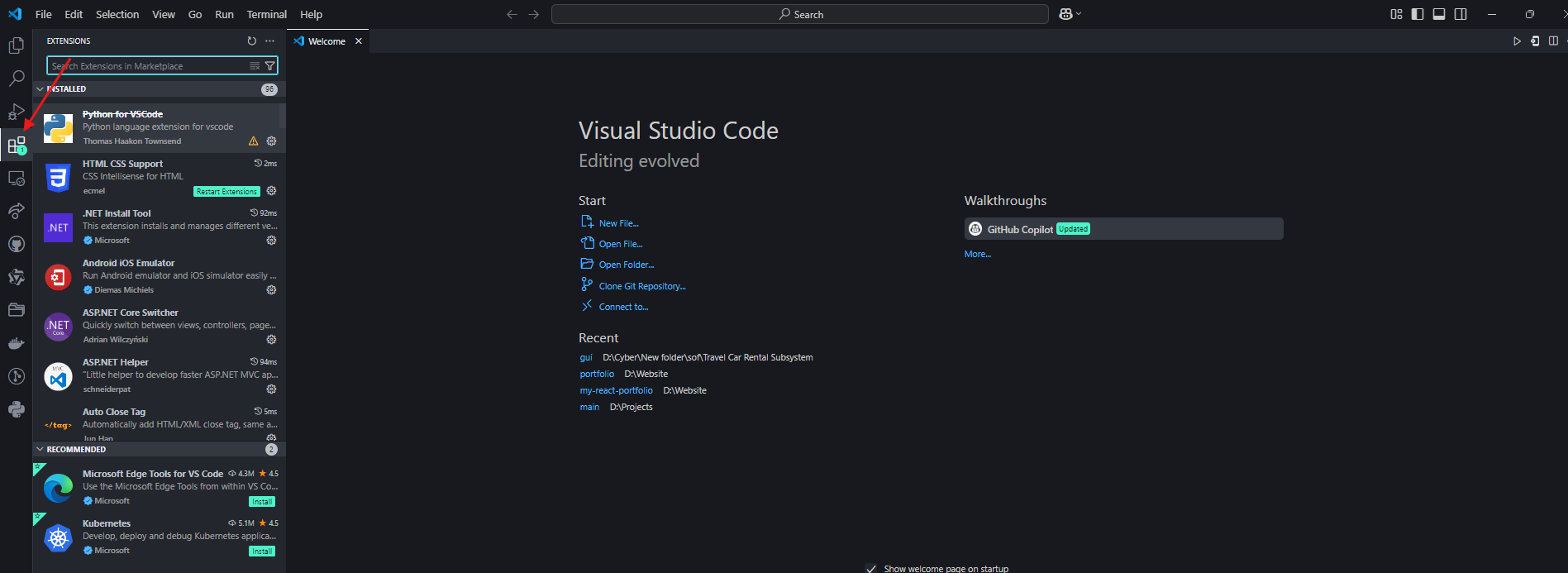

Paso 1: Instala el plugin de Cline

- Abre VS Code y navega a la pestaña Extensiones.

2. Busca "Cline" e instálalo.

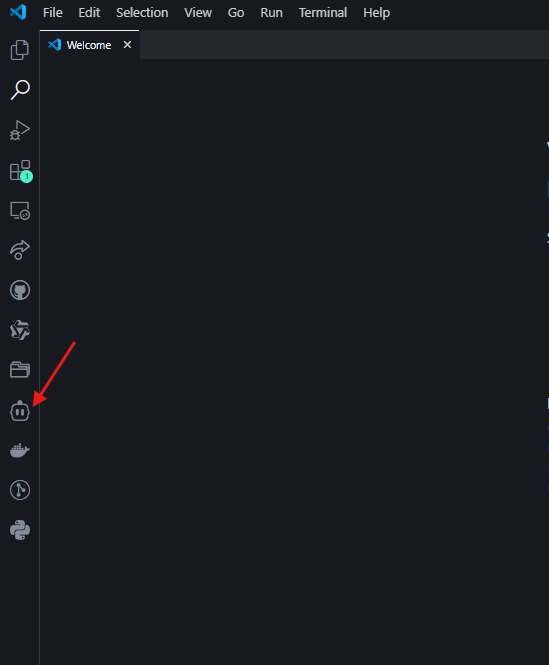

3. Haz clic en el icono del robot en la barra lateral izquierda para activar Cline.

Paso 2: Elige tu flujo de trabajo de DeepSeek R1

Opción A: Configuración local (gratuita, prioriza la privacidad)

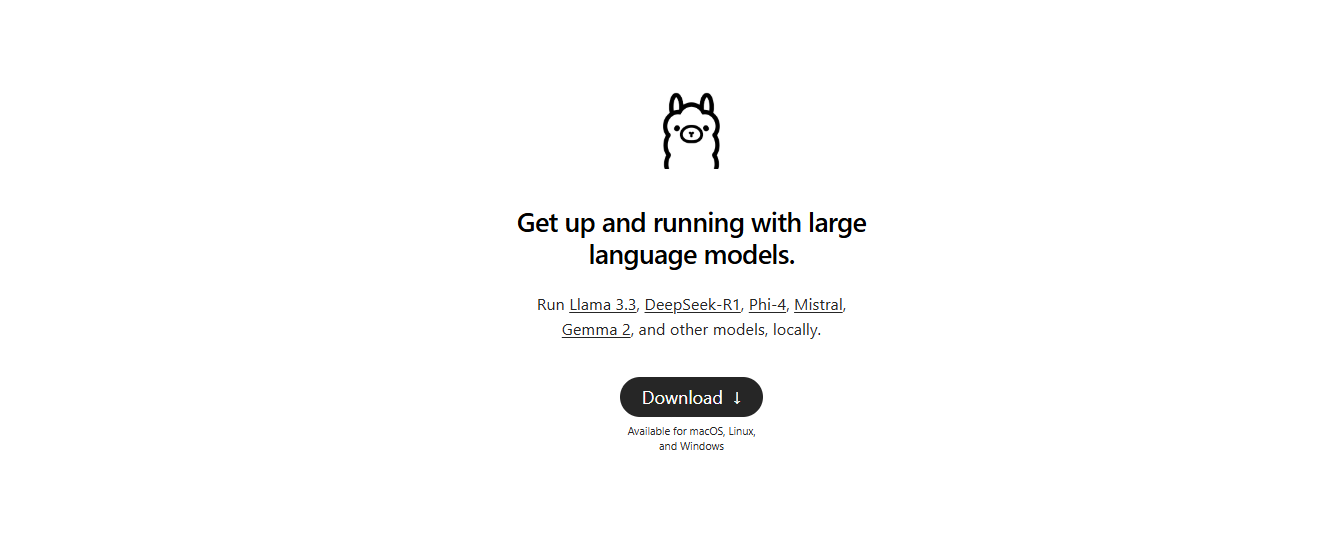

- Instala Ollama: Descárgalo de ollama.com para gestionar los modelos de IA locales.

2. Extrae el modelo: En tu terminal, ejecuta:

ollama pull deepseek-r1:14b # Para hardware de nivel medio (p. ej., RTX 3060)

Los modelos más pequeños como 1.5b funcionan para tareas básicas, pero se recomienda 14B+ para la codificación.

- Configura Cline:

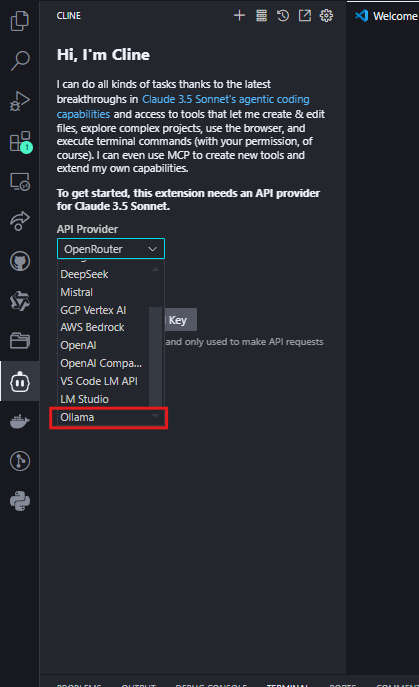

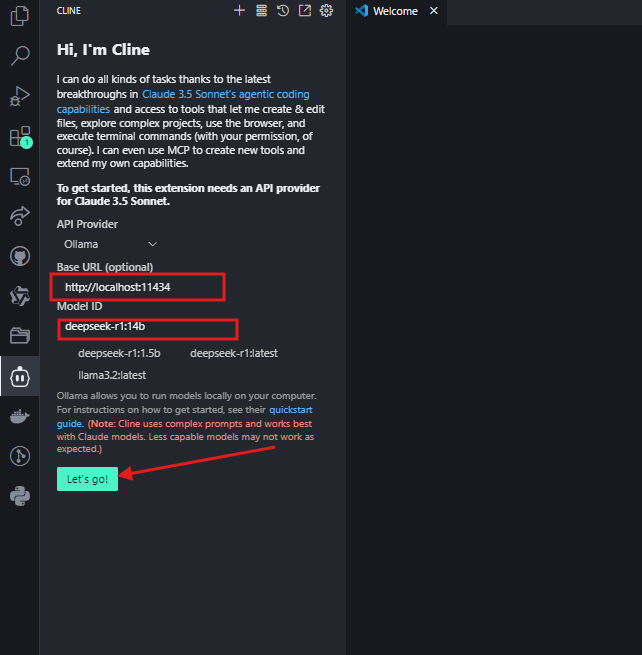

- Establece el proveedor de API en "Ollama".

- Introduce

http://localhost:11434como URL base y selecciona tu modelo (p. ej.,deepseek-r1:14b).

Haz clic en "¡Vamos!" y ya puedes usarlo.

Opción B: Integración de OpenRouter (cambio de modelo flexible)

Para los desarrolladores que desean acceder a múltiples modelos de IA (incluido DeepSeek R1) a través de una única clave API, OpenRouter ofrece una solución optimizada. Esto es ideal si ocasionalmente necesitas comparar salidas con modelos como GPT-4 o Claude, pero quieres DeepSeek R1 como tu opción predeterminada.

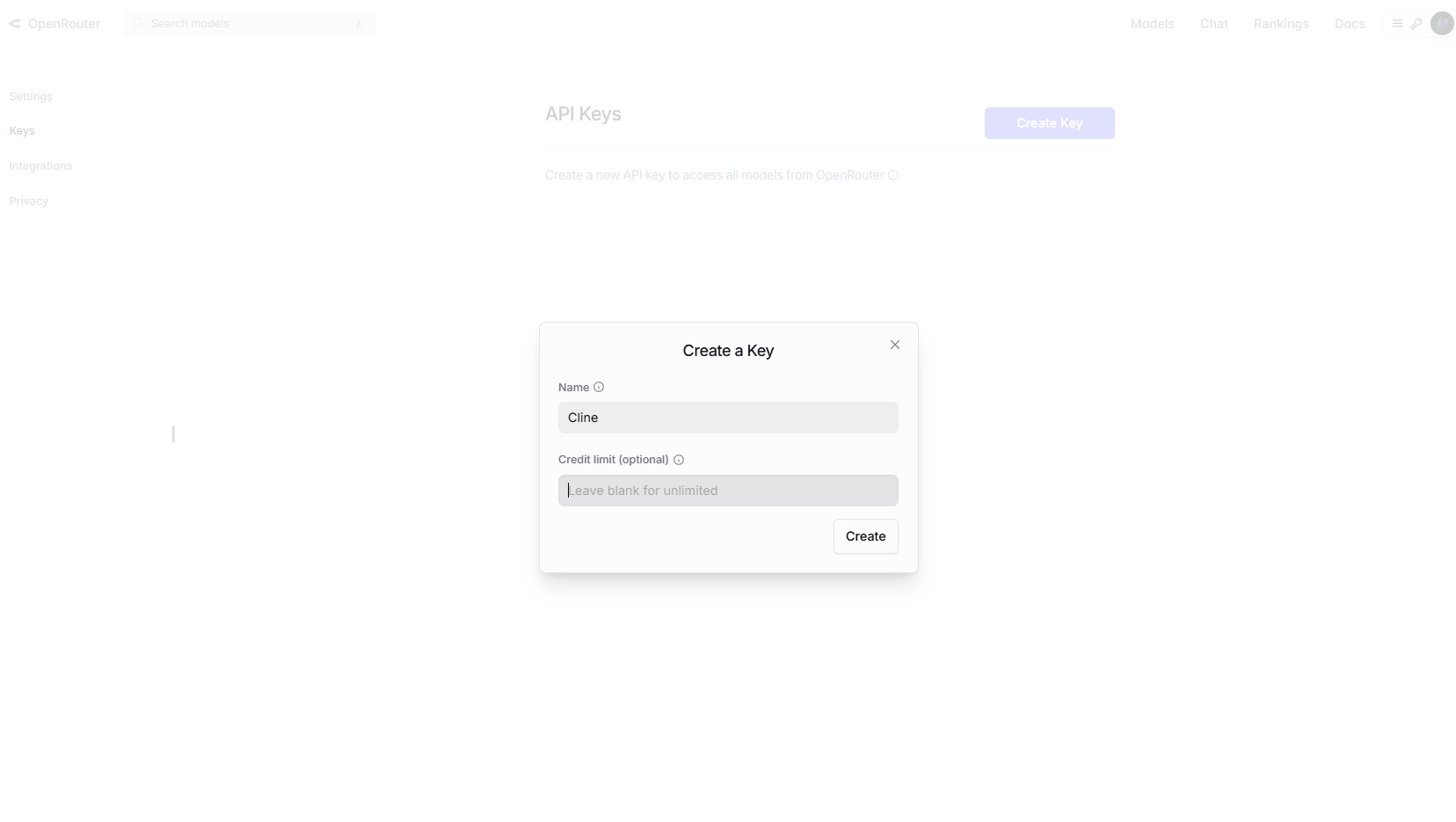

Paso 1: Obtén tu clave API de OpenRouter

- Visita OpenRouter.ai y regístrate.

- Navega a Claves API y crea una nueva clave.

Opcional: Activa los límites de gasto en la configuración de la cuenta para controlar los costes.

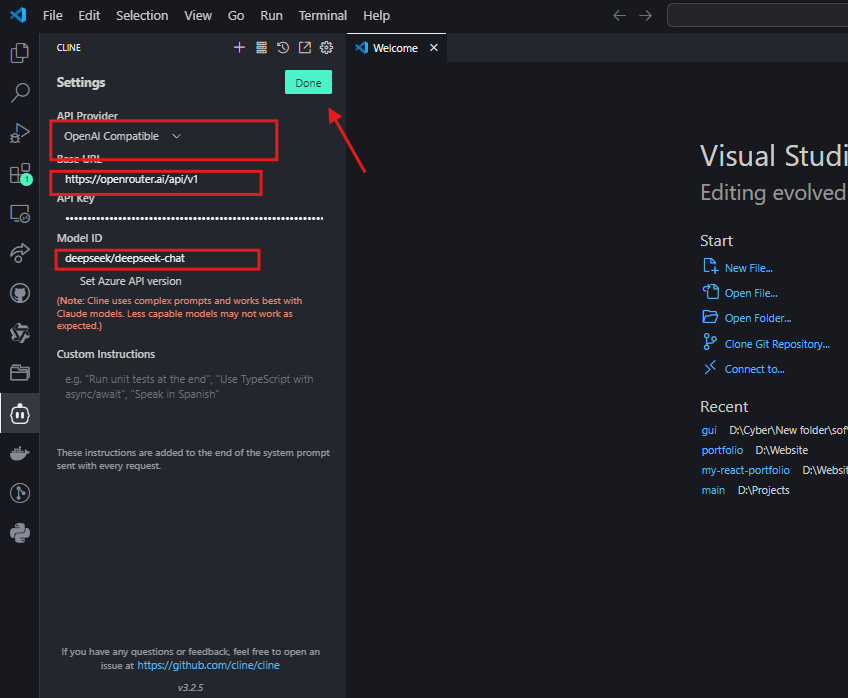

Paso 2: Configura Cline para OpenRouter

- En VS Code, abre la configuración de Cline.

- Selecciona "Compatible con OpenAI" como proveedor de API.

- Establece la URL base en

https://openrouter.ai/api/v1. - Pega tu clave API de OpenRouter.

- En el campo ID del modelo, introduce

deepseek/deepseek-chat

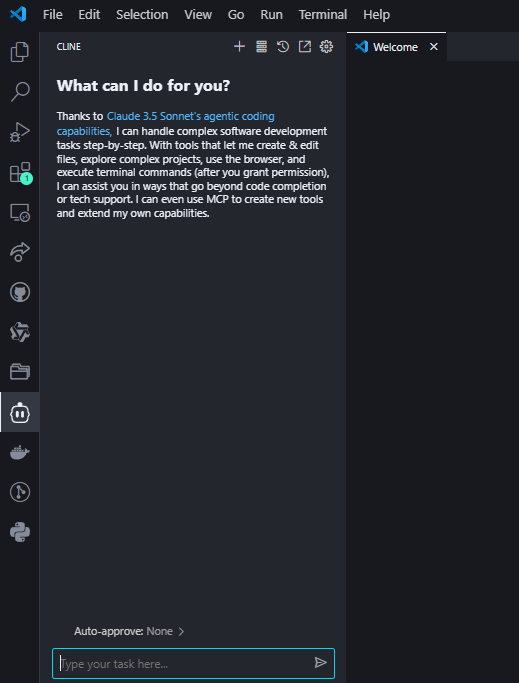

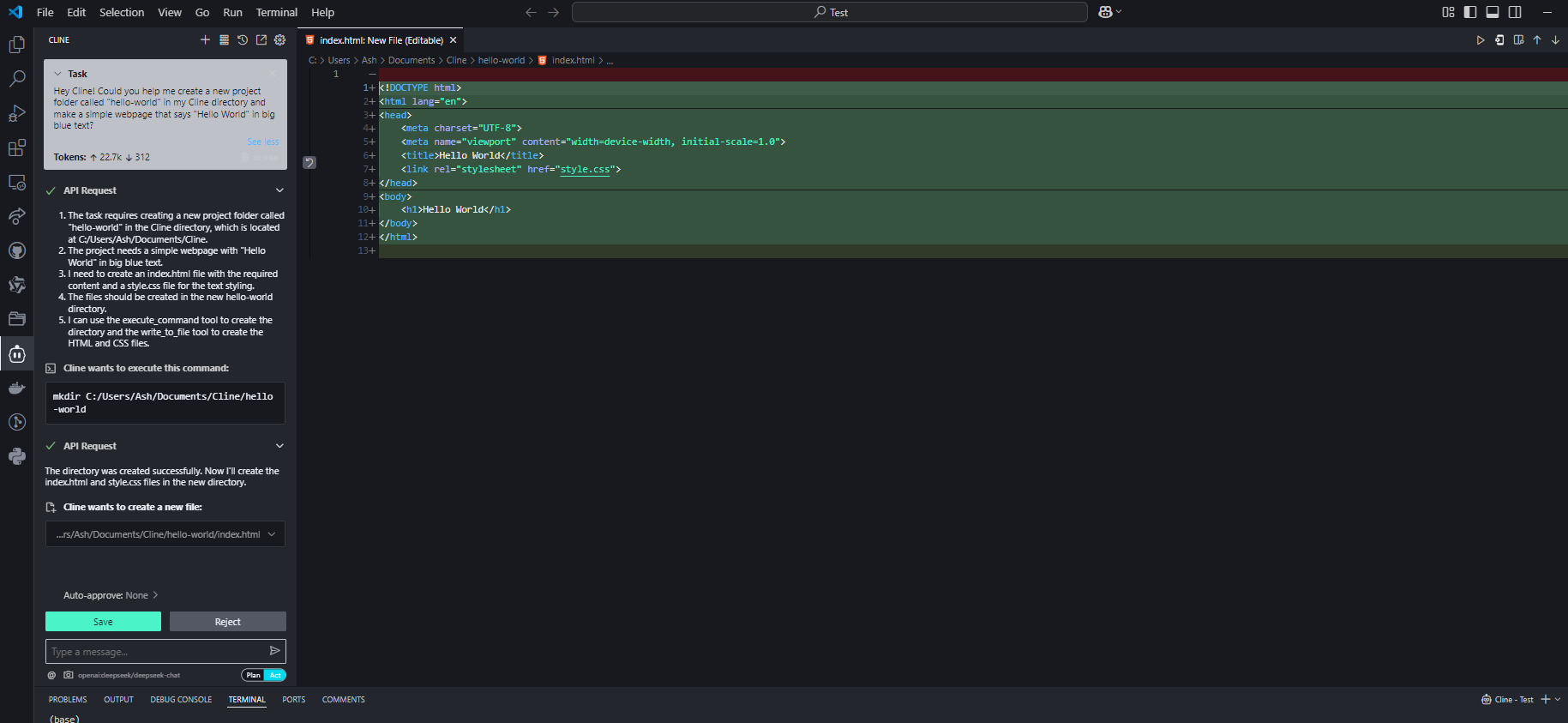

Paso 3: Prueba la integración

Hazle a Cline una pregunta de codificación para confirmar la configuración:

Si está configurado correctamente, DeepSeek R1 generará código con explicaciones en la interfaz de Cline.

¿Por qué elegir OpenRouter?

- Acceso a múltiples modelos: Cambia fácilmente entre DeepSeek R1 y más de 50 modelos (p. ej., GPT-4, Claude) sin reconfigurar las API4.

- Transparencia de costes: Realiza un seguimiento del uso de tokens en todos los modelos en un solo panel4.

- Soporte de respaldo: Enruta automáticamente las solicitudes a modelos de respaldo si la API de DeepSeek R1 está sobrecargada4.

Consideraciones sobre los costes

Si bien los precios de OpenRouter para DeepSeek R1 se alinean estrechamente con los costes directos de la API (~0,01 $ por millón de tokens de entrada), siempre consulta su página de precios para conocer las tarifas en tiempo real. Para los usuarios intensivos, la facturación unificada de OpenRouter puede simplificar la gestión de gastos25.

Consejos profesionales para optimizar el rendimiento

1. Tamaño del modelo vs. Hardware

| Modelo | RAM necesaria | GPU recomendada |

|---|---|---|

| 1.5B | 4GB | Integrada |

| 7B | 8–10GB | NVIDIA GTX 1660 |

| 14B | 16GB+ | RTX 3060/3080 |

| 70B | 40GB+ | RTX 4090/A100 |

Consejo: Los modelos cuantificados (p. ej., Q4_K_M.gguf) reducen el uso de VRAM en un 30% sin una gran pérdida de calidad.

2. Ingeniería de prompts

- Para código: Incluye instrucciones explícitas como "Usa Python 3.11 y sugerencias de tipo".

- Para depurar: Pega los registros de errores y pregunta "Explica este error y corrígelo".

Solución de problemas comunes

1. Respuestas lentas

- Solución: Cambia a un modelo más pequeño o activa la aceleración de la GPU en Ollama con

OLLAMA_GPU_LAYERS=12.

2. Alucinaciones o respuestas fuera de lugar

- Solución: Usa prompts más estrictos (p. ej., "Responde usando solo el contexto proporcionado") o actualiza a modelos más grandes como 32B.

3. Cline ignora el contexto del archivo

- Solución: Siempre proporciona rutas de archivo completas (p. ej.,

/src/components/Login.jsx) en lugar de referencias vagas.

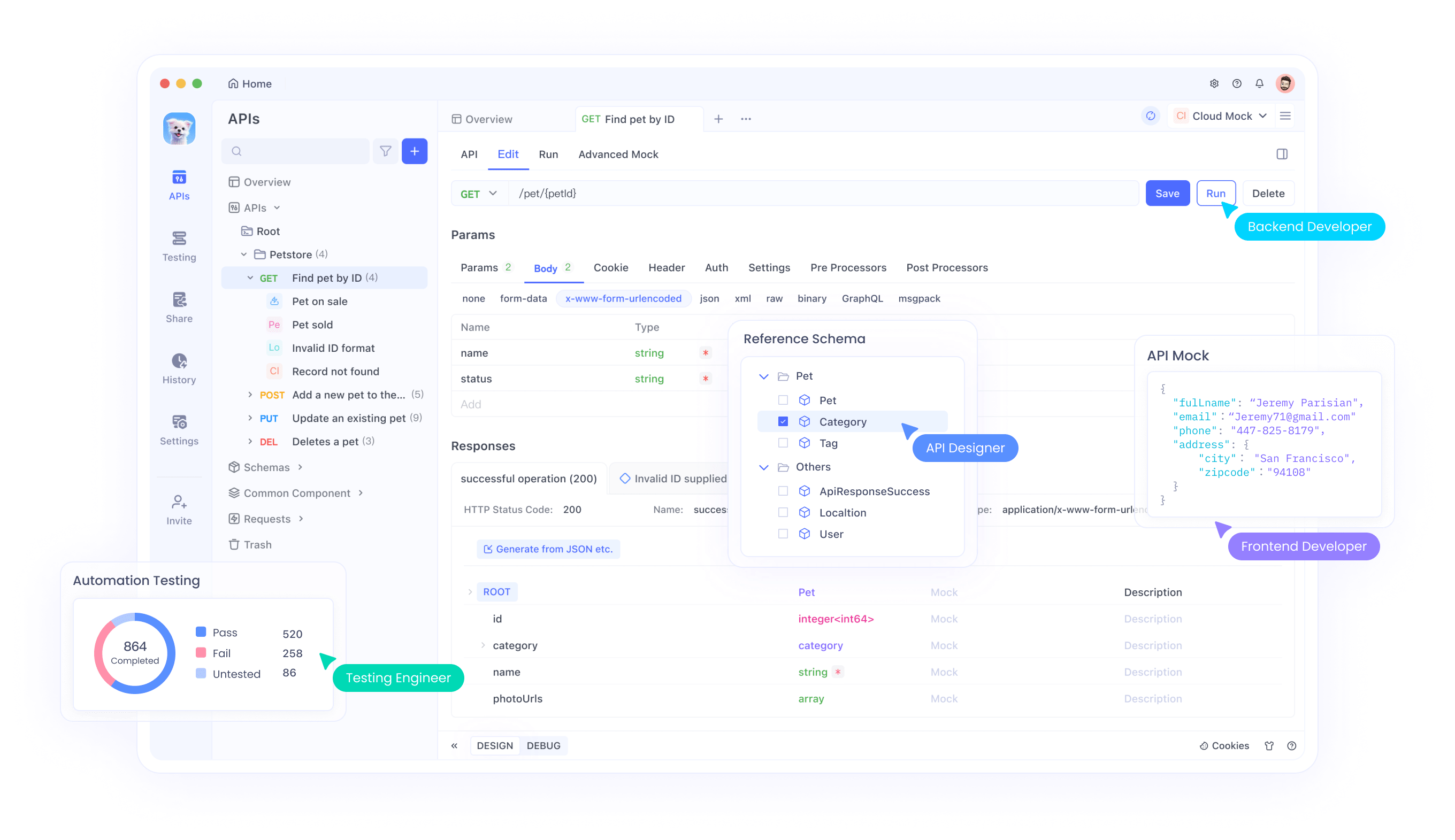

Casos de uso avanzados con la integración de Apidog

Una vez que tu configuración de DeepSeek R1 + Cline esté en funcionamiento, usa Apidog para:

- Probar puntos finales de API: Valida las respuestas de DeepSeek mediante programación.

- Automatizar flujos de trabajo: Encadena la generación de código de Cline con llamadas a la API (p. ej., implementa un script generado en AWS).

- Supervisar el rendimiento: Realiza un seguimiento de la latencia y la precisión a lo largo del tiempo.

Resumiendo: por qué esta combinación gana

DeepSeek R1 y Cline no son solo herramientas, son un cambio de paradigma. Obtienes la inteligencia de nivel GPT-4 sin el coste, control total sobre la privacidad y un flujo de trabajo que se siente como emparejarse con un desarrollador sénior.

¿Listo para sobrecargar tu codificación?

- Instala Cline y Ollama.

- Elige tu modelo de DeepSeek R1.

- Construye algo increíble, ¡y házmelo saber!

No olvides descargar Apidog para optimizar las pruebas y la automatización de la API. ¡Es el compañero perfecto para tu viaje de codificación impulsado por la IA!