Los desarrolladores buscan constantemente modelos de IA robustos que ofrezcan resultados fiables sin costes ni complejidad excesivos. Baidu aborda esta necesidad con ERNIE X1.1, un modelo de razonamiento de vanguardia que mejora la precisión fáctica, el seguimiento de instrucciones y las capacidades de agencia. Lanzado en la Wave Summit 2025, este modelo se basa en los fundamentos de ERNIE 4.5, incorporando aprendizaje por refuerzo de extremo a extremo para un rendimiento superior. Los usuarios acceden a él a través de ERNIE Bot, la aplicación Wenxiaoyan o la plataforma Qianfan Model-as-a-Service (MaaS) a través de API, lo que lo hace versátil tanto para aplicaciones individuales como empresariales.

Este artículo te guía a través de cada aspecto del uso de la API de ERNIE X1.1. Comenzamos con una visión general del modelo, luego pasamos a los procedimientos de configuración y, finalmente, exploramos escenarios de uso avanzados. Siguiendo estos pasos, integrarás ERNIE X1.1 de manera eficiente en tus flujos de trabajo.

¿Qué es ERNIE X1.1? Características y Capacidades Clave

Baidu diseña ERNIE X1.1 como un modelo de razonamiento multimodal de pensamiento profundo que aborda tareas complejas que implican planificación lógica, reflexión y evolución. Reduce significativamente las alucinaciones, mejora la adherencia a las instrucciones en un 12,5% y aumenta las funciones de agencia en un 9,6% en comparación con su predecesor, ERNIE X1. Además, logra una precisión fáctica un 34,8% mayor, lo que lo hace ideal para aplicaciones como preguntas y respuestas de conocimiento, generación de contenido y llamadas a herramientas.

El modelo admite ventanas de contexto extensas, hasta 32K tokens en algunas variantes, lo que le permite procesar entradas de formato largo sin perder coherencia. Los desarrolladores aprovechan sus capacidades multimodales para manejar texto, imágenes e incluso análisis de video, expandiendo los casos de uso más allá de los modelos de lenguaje tradicionales. Por ejemplo, ERNIE X1.1 identifica el contenido de las imágenes con precisión y simula escenarios físicos, como partículas en un contenedor 3D giratorio.

Además, ERNIE X1.1 prioriza la fiabilidad al proporcionar información precisa sobre instrucciones engañosas, lo que lo distingue en entornos críticos para la seguridad. Baidu lo implementa en la plataforma Qianfan, asegurando la escalabilidad para llamadas API de alto volumen. Esta configuración permite una integración perfecta con los sistemas existentes, ya sea que construyas chatbots, motores de recomendación o herramientas de análisis de datos.

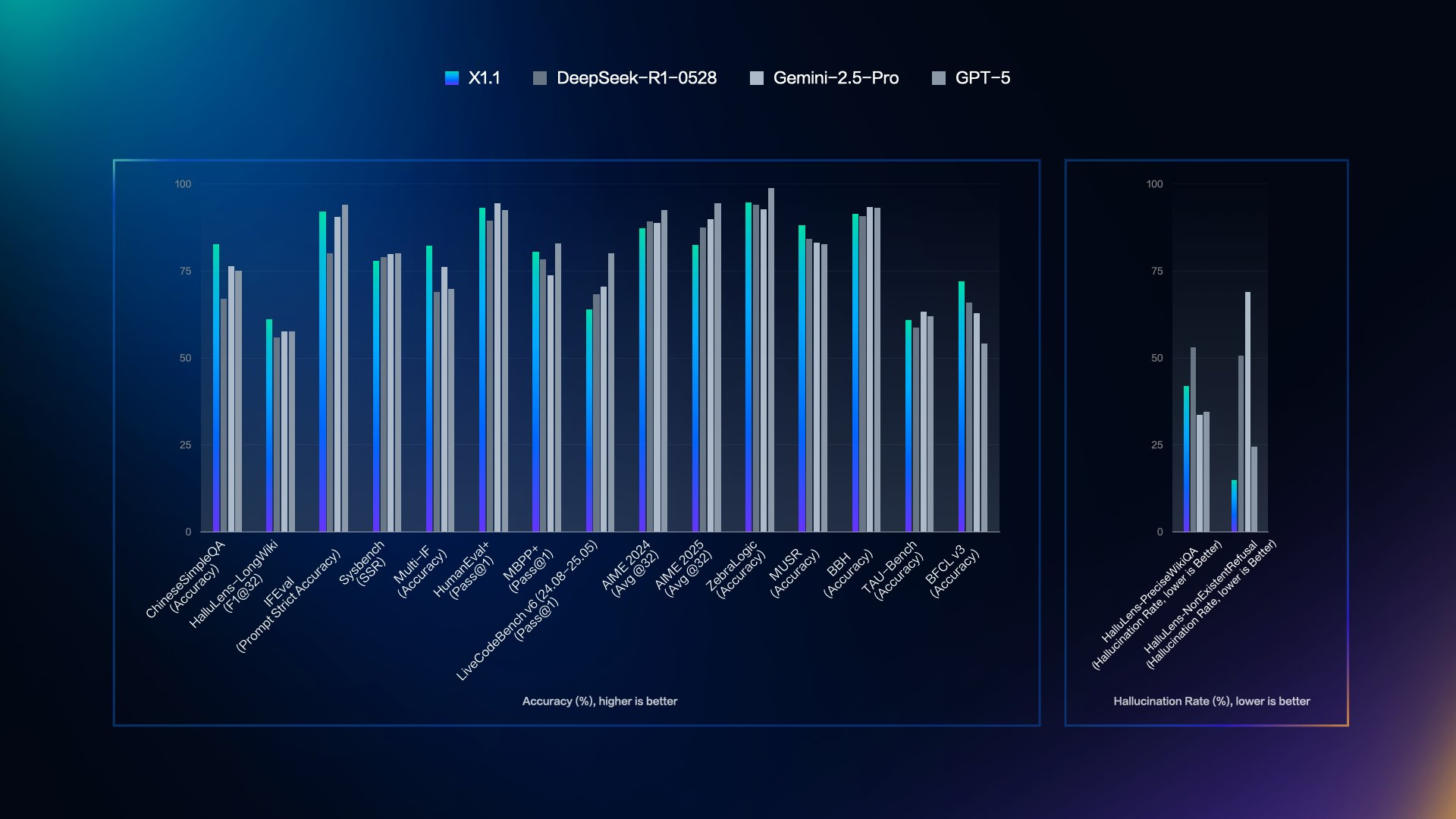

Pasando a las métricas de rendimiento, ERNIE X1.1 demuestra dominio en los benchmarks, como se muestra en evaluaciones recientes.

Rendimiento de ERNIE X1.1 en Benchmarks: Superando a la Competencia

Baidu evalúa ERNIE X1.1 frente a modelos superiores como DeepSeek R1-0528, Gemini 2.5 Pro y GPT-5, revelando sus puntos fuertes en precisión y bajas tasas de alucinación. Una visualización clave del lanzamiento ilustra estas comparaciones en múltiples benchmarks.

En contraste, el panel de tasa de alucinación cubre HalluQA (Hallu-Precision, menor no existente es mejor), Hallu Lens (Tasa, menor es mejor) y otros. Aquí, ERNIE X1.1 muestra las barras más bajas, lo que indica errores mínimos, por ejemplo, menos del 25% en HalluQA.

Estos datos subrayan cómo ERNIE X1.1 supera a DeepSeek en rendimiento general mientras se mantiene a la par con GPT-5. Los desarrolladores se benefician de estas métricas al seleccionar modelos para tareas que exigen precisión. Ahora, pasemos a la implementación práctica configurando el acceso.

Primeros Pasos con la API de ERNIE X1.1 en la Plataforma Qianfan

Comienza registrándote en la plataforma Wenxin Qianfan de Baidu AI Cloud. Visita el sitio oficial y crea una cuenta de desarrollador usando tu correo electrónico o número de teléfono. Una vez verificado, solicita acceso a la API para los modelos ERNIE. Baidu revisa las solicitudes rápidamente, a menudo en cuestión de horas, otorgándote tu ID de cliente y claves secretas.

A continuación, instala los SDK necesarios. Los usuarios de Python emplean el SDK de Qianfan a través de pip: pip install qianfan. Esta biblioteca maneja la autenticación y las solicitudes de manera eficiente. Para otros lenguajes como Java o Go, Baidu proporciona SDK equivalentes con interfaces similares.

Después de la instalación, configura tus variables de entorno. Establece QIANFAN_AK a tu clave de acceso y QIANFAN_SK a tu clave secreta. Este paso asegura tus credenciales sin codificarlas en los scripts. Con la configuración completa, puedes proceder a la autenticación.

Autenticación de Solicitudes a la API de ERNIE X1.1

La plataforma Qianfan utiliza OAuth 2.0 para la autenticación. Generas un token de acceso enviando una solicitud POST al endpoint del token. En Python, el SDK de Qianfan automatiza este proceso. Para una implementación manual, construye una solicitud como esta:

import requests

url = "https://aip.baidubce.com/oauth/2.0/token"

params = {

"grant_type": "client_credentials",

"client_id": "TU_ID_DE_CLIENTE",

"client_secret": "TU_SECRETO_DE_CLIENTE"

}

response = requests.post(url, params=params)

access_token = response.json()["access_token"]

Almacena el token, que expira después de 30 días, y actualízalo según sea necesario. Adjúntalo a las llamadas API a través del parámetro de consulta access_token. Este método garantiza una comunicación segura. Sin embargo, siempre maneja los tokens con cuidado para evitar su exposición.

Una vez autenticado, dirígete a los endpoints apropiados para ERNIE X1.1.

Endpoints y Estructura de Solicitud de la API de ERNIE X1.1

Baidu estructura las API de ERNIE bajo la ruta /chat. Para ERNIE X1.1, usa el endpoint /chat/ernie-x1.1 o /chat/ernie-x1.1-32k para un contexto extendido, según las variantes disponibles. Confirma el nombre exacto del modelo en tu panel de Qianfan, ya que puede aparecer como "ernie-x1.1-preview" durante el lanzamiento inicial.

Envía solicitudes POST con cuerpos JSON. Los parámetros clave incluyen:

messages: Una lista de diccionarios con "role" (usuario o asistente) y "content".temperature: Controla la aleatoriedad (0.0-1.0, predeterminado 0.8).top_p: Umbral de muestreo de núcleo (predeterminado 0.8).stream: Booleano para respuestas de streaming.

Un ejemplo de cuerpo de solicitud:

{

"messages": [

{"role": "user", "content": "Explica la computación cuántica."}

],

"temperature": 0.7,

"top_p": 0.9,

"stream": false

}

Los encabezados deben incluir Content-Type: application/json y el token de acceso en la URL: https://aip.baidubce.com/rpc/2.0/ai_custom/v1/wenxinworkshop/chat/ernie-x1.1?access_token=TU_TOKEN.

Este formato admite conversaciones de una sola vez y de varias vueltas. Para entradas multimodales, agrega campos "type" como "image" con URLs o datos base64.

Manejo de Respuestas de la API de ERNIE X1.1

Las respuestas llegan en formato JSON. Campos clave:

result: El texto generado.usage: Recuentos de tokens para el prompt, la finalización y el total.id: Identificador único de respuesta.

En modo de streaming, procesa los fragmentos a través de Server-Sent Events (SSE), donde cada evento contiene resultados parciales. Analízalos así en Python:

import qianfan

chat_comp = qianfan.ChatCompletion()

resp = chat_comp.do(model="ERNIE-X1.1", messages=[{"role": "user", "content": "Hola"}], stream=True)

for chunk in resp:

print(chunk["result"])

Verifica si hay errores en el campo "error_code". Los problemas comunes incluyen tokens inválidos (código 110) o límites de tasa (código 18). Monitorea el uso para mantenerte dentro de las cuotas, que varían según la suscripción: los niveles gratuitos limitan a 100 QPS, mientras que los planes de pago escalan más alto.

Con lo básico cubierto, los desarrolladores a menudo recurren a herramientas como Apidog para pruebas optimizadas.

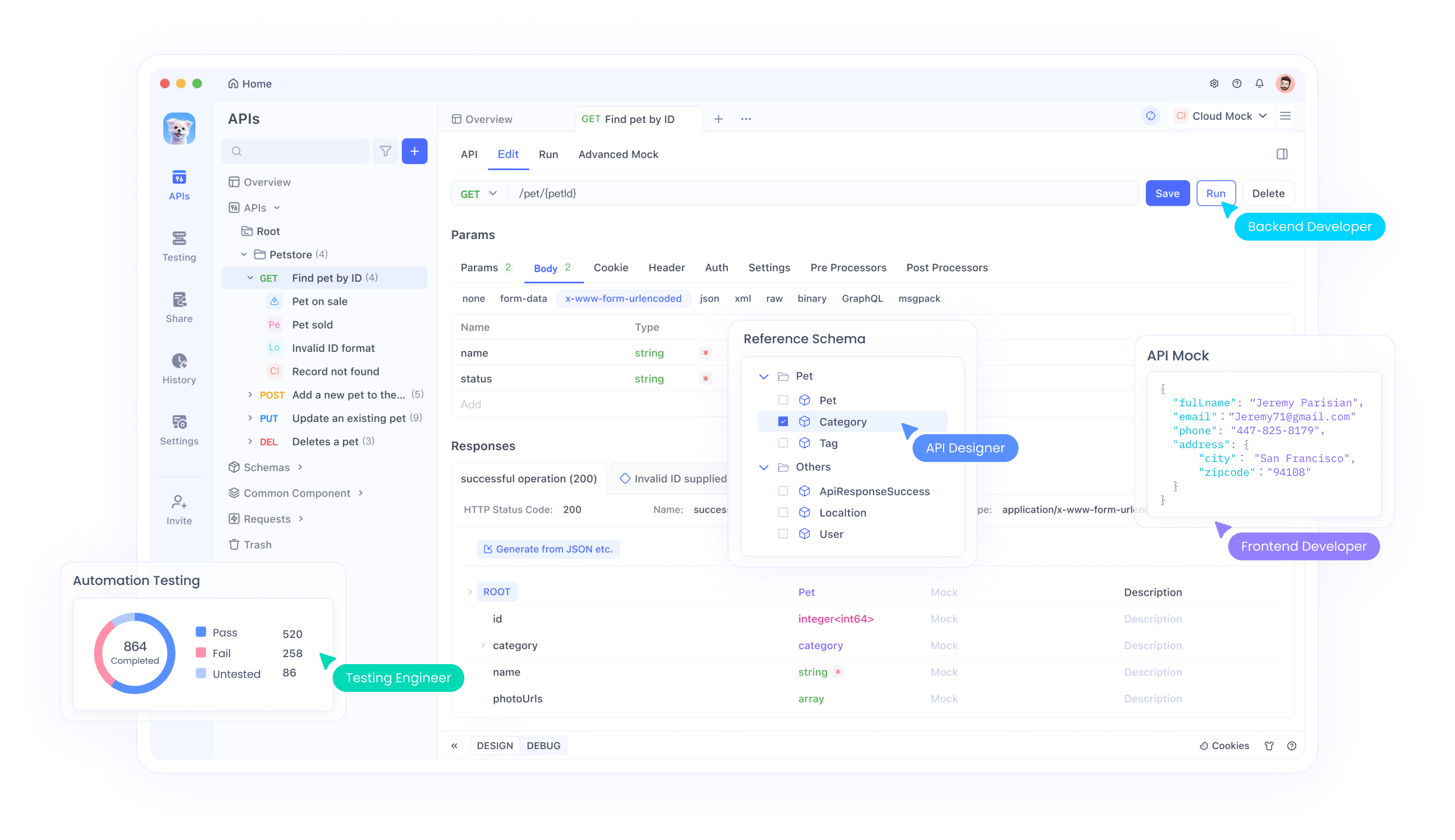

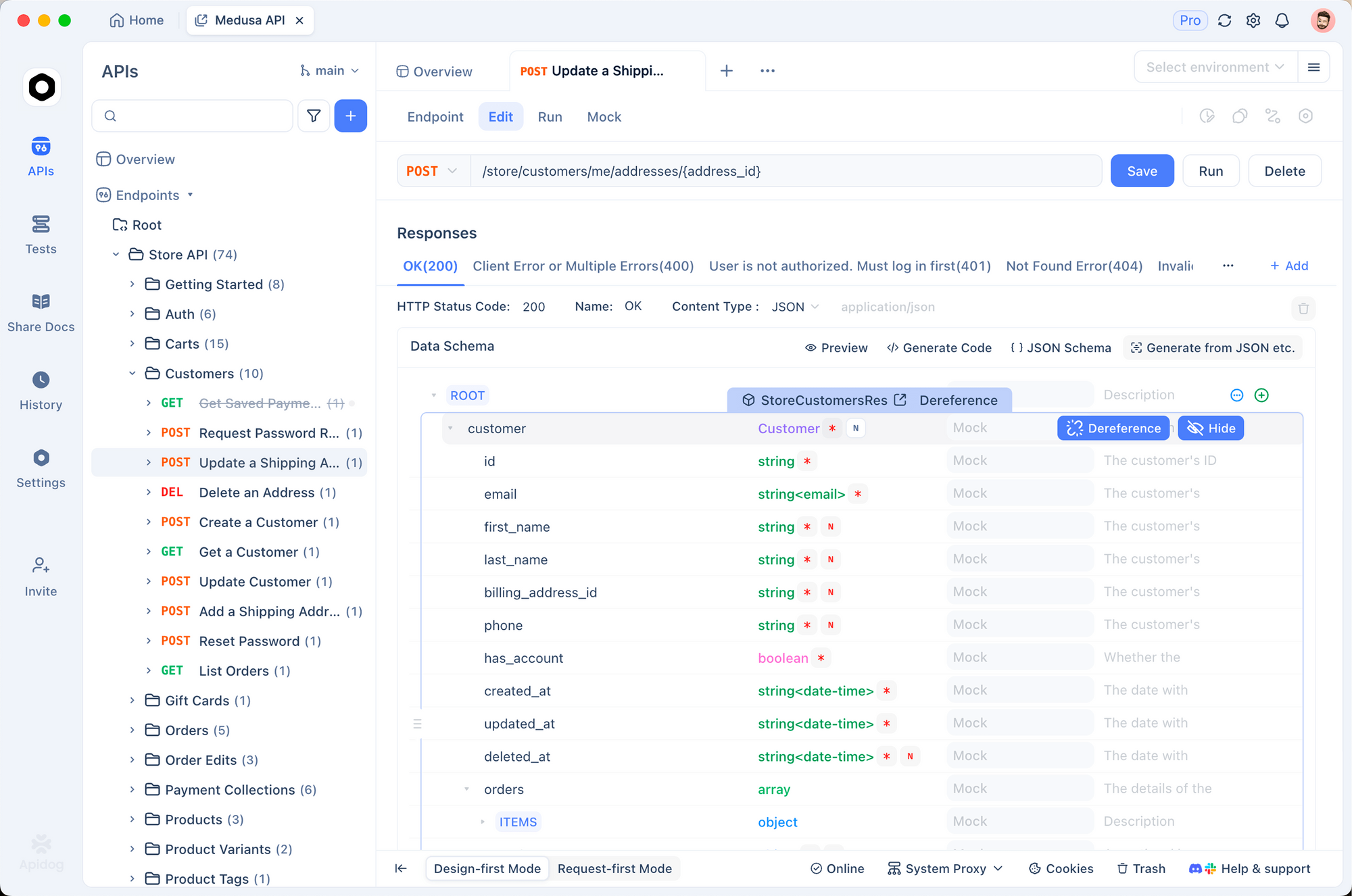

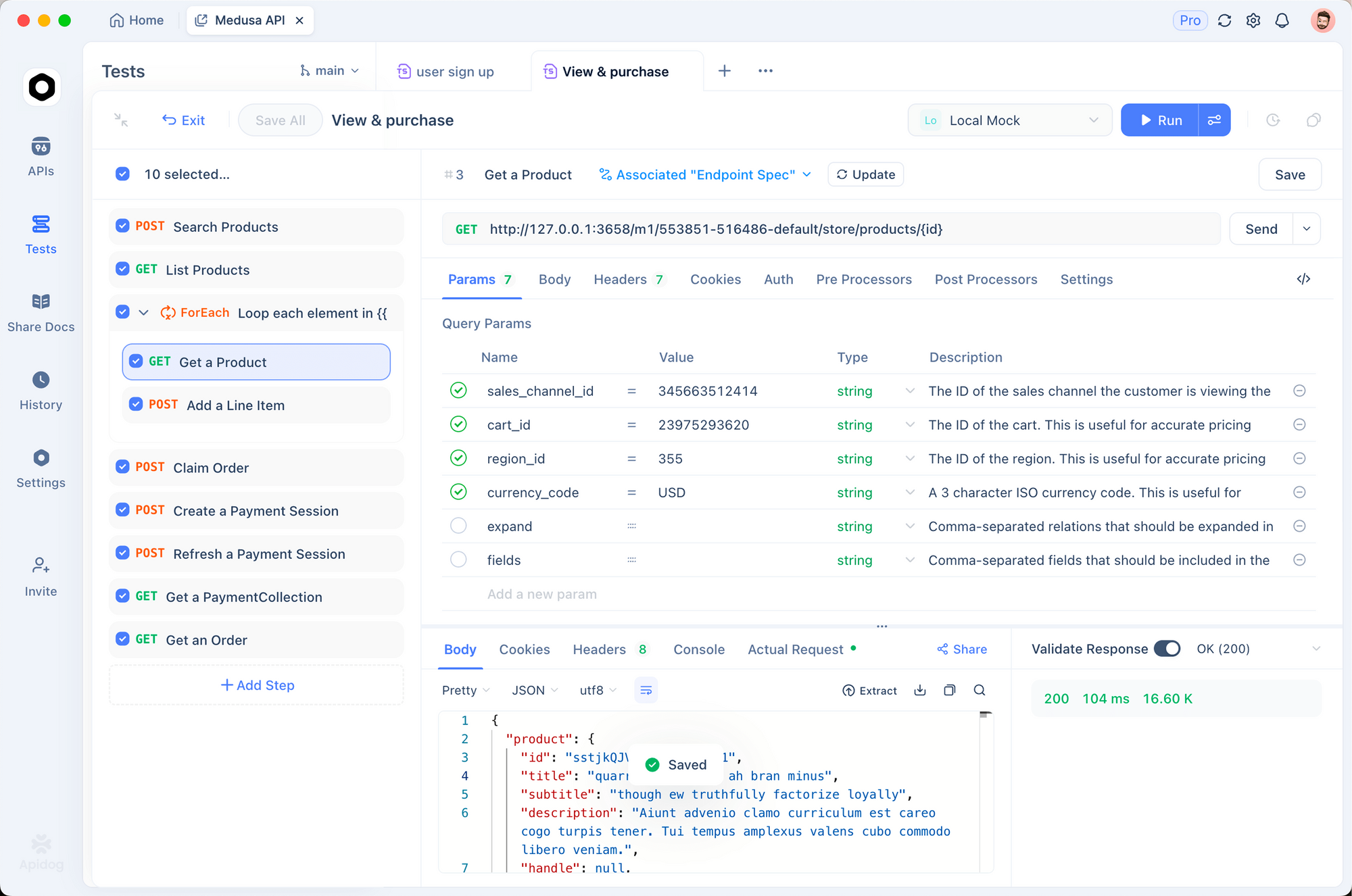

Uso de Apidog para Pruebas de la API de ERNIE X1.1

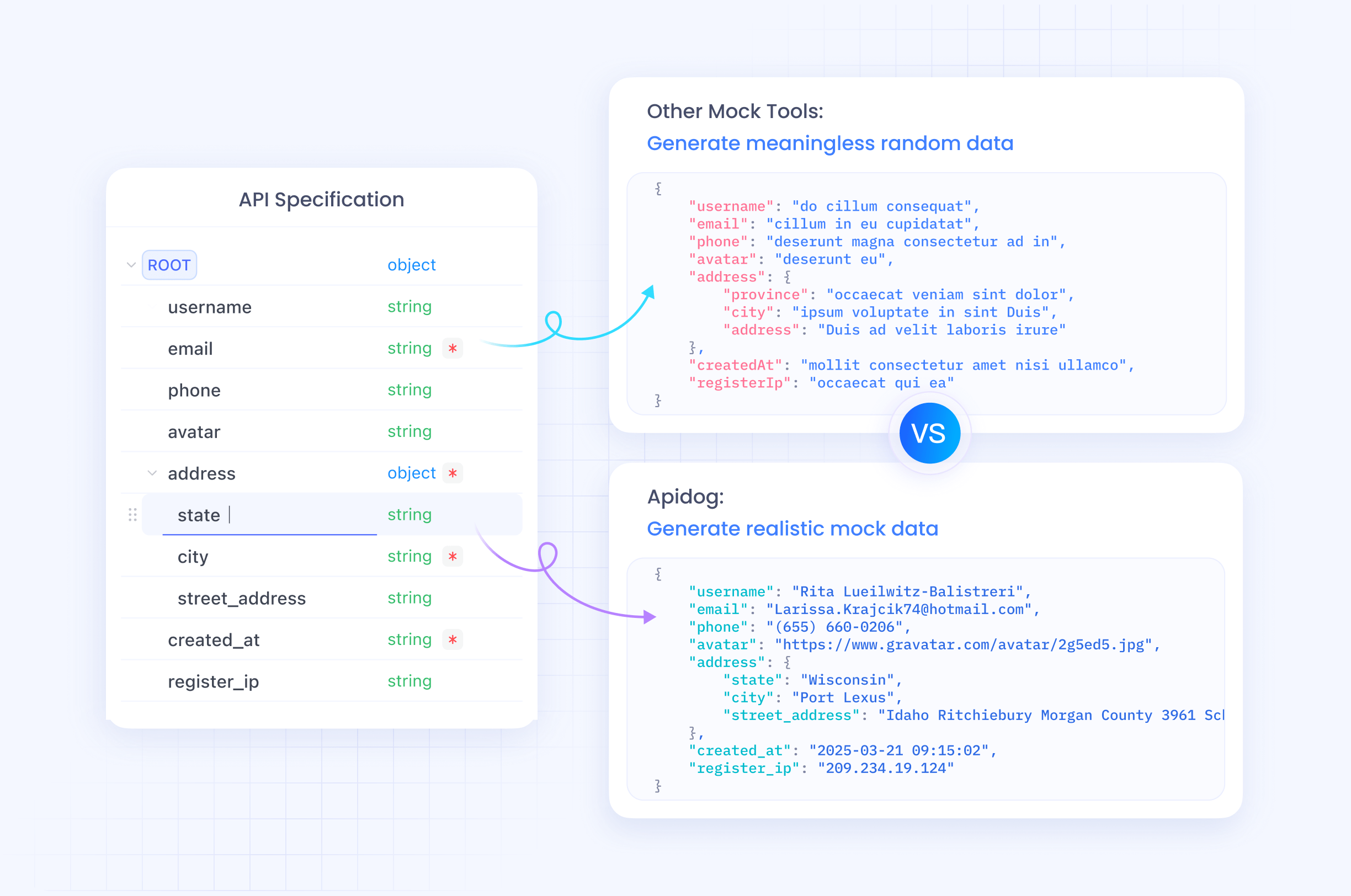

Apidog sirve como una excelente plataforma para probar los endpoints de la API de ERNIE X1.1. Ofrece interfaces intuitivas para diseñar, depurar y automatizar solicitudes, lo que lo hace superior para el desarrollo colaborativo.

Primero, descarga e instala Apidog desde su sitio oficial. Crea un nuevo proyecto e importa la especificación de la API de ERNIE. Apidog admite importaciones de OpenAPI, así que descarga la especificación de Baidu si está disponible, o agrega los endpoints manualmente.

Para configurar una solicitud, navega a la sección API y crea un nuevo método POST para /chat/ernie-x1.1. Ingresa tu token de acceso en los parámetros de consulta. En la pestaña del cuerpo, construye la estructura JSON con mensajes y parámetros. El sistema de variables de Apidog te permite parametrizar tokens o prompts para su reutilización.

Envía la solicitud e inspecciona las respuestas en tiempo real. Apidog resalta las estructuras JSON, rastrea los tiempos y registra los errores. Por ejemplo, prueba una consulta simple: "Genera un script de Python para análisis de datos". Analiza el campo "result" para verificar la precisión.

Además, automatiza las pruebas creando escenarios. Vincula múltiples solicitudes para simular chats de varias vueltas, una para el prompt inicial, otra para el seguimiento. Usa aserciones para validar las claves de respuesta, como asegurar que "usage.total_tokens" < 1000.

Apidog destaca en la simulación para el desarrollo offline. Crea servidores simulados que imiten las respuestas de ERNIE X1.1, permitiendo la colaboración en equipo sin llamadas a la API en vivo. Comparte proyectos a través de enlaces para obtener comentarios.

Para pruebas avanzadas, integra conjuntos de datos. Sube archivos CSV con prompts variados y ejecuta pruebas por lotes para evaluar la consistencia. Este enfoque revela casos límite, como entradas largas que activan límites de contexto.

Al incorporar Apidog, aceleras los ciclos de desarrollo. Sin embargo, recuerda cumplir con los límites de tasa de Baidu durante las pruebas extensivas.

Características Avanzadas de la API de ERNIE X1.1

ERNIE X1.1 brilla en tareas de agencia, donde llama a herramientas externas. Habilita esto incluyendo "tools" en las solicitudes: arrays de definiciones de funciones con nombres, descripciones y parámetros. El modelo responde con llamadas a herramientas si es necesario, las cuales ejecutas y retroalimentas.

Por ejemplo, define una herramienta meteorológica:

"tools": [

{

"type": "function",

"function": {

"name": "get_weather",

"description": "Obtener el clima actual",

"parameters": {

"type": "object",

"properties": {"location": {"type": "string"}}

}

}

}

]

ERNIE X1.1 procesa el prompt, emite una llamada a herramienta, y tú respondes con el resultado en el siguiente mensaje.

Además, aprovecha las entradas multimodales. Sube imágenes a través de base64 en los mensajes: {"role": "user", "content": [{"type": "image_url", "image_url": {"url": "data:image/jpeg;base64,..."}}]}. Esto permite el razonamiento basado en la visión, como describir escenas o analizar gráficos.

Integra con frameworks como LangChain para operaciones encadenadas. Usa QianfanChatEndpoint:

from langchain_community.chat_models import QianfanChatEndpoint

llm = QianfanChatEndpoint(model="ernie-x1.1")

response = llm.invoke("Resume este texto...")

Esta abstracción simplifica los flujos de trabajo complejos. Los límites de tasa suelen ser de 2000 tokens por minuto para la entrada, pero los planes empresariales ofrecen escalado personalizado. Los precios comienzan bajos, alrededor de $0.28 por millón de tokens de entrada para las variantes X1.

Mejores Prácticas para la Integración de la API de ERNIE X1.1

Los ingenieros optimizan el rendimiento creando prompts precisos. Usa mensajes de sistema para establecer roles: {"role": "system", "content": "Eres un asistente útil."}. Esto guía el comportamiento de manera efectiva.

Monitorea el uso de tokens para controlar los costos. Recorta los prompts y usa parámetros de truncamiento. Además, implementa reintentos para errores transitorios, como problemas de red, con retroceso exponencial.

Asegura tus claves API en variables de entorno o bóvedas. Evita registrar datos sensibles en las respuestas. Para producción, emplea el almacenamiento en caché para consultas frecuentes y así reducir las llamadas.

Prueba en varios idiomas, ya que ERNIE X1.1 destaca en chino pero maneja bien el inglés. Evalúa tus integraciones frente a las fortalezas del modelo, como las bajas alucinaciones en preguntas y respuestas factuales.

Finalmente, mantente actualizado a través del portal de desarrolladores de Baidu para nuevas características o actualizaciones del modelo.

Solución de Problemas Comunes de la API de ERNIE X1.1

Los usuarios encuentran errores de autenticación si los tokens expiran. Actualízalos rápidamente. Los nombres de modelo inválidos activan respuestas 404: verifica "ernie-x1.1" en tu panel.

Los límites de tasa excedidos causan errores 429. Implementa colas o actualiza los planes. Para respuestas incompletas, aumenta el parámetro max_tokens hasta el límite del modelo.

Depura con los registros de Apidog, que capturan ciclos completos de solicitud/respuesta. Si el multimodal falla, asegúrate de que los formatos de imagen coincidan con los tipos admitidos (JPEG, PNG).

Contacta al soporte de Baidu para problemas persistentes, proporcionando códigos de error y marcas de tiempo.

Conclusión: Eleva tu IA con la API de ERNIE X1.1

ERNIE X1.1 empodera a los desarrolladores para construir aplicaciones inteligentes y fiables. Desde la configuración hasta las integraciones avanzadas, esta guía te equipa con el conocimiento para aprovechar todo su potencial. Incorpora Apidog para pruebas eficientes y observa cómo tus proyectos prosperan.

A medida que la IA evoluciona, modelos como ERNIE X1.1 lideran el camino. Comienza a implementar hoy y experimenta la diferencia en precisión y eficiencia.