Los desarrolladores a menudo buscan APIs robustas para potenciar aplicaciones de IA. La API DeepSeek-V3.1 se destaca como una opción versátil. Ofrece capacidades avanzadas de modelado de lenguaje. Accedes a funciones como completados de chat e integraciones de herramientas. Esta publicación explica cómo usarla paso a paso.

Primero, obtén una clave API de la plataforma DeepSeek. Regístrate en su sitio y genera la clave. Con eso, puedes empezar a hacer solicitudes.

A continuación, comprende los componentes principales. DeepSeek-V3.1 se basa en modelos a gran escala. Admite contextos de hasta 128K tokens. Puedes manejar consultas complejas de manera eficiente. Además, incluye modos de pensamiento para un razonamiento más profundo. A medida que avanzas, observa cómo estos elementos encajan entre sí.

¿Qué es DeepSeek-V3.1 y por qué elegirlo?

DeepSeek-V3.1 representa una evolución en los modelos de IA. Los ingenieros de DeepSeek-ai lo desarrollaron como una arquitectura híbrida. El modelo totaliza 671 mil millones de parámetros, pero activa solo 37 mil millones durante la inferencia. Este diseño reduce las demandas computacionales mientras mantiene un alto rendimiento.

Encontrarás dos variantes principales: DeepSeek-V3.1-Base y la versión completa DeepSeek-V3.1. La versión base sirve como cimiento para un entrenamiento adicional. Se sometió a una extensión de contexto largo en dos fases. En la primera fase, el entrenamiento se expandió a 630 mil millones de tokens para un contexto de 32K. Luego, la segunda fase añadió 209 mil millones de tokens para un contexto de 128K. Documentos largos adicionales enriquecieron el conjunto de datos.

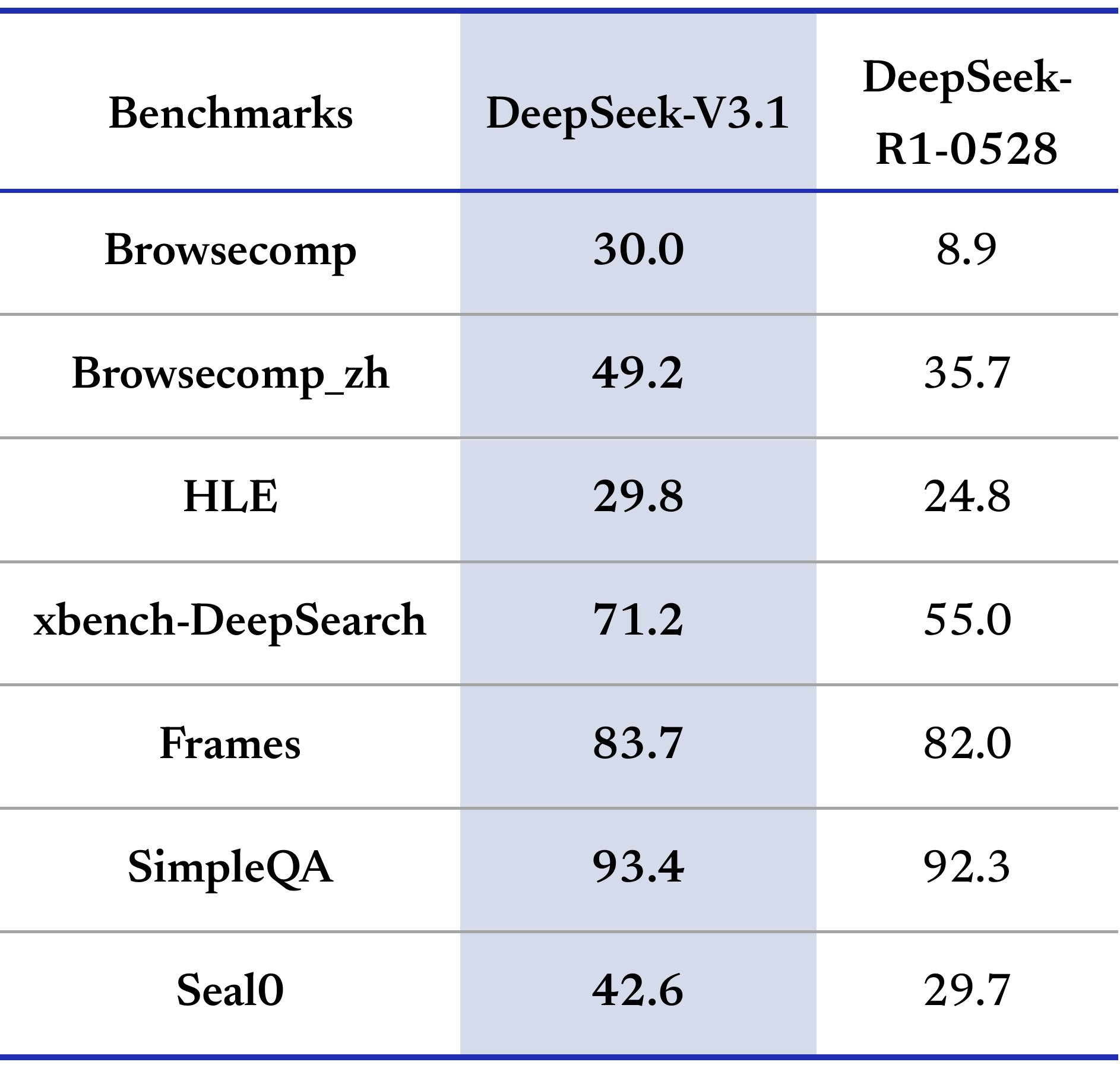

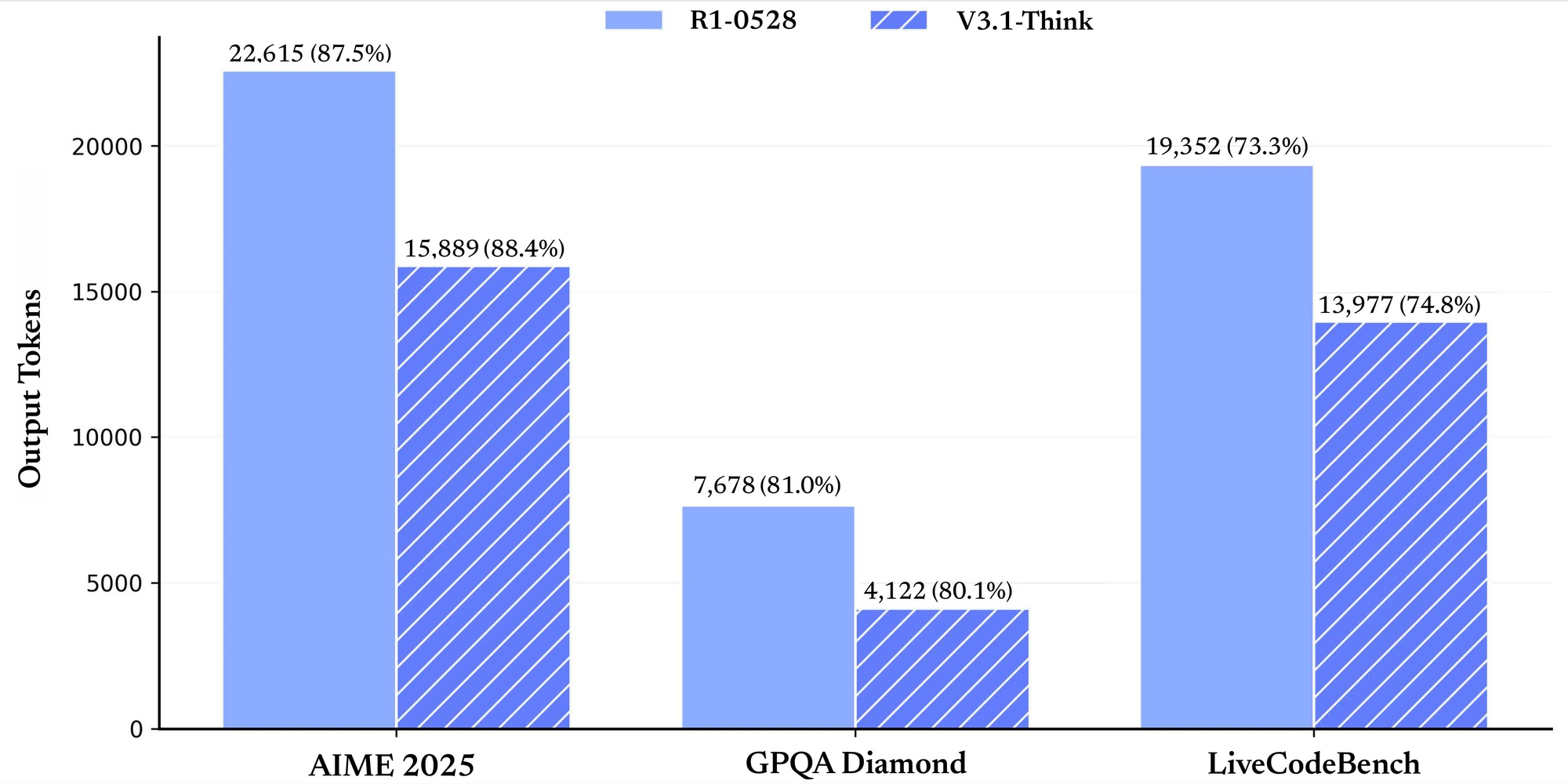

Los puntos de referencia de rendimiento destacan sus puntos fuertes. Para tareas generales, obtiene una puntuación de 91.8 en MMLU-Redux en modo no pensante y 93.7 en modo pensante. En GPQA-Diamond, alcanza 74.9 y 80.1 respectivamente. En evaluaciones relacionadas con código, LiveCodeBench arroja 56.4 en modo no pensante y 74.8 en modo pensante. Los puntos de referencia matemáticos como AIME 2024 muestran 66.3 y 93.1. Estos números demuestran fiabilidad en todos los dominios.

¿Por qué elegir la API DeepSeek-V3.1? Sobresale en tareas de agente y llamada a herramientas. La integras para agentes de búsqueda o agentes de código. En comparación con otras APIs, ofrece precios rentables y características de compatibilidad. Como resultado, los equipos la adoptan para soluciones de IA escalables. Pasando a la configuración, prepara tu entorno con cuidado.

Primeros Pasos con la Integración de la API DeepSeek-V3.1

Comienzas configurando tu entorno de desarrollo. Instala las bibliotecas necesarias. Para Python, usa pip para añadir requests o SDKs compatibles. Los puntos finales de la API DeepSeek-V3.1 siguen protocolos HTTP estándar. La URL base es https://api.deepseek.com.

Genera tu clave API desde el panel de control. Almacénala de forma segura en variables de entorno. Por ejemplo, establece DEEPSEEK_API_KEY en tu shell. Ahora, haz tu primera solicitud. Usa el punto final de completado de chat. Envía un POST a /chat/completions.

Incluye cabeceras con Authorization: Bearer your_key. El cuerpo contiene el modelo como "deepseek-chat", un array de mensajes y parámetros como max_tokens. Una solicitud simple se ve así:

import requests

url = "https://api.deepseek.com/chat/completions"

headers = {

"Authorization": "Bearer YOUR_API_KEY",

"Content-Type": "application/json"

}

data = {

"model": "deepseek-chat",

"messages": [{"role": "user", "content": "Hello, DeepSeek-V3.1!"}],

"max_tokens": 100

}

response = requests.post(url, headers=headers, json=data)

print(response.json())

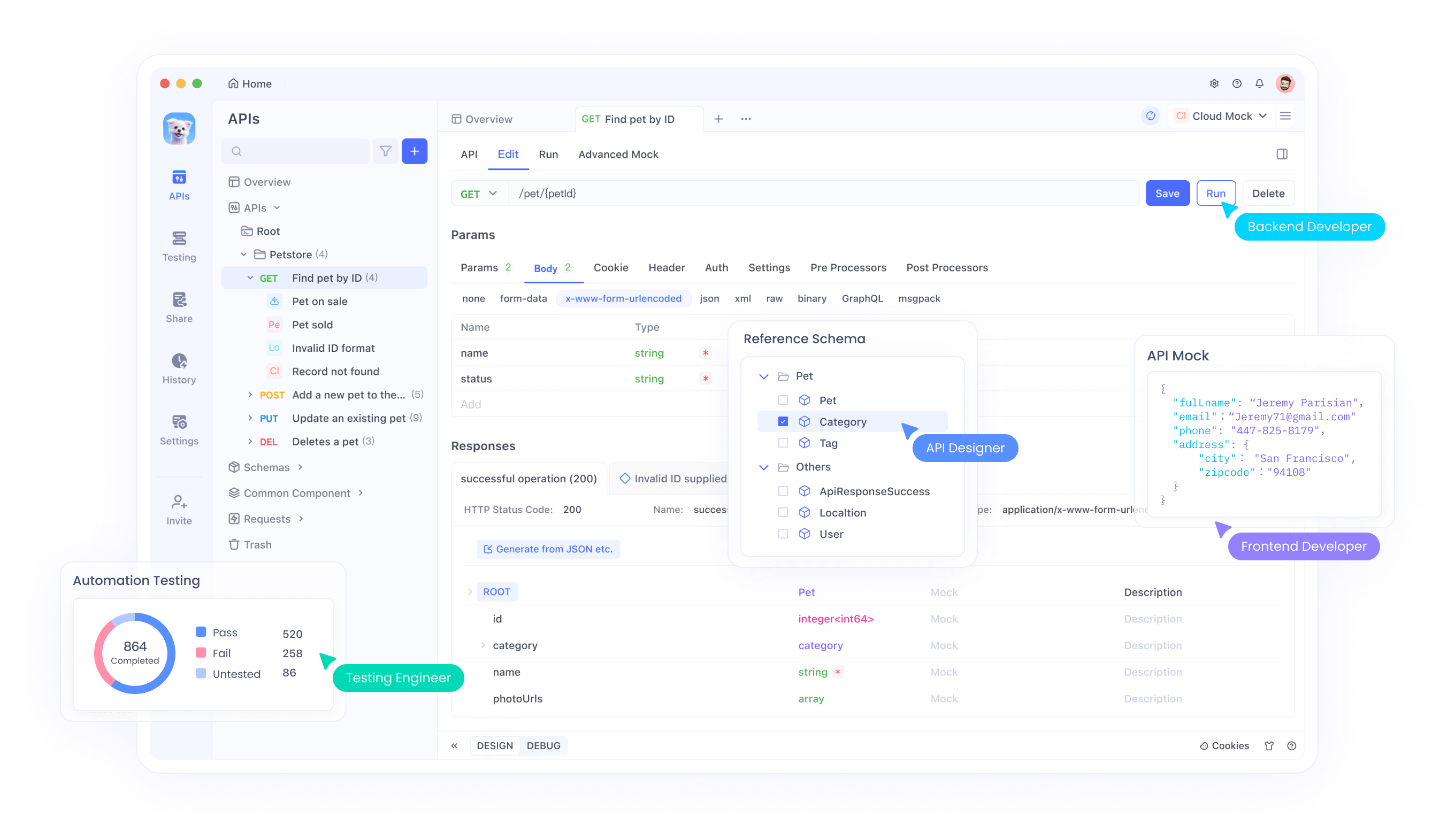

Este código obtiene una respuesta. Verifica el campo de contenido para la salida. Si ocurren errores, verifica la clave y la carga útil. Además, prueba con Apidog. Importa el punto final y simula llamadas. Apidog visualiza las respuestas, ayudando en la depuración.

Explora las opciones de modelo. DeepSeek-chat es adecuado para chats generales. DeepSeek-reasoner maneja tareas de razonamiento. Selecciona según tus necesidades. A medida que avanzas, incorpora streaming para salidas en tiempo real. Establece stream en true en la solicitud. Procesa los fragmentos en consecuencia.

La seguridad también importa. Usa HTTPS siempre. Limita la exposición de la clave. Rota las claves periódicamente. Con lo básico cubierto, pasa a funciones avanzadas como la llamada a funciones.

Dominando la Llamada a Funciones en la API DeepSeek-V3.1

La llamada a funciones mejora la API DeepSeek-V3.1. Defines herramientas que el modelo invoca. Esto permite interacciones dinámicas, como la obtención de datos meteorológicos.

Define herramientas en la solicitud. Cada herramienta tiene un tipo "function", nombre, descripción y parámetros. Los parámetros usan esquema JSON. Por ejemplo, una herramienta get_weather:

{

"type": "function",

"function": {

"name": "get_weather",

"description": "Get current weather",

"parameters": {

"type": "object",

"properties": {

"location": {"type": "string", "description": "City name"}

},

"required": ["location"]

}

}

}

Incluye esto en el array de herramientas de tu solicitud de completado de chat. El modelo analiza el mensaje del usuario. Si es relevante, devuelve tool_calls en la respuesta. Cada llamada tiene id, nombre y argumentos.

Maneja la llamada. Ejecuta la función localmente. Para get_weather, consulta una API externa o datos simulados. Añade el resultado como un mensaje de herramienta:

{

"role": "tool",

"tool_call_id": "call_id_here",

"content": "Temperature: 24°C"

}

Envía los mensajes actualizados de vuelta. El modelo genera una respuesta final.

Usa el modo estricto para una mejor validación. Establece strict en true y usa la URL base beta. Esto impone el cumplimiento del esquema. Los tipos admitidos incluyen string, number, array. Evita campos no admitidos como minLength.

Las mejores prácticas incluyen descripciones claras. Prueba las herramientas con Apidog para simular respuestas. Monitorea errores en los argumentos. Como resultado, tus aplicaciones se vuelven más interactivas. A continuación, examina la compatibilidad con otros ecosistemas.

Aprovechando la Compatibilidad con la API de Anthropic en DeepSeek-V3.1

La API DeepSeek-V3.1 es compatible con el formato de Anthropic. Esto te permite usar los SDKs de Anthropic sin problemas. Establece la URL base en https://api.deepseek.com/anthropic.

Instala el SDK de Anthropic: pip install anthropic. Configura el entorno:

export ANTHROPIC_BASE_URL=https://api.deepseek.com/anthropic

export ANTHROPIC_API_KEY=YOUR_DEEPSEEK_KEY

Crea mensajes:

import anthropic

client = anthropic.Anthropic()

message = client.messages.create(

model="deepseek-chat",

max_tokens=1000,

system="You are helpful.",

messages=[{"role": "user", "content": [{"type": "text", "text": "Hi"}]}]

)

print(message.content)

Esto funciona como Anthropic pero usa modelos DeepSeek. Campos admitidos: max_tokens, temperature (0-2.0), tools. Ignorados: top_k, cache_control.

Existen diferencias. No hay soporte para imágenes o documentos. Las opciones de elección de herramientas son limitadas. Usa esto para migrar desde Anthropic. Prueba con Apidog para comparar respuestas. En consecuencia, expandes tu conjunto de herramientas sin reescribir código.

Comprendiendo la Arquitectura del Modelo y el Tokenizador de DeepSeek-V3.1

DeepSeek-V3.1-Base constituye el núcleo. Utiliza un diseño híbrido para la eficiencia. La longitud del contexto alcanza los 128K, ideal para documentos largos.

El entrenamiento implicó fases extendidas. Primero, 32K con 630B tokens. Luego, 128K con 209B. El formato FP8 asegura la compatibilidad.

Configuración del tokenizador: add_bos_token true, model_max_length 131072. Token BOS "<|begin of sentence|>", EOS "<|end of sentence|>". La plantilla de chat maneja roles como Usuario, Asistente, etiquetas de pensamiento.

Aplica plantillas para conversaciones. Para el modo de pensamiento, envuelve el razonamiento en etiquetas . Esto aumenta el rendimiento en tareas complejas.

Cargas el modelo a través de Hugging Face. Usa from_pretrained("deepseek-ai/DeepSeek-V3.1"). Tokeniza las entradas con cuidado. Monitorea el recuento de tokens para mantenerte dentro de los límites. Así, optimizas la precisión.

Precios y Gestión de Costos para la API DeepSeek-V3.1

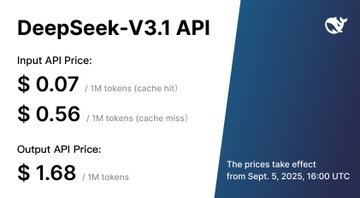

El precio afecta la adopción. La API DeepSeek-V3.1 cobra por millón de tokens. Modelos: deepseek-chat y deepseek-reasoner.

A partir del 5 de septiembre de 2025, 16:00 UTC: Ambos modelos cuestan $0.07 por entrada con acierto de caché, $0.56 por entrada con fallo de caché, $1.68 por salida.

Antes de eso, estándar (00:30-16:30 UTC): deepseek-chat $0.07 acierto, $0.27 fallo, $1.10 salida; reasoner $0.14 acierto, $0.55 fallo, $2.19 salida. Descuento (16:30-00:30): aproximadamente la mitad de los precios.

No se mencionan niveles gratuitos. Calcula los costos: Estima los tokens por solicitud. Usa el almacenamiento en caché para entradas repetidas. Optimiza las indicaciones para reducir los tokens.

Rastrea el uso en el panel de control. Establece presupuestos. Con Apidog, simula llamadas para predecir costos. Por lo tanto, gestiona los gastos de manera efectiva.

Mejores Prácticas y Solución de Problemas para la API DeepSeek-V3.1

Sigue las pautas para el éxito. Crea indicaciones concisas. Proporciona contexto en los mensajes.

Monitorea la latencia. Contextos largos ralentizan las respuestas. Divide las entradas si es posible.

Asegura los datos: Evita enviar información sensible.

Solución de problemas: Verifica los códigos de estado. 401 significa clave inválida. 429 demasiadas solicitudes.

Actualiza los SDKs regularmente. Lee la documentación para los cambios.

Escala: Agrupa las solicitudes si es compatible. Usa async para paralelismo.

Los foros de la comunidad ayudan. Comparte experiencias.

Al aplicar esto, logras integraciones fiables.

Conclusión: Eleva Tus Proyectos de IA con la API DeepSeek-V3.1

Ahora sabes cómo usar la API DeepSeek-V3.1 de manera efectiva. Desde la configuración hasta las funciones avanzadas, empodera a los desarrolladores. Incorpora Apidog para flujos de trabajo más fluidos. Empieza a construir hoy y observa el impacto.