Claude de Anthropic recientemente ganó atención con nuevas capacidades que le permiten acceder y sintetizar información web en tiempo real, actuando efectivamente como un asistente de investigación. Esta función, a menudo discutida como "Claude Research", tiene como objetivo ir más allá de una simple búsqueda en la web al explorar múltiples ángulos de un tema, reuniendo información de diversas fuentes y entregando respuestas sintetizadas. Si bien es poderoso, depender de sistemas cerrados y propietarios no siempre es ideal. Muchos usuarios buscan más control, transparencia, personalización o simplemente quieren experimentar con la tecnología subyacente.

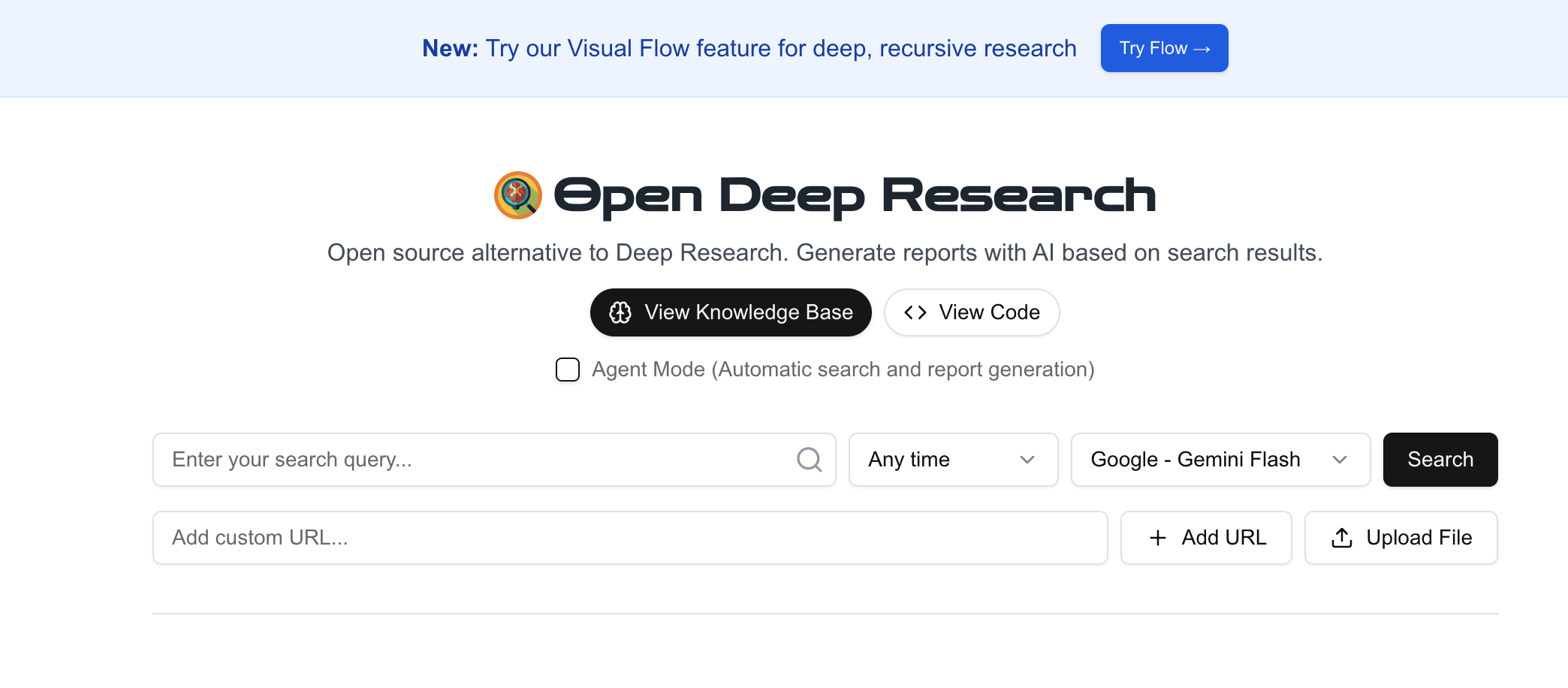

La buena noticia es que la comunidad de código abierto a menudo proporciona bloques de construcción para replicar tales funcionalidades. Un proyecto interesante en este espacio es btahir/open-deep-research en GitHub. Esta herramienta tiene como objetivo automatizar el proceso de realizar investigaciones en profundidad sobre un tema aprovechando búsquedas en la web y Modelos de Lenguaje Grande (LLMs).

Primero entendamos las capacidades clave ofrecidas por características de investigación de IA sofisticadas como las de Claude, que open-deep-research intenta emular de manera de código abierto, y luego profundicemos en cómo puedes ejecutar esta herramienta tú mismo.

Presentando open-deep-research: Tu Punto de Partida de Código Abierto

El proyecto open-deep-research (https://github.com/btahir/open-deep-research) proporciona un marco para lograr objetivos similares utilizando herramientas y APIs fácilmente disponibles. Probablemente orquesta un pipeline que involucra:

- Consultas de Motores de Búsqueda: Usando APIs (como SearchApi, Google Search API, etc.) para encontrar páginas web relevantes para un tema de investigación dado.

- Web Scraping: Recuperando el contenido de las URLs identificadas.

- Procesamiento LLM: Utilizando un Modelo de Lenguaje Grande (comúnmente a través de la API de OpenAI, pero potencialmente adaptable) para leer, entender, sintetizar y estructurar la información recopilada de las páginas web.

- Generación de Informes: Compilando la información procesada en una salida final, como un informe detallado.

Al ejecutar esto tú mismo, obtienes transparencia en el proceso y la capacidad de personalizarlo potencialmente.

¿Quieres una plataforma integrada, Todo-en-Uno, para que tu Equipo de Desarrolladores trabaje junto con máxima productividad?

Apidog satisface todas tus demandas, y reemplaza a Postman a un precio mucho más asequible!

Guía Paso a Paso para Ejecutar open-deep-research

¿Listo para intentar construir tu propio asistente de investigación? Aquí tienes una guía detallada para poner en marcha open-deep-research.

Requisitos Previos:

- Python: Necesitarás tener Python instalado en tu sistema (generalmente Python 3.7+).

- Git: Requerido para clonar el repositorio.

- Claves API: Esto es crucial. La herramienta necesitará claves API para:

- Una API de Motor de Búsqueda: Para realizar búsquedas en la web de manera programática. Ejemplos incluyen SearchApi, Serper, o potencialmente otros dependiendo de la configuración del proyecto. Necesitarás registrarte en uno de estos servicios y obtener una clave API.

- Una API LLM: Lo más probable es que se requiera la clave de API de OpenAI para acceder a modelos GPT (como GPT-3.5 o GPT-4) para el paso de síntesis. Necesitarás una cuenta de OpenAI con acceso a la API.

- (Consulta el README de

open-deep-researchpara las APIs y claves específicas requeridas). - Línea de Comandos / Terminal: Ejecutarás comandos en tu terminal o símbolo del sistema.

Paso 1: Clonar el Repositorio

Primero, abre tu terminal y navega al directorio donde deseas almacenar el proyecto. Luego, clona el repositorio de GitHub:

git clone <https://github.com/btahir/open-deep-research.git>

Ahora, cambia al nuevo directorio del proyecto creado:

cd open-deep-research

Paso 2: Configurar un Entorno Virtual (Recomendado)

Es una buena práctica utilizar un entorno virtual para gestionar las dependencias del proyecto por separado.

En macOS/Linux:

python3 -m venv venv

source venv/bin/activate

En Windows:

python -m venv venv

.\\venv\\Scripts\\activate

Tu símbolo del terminal ahora debería indicar que estás en el entorno (venv).

Paso 3: Instalar Dependencias

El proyecto debería incluir un archivo requirements.txt que enumere todas las bibliotecas de Python necesarias. Instálalas usando pip:

pip install -r requirements.txt

Este comando descargará e instalará bibliotecas como openai, requests, potencialmente beautifulsoup4 o similar para scraping, y bibliotecas para la API de búsqueda específica utilizada.

Paso 4: Configurar Claves API

Este es el paso de configuración más crítico. Necesitas proporcionar las claves API que obtuviste en los requisitos previos. Los proyectos de código abierto suelen manejar claves a través de variables de entorno o un archivo .env. Consulta cuidadosamente el archivo README de open-deep-research para los nombres exactos de las variables de entorno requeridas.

Comúnmente, es posible que necesites establecer variables como:

OPENAI_API_KEYSEARCHAPI_API_KEY(oSERPER_API_KEY,GOOGLE_API_KEY, etc., dependiendo del servicio de búsqueda utilizado)

Puedes establecer variables de entorno directamente en tu terminal (estas son temporales para la sesión actual):

En macOS/Linux:

export OPENAI_API_KEY='tu_clave_api_openai_aquí'

export SEARCHAPI_API_KEY='tu_clave_api_busqueda_aquí'

En Windows (Símbolo del Sistema):

set OPENAI_API_KEY=tu_clave_api_openai_aquí

set SEARCHAPI_API_KEY=tu_clave_api_busqueda_aquí

En Windows (PowerShell):

$env:OPENAI_API_KEY="tu_clave_api_openai_aquí"$env:SEARCHAPI_API_KEY="tu_clave_api_busqueda_aquí"

Alternativamente, el proyecto podría soportar un archivo .env. Si es así, crea un archivo llamado .env en el directorio raíz del proyecto y agrega las claves de esta manera:

OPENAI_API_KEY=tu_clave_api_openai_aquí

SEARCHAPI_API_KEY=tu_clave_api_busqueda_aquí

Bibliotecas como python-dotenv (si está enumerada en requirements.txt) cargarán automáticamente estas variables cuando se ejecute el script. Nuevamente, consulta la documentación del proyecto para el método y los nombres de variables correctos.

Paso 5: Ejecutar la Herramienta de Investigación

Con el entorno configurado, las dependencias instaladas y las claves API configuradas, ahora puedes ejecutar el script principal. El comando exacto dependerá de cómo esté estructurado el proyecto. Busca un script principal de Python (por ejemplo, main.py, research.py, o similar).

El comando podría verse algo así ( ¡revisa el README para el comando y argumentos exactos!):

python main.py --query "Impacto de la adopción de energía renovable en las tendencias de emisiones de C02 globales"

O quizás:

python research_agent.py "Últimos avances en tecnología de baterías de estado sólido para vehículos eléctricos"

El script luego:

- Toma tu consulta.

- Usa la clave API de búsqueda para encontrar URLs relevantes.

- Raspa contenido de esas URLs.

- Usa la clave API de OpenAI para procesar y sintetizar el contenido.

- Genera una salida.

Paso 6: Revisar la Salida

La herramienta probablemente tardará un tiempo en ejecutarse, dependiendo de la complejidad de la consulta, el número de fuentes analizadas y la velocidad de las APIs. Una vez finalizado, revisa la salida. Esto podría ser:

- Impreso directamente en la consola de tu terminal.

- Guardado como un archivo de texto o archivo Markdown en el directorio del proyecto (por ejemplo,

research_report.txtoreport.md).

Revisa el informe generado por relevancia, coherencia y precisión.

Personalización y Consideraciones

- Elección de LLM: Si bien probablemente se predetermine a OpenAI, verifica si el proyecto permite configurar diferentes LLMs (quizás modelos de código abierto que se ejecuten localmente a través de Ollama o LM Studio, aunque esto requeriría cambios en el código si no está integrado).

- Proveedor de Búsqueda: Podrías ser capaz de cambiar el proveedor de API de búsqueda si es necesario.

- Ingeniería de Prompts: Podrías potencialmente modificar los prompts utilizados para instruir al LLM durante la fase de síntesis para adaptar el estilo o enfoque de la salida.

- Costo: Recuerda que usar APIs (especialmente los modelos más potentes de OpenAI y potencialmente APIs de búsqueda) incurre costos basados en el uso. Monitorea tu gasto.

- Fiabilidad: Herramientas de código abierto como esta pueden ser menos robustas que productos comerciales. Los sitios web cambian, el scraping puede fallar y las salidas de LLM pueden variar. Espera tener que depurar problemas potencialmente.

- Complejidad: Configurar esto requiere más esfuerzo técnico que usar un producto SaaS pulido como Claude.

Conclusión

Si bien las herramientas de IA comerciales como Claude ofrecen capacidades de investigación impresionantes e integradas, proyectos de código abierto como btahir/open-deep-research demuestran que se pueden construir y ejecutar funcionalidades similares de manera independiente. Siguiendo los pasos anteriores, puedes configurar tu propio agente de investigación automatizado, brindándote una poderosa herramienta para profundizar en varios temas, combinada con la transparencia y la posibilidad de personalización que ofrece el código abierto. Recuerda consultar siempre la documentación específica del proyecto (README.md) para obtener las instrucciones más precisas y actualizadas. ¡Feliz investigación!

¿Quieres una plataforma integrada, Todo-en-Uno, para que tu Equipo de Desarrolladores trabaje junto con máxima productividad?

Apidog satisface todas tus demandas, y reemplaza a Postman a un precio mucho más asequible!