En el mundo de las aplicaciones impulsadas por IA, la API Claude de Anthropic se ha convertido en una solución de referencia para muchos desarrolladores que buscan capacidades avanzadas de procesamiento del lenguaje. Sin embargo, como con cualquier servicio popular, es probable que te encuentres con límites de velocidad que pueden detener temporalmente la funcionalidad de tu aplicación. Comprender estos límites e implementar estrategias para trabajar dentro de ellos es crucial para mantener una experiencia de usuario fluida.

Para la codificación con IA, Claude ha surgido como un poderoso asistente tanto para usuarios casuales como para desarrolladores. Sin embargo, muchos usuarios se encuentran con una frustración común: los límites de velocidad.

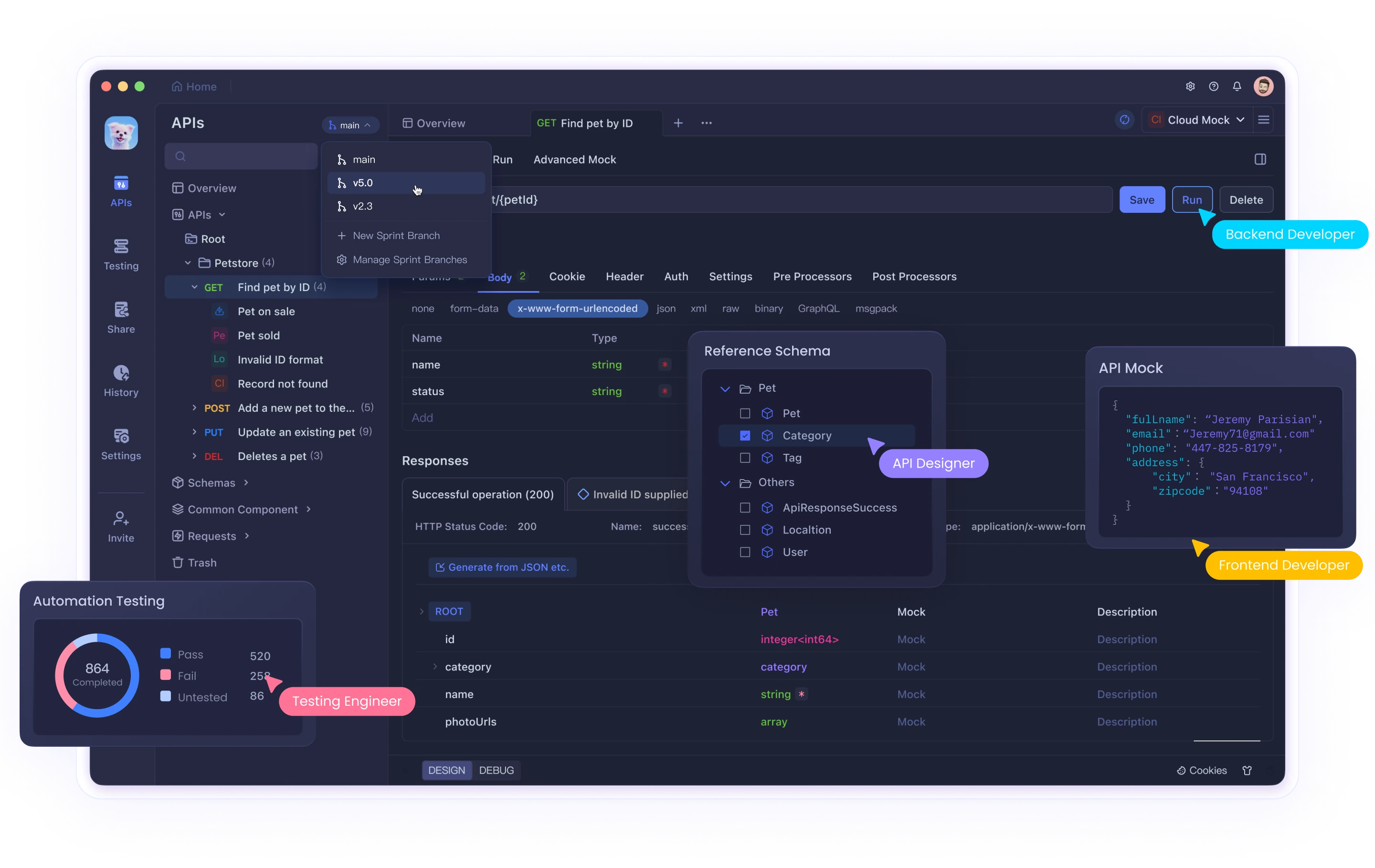

Ya sea que estés utilizando la interfaz web de Claude o integrándola con su API a través de herramientas como Cursor o Cline, alcanzar estos límites puede interrumpir tu flujo de trabajo y productividad. Si bien herramientas como Claude brindan poderosas capacidades de IA, la gestión eficaz de las interacciones de la API requiere herramientas adecuadas de prueba y depuración. Apidog ayuda a los desarrolladores a navegar por estas complejidades cuando trabajan con IA y otras API.

Esta guía completa explorará por qué existen los límites de velocidad de la API Claude, cómo identificar cuándo los has alcanzado y proporcionará tres soluciones detalladas para ayudarte a superar estos desafíos de manera efectiva.

¿Qué son los límites de velocidad de la API Claude y por qué existen?

Los límites de velocidad son restricciones impuestas por los proveedores de API para controlar el volumen de solicitudes que un usuario puede realizar dentro de un período de tiempo específico. Anthropic implementa estos límites por varias razones importantes:

- Gestión de recursos del servidor: Evitar que un solo usuario consuma demasiados recursos computacionales

- Acceso equitativo: Garantizar una distribución justa del acceso a la API entre todos los usuarios

- Prevención de abusos: Protección contra actividades maliciosas como el scraping o los ataques DDoS

- Estabilidad del servicio: Mantener el rendimiento general del sistema durante los momentos de mayor uso

Límites de velocidad específicos de la API Claude

Los límites de velocidad de Claude varían según tu tipo de cuenta:

- Usuarios gratuitos: Aproximadamente 100 mensajes por día, con la cuota restableciéndose a la medianoche

- Usuarios Pro: Aproximadamente cinco veces el límite de los usuarios gratuitos (aproximadamente 500 mensajes diarios)

- Usuarios de la API: Límites personalizados basados en tu plan específico y acuerdos con Anthropic

Además, durante los momentos de mayor uso, estos límites podrían aplicarse de manera más estricta y es posible que experimentes una limitación temporal incluso antes de alcanzar tu asignación máxima.

Identificación de problemas de límite de velocidad

Es probable que hayas alcanzado un límite de velocidad cuando tu aplicación recibe un código de estado HTTP 429 Too Many Requests. La respuesta normalmente incluye encabezados con información sobre:

- Cuándo puedes reanudar la realización de solicitudes

- Tus estadísticas de uso actuales

- Información de cuota restante

Solución 1: Implementar una limitación de velocidad adecuada en tu código

El enfoque más fundamental para manejar los límites de velocidad de la API es implementar la limitación de velocidad del lado del cliente. Esto evita de manera proactiva que tu aplicación exceda el volumen de solicitudes permitido.

Uso de un algoritmo de token bucket

El token bucket es un algoritmo popular para la limitación de velocidad que funciona de la siguiente manera:

- Mantener un "bucket" que se llena con tokens a una velocidad constante

- Consumir un token por cada solicitud de API

- Bloquear las solicitudes cuando no hay tokens disponibles

Aquí hay una implementación de Python:

import time

import threading

class TokenBucket:

def __init__(self, tokens_per_second, max_tokens):

self.tokens_per_second = tokens_per_second

self.max_tokens = max_tokens

self.tokens = max_tokens

self.last_refill = time.time()

self.lock = threading.Lock()

def _refill_tokens(self):

now = time.time()

elapsed = now - self.last_refill

new_tokens = elapsed * self.tokens_per_second

self.tokens = min(self.max_tokens, self.tokens + new_tokens)

self.last_refill = now

def get_token(self):

with self.lock:

self._refill_tokens()

if self.tokens >= 1:

self.tokens -= 1

return True

return False

def wait_for_token(self, timeout=None):

start_time = time.time()

while True:

if self.get_token():

return True

if timeout is not None and time.time() - start_time > timeout:

return False

time.sleep(0.1) # Sleep to avoid busy waiting

# Example usage with Claude API

import anthropic

# Create a rate limiter (5 requests per second, max burst of 10)

rate_limiter = TokenBucket(tokens_per_second=5, max_tokens=10)

client = anthropic.Anthropic(api_key="your_api_key")

def generate_with_claude(prompt):

# Wait for a token to become available

if not rate_limiter.wait_for_token(timeout=30):

raise Exception("Timed out waiting for rate limit token")

try:

response = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1000,

messages=[{"role": "user", "content": prompt}]

)

return response.content

except Exception as e:

if "429" in str(e):

print("Rate limit hit despite our rate limiting! Backing off...")

time.sleep(10) # Additional backoff

return generate_with_claude(prompt) # Retry

raise

Esta implementación:

- Crea un token bucket que se rellena a una velocidad constante

- Espera a que los tokens estén disponibles antes de realizar solicitudes

- Implementa un retroceso adicional si aún se encuentran límites de velocidad

Manejo de respuestas 429 con retroceso exponencial

Incluso con la limitación de velocidad proactiva, es posible que ocasionalmente alcances los límites. La implementación del retroceso exponencial ayuda a tu aplicación a recuperarse con elegancia:

import time

import random

def call_claude_api_with_backoff(prompt, max_retries=5, base_delay=1):

retries = 0

while retries <= max_retries:

try:

# Wait for rate limiter token

rate_limiter.wait_for_token()

# Make the API call

response = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1000,

messages=[{"role": "user", "content": prompt}]

)

return response.content

except Exception as e:

if "429" in str(e) and retries < max_retries:

# Calculate delay with exponential backoff and jitter

delay = base_delay * (2 ** retries) + random.uniform(0, 0.5)

print(f"Rate limited. Retrying in {delay:.2f} seconds...")

time.sleep(delay)

retries += 1

else:

raise

raise Exception("Max retries exceeded")

Esta función:

- Intenta realizar la llamada a la API

- Si se produce un error 429, espera un tiempo que aumenta exponencialmente

- Agrega jitter aleatorio para evitar la sincronización de solicitudes

- Se rinde después de un número máximo de reintentos

Solución 2: Implementar la cola y priorización de solicitudes

Para las aplicaciones con diferentes niveles de importancia de la solicitud, la implementación de una cola de solicitudes con manejo de prioridad puede optimizar el uso de tu API.

Construcción de un sistema de cola de prioridad

import heapq

import threading

import time

from dataclasses import dataclass, field

from typing import Any, Callable, Optional

@dataclass(order=True)

class PrioritizedRequest:

priority: int

execute_time: float = field(compare=False)

callback: Callable = field(compare=False)

args: tuple = field(default_factory=tuple, compare=False)

kwargs: dict = field(default_factory=dict, compare=False)

class ClaudeRequestQueue:

def __init__(self, requests_per_minute=60):

self.queue = []

self.lock = threading.Lock()

self.processing = False

self.requests_per_minute = requests_per_minute

self.interval = 60 / requests_per_minute

def add_request(self, callback, priority=0, delay=0, *args, **kwargs):

"""Add a request to the queue with the given priority."""

with self.lock:

execute_time = time.time() + delay

request = PrioritizedRequest(

priority=-priority, # Negate so higher values have higher priority

execute_time=execute_time,

callback=callback,

args=args,

kwargs=kwargs

)

heapq.heappush(self.queue, request)

if not self.processing:

self.processing = True

threading.Thread(target=self._process_queue, daemon=True).start()

def _process_queue(self):

"""Process requests from the queue, respecting rate limits."""

while True:

with self.lock:

if not self.queue:

self.processing = False

return

# Get the highest priority request that's ready to execute

request = self.queue[0]

now = time.time()

if request.execute_time > now:

# Wait until the request is ready

wait_time = request.execute_time - now

time.sleep(wait_time)

continue

# Remove the request from the queue

heapq.heappop(self.queue)

# Execute the request outside the lock

try:

request.callback(*request.args, **request.kwargs)

except Exception as e:

print(f"Error executing request: {e}")

# Wait for the rate limit interval

time.sleep(self.interval)

# Example usage

queue = ClaudeRequestQueue(requests_per_minute=60)

def process_result(result, callback):

print(f"Got result: {result[:50]}...")

if callback:

callback(result)

def make_claude_request(prompt, callback=None, priority=0):

def execute():

try:

response = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1000,

messages=[{"role": "user", "content": prompt}]

)

process_result(response.content, callback)

except Exception as e:

if "429" in str(e):

# Re-queue with a delay if rate limited

print("Rate limited, re-queuing...")

queue.add_request(

make_claude_request,

priority=priority-1, # Lower priority for retries

delay=10, # Wait 10 seconds before retrying

prompt=prompt,

callback=callback,

priority=priority

)

else:

print(f"Error: {e}")

queue.add_request(execute, priority=priority)

# Make some requests with different priorities

make_claude_request("High priority question", priority=10)

make_claude_request("Medium priority question", priority=5)

make_claude_request("Low priority question", priority=1)

Esta implementación:

- Crea una cola de prioridad para las solicitudes de API

- Procesa las solicitudes en función de la prioridad y el tiempo de ejecución programado

- Limita automáticamente las solicitudes para mantenerse por debajo de los límites de velocidad

- Maneja los reintentos con prioridad decreciente

Solución 3: Distribuir las solicitudes entre varias instancias

Para las aplicaciones de gran volumen, la distribución de las solicitudes de la API Claude entre varias instancias puede ayudarte a escalar más allá de los límites de una sola cuenta.

Equilibrio de carga entre varias claves de API

import random

import threading

from datetime import datetime, timedelta

class APIKeyManager:

def __init__(self, api_keys, requests_per_day_per_key):

self.api_keys = {}

self.lock = threading.Lock()

# Initialize each API key's usage tracking

for key in api_keys:

self.api_keys[key] = {

'key': key,

'daily_limit': requests_per_day_per_key,

'used_today': 0,

'last_reset': datetime.now().date(),

'available': True

}

def _reset_daily_counters(self):

"""Reset daily counters if it's a new day."""

today = datetime.now().date()

for key_info in self.api_keys.values():

if key_info['last_reset'] < today:

key_info['used_today'] = 0

key_info['last_reset'] = today

key_info['available'] = True

def get_available_key(self):

"""Get an available API key that hasn't exceeded its daily limit."""

with self.lock:

self._reset_daily_counters()

available_keys = [

key_info for key_info in self.api_keys.values()

if key_info['available'] and key_info['used_today'] < key_info['daily_limit']

]

if not available_keys:

return None

# Choose a key with the fewest used requests today

selected_key = min(available_keys, key=lambda k: k['used_today'])

selected_key['used_today'] += 1

# If key has reached its limit, mark as unavailable

if selected_key['used_today'] >= selected_key['daily_limit']:

selected_key['available'] = False

return selected_key['key']

def mark_key_used(self, api_key):

"""Mark that a request was made with this key."""

with self.lock:

if api_key in self.api_keys:

self.api_keys[api_key]['used_today'] += 1

if self.api_keys[api_key]['used_today'] >= self.api_keys[api_key]['daily_limit']:

self.api_keys[api_key]['available'] = False

def mark_key_rate_limited(self, api_key, retry_after=60):

"""Mark a key as temporarily unavailable due to rate limiting."""

with self.lock:

if api_key in self.api_keys:

self.api_keys[api_key]['available'] = False

# Start a timer to mark the key available again after the retry period

def make_available_again():

with self.lock:

if api_key in self.api_keys:

self.api_keys[api_key]['available'] = True

timer = threading.Timer(retry_after, make_available_again)

timer.daemon = True

timer.start()

# Example usage

api_keys = [

"key1_abc123",

"key2_def456",

"key3_ghi789"

]

key_manager = APIKeyManager(api_keys, requests_per_day_per_key=100)

def call_claude_api_distributed(prompt):

api_key = key_manager.get_available_key()

if not api_key:

raise Exception("No available API keys - all have reached their daily limits")

client = anthropic.Anthropic(api_key=api_key)

try:

response = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1000,

messages=[{"role": "user", "content": prompt}]

)

return response.content

except Exception as e:

if "429" in str(e):

# Parse retry-after header if available, otherwise use default

retry_after = 60 # Default

key_manager.mark_key_rate_limited(api_key, retry_after)

# Recursively try again with a different key

return call_claude_api_distributed(prompt)

else:

raise

Este enfoque:

- Administra varias claves de API y realiza un seguimiento de su uso

- Distribuye las solicitudes para mantenerse por debajo de los límites de velocidad por clave

- Maneja las respuestas de límite de velocidad eliminando temporalmente las claves afectadas de la rotación

- Restablece automáticamente los contadores de uso diariamente

Mejores prácticas para gestionar los límites de velocidad de la API Claude

Más allá de las tres soluciones anteriores, aquí hay algunas prácticas recomendadas adicionales:

Supervisa tu uso de forma proactiva

- Implementa paneles para realizar un seguimiento del uso de tu API

- Configura alertas para cuando te acerques a los límites de velocidad

- Revisa periódicamente los patrones de uso para identificar oportunidades de optimización

Implementa una degradación elegante

- Diseña tu aplicación para proporcionar respuestas alternativas cuando se limite la velocidad

- Considera la posibilidad de almacenar en caché las respuestas anteriores para consultas similares

- Proporciona comentarios transparentes a los usuarios cuando experimenten límites de velocidad

Optimiza tus prompts

- Reduce las llamadas innecesarias a la API elaborando prompts más eficaces

- Combina las consultas relacionadas en solicitudes únicas siempre que sea posible

- Preprocesa las entradas para eliminar la necesidad de solicitudes de aclaración

Comunícate con Anthropic

- Para las aplicaciones de producción, considera la posibilidad de actualizar a planes de nivel superior

- Ponte en contacto con Anthropic para obtener información sobre los límites de velocidad personalizados para tu caso de uso específico

- Mantente informado sobre las actualizaciones de la plataforma y los cambios en las políticas de limitación de velocidad

Conclusión

Los límites de velocidad son una parte inevitable del trabajo con cualquier API potente como Claude. Al implementar las soluciones descritas en este artículo (código de limitación de velocidad adecuado, cola de solicitudes y manejo de solicitudes distribuidas), puedes crear aplicaciones sólidas que manejen con elegancia estas limitaciones.

Recuerda que los límites de velocidad existen para garantizar un acceso justo y la estabilidad del sistema para todos los usuarios. Trabajar dentro de estas restricciones no solo mejora la fiabilidad de tu aplicación, sino que también contribuye a la salud general del ecosistema.

Con una planificación cuidadosa y la implementación de estas estrategias, puedes maximizar el uso de las potentes capacidades de IA de Claude manteniendo una experiencia fluida para tus usuarios, incluso a medida que tu aplicación se escala.