تشغيل نماذج البرمجة المتقدمة محليًا يمكّن المطورين من الاستفادة من الذكاء الاصطناعي المتقدم دون الاعتماد على خدمات السحابة. DeepCoder، نموذج برمجة مكون من 14 مليار معلمة ومفتوح المصدر بالكامل، يقدم أداءً استثنائيًا قابلًا للمقارنة مع O3-mini. عند اقترانه بـ Ollama، وهو إطار عمل خفيف لتشغيل نماذج اللغة الكبيرة (LLMs)، يمكنك نشر DeepCoder بكفاءة على جهازك. يوجّهك هذا الدليل الفني خلال العملية، من الإعداد إلى التنفيذ، بينما يتم دمج أدوات مثل Apidog لاختبار واجهات برمجة التطبيقات (APIs).

ما هو DeepCoder؟

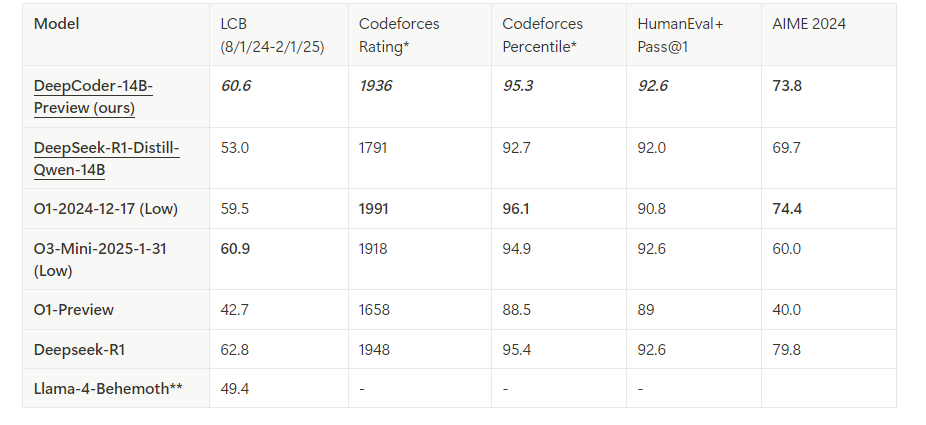

DeepCoder هو نموذج برمجة مفتوح المصدر يحتوي على 14 مليار معلمة تم تطويره من خلال التعاون بين Agentica وTogether AI. تم بناؤه عن طريق تحسين Deepseek-R1-Distilled-Qwen-14B مع التعلم المعزز الموزع (RL)، وهو يتفوق في مهام استنتاج الشيفرة وتوليدها. بالإضافة إلى ذلك، يوجد إصدار أصغر بقدرة 1.5 مليار معلمة مناسب للبيئات ذات الموارد المحدودة. على عكس النماذج المملوكة، يسمح الطابع المفتوح المصدر لـ DeepCoder بالشفافية الكاملة والتخصيص، مما يجعله مفضلًا بين المطورين.

Ollama، من ناحية أخرى، يسهل نشر نماذج LLM مثل DeepCoder. يوفر وقت تشغيل خفيف وواجهة برمجة تطبيقات لتكامل سلس ضمن سير العمل الخاص بالتطوير. من خلال دمج هذه الأدوات، يمكنك فتح مساعد برمجة قوي يعمل محليًا.

المتطلبات اللازمة لتشغيل DeepCoder محليًا

قبل المتابعة، تأكد من أن نظامك يناسب المتطلبات. إليك ما تحتاجه:

الأجهزة:

- آلة بحد أدنى 32 جيجابايت من ذاكرة الوصول العشوائي (من الموصى به أن تكون 64 جيجابايت لنموذج 14B).

- وحدة معالجة رسومات حديثة (مثل NVIDIA RTX 3090 أو أفضل) بذاكرة 24 جيجابايت أو أكثر لأفضل أداء.

- بدلاً من ذلك، يمكن استخدام معالج مركزي مع عدد كافٍ من الأنوية (مثل Intel i9 أو AMD Ryzen 9) لنموذج 1.5B.

البرمجيات:

- نظام التشغيل: Linux (Ubuntu 20.04+)، macOS، أو Windows (عبر WSL2).

- Git: لاستنساخ المستودعات.

- Docker (اختياري): للاستخدام الحاويات.

- Python 3.9+: لتشغيل السكربتات والتفاعل مع واجهة برمجة التطبيقات.

التبعيات:

- Ollama: مثبت ومكون بشكل صحيح.

- ملفات نموذج DeepCoder: تم تنزيلها من مكتبة Ollama الرسمية.

مع هذه الأمور في مكانها، يمكنك الآن البدء في تثبيت وتكوين البيئة.

الخطوة 1: تثبيت Ollama على جهازك

يعمل Ollama كدعامة لتشغيل DeepCoder محليًا. اتبع هذه الخطوات لتثبيته:

قم بتنزيل Ollama:

قم بزيارة الموقع الرسمي لـ Ollama أو استخدم مدير الحزم. لنظام Linux، نفذ:

curl -fsSL https://ollama.com/install.sh | sh

على macOS، استخدم Homebrew:

brew install ollama

تحقق من التثبيت:

تحقق من إصدار Ollama للتأكد من أنه تم تثبيته بشكل صحيح:

ollama --version

ابدأ خدمة Ollama:

قم بتشغيل Ollama في الخلفية:

ollama serve &

هذا يقوم بتشغيل الخادم على localhost:11434، مما يتيح واجهة برمجة التطبيقات لتفاعلات النموذج.

Ollama الآن قيد التشغيل. التالي، عليك استرداد نموذج DeepCoder.

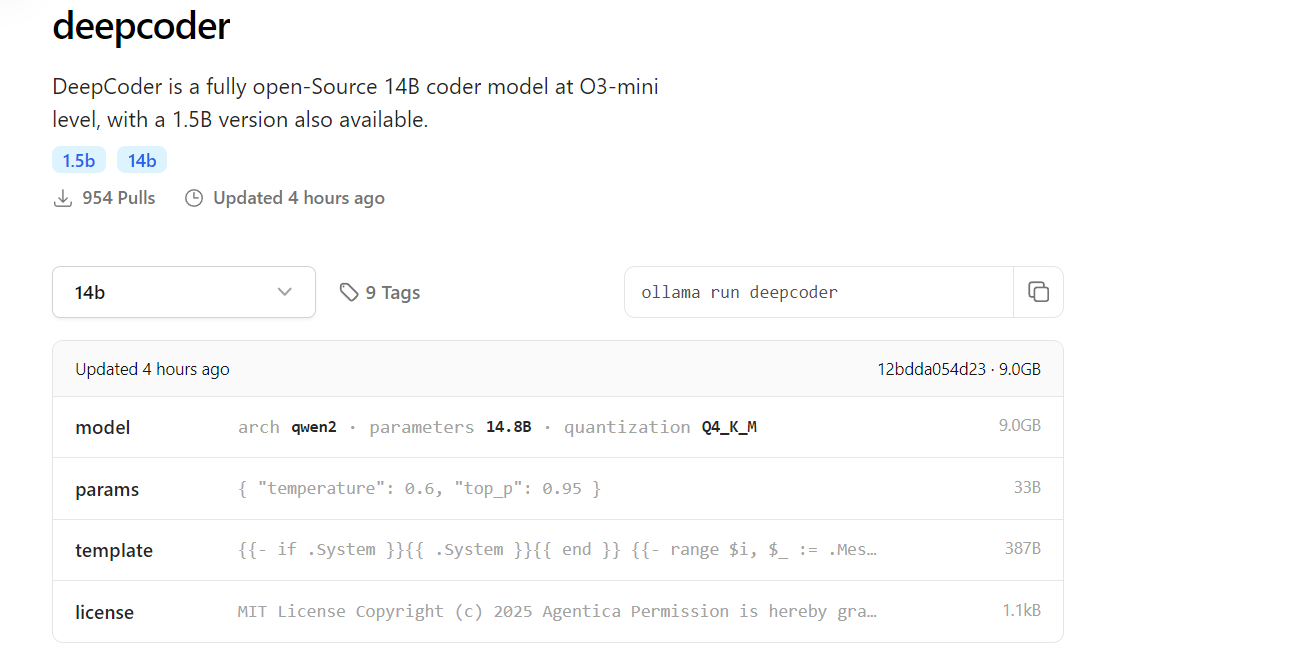

الخطوة 2: تنزيل DeepCoder من مكتبة Ollama

DeepCoder متوفر في مكتبة نماذج Ollama. إليك كيفية استرداده:

استرداد DeepCoder:

قم بتنزيل نموذج 14B (أو 1.5B للإعدادات الأخف):

ollama pull deepcoder

هذا الأمر يقوم بجلب أحدث إصدار مضاف. للحصول على إصدار محدد، استخدم:

ollama pull deepcoder:14b-preview

مراقبة تقدم التنزيل:

تقوم العملية ببث التحديثات، مع عرض وأعداد الملفات وحالة الاكتمال. توقع تنزيلًا عدة جيجابايت لنموذج 14B، لذا تأكد من وجود اتصال إنترنت مستقر.

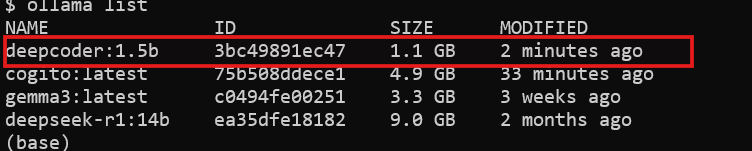

تحقق من التثبيت:

تحقق مما إذا كان DeepCoder متاحًا:

ollama list

سترى deepcoder مدرجًا ضمن النماذج المثبتة.

مع تنزيل DeepCoder، أصبحت جاهزًا لتشغيله.

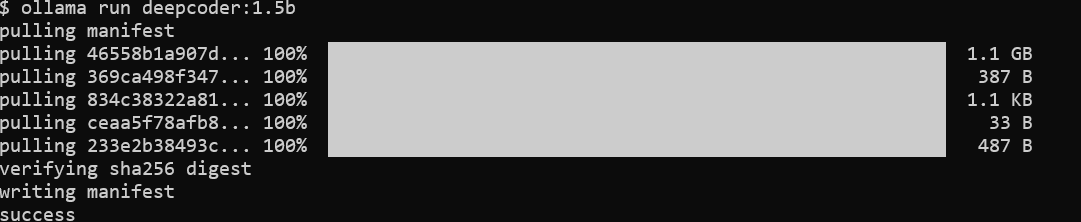

الخطوة 3: تشغيل DeepCoder محليًا مع Ollama

الآن، قم بتنفيذ DeepCoder واختبار قدراته:

ابدأ DeepCoder:

قم بتشغيل النموذج في جلسة تفاعلية:

ollama run deepcoder

هذا يفتح موجهًا حيث يمكنك إدخال استفسارات البرمجة.

تعديل المعلمات (اختياري):

للاستخدام المتقدم، قم بتعديل الإعدادات مثل درجة الحرارة عبر ملف تكوين أو استدعاء API (سيتم تغطيته لاحقًا).

DeepCoder الآن يعمل محليًا. ومع ذلك، لدمجه في سير العمل الخاص بك، ستستخدم واجهته البرمجية.

الخطوة 4: التفاعل مع DeepCoder عبر واجهة برمجة التطبيقات الخاصة بـ Ollama

يقوم Ollama بتوفير واجهة برمجة تطبيقات RESTful للوصول البرمجي. إليك كيفية الاستفادة منه:

تحقق من توفر واجهة برمجة التطبيقات:

تأكد من تشغيل خادم Ollama:

curl http://localhost:11434

تؤكد الاستجابة أن الخادم نشط.

أرسل طلبًا:

استخدم curl لاستعلام DeepCoder:

curl http://localhost:11434/api/generate -d '{

"model": "deepcoder",

"prompt": "توليد نقطة نهاية واجهة برمجة تطبيقات REST في Flask",

"stream": false

}'

تتضمن الاستجابة الشيفرة المولدة، مثل:

from flask import Flask, jsonify

app = Flask(__name__)

@app.route('/api/data', methods=['GET'])

def get_data():

return jsonify({"message": "مرحبًا بالعالم!"})

if __name__ == "__main__":

app.run(debug=True)

دمج مع Python:

استخدم مكتبة requests في Python لتفاعل أكثر نظافة:

import requests

url = "http://localhost:11434/api/generate"

payload = {

"model": "deepcoder",

"prompt": "اكتب واجهة برمجة تطبيقات Node.js Express",

"stream": False

}

response = requests.post(url, json=payload)

print(response.json()["response"])

تفتح واجهة برمجة التطبيقات إمكانيات DeepCoder للتشغيل الآلي والتكامل.

الخطوة 5: تحسين اختبار واجهة برمجة التطبيقات باستخدام Apidog

يتفوق DeepCoder في توليد شيفرات واجهة برمجة التطبيقات، ولكن اختبار تلك الواجهات أمر حيوي. يسهل Apidog هذه العملية:

تثبيت Apidog:

قم بتنزيل وتثبيت Apidog من موقعه الرسمي.

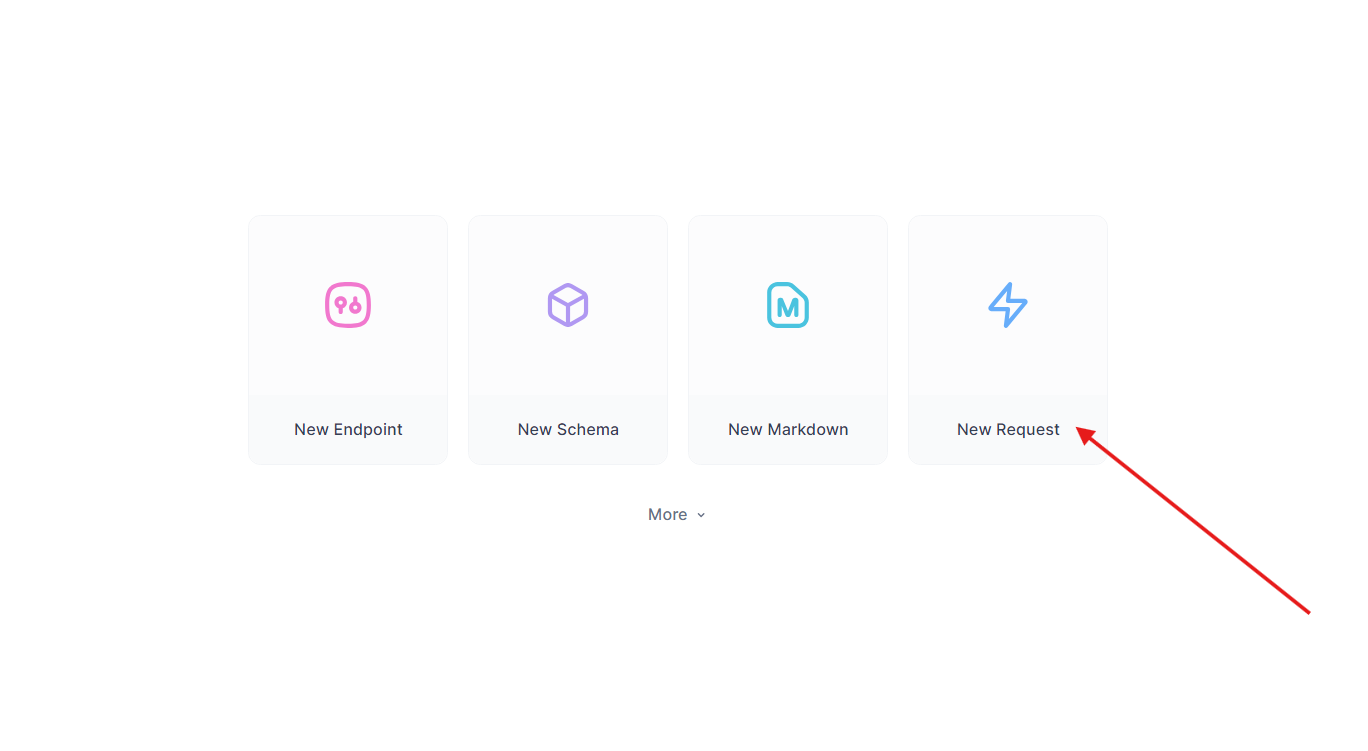

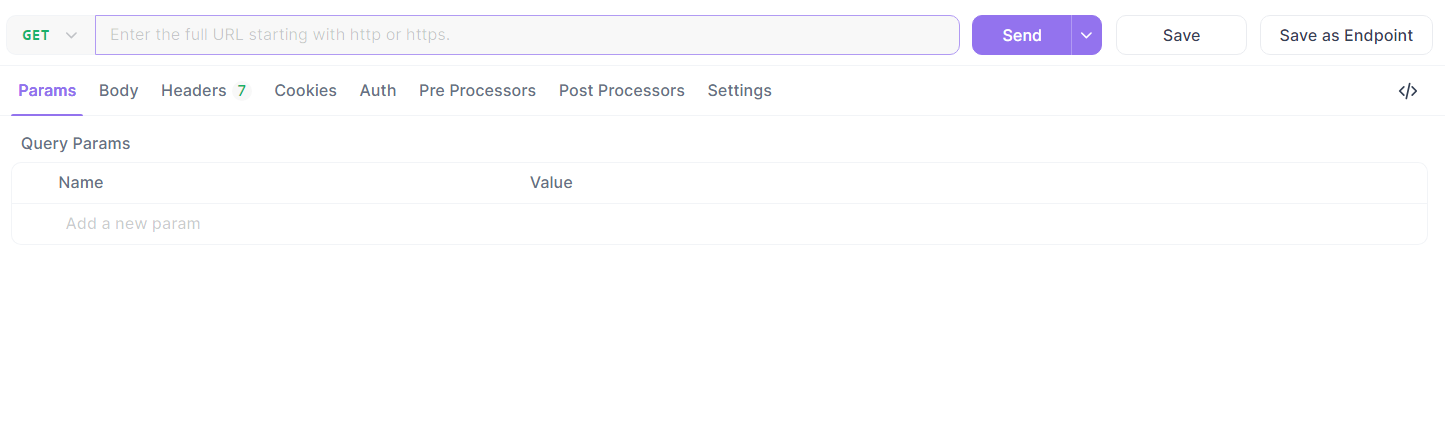

اختبر واجهة برمجة التطبيقات المولدة:

خذ نقطة النهاية Flask من قبل. في Apidog:

- أنشئ طلبًا جديدًا.

- قم بتعيين عنوان URL إلى

http://localhost:5000/api/dataوأرسل طلب GET.

- تحقق من الاستجابة:

{"message": "مرحبًا بالعالم!"}.

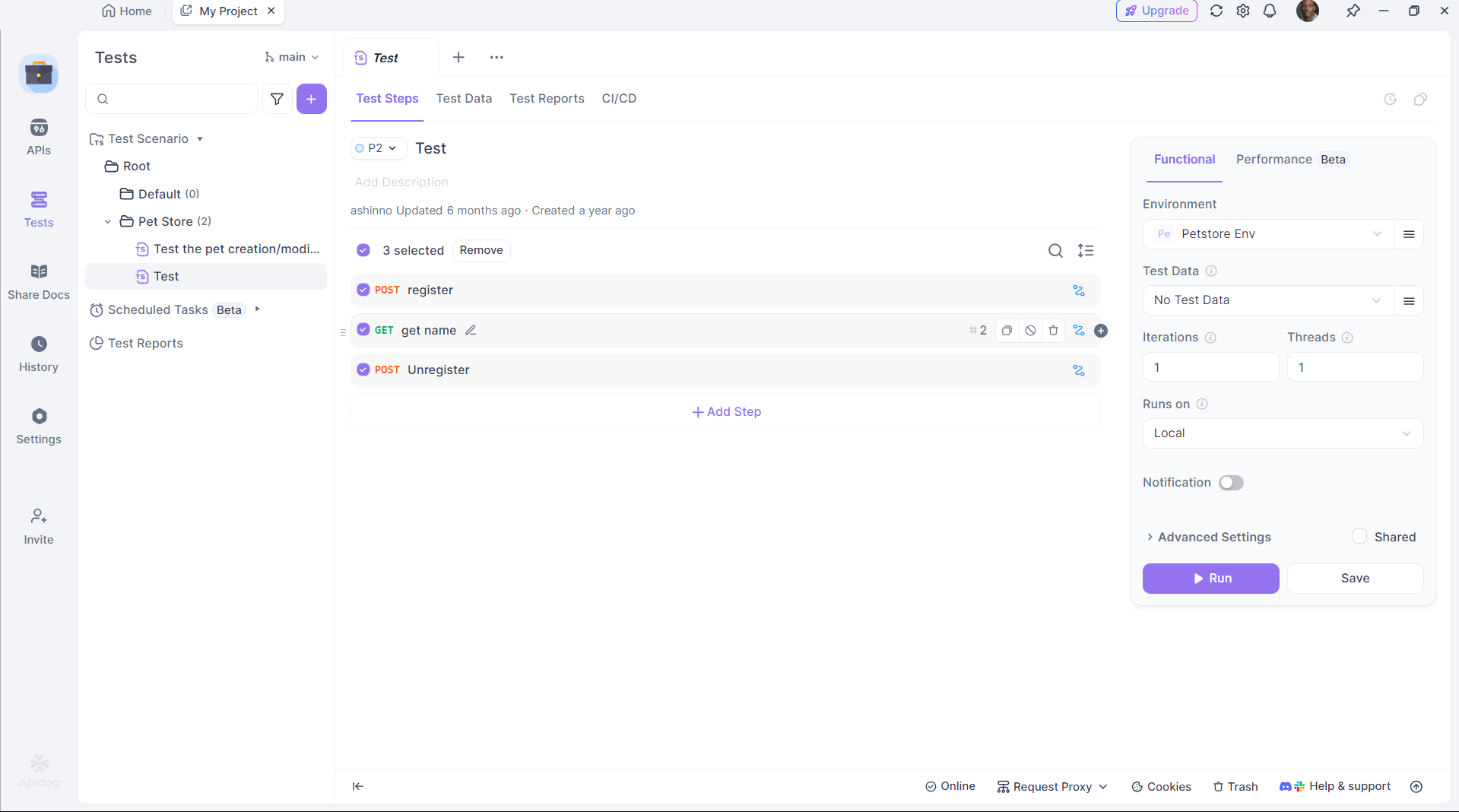

أتمتة الاختبار:

استخدم السكربتات المتاحة في Apidog لتسهيل التحقق، مما يضمن أن إنتاج DeepCoder يتوافق مع التوقعات.

يجسر Apidog الفجوة بين توليد الشيفرات والنشر، مما يعزز الإنتاجية.

الخطوة 6: تحسين أداء DeepCoder

لزيادة الكفاءة، قم بتحسين إعداد DeepCoder:

تسريع GPU:

تأكد من أن Ollama ينقل الحسابات إلى وحدة معالجة الرسومات الخاصة بك. تحقق من ذلك باستخدام:

nvidia-smi

يظهر استخدام GPU تسريعًا ناجحًا.

إدارة الذاكرة:

للنموذج 14B، خصص ذاكرة VRAM كافية. قم بضبط مساحة التبديل على Linux إذا لزم الأمر:

sudo fallocate -l 32G /swapfile

sudo chmod 600 /swapfile

sudo mkswap /swapfile

sudo swapon /swapfile

تكميم النموذج:

استخدم تكميمًا أصغر (مثل 4 بت) لنموذج 1.5B:

ollama pull deepcoder:1.5b-q4

تضمن هذه التعديلات تشغيل DeepCoder بسلاسة على الأجهزة الخاصة بك.

لماذا تختار DeepCoder مع Ollama؟

تشغيل DeepCoder محليًا يقدم مزايا مميزة:

- الخصوصية: حافظ على الشيفرات الحساسة بعيدًا عن خوادم السحابة.

- التكلفة: تجنب رسوم الاشتراك.

- التخصيص: خصص النموذج وفقًا لاحتياجاتك.

يجعل جمعه مع إطار عمل Ollama الخفيف وقدرات اختبار Apidog بيئة تطوير قوية ومتكاملة.

الخاتمة

تشكل إعداد DeepCoder محليًا مع Ollama عملية بسيطة ولكنها تحوّلية. تقوم بتثبيت Ollama، وسحب DeepCoder، وتشغيله، ودمجه عبر واجهة برمجة التطبيقات - كل ذلك في بضع خطوات. أدوات مثل Apidog تعزز التجربة من خلال التأكد من عمل واجهات برمجة التطبيقات المولدة بشكل خالٍ من الأخطاء. سواء كنت مطورًا فرديًا أو جزءًا من فريق، فإن هذا الإعداد يقدم مساعد برمجة قوي ومفتوح المصدر.