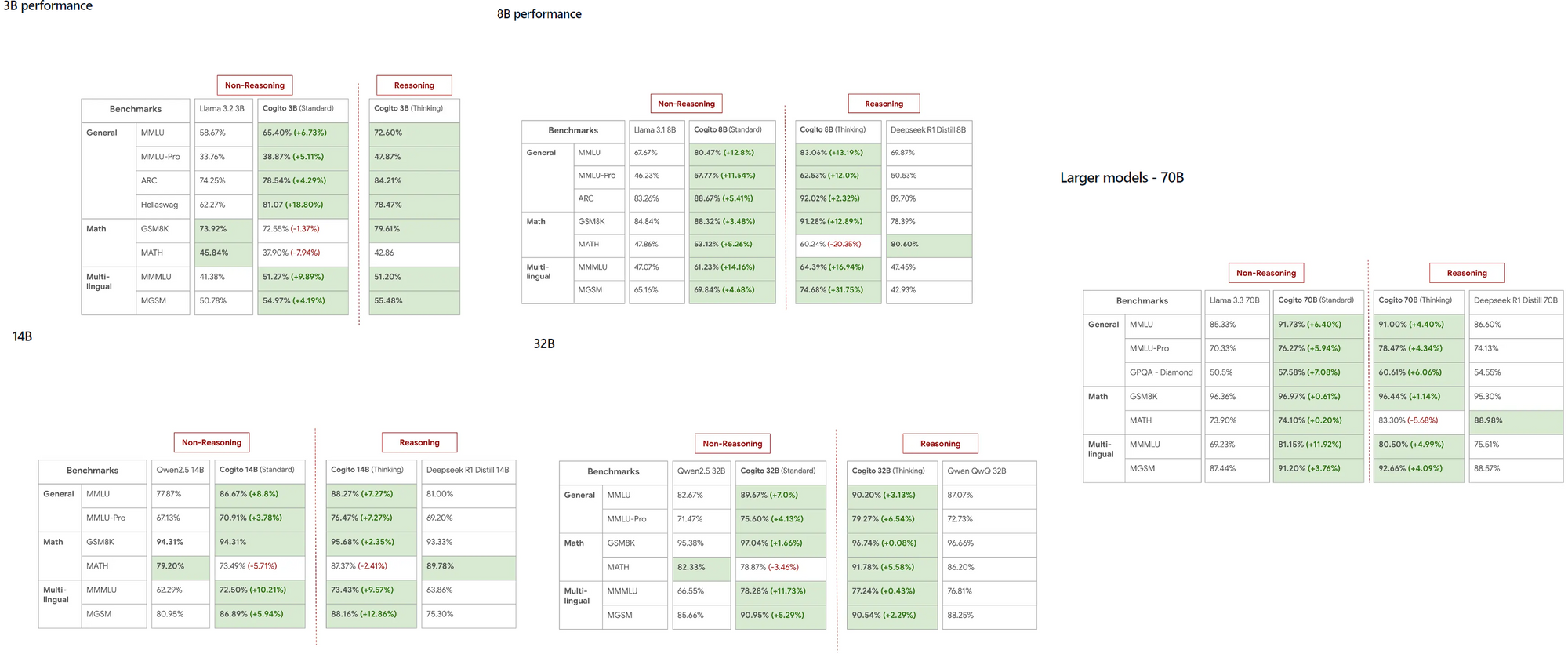

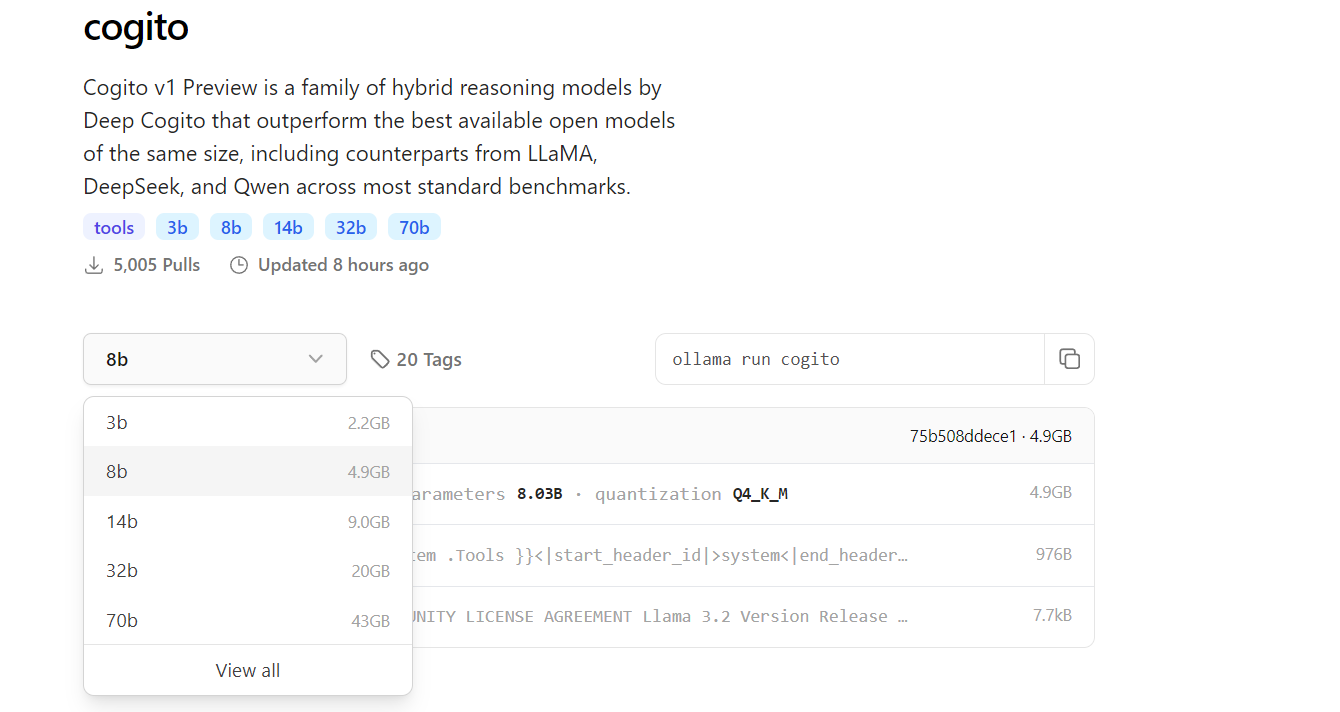

نموذج Cogito، الذي أطلقته DeepCogito، حصل بسرعة على اهتمام مجتمع الذكاء الاصطناعي بفضل قدرته الملحوظة على التفوق على النماذج المعروفة مثل LLaMA و DeepSeek عبر مقاييس متنوعة. توفر هذه النماذج مفتوحة المصدر، التي تتراوح من 3B إلى 70B من المعلمات، للمطورين أداة قوية لاستكشاف الذكاء الفائق العام مباشرة على أجهزتهم المحلية.

ما تحتاج إلى معرفته عن Cogito و Ollama

Cogito تمثل سلسلة من نماذج الذكاء الاصطناعي مفتوحة المصدر التي طورتها فريق DeepCogito، مع تركيز واضح على تحقيق الذكاء الفائق العام. تستفيد هذه النماذج من تقنية تُسمى التقطير والتعزيز المتكرر (IDA)، والتي تعزز بشكل متكرر قدرات التفكير في النموذج باستخدام المزيد من الحساب للوصول إلى حلول أفضل ثم تقطير تلك العملية إلى معلمات النموذج. متاحة بأحجام مثل 3B و 8B و 14B و 32B و 70B، من المقرر أن تتوسع نماذج Cogito أكثر مع الإصدارات القادمة من نماذج 109B و 400B من المعلمات.

من ناحية أخرى، Ollama هو إطار عمل متعدد الاستخدامات يمكّن المطورين من تشغيل LLMs محليًا على أجهزتهم، مما يلغي الحاجة إلى واجهات برمجة التطبيقات المستندة إلى السحابة. يدعم Ollama منصات متعددة مثل MacOS و Windows و Linux، مما يضمن سهولة الوصول لمجموعة واسعة من المستخدمين. من خلال تشغيل Cogito محليًا مع Ollama، يمكنك تجربة نماذج ذكاء اصطناعي متقدمة على الجهاز، مما لا يوفر التكاليف فحسب، بل يعزز أيضًا خصوصية البيانات لتطبيقات حساسة.

لماذا تشغيل Cogito محليًا؟

تقدم تشغيل Cogito محليًا العديد من المزايا للمطورين. أولاً، يقضي على الاعتماد على واجهات برمجة التطبيقات الخارجية، مما يقلل وقت الانتظار ويضمن أن تظل بياناتك خاصة. هذا مهم بشكل خاص للتطبيقات التي تكون فيها أمان البيانات أولوية. علاوة على ذلك، أظهرت نماذج Cogito أداءً متفوقًا مقارنة بالمنافسين مثل LLaMA 4 Scout، حتى عند المقاييس الصغيرة، مما يجعلها خيارًا ممتازًا للمهام عالية الأداء.

التنفيذ المحلي مثالي أيضًا للمطورين الذين يعملون في بيئات محدودة الموارد أو في مناطق ذات وصول محدود إلى الإنترنت، حيث يسمح بالعمل السلس دون اتصال. بالإضافة إلى ذلك، تبسط واجهة الأوامر المباشرة لـ Ollama عملية إدارة وتشغيل نماذج متعددة، بما في ذلك Cogito. أخيرًا، يتيح الإعداد المحلي تحسين سرعة التكرار خلال مرحلة التطوير، خاصة عند اختبار تكامل واجهات برمجة التطبيقات، والتي يمكن إدارتها بكفاءة باستخدام أدوات مثل Apidog لتصميم وتصحيح نقاط النهاية الخاصة بك.

المتطلبات المسبقة لتشغيل Cogito مع Ollama

قبل البدء في عملية الإعداد، تأكد من أن نظامك يلبي المتطلبات اللازمة. بالنسبة للنماذج الأصغر مثل الإصدارات التي تحتوي على 3B أو 8B من المعلمات، ينبغي أن تحتوي جهازك على 16GB على الأقل من ذاكرة الوصول العشوائي، بينما قد تحتاج النماذج الأكبر مثل 70B إلى 64GB أو أكثر لتعمل بسلاسة. يُوصى بشدة باستخدام بطاقة GPU متوافقة، مثل بطاقة NVIDIA مع دعم CUDA، لأنها تسهم بشكل كبير في تسريع استدلال النموذج.

ستحتاج أيضًا إلى تثبيت Python 3.8 أو أعلى، حيث إنه اعتماد لمكتبة Python الخاصة بـ Ollama والأدوات ذات الصلة الأخرى.

بعد ذلك، قم بتنزيل وتثبيت Ollama من موقعه الرسمي أو مستودع GitHub الخاص به، مع اتباع التعليمات الخاصة بنظام التشغيل الخاص بك. التخزين هو عامل حاسم آخر - يمكن أن تتراوح نماذج Cogito من Gigabytes قليلة للنموذج 3B إلى أكثر من 100GB للنموذج 70B، لذا تأكد من أن نظامك لديه مساحة كافية. أخيرًا، إذا كنت تخطط لتكامل Cogito مع واجهات برمجة التطبيقات، فإن تثبيت Apidog سيساعدك في تصميم واختبار نقاط النهاية الخاصة بك بكفاءة، مما يضمن تجربة تطوير سلسة.

الخطوة 1: تثبيت Ollama على جهازك

الخطوة الأولى في تشغيل Cogito محليًا هي تثبيت Ollama على جهازك. ابدأ بزيارة موقع Ollama أو صفحة GitHub لتنزيل المثبت لنظام التشغيل الخاص بك. لمستخدمي MacOS و Windows، فقط قم بتشغيل المثبت واتبع التعليمات الظاهرة على الشاشة لإكمال الإعداد. إذا كنت تستخدم Linux، يمكنك تثبيت Ollama مباشرة عن طريق تنفيذ الأمر :

curl -fsSL https://ollama.com/install.sh | sh في طرفيتك (terminal).

بمجرد اكتمال التثبيت، افتح طرفية واكتب ollama --version للتأكد من أنه تم تثبيت Ollama بشكل صحيح.

لضمان تشغيل Ollama، نفذ ollama serve، الذي يبدأ الخادم المحلي لإدارة النماذج. تقوم هذه الخطوة أيضًا بإعداد واجهة الأوامر الخاصة بـ Ollama، التي ستستخدمها لتحميل وتشغيل نماذج مثل Cogito في الخطوات التالية.

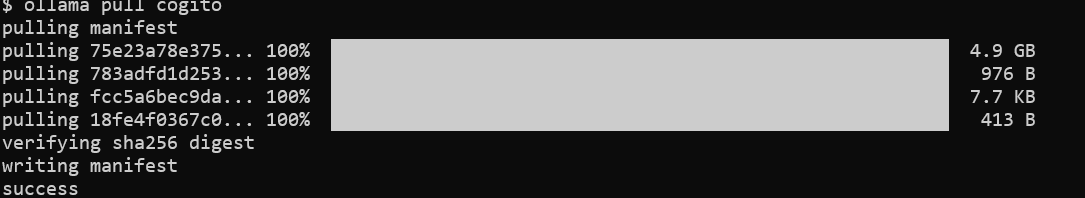

الخطوة 2: تحميل نموذج Cogito من مكتبة Ollama

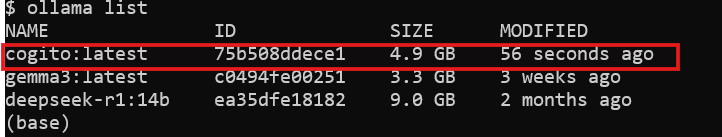

مع تثبيت Ollama، الخطوة التالية هي تنزيل نموذج Cogito. افتح طرفيتك وقم بتشغيل الأمر ollama pull cogito لجلب نموذج Cogito من مكتبة Ollama.

بشكل افتراضي، يقوم هذا الأمر بسحب أحدث إصدار من نموذج Cogito، لكن يمكنك تحديد حجم معين باستخدام علامة، مثل ollama pull cogito:3b لنموذج المعلمات 3B. يمكنك استكشاف أحجام النماذج المتاحة على https://ollama.com/library/cogito.

اعتمادًا على سرعة الإنترنت لديك وحجم النموذج، قد تستغرق عملية التنزيل بعض الوقت - توقع حوالي 2.2GB للنموذج 3B وما يصل إلى 43GB للنموذج 70B. بعد اكتمال التنزيل، تحقق من أن النموذج متاح على نظامك عن طريق تشغيل ollama list، الذي يعرض جميع النماذج المثبتة. في هذه المرحلة، أصبح Cogito جاهزًا للتشغيل محليًا، ويمكنك الانتقال إلى الخطوة التالية.

الخطوة 3: تشغيل Cogito محليًا مع Ollama

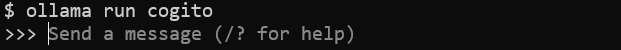

الآن بعد أن تم تنزيل النموذج، يمكنك البدء في تشغيل Cogito على جهازك. في طرفيتك، نفذ الأمر ollama run cogito لتشغيل نموذج Cogito.

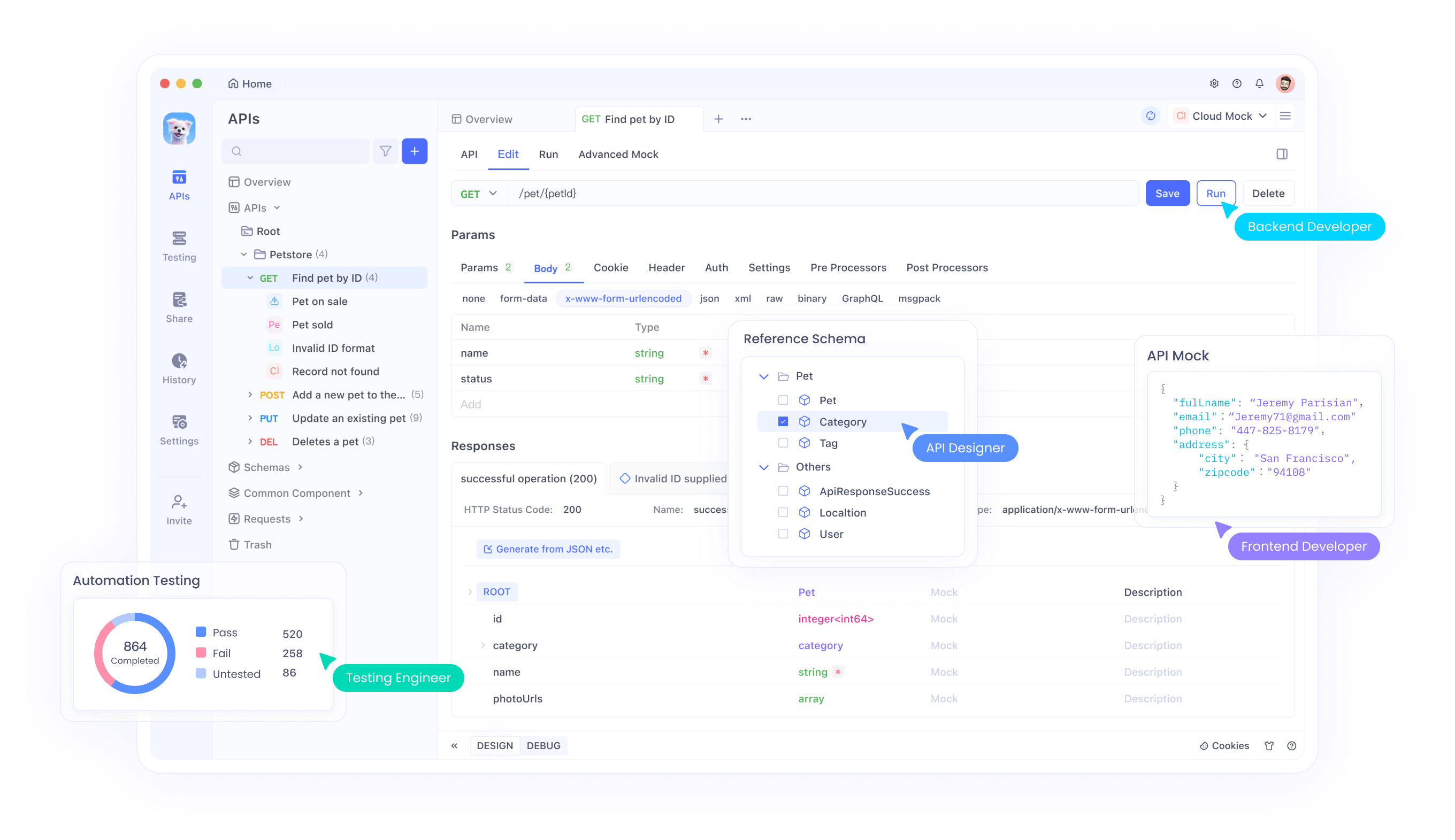

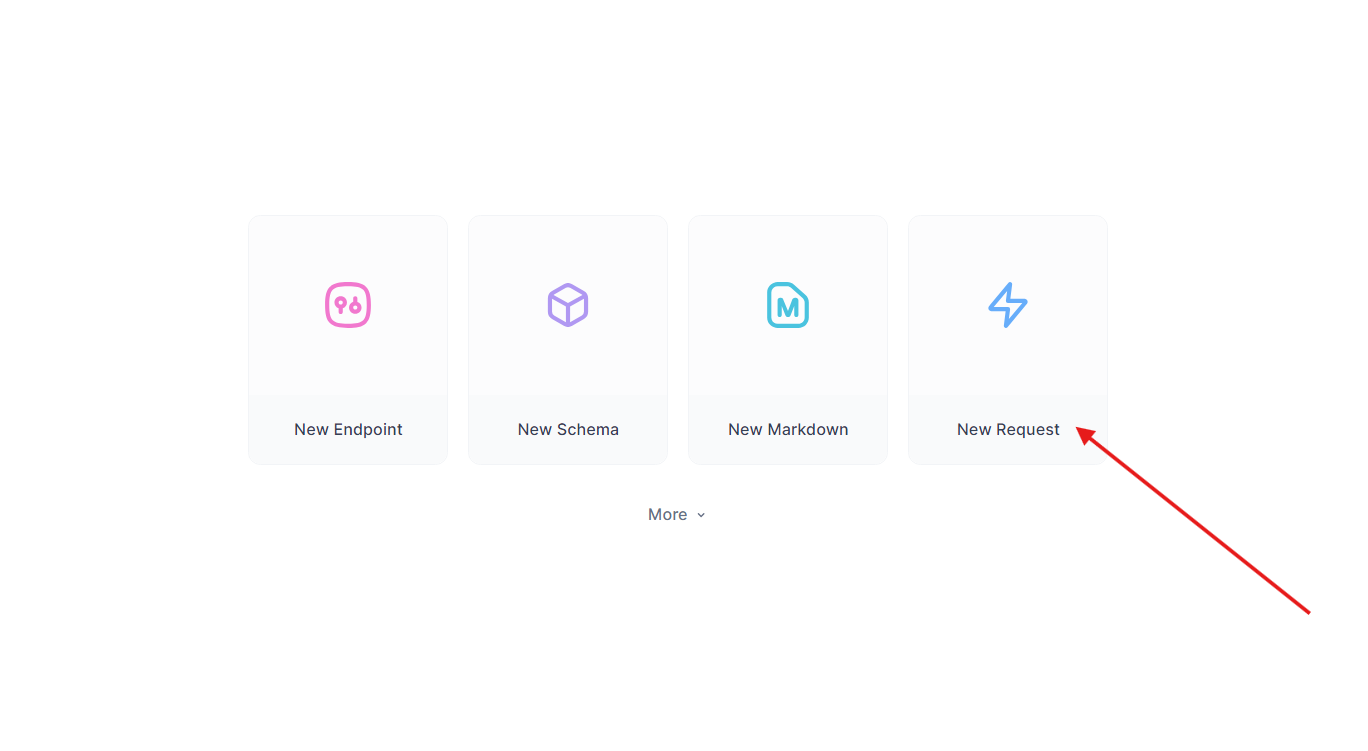

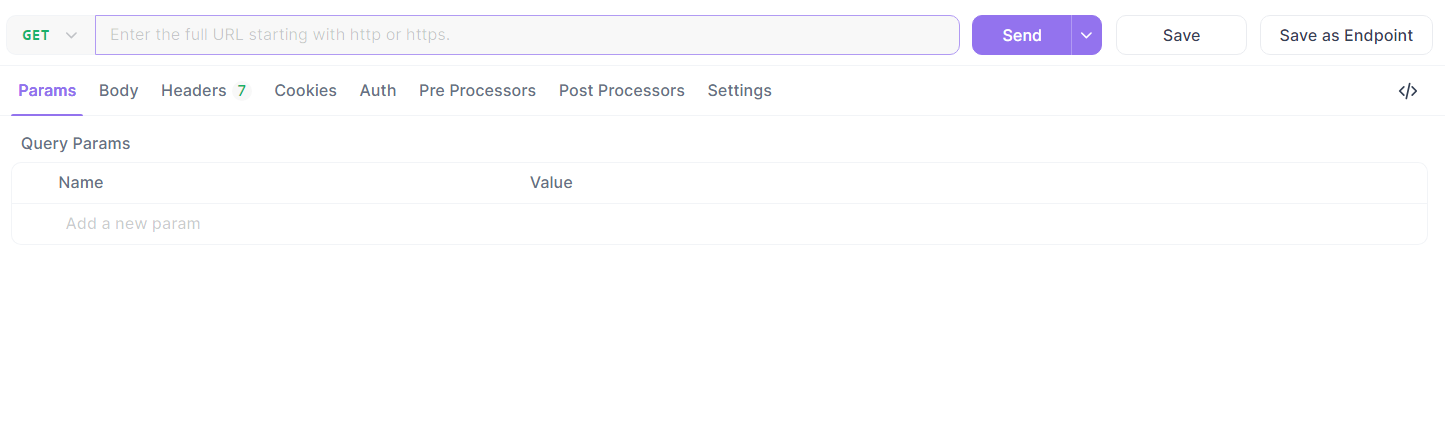

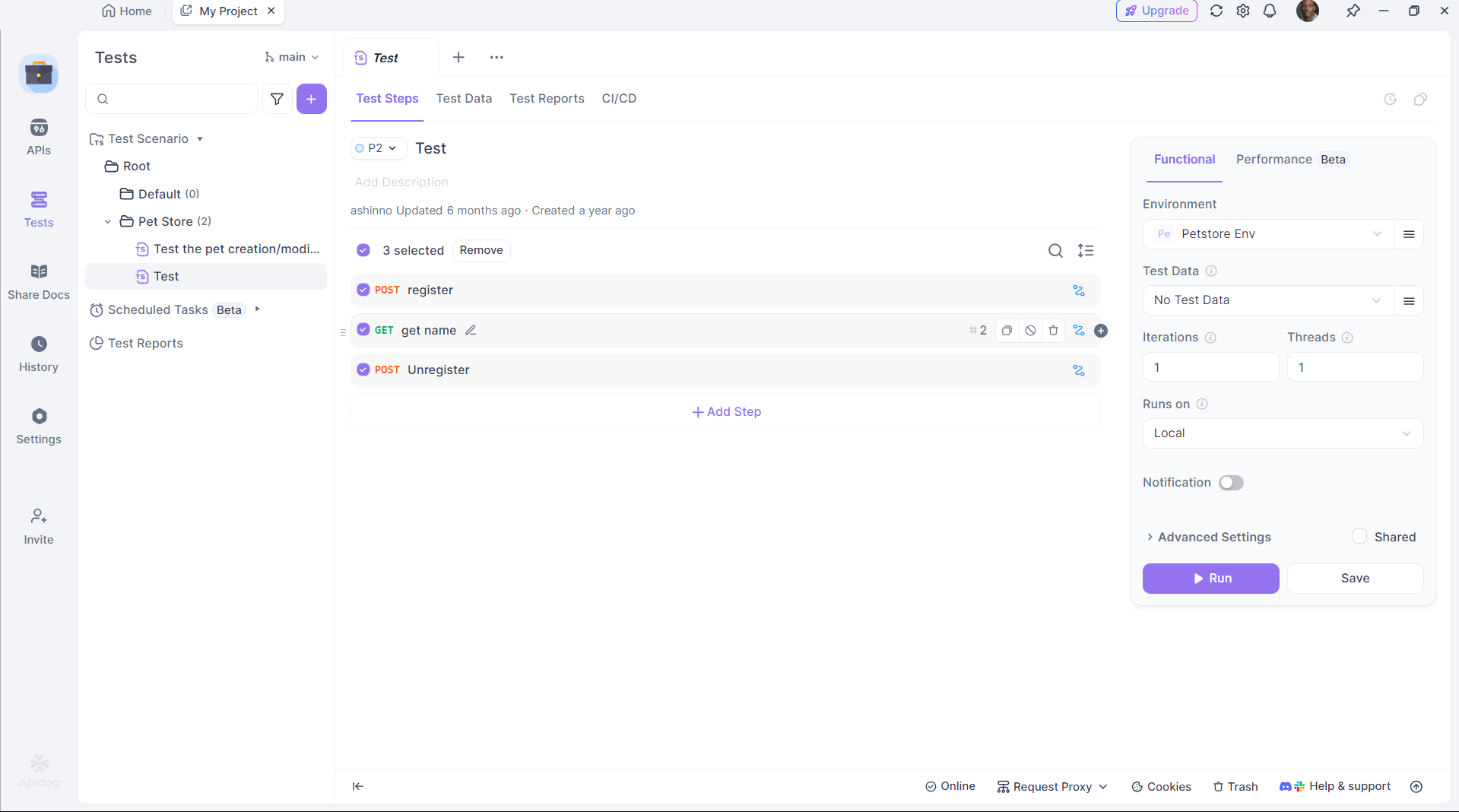

الخطوة 4: تحسين اختبار واجهات برمجة التطبيقات مع Apidog

يتميز Cogito بإنتاج كود واجهة برمجة التطبيقات، لكن اختبار تلك الواجهات ضروري. يبسط Apidog هذه العملية:

تثبيت Apidog:

قم بتنزيل وتثبيت Apidog من موقعه الرسمي.

اختبر واجهة برمجة التطبيقات التي تم إنشاؤها:

خذ نقطة النهاية Flask من قبل. في Apidog:

- قم بإنشاء طلب جديد.

- قم بتعيين عنوان URL إلى

http://localhost:5000/api/dataوأرسل طلب GET.

- تحقق من الاستجابة:

{"message": "Hello, World!"}.

أتمتة الاختبار:

استخدم برمجة Apidog لأتمتة التحقق، مما يضمن أن مخرجات DeepCoder تفي بالتوقعات.

يجسر Apidog الفجوة بين توليد الكود والنشر، مما يعزز من الإنتاجية.

تشخيص المشكلات الشائعة

قد يقدم تشغيل Cogito محليًا أحيانًا تحديات، لكن معظم المشكلات يمكن حلها من خلال بعض الفحوصات. إذا فشل Ollama في البدء، تحقق من عدم استخدام أي عملية أخرى للمنفذ 11434 - يمكنك قتل العملية المتعارضة أو تغيير المنفذ في تكوين Ollama. بالنسبة لأخطاء "نفاد الذاكرة"، فكر في تقليل حجم النموذج أو زيادة مساحة التبادل في نظامك لاستيعاب نماذج أكبر. إذا لم يستجب النموذج، تأكد من أنك سحبته بشكل صحيح باستخدام ollama pull cogito وأنه يظهر في ناتج ollama list. غالبًا ما تشير أوقات الاستدلال البطيئة إلى أنك تعمل على معالج مركزي فقط - تحقق من دعم GPU عن طريق تشغيل nvidia-smi للتأكد من أن CUDA نشطة.

عند استخدام Apidog لتكامل واجهات برمجة التطبيقات، قد تحدث أخطاء نتيجة لحمولات JSON غير الصحيحة، لذا تحقق مرة أخرى من مخططك في محرر Apidog. للحصول على تشخيصات أكثر تفصيلًا، راجع سجلات Ollama في ~/.ollama/logs لتحديد وحل المشكلات بسرعة.

الخاتمة

يسمح تشغيل Cogito محليًا مع Ollama بفتح عالم من الإمكانيات للمطورين الذين يتطلعون لاستكشاف الذكاء الفائق العام. من خلال اتباع الخطوات الموضحة في هذا الدليل، يمكنك إعداد Cogito على جهازك، وتحسين أدائه، وحتى دمجه في تطبيقات أكبر باستخدام واجهات برمجة التطبيقات المدارة عبر Apidog. سواء كنت تبني نظام RAG، أو مساعد ترميز، أو تطبيق ويب، تجعل القدرات المتقدمة لـ Cogito أداة قوية للابتكار. مع استمرار فريق DeepCogito في إصدار نماذج أكبر وتعديل تقنياتهم، ستزداد الإمكانية لتطوير الذكاء الاصطناعي المحلي، مما يمكّن المطورين من إنشاء حلول رائدة.