كان تشغيل نماذج اللغة الكبيرة (LLMs) محليًا في السابق حكرًا على مستخدمي سطر الأوامر (CLI) المتمرسين وخبراء الأنظمة. لكن هذا يتغير بسرعة. فقد أصدرت Ollama، المعروفة بواجهتها البسيطة لسطر الأوامر لتشغيل نماذج اللغة الكبيرة مفتوحة المصدر على الأجهزة المحلية، للتو تطبيقات سطح مكتب أصلية لنظامي macOS و Windows.

وهي ليست مجرد أغلفة أساسية. بل تجلب هذه التطبيقات ميزات قوية تجعل الدردشة مع النماذج، وتحليل المستندات، وكتابة التوثيقات، وحتى العمل مع الصور أسهل بكثير للمطورين.

في هذه المقالة، سنستكشف كيف تعمل تجربة سطح المكتب الجديدة على تحسين سير عمل المطورين، وما هي الميزات البارزة، وأين تتألق هذه الأدوات بالفعل في الحياة اليومية للبرمجة.

لماذا لا تزال نماذج اللغة الكبيرة المحلية مهمة

بينما تهيمن الأدوات المستندة إلى السحابة مثل ChatGPT و Claude و Gemini على العناوين الرئيسية، هناك حركة متنامية نحو تطوير الذكاء الاصطناعي الذي يركز على التشغيل المحلي أولاً. يرغب المطورون في أدوات تتميز بما يلي:

- خاصة - يبقى رمزك ومستنداتك على جهازك.

- قابلة للتخصيص - تختار النماذج، وحدود الذاكرة، والأجهزة.

- صديقة للعمل دون اتصال - لا تعتمد على واجهات برمجة التطبيقات الخارجية أو وقت التشغيل.

- سريعة - لا يوجد زمن انتقال للشبكة أو اختناقات في الخادم.

تستفيد Ollama مباشرة من هذا الاتجاه، مما يتيح لك تشغيل نماذج مثل LLaMA و Mistral و Gemma و Codellama و Mixtral وغيرها بشكل أصلي على جهازك - الآن بتجربة أكثر سلاسة بكثير.

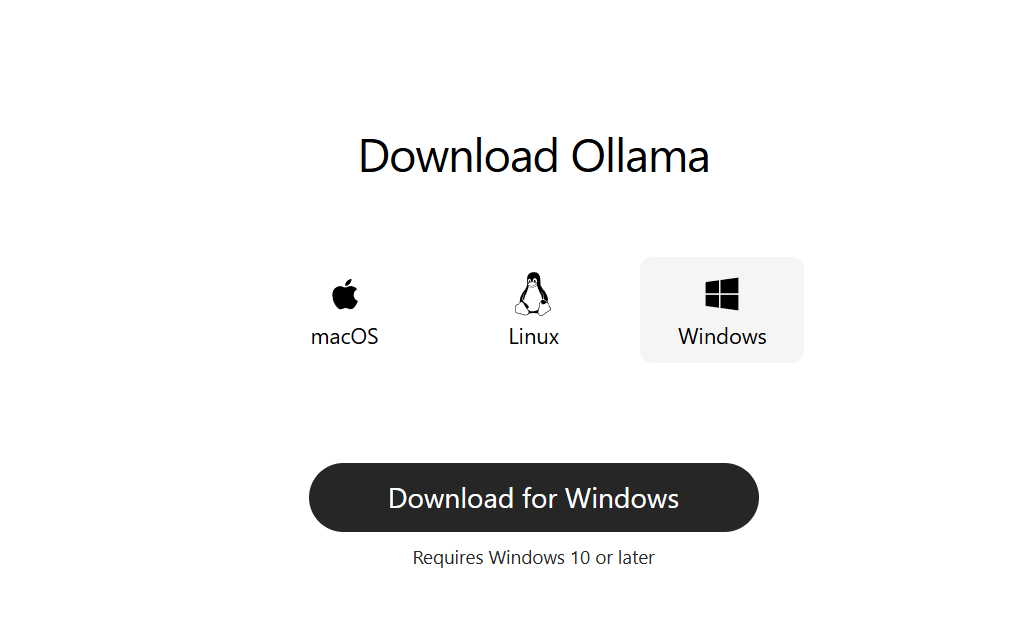

الخطوة 1: تنزيل Ollama لسطح المكتب

انتقل إلى ollama.com وقم بتنزيل أحدث إصدار لنظامك:

- macOS (معالج Apple Silicon أو Intel)

- Windows 10/11 (x64)

قم بتثبيته كتطبيق سطح مكتب عادي. لا يتطلب أي إعدادات سطر أوامر للبدء.

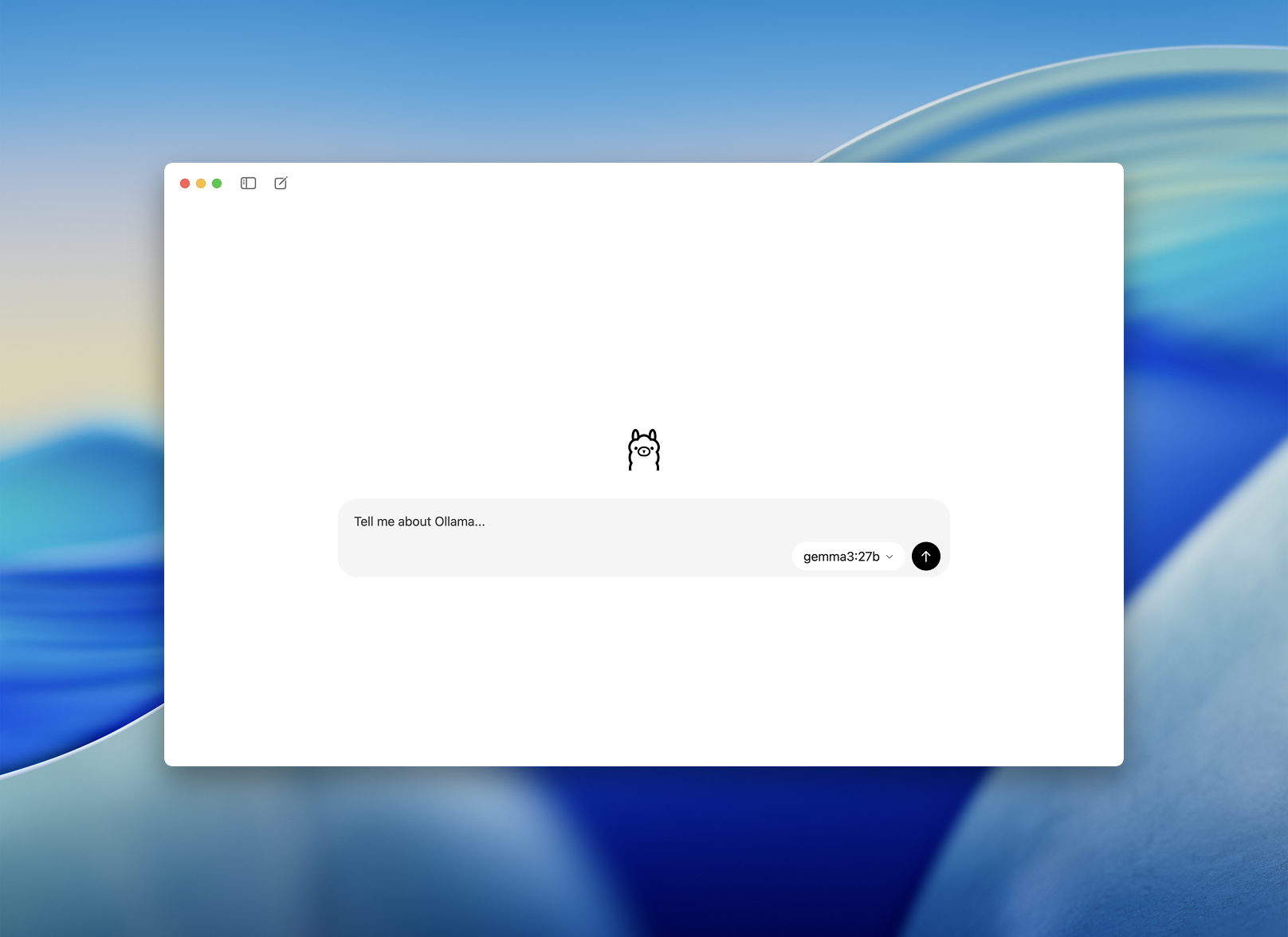

الخطوة 2: التشغيل واختيار نموذج

بمجرد التثبيت، افتح تطبيق Ollama لسطح المكتب. الواجهة نظيفة وتبدو كنافذة دردشة بسيطة.

سيُطلب منك اختيار نموذج لتنزيله وتشغيله. تتضمن بعض الخيارات:

llama3– مساعد للأغراض العامةcodellama– ممتاز لتوليد وإعادة هيكلة الكودmistral– سريع، صغير، ودقيقgemma– نموذج مفتوح الوزن مدعوم من Google

اختر واحدًا وسيقوم التطبيق بتنزيله وتحميله تلقائيًا.

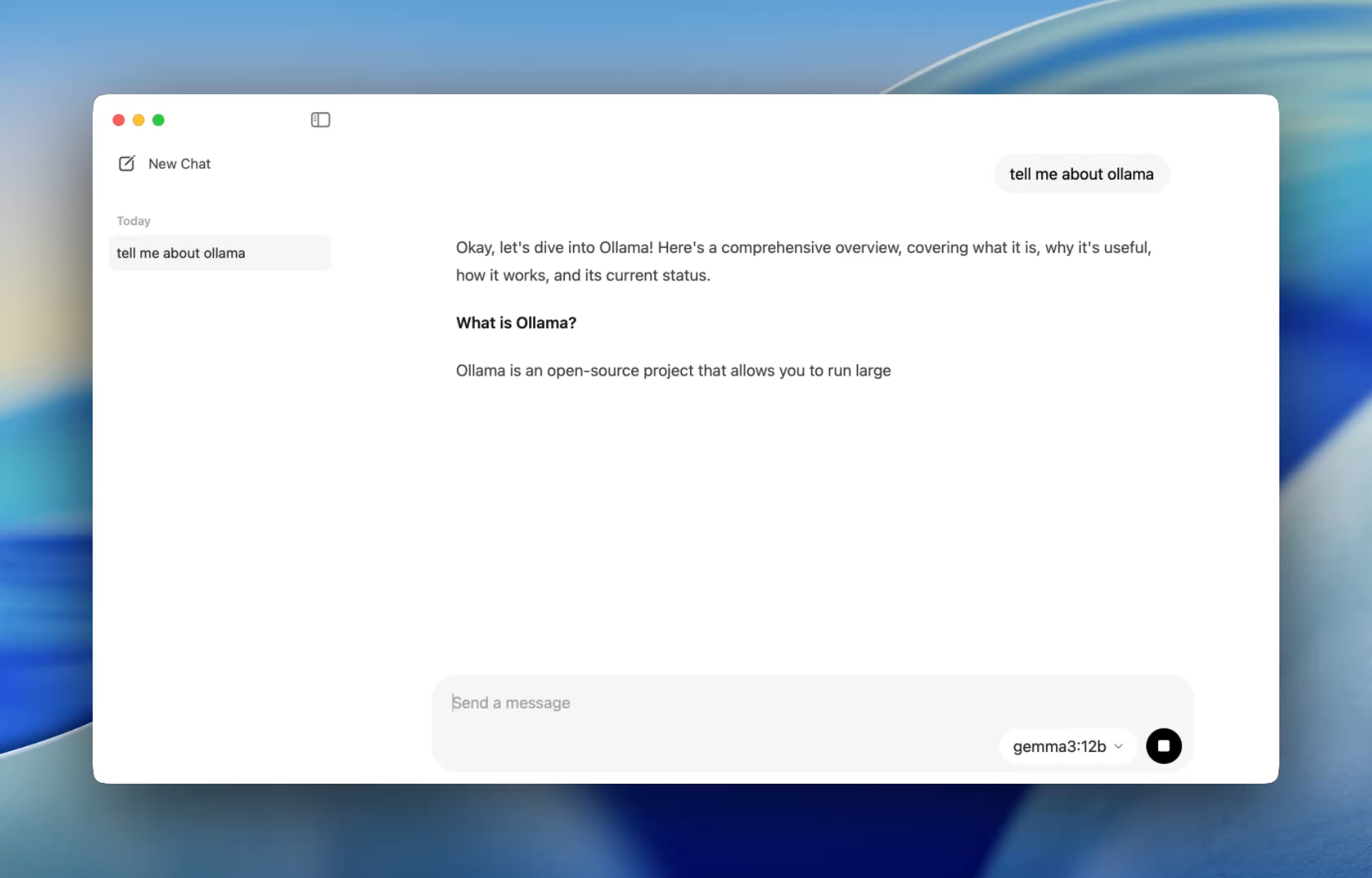

تجربة إعداد أكثر سلاسة للمطورين - طريقة أسهل للدردشة مع النماذج

في السابق، كان استخدام Ollama يعني تشغيل طرفية وإصدار أوامر ollama run لبدء جلسة نموذج. الآن، يفتح تطبيق سطح المكتب مثل أي تطبيق أصلي، ويوفر واجهة دردشة بسيطة ونظيفة.

يمكنك الآن التحدث إلى النماذج بنفس الطريقة التي تتحدث بها في ChatGPT — ولكن بالكامل دون اتصال بالإنترنت. هذا مثالي لـ:

- مساعدة مراجعة الكود

- توليد الاختبارات

- نصائح إعادة الهيكلة

- تعلم واجهات برمجة تطبيقات أو لغات جديدة

يمنحك التطبيق وصولاً فوريًا إلى النماذج المحلية مثل codellama أو mistral دون أي إعدادات تتجاوز التثبيت البسيط.

وللمطورين الذين يحبون التخصيص، لا يزال سطر الأوامر (CLI) يعمل في الخلفية مما يتيح لك تبديل طول السياق، ومطالبات النظام، وإصدارات النموذج عبر الطرفية إذا لزم الأمر.

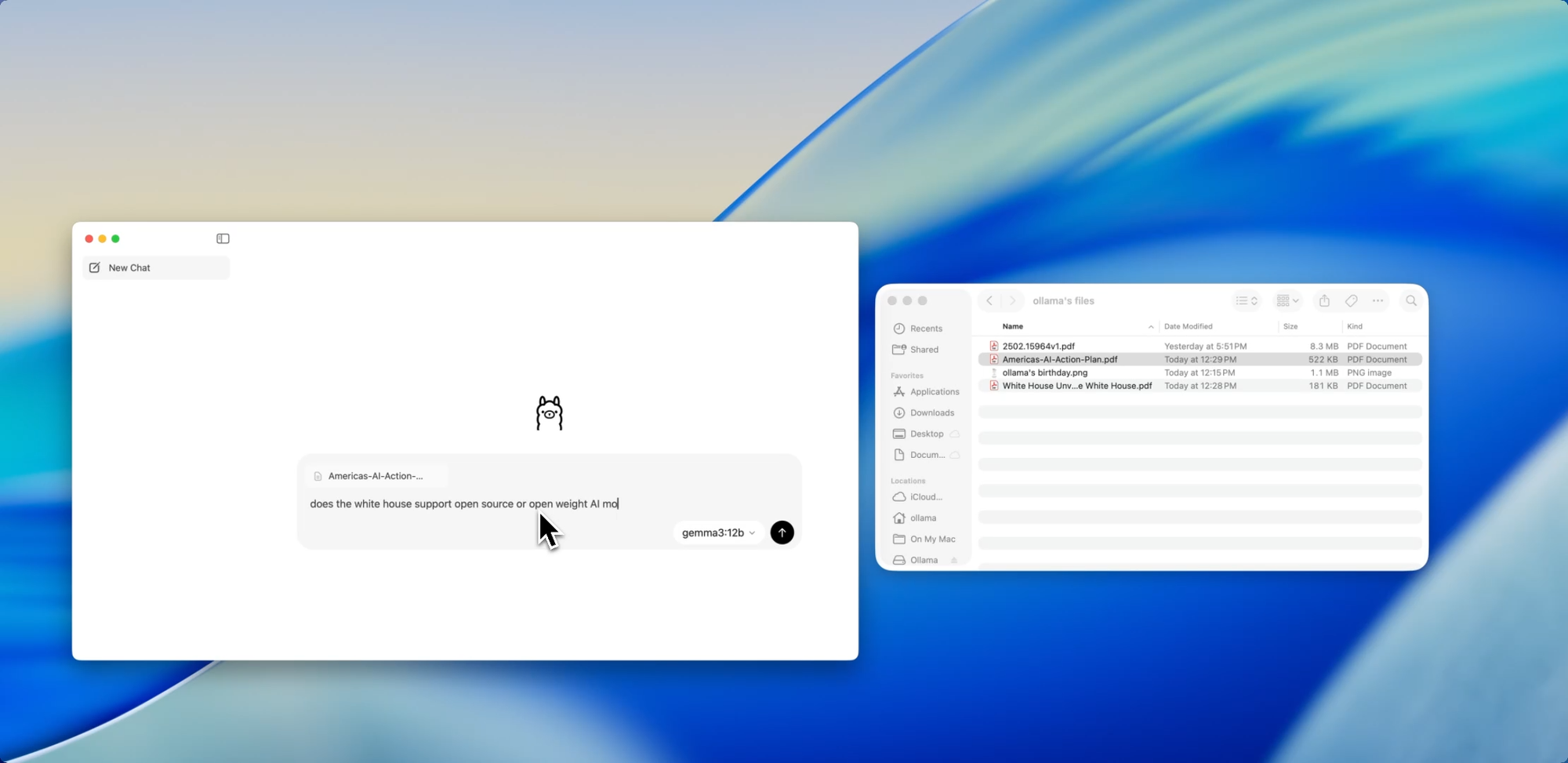

اسحب. أسقط. اسأل.

الدردشة مع الملفات

إحدى أكثر الميزات الصديقة للمطورين في التطبيق الجديد هي استيعاب الملفات. ما عليك سوى سحب ملف إلى نافذة الدردشة — سواء كان ملف .pdf أو .md أو .txt — وسيقوم النموذج بقراءة محتوياته.

هل تحتاج إلى فهم مستند تصميم من 60 صفحة؟ هل تريد استخراج مهام TODO من ملف README فوضوي؟ أو تلخيص موجز منتج عميل؟ قم بإسقاطه واسأل أسئلة بلغة طبيعية مثل:

- "ما هي الميزات الرئيسية التي نوقشت في هذا المستند؟"

- "لخص هذا في فقرة واحدة."

- "هل توجد أي أقسام مفقودة أو تناقضات؟"

يمكن لهذه الميزة أن تقلل بشكل كبير الوقت المستغرق في مسح التوثيقات، ومراجعة المواصفات، أو الانضمام إلى مشاريع جديدة.

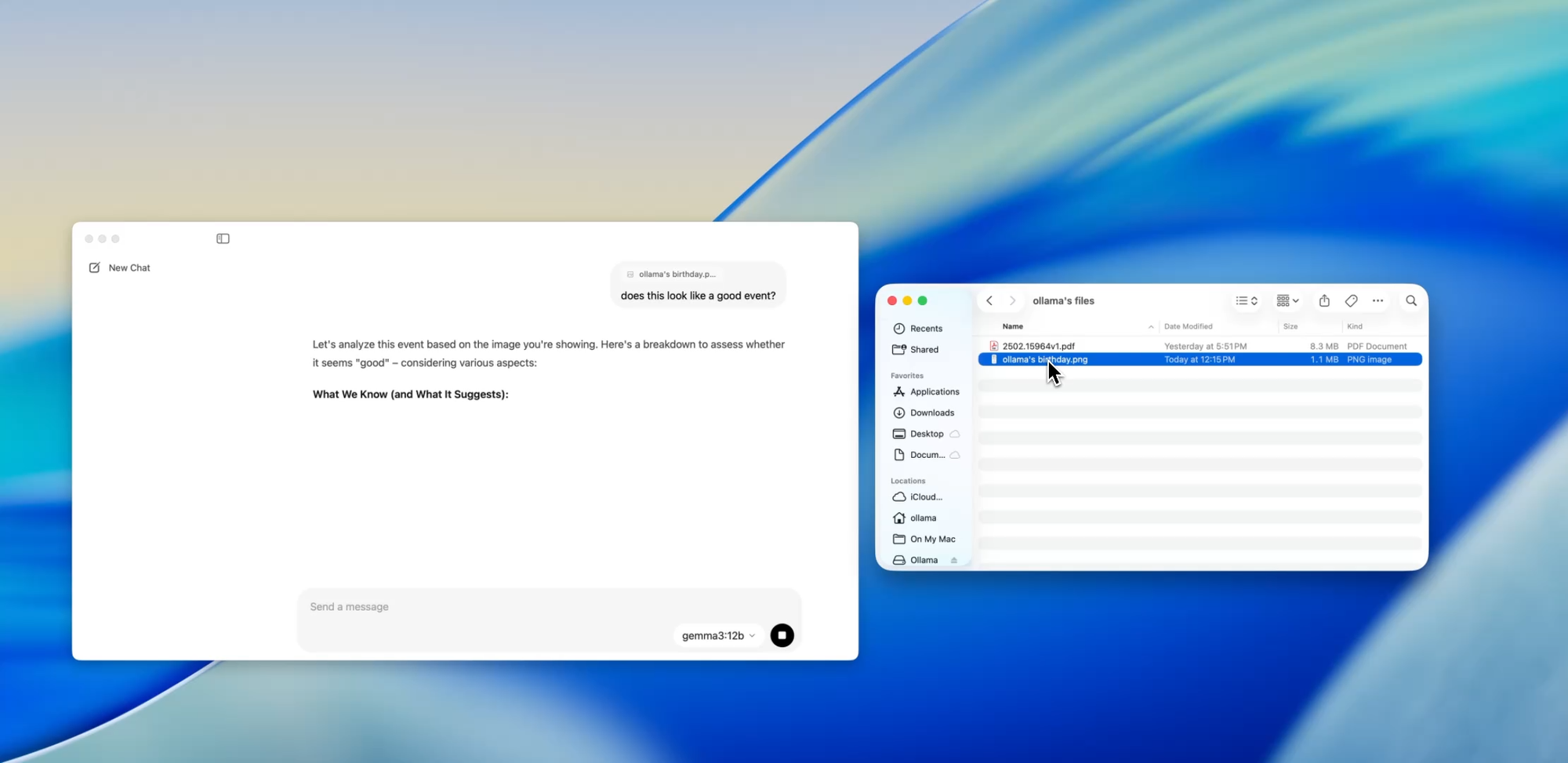

تجاوز النص

دعم متعدد الوسائط

تدعم نماذج مختارة داخل Ollama (مثل تلك المستندة إلى Llava) الآن إدخال الصور. وهذا يعني أنه يمكنك تحميل صورة، وسيقوم النموذج بتفسيرها والرد عليها.

تتضمن بعض حالات الاستخدام ما يلي:

- قراءة الرسوم البيانية أو المخططات من لقطة شاشة

- وصف النماذج الأولية لواجهة المستخدم (UI)

- مراجعة الملاحظات المكتوبة بخط اليد الممسوحة ضوئيًا

- تحليل الرسوم البيانية البسيطة

بينما لا يزال هذا في مراحله المبكرة مقارنة بأدوات مثل GPT-4 Vision، فإن وجود دعم متعدد الوسائط مدمج في تطبيق يركز على التشغيل المحلي أولاً يعد خطوة كبيرة للمطورين الذين يبنون أنظمة متعددة المدخلات أو يختبرون واجهات الذكاء الاصطناعي.

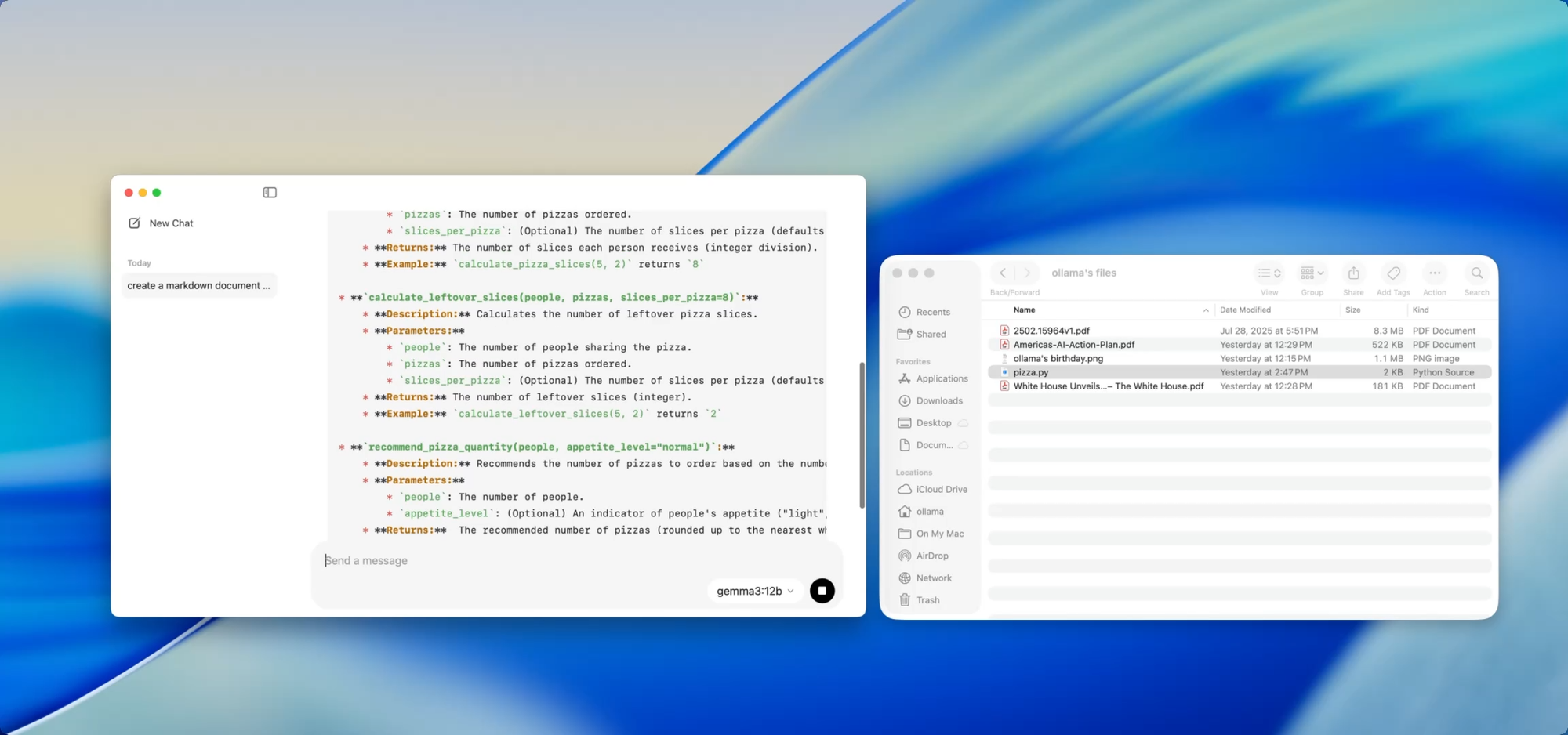

مستندات خاصة، محلية — تحت تصرفك

كتابة التوثيقات

إذا كنت تحتفظ بقاعدة بيانات متنامية، فأنت تعرف معاناة تشتت التوثيقات. باستخدام Ollama، يمكنك استخدام النماذج المحلية للمساعدة في توليد أو تحديث التوثيقات دون الحاجة إلى دفع أي كود حساس إلى السحابة.

ما عليك سوى سحب ملف — على سبيل المثال utils.py — إلى التطبيق واسأل:

- "اكتب توثيقات (docstrings) لهذه الدوال."

- "أنشئ نظرة عامة بتنسيق Markdown لما يفعله هذا الملف."

- "ما هي التبعيات التي يستخدمها هذا الموديل؟"

يصبح هذا أكثر قوة عند إقرانه بأدوات مثل [Deepdocs] التي تقوم بأتمتة سير عمل التوثيقات باستخدام الذكاء الاصطناعي. يمكنك تحميل ملفات README أو المخطط الخاصة بمشروعك مسبقًا، ثم طرح أسئلة متابعة أو إنشاء سجلات تغيير، أو ملاحظات ترحيل، أو أدلة تحديث — كل ذلك محليًا.

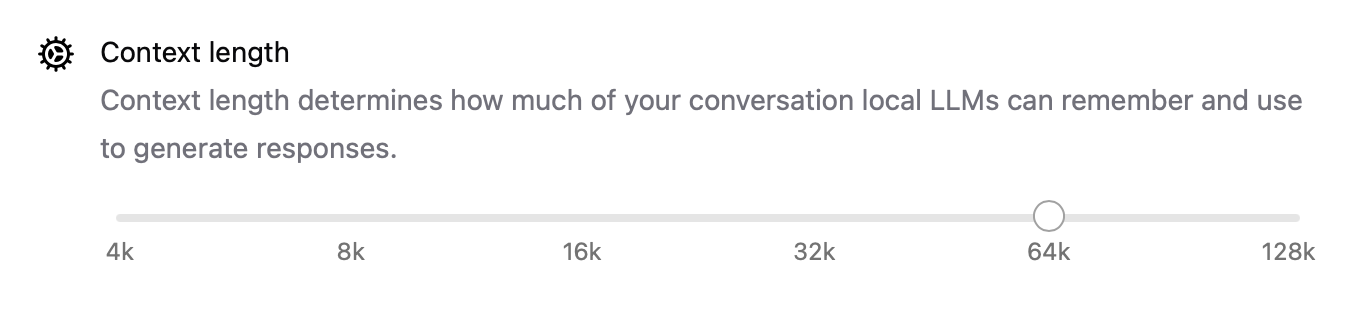

تحسين الأداء تحت الغطاء

مع هذا الإصدار الجديد، قامت Ollama أيضًا بتحسين الأداء بشكل عام:

- تم تحسين تسريع وحدة معالجة الرسوميات (GPU) بشكل أفضل لمعالجات Apple Silicon وبطاقات Nvidia/AMD الحديثة.

- أصبح طول السياق قابلاً للتكوين الآن بإعدادات مثل

num_ctx=8192، بحيث يمكنك التعامل مع مدخلات أطول. - يتيح وضع الشبكة لـ Ollama العمل كخادم API محلي يمكنك استدعاؤه من تطبيقات أو أجهزة أخرى على شبكتك المحلية (LAN).

- يمكنك الآن تغيير موقع التخزين للنماذج التي تم تنزيلها — وهو مثالي إذا كنت تعمل من محرك أقراص خارجي أو ترغب في عزل النماذج لكل مشروع.

هذه الترقيات تجعل التطبيق مرنًا لكل شيء بدءًا من الوكلاء المحليين إلى أدوات المطورين وصولاً إلى مساعدي البحث الشخصيين.

CLI و GUI: أفضل ما في العالمين

أفضل جزء؟ تطبيق سطح المكتب الجديد لا يحل محل الطرفية — بل يكملها.

لا يزال بإمكانك:

ollama pull codellama

ollama run codellama

أو كشف خادم النموذج:

ollama serve --host 0.0.0.0

لذا، إذا كنت تبني واجهة ذكاء اصطناعي مخصصة، أو وكيلًا، أو مكونًا إضافيًا يعتمد على نموذج لغة كبير محلي، يمكنك الآن البناء على واجهة برمجة تطبيقات Ollama واستخدام الواجهة الرسومية للتفاعل المباشر أو الاختبار.

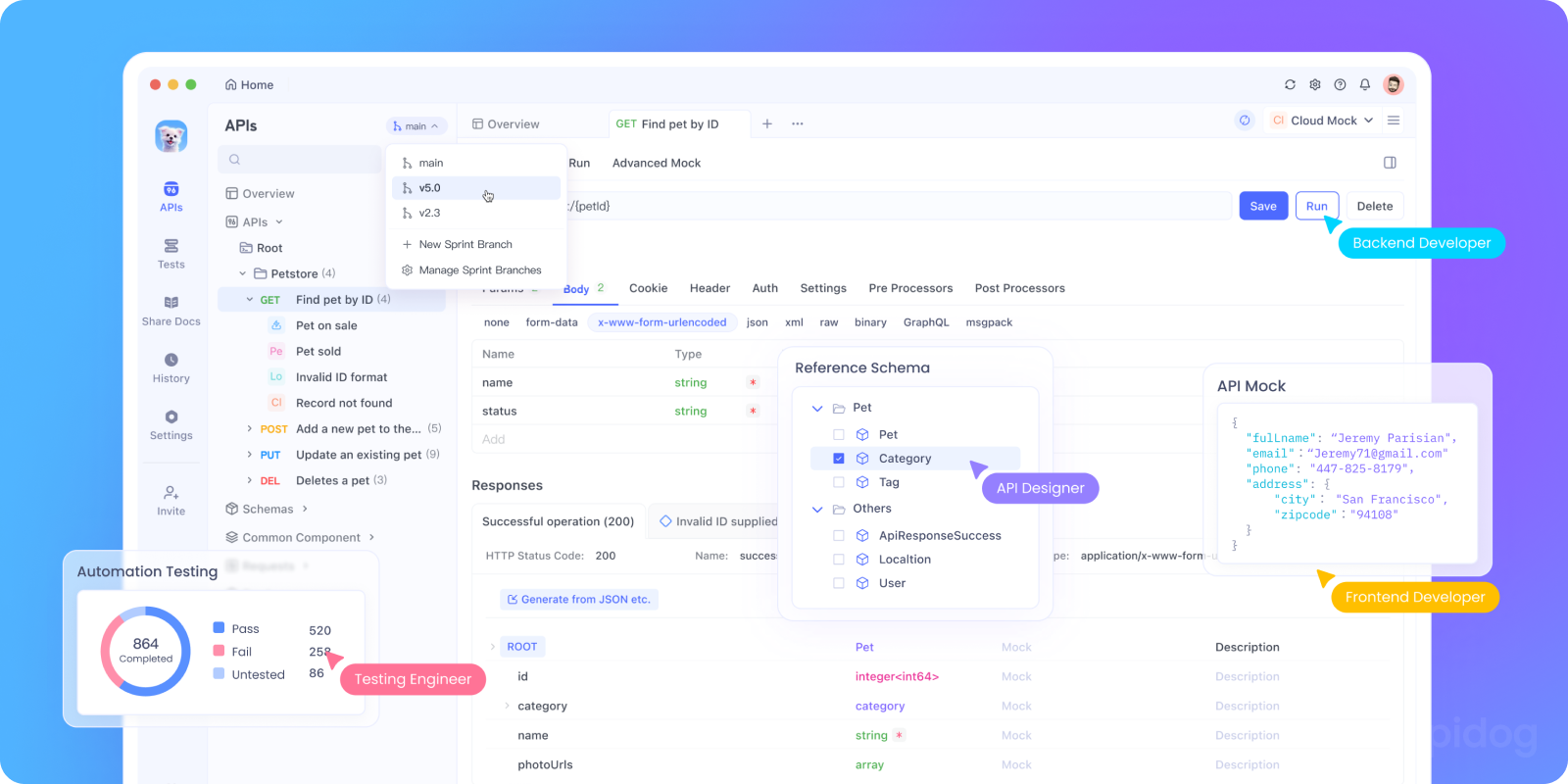

اختبر واجهة برمجة تطبيقات Ollama محليًا باستخدام Apidog

هل ترغب في دمج Ollama في تطبيق الذكاء الاصطناعي الخاص بك أو اختبار نقاط نهاية واجهة برمجة التطبيقات المحلية الخاصة بها؟ يمكنك تشغيل واجهة برمجة تطبيقات REST الخاصة بـ Ollama باستخدام:

bash tollama serve

بعد ذلك، استخدم Apidog لاختبار وتصحيح وتوثيق نقاط نهاية نموذج اللغة الكبيرة المحلية الخاصة بك.

لماذا تستخدم Apidog مع Ollama:

- واجهة مرئية لإرسال طلبات POST إلى خادمك المحلي

http://localhost:11434 - يدعم توليد الطلبات بمساعدة الذكاء الاصطناعي والتحقق من الاستجابة

- مثالي لتطبيقات الذكاء الاصطناعي المستضافة ذاتيًا، وأطر عمل الوكلاء، أو الأدوات الداخلية

- يعمل بسلاسة مع سير عمل نماذج اللغة الكبيرة المحلية وخوادم النماذج المخصصة

حالات استخدام المطورين التي تعمل بالفعل

إليك أين يتألق تطبيق Ollama الجديد في سير عمل المطورين الحقيقي:

| حالة الاستخدام | كيف تساعد Ollama |

|---|---|

| مساعد مراجعة الكود | تشغيل codellama محليًا للحصول على ملاحظات إعادة الهيكلة |

| تحديثات التوثيقات | اطلب من النماذج إعادة كتابة، تلخيص، أو إصلاح ملفات التوثيق |

| روبوت دردشة المطور المحلي | تضمينه في تطبيقك كمساعد يدرك السياق |

| أداة بحث دون اتصال | تحميل ملفات PDF أو الأوراق البيضاء وطرح أسئلة رئيسية |

| ساحة لعب شخصية لنموذج اللغة الكبير | التجربة مع هندسة المطالبات (prompt engineering) والضبط الدقيق (fine-tuning) |

بالنسبة للفرق التي تقلق بشأن خصوصية البيانات أو هلوسات النماذج، توفر سير عمل نماذج اللغة الكبيرة التي تركز على التشغيل المحلي بديلاً مقنعًا بشكل متزايد.

أفكار أخيرة

تجعل نسخة سطح المكتب من Ollama نماذج اللغة الكبيرة المحلية تبدو أقل شبهاً بتجربة علمية مبتكرة وأكثر شبهاً بأداة مطور مصقولة.

مع دعم التفاعل مع الملفات، والمدخلات متعددة الوسائط، وكتابة المستندات، والأداء الأصلي، يعد خيارًا جادًا للمطورين الذين يهتمون بالسرعة والمرونة والتحكم.

لا توجد مفاتيح API سحابية. لا تتبع في الخلفية. لا فواتير لكل رمز مميز. فقط استنتاج سريع ومحلي مع اختيار أي نموذج مفتوح يناسب احتياجاتك.

إذا كنت مهتمًا بتشغيل نماذج اللغة الكبيرة على جهازك، أو إذا كنت تستخدم Ollama بالفعل وترغب في تجربة أكثر سلاسة، فالآن هو الوقت المناسب لتجربتها مرة أخرى.