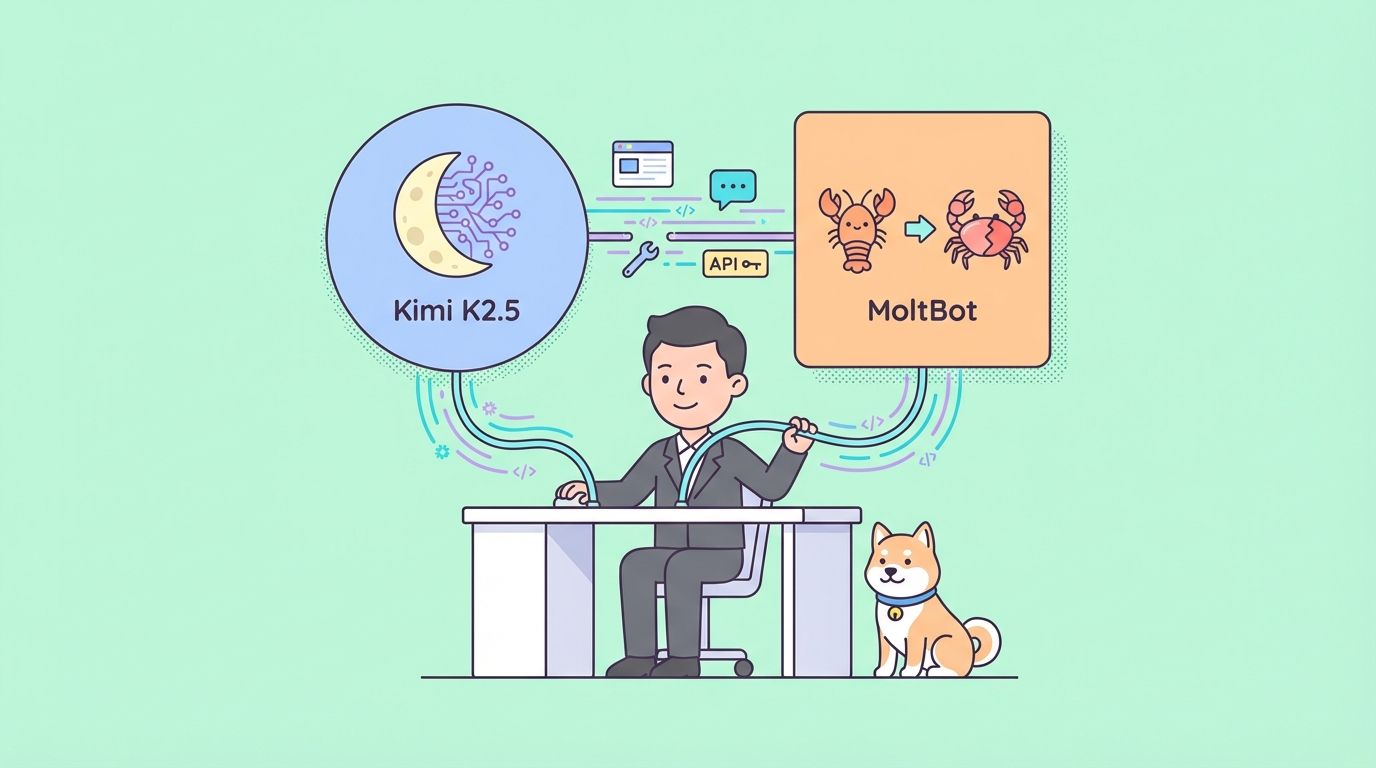

يبرز MoltBot، المعروف سابقًا باسم ClawdBot، كوكيل مستضاف ذاتيًا يتكامل مباشرة مع منصات المراسلة مثل Telegram وWhatsApp وDiscord وSlack. يقوم بتنفيذ مهام حقيقية على جهازك مع الحفاظ على الخصوصية وزمن الوصول المنخفض.

ربط Kimi K2.5 بـ MoltBot ينشئ مساعدًا متعدد الاستخدامات وفعالاً من حيث التكلفة. يكتسب المستخدمون أداءً قويًا للمهام العامة والعمل الإبداعي والسلوكيات الذكية بجزء بسيط من تكلفة نماذج مثل Claude 3.5 Sonnet أو GPT-4o. بالنسبة للإعدادات التي تركز على الخصوصية، فإن النشر المحلي باستخدام أوزان GGUF الكمية يلغي نقل البيانات الخارجية.

يشرح هذا الدليل كلاً من طرق API والطرق المحلية بالتفصيل. ويتضمن أمثلة للتكوين وخطوات التحقق وحلولاً للمشكلات المتكررة.

لماذا يتم إقران MoltBot مع Kimi K2.5؟

يعمل MoltBot كطبقة تنفيذ، بينما يوفر LLM الذكاء. يقدم Kimi K2.5 مزايا مميزة في هذا الدور.

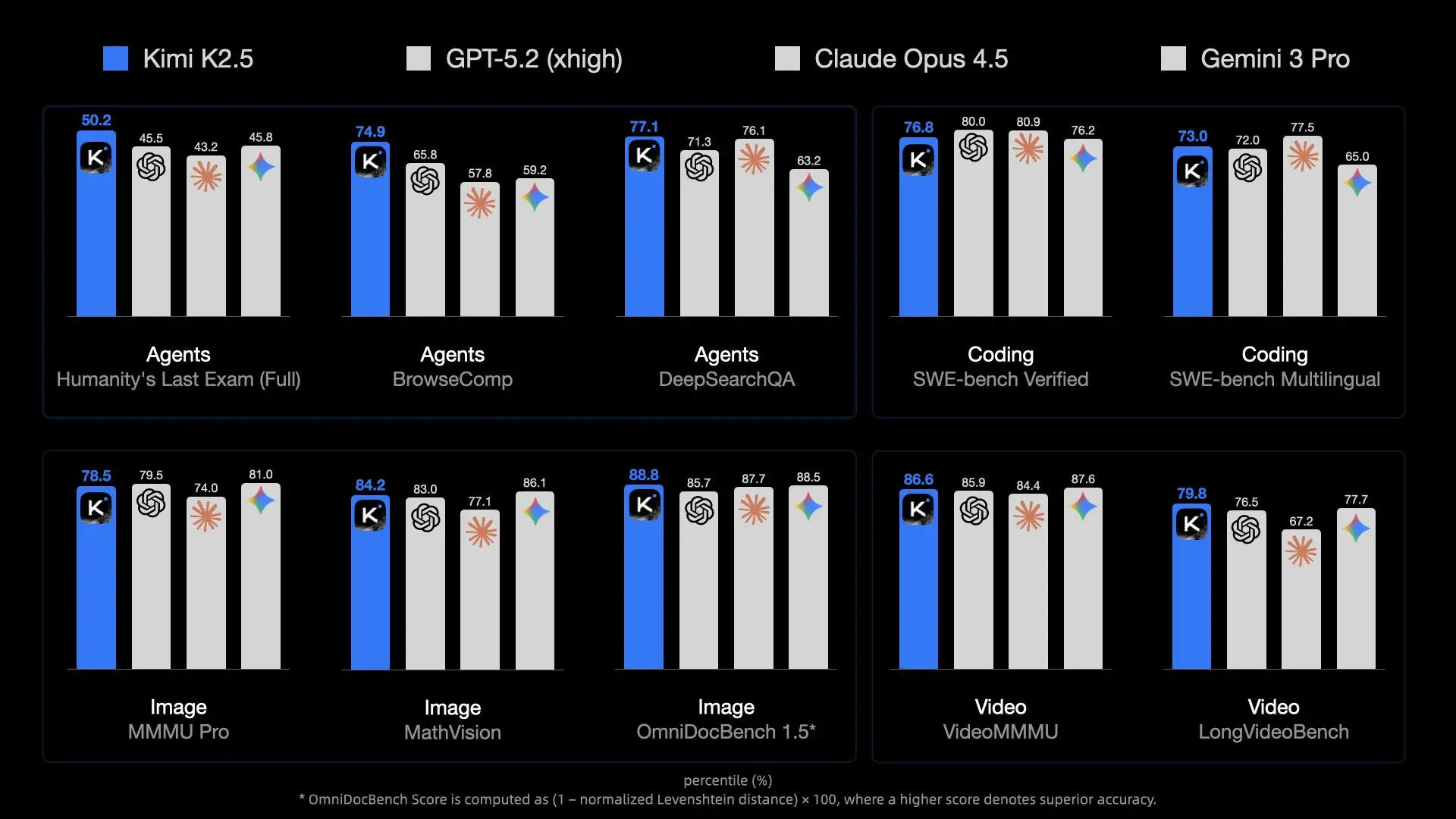

يوفر النموذج قدرة عالية من خلال تصميم MoE الخاص به، مما ينشط الخبراء المعنيين بكفاءة. يتعامل مع المدخلات متعددة الوسائط بشكل طبيعي، مما يسمح لـ MoltBot بمعالجة لقطات الشاشة أو تصميمات واجهة المستخدم أو مقاطع الفيديو القصيرة لمهام مثل توليد التعليمات البرمجية من المرئيات.

يصل طول السياق إلى 256 ألف رمز مميز في معظم عمليات النشر، مما يتيح الاحتفاظ بقواعد بيانات واسعة للمشروع، أو الوثائق، أو سجلات المحادثات - وهي أمور ضرورية للمساعدين الدائمين.

تظل تكاليف API منخفضة مقارنة بالبدائل الغربية. يوفر المستخدمون الكثيفون مبالغ كبيرة بمرور الوقت. وللتخلص من النفقات المستمرة وتحقيق أقصى قدر من التحكم، يعمل الاستدلال المحلي على أجهزة المستهلك مع الكمية.

يُظهر Kimi K2.5 قدرات وكيلة قوية، بما في ذلك أسراب موجهة ذاتيًا تصل إلى 100 وكيل فرعي لتنفيذ الأدوات المتوازي. عند توجيهها عبر نظام مهارات MoltBot، تعمل هذه الميزات على أتمتة مهام سير العمل المعقدة مباشرة من رسائل الدردشة.

تدعم مرونة MoltBot أي نقطة نهاية متوافقة مع OpenAI. يتطلب تبديل المزودين تحديثات بسيطة في التكوين، مما يتيح للمستخدمين التجربة بسهولة.

المتطلبات الأساسية

جهز هذه العناصر قبل التكوين.

ثبّت MoltBot بالكامل. قم بتشغيل برنامج التثبيت إذا لم تكن قد فعلت ذلك بالفعل:

curl -fsSL https://molt.bot/install.sh | bash

تمت إعادة تسمية المشروع من ClawdBot إلى MoltBot في 27 يناير 2026، بعد طلب علامة تجارية من Anthropic. قد تحتفظ الإصدارات القديمة بدليل ~/.clawdbot، ولكن الإصدارات الحديثة تستخدم أوامر moltbot ومسارات ~/.moltbot أو ما شابه ذلك. تحقق من الوثائق على molt.bot أو مستودع GitHub (github.com/moltbot/moltbot) لإعدادك الدقيق.

احصل على وصول Kimi K2.5:

- مسار API: أنشئ حسابًا على platform.moonshot.ai، أنشئ مفتاح API، ودوّن أي حدود لميزانية المشروع.

- المسار المحلي: قم بتنزيل الأوزان الكمية (مثل من Hugging Face moonshotai/Kimi-K2.5 أو مستودعات المجتمع مثل unsloth/Kimi-K2.5-GGUF). قم بتثبيت llama.cpp وابدأ الخادم.

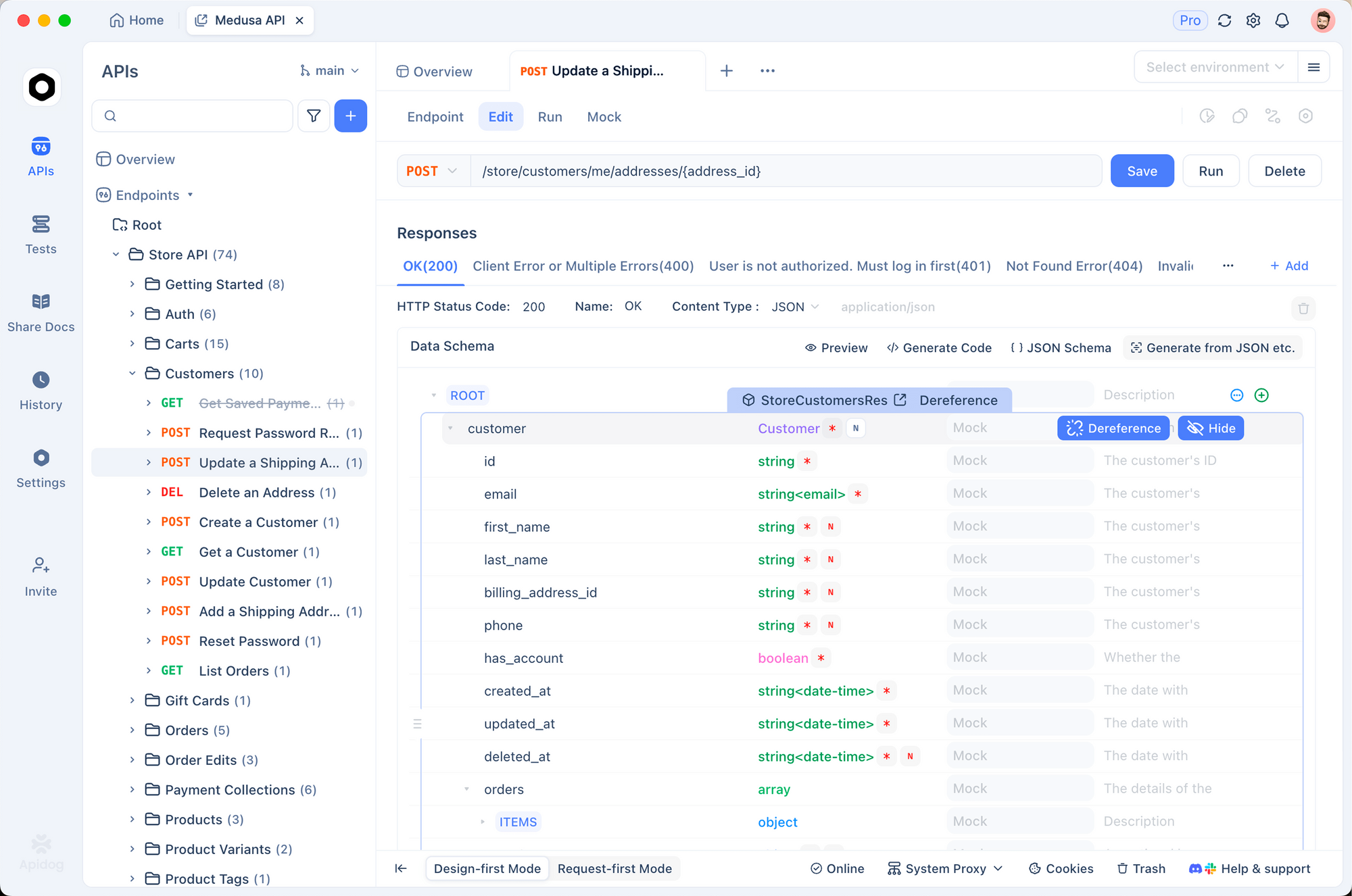

قم بتثبيت Apidog للاختبار. يتعامل بفعالية مع رؤوس المصادقة، وهيئات JSON، وتدفق الاستجابة.

تأكد من تشغيل Node.js لـ MoltBot. تساعد الإلمام الأساسي بالطرفية في تحرير ملفات JSON.

الطريقة 1: الاتصال عبر Moonshot API (موصى به لمعظم المستخدمين)

يتطلب هذا النهج الحد الأدنى من الأجهزة ويوفر سياقًا كاملاً بحجم 256K بالإضافة إلى دعم متعدد الوسائط.

الخطوة 1: التحقق من اتصال API باستخدام Apidog

شغل Apidog وأنشئ طلب POST جديد.

اضبط URL على:

https://api.moonshot.ai/v1/chat/completions

أضف الرأس:

Authorization: Bearer sk-XXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXX

(استبدله بمفتاحك الفعلي.)

استخدم هذا النص لاختبار أساسي:

{

"model": "kimi-k2.5",

"messages": [

{

"role": "user",

"content": "Confirm you are Kimi K2.5 and describe your capabilities briefly."

}

],

"temperature": 0.7,

"max_tokens": 256

}

أرسل الطلب. استجابة 200 ناجحة مع إخراج متماسك تؤكد أن المفتاح يعمل. لاحظ أي أخطاء تتعلق بحدود المعدل أو الميزانية هنا.

الخطوة 2: تحديد موقع ملف التكوين وتعديله

يخزن MoltBot الإعدادات في ملف JSON، وعادة ما يكون:

~/.moltbot/moltbot.json- أو الأقدم:

~/.clawdbot/moltbot.json/~/.clawdbot/agents/default/config.json

افتحه باستخدام محرر.

أضف أو عدّل قسم المزودين:

{

"agent": {

"model": {

"primary": "moonshot/kimi-k2.5"

}

},

"models": {

"providers": {

"moonshot": {

"baseUrl": "https://api.moonshot.ai/v1",

"apiKey": "sk-your-moonshot-api-key-here",

"api": "openai-completions",

"models": [

{

"id": "kimi-k2.5",

"name": "Kimi K2.5 (API)",

"contextWindow": 262144,

"maxTokens": 8192

}

]

}

}

}

}

ملاحظة أمنية: تجنب تضمين المفاتيح بشكل مباشر في الإنتاج. قم بتعيين متغير بيئة (مثلاً، export MOONSHOT_API_KEY=sk-...) وارجع إليه إذا كان MoltBot يدعم التوسع.

الخطوة 3: تطبيق التغييرات وإعادة التشغيل

احفظ الملف، ثم أعد التشغيل:

moltbot restart

أو أوقف وابدأ البوابة/الخدمة حسب الحاجة.

الطريقة 2: الاتصال عبر نشر Kimi K2.5 المحلي

يعطي التنفيذ المحلي الأولوية للخصوصية ويلغي التكاليف المتكررة، على الرغم من أنه يتطلب ذاكرة وصول عشوائي للفيديو (VRAM) / ذاكرة وصول عشوائي (RAM) كبيرة.

الخطوة 1: تشغيل خادم الاستدلال المحلي

استخدم llama.cpp للتوافق.

قم ببناء llama.cpp بدعم وحدة معالجة الرسوميات (GPU) إذا كانت متاحة:

git clone https://github.com/ggerganov/llama.cpp

cd llama.cpp

make LLAMA_CUDA=1 # أو أعلام مناسبة

قم بتنزيل متغير GGUF كمي (على سبيل المثال، UD-TQ1_0 للتوازن):

استخدم huggingface-cli أو التنزيل المباشر.

ابدأ الخادم المتوافق مع OpenAI:

./llama-server \

-m /path/to/Kimi-K2.5-UD-TQ1_0.gguf \

--port 8080 \

--ctx-size 32768 \ # اضبط حتى حد الأجهزة؛ 256 ألفًا يتطلب موارد هائلة

--n-gpu-layers 99 \

--host 0.0.0.0

تحقق من خلال تصفح http://localhost:8080/v1/models.

الخطوة 2: تحديث تكوين MoltBot لنقطة النهاية المحلية

عدّل ملف JSON:

{

"agent": {

"model": {

"primary": "local-kimi/kimi-k2.5"

}

},

"models": {

"providers": {

"local-kimi": {

"baseUrl": "http://127.0.0.1:8080/v1",

"apiKey": "sk-no-key-required",

"api": "openai-completions",

"models": [

{

"id": "kimi-k2.5-local",

"name": "Kimi K2.5 محلي",

"contextWindow": 32768, // يجب أن يتطابق مع --ctx-size

"maxTokens": 4096

}

]

}

}

}

}

ملاحظة Docker: إذا كان MoltBot يعمل داخل حاوية، فاستبدل 127.0.0.1 بـ host.docker.internal.

الخطوة 3: إعادة التشغيل ومراقبة استخدام الموارد

أعد تشغيل MoltBot وراقب شاشات النظام. يستهلك الاستدلال المحلي ذاكرة كبيرة؛ قم بتحميل الطبقات أو تقليل السياق إذا لزم الأمر.

الاختبار والتحقق

تأكيد عمل التكامل.

أرسل رسالة إلى مثيل MoltBot الخاص بك (عبر التطبيق المتصل):

"من هو مزود طاقتك الآن؟"

عادةً ما يستجيب Kimi K2.5 بتحديد Moonshot AI.

تحقق من السجلات:

moltbot logs

ابحث عن الطلبات الموجهة إلى api.moonshot.ai أو localhost:8080.

اختبر الوسائط المتعددة إذا كنت تستخدم واجهة برمجة التطبيقات (API): قم بتحميل صورة عبر الدردشة واطلب وصفًا لها أو إنشاء رمز منها.

استكشاف المشكلات الشائعة وإصلاحها

فشل التحقق من المزود ← أعد اختبار baseUrl + المفتاح بالضبط في Apidog. غالبًا ما تتداخل بروكسيات الشبكة أو جدران الحماية.

أخطاء تجاوز السياق ← قم بمواءمة contextWindow في JSON مع --ctx-size للخادم. يقوم MoltBot باقتطاع أو تلخيص المحتوى عند الوصول إلى الحدود؛ تؤدي القيم غير المتطابقة إلى تعطل النظام.

الاستجابات البطيئة محليًا ← قلل من طبقات وحدة معالجة الرسوميات (gpu-layers)، استخدم كمية أقل من الكوانتيزيشن (quantization)، أو قم بتمكين Flash Attention في llama.cpp.

تنسيق/هلوسات غير متوقعة ← جرب درجة الحرارة (0.6-1.0) أو أضف موجهات نظام مخصصة في تكوين وكيل MoltBot للضبط الخاص بـ Kimi.

استنفاد ميزانية API ← راقب الاستخدام على platform.moonshot.ai وحدد حدودًا يومية.

الخاتمة

يوفر دمج Kimi K2.5 مع MoltBot وكيل ذكاء اصطناعي شخصي عالي الأداء، واقتصادي، ويمكن أن يكون خاصًا بالكامل اختياريًا. توفر طريقة API الراحة وأقصى قدر من الإمكانيات، بينما يضمن الإعداد المحلي سيادة البيانات الكاملة.

جرب كلا النهجين. استخدم Apidog طوال الوقت لعزل المشكلات بسرعة. بينما تواصل Moonshot تحديث نماذج Kimi ويتطور MoltBot، فإن هذا المزيج يضع المستخدمين في طليعة الذكاء الاصطناعي الوكيلي المتاح.

ابدأ التكوين الآن - مساعدك المحسّن ينتظرك.